L'avenir de l'IA : la bulle va-t-elle éclater et l'hiver revenir ?

Tel le protagoniste de Memento qui découvre qu'il ne peut pas faire confiance à sa propre mémoire, l'intelligence artificielle de 2025 est confrontée à une vérité dérangeante : elle n'est peut-être pas aussi intelligente que nous le pensions. Sam Altman, PDG d'OpenAI, a récemment admis ce que beaucoup murmuraient dans les couloirs de la Silicon Valley : le marché de l'IA est dans une bulle, tout comme ce fut le cas pour les dot-coms à l'aube du nouveau millénaire. L'histoire, comme c'est souvent le cas dans le monde de la technologie, semble destinée à se répéter selon un scénario écrit il y a des décennies.

L'éternel retour de l'hiver numérique ?

Pour comprendre où nous allons, il faut regarder d'où nous venons. Le terme "hiver de l'IA", inventé en 1984 lors d'un débat public de l'AAAI, décrit ces périodes récurrentes où l'enthousiasme pour l'intelligence artificielle cède la place à la déception, suivie de coupes budgétaires drastiques et, enfin, de l'abandon de la recherche sérieuse. Roger Schank et Marvin Minsky, deux pionniers qui avaient vécu le premier hiver des années 70, ont comparé ce phénomène à un "hiver nucléaire" : une réaction en chaîne qui commence par le pessimisme au sein de la communauté scientifique, se propage à travers les médias et culmine avec la fin des financements.

La métaphore nucléaire n'était pas un hasard. Comme dans les films de science-fiction des années 80, où les scénarios post-apocalyptiques représentaient les peurs de l'époque, l'hiver de l'IA reflétait l'anxiété d'un secteur qui avait trop promis et trop peu livré. Le premier grand effondrement a eu lieu entre 1974 et 1980, suivi d'une deuxième période glaciaire entre 1987 et 2000.

Le conte de deux hivers

Le premier hiver de l'IA a des racines profondes dans l'échec de la traduction automatique. Dans les années 50 et 60, la guerre froide avait alimenté les rêves de machines capables de traduire instantanément des documents russes. L'expérience Georgetown-IBM de 1954 n'avait traduit que 49 phrases russes en anglais, en utilisant un vocabulaire de seulement 250 mots, mais les gros titres des journaux parlaient de "cerveaux de robots polyglottes". Comme souvent, les médias avaient amplifié une démonstration limitée, la transformant en une révolution imminente.

La réalité s'est avérée plus complexe. Le problème de la désambiguïsation sémantique – cette capacité toute humaine à comprendre le contexte – s'est révélé aussi ardu que de déchiffrer les énigmes du Sphinx dans Batman. Un exemple apocryphe mais emblématique : "l'esprit est prompt mais la chair est faible" traduit du russe devenait "la vodka est bonne mais la viande est pourrie". En 1966, le National Research Council a conclu que la traduction automatique était plus chère, moins précise et plus lente que la traduction humaine, décrétant la fin de vingt millions de dollars d'investissements et détruisant des carrières universitaires.

Parallèlement, le rapport Lighthill de 1973 a démoli la crédibilité de l'IA britannique, critiquant "l'échec total de l'IA à atteindre ses objectifs grandioses". Sir James Lighthill a identifié le problème de "l'explosion combinatoire" : les algorithmes les plus prometteurs de l'époque s'enlisaient dans des problèmes réels, ne fonctionnant que sur des versions "jouets" de la réalité. Le résultat fut le démantèlement complet de la recherche en IA au Royaume-Uni, avec la survie de seulement trois universités.

Le deuxième acte de la tragédie

Les années 80 ont apporté une renaissance grâce aux systèmes experts. XCON, développé par Carnegie Mellon pour Digital Equipment Corporation, a permis à l'entreprise d'économiser 40 millions de dollars en six ans, déclenchant une ruée vers l'or numérique. En 1985, les entreprises dépensaient plus d'un milliard de dollars en IA, principalement pour des départements internes. Une industrie de soutien est née, avec des entreprises comme Symbolics qui construisaient des ordinateurs spécialisés – les célèbres machines LISP – optimisés pour traiter le langage préféré de la recherche américaine en IA.

Mais comme dans un film de David Cronenberg, la technologie qui devait être le salut s'est transformée en piège. En 1987, trois ans après la prophétie de Minsky et Schank, le marché des machines LISP s'est effondré. Les stations de travail d'entreprises comme Sun Microsystems offraient des alternatives plus puissantes et moins chères. Toute une industrie d'une valeur d'un demi-milliard de dollars a disparu en l'espace d'un an, remplacée par des ordinateurs de bureau plus simples et plus populaires.

Les premiers systèmes experts à succès, comme XCON, se sont révélés trop coûteux à entretenir. Ils étaient difficiles à mettre à jour, incapables d'apprendre, "fragiles" – un terme en IA qui indique la tendance à commettre des erreurs grotesques face à des entrées inhabituelles. Les systèmes experts se sont avérés utiles uniquement dans des contextes très spécifiques, comme des acteurs de caractère capables de briller uniquement dans des rôles sur mesure.

Le présent inquiétant

Aujourd'hui, alors que l'industrie de l'IA connaît son moment de plus grande splendeur historique – avec des investissements de 50 milliards de dollars en 2022 et 800 000 postes à pourvoir aux États-Unis – les signes d'un nouvel hiver sont aussi tangibles que les premières gelées d'automne. OpenAI, le symbole de cette renaissance numérique, perd 2 dollars pour chaque dollar gagné, une dynamique financière insoutenable qui rappelle les pires excès de la bulle Internet.

La situation est devenue plus dramatique avec l'émergence de DeepSeek, l'entreprise chinoise qui a secoué Wall Street en janvier 2025. Nvidia a perdu près de 600 milliards de dollars de valeur de marché en une seule journée, lorsqu'il est apparu que DeepSeek avait développé son modèle R1 en deux mois pour moins de 6 millions de dollars, alors que le rival o1 d'OpenAI avait coûté 600 millions.

Comme dans Akira, où Neo-Tokyo est détruite par une force qui semblait contrôlable, l'apparition de DeepSeek a remis en question les fondements mêmes du boom boursier de l'IA américaine. Si une entreprise chinoise peut obtenir des résultats comparables en dépensant 100 fois moins, quelle justification existe-t-il pour les valorisations stratosphériques des entreprises américaines ?

Les chiffres qui ne mentent pas

Si OpenAI était contrainte de payer les tarifs du marché pour les services de cloud qu'elle utilise massivement, ses coûts annuels atteindraient 20 milliards de dollars, générant des pertes réelles de 16 milliards par an. Selon The Information, la formation d'un seul modèle coûte 3 milliards de dollars, des chiffres qui rendent ces projets économiquement viables uniquement tant que durent les subventions croisées et les investissements spéculatifs.

Les mathématiques sont aussi impitoyables qu'un théorème : si les entreprises leaders du secteur fonctionnent à perte structurelle, l'ensemble de l'écosystème repose sur le pari que la croissance future justifiera les investissements actuels. C'est la même logique qui animait les dot-coms, quand on croyait que "tôt ou tard" on trouverait un moyen de monétiser les clics et les globes oculaires.

Voix du front

Le débat entre optimistes et pessimistes fait écho aux discussions des hivers précédents. D'une part, les partisans de la "diversité technologique" soutiennent que l'IA d'aujourd'hui a des bases plus solides que les systèmes experts des années 80. Les grands modèles de langage ont démontré des capacités émergentes qui vont au-delà de la simple manipulation de symboles, et leur intégration dans les systèmes existants est aussi profonde que celle des microprocesseurs dans les années 90.

D'autre part, les critiques soulignent des parallèles inquiétants. Comme dans les années 80, lorsque les machines LISP semblaient indispensables jusqu'au jour où elles ne l'étaient plus, l'infrastructure actuelle de l'IA pourrait être vulnérable aux discontinuités technologiques. L'approche rentable de DeepSeek a déjà remis en question les hypothèses fondamentales du secteur, soulevant des questions sur la durabilité du modèle d'investissement actuel.

Mais il existe une troisième voie, celle du "réalisme critique" incarnée par des figures comme Gary Marcus, le scientifique cognitif et chercheur en IA qui marche depuis des années sur la corde raide entre l'enthousiasme technologique et le catastrophisme. Marcus, qui a prédit la bulle actuelle de l'IA dès 2023, ne nie pas le potentiel transformateur de la technologie, mais souligne que "les valorisations actuelles rappellent Vil Coyote courant dans le vide : nous sommes au-delà du précipice". Sa position n'est pas celle d'un néo-luddite qui rejette le progrès, mais celle d'un scientifique qui applique le rasoir d'Ockham aux promesses grandioses : l'IA générative a démontré des capacités surprenantes, mais ses limites fondamentales – de l'incapacité à raisonner logiquement à la tendance aux hallucinations – restent non résolues malgré des milliards d'investissements. Comme il l'a écrit sur son Substack, "il y a une bulle, l'arithmétique le montre clairement, ce qui ne signifie pas qu'il n'y aura pas de développements très significatifs par la suite". C'est la position de celui qui voit l'hiver non pas comme une catastrophe, mais comme une correction nécessaire qui séparera le bon grain technologique de l'ivraie spéculative, permettant aux innovations réellement utiles d'émerger des cendres du battage médiatique.

Le facteur géopolitique

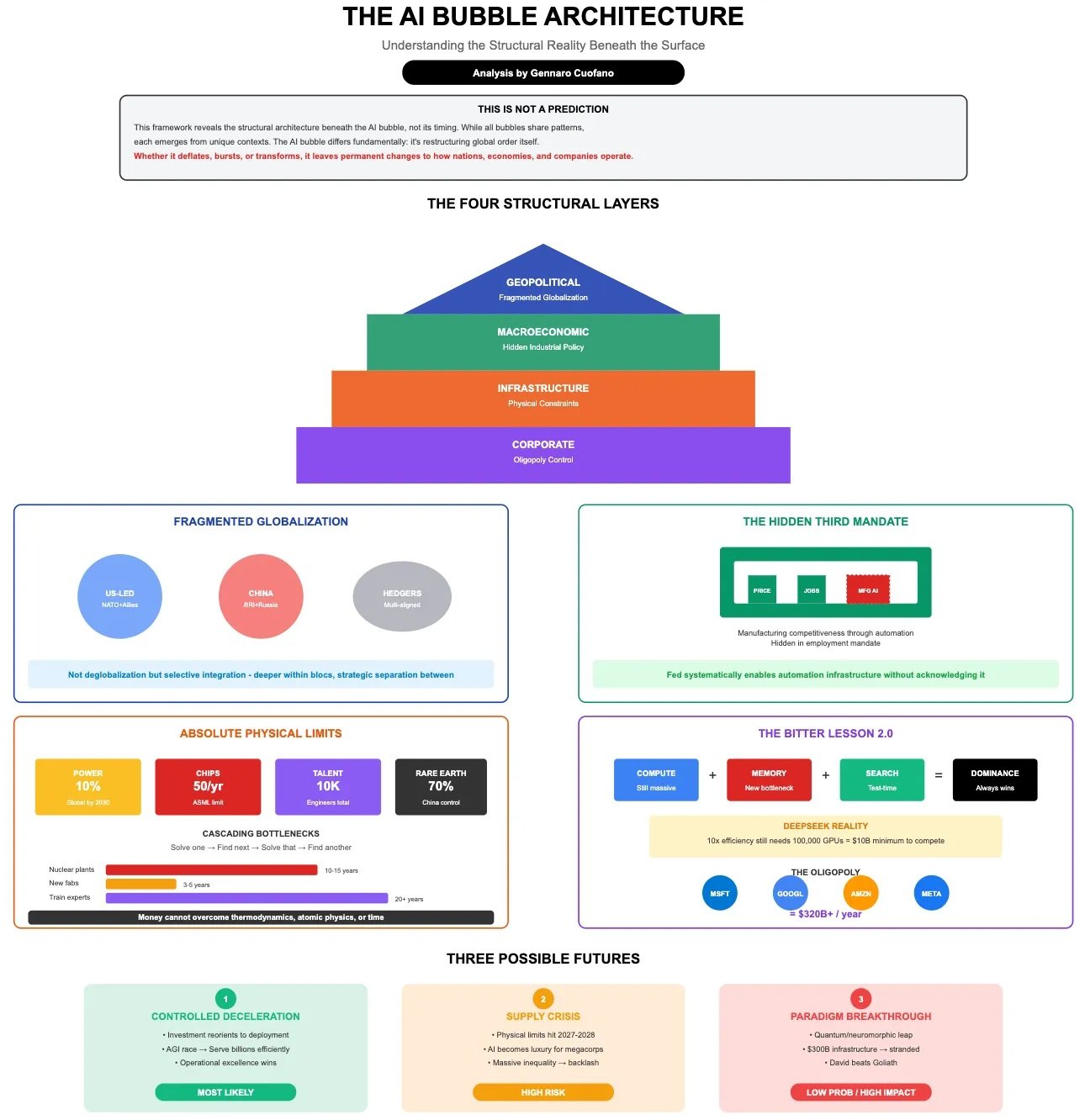

Pour compliquer le tableau, il y a une dimension que les hivers précédents ne connaissaient pas : la concurrence géopolitique. L'IA est devenue un atout stratégique national, et le succès d'entreprises comme DeepSeek ne représente pas seulement un défi commercial, mais une question de sécurité nationale. Les investisseurs expriment déjà des inquiétudes concernant les données personnelles gérées par des entreprises chinoises, faisant écho aux craintes qui ont caractérisé la saga TikTok.

Cette dimension géopolitique pourrait paradoxalement à la fois accélérer et retarder un éventuel hiver. D'une part, les gouvernements occidentaux pourraient intensifier leur soutien public pour maintenir leur compétitivité technologique. D'autre part, la fragmentation du marché mondial pourrait réduire les économies d'échelle nécessaires pour amortir les énormes investissements en R&D.

Leçons du passé, signaux du futur

L'histoire des hivers de l'IA nous apprend que les technologies peuvent être valides et révolutionnaires sans pour autant justifier les valorisations boursières de leur époque. Internet existait et fonctionnait même pendant le krach des dot-coms, tout comme de nombreuses techniques d'intelligence artificielle ont continué à se développer pendant les hivers précédents, souvent "déguisées" sous des noms différents pour éviter le stigmate associé à l'IA.

Nick Bostrom a observé en 2006 que "beaucoup d'IA de pointe se sont infiltrées dans les applications générales, souvent sans être appelées IA parce qu'une fois que quelque chose devient suffisamment utile et courant, on ne l'appelle plus IA". C'est le paradoxe du succès technologique : les innovations les plus durables deviennent invisibles, intégrées dans le tissu quotidien de la société.

Le verdict de la réalité

Au moment où j'écris, les marchés se sont partiellement remis de l'effondrement causé par DeepSeek, mais les fissures dans l'édifice du battage médiatique de l'IA sont visibles. Il ne s'agit pas de savoir si un hiver arrivera – l'histoire suggère que c'est inévitable – mais plutôt de comprendre quelle forme il prendra et quelles technologies survivront au gel.

L'intelligence artificielle, comme le Prométhée du mythe grec, a apporté le feu de la connaissance aux humains. Mais maintenant, comme dans toute tragédie qui se respecte, le moment est venu de payer le prix. La question n'est pas de savoir si l'hiver viendra, mais si cette fois l'industrie aura suffisamment appris de l'histoire pour construire des abris plus solides. Après tout, comme l'enseignait Philip K. Dick, la réalité est ce qui ne disparaît pas même quand on cesse d'y croire.