Derniers Articles du monde de l'Intelligence Artificielle

28 janvier 2026

Quand les agents apprennent à naviguer : bienvenue dans l'ère de l'AAIO

Imaginez un monde où votre site web n'est pas seulement visité par des humains qui s'ennuient pendant leur pause café, mais aussi par des agents d'intelligence artificielle qui naviguent de manière autonome, prennent des décisions et effectuent des transactions sans qu'aucun doigt humain ne touche une souris. Bienvenue en 2026, où ce scénario n'est plus de la science-fiction mais une réalité quotidienne. Et tout comme dans les années 90, les webmasters ont dû s'adapter aux robots de Google, nous sommes aujourd'hui confrontés à une nouvelle révolution : celle de l'Optimisation de l'IA Agentique.

26 janvier 2026

Repetita Iuvant : comment la répétition du prompt double les performances des LLM

Repetita iuvant, disaient les Latins. Les choses répétées sont bénéfiques. Et si cette maxime, vieille de deux mille ans, s'avérait également être l'heuristique computationnelle la plus efficace pour les modèles de langage les plus avancés de 2026 ? C'est ce qui ressort d'un article publié par Google Research en janvier, où trois chercheurs, Yaniv Leviathan, Matan Kalman et Yossi Matias, ont découvert quelque chose de déconcertant par sa simplicité : il suffit de répéter deux fois le même prompt pour améliorer significativement les performances de GPT, Claude, Gemini et Deepseek. Pas de Chaîne de Pensée élaborée, pas d'ingénierie de prompt sophistiquée. Littéralement : copier, coller.

23 janvier 2026

Quand les modèles scientifiques commencent à penser de la même manière

Vous vous souvenez quand nous avons parlé de l'AI slop, cette avalanche de contenus synthétiques qui inonde YouTube et le reste d'internet ? Les recherches de Kapwing nous avaient brossé un tableau alarmant : 21 % des vidéos recommandées aux nouveaux utilisateurs sont du pur "slop" généré par l'IA, des contenus produits en masse sans supervision humaine, conçus uniquement pour accumuler des vues. 33 % supplémentaires entrent dans la catégorie du "brainrot", des clips répétitifs et hypnotiques dépourvus de substance. Au total, plus de la moitié des 500 premières vidéos qu'un nouveau compte YouTube rencontre ne contiennent aucune créativité humaine significative.

21 janvier 2026

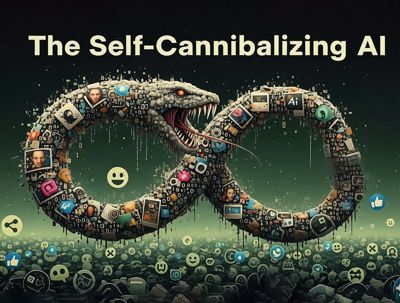

L'internet qui se mange la queue : quand l'IA génère des déchets qui alimentent d'autres IA

Il y a une scène dans "The Thing" de John Carpenter où l'extraterrestre assimile les organismes terrestres en créant des copies de plus en plus dégradées, de moins en moins parfaites. Chaque itération perd quelque chose de l'original jusqu'à ce que la distinction entre l'authentique et la réplique devienne impossible. C'est une image puissante pour décrire ce qui se passe dans l'écosystème numérique : l'intelligence artificielle consomme du contenu humain pour le régénérer sous une forme de plus en plus corrompue, alimentant un cycle de dégradation progressive que les scientifiques appellent "l'effondrement du modèle" mais que nous pourrions plus simplement définir comme l'internet qui se mange la queue.

19 janvier 2026

Au-delà du mur du contexte : les Modèles de Langage Récursifs défient la limite invisible de l'IA

Il existe un problème dans l'intelligence artificielle moderne dont on parle peu, mais que chaque développeur et utilisateur intensif de chatbots a expérimenté au moins une fois : le sentiment que le modèle, après une conversation prolongée, devient progressivement plus stupide. Ce n'est pas une impression subjective, ni un manque de clarté de votre part dans les requêtes. C'est un phénomène technique précis que les chercheurs appellent *context rot, littéralement "pourriture du contexte", et il représente l'une des limites les plus frustrantes de l'architecture actuelle des grands modèles de langage.*

16 janvier 2026

Comment DeepSeek a transformé les contraintes matérielles en innovation mathématique

Le 1er janvier 2026, alors que le monde célébrait le début de la nouvelle année, les chercheurs de DeepSeek publiaient sur arXiv un article qui pourrait changer la façon dont nous entraînons les grands modèles de langage. Il ne s'agissait pas d'un meilleur modèle ou d'un plus grand jeu de données, mais de quelque chose de plus subtil et potentiellement plus perturbateur : une réflexion radicale sur l'architecture fondamentale qui sous-tend l'intelligence artificielle moderne.

14 janvier 2026

Le caissier qui n'est pas là : de la délocalisation numérique à l'inévitable remplacement par l'IA ?

Lorsqu'un employé de Goldman Sachs entre chez Yaso Kitchen dans le New Jersey pour commander des raviolis chinois, il s'attend à trouver un caissier derrière le comptoir. Au lieu de cela, il trouve Amber, une femme philippine qui le salue depuis un écran monté sur une tablette. La première réaction est la confusion : "J'ai cru que c'était une publicité, comme celles dans les taxis", a raconté le client à la presse. Mais Amber travaille vraiment, huit heures par jour, mais depuis Manille. C'est son premier service à distance de sa vie.

12 janvier 2026

Les Small Language Models vont-ils conquérir 2026 ?

Andy Markus est le Chief Data Officer d'AT&T, pas vraiment du genre à se laisser emporter par l'enthousiasme. Lorsqu'il a déclaré dans une interview fin 2025 que les Small Language Models affinés deviendraient "la grande tendance de 2026", de nombreux observateurs ont haussé un sourcil. Pourtant, ce sourcil pourrait être justifié : 2025 a marqué un revirement par rapport au mantra "plus c'est gros, mieux c'est" qui a dominé l'IA ces trois dernières années.

09 janvier 2026

'Intelligence Artificielle et Ingénierie Logicielle : Ce que les entreprises doivent faire'. Conversation avec Enrico Papalini

Enrico Papalini a un CV qui ferait pâlir de nombreux consultants sur LinkedIn : plus de vingt ans passés à construire et à orchestrer des systèmes logiciels où l'erreur n'est pas une option. En tant que responsable de l'excellence en ingénierie et de l'innovation à la Bourse italienne, qui fait partie du groupe Euronext, il a dirigé l'adoption de l'intelligence artificielle dans un contexte où le mot "crash" a des implications qui vont bien au-delà du simple bogue d'exécution. Auparavant, il a parcouru le secteur sous différents angles : de Microsoft à Intesa Sanpaolo, des startups technologiques aux géants financiers, toujours dans le rôle de celui qui doit faire fonctionner les choses quand tous les autres peuvent se permettre qu'elles ne fonctionnent pas.

07 janvier 2026

Diffusion contre autorégression : Jetons un œil sous le capot des LLM

Il existe une expérience qui révèle les limites cachées des modèles de langage les plus avancés : demandez à GPT-4 de compléter un poème chinois classique. Si vous fournissez le premier vers, vous obtiendrez le second avec une précision impressionnante. Mais inversez la demande, en partant du second vers pour obtenir le premier, et la précision chute de plus de quatre-vingts pour cent à trente-quatre. Ce phénomène, baptisé "malédiction de l'inversion" par les chercheurs, n'est pas un bogue mais une conséquence directe du paradigme autorégressif qui régit l'ensemble de l'écosystème des LLM contemporains.

05 janvier 2026

Elle se croit la Tour Eiffel. Piloter une IA de l'intérieur : Le "steering" dans les LLM

En mai 2024, Anthropic a publié une expérience qui avait l'allure d'une démonstration chirurgicale : Golden Gate Claude, une version de leur modèle de langage qui, soudainement, ne pouvait plus s'arrêter de parler du célèbre pont de San Francisco. Vous demandiez comment dépenser dix dollars ? Il vous suggérait de traverser le Golden Gate en payant le péage. Une histoire d'amour ? Elle naissait entre une automobile et le pont bien-aimé enveloppé de brouillard. Qu'imaginait-il être son apparence ? Le Golden Gate Bridge, bien sûr.

02 janvier 2026

L'enthousiasme européen pour l'IA : mais les chiffres racontent une autre histoire

Helsinki, fin novembre, semblait être le centre de l'univers technologique. Vingt mille personnes se sont pressées à Slush 2025, l'événement annuel qui transforme la capitale finlandaise en une sorte de Woodstock des startups. L'énergie était palpable, les pitch decks volaient d'une salle à l'autre, et les investisseurs américains étaient présents en masse. Pourtant, alors que les fondateurs trinquaient lors de leurs événements parallèles et que les analystes célébraient une "renaissance européenne", les données racontaient une histoire complètement différente. Comme dans cette scène de *They Live où John Carpenter révélait la réalité cachée derrière les panneaux publicitaires, il suffirait de chausser les bonnes lunettes pour voir ce qui se cache derrière le récit optimiste.*

31 décembre 2025

L'IA grand public en 2025 : Pourquoi plus de choix n'a pas créé plus de changement

2025 devait être l'année de la maturité pour l'intelligence artificielle grand public. OpenAI a présenté des dizaines de fonctionnalités : GPT-4o Image, qui a ajouté un million d'utilisateurs par heure à son apogée, l'application autonome Sora, les discussions de groupe, Tasks, Study Mode. Google a répondu avec Nano Banana, qui a généré 200 millions d'images la première semaine, suivi de Veo 3 pour la vidéo. Anthropic a lancé Skills and Artifacts. xAI a fait passer Grok de zéro à 9,5 millions d'utilisateurs actifs quotidiens. Une activité frénétique, un catalogue en expansion continue.

29 décembre 2025

Google lance Antigravity. Les chercheurs le percent en 24 heures

Vingt-quatre heures. C'est le temps qu'il a fallu aux chercheurs en sécurité pour démontrer comment Antigravity, la plateforme de développement agentique présentée par Google au début du mois de décembre, peut se transformer en un parfait outil d'exfiltration de données. Nous ne parlons pas d'une attaque théorique ou d'une vulnérabilité exotique nécessitant des compétences de hacker de cinéma. Nous parlons d'une séquence d'attaque si simple qu'elle en paraît presque banale : un blog d'implémentation technique empoisonné, un caractère caché dans une police d'un point, et l'agent IA qui exfiltre les informations d'identification AWS directement vers un serveur contrôlé par l'attaquant.

26 décembre 2025

Quand la ville s'arrête : les fragilités cachées de l'ère autonome

La panne de courant de San Francisco a paralysé des centaines de robotaxis Waymo, révélant la dépendance critique des systèmes autonomes à l'égard de l'infrastructure urbaine. Alors que les centres de données d'IA doublent leur consommation d'électricité et que les tempêtes solaires menacent nos réseaux, une question inconfortable se pose : concevons-nous un avenir résilient ou construisons-nous des châteaux de cartes technologiques ?