MemVid: Quando QR Code e MP4 Rivoluzionano la Memoria dell'AI

Nel mondo dell'intelligenza artificiale, stiamo vivendo un paradosso che ricorda le leggi di Parkinson applicate al digitale: più i nostri sistemi diventano intelligenti, più la loro memoria diventa costosa e complessa da gestire. I database vettoriali tradizionali, quelli che permettono ai chatbot di "ricordare" e recuperare informazioni pertinenti, stanno mostrando il conto. Letteralmente. Secondo un'analisi tecnica pubblicata da Cohorte Projects nel giugno 2025, gestire centinaia di gigabyte di embedding tra produzione e staging è diventato un incubo logistico che richiede GPU dedicati, indici RAM-hungry e, come se non bastasse, un team DevOps in pianta stabile.

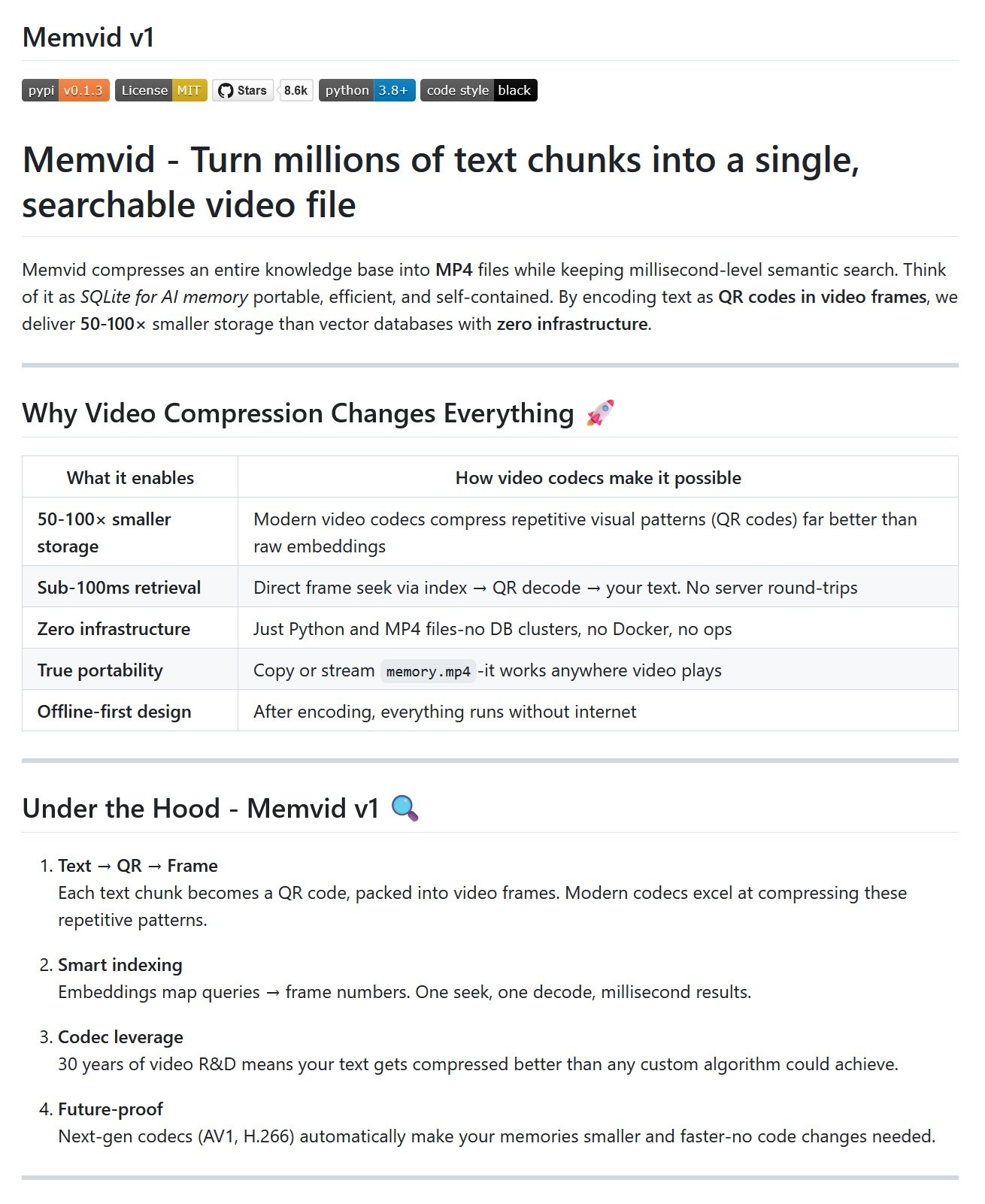

Ma cosa succederebbe se vi dicessi che esiste un modo per comprimere milioni di frammenti di testo in un semplice file MP4, mantenendo ricerche semantiche sotto il secondo? Benvenuti nel mondo di MemVid, un progetto che fa sembrare normale l'idea di trasformare i nostri video in banche dati intelligenti.

QR Code nel Frame: La Genesi di un'Idea Folle

MemVid, sviluppato dal team di Olow304 e disponibile su GitHub, parte da un'osservazione tanto semplice quanto rivoluzionaria: i codec video moderni sono straordinariamente efficienti nel comprimere pattern ripetitivi. E cosa sono i QR code se non pattern visivi altamente strutturati?

Il meccanismo è elegante nella sua apparente follia. Ogni chunk di testo viene prima processato per generarne l'embedding vettoriale - pensate a questo come l'impronta digitale semantica del contenuto. Contemporaneamente, il testo stesso viene codificato in un QR code e trasformato in un frame video. Il risultato? Un file MP4 che contiene letteralmente la vostra conoscenza di base, frame dopo frame.

Per chi non mastica quotidianamente machine learning, immaginate di trasformare ogni pagina di un'enciclopedia in un codice QR, poi montare tutti questi codici in un film. La magia sta nel fatto che i moderni codec video H.264 e H.265 riescono a comprimere questi pattern ripetitivi con un'efficienza che fa impallidire qualsiasi database tradizionale.

Il Video Digitale Incontra SQLite

La filosofia dietro MemVid richiama quella di SQLite: "portatile, efficiente e autonomo", ma applicata alla memoria dell'AI. Come in Tron Legacy dove Flynn digitalizza se stesso per entrare nel sistema, MemVid permette di "digitalizzare" intere conoscenze di base trasformandole in puri dati video accessibili istantaneamente.

Il processo di ricerca ha qualcosa di magico nella sua semplicità: quando fate una query, il sistema calcola l'embedding della vostra domanda, usa FAISS per trovare i vettori più simili nell'indice, identifica il frame corrispondente nel video, fa un seek diretto a quella posizione temporale e decodifica il QR code. Tutto questo avviene in meno di 100 millisecondi per corpus di un milione di chunk.

La bellezza tecnica risiede nel fatto che non c'è nessun database da gestire, nessun server da mantenere, nessuna infrastruttura cloud da monitorare. È il paradigma "copy and play" applicato all'AI: copiate il file MP4, e la vostra applicazione ha accesso a tutta la knowledge base.

Il Codec Come Alleato Segreto

Qui entra in gioco uno degli aspetti più affascinanti di MemVid: sfrutta trent'anni di ricerca e sviluppo nell'ottimizzazione video. I moderni codec comprimono i pattern ripetitivi dei QR code molto meglio di qualsiasi algoritmo custom per embedding, ottenendo rapporti di compressione che oscillano tra 50 e 100 volte rispetto ai database vettoriali tradizionali.

Per contestualizzare questi numeri, i benchmark mostrano che 100MB di testo possono essere compressi in 1-2MB di video, mantenendo tempi di ricerca inferiori al secondo anche su corpus da milioni di documenti. Un MacBook Pro del 2021 riesce a gestire questi volumi senza problemi, là dove soluzioni come pgvector richiedono 2-3 secondi anche con cache warm.

L'aspetto più intrigante è la scalabilità futura: ogni nuovo codec che esce automaticamente migliora le performance di MemVid senza richiedere modifiche al codice. AV1, H.266 e le future generazioni di codec renderanno i file ancora più piccoli e veloci, trasformando ogni update del settore video in un upgrade gratuito per l'AI memory.

Velocità e Performance: I Numeri Parlano

Le metriche di MemVid sfidano le convenzioni consolidate del settore. L'indicizzazione procede a circa 10.000 chunk al secondo su CPU moderne, mentre la ricerca mantiene latenze sotto i 100ms anche per un milione di chunk. Il consumo di memoria rimane costante sui 500MB indipendentemente dalla dimensione del dataset, un risultato che fa sembrare antiquate le architetture tradizionali che scalano linearmente con i dati.

Confrontando con i benchmark di settore, dove Qdrant raggiunge 626 query al secondo con recall del 99.5% su un milione di vettori, MemVid propone un paradigma completamente diverso: invece di massimizzare le query concurrent, ottimizza per la portabilità e l'efficienza di storage, mantenendo performance più che accettabili per la maggior parte dei casi d'uso.

Il vero asso nella manica è la distribuzione: condividere un corpus di conoscenza diventa semplice come inviare un file video. Niente deployment di database, niente configurazioni complesse, niente dipendenze server-side. È il "scrivi una volta, esegui ovunque" dell'AI memory.

Le Ombre della Rivoluzione

Come ogni innovazione dirompente, MemVid porta con sé limitazioni significative che non possono essere ignorate. La più evidente riguarda gli aggiornamenti: i file MP4 sono essenzialmente append-only, rendendo costoso modificare contenuti esistenti. Ogni piccolo cambiamento richiede una ri-codifica completa, un processo che può diventare proibitivo per applicazioni che richiedono aggiornamenti frequenti.

La sicurezza rappresenta un'altra zona grigia: chiunque abbia accesso al file MP4 può tecnicamente decodificare i QR code e accedere ai contenuti. Non esistono meccanismi built-in di controllo accesso granulare o crittografia a livello di frame. Per ambienti enterprise con stringenti requisiti di sicurezza, questo può essere un rompicapo.

La concorrenza è un altro tallone d'Achille: mentre multiple letture simultanee funzionano senza problemi, la scrittura concorrente è essenzialmente impossibile. In scenari dove più utenti devono aggiornare simultaneamente la knowledge base, MemVid mostra tutti i suoi limiti architetturali.

Infine, la scalabilità estrema rimane un punto interrogativo. Per corpus da miliardi di embedding con sharding distribuito, soluzioni consolidate come Vectara e Pinecone mantengono ancora un vantaggio.

L'Ecosistema Edge: Dove MemVid Trova Terreno Fertile

Il timing di MemVid coincide perfettamente con l'esplosione dell'edge computing e dell'IoT. Secondo le analisi di settore, i dispositivi IoT connessi genereranno 79,4 zettabyte di dati entro il 2025, un volume che renderebbe impraticabile l'elaborazione cloud tradizionale. In questo scenario, la capacità di MemVid di funzionare completamente offline con file autocontenuti diventa strategicamente rilevante.

L'edge computing market sta crescendo a un ritmo del 38% annuo, con 75 miliardi di dispositivi connessi previsti per il 2025. In questi contesti, dove latenza e autonomia sono critiche, la possibilità di distribuire knowledge base complete attraverso semplici file video elimina le dipendenze da connettività stabile e server remoti. Un sensore industriale può così trasformarsi in un sistema di analisi predittiva autonomo, caricando expertise di manutenzione da un file da pochi megabyte.

Il Conto Salato dell'AI: Quando la Memoria Costa

I numeri del mercato dei vector database dipingono uno scenario da capogiro economico. Il settore ha raggiunto i 2,2 miliardi di dollari nel 2024 e cresce a un ritmo del 21,9% annuo, trainato dalla fame insaziabile di dati delle applicazioni AI. Ma dietro questa crescita si nasconde una realtà meno romantica: i costi operativi che stanno mandando in rosso molte startup.

Per comprendere l'impatto economico di MemVid, considerate che costruire un data center AI di piccola scala costa tra 10 e 50 milioni di dollari, senza contare i costi operativi. Pinecone, uno dei leader del mercato, parte da piani gratuiti ma arriva a 500 dollari al mese per le versioni enterprise, mentre Qdrant offre un tier gratuito per circa 1 milione di vettori a 768 dimensioni. Numeri che sembrano ragionevoli, fino a quando non scalate a milioni di documenti e miliardi di embedding.

La crescita esplosiva delle ricerche per "vector database" è indicativa: aumentate di 11 volte tra gennaio 2023 e gennaio 2025, riflettendo la crescente consapevolezza del problema. In questo contesto, la proposta di valore di MemVid diventa cristallina: eliminare completamente l'infrastruttura database significa azzerare questi costi operativi ricorrenti, trasformandoli in un one-time cost per la generazione del file MP4.

La Democratizzazione Dell'AI Memory

L'aspetto più affascinante di MemVid trascende la pura ottimizzazione tecnica per toccare questioni di accessibilità democratica. In un panorama dove la crescita dei dati raggiungerà i 180 zettabyte entro il 2025, la complessità gestionale sta creando barriere sempre più alte per sviluppatori e organizzazioni di piccole dimensioni.

La semplicità di distribuzione di MemVid ricorda i primi giorni del web, quando condividere contenuti significava copiare file HTML su server FTP. Non servivano database administrator, non servivano cluster Kubernetes, non servivano team DevOps specializzati. Questa filosofia "democratica" si riflette nei numeri della popolarità GitHub: mentre Milvus raccoglie circa 25.000 stelle e Qdrant 9.000, progetti che abbassano le barriere tecniche guadagnano rapidamente trazione nella community.

L'implicazione è profonda: se MemVid mantiene le promesse, potremmo assistere a una esplosione di applicazioni AI sviluppate da team piccolissimi, liberati dalla necessità di gestire infrastrutture complesse. È il sogno punk dell'informatica: strumenti potenti nelle mani di chiunque abbia un'idea brillante e un laptop decente.

Le Sfide dell'Adozione: Più Sociali che Tecniche

La vera battaglia per MemVid non si combatte nei benchmark, ma nelle sale riunioni aziendali. La resistenza all'adozione di paradigmi radicalmente diversi è un fenomeno documentato nella sociologia dell'innovazione. Come osservato nel repository ufficiale, MemVid è ancora nella fase "experimental" della v1, con avvisi espliciti sui possibili cambiamenti di formato e API prima del rilascio stabile.

Questa incertezza tecnica si somma alle resistenze culturali tipiche del settore enterprise. L'idea di sostituire database relazionali consolidati con file video richiede un salto concettuale significativo. Tuttavia, i primi segnali di interesse dalla comunità open source sono incoraggianti: il progetto ha iniziato a raccogliere stelle su GitHub e contributi dalla community, suggerendo che almeno tra gli early adopter l'interesse è concreto. La sfida sarà dimostrare affidabilità e maturità sufficienti per convincere organizzazioni più conservative ad abbracciare questo approccio non convenzionale.

Verso MemVid 2.0: Il Futuro della Memoria AI

La roadmap di MemVid v2 promette evoluzioni significative: un Motore a memoria vivente che permette aggiornamenti incrementali, Capsule Context per condividere knowledge base con regole e scadenze personalizzate, e persino Time-Travel Debugging per ripercorrere e fare branch delle conversazioni.

Il team sta lavorando anche su Smart Recall, un sistema di cache locale che predice le informazioni necessarie e le precarica in meno di 5 millisecondi, e su Codec Intelligence, che ottimizza automaticamente i parametri per ogni tipo di contenuto.

L'ambizione è trasformare MemVid da curiosità tecnica a standard industriale, rendendo la gestione della memoria AI semplice quanto guardare un video.

Conclusioni: Il Paradigma che Cambia Tutto

MemVid rappresenta uno di quei momenti in cui l'innovazione emerge dall'intersezione inaspettata di tecnologie mature. Combinando trent'anni di ottimizzazioni video con le moderne necessità dell'AI, crea un paradigma che è al tempo stesso nostalgico e futuristico.

Non è la soluzione universale per ogni problema di vector storage, ma per casi d'uso specifico - applicazioni read-heavy, knowledge base offline, edge computing, distribuzione semplificata di corpus massivi - offre vantaggi ineguagliabili. È la dimostrazione che a volte le rivoluzioni nascono non dall'inventare qualcosa di nuovo, ma dal combinare l'esistente in modi che nessuno aveva mai immaginato.

Come diceva William Gibson, il futuro è già qui, è solo distribuito in modo non uniforme. MemVid potrebbe essere il modo per distribuirlo in un semplice file MP4.

MemVid è disponibile come progetto open source su GitHub sotto licenza MIT e installabile tramite pip install memvid.