KI als Werkzeug und nicht als Orakel: Der Fall Deloitte und die Illusion der Unfehlbarkeit

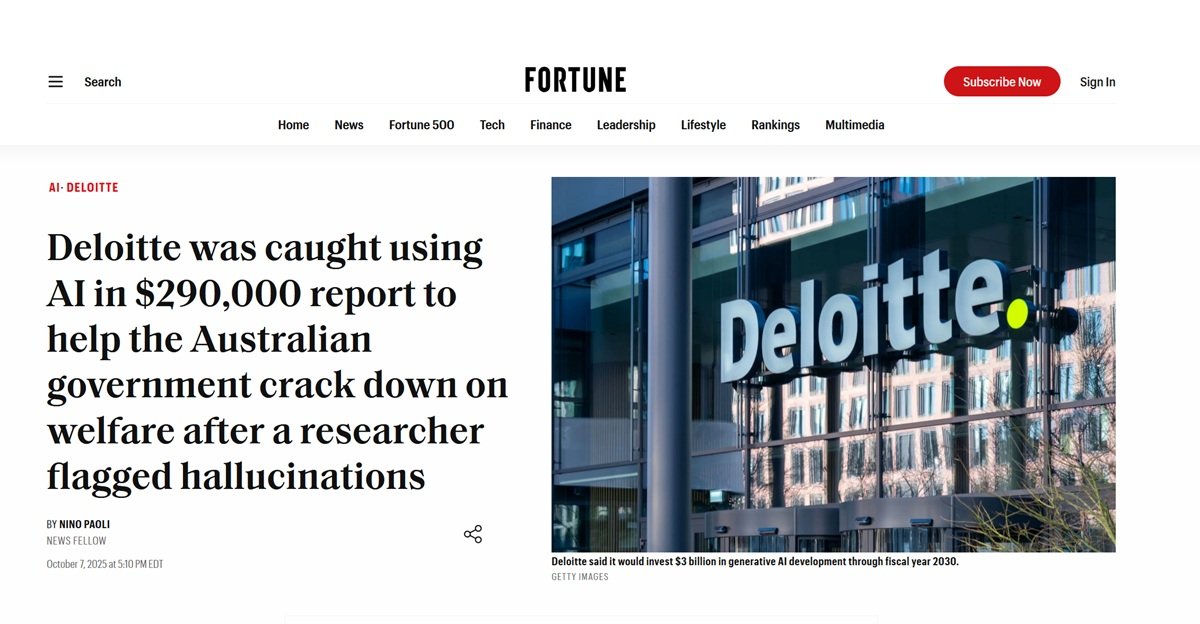

August 2025. Christopher Rudge, Forscher an der Universität Sydney und stellvertretender Direktor des Forschungszentrums Sydney Health Law, liest einen umfangreichen 237-seitigen Bericht, der einige Wochen zuvor von der australischen Regierung veröffentlicht wurde.

Das Dokument, das vom Ministerium für Beschäftigung und Arbeitsbeziehungen beim Beratungsriesen Deloitte für die bescheidene Summe von 439.000 australischen Dollar in Auftrag gegeben wurde, sollte den "Targeted Compliance Framework" überprüfen, ein automatisiertes System, das die Auszahlung von Sozialleistungen kontrolliert. Während er die Seiten voller akademischer und juristischer Verweise durchblättert, stimmt etwas nicht. Eine Zitat fällt ihm besonders auf: ein Urteil des Bundesgerichts, das als Eckpfeiler der Argumentation dienen sollte. Rudge überprüft es. Das Urteil existiert nicht. Es hat nie existiert.

Wie ein Detektiv, der an einem Faden zieht und sich mit einem ganzen Knäuel wiederfindet, beginnt der Forscher zu graben. Die Geisterzitate vervielfachen sich: nie veröffentlichte wissenschaftliche Artikel, nie gefällte Gerichtsentscheidungen, bibliografische Verweise, die ins Leere führen. Es handelt sich nicht um gelegentliche Fehler oder Tippfehler. Es ist ein ganzes Schloss, das auf nicht existierenden Fundamenten errichtet wurde, mit der formalen Präzision und der Selbstsicherheit, die für hochrangige Fachdokumente typisch sind. Rudge meldet alles den Medien und der Regierung. Das Ergebnis? Einer der peinlichsten Skandale in der jüngeren Geschichte der Unternehmensberatung und eine perfekte Fallstudie darüber, wie man künstliche Intelligenz nicht einsetzen sollte.

Das Schuldeingeständnis und der Preis der Fahrlässigkeit

Die Reaktion von Deloitte ließ, das muss man sagen, nicht lange auf sich warten. Ende September 2025 räumte das Unternehmen öffentlich ein, dass es Azure OpenAI GPT-4o für die Erstellung des ersten Entwurfs des Dokuments verwendet hatte. Kein marginales Unterstützungswerkzeug, kein Assistent für Entwürfe: Das Sprachmodell hatte große Teile des Berichts, einschließlich Zitate, generiert, die dann ohne angemessene Überprüfung im endgültigen Dokument landeten. Dem Eingeständnis folgten eine korrigierte Version des Berichts, die von den erfundenen Zitaten bereinigt war, und die Ankündigung einer teilweisen Rückerstattung an die australische Regierung. Aber der Schaden war, wie man so schön sagt, bereits angerichtet.

Was den Fall Deloitte besonders bedeutsam macht, ist nicht so sehr der technologische Fehler an sich, sondern die Haltung, die ihn ermöglicht hat. Wir sprechen von einer der vier großen globalen Beratungsfirmen, einer Organisation mit mehrschichtigen Qualitätssicherungsprozessen, erfahrenen Prüfern und verantwortlichen Partnern. Doch irgendwo in der Produktionskette hat jemand entschieden, dass der von GPT-4o generierte Text zuverlässig genug sei, um keine eingehende Überprüfung der Quellen zu erfordern. Es ist, als ob ein Archäologe eine sensationelle Entdeckung auf der Grundlage von Gerüchten aus der Nachbarschaft statt auf Ausgrabungen veröffentlichen würde, oder als ob Borges seine Bibliothek von Babel nicht als literarische Fiktion, sondern als realen Katalog geschrieben hätte. Nur dass es hier keine postmoderne Ironie gibt: Es gibt einen Regierungsbericht im Wert von fast einer halben Million Dollar, der die öffentliche Politik hätte leiten sollen.

Die stille Epidemie der digitalen Halluzinationen

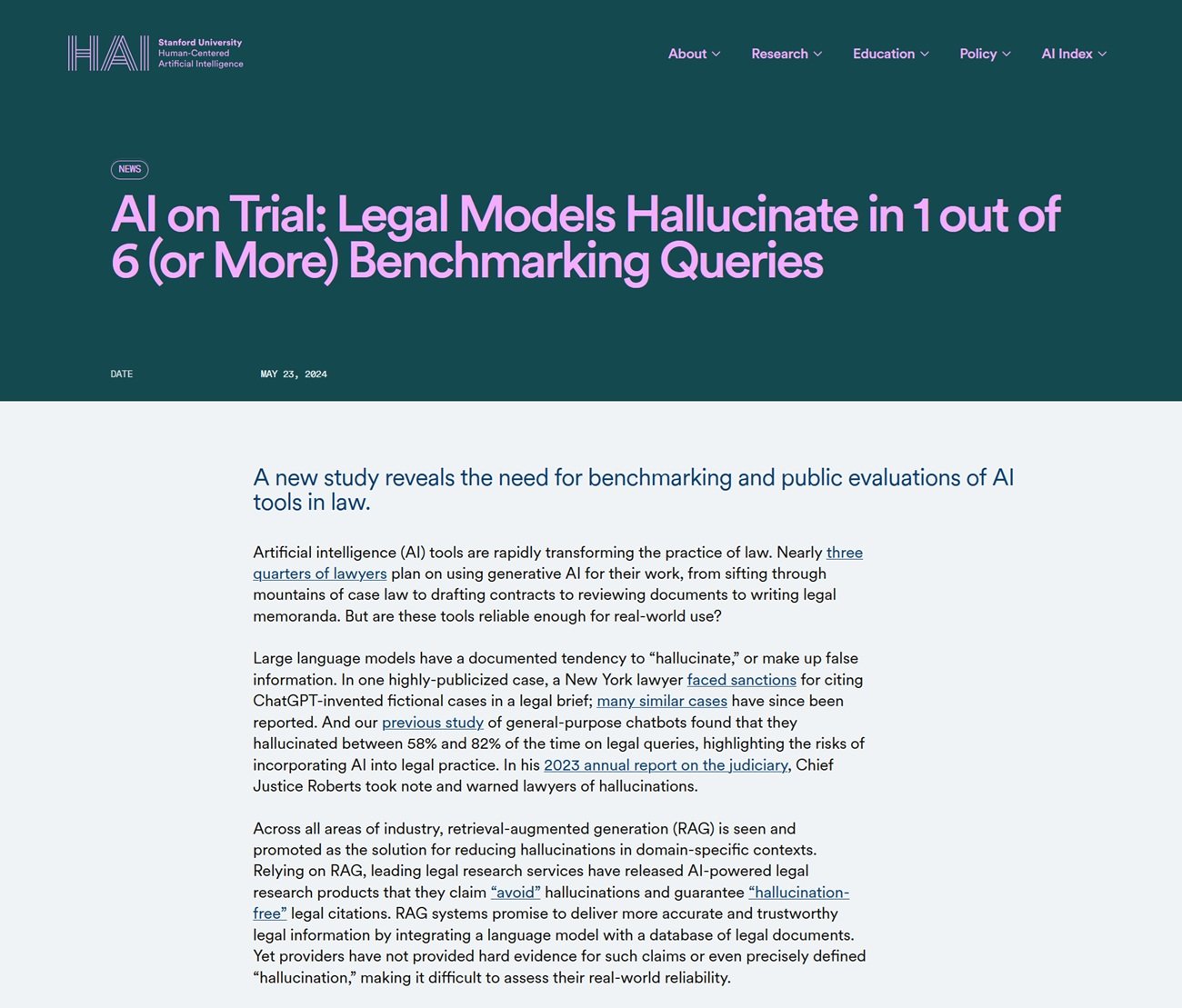

Der Fall Deloitte ist kein schwarzer Schwan, keine isolierte Anomalie in der Landschaft der KI-Einführung. Er ist vielmehr die sichtbarste Spitze eines Eisbergs, der mit zunehmender Deutlichkeit auftaucht. Im Mai 2023 geriet ein New Yorker Anwalt namens Steven Schwartz ins Rampenlicht, weil er in einem Gerichtsantrag sechs vollständig von ChatGPT erfundene frühere Fälle zitiert hatte. Richter Kevin Castel nahm das nicht gut auf und verhängte Sanktionen. Im September 2025 erhielt ein kalifornischer Anwalt, Amir Mostafavi, eine historische Geldstrafe vom Berufungsgericht, nachdem sich herausstellte, dass 21 der 23 Zitate in seinem Schriftsatz falsch waren, von ChatGPT generiert und nie überprüft wurden.

Das Problem betrifft nicht nur die Beratung und die juristischen Berufe. Vor einigen Tagen veröffentlichte die italienische Zeitung "La Provincia" aus Civitavecchia einen Nachrichtenartikel, der mit einem aufschlussreichen Satz endete: "Möchten Sie, dass ich ihn in einen Artikel für eine Zeitung (mit Überschrift, Unterüberschrift und journalistischem Layout) oder in eine erzählerischere Version für ein investigatives Magazin umwandle?". Es war die unverkennbare Ausgabe von ChatGPT, die gedruckt wurde, ohne dass jemand bemerkte, dass es sich nicht um redaktionellen Text, sondern um die typische Abschlussaufforderung des KI-Assistenten handelte.

Der Vorfall, so peinlich er auch ist, ist nicht wegen des Fauxpas an sich von Bedeutung, sondern wegen dem, was er aufdeckt: Selbst im Journalismus, einem Bereich, in dem die Überprüfung von Quellen berufliche DNA sein sollte, führt die Versuchung, das Schreiben ohne angemessene Aufsicht an die KI zu delegieren, zu Ausrutschern. Der Chefredakteur sprach von "menschlichem Versagen" und kündigte strengere Verfahren an, aber das Muster ist dasselbe wie bei Deloitte: leistungsstarke Werkzeuge, die leichtfertig eingesetzt werden, in dem Glauben, dass die makellose Form des generierten Textes zuverlässigen Inhalten entspricht. Der Unterschied ist, dass hier der Fehler so offensichtlich war, dass er sofort sichtbar war, während erfundene akademische Zitate oder falsche juristische Verweise monatelang unbemerkt bleiben können.

Aber das Phänomen geht weit über die Fälle hinaus, die in den Zeitungen gelandet sind oder von Zeitungen generiert wurden. Laut einer Studie aus Stanford, die 2025 veröffentlicht wurde, produzieren selbst auf den Rechtssektor spezialisierte Sprachmodelle in mindestens einem von sechs Fällen Halluzinationen, während generalistische Chatbots bei juristischen Fragen Fehlerraten zwischen 58 % und 82 % erreichen. Ein Rechtsforscher namens Damien Charlotin hat drei wiederkehrende Arten dieser Halluzinationen identifiziert: Zitate von vollständig erfundenen Fällen, korrekte Zitate aus realen Fällen mit gefälschtem Inhalt und die heimtückischste von allen, formal exakte Zitate, die das Argument, für das sie herangezogen werden, überhaupt nicht stützen.

Dieser letzte Typ ist besonders gefährlich, weil er die oberflächliche Überprüfung umgeht. Der Fall existiert, das Zitat ist korrekt formatiert, aber wenn man das Urteil tatsächlich liest, stellt man fest, dass es etwas völlig anderes besagt. Es ist, als würde Lovecrafts Necronomicon tatsächlich existierende Werke von Poe und Bierce zitieren, ihnen aber völlig andere Inhalte zuschreiben: Die Form ist perfekt, die Substanz ist phantasmagorisch.

Anatomie einer Halluzination: Warum erfindet die KI mit solcher Sicherheit?

Um zu verstehen, was im Fall Deloitte passiert ist, müssen wir einen Schritt zurückgehen und verstehen, wie große Sprachmodelle wie GPT-4o wirklich funktionieren. Diese Systeme sind außergewöhnliche Maschinen zur statistischen Sprachvorhersage: Bei einem gegebenen Kontext berechnen sie, welche Wortsequenz am wahrscheinlichsten mit diesem Kontext übereinstimmt, basierend auf Milliarden von Beispielen, die während des Trainings gesehen wurden. Sie sind unglaublich gut darin, Muster, rhetorische Strukturen und Schreibkonventionen zu erfassen. Wenn man sie bittet, ein akademisches Zitat im richtigen Format zu generieren, mit Autoren, Titel, Jahr und Zeitschrift, weiß das Modell perfekt, wie dieses Zitat aussehen sollte. Es hat Tausende ähnlicher Beispiele gesehen.

Aber hier liegt das grundlegende Problem: Das Modell weiß nicht, ob dieses Zitat wirklich existiert. Es hat keinen Zugang zu einer Verifizierungsdatenbank, es prüft не, ob der Artikel "Smith, J. (2023). AI Governance in Welfare Systems. Journal of Public Administration" jemals veröffentlicht wurde. Es generiert einfach eine Textzeichenfolge, die wie ein plausibles Zitat aussieht, basierend auf sprachlichen Mustern. Es ist wie ein so geschickter Fälscher, dass er den Stil von Vermeer perfekt nachbilden kann, aber das Originalgemälde nie gesehen hat, weil es nicht existiert: Er erschafft eine Fälschung eines imaginären Werks.

Diese Eigenschaft von LLMs ist in der Fachliteratur als "Halluzination" bekannt, ein vielleicht zu poetischer Begriff, um zu beschreiben, was im Wesentlichen ein Designfehler ist. Sprachmodelle wurden optimiert, um überzeugend, flüssig und formal kohärent zu sein. Die faktische Wahrheit ist eine emergente Eigenschaft, nicht das primäre Ziel der Architektur. Wenn der Kontext genügend überprüfbare Informationen liefert, können moderne Modelle wie GPT-4o überraschend genau sein. Aber wenn sie "die Lücken füllen" müssen, wenn die Trainingsdatenbank nicht die exakte Antwort enthält, wechseln sie nahtlos von der Wiedergabe gespeicherter Fakten zur plausiblen Erfindung. Und das tun sie mit demselben durchsetzungsfähigen Ton, derselben makellosen Formatierung, demselben professionellen Register.

Das eigentliche Problem: die Illusion der Unfehlbarkeit

Der Kern der Deloitte-Katastrophe ist nicht technologischer, sondern kultureller Natur. Es ist die Haltung, mit der man sich dem Werkzeug genähert hat. Irgendwo in dieser Produktionskette des Berichts wurde eine Entscheidung getroffen: GPT-4o nicht als Generator von Entwürfen zu betrachten, die Wort für Wort überprüft werden müssen, sondern als zuverlässige Quelle, eine Art erfahrener Ghostwriter, der bereits veröffentlichungsreife Inhalte produziert. Es ist ein grundlegender Kategorienfehler, vergleichbar mit dem Verwechseln eines Flugsimulators mit einem echten Flugzeug: Die oberflächliche Ähnlichkeit verschleiert wesentliche und kritische Unterschiede.

Diese unkritische Haltung wird durch eine gefährliche Erzählung genährt, die die zeitgenössische künstliche Intelligenz umgibt. Technologieunternehmen, die verständlicherweise daran interessiert sind, die Akzeptanz zu maximieren, neigen dazu, die Fähigkeiten ihrer Systeme zu betonen, indem sie sie als quasi-allwissend darstellen. Das Marketing spricht von "Denken", "Verstehen", von Systemen, die "denken" und "verstehen". Diese absichtliche Anthropomorphisierung schafft unrealistische Erwartungen und senkt die Hemmschwelle. Wenn die KI mein Problem "versteht", warum sollte ich dann an ihren Antworten zweifeln?

Der von NPR dokumentierte Fall bezüglich der Anwälte von MyPillow ist in diesem Sinne beispielhaft. Juristen, die in kritischem Denken und Quellenprüfung geschult sind, haben ChatGPT die juristische Recherche anvertraut und dann die Schriftsätze eingereicht, ohne sie zu überprüfen. Nicht aus böser Absicht, sondern weil die Konversationsschnittstelle des Chatbots, seine formale Sicherheit und die Kohärenz seiner Antworten eine Illusion von Kompetenz geschaffen haben. Das System hat nie gesagt "Achtung, dieses Zitat könnte erfunden sein". Es hat einfach plausiblen Text generiert, wie es dafür konzipiert wurde.

Die systemischen Implikationen: Jenseits der unternehmerischen Peinlichkeit

Wenn es um den Deloitte-Bericht geht, gehen die Konsequenzen weit über die Peinlichkeit eines multinationalen Konzerns und die Rückerstattung von ein paar hunderttausend Dollar hinaus. Das Dokument sollte ein automatisiertes System überprüfen, das die Gewährung von Sozialleistungen für schutzbedürftige Personen beeinflusst. Politische Empfehlungen, die auf nicht existierenden Grundlagen beruhen, hätten Entscheidungen mit realen Auswirkungen auf das Leben der Bürger leiten können. Wäre der Targeted Compliance Framework nach Vorschlägen geändert worden, die auf falschen Zitaten beruhen, hätten sich die Auswirkungen durch die gesamte Kette des Sozialsystems fortgepflanzt.

Dies wirft eine umfassendere Frage nach dem epistemischen Vertrauen in zeitgenössischen Gesellschaften auf. Wir leben in einer Zeit, in der die direkte Überprüfung von Quellen für den Durchschnittsbürger immer schwieriger wird. Wir verlassen uns notwendigerweise auf als zuverlässig geltende Vermittler: Universitäten, Zeitungen, Beratungsunternehmen, Regierungsinstitutionen. Wenn diese Vermittler beginnen, die Produktion von Wissen an Systeme zu delegieren, die mit Leichtigkeit erfinden, ohne strenge Überprüfungsprotokolle zu implementieren, bricht die gesamte Vertrauenskette zusammen. Es ist keine Verschwörungsparanoia festzustellen, dass, wenn Deloitte der australischen Regierung einen Bericht voller Geisterzitate liefern kann, andere ähnliche Dokumente in anderen Kontexten unentdeckt zirkulieren könnten.

Die Washington Post hat dokumentiert, wie amerikanische Richter mit zunehmender Strenge auf diese Fälle reagieren und immer höhere Strafen verhängen. Aber Geldstrafen für fahrlässige Anwälte sind nur Pflaster auf einer tieferen Wunde. Das strukturelle Problem ist, dass wir eine technologische Übergangsphase durchlaufen, ohne noch die geeigneten kulturellen und professionellen Protokolle entwickelt zu haben. Es ist, als ob die Druckerpresse erfunden worden wäre, aber moderne redaktionelle Konventionen, von der Peer-Review bis zur verifizierten Bibliographie, noch nicht existierten.

Die methodische Lektion: Werkzeuge, nicht Orakel

Die Technologie der generativen künstlichen Intelligenz ist außerordentlich leistungsfähig. GPT-4o und seine Zeitgenossen können kreative Prozesse dramatisch beschleunigen, riesige Informationskorpora zusammenfassen, nicht offensichtliche Zusammenhänge vorschlagen und in Sekundenschnelle mehrere Varianten eines Textes generieren. Richtig eingesetzt, sind sie Multiplikatoren menschlicher Fähigkeiten. Das Problem entsteht, wenn sie als Ersatz für menschliches Urteilsvermögen und nicht als Verstärker behandelt werden.

Die Unterscheidung ist entscheidend. Ein Verstärker verstärkt das, was bereits vorhanden ist: Wenn Sie über Fachwissen verfügen, kann die KI Sie schneller und effizienter machen. Aber wenn Sie Ihr Fachwissen vollständig an das Werkzeug delegieren, funktioniert die Verstärkung auch für Fahrlässigkeit und Fehler. Es ist das Paradox des positiven Feedbacks: Die KI ermöglicht es Ihnen, mehr zu produzieren, aber wenn "mehr" ungeprüfte Inhalte enthält, multiplizieren Sie einfach die Menge an Müll, die im System zirkuliert.

Im spezifischen Kontext der professionellen Beratung bedeutet dies, den Arbeitsablauf vollständig neu zu gestalten. Als Deloitte den Vorfall zugab, kündigte es auch die Einführung strengerer Protokolle für den Einsatz von KI an. Aber was sollten diese Protokolle sein? Die Antwort ergibt sich klar aus dem Scheitern selbst: Jedes von der KI generierte Zitat muss manuell überprüft werden. Jede sachliche Behauptung muss gegen Primärquellen geprüft werden. Jedes Argument muss auf tatsächlich existierende Dokumente zurückführbar sein. Im Wesentlichen muss die Ausgabe der KI als ein Entwurf von variabler Qualität behandelt werden, der von einem brillanten, aber unzuverlässigen Praktikanten erstellt wurde, nicht als fertiges Produkt.

Dieser Ansatz erfordert Zeit und Aufmerksamkeit, genau die Ressourcen, die die KI eigentlich einsparen sollte. Aber es ist der einzige Weg, Katastrophen zu vermeiden. Der Effizienzgewinn durch KI kann nicht dadurch entstehen, dass die Überprüfungsphase übersprungen wird, sondern dadurch, dass die Phase der Erstellung des ersten Entwurfs beschleunigt wird. Hätte Deloitte GPT-4o eingesetzt, um schnell eine anfängliche Struktur zu erstellen, und dann die eingesparte Zeit für eine sorgfältige Überprüfung aufgewendet, wäre das Ergebnis sowohl effizient als auch genau gewesen. Stattdessen wurde Zeit am falschen Ende des Prozesses "gespart", an dem, das Professionalität von Fahrlässigkeit trennt.

Auf dem Weg zu einer Kultur der algorithmischen Verantwortung

Der Fall Deloitte ereignet sich zu einem besonderen Zeitpunkt in der Geschichte der künstlichen Intelligenz. Wir haben die unkritische Begeisterung der Early Adopters hinter uns gelassen, sind aber noch nicht zu einer weit verbreiteten Reife im Umgang mit diesen Werkzeugen gelangt. Organisationen befinden sich in einem unbequemen Zwischenbereich: Der Wettbewerbsdruck zwingt zur Einführung von KI, um nicht ins Hintertreffen zu geraten, aber die Fähigkeiten, sie verantwortungsvoll zu nutzen, sind ungleich verteilt, oft auf wenige Spezialisten konzentriert, während die Masse der Nutzer LLMs als unfehlbare Suchmaschinen behandelt.

Es bedarf einer kulturellen Revolution mehr als einer technologischen. Unternehmen müssen aufhören, KI als Wettbewerbsvorteil zu betrachten, der schnell umgesetzt werden muss, und anfangen, sie als eine Dual-Use-Technologie zu sehen, die eine strenge Governance erfordert. Das bedeutet ernsthafte Schulungen, nicht dreistündige Tutorials. Es bedeutet regelmäßige Audits der Prozesse, in denen KI involviert ist. Es bedeutet vor allem, Vorsicht statt Geschwindigkeit zu belohnen, diejenigen zu schätzen, die methodische Zweifel äußern, statt diejenigen, die schnell liefern.

Die akademische und berufliche Welt reagiert. Immer mehr wissenschaftliche Zeitschriften verlangen von den Autoren, dass sie die Verwendung von KI explizit angeben, und viele haben die Verwendung von LLMs zur Generierung wesentlicher Teile von Artikeln gänzlich verboten. Gerichte in mehreren Ländern führen Regeln ein, die eine Zertifizierung der Genauigkeit von Zitaten in Gerichtsakten erfordern, mit persönlicher Verantwortung für die Anwälte. Dies sind notwendige, aber noch fragmentarische Antworten.

Es bedarf branchenübergreifender Standards. Wenn ein Fachdokument KI-generierte Inhalte enthält, sollte dies klar angegeben werden, mit Angabe der betroffenen Abschnitte und der angewandten Überprüfungsprotokolle. Nicht um den Einsatz von Technologie zu stigmatisieren, sondern um den Prozess der Wissensproduktion transparent zu machen. Es ist dasselbe Prinzip, das uns veranlasst, die Zutatenliste auf Lebensmitteln oder die Methodik in wissenschaftlichen Studien zu verlangen: nicht weil wir böse Absicht unterstellen, sondern weil Transparenz eine informierte Bewertung und Vertrauen ermöglicht.

Weder Apokalypse noch Utopie: das notwendige Gleichgewicht

Es wäre einfach, angesichts des Falles Deloitte und seiner kleineren Geschwister in der Rechtswelt in zwei entgegengesetzte und gleichermaßen kontraproduktive Rhetoriken zu verfallen. Die erste ist die Apokalypse: Die KI wird uns mit Unwahrheiten überschwemmen, es unmöglich machen, wahr von falsch zu unterscheiden, und das epistemische Vertrauen zerstören, auf dem komplexe Gesellschaften beruhen. Die zweite ist die Utopie: Das sind nur Kinderkrankheiten, der Fehler ist menschlich (oder in diesem Fall des menschlichen Benutzers), die Technologie wird sich weiter verbessern und diese Probleme werden von selbst verschwinden.

Beide Narrative sind unzureichend. Die generative KI bringt nicht die Apokalypse der Wahrheit, aber sie erleichtert sicherlich die Produktion von plausiblem, aber falschem Inhalt im industriellen Maßstab. Dieses Risiko zu ignorieren, ist unverantwortlich. Andererseits werden sich die Probleme nicht auf magische Weise mit der nächsten Generation von Modellen lösen. Selbst wenn GPT-5 oder Claude-4 niedrigere Halluzinationsraten haben, werden sie nie perfekt sein. Der Punkt ist nicht, auf eine unfehlbare KI zu warten, sondern Arbeitspraktiken zu entwickeln, die die Unvollkommenheit als Ausgangspunkt nehmen.

Christopher Rudge, der Forscher, der den Fall aufgedeckt hat, ist kein technologiefeindlicher Luddit. Er ist ein Gelehrter, der einfach das getan hat, was jeder tun sollte, der sich mit einem Fachdokument befasst: Er hat die Quellen überprüft. Seine Tat ist nicht heroisch, sie ist banal professionell. Die Tatsache, dass sie notwendig war, dass das Qualitätskontrollsystem einer der Big Four diese Geisterzitate nicht entdeckt hat, ist der eigentliche Skandal. Und die Lehre ist klar: Egal wie ausgeklügelt die KI wird, die letzte Verteidigungslinie gegen Fehler ist immer die kritische menschliche Aufmerksamkeit.

Die 439.000 australischen Dollar, die Deloitte zurückerstattet hat, sind kaum mehr als eine Fußnote in einer milliardenschweren Bilanz. Die wahren Kosten dieses Falles sind rufschädigend, könnten sich aber in einen systemischen Nutzen verwandeln, wenn sie richtig gelesen werden: nicht als peinlicher Vorfall eines Unternehmens, sondern als Symptom eines weit verbreiteten Problems, das eine kollektive Antwort erfordert. Werkzeuge sind neutral. Es ist der Gebrauch, den wir von ihnen machen, der definiert, ob sie unsere Intelligenz oder unsere Fahrlässigkeit verstärken. Und diese Wahl bleibt, und muss bleiben, hartnäckig menschlich.