La IA te hace más hábil, no más sabio. Sobreestimar los propios conocimientos

Imagínate hacer el examen de admisión a la facultad de derecho estadounidense con ChatGPT a tu lado. Los resultados mejoran sensiblemente: tres puntos más que quienes se enfrentan al examen solos. Sin embargo, cuando se te pide que evalúes tu propio rendimiento, te equivocas por cuatro puntos por exceso. Y no solo eso: cuanto más conoces técnicamente el funcionamiento de la inteligencia artificial, más se amplifica esta ilusión de competencia. Bienvenido a la paradoja de la cognición aumentada, donde ser más bueno significa al mismo tiempo perder la capacidad de entender lo bueno que realmente eres.

La paradoja del rendimiento aumentado

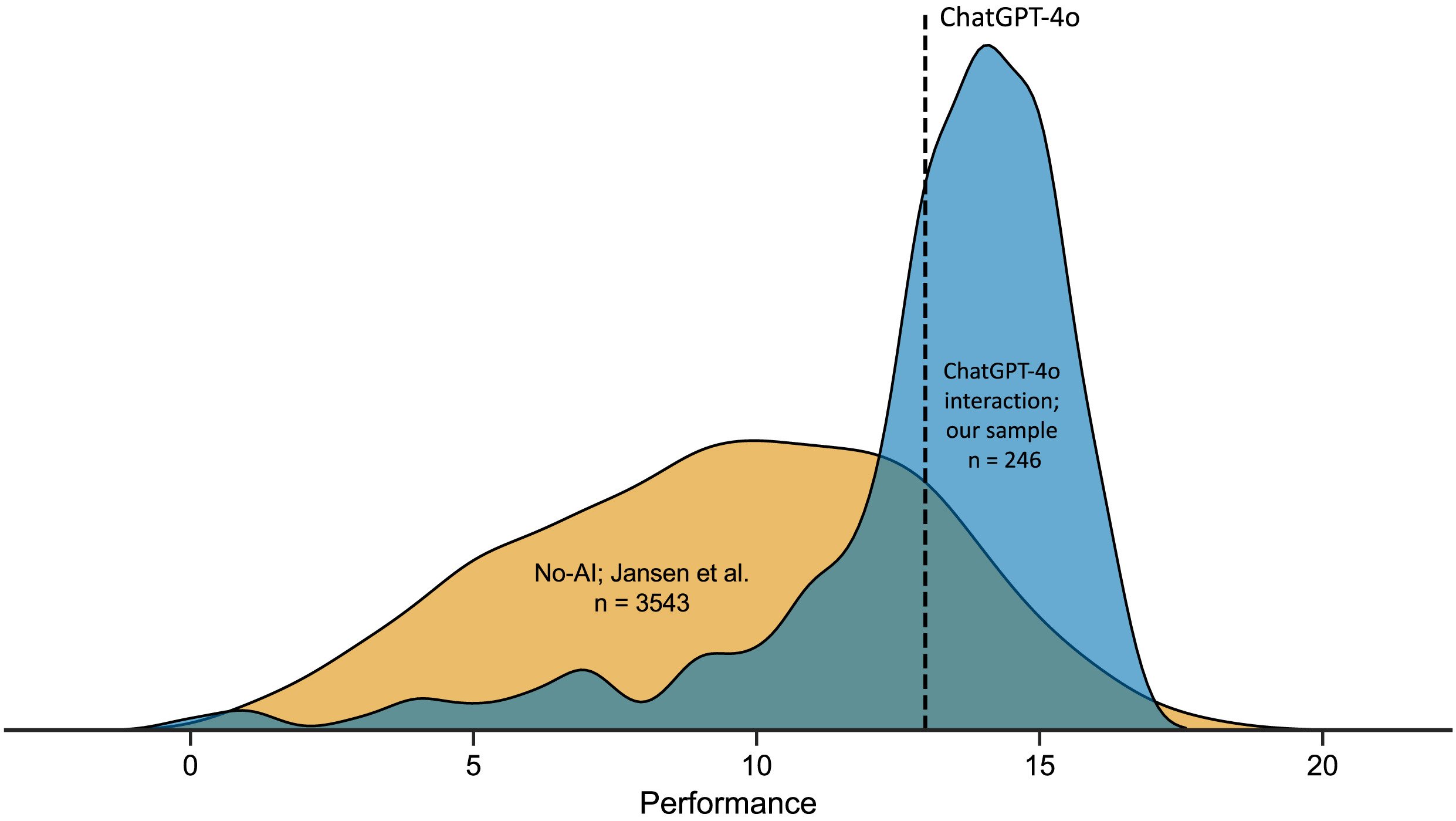

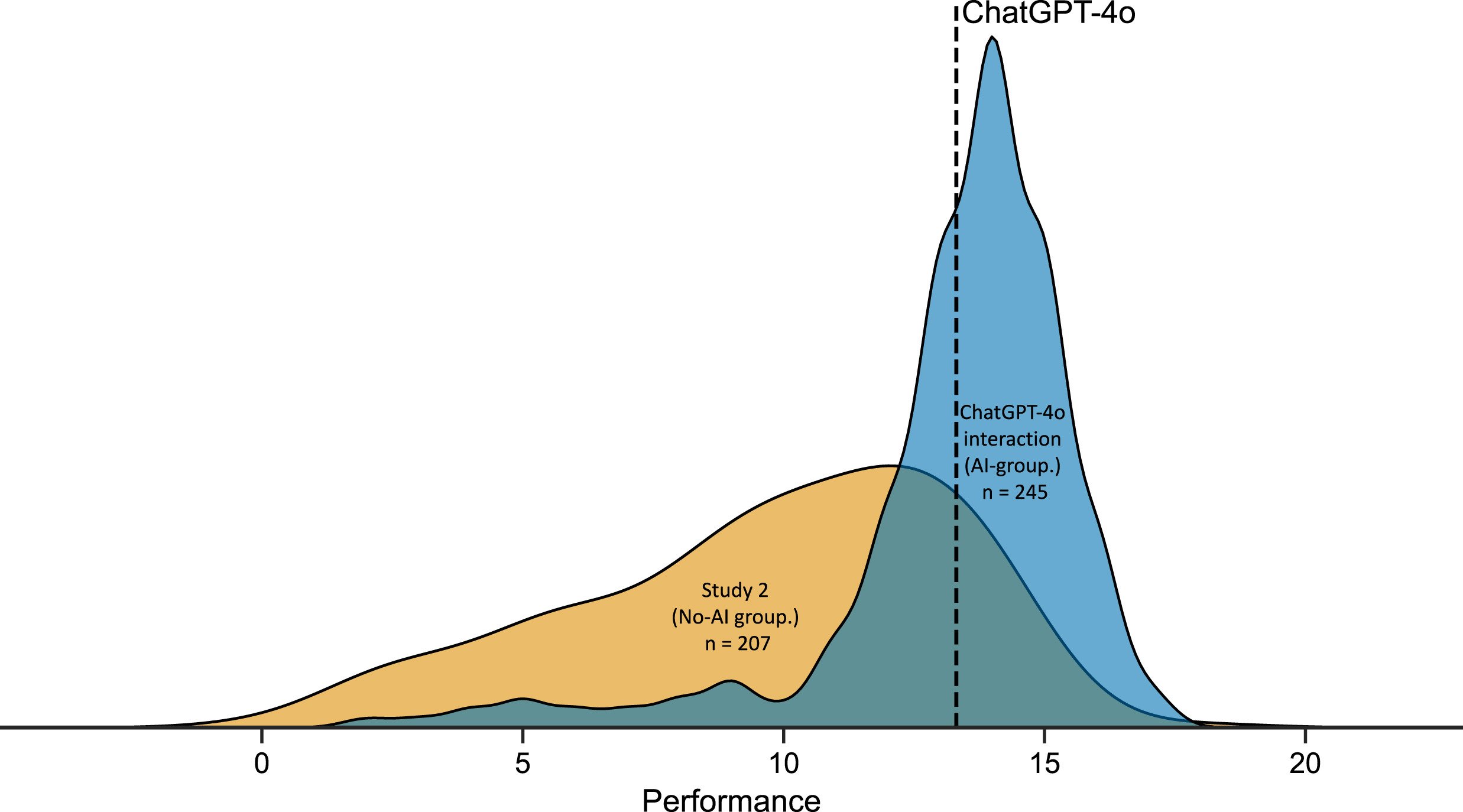

La investigación llevada a cabo por la Universidad de Aalto y publicada en Computers in Human Behavior sometió a 246 participantes a veinte preguntas de razonamiento lógico extraídas del LSAT, el examen estandarizado para el acceso a las facultades de derecho estadounidenses. La mitad de la muestra podía consultar libremente ChatGPT-4o durante la resolución, la otra mitad procedía de forma autónoma. Las cifras cuentan una historia ambivalente: quienes usaban la IA obtenían puntuaciones medias de 12,98 sobre 20, frente a los 9,45 de quienes trabajaban sin asistencia. Una mejora del 37% que, sobre el papel, confirmaría las promesas de la inteligencia aumentada.

Pero hay un detalle incómodo. Cuando se les pedía a los participantes del grupo de IA que estimaran cuántas respuestas habían dado correctamente, la media de sus predicciones se situaba en 16,50 sobre 20. Una sobreestimación sistemática de unos cuatro puntos, el doble que la del grupo de control. Como si el acceso a una herramienta potente no solo hubiera potenciado sus capacidades efectivas, sino que al mismo tiempo hubiera distorsionado la percepción de esas capacidades en una medida aún mayor.

El fenómeno recuerda esa sensación que todos hemos experimentado al navegar por Wikipedia a las tres de la mañana: después de leer tres artículos sobre el exoesqueleto de los crustáceos, nos sentimos de repente expertos en biología marina. Los psicólogos llaman a este mecanismo "ilusión de profundidad explicativa", y funciona así: cuando una información es fácilmente accesible, nuestro cerebro la confunde con información poseída. En el caso de la IA, sin embargo, el efecto se amplifica por la naturaleza conversacional de la interacción: ChatGPT no se limita a devolver un dato, construye una narración articulada que imita el propio proceso cognitivo.

Daniela Fernandes, primera autora del estudio, observó que la mayoría de los participantes interactuaba con ChatGPT de forma sorprendentemente superficial. El 46% enviaba un solo prompt por problema, copiando la pregunta en la interfaz y aceptando la respuesta sin más profundización. Es como fiarse del primer resultado de una búsqueda en Google sin verificar las fuentes, pero con consecuencias más sutiles: no solo estás delegando la búsqueda de información, estás externalizando el propio proceso de razonamiento.

La desaparición del efecto Dunning-Kruger

Durante décadas, uno de los fenómenos más estudiados en psicología cognitiva ha sido el efecto Dunning-Kruger: esa tendencia sistemática de los individuos menos competentes a sobrevalorar drásticamente sus propias habilidades, mientras que los más preparados tienden a una modesta subestimación. Es el principio que explica por qué el colega que apenas sabe abrir una hoja de Excel se ofrece con seguridad para gestionar la base de datos de la empresa, mientras que el ingeniero informático duda antes de dar una opinión.

En las pruebas de razonamiento lógico realizadas sin IA, este patrón emerge con regularidad matemática: quienes se sitúan en el perfil más bajo de rendimiento tienden a creer que pertenecen a la franja medio-alta, quienes destacan a menudo se posicionan más bajo de lo que merecerían. Es un efecto de calibración inversamente proporcional a la competencia efectiva, alimentado por lo que los investigadores llaman "ruido metacognitivo": el ruido de fondo que interfiere con nuestra capacidad de autoevaluación.

Pero cuando los investigadores de Aalto aplicaron un modelo computacional bayesiano a los datos del grupo que usaba ChatGPT, descubrieron algo inesperado. El efecto Dunning-Kruger simplemente desaparecía. No se reducía ni se atenuaba: dejaba de existir como patrón estadísticamente relevante. Todos los participantes, independientemente de su rendimiento efectivo, mostraban niveles similares de sobreestimación. Como si la IA hubiera nivelado no solo las competencias, sino también la incapacidad de evaluarlas con precisión.

El mecanismo subyacente es contraintuitivo pero lógico. El efecto Dunning-Kruger surge de la correlación entre la habilidad en la tarea y la habilidad metacognitiva, es decir, la capacidad de supervisar la calidad del propio razonamiento. Quien es bueno resolviendo problemas lógicos también es bueno reconociendo cuándo su solución se sostiene o se desmorona. Pero cuando entra en juego ChatGPT, esta correlación se rompe: la IA proporciona resultados de calidad relativamente uniforme a todos, independientemente de la capacidad del usuario individual para evaluar su validez. El resultado es un rendimiento nivelado hacia arriba y una metacognición nivelada hacia abajo. Todos mejoran, pero nadie sabe realmente cuánto.

Robin Welsch, psicólogo cognitivo y supervisor de la investigación, observó que esto representa una inversión de la hipótesis del aumento cognitivo formulada en los años 60 por Doug Engelbart. La idea original era que las tecnologías podían amplificar el intelecto humano manteniendo o mejorando la conciencia crítica. En cambio, estamos asistiendo a una amplificación asimétrica: las capacidades crecen, la sabiduría se estanca.

La alfabetización tecnológica como bumerán

Si hay un resultado del estudio que invierte las suposiciones comunes sobre la relación entre la competencia y el uso consciente de la tecnología, es la correlación entre la alfabetización en IA y la precisión metacognitiva. Los investigadores midieron la alfabetización en IA de los participantes utilizando la escala SNAIL (Scale for the assessment of non-experts' AI literacy), que evalúa tres dimensiones: la comprensión técnica del funcionamiento de los sistemas, la capacidad de evaluación crítica de los resultados y la habilidad en la aplicación práctica.

Lo que se esperaría es una relación positiva: quienes conocen mejor la IA deberían usarla de forma más consciente, reconocer sus límites, calibrar mejor la confianza en sus sugerencias. En cambio, los datos muestran lo contrario. Los participantes con puntuaciones más altas en la dimensión de "comprensión técnica" eran sistemáticamente menos precisos en sus autoevaluaciones. Cuanto más sabían de ingeniería de prompts, temperatura de los modelos y arquitecturas de transformadores, más sobrevaloraban la calidad de su trabajo con la IA.

Es un efecto que recuerda a esa escena de Primer, la película de culto de Shane Carruth sobre los viajes en el tiempo, en la que los protagonistas se sumergen tanto en la complejidad técnica de su máquina que pierden por completo de vista las implicaciones de lo que están construyendo. La familiaridad con el mecanismo no garantiza la sabiduría en el uso. Al contrario, puede crear una falsa sensación de control: "Sé cómo funciona esto, así que puedo confiar en los resultados que me da".

Thomas Kosch, experto en interacción hombre-máquina y coautor del estudio, sugiere que esta paradoja se deriva de un malentendido fundamental sobre lo que significa "conocer" un sistema de IA. Comprender técnicamente un modelo de lenguaje grande significa saber que procesa texto a través de capas de atención, que predice el siguiente token mediante la maximización de la probabilidad, que se puede ajustar con conjuntos de datos específicos. Pero este conocimiento procedimental no se traduce automáticamente en conciencia epistémica: saber cuándo el modelo está produciendo una respuesta fiable y cuándo simplemente está generando texto plausible.

El grupo de investigación encontró una correlación positiva entre los tres factores de la escala SNAIL y la confianza media de los participantes. Quienes sabían más se sentían más seguros. Pero esta seguridad no se traducía en una mejor capacidad para discriminar entre respuestas correctas e incorrectas: el área bajo la curva ROC, que mide qué tan bien los juicios de confianza predicen la precisión real, se mantenía estable o incluso disminuía al aumentar la alfabetización en IA. Cuanto más sabes, más confías, pero no necesariamente juzgas mejor.

El colapso de la metacognición

Para entender cuán profundo es el déficit metacognitivo inducido por el uso de la IA, los investigadores analizaron no solo las estimaciones globales de rendimiento (¿cuántas preguntas crees que has resuelto correctamente?), sino también los juicios de confianza paso a paso: después de cada problema, los participantes evaluaban en una escala de 0 a 100 cuán seguros estaban de su respuesta.

En condiciones normales, estos juicios deberían ser predictivos: alta confianza para las respuestas correctas, baja para las incorrectas. Es la señal de que el sistema metacognitivo está funcionando, de que existe un bucle de retroalimentación entre el proceso de toma de decisiones y la supervisión de la calidad de ese proceso. Pero en el grupo que usaba ChatGPT, esta correlación resultaba significativamente atenuada. La confianza media para las respuestas correctas era solo marginalmente más alta que la de las respuestas incorrectas, con un AUC medio de 0,62, apenas por encima del nivel de aleatoriedad y muy por debajo del umbral de 0,70 que los psicólogos consideran un índice de "sensibilidad metacognitiva moderada".

En la práctica, los participantes se sentían más o menos seguros siempre, independientemente de si estaban dando la respuesta correcta o incorrecta. Es como conducir con el salpicadero cubierto: el vehículo funciona, pero no tienes ni idea de si vas a treinta o a ciento treinta por hora.

Este colapso de la sensibilidad metacognitiva tiene implicaciones que van mucho más allá de las pruebas de lógica. Piensa en un médico que usa un sistema de diagnóstico por IA: si su capacidad para distinguir entre diagnósticos fiables y dudosos se ve comprometida por la facilidad con la que la IA produce resultados formalmente convincentes, el resultado no es una mejora de la práctica clínica, sino un posible aumento del riesgo. O en un estudiante que prepara un examen usando ChatGPT para resolver problemas: si el acceso inmediato a las soluciones le convence de que ha entendido la materia, se presentará al examen con una sensación de preparación ilusoria.

El fenómeno se agrava por lo que Stephen Fleming, neurocientífico de la cognición en el University College London, llama "heurística de la fluidez": cuando una información se procesa rápidamente y sin esfuerzo, el cerebro la interpreta como una señal de competencia. ChatGPT devuelve respuestas elaboradas, articuladas, formateadas impecablemente y casi al instante. Cada aspecto de esta experiencia grita "esto es correcto" a nuestro sistema intuitivo, eludiendo el análisis deliberativo que normalmente activamos ante una información incierta.

Repensar las interfaces inteligentes

La pregunta entonces es: si la IA mejora realmente el rendimiento pero deteriora la conciencia crítica, ¿cómo diseñamos sistemas que mantengan los beneficios minimizando los daños? La respuesta no puede limitarse a "usémosla menos" o "fiémonos menos". El genio ha salido de la lámpara, y decenas de millones de personas usan a diario herramientas como ChatGPT, Claude, Gemini para razonar, escribir, resolver problemas.

Los investigadores proponen lo que llaman "micro-tarea de explicación de vuelta" (explain-back micro-task): antes de aceptar una respuesta generada por la IA, el usuario debe reformularla con sus propias palabras, explicitando la lógica subyacente. Es una técnica que fuerza el paso de un aprendizaje superficial, basado en el reconocimiento de patrones, a uno profundo, basado en la comprensión estructural. Si le pides a ChatGPT que resuelva un problema de física y luego tienes que explicar con tus propias palabras por qué esa solución funciona, el sistema te obliga a una confrontación directa con tu comprensión real.

Otra dirección prometedora se refiere a la calibración explícita de la confianza. En lugar de dejar que el usuario deduzca implícitamente la fiabilidad de una respuesta a partir del tono asertivo del modelo, la interfaz podría mostrar métricas de incertidumbre: cuánto de "seguro" está el modelo de la respuesta en términos de distribución de probabilidad, si existen respuestas alternativas plausibles, cuánto se desvía la pregunta del conjunto de entrenamiento. No es una solución perfecta porque los usuarios tienden de todos modos a ignorar estas señales cuando el resultado parece convincente, pero al menos introduce un elemento de fricción cognitiva.

Los expertos en interacción hombre-IA también están explorando arquitecturas más radicales, como los agentes metacognitivos: sistemas de IA secundarios cuya tarea no es ayudarte a resolver el problema, sino supervisar cómo estás resolviendo el problema con la ayuda de la primera IA. Una especie de supervisor cognitivo que interviene cuando detecta patrones de dependencia excesiva o aceptación acrítica. Suena a ciencia ficción, pero algunos experimentos preliminares muestran reducciones significativas de la sobreestimación del rendimiento cuando se implementa este tipo de andamiaje metacognitivo.

Falk Lieder, investigador del Instituto Max Planck, ha propuesto un marco aún más ambicioso: interfaces que se adaptan dinámicamente al nivel de competencia metacognitiva del usuario. Cuando el sistema detecta que te estás fiando demasiado ciegamente de los resultados, aumenta el nivel de ambigüedad de las respuestas, inserta señales de incertidumbre más marcadas, te pide que justifiques tus elecciones. Cuando, en cambio, demuestras capacidad crítica, se retrae y deja más autonomía. Es un modelo que invierte la lógica actual, en la que la IA intenta ser cada vez más fluida y de asistencia, para introducir en cambio una estrategia de "asistencia calibrada".

El riesgo, por supuesto, es que estas intervenciones creen tales fricciones que hagan que las herramientas sean menos atractivas. Si cada vez que le pido a ChatGPT que me ayude con un problema tengo que pasar por un cuestionario metacognitivo antes de ver la respuesta, es probable que deje de usarlo. Pero quizás ese sea precisamente el punto: el objetivo no debería ser maximizar el compromiso con la IA, sino optimizar el aumento cognitivo en el sentido más pleno, incluida la dimensión metacognitiva.

Janet Rafner, que estudia las implicaciones sociotécnicas de la IA en el Instituto de Copenhague, sugiere que el problema requiere soluciones a varios niveles. A corto plazo, mejores diseños de interfaz. A medio plazo, programas educativos que enseñen no solo la alfabetización técnica en IA, sino también la metacognitiva. A largo plazo, una reconsideración cultural de lo que significa la competencia en un mundo donde el acceso a capacidades cognitivas externas es ubicuo. Es un desafío que recuerda al que se enfrentó la propia escritura hace milenios: cuando tienes a tu disposición la memoria externa de la palabra escrita, ¿qué le pasa a la memoria interna? Y, sobre todo, ¿qué le pasa a tu conciencia de lo que realmente recuerdas y lo que solo has transcrito?

La investigación de la Universidad de Aalto no ofrece soluciones definitivas, pero identifica con precisión un problema que corría el riesgo de quedar sumergido bajo el entusiasmo por las ganancias de rendimiento. La IA nos hace más inteligentes en el sentido computacional: resolvemos más problemas, más rápido, con menos errores. Pero no nos hace más sabios en el sentido metacognitivo: no mejoramos en la capacidad de evaluar críticamente nuestros propios procesos cognitivos, de reconocer cuándo estamos comprendiendo realmente y cuándo solo estamos simulando la comprensión.

Es la diferencia entre Deckard y los replicantes en Blade Runner: todos poseen recuerdos, pero solo algunos saben cuáles son auténticamente propios. En nuestro caso, todos obtenemos mejores respuestas con la IA, pero corremos el riesgo de perder la capacidad de distinguir entre la comprensión genuina y la competencia prestada. Y en un mundo donde cada vez se toman más decisiones importantes con la ayuda de sistemas inteligentes, esa distinción podría marcar toda la diferencia.