El internet que se muerde la cola: cuando la IA genera basura que alimenta a otra IA

Hay una escena en "La Cosa" de John Carpenter donde el extraterrestre asimila organismos terrestres creando copias cada vez más degradadas, cada vez menos perfectas. Cada iteración pierde algo del original hasta que la distinción entre lo auténtico y la réplica se vuelve imposible. Es una imagen poderosa para describir lo que está sucediendo en el ecosistema digital: la inteligencia artificial está consumiendo contenido humano para regenerarlo en una forma cada vez más corrupta, alimentando un ciclo de degradación progresiva que los científicos llaman "colapso del modelo" pero que podríamos definir más simplemente como el internet que se muerde la cola.

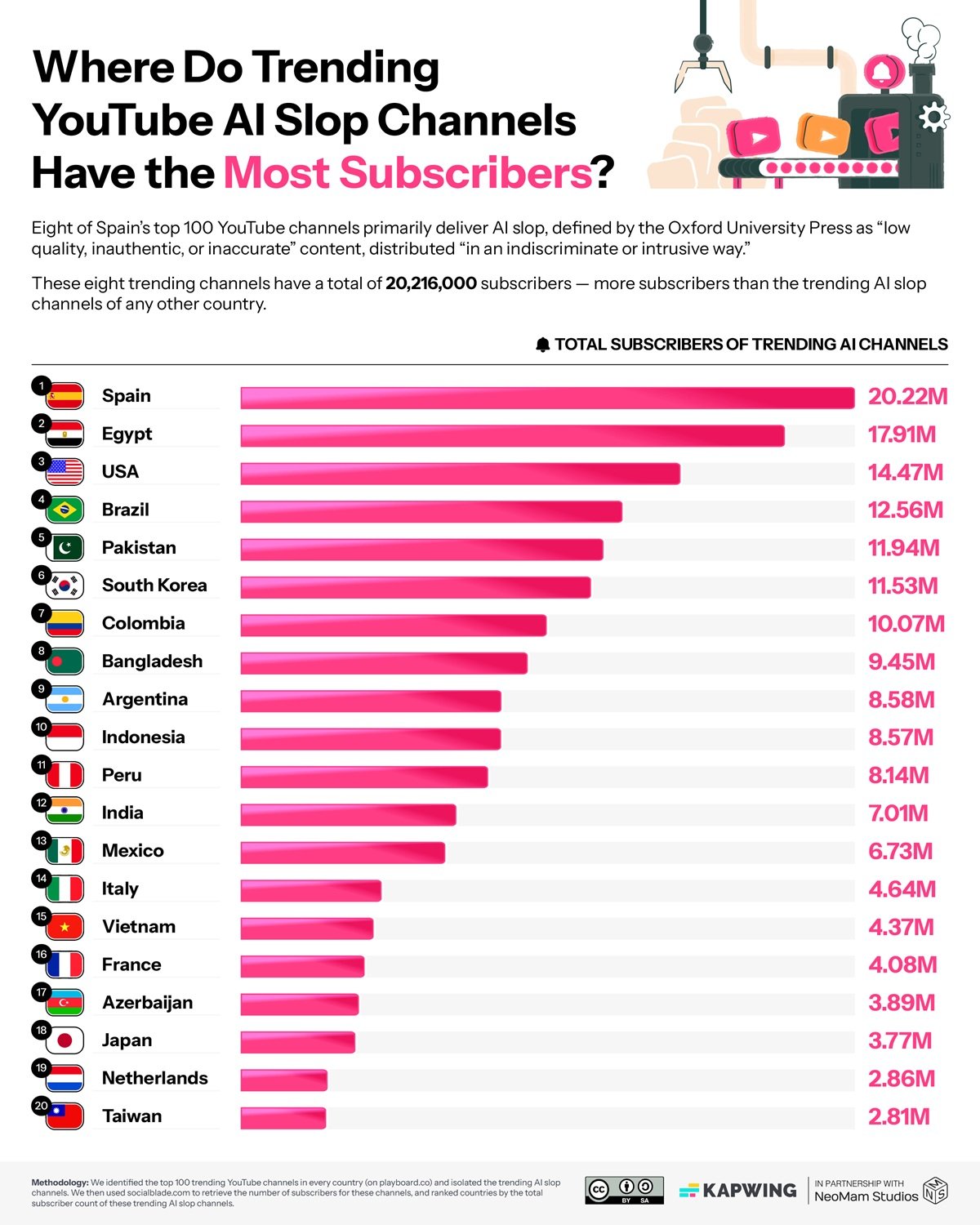

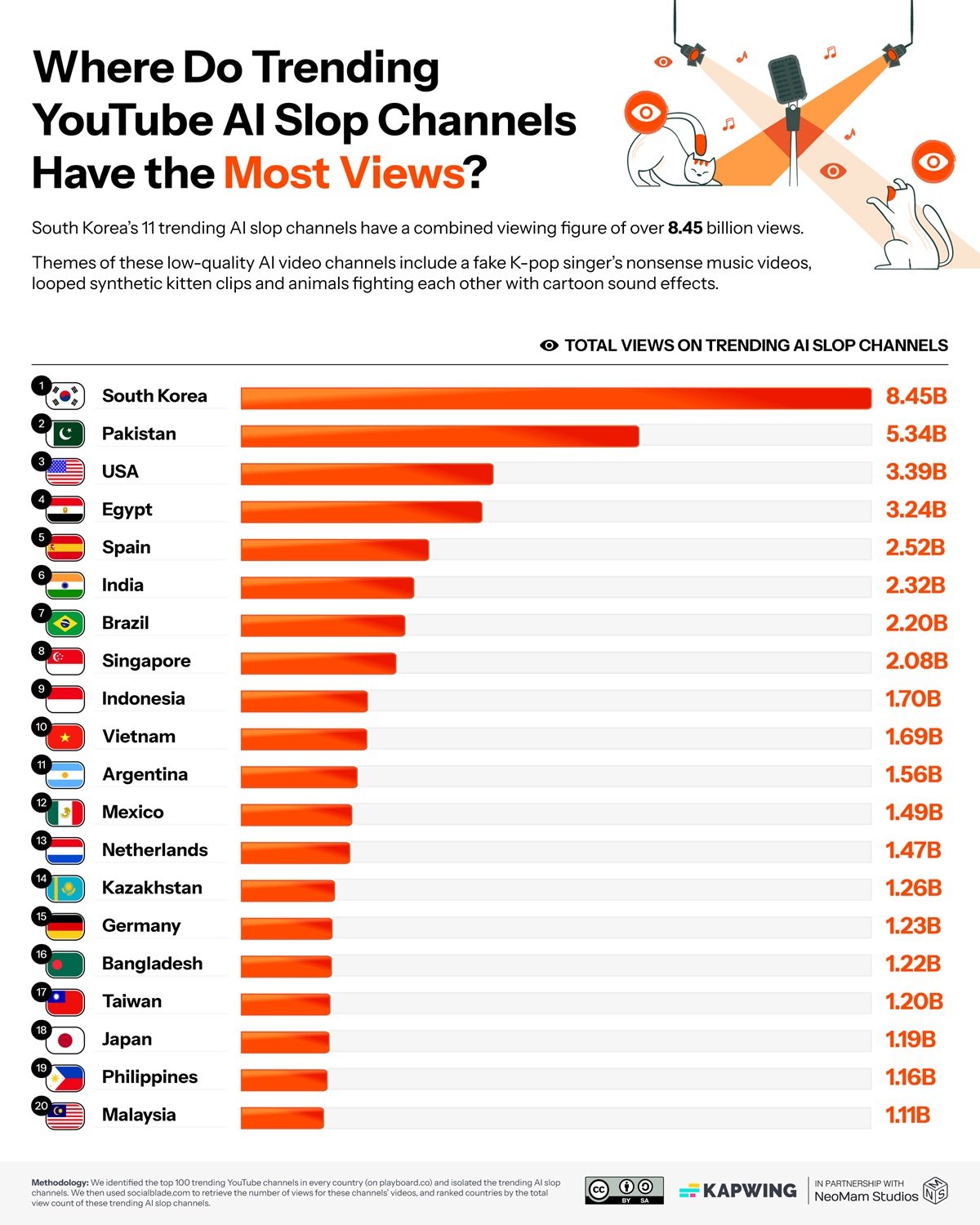

Las cifras recopiladas por Kapwing en su último informe tienen la precisión brutal de un diagnóstico médico: entre el 21% y el 33% del contenido que YouTube propone a los nuevos usuarios es lo que en la jerga de la industria se llama "AI slop", basura generada por inteligencia artificial. No estamos hablando de contenido de IA de calidad, sino de esa producción industrial de bajo costo que tiene un solo propósito: maximizar las visualizaciones para generar ingresos publicitarios. Canales como Cuentos Fascinantes en España han acumulado más de veinte millones de suscriptores con videos totalmente sintéticos, mientras que en Corea del Sur este tipo de contenido ha alcanzado los ocho mil millones de visualizaciones. La economía del "slop" ya vale ciento diecisiete millones de dólares al año, con canales individuales que facturan más de cuatro millones.

La máquina funciona de manera simple pero efectiva. Los algoritmos de YouTube premian la novedad y la interacción inmediata. El contenido generado por IA, producido en masa a costos muy bajos, puede saturar la plataforma con infinitas variaciones del mismo tema. Un creador tradicional tarda horas o días en producir un video. Un sistema de IA puede producir docenas en el mismo tiempo, probando múltiples variantes para identificar la que funciona mejor. El 54% de los primeros videos vistos por los nuevos usuarios pertenecen a esta categoría, creando una especie of puerta de entrada distorsionada a la plataforma.

Neal Mohan, CEO de YouTube, declaró a la revista Time que la inteligencia artificial representa "la próxima frontera" para la plataforma. En una reorganización anunciada en octubre de 2024, YouTube reestructuró sus divisiones de producto e ingeniería precisamente para alinearse con esta visión centrada en la IA. Pero hay una inconsistencia inquietante: mientras la empresa invierte masivamente en herramientas de IA para los creadores, sus propios sistemas de moderación automatizada están causando bloqueos masivos de canales legítimos, con creadores que ven sus cuentas prohibidas mientras los canales que robaron su contenido permanecen activos. Es como si YouTube estuviera alimentando y combatiendo simultáneamente el mismo fenómeno, atrapada en una contradicción sistémica que recuerda mucho a la dinámica de monopolio tecnológico que la Unión Europea está tratando de regular.

La entropía que crece

Pero el problema del "slop" es solo la manifestación superficial de algo mucho más profundo. Mientras YouTube se llena de videos sintéticos, LinkedIn ha alcanzado un punto crítico aún más extremo: según el análisis de Originality.AI, el 54% de las publicaciones de formato largo en la plataforma profesional son generadas por inteligencia artificial. Un salto del 189% con respecto al período anterior a ChatGPT. No hablamos de asistencia para la escritura, sino de contenido totalmente artificial presentado como pensamiento original. Los algoritmos de LinkedIn ahora premian esta producción masiva, creando un feed donde distinguir lo auténtico de lo sintético se vuelve cada vez más difícil.

La cuestión ya no es solo cualitativa, sino estructural. Un artículo publicado en arXiv documenta científicamente el fenómeno del "colapso del modelo", la entropía informacional que se genera cuando los modelos de inteligencia artificial se entrenan con datos producidos por otros modelos de IA. Los autores demuestran que esta práctica provoca una pérdida progresiva de diversidad: la variedad semántica medida en bits por token desciende de 4,2 a 2,5 en unas pocas iteraciones de entrenamiento. Es como hacer fotocopias de fotocopias: cada generación pierde detalles, matices, complejidad.

El mecanismo es sutil. Los modelos actuales han sido entrenados con miles de millones de textos producidos por seres humanos durante décadas de actividad en línea. Pero esa mina de datos originales se está agotando. Un estudio publicado en Nature estima que el "presupuesto" de contenido humano disponible para el entrenamiento se agotará entre 2026 y 2032, dependiendo de los escenarios. Después de eso, los nuevos modelos tendrán que alimentarse necesariamente también de contenido generado por IA anteriores. Y aquí es donde salta la trampa: cada ciclo de entrenamiento con datos sintéticos amplifica los errores, reduce la variedad, homogeneiza el resultado. Como en una población que se reproduce solo dentro de sí misma, la diversidad genética colapsa.

La serpiente digital Ouroboros

El "slop" de YouTube y el colapso del modelo no son fenómenos separados, sino dos caras de la misma moneda. Los videos basura generados hoy formarán parte de los conjuntos de datos con los que se entrenarán los modelos del mañana. Las publicaciones de IA de LinkedIn serán indexadas, archivadas, utilizadas como material de entrenamiento. Es un ciclo de retroalimentación perfecto: el contenido de baja calidad genera datos corruptos que producen peores modelos que a su vez crean contenido aún más degradado. Una serpiente que se muerde la cola, como el Ouroboros alquímico, pero sin ninguna promesa de renacimiento.

Las implicaciones prácticas ya son medibles. Una investigación publicada en JMIR ha identificado que el 5,3 por ciento del contenido educativo biomédico en YouTube contiene información generada por IA de dudosa calidad. No estamos hablando de entretenimiento, sino de material que médicos, estudiantes y pacientes consultan para tomar decisiones sobre la salud. El efecto de "verdad ilusoria" está bien documentado: repetir información falsa o imprecisa aumenta su credibilidad percibida. Si YouTube continúa bombeando contenido de IA no verificado, estamos construyendo una infraestructura de desinformación que será cada vez más difícil de desmantelar.

En el plano económico, el "slop" crea profundas distorsiones. Los ciento diecisiete millones de dólares que genera anualmente no son nueva riqueza: se desvían de los creadores legítimos hacia quienes han entendido cómo "jugar" con el sistema algorítmico con una producción industrial de bajo costo. Es una forma de selección adversa: el algoritmo premia a quienes producen en cantidad en detrimento de quienes producen en calidad, creando un incentivo perverso que empuja a todo el ecosistema hacia abajo. Y mientras esto sucede, gigantes como Google continúan redefiniendo su relación con la IA, invirtiendo masivamente en una tecnología que al mismo tiempo amenaza con canibalizar los cimientos mismos de la web que ayudaron a construir.

La normalización es quizás el aspecto más insidioso. Cuando la mitad del contenido en LinkedIn es IA y un tercio de YouTube es "slop", nuestro sentido crítico se adapta. Empezamos a esperar esa pátina de artificialidad, esa falta de autenticidad. El riesgo es que estemos entrenando a una generación de usuarios a no distinguir más, a no buscar más el original. Y cuando ya no buscas el original, dejas de valorarlo y, por lo tanto, de producirlo.

Los ganadores invisibles

Mientras el ecosistema digital se llena de basura y los modelos corren el riesgo de colapsar, existe una economía paralela que prospera precisamente con este caos. Nvidia cerró el tercer trimestre fiscal de 2026 con cincuenta y siete mil millones de dólares en ingresos, un aumento del sesenta y dos por ciento interanual. La empresa controla el 92% del mercado de GPU y monetiza cada generación de IA, ya sea contenido de calidad o "slop". El CEO Jensen Huang habla de una "demanda increíble" y de GPU en la nube "agotadas", proyectando inversiones en infraestructura de IA de entre tres y cuatro billones de dólares para 2030.

No es solo Nvidia. Los proveedores de la nube como AWS, Azure y Google Cloud facturan miles de millones a las empresas que entrenan modelos y generan contenido. OpenAI y Anthropic recaudan cientos de millones en financiación justo cuando la web se llena del contenido que producen sus modelos. Es una paradoja perfecta: cuanto más contenido de IA se genera, más potencia de cálculo se necesita para entrenar los modelos posteriores con conjuntos de datos cada vez más contaminados, generando beneficios crecientes para la infraestructura que alimenta el propio problema. Los "sloppers" de YouTube que facturan cuatro millones son la punta visible del iceberg. Bajo la superficie, hay una industria de decenas de miles de millones que monetiza cada vatio de energía gastado en generar y procesar contenido, independientemente de su calidad o utilidad.

Hacia qué ecosistema

Pero existen alternativas concretas que ya funcionan. Common Crawl, a pesar de las recientes controversias sobre la gestión de los muros de pago, sigue siendo el mayor archivo público de datos web y se utiliza en el 64% de los modelos de lenguaje. La diferencia crucial radica en la curación: las versiones filtradas como C4 de Google o Pile-CC de EleutherAI aplican procesos de limpieza agresivos. NVIDIA ha desarrollado Nemotron-CC, un conjunto de datos de 6,3 billones de tokens construido mediante conjuntos de clasificadores y técnicas de reformulación sintética que mantienen la calidad mientras amplían la cantidad.

Cohere Labs está construyendo alternativas radicalmente diferentes con el proyecto Aya, una iniciativa de ciencia abierta que ha involucrado a tres mil investigadores de 150 países para crear conjuntos de datos multilingües curados manualmente en 101 idiomas. No es una automatización ciega, sino una curación humana a gran escala. El Data Provenance Explorer, desarrollado por el MIT y Cohere Labs, ha rastreado y verificado dos mil de los conjuntos de datos más utilizados, creando por primera vez un sistema de trazabilidad que documenta las licencias, los creadores y el linaje de los datos. Plataformas como Substack han construido modelos económicos que premian la autenticidad humana verificada, demostrando que existen mercados dispuestos a pagar por contenido original certificado.

El marcado de agua del contenido de IA sigue siendo una solución parcial pero necesaria. La Unión Europea, con la Ley de IA, ha comenzado a imponer obligaciones de transparencia. YouTube ha anunciado sistemas de etiquetado, aunque la implementación sigue siendo desigual. Pero la cuestión no es solo tecnológica. Se necesitan intervenciones estructurales: las plataformas deben repensar los algoritmos que premian la interacción inmediata creando incentivos perversos. Los conjuntos de datos para el entrenamiento requieren una curación extrema, privilegiando las fuentes humanas verificadas. Y se necesita una inversión masiva en alfabetización mediática: reconocer el contenido de IA ya no es opcional, sino una competencia fundamental.

El punto crítico es que estamos en una encrucijada. Podemos continuar en la trayectoria actual, donde cada año un porcentaje mayor de la web es generado por IA, donde los modelos se entrenan con el resultado de otros modelos, donde la diversidad informacional colapsa progresivamente hasta crear un ecosistema digital homogéneo, predecible y estéril. O podemos intervenir ahora, con una regulación inteligente, elecciones técnicas conscientes y una renovada valoración del contenido humano auténtico.

La apuesta de YouTube es que la IA pueda democratizar la creación, reduciendo las barreras técnicas y permitiendo que cualquiera se convierta en creador. Pero si esa democratización produce principalmente basura que contamina el ecosistema y alimenta el colapso de los modelos futuros, no estamos democratizando nada: solo estamos acelerando una degradación sistémica. Como en el extraterrestre de Carpenter, cada copia se vuelve menos perfecta que la anterior. Y a diferencia de la película, aquí no hay un Kurt Russell con un lanzallamas listo para detener la asimilación.

La pregunta ya no es si la IA transformará internet. Esa transformación ya está en marcha. La pregunta es: ¿en qué lo estamos transformando? ¿En un sistema más rico, variado y accesible, o en una cámara de eco donde las máquinas hablan principalmente con otras máquinas, mientras que los humanos nos convertimos en espectadores cada vez más pasivos de un deterioro informacional que hemos puesto en marcha pero que cada vez nos cuesta más controlar?