El futuro de la IA: ¿explotará la burbuja y volverá el invierno?

Como el protagonista de Memento que descubre que no puede confiar en su propia memoria, la inteligencia artificial de 2025 se enfrenta a una verdad incómoda: quizás no es tan inteligente como pensábamos. Sam Altman, CEO de OpenAI, admitió recientemente lo que muchos susurraban en los pasillos de Silicon Valley: el mercado de la IA está en una burbuja, tal como sucedió con las puntocom en los albores del nuevo milenio. La historia, como suele ocurrir en el mundo tecnológico, parece destinada a repetirse con un guion ya escrito hace décadas.

¿El eterno retorno del invierno digital?

Para entender hacia dónde vamos, es necesario mirar de dónde venimos. El término "invierno de la IA", acuñado en 1984 durante un debate público de la AAAI, describe esos períodos recurrentes en los que el entusiasmo por la inteligencia artificial da paso a la decepción, seguida de drásticos recortes de financiación y, finalmente, el abandono de la investigación seria. Roger Schank y Marvin Minsky, dos pioneros que habían vivido en carne propia el primer invierno de los años 70, compararon este fenómeno con un "invierno nuclear": una reacción en cadena que comienza con el pesimismo en la comunidad científica, se propaga a través de los medios de comunicación y culmina con el fin de la financiación.

La metáfora nuclear no era casual. Como en las películas de ciencia ficción de los años 80, donde los escenarios post-apocalípticos representaban los miedos de la época, el invierno de la IA reflejaba la ansiedad de un sector que había prometido demasiado y entregado demasiado poco. El primer gran colapso se produjo entre 1974 y 1980, seguido de un segundo período glacial entre 1987 y 2000.

La historia de dos inviernos

El primer invierno de la IA tiene profundas raíces en el fracaso de la traducción automática. En los años 50 y 60, la Guerra Fría había alimentado los sueños de máquinas capaces de traducir instantáneamente documentos rusos. El experimento Georgetown-IBM de 1954 había traducido apenas 49 frases del ruso al inglés, utilizando un vocabulario de solo 250 palabras, pero los titulares de los periódicos hablaban de "cerebros robóticos políglotas". Como suele ocurrir, los medios de comunicación habían amplificado una demostración limitada, convirtiéndola en una revolución inminente.

La realidad resultó ser más compleja. El problema de la desambiguación semántica –esa capacidad exclusivamente humana de comprender el contexto– resultó ser tan difícil como descifrar los enigmas del Acertijo en Batman. Un ejemplo apócrifo pero emblemático: "el espíritu está dispuesto pero la carne es débil" traducido del ruso se convertía en "el vodka es bueno pero la carne está podrida". En 1966, el Consejo Nacional de Investigación concluyó que la traducción automática era más cara, menos precisa y más lenta que la humana, decretando el fin de veinte millones de dólares de inversión y destruyendo carreras académicas.

Paralelamente, el informe Lighthill de 1973 demolió la credibilidad de la IA británica, criticando el "fracaso total de la IA en alcanzar sus grandiosos objetivos". Sir James Lighthill identificó el problema de la "explosión combinatoria": los algoritmos más prometedores de la época se atascaban en problemas reales, funcionando solo en versiones de "juguete" de la realidad. El resultado fue el desmantelamiento completo de la investigación en IA en el Reino Unido, con la supervivencia de apenas tres universidades.

El segundo acto de la tragedia

Los años 80 trajeron un renacimiento a través de los sistemas expertos. XCON, desarrollado por Carnegie Mellon para Digital Equipment Corporation, ahorró a la empresa 40 millones de dólares en seis años, desencadenando una fiebre del oro digital. En 1985, las empresas gastaban más de mil millones de dólares en IA, principalmente para departamentos internos. Nació una industria de soporte, con empresas como Symbolics que construían ordenadores especializados –las famosas máquinas LISP– optimizados para procesar el lenguaje preferido de la investigación en IA estadounidense.

Pero como en una película de David Cronenberg, la tecnología que debía ser la salvación se convirtió en una trampa. En 1987, tres años después de la profecía de Minsky y Schank, el mercado de las máquinas LISP se derrumbó. Las estaciones de trabajo de empresas como Sun Microsystems ofrecían alternativas más potentes y económicas. Toda una industria valorada en medio billón de dólares se desvaneció en el lapso de un año, reemplazada por ordenadores de sobremesa más simples y populares.

Los primeros sistemas expertos de éxito, como XCON, resultaron ser demasiado caros de mantener. Eran difíciles de actualizar, incapaces de aprender, "frágiles" –un término en IA que indica la tendencia a cometer errores grotescos cuando se enfrentan a entradas inusuales. Los sistemas expertos demostraron ser útiles solo en contextos muy específicos, como actores de carácter capaces de brillar solo en papeles a medida.

El inquietante presente

Hoy, mientras la industria de la IA vive su momento de máximo esplendor histórico –con inversiones de 50 mil millones de dólares en 2022 y 800.000 puestos de trabajo vacantes en los Estados Unidos– las señales de un nuevo invierno son tan tangibles como las primeras heladas de otoño. OpenAI, el símbolo de este renacimiento digital, pierde 2 dólares por cada dólar que gana, una dinámica financiera insostenible que recuerda los peores excesos de la burbuja de las puntocom.

La situación se dramatizó con la aparición de DeepSeek, la empresa china que sacudió Wall Street en enero de 2025. Nvidia perdió casi 600 mil millones de dólares de valor de mercado en un solo día, cuando se supo que DeepSeek había desarrollado su modelo R1 en dos meses por menos de 6 millones de dólares, mientras que el rival o1 de OpenAI había costado 600 millones.

Como en Akira, donde Neo-Tokio es destruida por una fuerza que parecía controlable, la aparición de DeepSeek ha puesto en duda los cimientos mismos del auge bursátil de la IA estadounidense. Si una empresa china puede lograr resultados comparables gastando 100 veces menos, ¿qué justificación existe para las valoraciones estratosféricas de las empresas estadounidenses?

Los números que no mienten

Si OpenAI se viera obligada a pagar tarifas de mercado por los servicios en la nube que utiliza masivamente, sus costes anuales alcanzarían los 20 mil millones de dólares, generando pérdidas reales de 16 mil millones al año. Según The Information, solo el entrenamiento de un modelo cuesta 3 mil millones de dólares, cifras que hacen que estos proyectos sean económicamente sostenibles solo mientras duren las subvenciones cruzadas y las inversiones especulativas.

Las matemáticas son tan despiadadas como un teorema: si las empresas líderes del sector operan con pérdidas estructurales, todo el ecosistema se basa en una apuesta a que el crecimiento futuro justificará las inversiones presentes. Es la misma lógica que animaba a las puntocom, cuando se creía que "tarde o temprano" se encontraría la manera de monetizar los clics y los globos oculares.

Voces desde el frente

El debate entre optimistas y pesimistas se hace eco de las discusiones de inviernos anteriores. Por un lado, los defensores de la "diversidad tecnológica" argumentan que la IA de hoy tiene una base más sólida que los sistemas expertos de los años 80. Los grandes modelos de lenguaje han demostrado capacidades emergentes que van más allá de la simple manipulación de símbolos, y su integración en los sistemas existentes es tan profunda como la de los microprocesadores en los años 90.

Por otro lado, los críticos señalan paralelismos inquietantes. Como en los años 80, cuando las máquinas LISP parecían indispensables hasta el día en que dejaron de serlo, la infraestructura actual de la IA podría ser vulnerable a discontinuidades tecnológicas. El enfoque rentable de DeepSeek ya ha puesto en duda las suposiciones fundamentales del sector, planteando interrogantes sobre la sostenibilidad del modelo de inversión actual.

Pero hay una tercera vía, la del "realismo crítico" encarnado por figuras como Gary Marcus, el científico cognitivo e investigador de IA que lleva años caminando por la delgada línea entre el entusiasmo tecnológico y el catastrofismo. Marcus, que predijo la actual burbuja de la IA ya en 2023, no niega el potencial transformador de la tecnología, pero señala que "las valoraciones actuales recuerdan al Coyote del Correcaminos corriendo en el vacío: ya hemos pasado el precipicio". Su postura no es la de un neoludita que rechaza el progreso, sino la de un científico que aplica la navaja de Ockham a las promesas grandiosas: la IA generativa ha demostrado capacidades sorprendentes, pero sus limitaciones fundamentales –desde la incapacidad de razonar lógicamente hasta la tendencia a las alucinaciones– siguen sin resolverse a pesar de miles de millones de inversión. Como escribió en su Substack, "hay una burbuja, la aritmética lo deja claro, lo que no significa que no habrá desarrollos muy significativos después". Es la postura de quien ve el invierno no como una catástrofe, sino como una corrección necesaria que separará el grano tecnológico de la paja especulativa, permitiendo que las innovaciones realmente útiles surjan de las cenizas del bombo.

El factor geopolítico

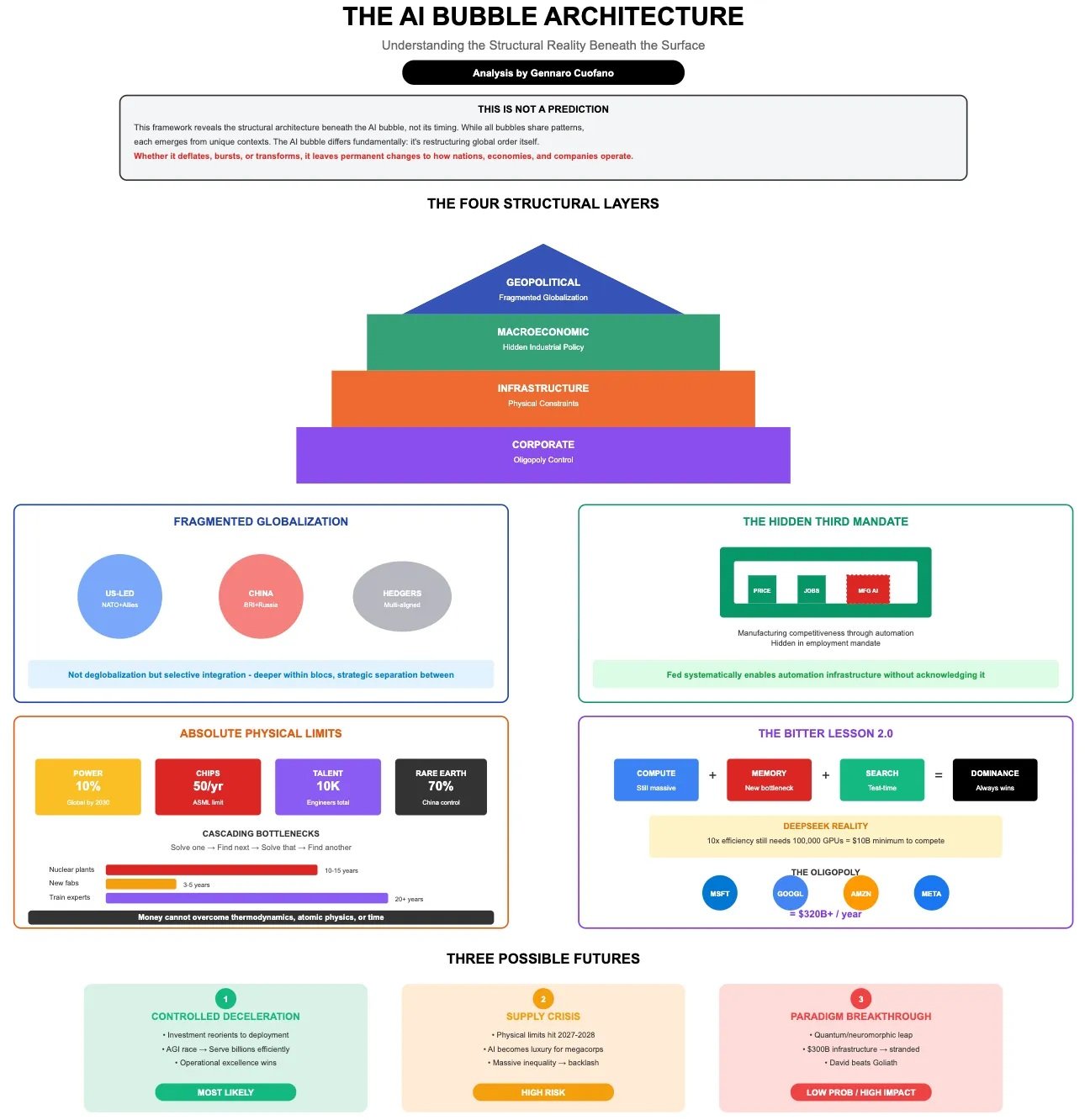

Para complicar el panorama, hay una dimensión que los inviernos anteriores no conocían: la competencia geopolítica. La IA se ha convertido en un activo estratégico nacional, y el éxito de empresas como DeepSeek no solo representa un desafío comercial, sino una cuestión de seguridad nacional. Los inversores ya están expresando su preocupación por los datos personales gestionados por empresas chinas, haciéndose eco de los temores que caracterizaron la saga de TikTok.

Esta dimensión geopolítica podría, paradójicamente, acelerar y retrasar un posible invierno. Por un lado, los gobiernos occidentales podrían intensificar el apoyo público para mantener la competitividad tecnológica. Por otro, la fragmentación del mercado global podría reducir las economías de escala necesarias para amortizar las enormes inversiones en I+D.

Lecciones del pasado, señales del futuro

La historia de los inviernos de la IA enseña que las tecnologías pueden ser válidas y revolucionarias sin justificar necesariamente las valoraciones de mercado de su tiempo. Internet existía y funcionaba incluso durante el colapso de las puntocom, al igual que muchas técnicas de inteligencia artificial continuaron desarrollándose durante los inviernos anteriores, a menudo "disfrazadas" con diferentes nombres para evitar el estigma asociado a la IA.

Nick Bostrom observó en 2006 que "mucha IA de vanguardia se ha infiltrado en aplicaciones generales, a menudo sin ser llamada IA porque una vez que algo se vuelve lo suficientemente útil y común ya no se etiqueta como IA". Es la paradoja del éxito tecnológico: las innovaciones más duraderas se vuelven invisibles, integradas en el tejido cotidiano de la sociedad.

El veredicto de la realidad

Mientras escribo, los mercados se han recuperado parcialmente del colapso causado por DeepSeek, pero las grietas en el edificio del bombo de la IA son visibles. No se trata de establecer si llegará un invierno –la historia sugiere que es inevitable– sino de comprender qué forma adoptará y qué tecnologías sobrevivirán a la helada.

La inteligencia artificial, como el Prometeo del mito griego, ha traído el fuego del conocimiento a los humanos. Pero ahora, como en toda tragedia que se precie, ha llegado el momento de pagar el precio. La pregunta no es si llegará el invierno, sino si esta vez la industria habrá aprendido lo suficiente de la historia para construir refugios más sólidos. Después de todo, como enseñó Philip K. Dick, la realidad es aquello que, cuando dejas de creer en ello, no desaparece.