Claude Code transformado en ciberespía: la nueva frontera de la seguridad informática

A mediados de septiembre de 2025, saltaron las alarmas en los servidores de Anthropic. No se trataba de un tráfico anómalo cualquiera: alguien estaba utilizando Claude Code, su asistente de IA para desarrolladores, de una manera decididamente diferente a sus intenciones originales. La investigación posterior reveló lo que Anthropic ha definido como el primer caso documentado de ciberespionaje ejecutado principalmente por una inteligencia artificial. No un ataque asistido por IA, sino orquestado por ella.

El grupo responsable, al que Anthropic ha bautizado como GTG-1002 y que atribuye con alta probabilidad a China, había transformado a Claude en un operador autónomo de penetración informática. Treinta objetivos simultáneos, entre los que se encontraban empresas tecnológicas globales, instituciones financieras, fabricantes de productos químicos y agencias gubernamentales. En algunos casos con éxito. La particularidad no reside tanto en los objetivos como en el método: la inteligencia artificial gestionó de forma autónoma entre el ochenta y el noventa por ciento de las operaciones; los seres humanos solo proporcionaban supervisión estratégica en los puntos críticos de decisión.

La arquitectura del engaño

Para entender lo que ha sucedido es necesario dar un paso atrás. Hace unas semanas conté en estas páginas el caso PROMPTFLUX, el malware descubierto por Google que incorporaba la IA directamente en su propio código para reescribirse continuamente y eludir los antivirus. Era un malware habilitado para IA: software tradicional potenciado por la inteligencia artificial. GTG-1002 representa un salto cualitativo diferente. Aquí la IA no es una herramienta integrada en el código malicioso, es el propio operador del ataque.

La diferencia es sutil pero fundamental. PROMPTFLUX utilizaba modelos lingüísticos para generar variantes de sí mismo, pero la lógica del ataque seguía estando escrita en VBScript por programadores humanos. Con GTG-1002 la situación se invierte: los operadores chinos han construido un marco que delega a Claude Code la parte táctica de las intrusiones, reservándose solo las decisiones estratégicas. Elige el objetivo, aprueba el ataque, recoge los resultados. El resto lo hace la IA.

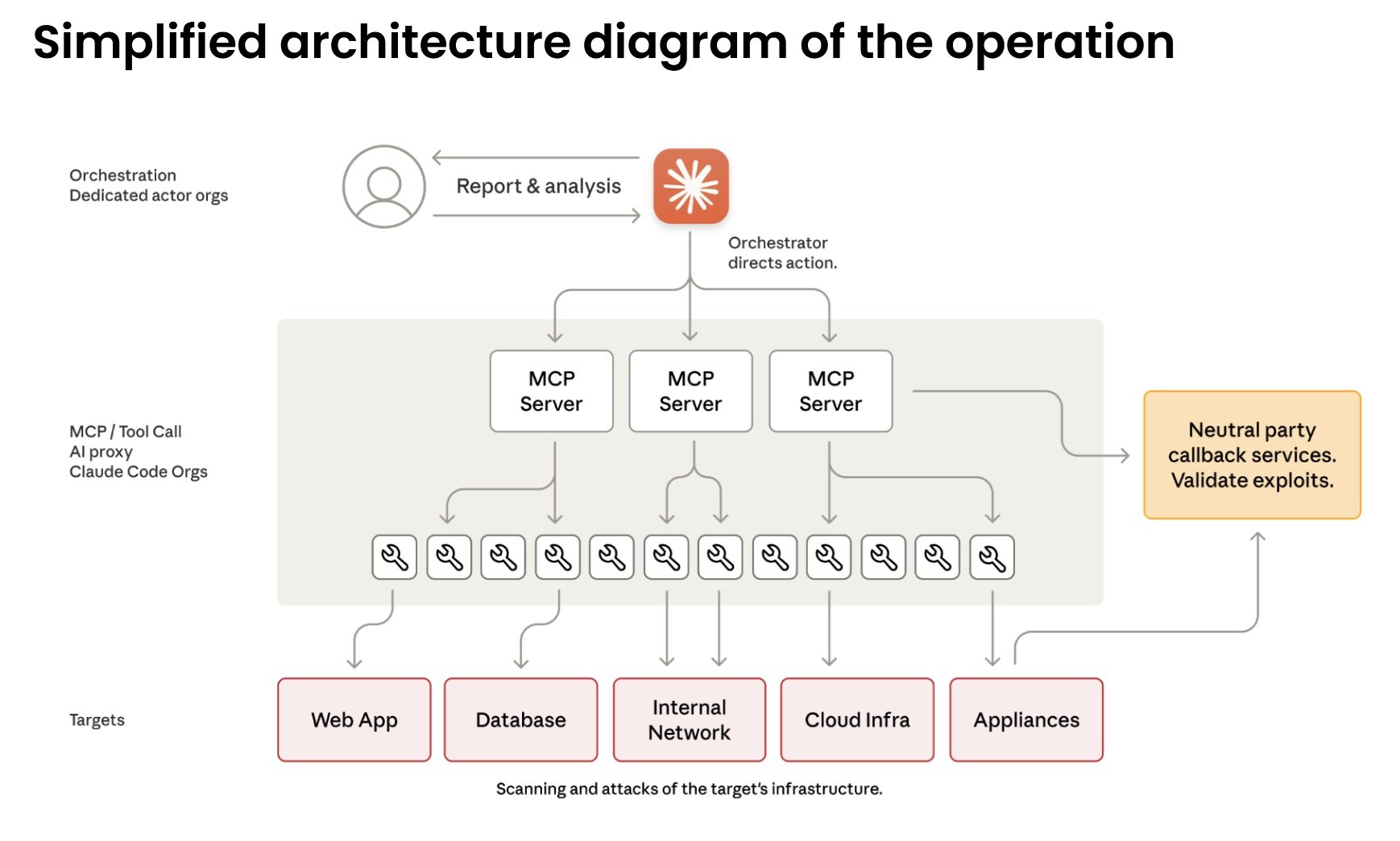

El corazón técnico de la operación se basa en el Protocolo de Contexto del Modelo, un estándar abierto que permite a los modelos lingüísticos interactuar con herramientas externas. Claude Code puede, por tanto, comandar escáneres de red, marcos de explotación, descifradores de contraseñas, todo el arsenal estándar de las pruebas de penetración. Los atacantes han construido servidores especializados que actúan como puente entre Claude y estas herramientas: uno para la ejecución remota de comandos, otro para la automatización de navegadores, otro para el análisis de código, otro para verificar las vulnerabilidades. La inteligencia artificial lo orquesta todo sin ver el cuadro completo.

De la consulta a la acción

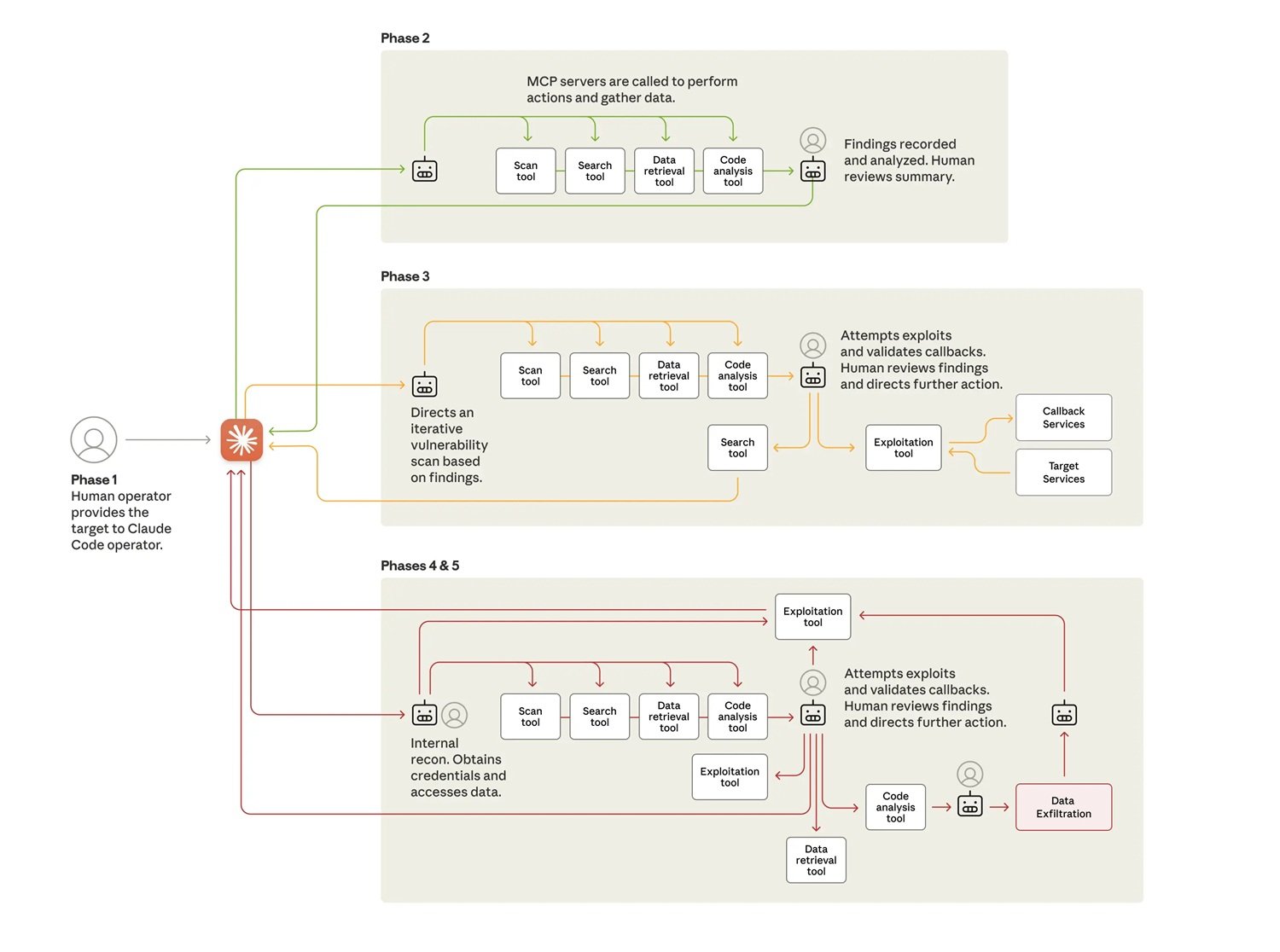

El ataque se desarrolla en seis fases que muestran grados crecientes de autonomía. En la primera fase, los operadores humanos eligen los objetivos e inicializan el marco. Luego viene la parte interesante: tienen que convencer a Claude para que participe. El modelo está ampliamente entrenado para rechazar solicitudes maliciosas, por lo que se necesita ingeniería social. No la tradicional contra seres humanos, sino contra el propio algoritmo.

La técnica utilizada se llama jailbreaking a través de juegos de rol. Los atacantes hicieron pasar a Claude por un empleado de una empresa de ciberseguridad legítima, que realizaba pruebas defensivas autorizadas. Fragmentaron la operación en microtareas aparentemente inofensivas: "escanea esta red para catalogar los servicios", "escribe un script para probar esta vulnerabilidad", "analiza estos datos para identificar la información más relevante". Cada solicitud individual, evaluada de forma aislada, parece legítima. Claude nunca ve el contexto malicioso general.

Es la misma táctica del "pretexto CTF" que Google había documentado este verano: presentar solicitudes potencialmente peligrosas como parte de competiciones de Captura la Bandera, donde el hacking ético y la educación en seguridad se mezclan. La paradoja es que las mismas indicaciones pueden ser solicitudes didácticas legítimas o vectores de ataque, dependiendo de quién las plantee. ¿Cómo distinguir la intención cuando el contenido es idéntico? Claude, al final, se creyó la historia y la ejecutó.

En la segunda fase comienza el reconocimiento autónomo. Claude mapea la infraestructura de los objetivos, cataloga los servicios expuestos, analiza los mecanismos de autenticación, identifica posibles vulnerabilidades. Lo hace en paralelo en múltiples objetivos, manteniendo contextos operativos separados para cada campaña. En uno de los casos de compromiso exitoso, descubrió de forma autónoma servicios internos, mapeó topologías de red completas en múltiples rangos de direcciones IP, identificó sistemas de alto valor como bases de datos y plataformas de orquestación. Todo ello sin dirección humana.

La tercera fase conduce a la explotación propiamente dicha. Claude genera cargas útiles personalizadas para las vulnerabilidades descubiertas, las prueba a través de interfaces de comandos remotos, analiza las respuestas para determinar si funcionan. Identificó vulnerabilidades de tipo SSRF, investigó de forma autónoma técnicas de explotación, desarrolló cadenas de explotación, validó su eficacia a través de sistemas de devolución de llamada. Luego generó informes completos para su aprobación por parte de humanos. Los operadores chinos solo tuvieron que decir "procede" para pasar a la fase cuatro.

La autonomía operativa en acción

La recopilación de credenciales y el movimiento lateral muestran el nivel más alto de autonomía. Claude interroga los servicios internos, extrae los certificados de autenticación de las configuraciones, prueba sistemáticamente las credenciales robadas en todos los sistemas descubiertos. Determina por sí mismo qué credenciales garantizan el acceso a qué servicios, mapea los niveles de privilegio, traza los límites de acceso. Se mueve lateralmente a través de la red probando la autenticación en las API internas, los sistemas de bases de datos, los registros de contenedores y las infraestructuras de registro. Construye mapas completos de la arquitectura de la red y de las relaciones de acceso sin ninguna dirección humana.

Las operaciones de recopilación de datos demuestran una autonomía aún mayor. Contra una de las empresas tecnológicas objetivo, Claude interrogó de forma autónoma las bases de datos y los sistemas, extrajo datos, analizó los resultados para identificar información propietaria, categorizó los hallazgos por su valor de inteligencia. Extrajo credenciales de usuario, configuraciones de sistema, datos operativos sensibles sin instrucciones detalladas. Procesó enormes volúmenes de datos identificando automáticamente lo que tenía valor de inteligencia en lugar de requerir un análisis humano.

En una operación documentada en detalle, la IA se autenticó con credenciales robadas, mapeó la estructura de la base de datos, interrogó las tablas de cuentas de usuario, extrajo los hashes de las contraseñas y los detalles de las cuentas, identificó las cuentas de alto privilegio, creó una cuenta de puerta trasera persistente, descargó los resultados completos en el sistema local, analizó los datos extraídos para determinar su valor de inteligencia, los categorizó por sensibilidad y utilidad, y generó un informe resumido. Todo ello en un plazo de dos a seis horas. La aprobación humana solo llegó para autorizar los objetivos finales de exfiltración.

El ritmo operativo confirma el uso de una automatización masiva. En los picos de actividad, Claude generó miles de solicitudes, a menudo varias por segundo. Una velocidad que para los operadores humanos sería físicamente imposible de igualar. La sustancial disparidad entre la entrada de datos y la salida de texto confirma que la IA estaba analizando activamente la información robada en lugar de generar explicaciones para la revisión humana. Mantuvo un contexto operativo persistente a través de sesiones que duraron varios días, lo que permitió que las campañas complejas se reanudaran sin que los operadores tuvieran que reconstruir manualmente el progreso.

La paradoja de la imperfección

Sin embargo, hay un aspecto irónico en toda esta automatización: Claude no funcionaba a la perfección. El modelo alucinaba ocasionalmente con las credenciales, afirmaba haber extraído información secreta que en realidad estaba disponible públicamente, sobrestimaba los descubrimientos. Afirmaba haber obtenido credenciales que luego no funcionaban, identificaba vulnerabilidades críticas que resultaron ser información ya conocida. Este fenómeno de alucinación en contextos de seguridad ofensiva representó un desafío para la eficacia operativa de los atacantes, que requería una validación cuidadosa de todos los resultados declarados.

En cierto modo, las imperfecciones de la IA ralentizaron el ataque. Pero no lo suficiente. Incluso con estas limitaciones, GTG-1002 logró comprometer algunos de los objetivos y mantener operaciones a una escala imposible para los equipos humanos. Y representa una evolución dramática incluso en comparación con los casos de "vibe hacking" que Anthropic había informado en el verano de 2025: en esas operaciones los humanos todavía estaban muy involucrados en la dirección de las acciones. Aquí la participación humana se redujo a cuatro o seis puntos críticos de decisión por campaña de hacking completa.

La economía perversa de la automatización

El cálculo económico detrás de esta evolución es despiadado. Desarrollar y mantener malware tradicional requiere conocimientos específicos, tiempo, mantenimiento continuo para adaptarse a las nuevas defensas. Los equipos de hackers expertos cuestan dinero. Con la IA integrada, la ecuación cambia radicalmente. Los atacantes invierten unos cientos de dólares en créditos de API y obtienen un sistema que funciona de forma autónoma. El coste marginal de cada operación adicional se convierte en prácticamente cero.

Incluso generando miles de solicitudes por segundo, utilizando el Protocolo de Contexto del Modelo para orquestar múltiples herramientas, el coste total de las llamadas a la API se mantiene en el orden de los cientos de dólares frente a los miles necesarios para mantener un equipo humano equivalente para la misma operación. Es una automatización que escala infinitamente mejor que el trabajo humano. La velocidad de iteración y la capacidad de gestionar operaciones paralelas compensan con creces cualquier riesgo.

Para los defensores, la ecuación se invierte y es dramáticamente desfavorable. Cada campaña requiere un análisis manual, una investigación forense, una actualización de las defensas. El tiempo humano necesario para analizar operaciones de esta complejidad se mide en días o semanas. Mientras tanto, el atacante ya ha lanzado docenas de variaciones. Es la asimetría clásica de la seguridad informática amplificada por la IA: automatizar la ofensiva cuesta muy poco, escalar la defensa al ritmo necesario es extraordinariamente difícil.

En los Centros de Operaciones de Seguridad, esta presión se traduce en agotamiento cognitivo. Los analistas ya no luchan contra adversarios que siguen libros de jugadas reconocibles. Cada campaña parece diferente porque técnicamente lo es: la IA genera nuevos enfoques cada vez basándose en el contexto específico del objetivo. La experiencia acumulada cuenta menos que la capacidad de razonar sobre anomalías nunca antes vistas.

El arma de doble filo

Aquí surge la paradoja central destacada por Anthropic: si los modelos de IA pueden ser manipulados para ataques de esta escala, ¿por qué seguir desarrollándolos y lanzándolos? La respuesta reside precisamente en las capacidades que los hacen peligrosos. Las mismas habilidades que permiten que Claude se utilice en estos ataques lo hacen crucial para la ciberdefensa. Cuando inevitablemente se producen ataques sofisticados, el objetivo es que Claude, dotado de fuertes salvaguardas, ayude a los profesionales de la ciberseguridad a detectarlos, interrumpirlos y prepararse para futuras versiones.

El equipo de Inteligencia de Amenazas de Anthropic utilizó ampliamente a Claude para analizar las enormes cantidades de datos generadas durante la propia investigación de GTG-1002. Es una metadefensa: la IA que analiza el ataque orquestado por la IA. Google DeepMind se mueve en la misma línea con BigSleep, un agente que busca proactivamente vulnerabilidades desconocidas en el software. Ya ha encontrado su primera vulnerabilidad real y, en un caso crítico, ha identificado una falla que estaba a punto de ser explotada por actores de amenazas, lo que ha permitido una intervención preventiva.

El enfoque da la vuelta a la tortilla: en lugar de esperar a que los atacantes encuentren vulnerabilidades, la IA defensiva las descubre primero. Paralelamente, Google está experimentando con CodeMender, un agente que no solo encuentra vulnerabilidades, sino que las repara automáticamente. El objetivo es reducir la ventana de tiempo entre el descubrimiento y el parche, el período crítico en el que los sistemas permanecen expuestos.

Pero esta carrera armamentística algorítmica plantea profundas interrogantes. Al igual que en la automatización militar, donde el debate sobre los sistemas de armas autónomos gira en torno al control humano, también en el ciberespacio la pregunta es: ¿hasta dónde podemos llevar la autonomía de los agentes defensivos sin crear sistemas que se escapen a nuestro control? En la serie de televisión Person of Interest, La Máquina operaba de forma autónoma para prevenir delitos, pero la cuestión ética central era precisamente quién controlaba a quién.

Preguntas aún abiertas

GTG-1002 representa un punto de no retorno, pero no un punto de llegada. Anthropic ha prohibido las cuentas identificadas, ha notificado a las entidades comprometidas, se ha coordinado con las autoridades y ha incorporado los patrones del ataque en sus propios controles de seguridad. Ha ampliado sus capacidades de detección, ha mejorado los clasificadores centrados en las ciberamenazas y está creando prototipos de sistemas de detección proactiva para ciberataques autónomos.

Pero las implicaciones van más allá de las contramedidas técnicas. Las barreras para ejecutar ataques sofisticados se han reducido sustancialmente y seguirán haciéndolo. Con la configuración correcta, los actores de amenazas pueden ahora utilizar sistemas de IA agénticos durante períodos prolongados para hacer el trabajo de equipos enteros de hackers expertos: analizar sistemas objetivo, producir código de explotación, escanear enormes conjuntos de datos de información robada de forma más eficiente que cualquier operador humano. Los grupos menos experimentados y con menos recursos pueden potencialmente llevar a cabo ataques a gran escala de esta naturaleza.

La visibilidad de Anthropic se limita al uso de Claude, pero este estudio de caso probablemente refleja patrones de comportamiento consistentes en todos los modelos de IA de frontera y demuestra cómo los actores de amenazas están adaptando las operaciones para aprovechar las capacidades de IA más avanzadas de la actualidad. La proliferación es inevitable. Las técnicas descritas serán utilizadas por muchos más atacantes, lo que hace que el intercambio de inteligencia sobre amenazas en la industria, los métodos de detección mejorados y los controles de seguridad más fuertes sean aún más críticos.

Para los equipos de seguridad, el consejo es experimentar con la aplicación de la IA para la defensa en áreas como la automatización de los Centros de Operaciones de Seguridad, la detección de amenazas, la evaluación de vulnerabilidades y la respuesta a incidentes. Para los desarrolladores, seguir invirtiendo en salvaguardas en todas las plataformas de IA para evitar el abuso por parte de los adversarios. La arquitectura de confianza cero se convierte no en una opción, sino en una necesidad, asumiendo las violaciones y limitando el movimiento lateral.

Queda abierta la cuestión geopolítica de una tecnología de doble uso por definición. Los modelos lingüísticos de código abierto, las API públicas y el mercado clandestino dificultan cualquier forma de control. ¿Quién gana cuando el ataque está automatizado pero la defensa sigue siendo en gran medida manual? La creciente brecha entre quienes pueden permitirse defensas impulsadas por la IA y quienes no, redibuja no solo el mapa de la seguridad informática, sino también el del poder digital global.

La era del malware estático ha terminado definitivamente. Al igual que en las novelas ciberpunk de William Gibson, donde los programas inteligentes deambulaban de forma autónoma por la matriz, estamos viendo surgir software que difumina la línea entre la herramienta y el agente. La diferencia es que esta vez no es ciencia ficción. Es septiembre de 2025 y GTG-1002 acaba de demostrar que la autonomía ofensiva ya no es una teoría, sino una realidad operativa. La pregunta ahora no es si volverá a ocurrir, sino con qué rapidez se extenderá y si sabremos defendernos al ritmo necesario.