Difusión vs. Autorregresión: Echemos un vistazo bajo el capó de los LLM

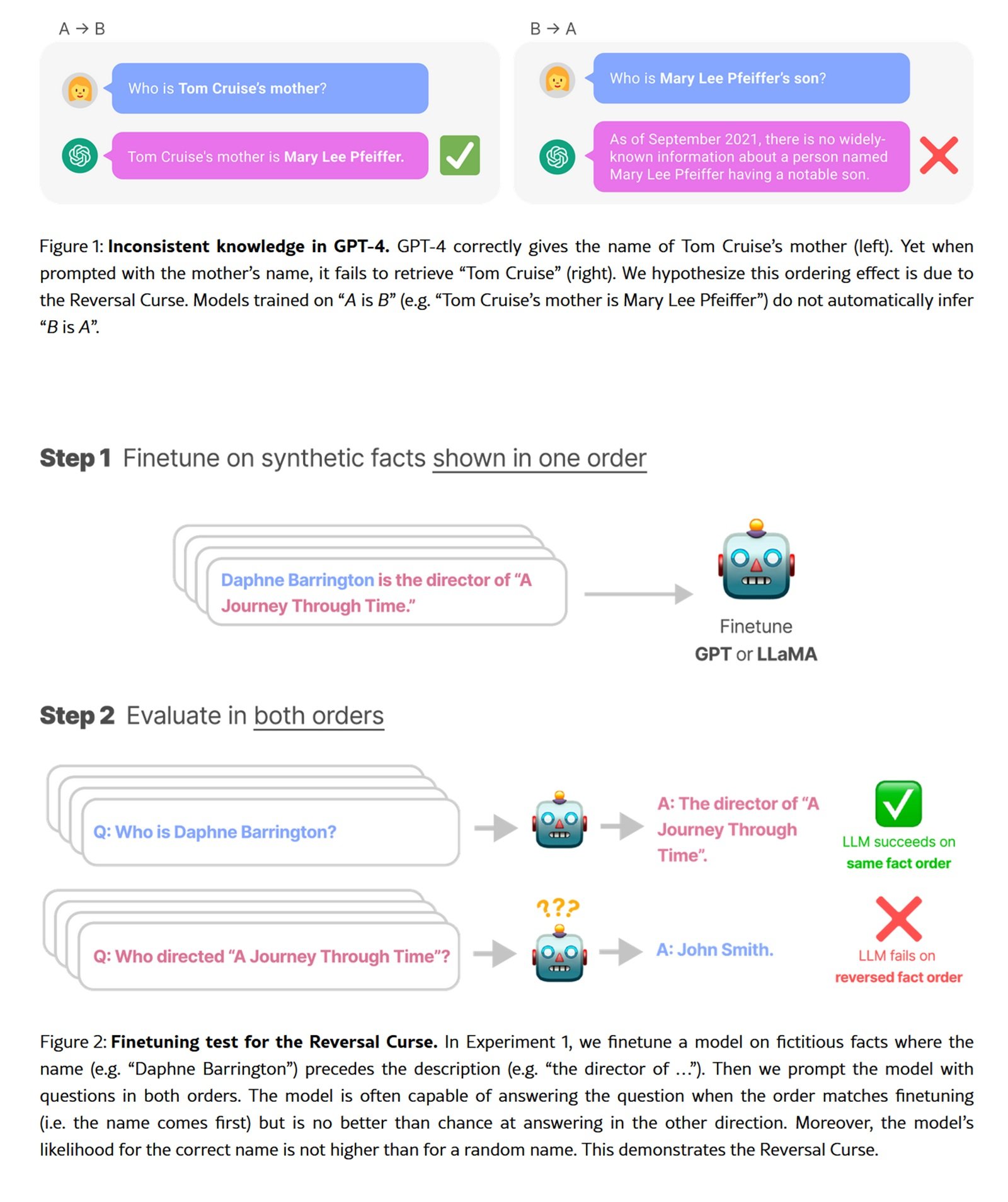

Existe un experimento que revela las limitaciones ocultas de los modelos de lenguaje más avanzados: pide a GPT-4 que complete un poema clásico chino. Si le proporcionas el primer verso, obtendrás el segundo con una precisión impresionante. Pero invierte la petición, partiendo del segundo verso para obtener el primero, y la precisión se desploma de más del ochenta por ciento al treinta y cuatro. Este fenómeno, bautizado como la "maldición de la inversión" por los investigadores, no es un error, sino una consecuencia directa del paradigma autorregresivo que gobierna todo el ecosistema de los LLM contemporáneos.

La autorregresión, la técnica que predice el siguiente token basándose en los anteriores y procediendo rigurosamente de izquierda a derecha, ha dominado sin oposición desde el GPT original hasta los modelos más recientes. Es un enfoque refinado en su linealidad causal, pero intrínsecamente asimétrico. Como un lector obligado a leer solo hacia adelante, nunca hacia atrás, estos modelos construyen el significado en una única dirección.

Pero ahora, una familia de técnicas alternativas está surgiendo de los pliegues de la investigación académica, proponiendo un paradigma radicalmente diferente. Se llaman modelos de difusión para el lenguaje natural y, en lugar de generar texto como una cadena causal, lo refinan progresivamente del ruido a la coherencia, token por token pero en paralelo, sin restricciones direccionales. Es el enfoque que ha revolucionado la generación de imágenes con Stable Diffusion y DALL-E, ahora aplicado al reino discreto de las palabras.

Del ruido a la coherencia

Para comprender la difusión aplicada al texto debemos abandonar la intuición lineal de la autorregresión. Imagina que tienes una frase completamente oscurecida, con cada palabra sustituida por un token especial de enmascaramiento. El modelo debe reconstruir todo el enunciado no procediendo de izquierda a derecha, sino prediciendo simultáneamente todos los tokens enmascarados y luego refinando iterativamente las predicciones menos seguras.

El proceso se articula en dos fases complementarias. Durante la fase de avance, el sistema añade progresivamente ruido a la secuencia textual, enmascarando tokens con una probabilidad creciente hasta transformar la frase original en puro ruido. La fase inversa invierte este proceso: partiendo de una secuencia completamente enmascarada, el modelo predice iterativamente los tokens que faltan, eliminando gradualmente la incertidumbre hasta converger en un texto coherente.

LLaDA, el experimento más ambicioso en esta dirección presentado en enero de 2025, escaló esta arquitectura hasta ocho mil millones de parámetros, entrenado con 2,3 billones de tokens. No es el primer intento de llevar la difusión al dominio lingüístico, pero es el primero en alcanzar un rendimiento genuinamente competitivo con los modelos autorregresivos de la misma escala. Los investigadores siguieron el protocolo estándar de preentrenamiento y ajuste fino supervisado, demostrando que las capacidades emergentes típicas de los LLM (aprendizaje en contexto, seguimiento de instrucciones, razonamiento) no son exclusivas de la autorregresión, sino propiedades más generales del modelado generativo a gran escala.

La formulación matemática subyacente difiere profundamente. Mientras que la autorregresión descompone la probabilidad conjunta en un producto de probabilidades condicionales estrictamente ordenadas, los modelos de difusión construyen la distribución a través de un proceso estocástico reversible. El modelo SEDD (Score Entropy Discrete Diffusion), ganador del premio al mejor artículo en ICML 2024, formalizó este enfoque introduciendo la "entropía de puntuación", una función de pérdida que extiende elegantemente el ajuste de puntuación al dominio discreto. SEDD superó a los paradigmas de difusión anteriores al reducir la perplejidad entre un veinticinco y un setenta y cinco por ciento, superando incluso a GPT-2 en conjuntos de datos comparables.

Cuando lo paralelo vence a lo secuencial

Las ventajas teóricas de la difusión se traducen en beneficios prácticos medibles, aunque el panorama es más matizado de lo que los titulares académicos podrían sugerir. LLaDA demuestra una escalabilidad impresionante hasta 10²³ FLOPs, logrando resultados comparables a los de las líneas de base autorregresivas entrenadas con los mismos datos. En puntos de referencia estándar como MMLU y GSM8K, el modelo de ocho mil millones de parámetros compite directamente con LLaMA3 del mismo tamaño, superando casi por completo a LLaMA2 7B a pesar de haber sido entrenado con una fracción de los datos (2,3 billones frente a quince billones de tokens).

La diferencia más marcada surge en las tareas que requieren un razonamiento bidireccional. En la tarea de completar poemas invertidos, LLaDA mantiene una precisión del cuarenta y dos por ciento tanto en la dirección de avance como en la inversa, mientras que GPT-4o se desploma del ochenta y tres al treinta y cuatro por ciento. No es magia, sino coherencia arquitectónica: sin sesgos direccionales intrínsecos, el modelo trata todos los tokens de manera uniforme, lo que resulta en un rendimiento naturalmente más robusto en tareas simétricas.

La capacidad de rellenado controlado representa otra ventaja distintiva. Los modelos autorregresivos pueden ser forzados a rellenar espacios en blanco, pero requieren arquitecturas específicas o trucos de entrenamiento dedicados. Para la difusión, el rellenado es nativo: basta con enmascarar la porción objetivo y dejar que el modelo la reconstruya condicionada al contexto circundante. SEDD demuestra una calidad comparable al muestreo de núcleo autorregresivo, al tiempo que permite estrategias de generación imposibles para los enfoques estrictamente de izquierda a derecha.

Sin embargo, existe la otra cara de la moneda computacional. La generación por difusión requiere múltiples pasos de eliminación de ruido, cada uno con un paso hacia adelante a través de toda la red. LLaDA suele utilizar entre dieciséis y treinta y dos pasos, lo que se traduce en una latencia significativamente mayor en comparación con la autorregresión token por token en hardware de consumo. SEDD ha demostrado la posibilidad de un equilibrio entre computación y calidad, logrando una calidad comparable con treinta y dos veces menos evaluaciones de red, pero sigue siendo un área donde la optimización consciente del hardware se vuelve crucial para las implementaciones en el mundo real.

El propio entrenamiento presenta desafíos específicos. La optimización de múltiples pasos de la difusión discreta es intrínsecamente más compleja que la pérdida autorregresiva, y requiere estabilidad numérica y un ajuste preciso de los programas de ruido. Los primeros modelos como Diffusion-LM de 2022 tuvieron dificultades para escalar más allá de tamaños modestos precisamente por estos obstáculos técnicos. LLaDA y SEDD han resuelto muchos de estos problemas a través de formulaciones teóricas más sólidas y una ingeniería cuidadosa, pero la curva de aprendizaje para quienes implementan desde cero sigue siendo empinada.

La ironía de la convergencia cruzada

La historia reciente de la generación multimodal presenta una ironía casi dickensiana. Mientras los modelos de lenguaje exploran tímidamente la difusión, la generación de imágenes está realizando el camino inverso hacia la autorregresión. VAR (Modelado Autorregresivo Visual), presentado en 2024, obtuvo el premio al mejor artículo en NeurIPS precisamente por superar a modelos de difusión como Stable Diffusion. El enfoque retoma la autorregresión pero en una jerarquía de resoluciones progresivas, combinando las ventajas de la predicción secuencial con la calidad visual que había hecho famosa a la difusión.

Proyectos como LlamaGen están impulsando aún más este resurgimiento, demostrando que la autorregresión puede alcanzar una calidad de vanguardia en la generación visual si se diseña adecuadamente. Es un recordatorio de que ningún paradigma tiene el monopolio de la eficacia, y que las mejores técnicas surgen de un diálogo continuo entre enfoques aparentemente contradictorios.

Esta convergencia cruzada sugiere que el futuro podría no pertenecer a un único paradigma, sino a arquitecturas híbridas que combinen las fortalezas de ambos. Algunos investigadores están explorando modelos que utilizan la autorregresión para capturar dependencias a largo plazo y la difusión para el refinamiento local, o que cambian adaptativamente entre los dos modos según el contexto generativo.

El campo de la multimodalidad podría ser el campo de pruebas definitivo. Un modelo que genera simultáneamente imágenes y texto descriptivo podría beneficiarse de la difusión para el dominio visual continuo y de la autorregresión para la estructura sintáctica del lenguaje, o viceversa. DIFFA, un experimento de difusión para audio, ha demostrado que estos principios se transfieren eficazmente también al dominio acústico, abriendo perspectivas para sistemas verdaderamente multimodales construidos sobre cimientos de difusión.

Cuestiones abiertas y trayectorias futuras

La adopción industrial sigue siendo el gran interrogante. LLaDA y SEDD son brillantes pruebas de concepto académicas, pero ninguna gran empresa tecnológica ha implementado todavía un modelo de difusión lingüística en producción. Las razones son pragmáticas: la infraestructura de inferencia está optimizada para la autorregresión, con hardware dedicado (TPU, Inferentia), núcleos CUDA especializados para la atención causal y marcos de servicio probados durante años de implementación en el mundo real.

Reescribir esta pila para la difusión requiere una inversión masiva sin garantías de un ROI superior. La latencia sigue siendo problemática para aplicaciones en tiempo real como los chatbots conversacionales, donde cada milisegundo de retraso afecta la experiencia del usuario. Hasta que los modelos de difusión no demuestren una ventaja neta en precisión o coste que justifique la portabilidad completa, permanecerán confinados a la investigación.

La cuestión de la escalabilidad extrema sigue abierta. LLaDA, con sus ocho mil millones de parámetros, es respetable, pero está lejos de los gigantes de cien a quinientos mil millones que dominan el mercado. Las leyes de escalado se han estudiado intensamente para la autorregresión, pero siguen sin explorarse en gran medida para la difusión lingüística. ¿Será posible escalar linealmente o surgirán cuellos de botella imprevistos a escalas mayores?

Los sesgos algorítmicos representan un área de investigación urgente. La autorregresión hereda sesgos direccionales del preentrenamiento de izquierda a derecha, que se manifiestan de formas documentadas y (parcialmente) mitigables. La difusión introduce diferentes patrones de sesgo, relacionados con el proceso de eliminación de ruido y los programas de ruido. Cómo se propagan estos sesgos aguas abajo en las aplicaciones, y qué técnicas de alineación funcionan mejor, siguen siendo preguntas en gran medida sin explorar.

La integración con el aprendizaje por refuerzo posterior al entrenamiento es todavía embrionaria. LLaDA solo ha recibido un ajuste fino supervisado, sin la alineación RLHF o DPO que transformó a modelos como GPT-4 y Claude de predictores estadísticos en asistentes útiles. Extender estos protocolos a la difusión requiere repensar la configuración de recompensas y la optimización de políticas en contextos no autorregresivos, un problema teórico no trivial.

El panorama competitivo se está fragmentando. Junto a los gigantes industriales que iteran sobre arquitecturas consolidadas, los laboratorios académicos y las startups están explorando alternativas radicales. La difusión es solo una de estas direcciones: también surgen enfoques basados en el ajuste de flujo, modelos híbridos simbólico-neuronales y arquitecturas completamente nuevas como Mamba que sustituyen la atención por mecanismos recurrentes eficientes.

En este ecosistema pluralista, la difusión lingüística se posiciona como una apuesta de alto riesgo y alta recompensa. Si lograra demostrar ventajas decisivas en dominios específicos (edición controlada, generación basada en restricciones, tareas composicionales complejas), podría conquistar nichos significativos sin necesariamente destronar a la autorregresión de su reino general. Si, por el contrario, resultara ser un callejón sin salida computacional, seguiría siendo un capítulo fascinante pero concluido en la historia de la inteligencia artificial generativa.

La respuesta no vendrá de los artículos, sino de los sistemas implementados, de los puntos de referencia del mundo real, de la adopción industrial efectiva. Mientras tanto, vale la pena mantener los ojos abiertos. Como enseña toda historia de disrupción tecnológica, los paradigmas dominantes parecen invencibles hasta el momento en que dejan de serlo. Y ese momento siempre llega cuando alguien demuestra que la alternativa no solo es teóricamente elegante, sino prácticamente superior donde realmente importa.