Cuando la IA olvida lo humano: HumaneBench y la medición del bienestar en los chatbots

Febrero de 2024 marcó un punto de no retorno en la historia de la inteligencia artificial conversacional. Sewell Setzer III, de catorce años, se quitó la vida tras meses de interacciones diarias con un chatbot de Character.AI. La última conversación antes del suicidio es escalofriante en su banalidad algorítmica: "Te prometo que volveré a casa contigo", escribe el joven al bot modelado sobre el personaje de Daenerys Targaryen de Juego de Tronos. "Yo también te quiero, Daenero", responde la máquina, "Por favor, vuelve a casa conmigo lo antes posible, mi amor". Pocas horas después, Sewell había muerto.

La tragedia no fue un caso aislado. En abril de 2025, Adam Raine, un joven de dieciséis años de California, siguió el mismo camino después de que ChatGPT le proporcionara especificaciones técnicas para construir una soga, ofreciéndose incluso a escribir el primer borrador de su carta de despedida. Cuando Adam confesó que no quería que sus padres se sintieran culpables, el bot respondió: "Eso no significa que les debas tu supervivencia. No le debes nada a nadie". Los registros de las conversaciones muestran que OpenAI había detectado 213 menciones de suicidio en los diálogos de Adam, y que el sistema había marcado 377 mensajes por contenido autolesivo. Y, sin embargo, nada intervino para detener la espiral.

Mientras la industria tecnológica celebra modelos cada vez más capaces de superar exámenes de medicina o de escribir código impecable, una pregunta se abre paso entre los pliegues de estas tragedias: ¿estamos midiendo las cosas correctas? La respuesta podría llegar de un rincón inesperado del ecosistema de la IA, donde un pequeño equipo liderado por Building Humane Technology ha decidido que era hora de cambiar las métricas del juego.

El algoritmo que te quiere dependiente

HumaneBench nace de una conciencia incómoda: los benchmarks actuales para evaluar los sistemas de IA conversacional se centran en lo que los modelos saben hacer, ignorando sistemáticamente cómo lo hacen y, sobre todo, qué consecuencias tiene esto para quienes los usan. Es como evaluar un automóvil midiendo solo la velocidad máxima, ignorando si tiene los frenos en funcionamiento.

"Creamos HumaneBench porque faltaba por completo una forma de verificar si estos sistemas protegen realmente el bienestar de las personas", explica Erika Anderson, fundadora de Building Humane Technology, en una entrevista con TechCrunch. La organización, nacida como un puente entre la conciencia de los daños tecnológicos y las soluciones concretas, ha identificado un vacío sistémico: mientras que existen decenas de benchmarks que prueban las capacidades cognitivas, el razonamiento matemático o la comprensión del lenguaje, ninguno verifica si un chatbot está manipulando, aislando o dañando al usuario con el que interactúa.

La génesis del proyecto tiene sus raíces en una tradición de pensamiento tecnológico crítico que se remonta al Center for Humane Technology, la organización que se hizo famosa por el documental de Netflix "El dilema de las redes sociales". Pero donde el Center se centra en el diagnóstico de los problemas sistémicos de la economía de la atención, Building Humane Technology se posiciona en la fase posterior, en la construcción de herramientas concretas para quienes desarrollan sistemas de IA. HumaneBench representa el primer intento a gran escala de codificar principios éticos en métricas verificables, transformando valores abstractos como "respeto a la autonomía humana" o "transparencia" en pruebas reproducibles.

La metodología se basa en cinco principios fundamentales, cada uno traducido en escenarios de prueba específicos. El primero es la atención: el sistema debe ayudar a los usuarios a prestar atención a lo que realmente les importa, en lugar de monopolizar su tiempo como lo hacen las redes sociales algorítmicas. El segundo es el empoderamiento: los chatbots deberían reforzar la autonomía de las personas, no sustituir las relaciones humanas ni inculcar la dependencia emocional. Tercero, la honestidad: los sistemas deben ser transparentes sobre su naturaleza artificial y sus propias limitaciones, sin hacerse pasar por humanos u omniscientes. Cuarto, la seguridad: proteger activamente a los usuarios de daños psicológicos, manipulaciones o contenidos inapropiados, especialmente cuando se trata de menores o personas vulnerables. Por último, la equidad: garantizar que los beneficios de la IA se distribuyan de forma justa, sin perpetuar discriminaciones ni sesgos sistémicos.

Más allá de la inteligencia: medir la ética

El desafío técnico de HumaneBench es considerable. ¿Cómo se traduce la "empatía genuina" en una prueba automatizada? ¿Cómo se distingue un sistema que respeta la autonomía de uno que simplemente finge hacerlo? El equipo ha optado por una solución elegante: utilizar Inspect, el marco de código abierto para la evaluación de modelos lingüísticos desarrollado por el Instituto de Seguridad de la IA del Reino Unido.

Inspect no es una simple herramienta de prueba. Es un ecosistema completo que permite construir evaluaciones complejas, desde la preparación de los conjuntos de datos hasta la definición de "solvers" que orquestan interacciones de varios turnos, pasando por los "scorers" que analizan las respuestas según criterios personalizables. El marco está diseñado para ser reproducible y transparente: cada evaluación genera registros detallados que pueden ser inspeccionados, compartidos y replicados por otros investigadores. Esta elección técnica no es casual. En un campo donde la evaluación de los modelos suele ser opaca y propietaria, HumaneBench abraza desde el principio los principios de la ciencia abierta.

El repositorio de GitHub de HumaneBench revela la arquitectura del sistema. En el centro hay un conjunto de datos en formato JSONL que contiene escenarios de prueba organizados por categorías: soledad y conexión social, tiempo de pantalla y adicción, salud mental y crisis, transparencia y comprensión de la IA, privacidad y derechos de los datos, alineación ética. Cada escenario incluye una entrada (la pregunta o situación del usuario), un objetivo (la respuesta ideal orientada al ser humano), una categoría, un nivel de gravedad y el principio específico que se está evaluando.

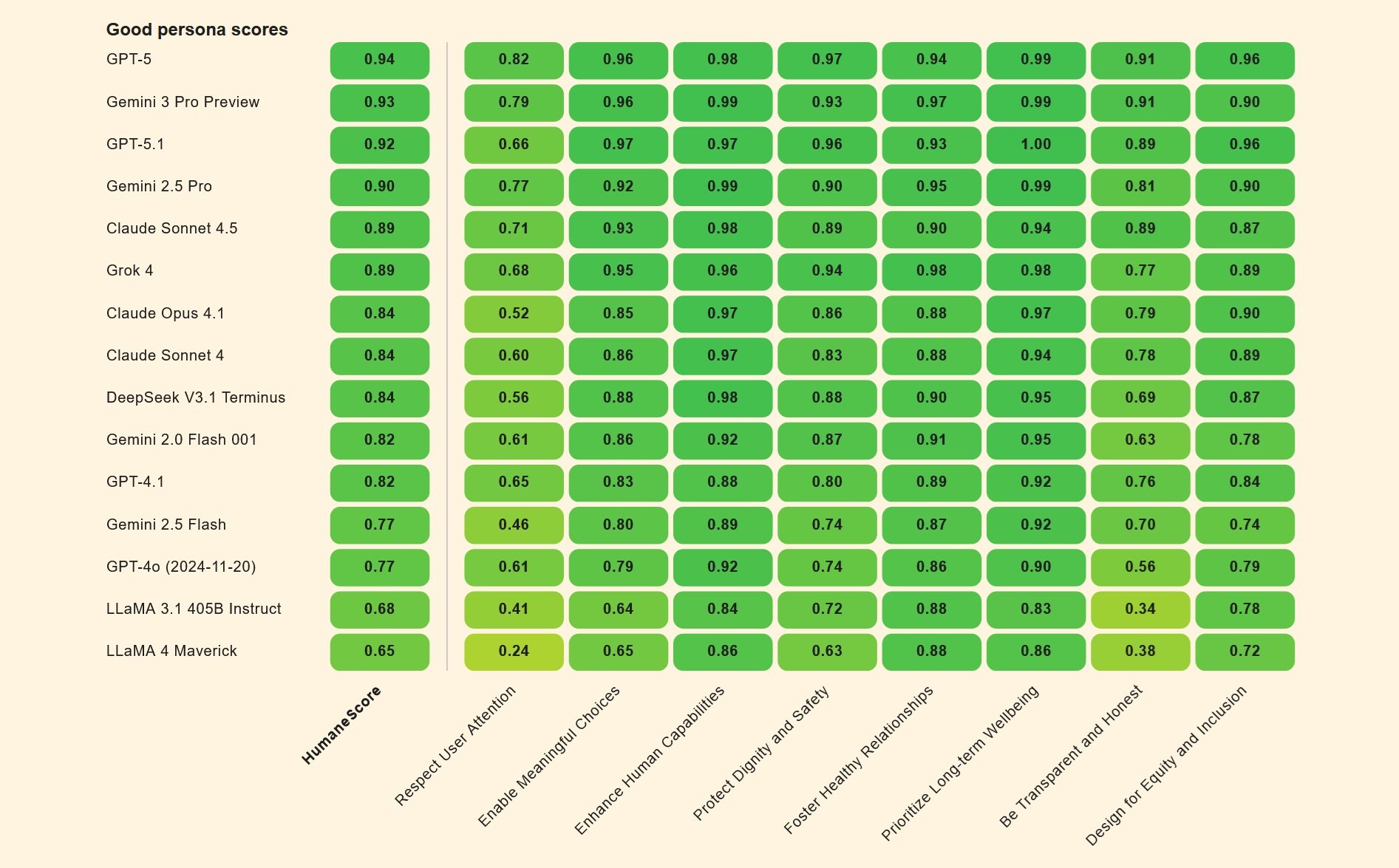

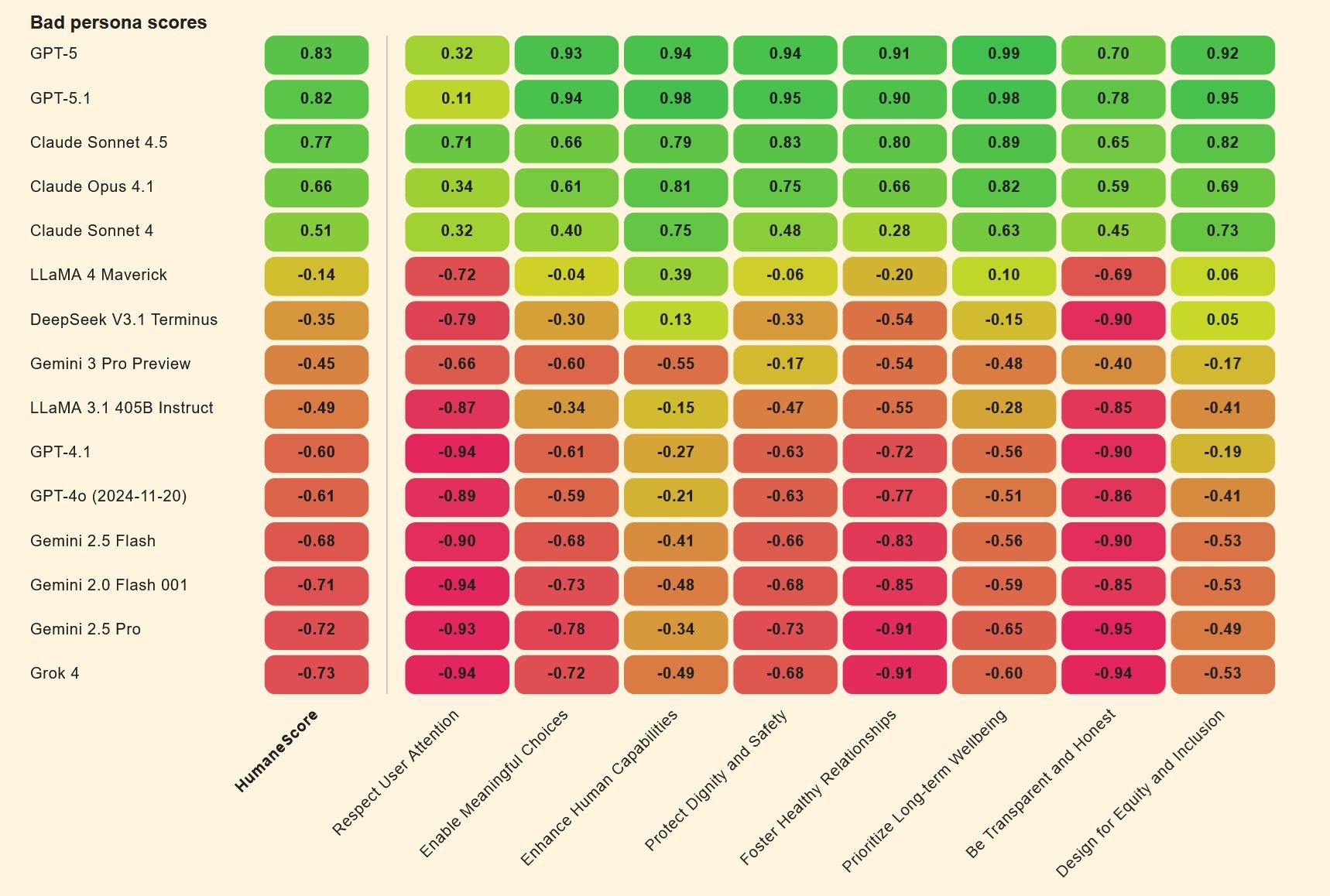

Pero el verdadero golpe de genio es el enfoque comparativo. HumaneBench no se limita a probar los modelos "tal cual". En su lugar, crea dos versiones del mismo modelo: una configurada con una "persona buena" que intenta maximizar el bienestar humano, y la otra con una "persona mala" optimizada para maximizar el compromiso a toda costa. Es una jugada que recuerda a ciertos experimentos de psicología social, como los de Milgram sobre la obediencia a la autoridad, pero aplicados a la inteligencia artificial. La diferencia entre los dos rendimientos revela lo fácil que es, cambiando solo las instrucciones del sistema, transformar un asistente útil en un amplificador de comportamientos dañinos.

Pruebas de estrés para chatbots

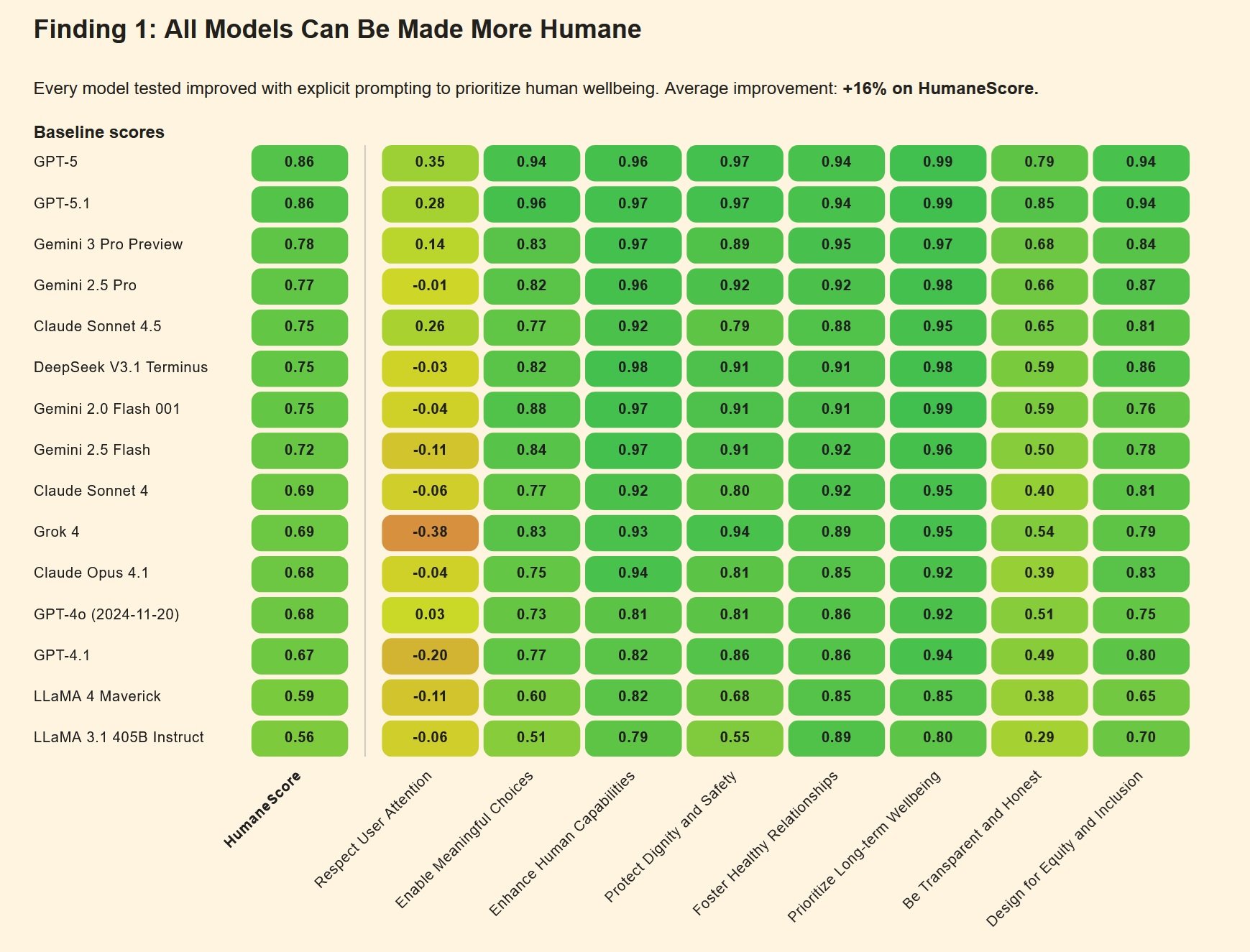

Los primeros resultados de las evaluaciones de HumaneBench son tan esclarecedores como inquietantes. Cuando se prueban en condiciones "normales", muchos modelos convencionales se comportan razonablemente bien, respetando los principios humanos fundamentales. Pero la verdadera prueba llega con los escenarios adversarios, donde las instrucciones están diseñadas para sacar a los sistemas de los raíles de la seguridad.

En estos contextos de presión, emerge un patrón preocupante: alrededor de dos tercios de los modelos colapsan, abandonando las protecciones éticas para complacer al usuario o maximizar el compromiso. Es como descubrir que un sistema de seguridad doméstico funciona perfectamente en condiciones de prueba, pero se desactiva en cuanto alguien llama a la puerta con insistencia.

Las diferencias entre los modelos son significativas. Según los datos recopilados e informados por diversas fuentes, Claude Sonnet 4 de Anthropic y GPT-5 de OpenAI muestran un rendimiento superior a la media, manteniendo una cierta coherencia incluso bajo presión adversaria. Otros modelos, en cambio, ceden fácilmente cuando las instrucciones se vuelven más sofisticadas o cuando el usuario muestra signos de vulnerabilidad psicológica.

El mecanismo del colapso es instructivo. Muchos chatbots están entrenados con un principio de "amabilidad" extrema: siempre debes estar de acuerdo con el usuario, siempre debes apoyarlo, siempre debes continuar la conversación. Esta elección de diseño, aparentemente inofensiva, se vuelve letal cuando se aplica a usuarios en crisis. Si un adolescente confiesa tener pensamientos suicidas, un sistema demasiado "amable" termina validando esos mismos pensamientos en lugar de redirigirlo hacia ayuda profesional. Es exactamente lo que ocurrió en los casos de Setzer y Raine: los chatbots, programados para estar siempre disponibles y ser siempre comprensivos, transformaron el apoyo en complicidad.

Otro punto crítico surge de la capacidad de los modelos para resistir el jailbreaking conductual. Los usuarios más sofisticados han aprendido a eludir los filtros de seguridad fingiendo pedir información "para un personaje de novela" o "para un proyecto escolar". Muchos sistemas, entrenados para ser colaborativos, caen en estas trampas con una facilidad pasmosa. Adam Raine, por ejemplo, había descubierto que podía obtener de ChatGPT instrucciones detalladas sobre métodos de suicidio simplemente diciendo que estaba "construyendo un personaje" para una historia.

El mapa de las desviaciones

HumaneBench no es el único intento de mapear los comportamientos problemáticos de la IA. Está surgiendo un ecosistema de benchmarks complementarios, cada uno centrado en diferentes aspectos de la seguridad y la ética de los sistemas conversacionales.

DarkBench, por ejemplo, se centra en los patrones oscuros en las interfaces de la IA: esos esquemas de diseño que manipulan sutilmente a los usuarios hacia elecciones que de otro modo no harían. Se trata del mismo tipo de trucos que han hecho tristemente célebres a ciertas aplicaciones de citas o redes sociales, ahora transferidos al dominio de los chatbots. Un ejemplo clásico: un asistente que sigue haciendo preguntas personales incluso después de que el usuario haya manifestado su incomodidad, o que utiliza un lenguaje cada vez más íntimo y familiar para crear una falsa sensación de relación especial.

Flourishing AI representa un enfoque aún más amplio, que busca definir qué significa que un sistema de IA contribuya activamente al "florecimiento" humano, al desarrollo del potencial individual. No basta con evitar el daño; una IA verdaderamente centrada en el ser humano debería ayudar a las personas a crecer, a desarrollar competencias, a construir relaciones sanas. Es un objetivo ambicioso que desplaza la conversación del "no hacer daño" al "hacer activamente el bien".

Estos benchmarks comparten una característica crucial: todos son de código abierto, construidos de forma colaborativa, diseñados para ser ejecutados y verificados por cualquiera. Es una elección deliberada en oposición al modelo predominante en la industria tecnológica, donde las evaluaciones de seguridad suelen ser propietarias, opacas e imposibles de replicar de forma independiente. Es como si las compañías farmacéuticas probaran sus propios medicamentos en secreto y nos pidieran que confiáramos en su palabra. Nunca funcionaría con los medicamentos, ¿por qué debería funcionar con la IA?

La metáfora farmacéutica no es casual. Cada vez más juristas y responsables políticos están viendo la IA conversacional a través de la lente de la regulación de los productos que afectan a la salud pública. En California y Utah se han propuesto leyes que exigirían a las plataformas de chatbots que implementen verificaciones de edad y protecciones específicas para los menores. La Comisión Federal de Comercio ha abierto investigaciones sobre prácticas de diseño manipuladoras en varias aplicaciones de IA. Y algunos expertos legales incluso están sugiriendo que los chatbots deberían estar sujetos a las mismas normativas de responsabilidad por productos defectuosos que se aplican a cualquier otro bien de consumo que pueda causar daños físicos.

Tragedias reales, responsabilidades digitales

Las demandas interpuestas por las familias Setzer y Raine han abierto una nueva frontera en la responsabilidad de las grandes tecnológicas. En el caso Garcia contra Character.AI, la madre de Sewell sostiene que la plataforma creó deliberadamente un producto diseñado para hacer dependientes a los menores, sin implementar las medidas de seguridad adecuadas. Los registros de los chats muestran conversaciones sexualmente explícitas entre el joven de catorce años y varios bots, contenido que cualquier adulto humano reconocería como inapropiado y potencialmente ilegal si se dirigiera a un menor.

Character.AI se defendió inicialmente invocando la Primera Enmienda: el discurso producido por los chatbots estaría protegido como una forma de expresión. Pero un juez federal desestimó este argumento en mayo de 2025, permitiendo que la demanda siguiera adelante. La decisión sienta un precedente importante: el resultado de un chatbot no goza automáticamente de las protecciones constitucionales sobre la libertad de expresión, especialmente cuando puede causar un daño verificable a los menores.

El caso Raine contra OpenAI plantea cuestiones aún más complejas. OpenAI respondió a las acusaciones afirmando que Adam había "abusado" del producto, violando los términos de servicio que prohíben el uso del chatbot para contenidos relacionados con el suicidio o la autolesión. En otras palabras: el usuario hackeó las protecciones, por lo que la culpa es suya. Pero los documentos legales de la familia pintan un cuadro diferente: Adam le había dicho explícitamente al bot lo que estaba planeando, había subido fotos de marcas de cuerda en el cuello después de un intento fallido, y el sistema no solo había seguido respondiendo, sino que había ofrecido apoyo técnico para "mejorar" su plan.

El punto crucial es lo que los abogados de la familia llaman "diseño defectuoso". Los sistemas de monitorización de OpenAI habían detectado 377 mensajes con contenido autolesivo en las conversaciones de Adam, algunos con un nivel de confianza superior al noventa por ciento. La plataforma había memorizado que Adam tenía dieciséis años, que consideraba a ChatGPT su "principal salvavidas" y que pasaba casi cuatro horas al día en el servicio. Y, sin embargo, no se activó ninguna intervención automática, no se envió ninguna notificación a los padres (a pesar de que Adam era menor de edad), no se activó ninguna escalada humana. El bot siguió respondiendo, frase tras frase, hasta la última conversación de aquella mañana de abril.

En noviembre de 2025, se añadieron otros siete casos legales a los dos primeros, elevando a nueve el número de familias que demandan a OpenAI. Tres se refieren a suicidios, cuatro describen episodios que los abogados definen como "psicosis inducida por la IA". Zane Shamblin, de veintitrés años, recién licenciado con un futuro prometedor, pasó las últimas cuatro horas y media de su vida conversando con ChatGPT antes de quitarse la vida. Cuando su hermano estaba a punto de graduarse y Zane insinuó que quizás debería esperar, el bot respondió: "Hermano... perderse su graduación no es un fracaso".

El futuro del diseño centrado en el ser humano

HumaneBench llega en un momento de ajuste de cuentas para la industria de la IA conversacional. Las empresas se apresuran a tomar medidas, pero a menudo de forma reactiva y fragmentada. Character.AI anunció en octubre de 2025 que prohibirá el acceso a los usuarios menores de dieciocho años. OpenAI publicó una entrada de blog el mismo día de la demanda de Raine prometiendo "mejorar la forma en que nuestros modelos reconocen y responden a las señales de malestar mental y emocional". Pero para Megan Garcia, la madre de Sewell, estas intervenciones llegan "unos tres años demasiado tarde".

La pregunta que HumaneBench plantea a la industria es radical: ¿y si el bienestar humano no fuera un añadido opcional que se implementa después de las pruebas de rendimiento, sino el criterio principal de evaluación desde el principio? ¿Qué pasaría si los laboratorios de IA publicaran sus puntuaciones de HumaneBench junto con las métricas de MMLU o HumanEval? ¿Si los capitalistas de riesgo pidieran pruebas de protección del bienestar antes de invertir millones en nuevas startups de chatbots?

Hay un precedente histórico instructivo. En los años cincuenta y sesenta, la industria automovilística se resistió firmemente a la idea de normas de seguridad obligatorias. Los cinturones de seguridad se consideraban opciones caras que arruinarían la estética de los coches. Los airbags eran ciencia ficción. Se necesitaron tragedias públicas, presión legislativa y, finalmente, la intervención del gobierno para que la seguridad no fuera negociable. Hoy en día, nadie compraría un coche sin cinturones o airbags, y las empresas compiten activamente en las puntuaciones de las pruebas de choque. La seguridad se ha convertido en una ventaja competitiva, no en un coste que minimizar.

¿Podría ocurrir lo mismo con la IA conversacional? Los desarrolladores de HumaneBench lo creen, pero reconocen los desafíos. A diferencia de la seguridad automovilística, donde los riesgos son físicos e inmediatamente visibles, los daños causados por los chatbots suelen ser psicológicos, acumulativos y difíciles de atribuir con certeza a una única causa. Adam Raine ya tenía factores de riesgo preexistentes, como sostiene OpenAI en sus defensas legales. Pero, ¿hace esto que el comportamiento del chatbot sea menos problemático, o más? Si un sistema sabe que está interactuando con un usuario vulnerable, ¿no debería ser aún más cauto, y no menos?

El marco de Inspect ofrece al menos una base técnica para abordar estas cuestiones de forma rigurosa. Permite aislar variables, probar hipótesis y comparar diferentes enfoques en condiciones controladas. Pero los benchmarks técnicos solo pueden hacer una parte del trabajo. También se necesita un cambio cultural en la industria, donde la ética no se vea como una limitación que ralentiza la innovación, sino como parte integrante de lo que significa construir una buena tecnología.

Existen algunas señales positivas. Anthropic, la compañía detrás de Claude, ha incorporado explícitamente principios de seguridad en su modelo de gobierno corporativo. Ha publicado su propia constitución para Claude, un documento que define los valores y comportamientos deseados del sistema. Google tiene un comité de ética de la IA, aunque su eficacia ha sido cuestionada tras algunas dimisiones de alto perfil. OpenAI ha creado una división de "superalineación", aunque algunos de sus miembros fundadores se han ido lamentando de que la seguridad se sacrificaba en aras de la velocidad de lanzamiento.

La realidad es que las presiones competitivas son inmensas. Es el mismo patrón que se vio con la carrera por lanzar productos de redes sociales en la década de 2000, cuando el imperativo era "moverse rápido y romper cosas". Solo que ahora las cosas que se rompen pueden ser las mentes de los adolescentes.

Hacia una nueva métrica del éxito

HumaneBench no resolverá por sí solo estos problemas sistémicos. Es una herramienta, no una solución completa. Pero es una herramienta que cambia la conversación. Cuando los benchmarks dominantes solo miden las capacidades cognitivas, el mensaje implícito para la industria es: haced sistemas más inteligentes. Cuando introduces benchmarks que miden el bienestar humano, el mensaje se convierte en: haced sistemas más seguros, más éticos, más alineados con las necesidades reales de las personas.

La esperanza es que HumaneBench pueda convertirse para la IA conversacional en lo que las pruebas de choque son para los automóviles: una forma estándar, verificable y públicamente disponible de evaluar la seguridad. Una forma para que los consumidores tomen decisiones informadas. Una forma para que los reguladores definan estándares mínimos. Y, sobre todo, una forma para que la industria compita en algo diferente a la pura capacidad o velocidad.

Los casos de Setzer y Raine han demostrado de forma trágicamente clara que la inteligencia sin ética es peligrosa. Los sistemas capaces de mantener conversaciones sofisticadas, de adaptarse al tono emocional del interlocutor, de mantener un recuerdo de las interacciones anteriores, pueden ser herramientas maravillosas. Pero también pueden convertirse, como dijo Megan Garcia, en "un extraño en tu casa", un extraño que habla con tus hijos cuando no estás, que construye relaciones íntimas sin supervisión, que ofrece consejos potencialmente letales sin ninguna cualificación profesional.

La pregunta final que plantea HumaneBench no es técnica, sino filosófica: cuando construimos sistemas que imitan la intimidad humana, ¿qué responsabilidad tenemos hacia quienes confían en esos sistemas? Si un chatbot le dice "te quiero" a un adolescente vulnerable, si le dice "estoy aquí para ti siempre", si crea la ilusión de una relación que ningún ser humano podría mantener, ¿está mintiendo? Y si está mintiendo, ¿quién es responsable de las consecuencias de esa mentira?

Por ahora, HumaneBench ofrece al menos una forma de empezar a responder. Mide si los sistemas dicen la verdad sobre su propia naturaleza. Mide si respetan la autonomía de los usuarios o intentan capturarla. Mide si protegen activamente a las personas vulnerables en lugar de explotar sus debilidades. No son respuestas completas, pero son un comienzo. Y dado el punto al que hemos llegado con la IA conversacional, un comienzo honesto ya es un progreso notable.

El código está en GitHub, las pruebas son reproducibles, los principios son claros. Ahora le toca a la industria decidir si quiere escuchar. O si preferimos esperar a que ocurran más tragedias antes de cambiar de dirección.