¿Conquistarán los Small Language Models el 2026?

Andy Markus es el Director de Datos de AT&T, no es precisamente el tipo de persona que se deja llevar por el entusiasmo. Cuando en una entrevista a finales de 2025 declaró que los Small Language Models afinados se convertirían en "la gran tendencia de 2026", muchos observadores levantaron una ceja. Sin embargo, esa ceja podría estar justificada: 2025 marcó un cambio de rumbo con respecto al mantra "cuanto más grande, mejor" que ha dominado la IA en los últimos tres años.

Es el mismo cambio de paradigma que documentamos cuando el MIT demostró cómo los modelos pueden aprender a pensar menos y mejor a través de la asignación dinámica de recursos, o cuando Harvard reveló que las capacidades de razonamiento ya estaban en los modelos base, solo había que extraerlas de la manera correcta. Incluso gigantes como Samsung y Microsoft han invertido en técnicas que priorizan la inteligencia algorítmica sobre la fuerza bruta, como demuestran el enfoque TRM para la recuperación selectiva y DeepConf para la autocorrección basada en la confianza. La pregunta ahora es: ¿representan los SLM un avance pragmático o una burbuja más destinada a desinflarse? Y, sobre todo, ¿quién gana y quién pierde en este nuevo equilibrio?

Anatomía de un modelo compacto

Definir qué es un Small Language Model no es tan trivial como parece. Si le preguntas a diez investigadores, obtendrás al menos doce respuestas diferentes. El umbral más comúnmente aceptado ronda los diez mil millones de parámetros, pero es una convención tan arbitraria como el límite entre un planeta enano y un planeta. Lo que realmente importa es la capacidad de despliegue: un SLM es un modelo diseñado para funcionar eficientemente en hardware de consumo o dispositivos de borde, consumiendo poca memoria y produciendo respuestas con una latencia inferior al segundo.

A diferencia de los LLM, que son esencialmente modelos transformer escalados hasta lo inverosímil y entrenados con terabytes de datos, los SLM nacen de una reconsideración arquitectónica. La técnica más extendida es la destilación de conocimiento: un modelo "maestro" masivo transfiere sus conocimientos a un "estudiante" compacto, que aprende a replicar el comportamiento del gigante utilizando una fracción de los recursos. Es como si Richard Feynman hubiera comprimido su conocimiento de física en un libreto de bolsillo sin perder la esencia. Pero no termina ahí. La poda elimina conexiones neuronales redundantes, como un jardinero que poda un árbol para que crezca más sano. La cuantización reduce la precisión numérica de los pesos: en lugar de representar cada número con 32 bits, se usan 8, 4 o incluso 1.58 bits como en el reciente BitNet, obteniendo modelos que ocupan una décima parte del espacio original con pérdidas de precisión sorprendentemente contenidas.

Las arquitecturas híbridas representan la frontera más interesante. Modelos como Samba-CoE de SambaNova Systems combinan State Space Models, que procesan secuencias de forma lineal sin la explosión cuadrática de complejidad típica de la atención, con mecanismos de atención selectiva aplicados solo donde es necesario. El resultado son modelos que escalan a contextos de millones de tokens manteniendo una velocidad de inferencia casi constante. No son LLM encogidos: son sistemas repensados desde cero para maximizar la relación rendimiento-eficiencia.

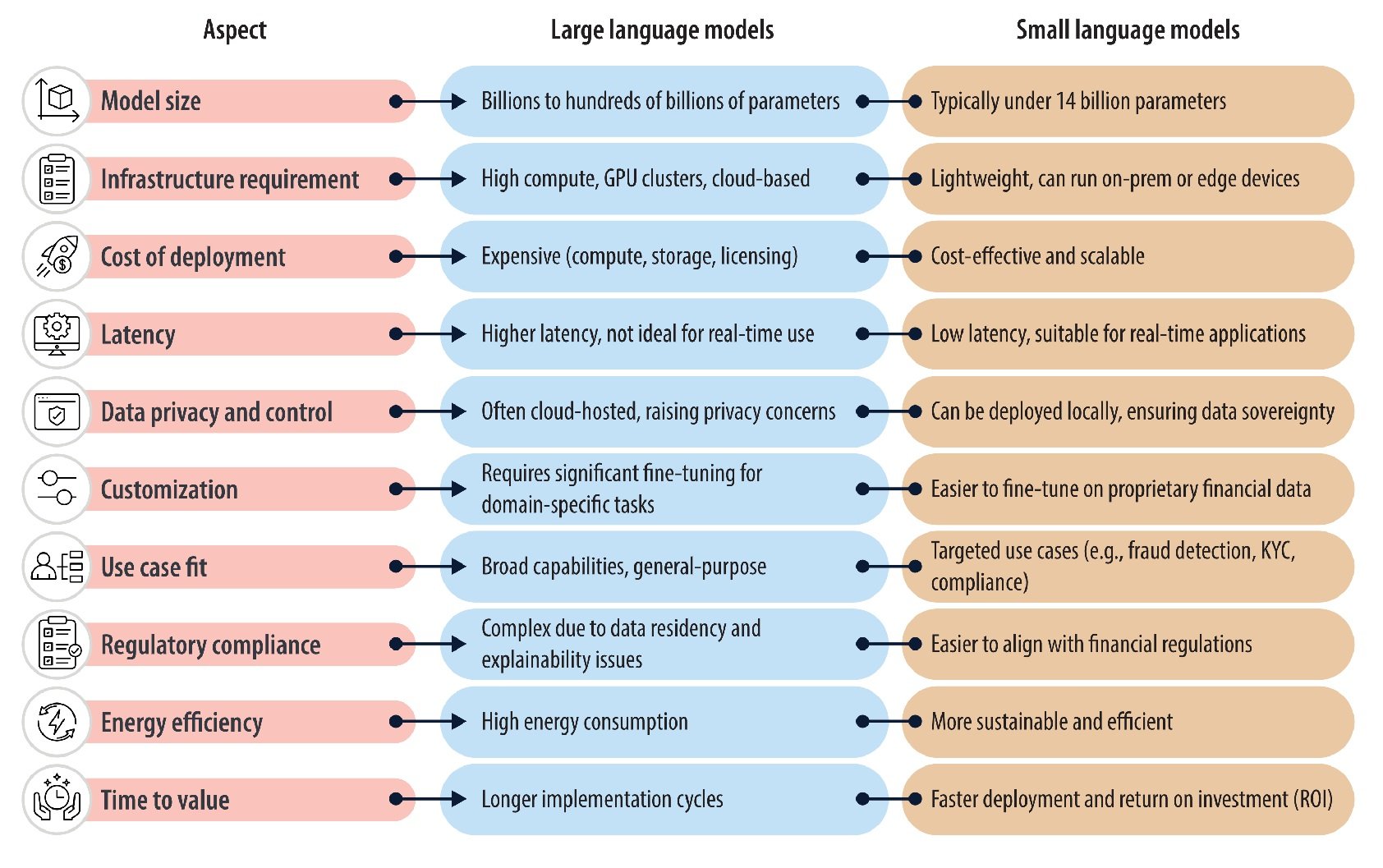

La comparación que importa: SLM vs. LLM

Las diferencias estructurales se traducen en compromisos operativos precisos. En el frente del rendimiento puro, la brecha se ha reducido drásticamente en los últimos doce meses. Phi-3.5-Mini de Microsoft, con sus tres mil ochocientos millones de parámetros, iguala a GPT-3.5 en benchmarks matemáticos como GSM8K utilizando un noventa y ocho por ciento menos de potencia computacional, según datos publicados por Microsoft Research a mediados de 2025. Llama 3.2 de tres mil millones supera a modelos de setenta mil millones en tareas de dominio específico después de un ajuste fino dirigido. Pero cuando se pasa a un razonamiento complejo multidominio o a consultas que requieren un amplio conocimiento general, los LLM mantienen una ventaja neta: GPT-4 o Claude Sonnet resuelven problemas que requieren concatenaciones lógicas profundas con una precisión que ningún SLM actual alcanza en modo zero-shot.

La latencia es donde los SLM brillan sin concesiones. Un modelo de siete mil millones genera tokens en tiempo real en una sola GPU de consumo, con retrasos medibles en decenas de milisegundos. Un modelo de ciento cincuenta mil millones requiere clústeres de múltiples GPU e introduce retrasos de segundos solo para inicializar la inferencia. Para aplicaciones en tiempo real como asistentes de voz, control robótico o monitoreo industrial, esta diferencia no es despreciable: es la frontera entre lo utilizable y lo inútil.

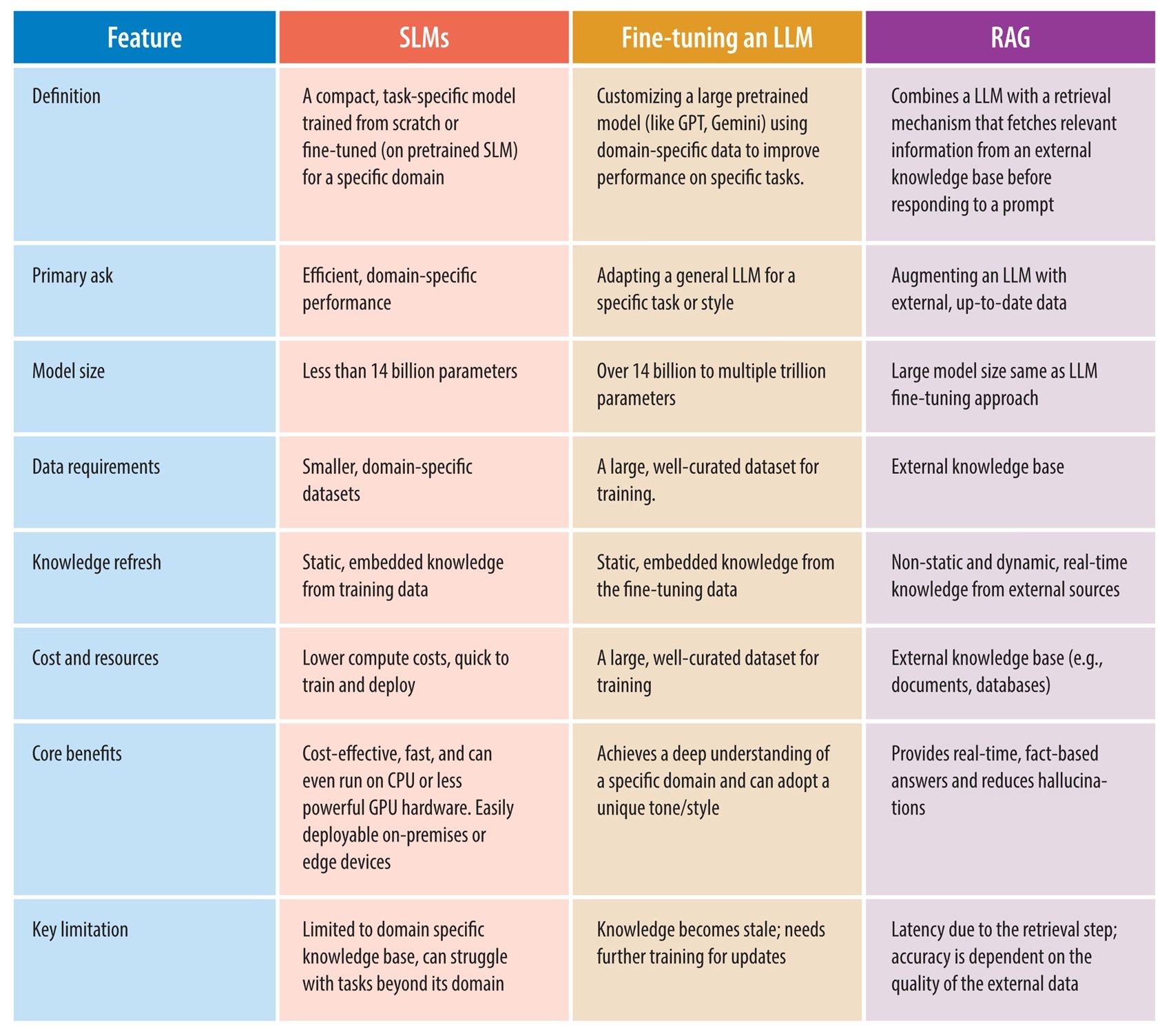

En el aspecto económico, los números cuentan historias divergentes. El entrenamiento de GPT-3 costó más de cien millones de dólares según estimaciones conservadoras, requiriendo meses de cálculo en miles de GPU. El ajuste fino de un modelo de siete mil millones en una tarea específica puede costar unos pocos miles de dólares en una sola GPU A100 alquilada por unos días. Pero hay un compromiso oculto: los LLM son generalistas extraordinarios, un mismo modelo sirve para mil casos de uso. Un SLM afinado sobresale en su dominio pero colapsa tan pronto como sales del perímetro de entrenamiento. Por lo tanto, se necesitan baterías de SLM especializados donde un solo LLM era suficiente, desplazando la complejidad del entrenamiento a la orquestación.

La verdadera línea divisoria es la generalización frente a la especialización. Los LLM son la navaja suiza de la IA: hacen todo decentemente. Los SLM son bisturíes quirúrgicos: sobresalen en tareas precisas y fracasan estrepitosamente fuera de contexto. Esta dicotomía está empujando a la industria hacia arquitecturas híbridas: un SLM filtra las consultas de rutina, un LLM interviene solo en los casos extremos y complejos. Es el patrón en cascada que startups como Anthropic están explorando en sus pilas de producción.

Cuándo usar qué: la brújula para decidir

Los escenarios ideales para los SLM surgen con claridad del análisis de los despliegues de 2025. La computación en el borde es su terreno natural: dispositivos IoT con chips ARM de bajo consumo, teléfonos inteligentes que procesan datos sensibles sin enviarlos a la nube, coches autónomos que deben reaccionar en milisegundos sin depender de una conectividad incierta. Cada aplicación donde la latencia de la red o la privacidad de los datos son restricciones estrictas se convierte en territorio de los SLM. En el sector de la salud, los dispositivos médicos con SLM integrados analizan señales vitales en tiempo real detectando anomalías sin transmitir nunca los datos del paciente fuera del perímetro local, eludiendo gran parte de las complejidades para la protección de la privacidad y la seguridad de la información sanitaria. En las finanzas, los terminales de pago con detección de fraude en el dispositivo bloquean transacciones sospechosas en milisegundos, mucho antes de que cualquier API en la nube pueda responder.

Las aplicaciones de dominio específico donde el ajuste fino sobresale son el otro punto fuerte. Un modelo de tres mil millones entrenado en millones de contratos legales italianos supera a GPT-4 en la extracción de cláusulas específicas de documentos técnicos, porque ha visto variaciones lingüísticas que el gigante generalista nunca ha encontrado. Un SLM afinado en el código base interno de una empresa entiende las convenciones de nomenclatura, los patrones arquitectónicos y las dependencias heredadas mejor que Copilot. Pero cuidado: estas ventajas se evaporan tan pronto como cambias de dominio. Ese modelo legal impecable en contratos comerciales se derrumba estrepitosamente en los de derecho administrativo si no los ha visto en el conjunto de entrenamiento.

Cuándo se necesita todavía un LLM, la respuesta es igualmente clara. Razonamiento de múltiples pasos que concatena la lógica de diferentes dominios, investigación exploratoria donde no sabes lo que buscas hasta que lo encuentras, amplitud del conocimiento general para conversaciones que saltan de la física cuántica a las recetas de cocina. Los SLM son especialistas brillantes, los LLM son generalistas indispensables. La frontera pragmática es entender que no son alternativas, sino complementarias. Sebastian Raschka, líder de investigación de Lightning AI, lo resume así: el progreso de 2026 vendrá más de optimizar la inferencia que de engrosar el entrenamiento. Es un cambio de perspectiva radical para una industria obsesionada con el mantra "la escala es todo lo que necesitas".

El impacto ambiental completa el cuadro de decisiones. Hemos documentado en detalle cómo el consumo de agua de la IA se está convirtiendo en un problema sistémico: el entrenamiento de GPT-3 consumió mil trescientos ochenta y siete megavatios-hora, energía suficiente para ciento veinte hogares estadounidenses durante un año entero. Cada consulta a ChatGPT requiere treinta mililitros de agua para la refrigeración de los servidores y 0,42 vatios-hora de electricidad. Con setecientos millones de consultas diarias, la escala se vuelve alarmante: energía para treinta y cinco mil hogares al año. Los SLM reducen esta huella en un cuarenta por ciento según datos de la industria de 2025, no por arte de magia, sino por física elemental: menos parámetros significan menos cálculos, menos memoria, menos calor que disipar. Melanie Nakagawa, Directora de Sostenibilidad de Microsoft, lo dijo claramente: la intensidad energética nos empuja a acelerar la eficiencia. No es greenwashing: es supervivencia competitiva en un mundo donde los costos energéticos se están convirtiendo en el principal obstáculo para la escalabilidad.

La galaxia de los modelos: quién está en el campo

El panorama de los SLM a principios de 2026 es sorprendentemente denso. La familia Phi de Microsoft domina las conversaciones empresariales: Phi-4-mini integra capacidades de razonamiento multimodal, procesa imágenes y texto manteniendo un tamaño por debajo de los cuatro mil millones de parámetros. Meta ha lanzado Llama 3.2 en variantes de uno y tres mil millones, con versiones de visión que aceptan entradas visuales de forma nativa. Google ha respondido con Gemma 3n, optimizado específicamente para el despliegue en dispositivos en teléfonos inteligentes Android con soporte para más de ciento cuarenta idiomas, con el objetivo de democratizar la IA multilingüe en los mercados emergentes.

Qwen 3 de Alibaba representa el fenómeno más interesante: la versión de catorce mil millones ha superado a Llama en descargas en HuggingFace durante tres meses consecutivos entre septiembre y noviembre de 2025, lo que indica un cambio en la comunidad de código abierto hacia modelos más eficientes. Las variantes más pequeñas de 0,6 y 1,8 mil millones han encontrado una adopción masiva en China para aplicaciones de borde donde el consumo de energía es una restricción principal. Mistral AI ha lanzado Ministral 3, optimizado para la inferencia en el borde con una cuantización agresiva que mantiene una calidad sorprendente. Como analizamos al discutir la estrategia de Mistral con Devstral, las startups europeas están apostando por la eficiencia y la especialización para competir con los gigantes estadounidenses que dominan la escalabilidad vertical.

HuggingFace ha contribuido con SmolLM3, acompañado de un completo plan de ingeniería que documenta cada aspecto del pipeline de entrenamiento. Es un experimento de transparencia radical: conjunto de datos, hiperparámetros, estudios de ablación, todo público. El objetivo declarado es reducir las barreras de entrada para investigadores y pequeñas empresas que quieran entrenar SLM personalizados sin reinventar la rueda cada vez. La distinción entre modelos de código abierto y propietarios se está difuminando: incluso gigantes como Microsoft y Google lanzan variantes de sus SLM con licencias permisivas, conscientes de que el ecosistema creado por una comunidad activa vale más que el bloqueo propietario.

La huella ecológica que marca la diferencia

Las cifras del impacto ambiental merecen un análisis más profundo porque se están convirtiendo en un motor competitivo y no solo en una cuestión ética. Microsoft registró un aumento del treinta y cuatro por ciento en el consumo de agua entre 2021 y 2022, un incremento atribuible casi en su totalidad a la expansión de la infraestructura de IA. Google ha documentado patrones similares en sus centros de datos. El problema es sistémico: los modelos de lenguaje masivos generan calor que debe ser disipado, y los sistemas de refrigeración más eficientes utilizan la evaporación de agua. Cuantos más parámetros entrenas, más calor produces, más agua consumes.

Los SLM intervienen en ambos frentes. Durante el entrenamiento, un modelo de siete mil millones requiere órdenes de magnitud menos energía que uno de setenta. Pero es durante la inferencia donde el impacto escala dramáticamente: miles de millones de consultas diarias en modelos compactos en lugar de en gigantes producen ahorros acumulativos enormes. El benchmark SLM-Bench lanzado a finales de 2025 representa el primer marco sistemático para medir los compromisos entre precisión y sostenibilidad, introduciendo métricas que ponderan el rendimiento y la eficiencia energética con la misma prioridad. Empresas como Hugging Face ya lo están integrando en sus hubs de modelos para permitir a los desarrolladores elegir conscientemente.

Pero hay un giro paradójico que rara vez se discute. Si los SLM reducen tanto el costo por consulta, el riesgo es un efecto rebote: las empresas podrían multiplicar el uso porque "cuesta poco", anulando los beneficios ambientales con la explosión del volumen. Es el mismo mecanismo que ha anulado las ganancias de eficiencia energética de los coches: motores más eficientes han llevado a conducir más y a comprar SUV más pesados. La sostenibilidad real requerirá no solo modelos más eficientes, sino también una gobernanza sobre cuánto y cómo los usamos.

Del laboratorio a las fábricas: casos de estudio reales

Los despliegues empresariales cuentan historias más concretas que las especulaciones teóricas, aunque documentar los detalles específicos sigue siendo un desafío en el mundo corporativo donde las implementaciones de IA a menudo están cubiertas por acuerdos de confidencialidad. Lo que emerge con claridad de los informes de la industria y las declaraciones públicas es un patrón de adopción que privilegia la eficiencia, la privacidad y la especialización.

En el sector financiero, JPMorgan Chase ha desplegado COiN (Contract Intelligence), un Small Language Model especializado en el análisis automático de contratos de préstamos comerciales, un proceso tradicionalmente gestionado manualmente por equipos legales. Al entrenar a COiN en miles de documentos legales y presentaciones regulatorias, el banco ha reducido los tiempos de revisión de contratos de varias semanas a unas pocas horas, manteniendo una alta precisión y trazabilidad del cumplimiento. Esto ha permitido reasignar los recursos legales hacia tareas que requieren un juicio humano complejo, garantizando al mismo tiempo una adherencia constante a los estándares normativos en evolución.

La detección de fraude representa otro terreno fértil para los SLM empresariales. Como documentan Infosys y Lumenalta, las instituciones bancarias están entrenando modelos compactos en patrones fraudulentos específicos para analizar transacciones e identificar actividades sospechosas casi instantáneamente. La eficiencia y la alta precisión permiten reducir significativamente los falsos positivos, al tiempo que aumentan las tasas de detección. Los SLM en este dominio se utilizan para la prevención de la toma de cuentas, analizando patrones de inicio de sesión y cambios de comportamiento en tiempo real, para identificar actividades de blanqueo de dinero automatizando tareas que tradicionalmente requerían una intervención manual significativa, y para la detección de fraudes en los pagos digitales, donde sobresalen en el reconocimiento rápido de patrones.

La ventaja clave en el uso de SLM para la prevención de fraudes radica en su capacidad para ser continuamente actualizados y afinados en función de nuevos patrones de amenazas, lo que permite a los bancos adelantarse a los esquemas fraudulentos emergentes manteniendo la eficiencia operativa. FinBERT, un modelo transformer entrenado meticulosamente en datos financieros diversificados como transcripciones de llamadas de resultados, artículos de noticias financieras e informes de mercado, representa otro ejemplo concreto de especialización eficaz. Este entrenamiento específico del dominio habilita a FinBERT para detectar con precisión el sentimiento dentro de los documentos financieros, identificando tonos matizados como positivo, negativo o neutral que a menudo guían el comportamiento de los inversores y los mercados.

En el sector de la salud, la adopción es más cautelosa por las restricciones regulatorias, pero se está acelerando. Según informa TechTarget, los despliegues en dispositivos médicos analizan datos de sensores portátiles localmente para la identificación proactiva de riesgos para la salud, garantizando la privacidad y permitiendo un monitoreo continuo. Los SLM asisten a los médicos proporcionando recomendaciones terapéuticas o resumiendo historiales clínicos, siempre operando en infraestructuras segregadas que nunca envían datos sensibles más allá de perímetros controlados.

En la fabricación, los sensores con SLM integrados detectan defectos con un análisis que se realiza directamente en el sitio de producción en lugar de en centros de datos remotos, garantizando tiempos de respuesta de milisegundos en lugar de segundos, operación continua durante una conectividad a Internet limitada y una menor dependencia del ancho de banda y la nube. Este patrón es particularmente relevante para las industrias donde la latencia de la red sería inaceptable para el control de calidad en tiempo real.

Gartner predijo en abril de 2025 que para 2027 las organizaciones implementarán modelos de IA pequeños y específicos para tareas con un volumen de uso al menos tres veces superior al de los modelos de lenguaje grandes de propósito general. La predicción se basa en una encuesta a ochocientos directores de tecnología europeos y norteamericanos, muchos de los cuales citan el cumplimiento y los costos operativos como los principales impulsores.

Pero los despliegues no están exentos de desafíos concretos. La integración de los SLM en sistemas heredados requiere una refactorización sustancial de la arquitectura existente. Garantizar la calidad de los datos para el ajuste fino sigue siendo tan complejo como para los LLM, y a menudo más crítico, dado que los conjuntos de datos más pequeños amplifican el impacto de los datos sucios o sesgados. La gobernanza de decenas de modelos especializados introduce una nueva sobrecarga operativa: se necesita una orquestación sofisticada para decidir qué modelo invocar para qué consulta, un monitoreo separado para cada uno y la gestión de versiones en despliegues distribuidos.

Alemania lidera la adopción europea con una tasa de crecimiento anual compuesta del 32,5% prevista entre 2025 y 2035 para los despliegues de LLM y SLM, impulsada por los sectores manufacturero y aeroespacial, donde la computación en el borde es un requisito técnico no negociable y donde la cultura de ingeniería alemana privilegia el determinismo y la validación, características nativas de los SLM locales. El mercado global de los SLM, valorado en novecientos tres millones de dólares en 2025, se proyecta que alcance los 5.45 mil millones para 2032, con un CAGR del veintiocho coma siete por ciento, lo que refleja un cambio en las inversiones hacia modelos de IA que se alinean con las restricciones operativas y los requisitos de seguridad.

El marco normativo: entre la Ley de IA y el despliegue en el dispositivo

Los SLM en el dispositivo se deslizan en una zona gris interesante del panorama regulatorio europeo. La Ley de IA distingue entre sistemas de alto riesgo que requieren auditorías estrictas y aplicaciones de bajo riesgo con obligaciones reducidas. Un modelo que procesa datos sensibles íntegramente en un dispositivo local, sin transferencia a servidores externos, elude parte de la complejidad normativa simplemente porque los datos no "viajan". Para los sectores regulados como la salud y las finanzas, donde el RGPD y la HIPAA imponen restricciones estrictas a la transferencia de datos, esta arquitectura se convierte en una ventaja competitiva además de un requisito de cumplimiento.

Las auditorías de cumplimiento en los SLM resultan paradójicamente más sencillas que las de los LLM basados en la nube. Con un modelo compacto con distribución bloqueada en hardware controlado, inspeccionar el comportamiento y los modos de fallo es factible. Con un LLM de cientos de miles de millones servido por una infraestructura distribuida que cambia continuamente, garantizar la reproducibilidad se convierte en una pesadilla de ingeniería. Alemania está emergiendo como un centro europeo para SLM conformes precisamente por este motivo: la cultura de ingeniería alemana privilegia el determinismo y la auditoría, habilidades que son características nativas de los SLM locales.

Pero en los Estados Unidos, el panorama es más fragmentado. La orden ejecutiva de Trump de noviembre de 2025 intentó evitar el mosaico de regulaciones estatales que estaba surgiendo, con California, Nueva York y Texas legislando de forma independiente. La tensión está entre la innovación federal y el control estatal, con la IA convirtiéndose en un campo de batalla constitucional sobre la división de poderes. Una petición del Future of Life Institute en octubre de 2025, firmada por miles de investigadores y personalidades políticas transversales, incluidos Steve Bannon y Susan Rice, pedía frenar la carrera hacia la superinteligencia artificial sin una gobernanza adecuada. Los SLM surgen en este contexto como un posible compromiso: lo suficientemente potentes como para ser útiles, lo suficientemente limitados como para ser controlables.

El 2026 que vendrá: ¿bombo publicitario o punto de inflexión?

Las predicciones verificables para 2026 convergen en algunos patrones. Andy Markus de AT&T no está solo en su optimismo sobre los SLM: Sebastian Raschka, Yann LeCun y otros líderes de investigación han desplazado públicamente el enfoque de "cuán grandes podemos llegar a ser" a "cuán eficientes podemos ser". El cambio retórico refleja presiones económicas reales: los costos de la energía están creciendo más rápido que las curvas de la ley de Moore, y los inversores comienzan a exigir un retorno de los miles de millones gastados en clústeres de GPU.

La evolución esperada es de "hablar" a "hacer": modelos que no solo generan texto, sino que ejecutan acciones, orquestan flujos de trabajo e interactúan con herramientas externas. Se espera que Meta lance Llama 4 Scout en el primer trimestre de 2026, con conciencia de pantalla nativa que permite al modelo "ver" lo que está sucediendo en un dispositivo e intervenir de forma proactiva. Esto requiere una latencia muy baja y una eficiencia energética a nivel de teléfono inteligente, territorio natural para los SLM. Los SLM personalizados con ajuste fino continuo representan otra frontera: modelos que se adaptan continuamente al contexto específico del usuario o de la organización sin requerir un costoso reentrenamiento por lotes.

La escalabilidad en tiempo de inferencia se convierte en una prioridad arquitectónica. En lugar de entrenar modelos cada vez más grandes, la industria está invirtiendo en técnicas que permiten a los modelos existentes "pensar más tiempo" en problemas difíciles asignando dinámicamente la computación. Es el patrón que hemos visto surgir con la asignación adaptativa del MIT y con el razonamiento markoviano de Harvard, donde la inteligencia algorítmica en tiempo de prueba compite con la fuerza bruta del entrenamiento. Los SLM se benefician particularmente de estos enfoques porque parten de una línea de base más eficiente.

El Protocolo de Contexto de Modelo de Anthropic se está convirtiendo en el estándar de facto para la IA agéntica, permitiendo que diferentes modelos se comuniquen y coordinen. En este ecosistema, las baterías de SLM especializados orquestados por un controlador central podrían superar a los LLM generalistas individuales. Los modelos del mundo, sistemas que aprenden representaciones causales del entorno en lugar de patrones estadísticos puros, surgen como un complemento, no un sustituto: un modelo del mundo predice las consecuencias de las acciones, un SLM lingüístico las verbaliza e interactúa con el usuario.

DeepSeek-R1 y otros modelos de razonamiento lanzados a finales de 2025 siguen siendo técnicamente LLM, pero señalan un cambio hacia la optimización: utilizan una mezcla de expertos para activar solo un subconjunto de parámetros por consulta, reduciendo la computación efectiva mientras mantienen una alta capacidad total. Es un híbrido entre la filosofía de los LLM y los SLM. El hecho de que Qwen supere a Llama en las descargas de la comunidad de código abierto indica una preferencia por la eficiencia. La adopción por parte de Mistral de la arquitectura DeepSeek V3 muestra una polinización cruzada entre enfoques: las mejores ideas se propagan rápidamente independientemente de quién las origine.

Las preguntas que quedan abiertas

¿Será 2026 realmente el año de los SLM o asistiremos a una convivencia híbrida? La historia de la IA sugiere cautela con las proclamaciones definitivas. Cada ola tecnológica atraviesa ciclos predecibles: entusiasmo inicial, desilusión cuando la realidad no coincide con las expectativas y consolidación pragmática donde la tecnología encuentra sus casos de uso reales. Los SLM resuelven problemas genuinos de costo, latencia, privacidad y sostenibilidad, pero no reemplazan a los LLM en todos los frentes. La pregunta relevante no es "SLM o LLM", sino "qué herramienta para qué tarea".

El principal riesgo es sobrestimar las capacidades y subestimar las dificultades de integración. Desplegar un SLM en un dispositivo de borde parece simple hasta que te enfrentas a la gestión del control de versiones en miles de dispositivos heterogéneos, la depuración de modos de fallo en hardware con telemetría limitada y la gobernanza de modelos que evolucionan de forma independiente. La industria todavía tiene poca experiencia operativa en esta complejidad. Por otro lado, la oportunidad es la democratización real: las pequeñas empresas y los investigadores sin presupuestos de centros de datos ahora pueden competir con la innovación algorítmica en lugar de la escala bruta.

Sebastian Raschka lo resume: el progreso de 2026 vendrá más de la inferencia que del entrenamiento. Es una declaración radical para una industria que ha pasado los últimos cinco años obsesionada con las leyes de escala durante el entrenamiento. Pero las señales económicas respaldan este cambio: los márgenes se están reduciendo para quienes sirven LLM gigantes, mientras que quienes optimizan la inferencia eficiente ven caer los costos operativos. La sostenibilidad ya no es algo agradable de tener, sino un imperativo empresarial.

La pregunta final para quien lee es pragmática e incómoda: en tu organización, ¿cuántas de las consultas que envías a GPT-4 requieren realmente un modelo de quinientos mil millones de parámetros? ¿Cuántas podrían ser gestionadas por un Phi-3 afinado a una décima parte del costo y una centésima parte de la latencia? Si la respuesta es "la mayoría", entonces quizás Andy Markus y Sebastian Raschka tengan razón. 2026 podría ser realmente el año en que la industria deje de perseguir la escala por la escala y comience a preguntarse: ¿cuánto es suficiente?