Menos es Más: La Revolución continúa con el Modelo TRM

En el mundo de la inteligencia artificial, donde la regla de oro parecía ser "cuanto más grande, mejor", está surgiendo una contranarrativa que recuerda al final de *Attack on Titan: a veces, son los titanes más pequeños los que esconden el verdadero poder. Samsung AI, a través de su laboratorio SAIL en Montreal, acaba de publicar un artículo científico que podría marcar un punto de inflexión en cómo pensamos sobre la inteligencia de las máquinas.*

Se llama Tiny Recursive Model, abreviado como TRM, y con sus míseros 7 millones de parámetros está haciendo lo que parecía imposible: vencer sistemáticamente a colosos de cientos de miles de millones de parámetros en tareas de razonamiento complejo.

Para poner estas cifras en perspectiva, estamos hablando de un modelo diez mil veces más pequeño que GPT-4o o Gemini 2.5 Pro que logra un rendimiento superior en benchmarks considerados entre los más difíciles para la inteligencia artificial. En la célebre prueba ARC-AGI, la que François Chollet diseñó para medir la verdadera generalización inteligente en lugar de la mera memorización, TRM alcanza un 45% de precisión en la primera versión y un 8% en la segunda, cifras que superan a modelos como DeepSeek-R1, o3-mini de OpenAI e incluso a Gemini 2.5 Pro. Y lo hace consumiendo una fracción infinitesimal de los recursos computacionales.

Pero la historia de TRM no empieza aquí. Para entender realmente qué hace revolucionario a este enfoque, debemos dar un paso atrás y observar una tendencia que hemos seguido de cerca en AITalk.it en los últimos meses: el surgimiento de una filosofía completamente diferente en el diseño de la inteligencia artificial, una que privilegia la astucia sobre la fuerza bruta.

El ADN Rebelde: De HRM a TRM

Como contamos hace unos meses, la pequeña startup de Singapur Sapient Intelligence ya había sacudido el sector con su Hierarchical Reasoning Model. HRM había logrado la hazaña de vencer a modelos enormes usando apenas 27 millones de parámetros, gracias a una arquitectura inspirada directamente en el funcionamiento jerárquico del cerebro humano. La idea base era revolucionaria: en lugar de procesar todo en un único paso lineal como hacen los transformadores tradicionales, HRM utilizaba dos redes neuronales que razonaban a frecuencias diferentes, una rápida y una lenta, iterando recursivamente sobre el problema hasta converger en la solución correcta.

TRM, desarrollado por Alexia Jolicoeur-Martineau y el equipo de Samsung SAIL Montreal, reconoce explícitamente en el artículo que es una evolución directa de HRM. Pero es una evolución que hace lo que toda buena secuela debería hacer: toma los conceptos ganadores y los lleva al extremo, eliminando todo lo superfluo. Como explica el artículo original, el análisis independiente realizado por la ARC Prize Foundation había revelado que en HRM el verdadero motor del rendimiento era la "supervisión profunda", es decir, la capacidad de iterar y mejorar progresivamente la respuesta a través de múltiples pasos de supervisión, mientras que el razonamiento jerárquico en dos redes separadas contribuía de forma marginal.

Partiendo de esta intuición, TRM simplifica radicalmente la arquitectura. Fuera las complejas justificaciones biológicas, fuera los teoremas de puntos fijos, fuera la jerarquía de dos niveles. Queda la esencia pura del razonamiento recursivo: una única red minúscula de apenas dos capas que itera sobre sí misma, refinando progresivamente tanto su "razonamiento latente" como la respuesta final. Es como si, en lugar de tener un equipo de expertos trabajando en diferentes niveles de abstracción, tuvieras a un único genio que se concentra intensamente en el problema, revisa continuamente su propio pensamiento y refina la solución hasta que es perfecta.

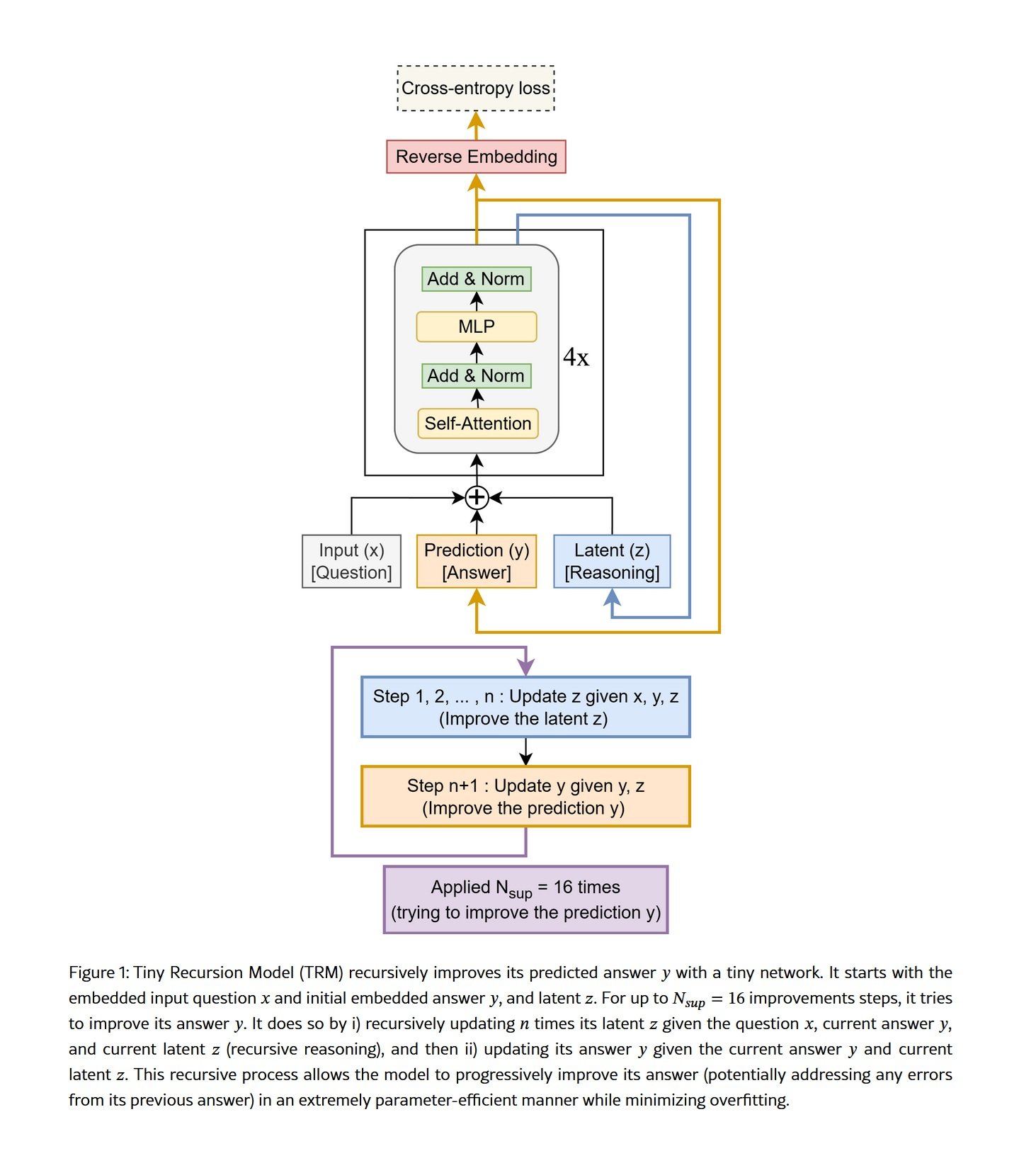

El mecanismo es elegante en su simplicidad. TRM comienza con una pregunta codificada, genera un primer borrador de respuesta y luego entra en lo que los investigadores llaman un "proceso recursivo completo". Durante un número predefinido de iteraciones, la red actualiza repetidamente su estado latente interno, que podemos imaginar como una especie de "bloc de notas" mental donde el modelo formula hipótesis, verifica consistencias internas y construye una comprensión cada vez más profunda del problema. Después de estas iteraciones sobre el razonamiento latente, la red actualiza la respuesta final basándose en esta comprensión refinada. Y luego vuelve a empezar, mejorando aún más tanto el razonamiento como la respuesta.

Lo que hace que este enfoque sea particularmente potente es que TRM no necesita externalizar su pensamiento a través del lenguaje, como hacen los modelos basados en la "cadena de pensamiento". No tiene que escribir "paso uno, paso dos, paso tres" en texto explícito, con todos los riesgos de errores en cascada que esto conlleva. Su razonamiento tiene lugar en un espacio latente interno, paralelo y comprimido, donde puede mantener simultáneamente múltiples hipótesis y relaciones sin tener que linealizar todo en una secuencia de tokens. Es la diferencia entre pensar en cómo resolver un problema y tener que explicar en voz alta cada uno de los pasos de tu razonamiento mientras lo haces.

Los Números que Sacuden las Certezas

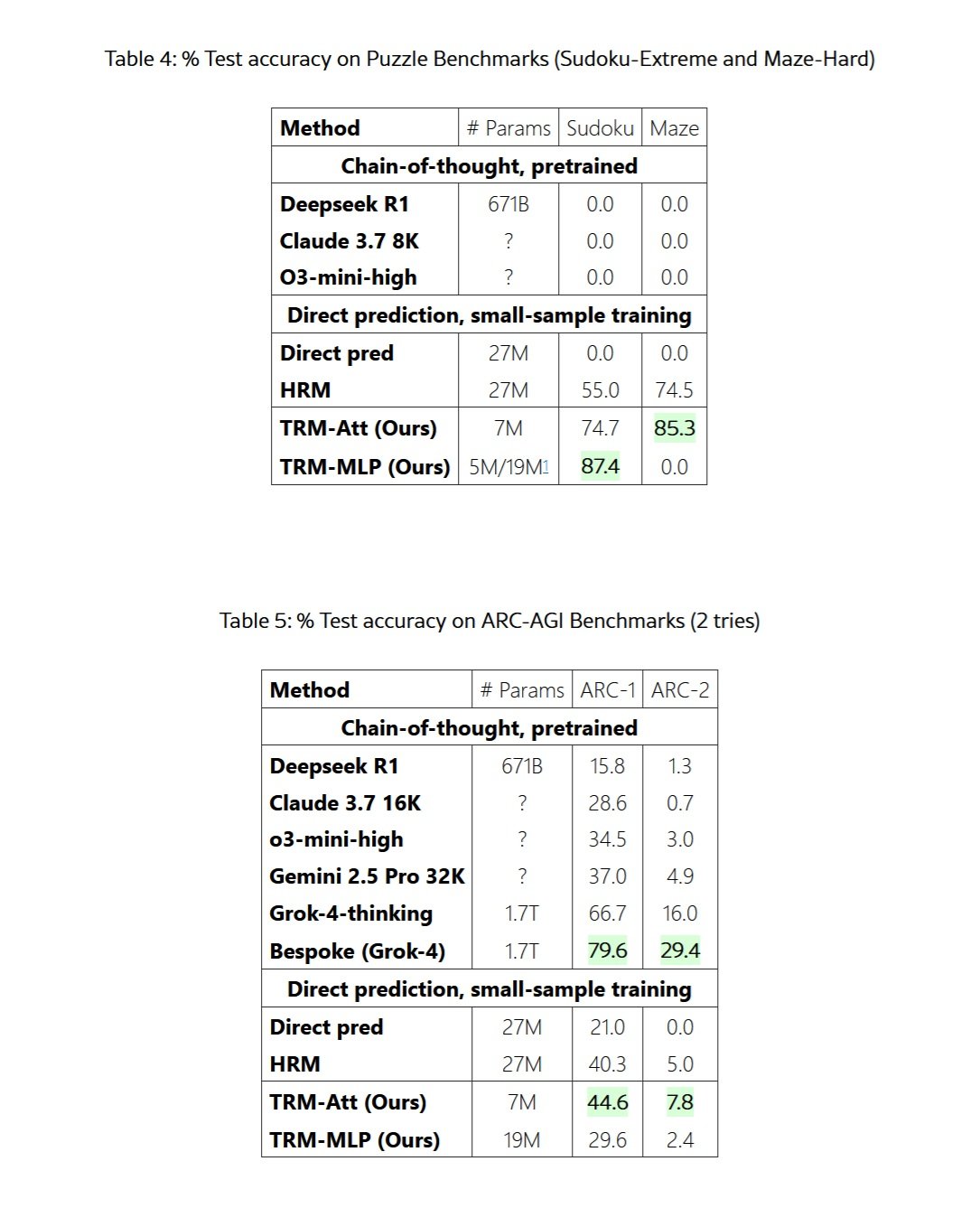

Los resultados reportados en el artículo de Samsung no dejan lugar a interpretaciones ambiguas. En Sudokus de dificultad extrema, aquellos que ponen en aprietos incluso a los expertos humanos, TRM alcanza un 87,4% de precisión frente al 55% de su predecesor HRM y el 0% de los LLM tradicionales con cadena de pensamiento. Cero por ciento. Ni siquiera DeepSeek-R1 con sus 671 mil millones de parámetros logró resolver un solo Sudoku difícil.

En el conjunto de datos Maze-Hard, que consiste en laberintos de 30x30 particularmente retorcidos donde el camino más corto supera las 110 celdas, TRM encuentra la solución óptima en el 85,3% de los casos, mejorando el 74,5% de HRM. De nuevo, los LLM gigantes obtienen un cero rotundo. No es que fallen por poco, simplemente ni siquiera logran acercarse a una solución correcta.

Pero es en los benchmarks ARC-AGI donde la comparación se vuelve realmente despiadada. ARC-AGI, el benchmark creado por François Chollet para medir la verdadera inteligencia general en lugar de la capacidad de memorizar patrones de los datos de entrenamiento, está diseñado para ser fácil para un humano pero diabólicamente difícil para la IA actual. Cada rompecabezas es único y requiere abstracción visual, razonamiento causal y generalización a situaciones nunca antes vistas. En ARC-AGI-1, TRM alcanza un 44,6% de precisión, superando el 40,3% de HRM pero también el 37% de Gemini 2.5 Pro con un cómputo masivo en tiempo de prueba, el 34,5% de o3-mini-high y el 28,6% de Claude 3.7 Sonnet con un contexto de 16K tokens.

En ARC-AGI-2, la versión aún más difícil del benchmark lanzada este año, TRM obtiene un 7,8% frente al 5% de HRM, el 4,9% de Gemini 2.5 Pro y el 3% de o3-mini-high. Números que parecen bajos en términos absolutos, pero que representan saltos de rendimiento enormes en una prueba donde incluso los modelos más avanzados tienen dificultades para superar el porcentaje de un solo dígito.

Para ser justos y completos, debemos mencionar que los modelos verdaderamente de vanguardia como Grok-4-thinking obtienen un 66,7% en ARC-AGI-1 y un 16% en ARC-AGI-2, mientras que la versión Bespoke basada en Grok-4 alcanza incluso el 79,6% y el 29,4%. Pero estamos hablando de un modelo con 1,7 billones de parámetros, más de doscientas cuarenta mil veces más grande que TRM. Es como comparar un Smart Fortwo con un camión articulado y descubrir que el Smart logra llegar primero en ciertos caminos particularmente tortuosos.

El verdadero golpe de genio, sin embargo, se refiere a la eficiencia del entrenamiento. Donde los grandes LLM requieren conjuntos de datos mastodónticos extraídos de todo internet y meses de procesamiento en clústeres de miles de GPU, TRM se entrena con apenas mil ejemplos por problema. En Sudoku-Extreme, el entrenamiento completo requiere menos de 36 horas en una sola GPU L40S de 40GB. Para ARC-AGI, se necesitan unos tres días en cuatro H100. Estamos hablando de recursos accesibles para un laboratorio universitario o una startup bien financiada, no de infraestructuras de decenas de millones de dólares.

La Inteligencia Distribuida: Un Movimiento Subterráneo

TRM no es un caso aislado, sino que forma parte de un movimiento más amplio que está surgiendo en los márgenes de la industria de la IA. Como hemos documentado en los últimos meses, existe una tendencia creciente entre las startups con presupuestos limitados y los investigadores independientes a buscar soluciones que privilegian la astucia arquitectónica sobre la pura potencia computacional.

Tomemos el caso de DeepConf, una técnica descubierta por Jiawei Zhao durante su pasantía en Meta en 2024. Zhao demostró que si en lugar de pedirle a un LLM una sola respuesta, le haces generar múltiples respuestas alternativas, luego las haces discutir entre ellas de manera estructurada y finalmente agregas las conclusiones, obtienes enormes mejoras de rendimiento en tareas de razonamiento complejo. El principio subyacente es similar al de TRM: iterar, reflexionar, refinar. No solo importa cuán grande es tu modelo, sino cómo lo usas.

Aún más fascinante es el caso de MemVid, un proyecto experimental que aborda un problema completamente diferente pero con la misma filosofía de fondo. En lugar de construir bases de datos vectoriales cada vez más mastodónticas y costosas para gestionar la memoria a largo plazo de las IA, MemVid codifica la información en códigos QR y la comprime en archivos de video MP4. Parece una locura, pero funciona extraordinariamente bien, aprovechando treinta años de optimizaciones de códecs de video para obtener relaciones de compresión 50-100 veces mejores que las bases de datos tradicionales, manteniendo búsquedas semánticas por debajo del segundo. De nuevo, no se trata de lanzar más potencia computacional al problema, sino de encontrar una solución más elegante e inteligente.

Lo que une a todos estos enfoques es una visión fundamentalmente diferente de lo que significa construir inteligencia artificial. La industria principal, dominada por gigantes como OpenAI, Google y Anthropic, ha seguido durante años el paradigma del "escalado": más parámetros, más datos, más cómputo. La famosa "ley de escalado" sugería que el rendimiento mejoraría de manera predecible simplemente aumentando la escala. Y funcionó, por un tiempo. Pero ahora estamos viendo rendimientos decrecientes cada vez más evidentes, junto con costos ambientales y económicos que se están volviendo insostenibles.

El movimiento hacia la eficiencia, en cambio, parte de una premisa diferente: la inteligencia no es solo una cuestión de la cantidad de información procesada, sino de la calidad del procesamiento. Es la diferencia entre leer mil libros a toda prisa y leer diez con atención profunda, reflexionando críticamente sobre cada pasaje, haciendo conexiones, revisando las propias conclusiones. TRM, DeepConf, MemVid y decenas de otros proyectos emergentes están explorando variaciones sobre este tema: iteración, reflexión, optimización arquitectónica.

La Arquitectura del Pensamiento Miniaturizado

Para entender realmente por qué TRM funciona tan bien a pesar de ser tan pequeño, debemos adentrarnos en los detalles técnicos de la arquitectura. Como explica detalladamente el artículo original, TRM se compone de cuatro elementos esenciales: un módulo de incrustación que transforma la entrada en representaciones vectoriales, una única red recursiva de apenas dos capas de transformadores, un "bloc de notas" latente donde tiene lugar el razonamiento interno, y un módulo de salida que transforma las representaciones refinadas en la respuesta final.

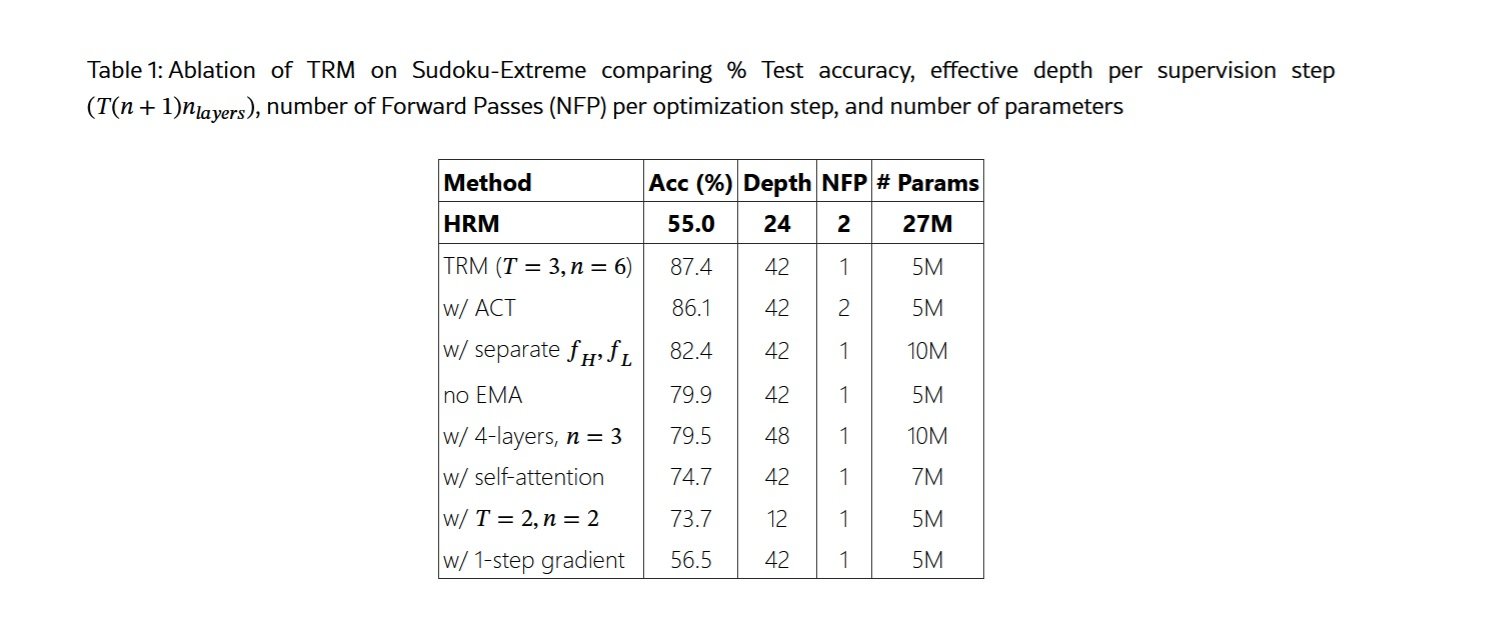

La clave es el proceso recursivo completo. A diferencia de HRM, que se basaba en el teorema de la función implícita con una aproximación de un solo paso para justificar la retropropagación solo a través de los dos últimos pasos, TRM retropropaga a través de todo el proceso recursivo. Esto elimina las problemáticas suposiciones teóricas de HRM, que no podía garantizar haber alcanzado realmente un punto fijo, y proporciona gradientes más precisos para el aprendizaje.

El proceso funciona así: partiendo de la pregunta incrustada y una respuesta inicial, TRM realiza n iteraciones sobre su variable latente z, que representa su "razonamiento interno". En cada iteración, la red toma como entrada la pregunta x, la respuesta actual y y el razonamiento actual z, y produce un razonamiento actualizado. Esto se repite n veces seguidas, digamos 6 veces, permitiendo que el modelo construya una comprensión cada vez más refinada. Luego, utilizando este razonamiento refinado z y la respuesta actual y, la red produce una nueva respuesta y mejorada. Esto constituye un "proceso recursivo completo".

Pero no termina ahí. A través de la "supervisión profunda", TRM puede ejecutar hasta 16 de estos procesos recursivos completos en secuencia, cada vez partiendo de la respuesta mejorada del paso anterior y continuando con el refinamiento. Es como si un estudiante resolviera un problema, revisara su trabajo, hiciera correcciones, volviera a revisar, hiciera más correcciones, y así sucesivamente hasta estar completamente seguro de la solución. Con n=6 iteraciones de razonamiento latente y 16 pasos de supervisión, TRM realiza efectivamente unas 42 recursiones de profundidad emulada, obteniendo una capacidad de razonamiento que normalmente requeriría una red mucho más profunda y compleja.

Una de las ideas más contraintuitivas reportadas en el artículo se refiere precisamente al tamaño de la red. Los investigadores descubrieron que aumentar el número de capas empeora el rendimiento debido al sobreajuste en los pequeños conjuntos de datos típicos de las tareas de razonamiento. Al reducir de cuatro a dos capas y compensar con más recursiones, lograron una mejora del 79,5% al 87,4% en Sudoku-Extreme, al tiempo que reducían a la mitad el número de parámetros. Menos es realmente más cuando se tienen muy pocos datos y se busca una generalización verdadera en lugar de la memorización.

Igualmente interesante es la elección de eliminar el mecanismo de atención para tareas con longitudes de contexto pequeñas y fijas. Inspirándose en el MLP-Mixer, TRM reemplaza la autoatención con simples perceptrones multicapa aplicados sobre la dimensión de la secuencia. Para cuadrículas de 9x9 como en el Sudoku, esto conduce a una mejora del 74,7% al 87,4%. Sin embargo, para tareas con contextos más amplios como los laberintos de 30x30 o ARC-AGI, la autoatención sigue siendo superior, lo que demuestra que no existe una solución universal, sino que la arquitectura debe adaptarse al problema específico.

El Talón de Aquiles y los Desafíos Reales

Sería deshonesto presentar a TRM como una panacea universal sin discutir sus limitaciones significativas. La primera y más evidente se refiere a su dominio de aplicación: TRM está diseñado específicamente para problemas de razonamiento estructurado con entradas y salidas de forma fija. No puede chatear de forma natural, no puede generar texto creativo, no puede responder a preguntas abiertas como lo hace ChatGPT. Es un especialista quirúrgico, no un generalista polivalente.

La segunda limitación se refiere a la escalabilidad computacional durante el entrenamiento. Retropropagar a través de 42 recursiones requiere mucha memoria, y el artículo documenta honestamente cómo aumentar demasiado el número de recursiones conduce rápidamente a errores de "Falta de Memoria" incluso en GPU de 80GB. Esto impone un límite práctico a la profundidad de razonamiento que TRM puede alcanzar, al menos con las técnicas de entrenamiento actuales.

Una tercera preocupación es la generalización más allá de los dominios de entrenamiento. Sí, TRM generaliza magníficamente dentro de su dominio, resolviendo Sudokus o laberintos nunca antes vistos con gran precisión. Pero, ¿qué sucede si se le presenta un tipo de rompecabezas completamente diferente, o si se intenta aplicarlo a una tarea que no entra en la categoría de "razonamiento estructurado"? El artículo no proporciona respuestas definitivas a estas preguntas, y es plausible pensar que probablemente se necesitarían reentrenamientos significativos.

Además, TRM es intrínsecamente determinista: dada una pregunta, produce una única respuesta. En muchos contextos del mundo real, las preguntas tienen múltiples respuestas válidas o requieren exploraciones creativas del espacio de soluciones. Como señalan los propios autores en las conclusiones del artículo, extender TRM a tareas generativas requeriría modificaciones arquitectónicas sustanciales.

También hay una cuestión más sutil pero importante: TRM todavía requiere un entrenamiento supervisado con ejemplos etiquetados para cada nueva tarea. No puede hacer "aprendizaje de pocos ejemplos" de la manera en que lo hacen los grandes LLM, donde puedes describir un nuevo problema con algunos ejemplos y el modelo entiende inmediatamente qué hacer. Esto significa que para cada nuevo dominio de aplicación es necesario recopilar datos, diseñar aumentos apropiados y realizar un entrenamiento dedicado.

A nivel práctico, también está la cuestión de la infraestructura y el ecosistema. Los grandes LLM se benefician de años de desarrollo de herramientas, bibliotecas, mejores prácticas y una enorme comunidad de desarrolladores. TRM es un proyecto de código abierto joven, con todos los desafíos que esto conlleva en términos de documentación, soporte, depuración e integración con otros sistemas.

El Contexto Económico: ¿Por Qué Ahora?

Para entender por qué enfoques como TRM están surgiendo justo ahora, debemos observar la realidad económica de la IA en 2025. Los costos para entrenar y desplegar los grandes modelos de lenguaje se han vuelto prohibitivos para cualquiera que no sea un gigante tecnológico. Como discutimos en el artículo sobre MemVid, construir incluso un pequeño centro de datos de IA cuesta entre 10 y 50 millones de dólares, sin contar los costos operativos recurrentes. Las bases de datos vectoriales necesarias para gestionar la memoria a largo plazo de estos sistemas se han convertido en industrias multimillonarias, con un mercado que alcanzó los 2.200 millones de dólares en 2024.

Esta concentración de capital está creando de facto una oligarquía de la IA, donde solo cinco o seis empresas en el mundo pueden permitirse competir al más alto nivel. OpenAI ha recaudado miles de millones, Anthropic igualmente, y Google y Meta pueden recurrir a las ganancias de sus negocios principales. Pero para las miles de startups, laboratorios universitarios e investigadores independientes, la carrera por el escalado está simplemente fuera de su alcance.

TRM y enfoques similares representan una democratización de la IA avanzada. Con unas pocas decenas de miles de dólares en recursos en la nube, un pequeño equipo puede ahora entrenar modelos que superan a los gigantes en tareas específicas. Esto está reduciendo drásticamente las barreras de entrada y permitiendo la exploración de un panorama mucho más diverso de arquitecturas y enfoques.

También hay una dimensión ambiental que no puede ser ignorada. Los centros de datos que entrenan los modelos más grandes consumen la electricidad de pequeñas ciudades, con huellas de carbono medibles en miles de toneladas. Un modelo como TRM, entrenable en una sola GPU en menos de dos días, tiene un impacto ambiental literalmente diez mil veces menor. En una era de creciente conciencia sobre la crisis climática, esta no es una consideración marginal.

Las Aplicaciones que Cambian las Reglas

¿Dónde podría tener sentido desplegar TRM en el mundo real? La respuesta está en los dominios donde el razonamiento estructurado profundo es crítico, los datos son escasos y los recursos computacionales son limitados.

El primer campo que viene a la mente es la robótica, especialmente para dispositivos de borde que necesitan tomar decisiones complejas en tiempo real sin poder depender de conexiones constantes a la nube. Un robot industrial que necesita planificar secuencias de movimiento óptimas, o un dron autónomo que debe navegar a través de entornos complejos, podrían beneficiarse enormemente de un modelo como TRM que puede "pensar profundamente" usando recursos computacionales mínimos.

En el campo de la medicina, tareas como el diagnóstico de enfermedades raras o la planificación de estrategias terapéuticas complejas requieren exactamente el tipo de razonamiento abstracto y generalización en el que TRM sobresale. Como mencionamos en el artículo sobre HRM, modelos similares ya han demostrado una precisión del 97% en las predicciones climáticas estacionales, lo que sugiere que el mismo enfoque podría funcionar para predicciones médicas basadas en patrones complejos.

La educación podría ver aplicaciones fascinantes. Imaginen sistemas de tutoría personalizados que realmente puedan "entender" dónde se atasca un estudiante en matemáticas o física, no simplemente proporcionando la respuesta correcta, sino guiando el razonamiento a través de pasos lógicos. TRM, con su capacidad para iterar sobre problemas complejos y su relativa transparencia en comparación con las cajas negras de los LLM gigantes, podría ser ideal para este tipo de aplicaciones.

En el campo de la ciberseguridad, tareas como el análisis de código malicioso, la detección de patrones de ataque sofisticados o la verificación formal de protocolos criptográficos requieren un razonamiento profundo sobre estructuras complejas. Estos son exactamente los contextos donde un modelo pequeño pero inteligente supera a un gigante que ha visto todo internet pero no sabe realmente razonar.

Finalmente, está todo el mundo de la IA integrada: dispositivos IoT, sensores industriales, vehículos autónomos, donde la idea de enviar constantemente datos a la nube para su procesamiento es inviable por latencia, costos o restricciones de privacidad. Como hemos visto con MemVid y ahora con TRM, la IA eficiente abre escenarios completamente nuevos para la inteligencia distribuida en el borde de la red.

El Debate: Especialistas vs. Generalistas

El surgimiento de enfoques como TRM está reavivando un debate fundamental en la IA: ¿es mejor tener modelos gigantescos y generalistas que hacen todo decentemente, o un ecosistema de modelos especializados que sobresalen en sus dominios específicos?

El paradigma actual favorece a los generalistas. OpenAI, Anthropic y Google apuestan por modelos cada vez más grandes y capaces que pueden hacer "de todo": escribir código, analizar imágenes, mantener conversaciones naturales, resolver problemas matemáticos, etc. La idea es que con suficientes parámetros y suficientes datos, surja una especie de inteligencia general que pueda adaptarse a cualquier tarea.

Pero esta estrategia tiene costos enormes. Cada vez que salen GPT-5 o Claude 4.5, requieren órdenes de magnitud más recursos para su entrenamiento. La gran mayoría de estos recursos se destinan a mejorar marginalmente el rendimiento en tareas que quizás ni siquiera nos interesan. Si usas GPT-4 principalmente para analizar datos científicos, sigues pagando por todo el entrenamiento que se destinó a enseñarle a escribir poesía, jugar a juegos de rol de texto y mil cosas más.

El enfoque de los especialistas, que TRM representa, propone en cambio una arquitectura modular: modelos pequeños y optimizados para tareas específicas, que pueden combinarse en sistemas más complejos cuando sea necesario. ¿Quieres un asistente de IA completo? Usa un pequeño LLM para la comprensión del lenguaje y la conversación, un TRM para el razonamiento complejo, un modelo especializado para la visión, otro para la generación de código. Cada componente hace su parte excepcionalmente bien, y juntos cubren un amplio espectro de capacidades.

Este enfoque modular tiene ventajas significativas más allá de la pura eficiencia. Permite actualizaciones independientes de los componentes, una depuración más sencilla porque sabes exactamente qué módulo está fallando, y una transparencia superior porque el flujo de información entre módulos especializados es más rastreable que el pensamiento inescrutable de un gigante monolítico.

Sin embargo, también hay una desventaja: los modelos generalistas muestran capacidades emergentes que surgen de la interacción de todas sus partes. Fenómenos como el "aprendizaje por transferencia", donde el conocimiento adquirido en un dominio ayuda en dominios completamente diferentes, o la capacidad de "cadena de pensamiento", donde el modelo aprende espontáneamente a razonar paso a paso, parecen requerir una cierta escala. Si se fragmenta demasiado, se podría perder esta magia emergente.

Mi sensación es que veremos una convergencia entre los dos enfoques. Los grandes generalistas seguirán existiendo para aplicaciones donde realmente se necesiten, pero la mayoría de las implementaciones del mundo real probablemente usarán sistemas híbridos: pequeños modelos especializados para tareas críticas donde la eficiencia importa, coordinados por modelos más grandes cuando sea necesario para tareas que requieran una flexibilidad extrema.

Más Allá de los Benchmarks: Lo que Aún Falta

Por impresionantes que sean los resultados de TRM en los benchmarks, es importante mantener una perspectiva crítica sobre lo que estos números realmente nos dicen y lo que dejan fuera. Los benchmarks como ARC-AGI, por muy bien diseñados que estén, siguen siendo entornos controlados y artificiales. El razonamiento en el mundo real es a menudo mucho más complejo, ambiguo y dependiente del contexto.

Una limitación fundamental es la falta de robustez ante entradas adversarias. Los benchmarks publicados tienen formatos bien definidos, pero en el mundo real las entradas suelen ser ruidosas, incompletas o deliberadamente engañosas. Un sistema de IA desplegado en producción debe manejar usuarios que hacen preguntas mal formuladas, datos con errores y casos límite que nadie había previsto. Todavía no tenemos datos sobre cómo se comporta TRM en estos escenarios.

Luego está la cuestión del aprendizaje continuo. TRM se entrena en un conjunto de datos estático y luego se congela. Pero el mundo real cambia constantemente: surgen nuevos tipos de problemas, las reglas de los dominios evolucionan, los estándares cambian. Los grandes LLM pueden ser ajustados o actualizados mediante técnicas como RLHF, pero no está claro con qué facilidad puede adaptarse TRM sin reentrenamientos completos.

La explicabilidad de las decisiones es otra área gris. Sí, TRM es más transparente que los gigantes en el sentido de que podemos observar cómo evoluciona su estado latente a través de las recursiones. Pero ese estado latente sigue siendo un vector multidimensional en un espacio que no corresponde directamente a conceptos humanos interpretables. Cuando TRM se equivoca, ¿con qué facilidad podemos entender por qué y corregir el problema?

En el frente de la seguridad, los modelos pequeños y eficientes como TRM plantean nuevas preguntas. Si se vuelve posible entrenar modelos altamente capaces con recursos modestos, esto también reduce drásticamente las barreras para los actores malintencionados. Un grupo con intenciones dañinas podría entrenar un TRM especializado en tareas como encontrar vulnerabilidades de software, generar exploits u optimizar estrategias de ataque. La democratización de la IA es deseable, pero conlleva responsabilidades que la comunidad aún debe abordar plenamente.

Finalmente, está la cuestión de la evaluación misma. Los benchmarks actuales, por muy difíciles que sean, miden principalmente las capacidades de razonamiento abstracto sobre problemas bien definidos. Pero gran parte de la inteligencia humana tiene que ver con la capacidad de navegar la ambigüedad, gestionar la incertidumbre, integrar conocimientos de diferentes dominios y razonar sobre sistemas abiertos sin límites claros. ¿Cuánta de esta inteligencia más matizada puede capturar TRM? El artículo no proporciona respuestas, y probablemente se necesitarán años de investigación para descubrirlo.

La Frontera de la Investigación: ¿Qué Viene Después?

Mirando al futuro inmediato, hay varias direcciones prometedoras que la investigación sobre arquitecturas recursivas como TRM podría explorar. La primera y más obvia se refiere a la extensión a tareas generativas. Como se menciona en el artículo de Samsung, TRM actualmente produce salidas deterministas, pero muchos problemas del mundo real requieren la exploración del espacio de soluciones, la generación de múltiples alternativas y la evaluación probabilística de las opciones. Integrar mecanismos de muestreo y evaluación de la incertidumbre en TRM podría abrir aplicaciones completamente nuevas.

Una segunda frontera se refiere al aprendizaje por transferencia entre dominios. Actualmente, TRM se entrena por separado para cada tarea, pero hay indicios en el artículo que sugieren posibilidades interesantes. El hecho de que la misma arquitectura funcione excepcionalmente bien en Sudoku, laberintos y rompecabezas ARC-AGI, que son superficialmente muy diferentes, sugiere que TRM está aprendiendo algo más fundamental sobre el razonamiento abstracto. Podríamos imaginar un pre-entrenamiento en un amplio espectro de tareas de razonamiento, seguido de un ajuste fino rápido en dominios específicos.

La tercera dirección implica la integración con sistemas simbólicos. TRM opera completamente en el dominio sub-simbólico de las redes neuronales, pero muchos problemas de razonamiento complejo en el mundo real se beneficiarían de la integración con motores de inferencia lógica, solucionadores de restricciones o planificadores simbólicos. Los sistemas híbridos que combinan la capacidad de TRM para aprender patrones de los datos con la precisión y verificabilidad del razonamiento simbólico podrían ser extremadamente potentes.

En el frente de la eficiencia, todavía hay margen de mejora. El artículo menciona que aumentar el número de recursiones conduce rápidamente a problemas de memoria, pero técnicas como el checkpointing de gradientes, la cuantización o arquitecturas más eficientes en memoria podrían permitir recursiones aún más profundas con el mismo hardware. Del mismo modo, las optimizaciones a nivel de compilación y el hardware especializado para operaciones recursivas podrían acelerar aún más el entrenamiento y la inferencia.

Una dirección particularmente fascinante se refiere al meta-aprendizaje: entrenar a TRM para que aprenda a aprender. En lugar de entrenar manualmente para cada nueva tarea, podríamos imaginar un sistema que, dadas unos cientos de ejemplos de un problema completamente nuevo, determine automáticamente la arquitectura óptima, el número de recursiones necesarias y las estrategias de aumento apropiadas. Esto probablemente requeriría un nivel de abstracción superior, quizás un "meta-TRM" que razone sobre cómo configurar TRM para tareas específicas.

La Lección de One Punch Man: Cuando el Entrenamiento Básico Vence al Talento Puro

Hay una metáfora de la cultura pop que me viene a la mente al pensar en TRM. En One Punch Man, el protagonista Saitama obtiene una fuerza literalmente invencible no a través de poderes especiales o tecnologías avanzadas, sino a través de un régimen de entrenamiento absurdamente simple y repetitivo: cien flexiones, cien abdominales, cien sentadillas y diez kilómetros de carrera, todos los días. Los otros héroes con sus poderes exóticos y complejos lo miran perplejos, pero Saitama los supera a todos precisamente a través de esa repetición metódica y obsesiva.

TRM es un poco así. Donde los gigantes de la IA acumulan miles de millones de parámetros y arquitecturas cada vez más elaboradas, TRM toma una red minúscula de dos capas y la hace recurrir sobre sí misma una y otra y otra vez, con una paciencia casi zen. Sin teoremas complicados, sin justificaciones biológicas elaboradas, solo recursión disciplinada y supervisión profunda. Y funciona mejor.

Esta lección tiene implicaciones que van más allá de la arquitectura específica de TRM. Sugiere que en el campo de la IA, como en muchos otros, podríamos haber llegado a un punto de rendimientos decrecientes por la mera acumulación de complejidad. La elegancia arquitectónica, la comprensión profunda de los mecanismos de aprendizaje y la optimización inteligente podrían aportar mayores ganancias que simplemente "hacer todo más grande".

Hacia una Ecología de la Inteligencia Artificial

Una de las perspectivas más interesantes abiertas por TRM y enfoques similares es la idea de una ecología de la inteligencia artificial, en lugar de una monocultura dominada por unos pocos gigantes. En la naturaleza, los ecosistemas más robustos y adaptativos no son los dominados por un único superdepredador, sino los caracterizados por la diversidad: innumerables especies, cada una optimizada para su propio nicho, que interactúan en complejas redes de simbiosis y competencia.

Podríamos imaginar un futuro similar para la IA. En lugar de una industria donde cinco empresas controlan cinco modelos gigantes que intentan hacer de todo, podríamos tener miles de modelos especializados, cada uno excelente en su propio dominio. TRM para el razonamiento abstracto, MemVid para la gestión eficiente de la memoria, modelos especializados para la visión, para el lenguaje natural, para la planificación, para el aprendizaje continuo. Estos modelos podrían ser desarrollados por una comunidad global de investigadores, abiertos, verificables y componibles.

Este paradigma tendría enormes ventajas. Primero, reduciría la concentración de poder que estamos viendo en la IA, donde unas pocas corporaciones controlan de facto el acceso a la inteligencia artificial avanzada. Segundo, permitiría una innovación mucho más rápida, porque los equipos pequeños podrían contribuir con mejoras a componentes específicos sin tener que competir en el entrenamiento de modelos gigantescos. Tercero, mejoraría la robustez general del sistema, porque el fallo de un componente no comprometería todo el stack.

Por supuesto, esto requeriría infraestructuras de coordinación, estándares de interoperabilidad y mecanismos de gobernanza que actualmente no existen. Pero los proyectos de código abierto como TRM en GitHub están sentando las bases para esta visión, demostrando que es posible desarrollar y compartir abiertamente IA avanzada.

El Camino por Delante: Predicciones y Esperanzas

Mirando a los próximos años, es razonable esperar que veamos una explosión de variaciones y mejoras sobre el tema del razonamiento recursivo. TRM ha demostrado que el enfoque es viable y potente, pero como toda innovación significativa, abre más preguntas de las que responde. Otros laboratorios ya están explorando variaciones: modelos recursivos con diferentes mecanismos de atención, arquitecturas que aprenden dinámicamente cuántas recursiones usar para cada problema, sistemas que combinan la recursión con la recuperación de información externa.

En el frente industrial, espero que veamos una adopción relativamente rápida en dominios específicos donde las ventajas de TRM son abrumadoras. La robótica, los vehículos autónomos, los sistemas integrados y las aplicaciones de borde donde la eficiencia es crítica son candidatos obvios. También podríamos ver startups que ofrezcan "TRM-como-servicio" para tareas de razonamiento específicas, compitiendo con los gigantes precisamente en la capacidad de hacer más con menos.

En el mundo académico, TRM proporciona un nuevo marco para explorar preguntas fundamentales sobre el aprendizaje и la generalización. ¿Por qué funciona tan bien la recursión? ¿Qué está aprendiendo realmente TRM en el espacio latente durante sus iteraciones? ¿Cómo podemos caracterizar formalmente la clase de problemas para los que este enfoque es óptimo? Estos son temas de investigación que mantendrán ocupados a doctorandos y postdoctorados durante años.

También hay una dimensión geopolítica a considerar. La concentración de la IA avanzada en unas pocas empresas estadounidenses y chinas ha creado preocupaciones en Europa y en otras regiones. Enfoques como TRM, que reducen drásticamente las barreras de entrada, podrían permitir a los países con menos recursos computacionales desarrollar de todos modos capacidades de IA avanzadas. Esto podría reequilibrar parcialmente el panorama global de la IA, con implicaciones para la competencia económica, la seguridad nacional y la gobernanza internacional de la tecnología.

Reflexiones Finales: La Inteligencia Como Proceso, No Como Producto

TRM nos recuerda una verdad fundamental que la industria de la IA quizás había olvidado en su carrera por el escalado: la inteligencia no es una cuestión de tamaño, sino de proceso. No importa cuán grande sea tu modelo o cuántos parámetros contenga. Lo que importa es cómo procesa la información, cómo itera sobre su propio razonamiento, cómo refina progresivamente sus propias conclusiones.

Esta intuición resuena con nuestra experiencia humana. Las personas más inteligentes que conocemos no son necesariamente las que tienen el cerebro más grande o más neuronas. Son las que piensan metódicamente, que consideran los problemas desde múltiples ángulos, que revisan sus propias conclusiones, que aprenden de sus propios errores. En otras palabras, son las que iteran eficazmente sobre su propio proceso de razonamiento.

Si hay una lección que podemos extraer del surgimiento de TRM, DeepConf, MemVid y la tendencia más amplia hacia la eficiencia en la IA, es que el futuro no pertenecerá necesariamente a los más grandes, sino a los más astutos. La industria está despertando lentamente a la conciencia de que lanzar más recursos a los problemas tiene rendimientos decrecientes, y que la innovación arquitectónica inteligente puede producir saltos cualitativos que el mero escalado nunca alcanzará.

Como el pequeño Saitama de One Punch Man que derrota a monstruos cósmicos con su entrenamiento básico, o como el diminuto Luke Skywalker que aprende que la Fuerza no tiene que ver con el tamaño, TRM nos muestra que en la IA todavía vale el viejo adagio: no es cuán grande eres, es cómo usas lo que tienes.

Y en un mundo donde los recursos computacionales y ambientales están cada vez más bajo presión, donde la concentración de poder tecnológico plantea legítimas preocupaciones democráticas, y donde el acceso a la inteligencia artificial avanzada podría determinar el éxito o el fracaso de economías enteras, esta lección no podría llegar en un momento más oportuno.

El artículo de Samsung SAIL Montreal no es solo una innovación técnica. Es un manifiesto para una forma diferente de pensar sobre la inteligencia artificial, una que privilegia la elegancia sobre la fuerza bruta, la accesibilidad sobre la concentración, la sostenibilidad sobre el crecimiento indiscriminado. Si este enfoque se afianza, y todos los indicios sugieren que lo hará, podríamos mirar hacia atrás a TRM como el punto de inflexión donde la industria de la IA finalmente aprendió que más pequeño puede ser realmente más inteligente.