L'Hôpital Virtuel : Quand l'Intelligence Artificielle devient Médecin

L'Agent Hospital chinois simule des milliers de diagnostics par jour dans un monde virtuel. Est-ce l'avenir de la médecine ou le début d'une révolution que personne n'a demandée ? Imaginez un hôpital qui fonctionne vingt-quatre heures sur vingt-quatre, sept jours sur sept. Les médecins consultent des patients, ordonnent des examens, interprètent des radiographies, prescrivent des thérapies. En quelques jours, ils traitent dix mille cas cliniques, accumulant une expérience qui nécessiterait des années dans un service d'urgence bondé. Il n'y a qu'un seul détail qui rend tout cela inquiétant : aucun de ces patients n'existe vraiment. Personne ne souffre, personne ne guérit, personne ne meurt. C'est comme si *Les Sims avaient rencontré Urgences dans une dimension où personne ne joue, mais où quelque chose apprend.*

L'Agent Hospital de l'Université de Tsinghua, inauguré officiellement en avril 2025 avec la première intégration à l'hôpital Changgung de Pékin, représente plus qu'une simple expérience universitaire. C'est tout un écosystème de santé synthétique où des intelligences artificielles s'entraînent à être médecins en soignant des entités qui n'existent que sous forme de chaînes de code. Quarante-deux médecins virtuels, vingt et une spécialités médicales, cinq cent mille patients qui n'ont jamais respiré. La question n'est plus de savoir si l'intelligence artificielle peut poser des diagnostics médicaux : la question est de savoir si nous sommes en train de construire les médecins du futur ou si nous venons d'ouvrir une boîte de Pandore que personne ne sait comment refermer.

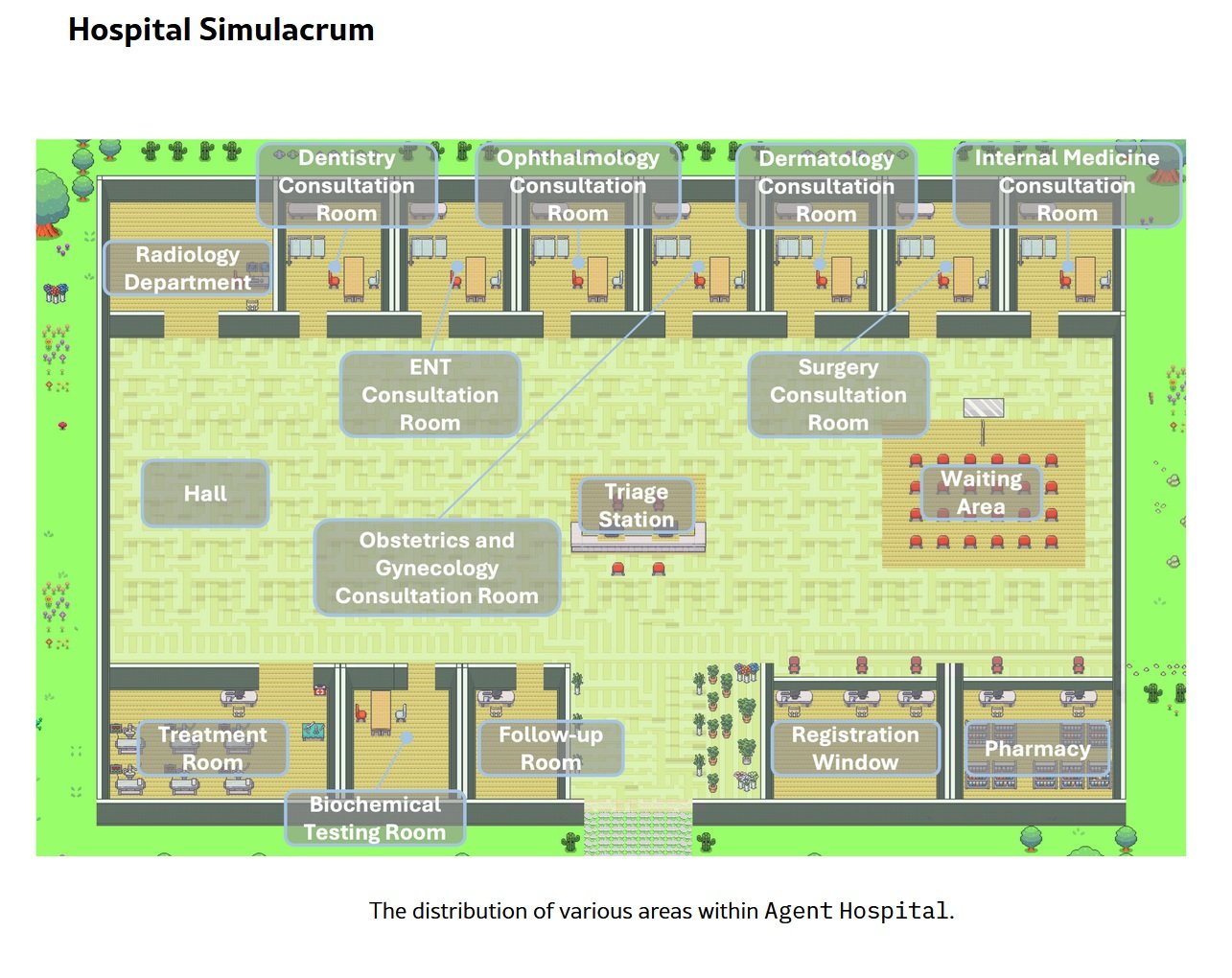

Anatomie d'un Monde Virtuel

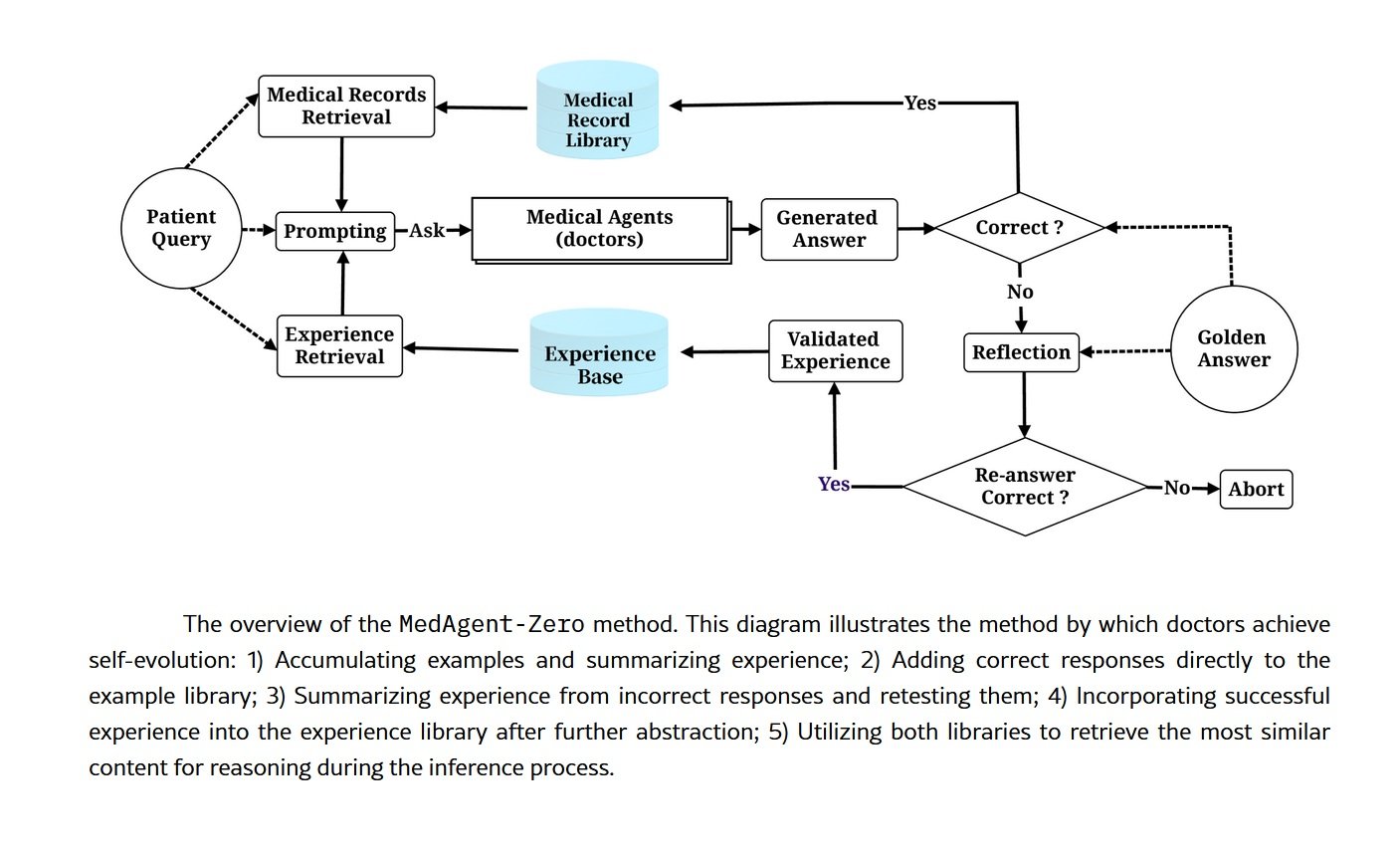

Sous le capot de l'Agent Hospital se trouve MedAgent-Zero, un cadre de travail techniquement sophistiqué qui renverse l'approche traditionnelle de l'entraînement des intelligences artificielles médicales. Au lieu de nourrir un modèle avec des ensembles de données statiques de cas cliniques passés, les chercheurs de Tsinghua ont construit un environnement où les agents d'IA apprennent en faisant, exactement comme le feraient des internes en chair et en os. La différence réside dans l'échelle et la vitesse : ce qui prendrait à un médecin humain une résidence de quatre ans se fait ici en quelques jours de simulation continue.

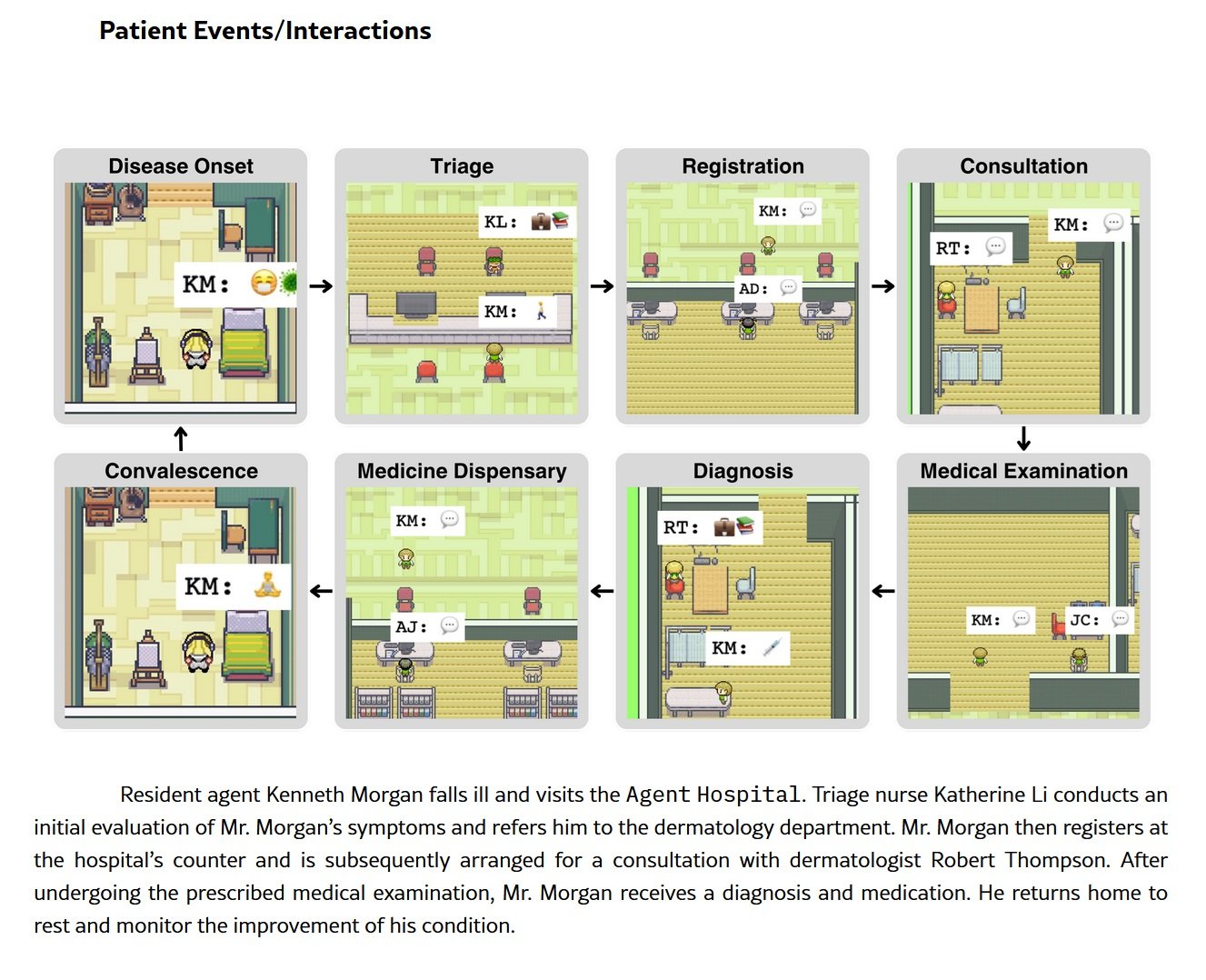

L'architecture est basée sur de grands modèles de langage modifiés pour fonctionner dans un cycle d'apprentissage perpétuel. Le système génère de manière autonome des profils de patients synthétiques avec des antécédents médicaux, des symptômes, des résultats de laboratoire. Ces patients virtuels entrent dans l'hôpital fantôme et sont affectés aux médecins IA, chacun spécialisé dans un domaine spécifique : cardiologie, oncologie, médecine respiratoire, neurologie. Les agents mènent des anamnèses, demandent des examens diagnostiques, interprètent des données, formulent des diagnostics et proposent des plans de traitement. Après chaque interaction, un système de retour d'information évalue l'exactitude des décisions cliniques en les comparant aux directives établies et à la vérité terrain du cas simulé. Les erreurs deviennent des leçons, les succès renforcent les schémas décisionnels.

Les chiffres actuels sont impressionnants mais pas parfaits, et cette honnêteté dans les mesures est peut-être plus significative que les pourcentages eux-mêmes. Dans la phase d'examen, celle de l'anamnèse et de la collecte de données, le système atteint quatre-vingt-huit pour cent de précision. Dans la phase de diagnostic, il grimpe à quatre-vingt-quinze virgule six pour cent. Dans la planification du traitement, la phase la plus complexe car elle exige non seulement d'identifier la maladie mais aussi de trouver un équilibre entre l'efficacité thérapeutique, les effets secondaires, les pathologies et les préférences du patient, la précision chute à soixante-dix-sept virgule six pour cent. Sur le benchmark MedQA, qui utilise des questions de type USMLE (l'examen d'aptitude médicale américain) axées sur les maladies respiratoires, le système a atteint quatre-vingt-treize pour cent.

Ces performances feraient-elles pâlir de nombreux médecins humains ? Cela dépend. Un score de quatre-vingt-treize pour cent à des questions à choix multiples est excellent mais pas extraordinaire pour un système d'IA optimisé pour ce type de tâche. Le score de soixante-dix-sept pour cent dans la planification du traitement est plus préoccupant : cela signifie que dans près d'un cas sur quatre, la thérapie proposée n'est pas optimale. Dans un hôpital réel, avec des patients réels, ce pourcentage représenterait des milliers d'erreurs potentiellement graves. Mais c'est là qu'émerge la véritable valeur de la simulation : ces erreurs se produisent dans un environnement sûr, où la seule conséquence est un ajustement des poids neuronaux.

La compression temporelle est le véritable super-pouvoir de cette architecture. Ce qui en médecine demande des années d'expérience clinique, une exposition à des centaines de cas différents, des nuits blanches de garde, est ici condensé en cycles de calcul. Un médecin IA peut voir en une semaine de simulation plus de cas de pneumonie atypique qu'un pneumologue humain n'en verrait dans toute sa carrière dans un hôpital de province. Le problème est de savoir si la quantité d'exposition équivaut vraiment à la qualité de la compétence.

Du Virtuel au Réel

Le calendrier de déploiement de l'Agent Hospital raconte une histoire d'accélération vertigineuse. Les tests internes ont commencé en novembre 2024, alors que le système était encore confiné dans les laboratoires de Tsinghua. Le pilote public a été lancé au premier trimestre 2025, avec de vrais médecins qui ont commencé à interagir avec les diagnostics générés par l'IA dans des scénarios contrôlés. En avril 2025, l'intégration opérationnelle avec l'hôpital Changgung de Pékin a eu lieu, marquant le passage d'une expérience universitaire à un outil clinique effectif.

Derrière cette transition se trouve Tairex, la start-up dérivée qui a commercialisé la technologie sous la marque Zijing AI Doctor. Les quarante-deux médecins virtuels couvrent aujourd'hui plus de trois cents maladies et sont actifs dans des programmes pilotes allant de l'ophtalmologie à la radiologie, de la médecine respiratoire à la médecine générale. Il ne s'agit pas de simples chatbots médicaux ou de systèmes de triage téléphonique : ces agents d'IA sont intégrés dans les flux de travail hospitaliers réels, ils assistent les médecins humains dans la lecture de l'imagerie diagnostique, suggèrent des diagnostics différentiels, proposent des protocoles thérapeutiques basés sur des données probantes à jour.

Le modèle économique derrière cette révolution est à la fois ambitieux et pragmatique. Les estimations les plus prudentes parlent d'une économie potentielle de dix à vingt pour cent sur les coûts hospitaliers globaux. Projeté à 2050 dans le seul système de santé américain, cela se traduirait par une fourchette de trois cents à neuf cents milliards de dollars par an. Des chiffres qui font briller les yeux des directeurs financiers des hôpitaux et des investisseurs en technologie de la santé, mais qui soulèvent des questions embarrassantes : optimisons-nous les soins aux patients ou optimisons-nous les bilans ?

L'objectif déclaré par les chercheurs chinois est double et apparemment noble. D'une part, combler le fossé sanitaire dans les zones rurales et les régions sous-dotées en personnel médical spécialisé, un problème particulièrement aigu dans un pays de mille trois cent cinquante millions d'habitants répartis sur un territoire aussi vaste que l'Europe. D'autre part, créer un terrain d'entraînement pour ce qu'ils appellent les "médecins collaboratifs avec l'IA", une nouvelle génération de médecins qui ne travaille pas contre l'intelligence artificielle et n'est pas remplacée par elle, mais qui apprend à l'orchestrer comme un outil d'amélioration cognitive. C'est une vision séduisante, presque utopique. Le diable, comme toujours, se cache dans la mise en œuvre.

Le Côté Obscur de l'Algorithme

Responsabilité Légale dans le Vide Normatif

La première fissure dans l'édifice étincelant de l'IA médicale s'ouvre sur la question de la responsabilité. Lorsqu'un médecin IA commet une erreur de diagnostic, qui est responsable ? Le médecin humain qui a supervisé (ou n'a pas supervisé) la décision ? L'hôpital qui a mis en œuvre le système ? Les développeurs qui ont entraîné le modèle ? L'université qui a mené la recherche ? La réponse honnête est : personne ne le sait avec certitude, car les cadres réglementaires sont dramatiquement en retard sur la technologie.

La Food and Drug Administration américaine classe les algorithmes médicaux comme des dispositifs médicaux, mais les catégories existantes ne rendent pas compte de la nature dynamique des systèmes basés sur l'apprentissage automatique qui continuent d'apprendre après leur déploiement. Le règlement européen sur les dispositifs médicaux est encore plus vague sur ces aspects. En Chine, où l'Agent Hospital prend forme, la situation réglementaire est opaque pour les observateurs occidentaux mais manifestement assez permissive pour permettre ces expérimentations à grande échelle.

Il y a ensuite le problème du consentement éclairé. Lorsqu'un patient entre dans un service où les décisions diagnostiques sont influencées ou déterminées par des algorithmes, le sait-il ? Lui explique-t-on que sa radiographie sera d'abord analysée par un système d'IA et seulement ensuite vérifiée par un radiologue humain ? Que le plan de traitement a été généré par un agent artificiel entraîné sur des patients qui n'ont jamais existé ? Le fossé entre la transparence théorique et la pratique clinique quotidienne peut être embarrassant.

Le Risque de Déqualification Médicale

La dépendance excessive à l'égard de l'intelligence artificielle n'est pas un scénario dystopique futur : c'est un risque présent et documenté. Lorsque les médecins s'habituent à avoir toujours un deuxième avis algorithmique à leur disposition, leurs compétences cliniques indépendantes s'érodent. C'est le même principe qui a fait perdre aux nouvelles générations la capacité de s'orienter sans GPS : la technologie devient une béquille cognitive et, lorsqu'elle fait défaut, les performances s'effondrent.

L'impact sur les médecins en formation est potentiellement encore plus grave. Si les internes apprennent à diagnostiquer aux côtés de systèmes d'IA qui suggèrent toujours la réponse, développeront-ils jamais le raisonnement clinique autonome nécessaire pour opérer dans des contextes où cette technologie n'est pas disponible ? Ou sommes-nous en train de créer une génération de médecins qui ne fonctionnent qu'avec les petites roues de l'assistant artificiel ? La variabilité entre les établissements de santé aggrave le problème : un médecin formé dans un hôpital hyper-technologique avec un Agent Hospital intégré pourrait se trouver en difficulté lorsqu'il se déplace dans une clinique rurale aux ressources limitées.

Biais Algorithmiques et Représentativité

Cinq cent mille patients synthétiques, c'est beaucoup, mais représentent-ils la diversité réelle de la population humaine ? Les médecins IA s'entraînent sur des cas générés par des modèles qui ont inévitablement des biais intégrés à partir des données sur lesquelles ils ont été pré-entraînés. Si ces données surreprésentent certaines populations (généralement des hommes, des Caucasiens, d'âge moyen) et en sous-représentent d'autres (femmes, minorités ethniques, personnes âgées, patients atteints de pathologies multiples), le système perpétue et amplifie les disparités existantes.

Le problème de la souveraineté des données ajoute un niveau de complexité supplémentaire. Les patients virtuels de l'Agent Hospital ont-ils été générés par des modèles entraînés sur quelles données ? Proviennent-elles de populations chinoises, occidentales, mondiales ? Les maladies rares dans les populations asiatiques sont-elles surreprésentées par rapport à celles typiques d'autres zones géographiques ? Et surtout : lorsque ces systèmes seront exportés et mis en œuvre dans d'autres pays, fonctionneront-ils aussi bien sur des populations génétiquement et cliniquement différentes ?

L'Éléphant dans la Pièce : l'Empathie

Dong Jiahong, un universitaire chinois cité dans le débat sur l'Agent Hospital, a résumé l'objection la plus fondamentale par une phrase qui sonne presque poétique : "La médecine est la science de l'amour, mais l'intelligence artificielle reste froide". Il ne s'agit pas de luddisme ou de nostalgie romantique : c'est la reconnaissance que la relation médecin-patient comporte des éléments qui échappent à la quantification algorithmique.

Un médecin IA peut analyser des symptômes, corréler des données de laboratoire, suggérer des diagnostics avec des pourcentages de confiance à trois chiffres après la virgule. Il ne peut pas saisir le regard d'un patient qui cache des informations par honte, il ne peut pas lire l'hésitation dans la voix de celui qui a peur de poser des questions, il ne peut pas offrir le réconfort d'une présence humaine au moment d'une mauvaise nouvelle. Le contact humain n'est pas une option romantique en médecine : il fait partie intégrante du processus thérapeutique, documenté par des décennies de recherche sur l'effet placebo, l'observance thérapeutique, les résultats psychologiques.

Lorsque nous déléguons le diagnostic à des systèmes artificiels, qu'advient-il de cette dimension relationnelle ? Certains soutiennent que libérer les médecins des tâches informatiques leur permettrait de consacrer plus de temps à l'aspect humain. D'autres craignent que la médecine ne devienne progressivement une expérience désincarnée, où le patient interagit avec des écrans et des algorithmes tandis que le médecin humain devient un superviseur distant, un contrôleur de qualité qui signe des rapports générés par des machines.

La Question que Personne ne Pose

Qui a réellement demandé cette révolution ? Les patients ont-ils organisé des manifestations pour avoir plus d'IA dans les services ? Les médecins ont-ils fait grève pour obtenir des agents virtuels pour les assister ? La réponse embarrassante est que l'Agent Hospital est né d'un programme qui a plus à voir avec l'efficacité économique et la vitrine technologique qu'avec des besoins exprimés par la base. C'est l'offre qui crée la demande, le classique "technology push" déguisé en innovation nécessaire.

Le paradoxe de l'efficacité imprègne tout le discours sur l'IA médicale. Plus vite est-il toujours mieux ? Un diagnostic correct en trente secondes est-il vraiment supérieur à un diagnostic correct en dix minutes si le second inclut une conversation qui rassure le patient et instaure la confiance ? Optimisons-nous des mesures qui comptent vraiment ou optimisons-nous ce qui est facile à mesurer ?

Cronenberg dans eXistenZ explorait le moment où la simulation devient plus réelle que la réalité, où les frontières entre les niveaux d'existence se dissolvent et où personne ne sait plus dans quelle dimension il opère. L'Agent Hospital pose une question structurellement similaire : lorsqu'un système entraîné sur des patients inexistants commence à soigner des personnes réelles, où traçons-nous la frontière entre la simulation validée et la pratique clinique ? Qui décide quand la compression temporelle virtuelle a généré suffisamment d'expérience pour équivaloir à des décennies de pratique humaine ?

Les perspectives sont polarisées selon des axes géographiques et culturels. L'urgence chinoise est compréhensible : une population qui vieillit rapidement, une pénurie chronique de médecins spécialistes, d'énormes disparités sanitaires entre les mégalopoles côtières et les provinces intérieures. Pour Pékin, l'Agent Hospital n'est pas une expérience philosophique mais une solution pragmatique à des problèmes réels et immédiats. La prudence occidentale, en revanche, reflète des systèmes de santé différents, des cadres réglementaires plus stricts, une sensibilité plus grande (du moins en théorie) à l'autonomie du patient et au consentement éclairé.

L'interrogation finale est brutalement simple : construisons-nous des outils pour l'humanité ou remplaçons-nous l'humanité par des outils ? La distinction n'est pas académique. Dans le premier cas, l'IA médicale est un amplificateur des capacités humaines, un moyen d'étendre la compétence des bons médecins et de combler les lacunes des moins préparés. Dans le second cas, c'est le début d'un parcours où la profession médicale devient progressivement automatisée, où les décisions cliniques migrent des processus cognitifs humains vers des chaînes algorithmiques supervisées.

La Frontière qui s'Amincit

L'Agent Hospital est un miroir qui reflète nos priorités en tant que civilisation technologique. Il montre ce que nous apprécions (efficacité, évolutivité, coûts optimisés) et ce que nous sommes prêts à sacrifier (temps relationnel, intuition clinique humaine, le droit d'être soigné par quelqu'un qui a vécu l'expérience de la maladie et de la guérison). La technologie en soi est neutre, une vérité si galvaudée qu'elle en est devenue presque vide de sens. Mais la mise en œuvre n'est jamais neutre : chaque choix de déploiement révèle des hypothèses éthiques, des biais économiques, des visions anthropologiques.

Les dix mille patients virtuels qui peuplent aujourd'hui les services fantômes de Tsinghua pourraient être nous demain, assis dans des cabinets où la première anamnèse est faite par un agent d'IA, où notre radiographie est lue par des réseaux neuronaux entraînés sur des millions d'images synthétiques, où le plan de traitement nous est présenté par un médecin humain qui se contente de valider ce que l'algorithme a déjà décidé. Ce n'est pas de la science-fiction : c'est déjà là, en phase pilote, en expansion contrôlée, en attente d'être déployé à grande échelle.

La question n'est plus "si" cet avenir arrivera. C'est "comment" nous le gérerons, avec quelles garanties, avec quelle transparence, avec quel équilibre entre l'efficacité systémique et la dignité individuelle. L'Agent Hospital de Tsinghua n'est pas la réponse : c'est le début de la conversation que nous aurions dû commencer il y a des années. Mieux vaut tard que jamais, mais le temps presse. Les algorithmes apprennent vite. Nous, les humains, beaucoup moins.