Révolution DeepConf : plus de précision et moins de ressources pour les LLM

Imaginez que vous passez un examen de mathématiques particulièrement difficile. Vous êtes confronté à un problème qui vous donne des sueurs froides, du genre de ceux des Olympiades de mathématiques qui font pleurer même les plus brillants. La stratégie classique ? Essayer encore et encore, écrire des dizaines de tentatives différentes en espérant que l'une d'elles soit la bonne. Mais il existe une approche plus intelligente : comprendre quand vous vous engagez dans la mauvaise direction et vous arrêter avant de gaspiller du temps et de l'énergie.

C'est exactement ce qu'a fait une jeune équipe de chercheurs de Meta AI, dirigée par Jiawei Zhao, chercheur à Meta AI FAIR et diplômé du prestigieux Caltech, en collaboration avec ses collègues Yichao Fu et Xuewei Wang.

Leur travail, publié sur arXiv il y a seulement quelques semaines sous le titre "Deep Think with Confidence", représente l'une de ces découvertes qui semblent simples a posteriori mais qui cachent en réalité une complexité technique considérable. Comme le geste apparemment anodin d'Archimède dans sa baignoire, cette recherche part également d'une observation élémentaire : si une intelligence artificielle raisonne mal, pourquoi ne pas lui apprendre à le reconnaître elle-même ?

Le Problème : Quand "Penser Plus" Ne Suffit Pas

Pour comprendre la portée révolutionnaire de cette approche, revenons un peu en arrière. Les grands modèles de langage, que nous appelons tous des LLM, ont une particularité lorsqu'ils sont confrontés à des problèmes complexes : plus ils font de tentatives, meilleures sont leurs réponses. C'est comme s'ils étaient des étudiants particulièrement têtus qui continuent de réessayer un exercice jusqu'à ce qu'ils le réussissent.

Cette approche, techniquement appelée "test-time scaling", fonctionne selon une logique apparemment simple : si vous demandez au modèle de générer cinquante solutions différentes à un problème, puis que vous choisissez la plus fréquente d'entre elles, les chances de trouver la bonne augmentent de façon spectaculaire. C'est le principe de la "self-consistency with majority voting" (auto-cohérence avec vote majoritaire), une stratégie qui a très bien fonctionné pendant des années.

Mais il y a un problème, en fait deux. Le premier est économique : générer des dizaines ou des centaines de réponses coûte une fortune en termes de puissance de calcul. C'est comme louer cinquante ordinateurs pour faire le même calcul en espérant que la majorité arrivera au bon résultat. Le second problème est plus subtil : après un certain point, ajouter plus de tentatives n'améliore pas significativement les résultats. C'est la fameuse "loi des rendements décroissants" que les économistes connaissent bien, appliquée au monde de l'intelligence artificielle.

La Solution : De "Plus Fort" à "Plus Malin"

Et c'est là qu'intervient l'intuition géniale de l'équipe de Meta. Au lieu de continuer à marteler le problème avec la force brute computationnelle, pourquoi ne pas apprendre au modèle à reconnaître quand il est sur le point de s'engager sur une mauvaise voie ? C'est un peu comme le radar de proximité des voitures modernes : au lieu d'attendre l'impact, il vous avertit avant que vous ne soyez sur le point de percuter un obstacle.

DeepConf, c'est le nom de la nouvelle méthode, qui exploite ce que les chercheurs appellent les "signaux de confiance internes au modèle". En termes simples, chaque fois qu'un LLM génère un mot ou un concept, il dispose d'une sorte de "thermomètre interne" qui indique à quel point il est sûr de ce choix. C'est comme lorsque vous répondez à une question de quiz : parfois vous êtes sûr à 100 %, d'autres fois vous hésitez entre deux options.

La brillance de DeepConf réside dans la transformation de cette "hésitation" interne en un filtre intelligent. Au lieu de générer aveuglément des centaines de tentatives pour ensuite les compter une par une, le système surveille en temps réel la confiance du modèle et écarte automatiquement les raisonnements qui présentent des signes d'incertitude trop élevés. C'est comme avoir un assistant personnel qui vous murmure à l'oreille "il vaut peut-être mieux que tu essaies une autre approche" quand il vous voit vous embourber dans une mauvaise solution.

Comment Ça Marche : Les Secrets de la Nouvelle Architecture

D'un point de vue technique, DeepConf fonctionne sur deux niveaux complémentaires. Le premier est ce que les chercheurs appellent le "filtrage pendant la génération". Imaginez que vous êtes Sherlock Holmes qui, tout en raisonnant à voix haute, se rend compte qu'il suit une mauvaise piste et change immédiatement de direction. C'est exactement ce que fait DeepConf : il surveille les probabilités logarithmiques internes du modèle jeton par jeton et, lorsqu'il détecte des schémas d'incertitude, il interrompt cette ligne de raisonnement particulière et en commence une nouvelle.

Le second niveau est le "filtrage après la génération", qui fonctionne davantage comme un éditeur expert. Une fois que le modèle a généré plusieurs solutions complètes, DeepConf analyse rétrospectivement les signaux de confiance de chaque trace de raisonnement et leur attribue un score de fiabilité. C'est comme avoir un correcteur d'épreuves qui ne se contente pas de compter les erreurs, mais qui évalue la cohérence globale du raisonnement.

La vraie magie, cependant, réside dans sa simplicité de mise en œuvre. Comme le soulignent les auteurs dans leur article, DeepConf ne nécessite aucune formation supplémentaire du modèle ni aucune optimisation des hyperparamètres. Il s'agit d'une approche "plug-and-play" qui peut être intégrée dans les frameworks de service existants comme vLLM sans modifications substantielles de l'architecture. C'est comme installer un nouveau logiciel sur votre ordinateur : vous n'avez pas à changer le matériel, il fonctionne avec ce que vous avez déjà.

Les Chiffres qui Stupéfient

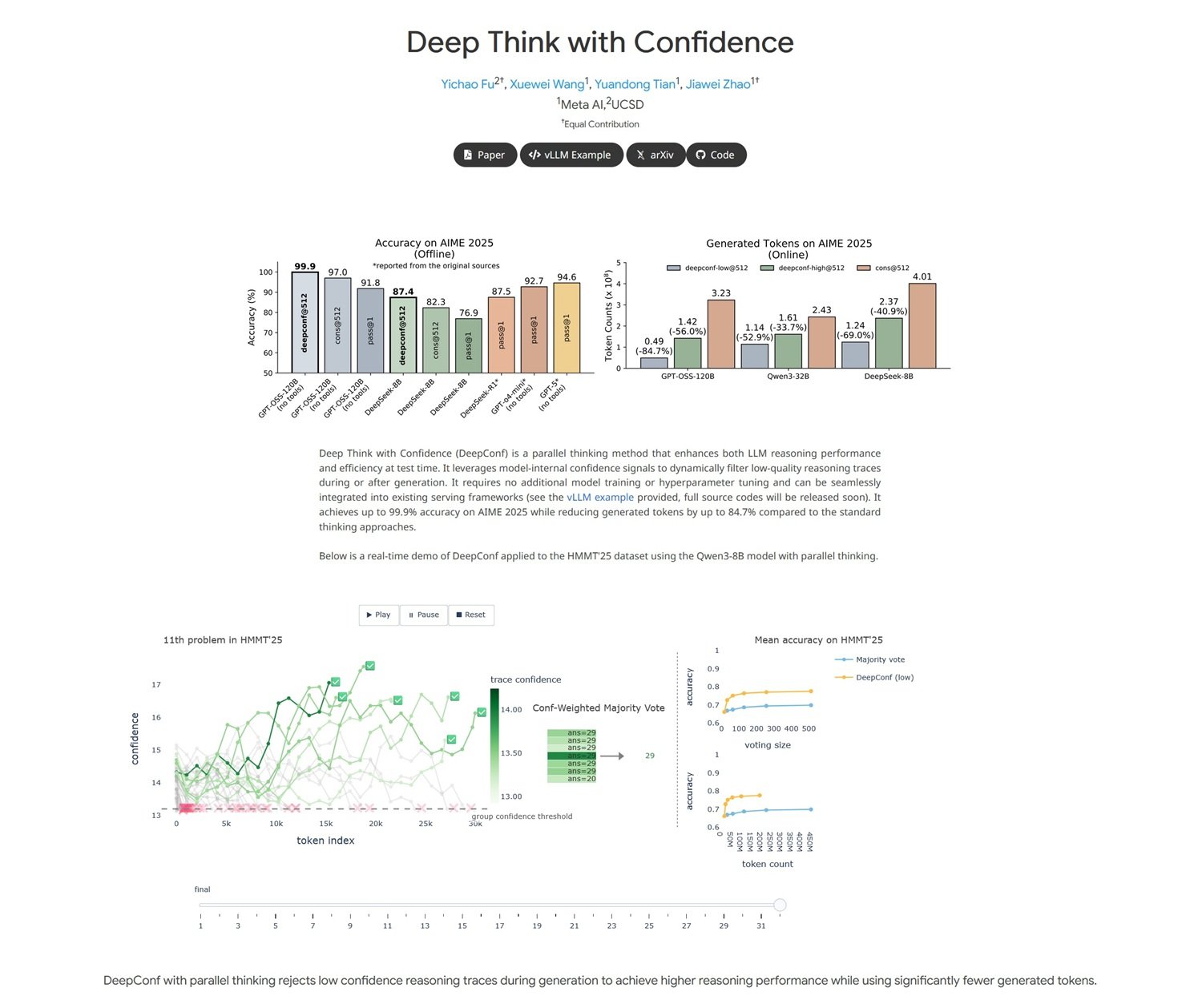

Les résultats obtenus par l'équipe de Meta sont pour le moins impressionnants, avec cette saveur de "trop beau pour être vrai" qui caractérise les découvertes vraiment innovantes. Sur AIME 2025, l'un des benchmarks les plus difficiles pour le raisonnement mathématique (pensez-y comme l'examen du baccalauréat pour les intelligences artificielles), DeepConf a atteint une précision de 99,9 % tout en réduisant simultanément l'utilisation de jetons de 84,7 % par rapport aux méthodes traditionnelles.

Pour comprendre la portée de ces chiffres, faisons une comparaison cinématographique. C'est comme si quelqu'un avait inventé un moyen de tourner des films de qualité hollywoodienne en utilisant un dixième du budget habituel, tout en conservant la même qualité visuelle et narrative. Dans le monde de l'IA, où chaque jeton généré a un coût de calcul mesurable, une réduction de 85 % signifie littéralement réduire les coûts d'exploitation d'un ordre de grandeur.

Mais ce n'est pas seulement une question économique. L'aspect le plus fascinant est que DeepConf parvient à améliorer les performances précisément en éliminant le "bruit" computationnel. C'est contre-intuitif : normalement, en informatique, plus vous consacrez de ressources à un problème, meilleurs sont les résultats que vous obtenez. Ici, au contraire, c'est l'inverse qui se produit : en supprimant les tentatives de faible qualité, le signal émerge plus clairement du bruit de fond.

Les tests ont été menés sur les modèles open-source les plus avancés, notamment Qwen 3 et la série GPT-OSS, démontrant que l'approche fonctionne de manière transversale sur différentes architectures. C'est comme découvrir qu'une astuce fonctionne aussi bien sur un iPhone que sur un Android : cela signifie que vous avez probablement trouvé quelque chose de fondamental.

Deux Modes, Un Objectif

DeepConf fonctionne selon deux modes distincts, comme une voiture de sport qui peut fonctionner en mode éco ou en mode performance. Le mode "hors ligne" analyse toutes les traces de raisonnement générées, puis sélectionne celles qui présentent les meilleurs signaux de confiance. Il est parfait pour les applications où vous avez le temps de réfléchir et où vous souhaitez la plus grande précision possible.

Le mode "en ligne", quant à lui, est conçu pour les applications en temps réel où la vitesse est cruciale. Dans ce cas, DeepConf interrompt dynamiquement les traces de raisonnement qui montrent des signes de faible confiance et en lance de nouvelles à la volée. C'est comme avoir un GPS intelligent qui, au lieu de continuer à calculer un itinéraire qu'il sait être erroné, change immédiatement de cap vers une destination plus prometteuse.

La flexibilité de cette approche est l'un de ses points forts. Les développeurs peuvent calibrer le système en fonction de leurs besoins spécifiques : plus conservateur pour les applications critiques où l'erreur n'est pas tolérable, plus agressif pour les cas d'utilisation où la vitesse l'emporte sur la perfection absolue.

Impact Pratique : La Révolution Économique

L'impact économique de DeepConf pourrait être dévastateur pour l'industrie de l'IA, dans le bon sens du terme. Pensez aux implications : si vous pouvez obtenir les mêmes performances d'un système qui coûte 1000 dollars par jour avec un système qui en coûte 150, des services qui étaient auparavant économiquement insoutenables deviennent soudainement accessibles à un public beaucoup plus large d'utilisateurs et d'entreprises.

Mais ce n'est pas seulement une question de coûts directs. La réduction des jetons générés signifie également moins d'émissions de CO2, moins de stress sur les centres de données et, en fin de compte, une IA plus durable sur le plan environnemental. C'est comme passer d'un SUV qui consomme 15 litres aux 100 kilomètres à une voiture hybride qui en consomme 4, tout en conservant la même vitesse et le même confort.

Pour les entreprises qui proposent des services basés sur les LLM, DeepConf représente un potentiel "game-changer" concurrentiel. Celui qui parviendra à le mettre en œuvre en premier pourra offrir des services de qualité supérieure à des prix inférieurs, créant ainsi le type d'avantage concurrentiel qui redéfinit des industries entières. C'est la "disruption" classique dont parle Clayton Christensen, appliquée au monde de l'intelligence artificielle.

Perspectives Futures : Vers une IA Autoconsciente

Mais l'aspect le plus fascinant de DeepConf n'est peut-être même pas les résultats immédiats, mais ce qu'il représente comme direction de recherche. Pour la première fois, nous disposons d'un système qui ne se contente pas de générer des réponses, mais qui développe une forme primitive de métacognition : la capacité de réfléchir à ses propres processus de pensée.

C'est un pas important vers ce que les chercheurs appellent une "IA autoconsciente", des systèmes qui non seulement résolvent des problèmes, mais qui sont également conscients de la manière dont ils les résolvent et, surtout, de quand ils échouent. Nous ne parlons pas de conscience au sens de la science-fiction, mais d'une forme d'intelligence procédurale qui sait quand se faire confiance et quand être sceptique.

L'équipe de Meta a montré que ce type de "doute de soi constructif" peut être mis en œuvre sans bouleverser les architectures existantes, ouvrant la voie à une nouvelle génération de modèles plus efficaces et plus économiques. C'est comme si nous avions trouvé un moyen de rendre les machines non seulement plus intelligentes, mais aussi plus sages dans le sens où elles savent reconnaître leurs propres limites.

En regardant vers l'avenir, DeepConf pourrait n'être que l'apéritif d'une révolution plus large. Si les machines peuvent apprendre à douter de leurs propres réponses dans le domaine mathématique, qu'est-ce qui les empêche d'appliquer le même principe à l'écriture créative, à la résolution de problèmes éthiques, ou même à la recherche scientifique ? Le chemin vers une intelligence artificielle véritablement polyvalente pourrait bien passer par cette capacité d'autocritique constructive.

Le travail de Zhao et de ses collègues montre que les révolutions les plus importantes naissent parfois des intuitions les plus simples. Dans un monde où tout le monde court après des modèles toujours plus grands et plus puissants, ils ont choisi de miser sur l'efficacité et la conscience de soi. Comme le dirait le bon vieil Einstein, "tout devrait être rendu aussi simple que possible, mais pas plus simple". DeepConf semble avoir parfaitement trouvé cet équilibre, ouvrant de nouvelles frontières pour une IA plus intelligente, plus durable et, paradoxalement, plus humaine dans sa capacité à se remettre en question.