L'internet qui se mange la queue : quand l'IA génère des déchets qui alimentent d'autres IA

Il y a une scène dans "The Thing" de John Carpenter où l'extraterrestre assimile les organismes terrestres en créant des copies de plus en plus dégradées, de moins en moins parfaites. Chaque itération perd quelque chose de l'original jusqu'à ce que la distinction entre l'authentique et la réplique devienne impossible. C'est une image puissante pour décrire ce qui se passe dans l'écosystème numérique : l'intelligence artificielle consomme du contenu humain pour le régénérer sous une forme de plus en plus corrompue, alimentant un cycle de dégradation progressive que les scientifiques appellent "l'effondrement du modèle" mais que nous pourrions plus simplement définir comme l'internet qui se mange la queue.

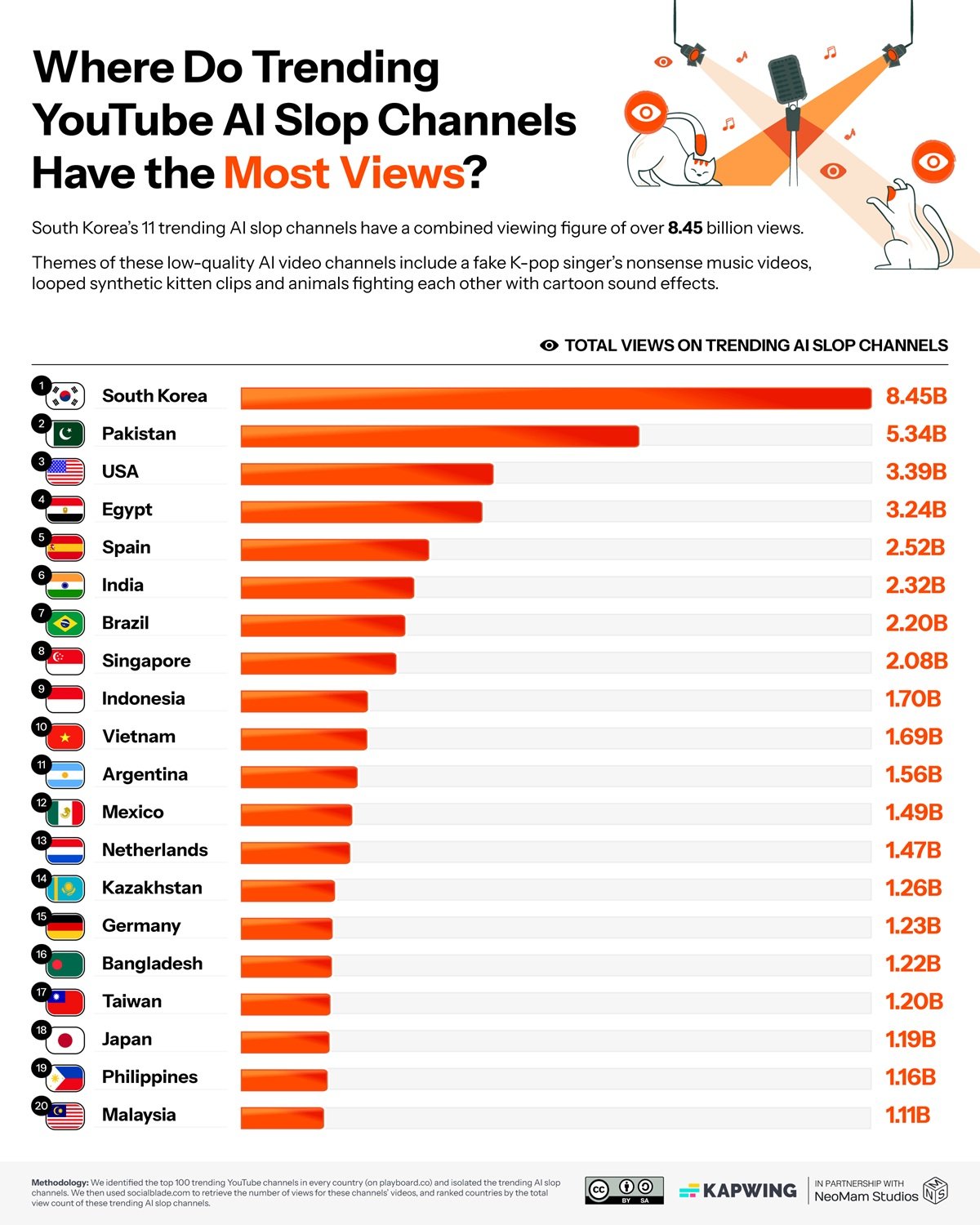

Les chiffres recueillis par Kapwing dans leur dernier rapport ont la précision brutale d'un diagnostic médical : entre 21 % et 33 % du contenu que YouTube propose aux nouveaux utilisateurs est ce que le jargon de l'industrie appelle du "slop IA", des déchets générés par l'intelligence artificielle. Nous ne parlons pas de contenu IA de qualité, mais de cette production industrielle à bas coût qui n'a qu'un seul but : maximiser les vues pour générer des revenus publicitaires. Des chaînes comme Cuentos Fascinantes en Espagne ont accumulé plus de vingt millions d'abonnés avec des vidéos entièrement synthétiques, tandis qu'en Corée du Sud, ce type de contenu a atteint huit milliards de vues. L'économie du "slop" vaut déjà cent dix-sept millions de dollars par an, avec des chaînes individuelles qui facturent plus de quatre millions.

La machine fonctionne de manière simple mais efficace. Les algorithmes de YouTube récompensent la nouveauté et l'engagement immédiat. Le contenu généré par l'IA, produit en masse à très bas coûts, peut saturer la plate-forme avec des variations infinies du même thème. Un créateur traditionnel met des heures ou des jours à produire une vidéo. Un système d'IA peut en produire des dizaines dans le même temps, en testant de multiples variantes pour identifier celle qui fonctionne le mieux. 54 % des premières vidéos vues par les nouveaux utilisateurs appartiennent à cette catégorie, créant une sorte de porte d'entrée déformée vers la plate-forme.

Neal Mohan, PDG de YouTube, a déclaré au magazine Time que l'intelligence artificielle représente "la prochaine frontière" pour la plate-forme. Lors d'une réorganisation annoncée en octobre 2024, YouTube a restructuré ses divisions de produits et d'ingénierie précisément pour s'aligner sur cette vision centrée sur l'IA. Mais il y a une incohérence inquiétante : alors que l'entreprise investit massivement dans des outils d'IA pour les créateurs, ses propres systèmes de modération automatisée provoquent des blocages massifs de chaînes légitimes, les créateurs voyant leurs comptes bannis tandis que les chaînes qui ont volé leur contenu restent actives. C'est comme si YouTube alimentait et combattait simultanément le même phénomène, piégé dans une contradiction systémique qui rappelle de près la dynamique de monopole technologique que l'Union européenne tente de réglementer.

L'entropie croissante

Mais le problème du "slop" n'est que la manifestation superficielle de quelque chose de beaucoup plus profond. Alors que YouTube se remplit de vidéos synthétiques, LinkedIn a atteint un point critique encore plus extrême : selon l'analyse d'Originality.AI, 54 % des publications de format long sur la plate-forme professionnelle sont générées par l'intelligence artificielle. Un bond de 189 % par rapport à la période pré-ChatGPT. Nous ne parlons pas d'aide à la rédaction, mais de contenu entièrement artificiel présenté comme une pensée originale. Les algorithmes de LinkedIn récompensent désormais cette production massive, créant un fil d'actualité où distinguer l'authentique du synthétique devient de plus en plus difficile.

La question n'est plus seulement qualitative mais structurelle. Un article publié sur arXiv documente scientifiquement le phénomène de "l'effondrement du modèle", l'entropie informationnelle qui se produit lorsque les modèles d'intelligence artificielle sont entraînés sur des données produites par d'autres modèles d'IA. Les auteurs démontrent que cette pratique entraîne une perte progressive de diversité : la variété sémantique mesurée en bits par token passe de 4,2 à 2,5 en quelques itérations d'entraînement seulement. C'est comme faire des photocopies de photocopies : chaque génération perd des détails, des nuances, de la complexité.

Le mécanisme est subtil. Les modèles actuels ont été entraînés sur des milliards de textes produits par des êtres humains au cours de décennies d'activité en ligne. Mais cette mine de données originales s'épuise. Une étude publiée dans Nature estime que le "budget" de contenu humain disponible pour l'entraînement s'épuisera entre 2026 et 2032, selon les scénarios. Après cela, les nouveaux modèles devront nécessairement se nourrir également de contenu généré par des IA précédentes. Et c'est là que le piège se referme : chaque cycle d'entraînement sur des données synthétiques amplifie les erreurs, réduit la variété, homogénéise le résultat. Comme dans une population qui ne se reproduit qu'en son sein, la diversité génétique s'effondre.

Le serpent Ouroboros numérique

Le "slop" de YouTube et l'effondrement du modèle ne sont pas des phénomènes distincts mais les deux faces d'une même médaille. Les vidéos poubelles générées aujourd'hui feront partie des ensembles de données avec lesquels les modèles de demain seront entraînés. Les publications IA de LinkedIn seront indexées, archivées, utilisées comme matériel d'entraînement. C'est une boucle de rétroaction parfaite : le contenu de mauvaise qualité génère des données corrompues qui produisent de moins bons modèles qui, à leur tour, créent un contenu encore plus dégradé. Un serpent qui se mange la queue, comme l'Ouroboros alchimique, mais sans aucune promesse de renaissance.

Les implications pratiques sont déjà mesurables. Une recherche publiée dans le JMIR a identifié que 5,3 % du contenu éducatif biomédical sur YouTube contient des informations générées par l'IA de qualité douteuse. Nous ne parlons pas de divertissement mais de matériel que les médecins, les étudiants et les patients consultent pour prendre des décisions en matière de santé. L'effet de "vérité illusoire" est bien documenté : la répétition d'informations fausses ou imprécises augmente leur crédibilité perçue. Si YouTube continue de diffuser du contenu IA non vérifié, nous construisons une infrastructure de désinformation qu'il deviendra de plus en plus difficile de démanteler.

Sur le plan économique, le "slop" crée de profondes distorsions. Les cent dix-sept millions de dollars qu'il génère chaque année ne sont pas une nouvelle richesse : ils sont détournés des créateurs légitimes vers ceux qui ont compris comment "jouer" le système algorithmique avec une production industrielle à bas coût. C'est une forme de sélection adverse : l'algorithme récompense ceux qui produisent en quantité au détriment de ceux qui produisent en qualité, créant une incitation perverse qui pousse l'ensemble de l'écosystème vers le bas. Et pendant ce temps, des géants comme Google continuent de redéfinir leur relation avec l'IA, investissant massivement dans une technologie qui menace en même temps de cannibaliser les fondements mêmes du web qu'ils ont contribué à construire.

La normalisation est peut-être l'aspect le plus insidieux. Lorsque la moitié du contenu sur LinkedIn est de l'IA et qu'un tiers de YouTube est du "slop", notre sens critique s'adapte. Nous commençons à nous attendre à cette patine d'artificialité, à ce manque d'authenticité. Le risque est que nous entraînions une génération d'utilisateurs à ne plus faire la distinction, à ne plus chercher l'original. Et quand on ne cherche plus l'original, on cesse de le valoriser et donc de le produire.

Les gagnants invisibles

Alors que l'écosystème numérique se remplit de déchets et que les modèles risquent de s'effondrer, il existe une économie parallèle qui prospère précisément sur ce chaos. Nvidia a clôturé le troisième trimestre fiscal 2026 avec cinquante-sept milliards de dollars de revenus, en hausse de soixante-deux pour cent d'une année sur l'autre. L'entreprise contrôle 92 % du marché des GPU et monétise chaque génération d'IA, qu'il s'agisse de contenu de qualité ou de "slop". Le PDG Jensen Huang parle d'une "demande incroyable" et de GPU cloud "épuisés", prévoyant des investissements dans l'infrastructure d'IA entre trois et quatre billions de dollars d'ici 2030.

Il n'y a pas que Nvidia. Les fournisseurs de cloud comme AWS, Azure et Google Cloud facturent des milliards aux entreprises qui entraînent des modèles et génèrent du contenu. OpenAI et Anthropic lèvent des centaines de millions de fonds au moment même où le web se remplit du contenu que leurs modèles produisent. C'est un paradoxe parfait : plus on génère de contenu IA, plus il faut de puissance de calcul pour entraîner les modèles suivants sur des ensembles de données de plus en plus pollués, générant des profits croissants pour l'infrastructure qui alimente le problème lui-même. Les "sloppers" de YouTube qui facturent quatre millions sont la partie visible de l'iceberg. Sous la surface, il y a une industrie de plusieurs dizaines de milliards qui monétise chaque watt d'énergie dépensé pour générer et traiter du contenu, quelle que soit sa qualité ou son utilité.

Vers quel écosystème

Mais il existe des alternatives concrètes qui fonctionnent déjà. Common Crawl, malgré les controverses récentes sur la gestion des murs payants, reste la plus grande archive publique de données web et est utilisée dans 64 % des modèles de langage. La différence cruciale réside dans la curation : des versions filtrées comme C4 de Google ou Pile-CC d'EleutherAI appliquent des processus de nettoyage agressifs. NVIDIA a développé Nemotron-CC, un ensemble de données de 6,3 billions de tokens construit à l'aide d'ensembles de classificateurs et de techniques de reformulation synthétique qui maintiennent la qualité tout en augmentant la quantité.

Cohere Labs construit des alternatives radicalement différentes avec le projet Aya, une initiative de science ouverte qui a impliqué trois mille chercheurs de 150 pays pour créer des ensembles de données multilingues organisés manuellement dans 101 langues. Pas d'automatisation aveugle, mais une curation humaine à grande échelle. Le Data Provenance Explorer, développé par le MIT et Cohere Labs, a suivi et vérifié deux mille des ensembles de données les plus utilisés, créant pour la première fois un système de traçabilité qui documente les licences, les créateurs et la lignée des données. Des plates-formes comme Substack ont construit des modèles économiques qui récompensent l'authenticité humaine vérifiée, démontrant qu'il existe des marchés prêts à payer pour du contenu original certifié.

Le watermarking du contenu IA reste une solution partielle mais nécessaire. L'Union européenne, avec la loi sur l'IA, a commencé à imposer des obligations de transparence. YouTube a annoncé des systèmes d'étiquetage, bien que la mise en œuvre reste inégale. Mais la question n'est pas seulement technologique. Des interventions structurelles sont nécessaires : les plates-formes doivent repenser les algorithmes qui récompensent l'engagement immédiat en créant des incitations perverses. Les ensembles de données pour l'entraînement nécessitent une curation extrême, en privilégiant les sources humaines vérifiées. Et un investissement massif dans l'éducation aux médias est nécessaire : reconnaître le contenu IA n'est plus une option mais une compétence fondamentale.

Le point critique est que nous sommes à la croisée des chemins. Nous pouvons continuer sur la trajectoire actuelle, où chaque année un pourcentage plus important du web est généré par l'IA, où les modèles sont entraînés sur les résultats d'autres modèles, où la diversité informationnelle s'effondre progressivement pour créer un écosystème numérique homogène, prévisible et stérile. Ou nous pouvons intervenir maintenant, avec une réglementation intelligente, des choix techniques conscients et une valorisation renouvelée du contenu humain authentique.

Le pari de YouTube est que l'IA peut démocratiser la création, en abaissant les barrières techniques et en permettant à quiconque de devenir créateur. Mais si cette démocratisation produit principalement des déchets qui polluent l'écosystème et alimentent l'effondrement des futurs modèles, nous ne démocratisons rien : nous ne faisons qu'accélérer une dégradation systémique. Comme dans l'extraterrestre de Carpenter, chaque copie devient moins parfaite que la précédente. Et contrairement au film, il n'y a pas de Kurt Russell avec un lance-flammes prêt à arrêter l'assimilation.

La question n'est plus de savoir si l'IA transformera l'internet. Cette transformation est déjà en cours. La question est : en quoi le transformons-nous ? En un système plus riche, plus varié et plus accessible, ou en une chambre d'écho où les machines parlent principalement à d'autres machines, tandis que nous, les humains, devenons des spectateurs de plus en plus passifs d'une détérioration informationnelle que nous avons mise en route mais que nous avons de plus en plus de mal à contrôler ?