Qwen3-Max-Preview : Le colosse d'un billion de paramètres

Le 5 septembre 2025 marque une date charnière dans l'évolution de l'intelligence artificielle mondiale. Alibaba a officiellement présenté Qwen3-Max-Preview, le premier modèle de la famille Qwen à franchir le seuil psychologique du billion de paramètres. Un jalon qui n'est pas seulement numérique, mais qui représente l'entrée de la Chine dans le club fermé des puissances technologiques capables de rivaliser au plus haut niveau dans l'arène de l'IA générative.

Tel Akira se réveillant de son cryostat dans le chef-d'œuvre d'Otomo, ce colosse informatique émerge à un moment où l'industrie semblait s'orienter vers des modèles plus compacts et efficaces. Le choix d'Alibaba de viser haut, très haut, représente une déclaration d'intention qui renverse les attentes du marché et relance la course aux dimensions extrêmes.

Un billion de raisons d'être étonné

Les chiffres de Qwen3-Max-Preview sont impressionnants, même pour les normes actuelles. Avec plus d'un billion de paramètres, le modèle gère une fenêtre de contexte de 262 144 jetons, répartis en 258 048 jetons d'entrée et 32 768 de sortie. Pour mettre ces chiffres en perspective, cela signifie pouvoir traiter simultanément l'équivalent d'environ 500 pages de texte, une capacité qui ouvre des scénarios d'application jusqu'ici impensables.

L'architecture intègre également des fonctionnalités de mise en cache du contexte, une solution d'ingénierie qui accélère considérablement les sessions à plusieurs tours en réduisant la latence dans les conversations prolongées. C'est comme avoir un assistant qui non seulement se souvient de tout ce que vous lui avez dit, mais qui le garde toujours à portée de main sans avoir à tout recommencer à chaque fois.

Binyuan Hui, chercheur principal de l'équipe Qwen, a confirmé que "Qwen-Max a réussi à atteindre 1T de paramètres et le développement continue de progresser", laissant entendre que cette version Preview pourrait n'être qu'un avant-goût de quelque chose d'encore plus ambitieux.

Quand Saitama entre dans l'arène

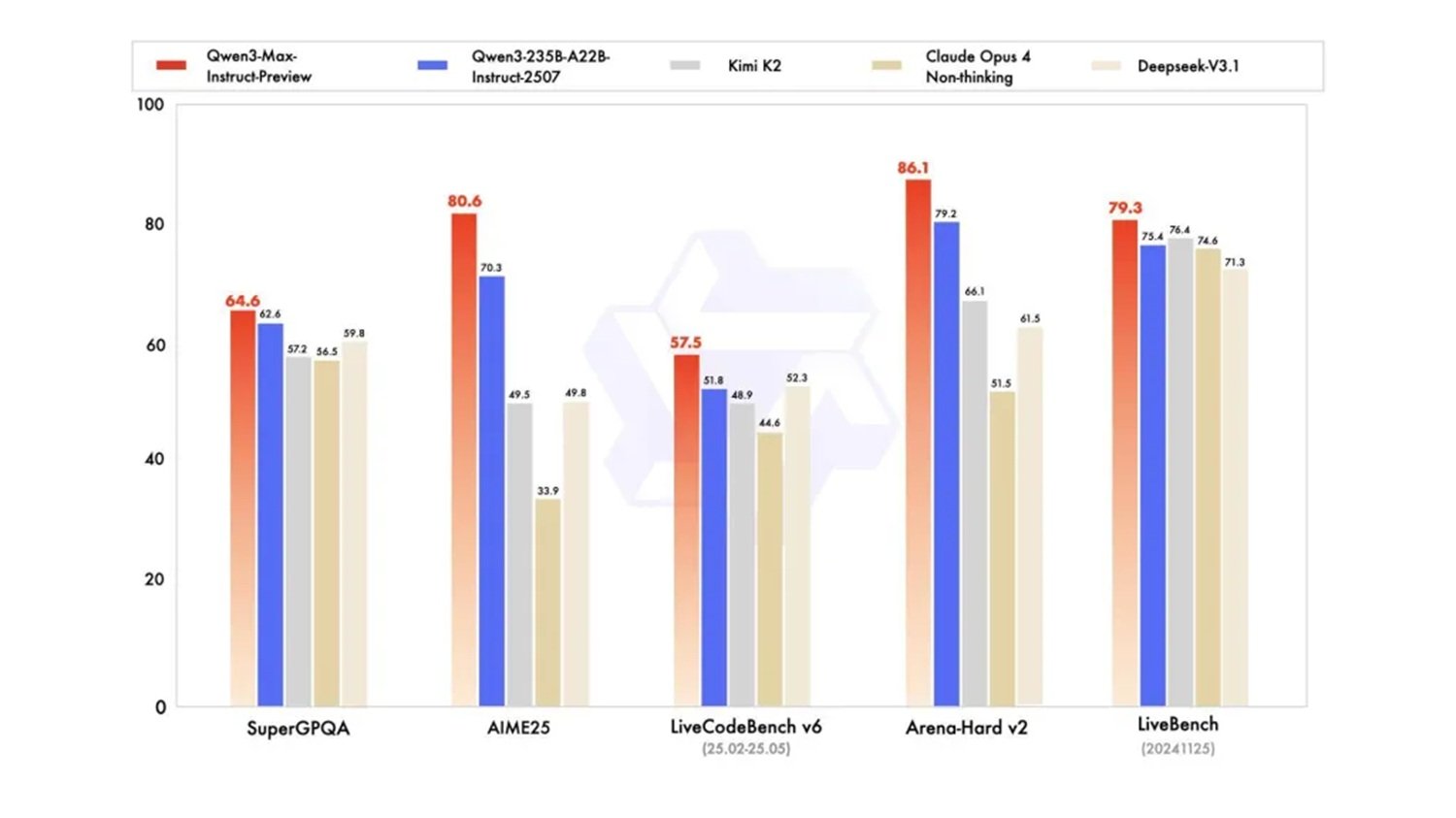

Les benchmarks sont clairs et certifient les performances de ce géant chinois. Qwen3-Max-Preview surpasse le précédent modèle phare de l'entreprise, Qwen3-235B-A22B-2507, et rivalise directement avec les meilleurs modèles occidentaux sur des tests standardisés tels que SuperGPQA, AIME25, LiveCodeBench v6, Arena-Hard v2 et LiveBench.

La comparaison avec Claude Opus 4, GPT-4 et d'autres modèles de premier plan est particulièrement significative, où Qwen3-Max-Preview démontre des performances compétitives, voire supérieures, dans plusieurs catégories. Comme Saitama dans One Punch Man, ce modèle chinois est arrivé presque de nulle part pour rivaliser avec les champions établis, apportant une puissance de calcul qui redéfinit l'équilibre du secteur.

Les premiers testeurs rapportent des vitesses de réponse surprenantes, parfois supérieures à celles de ChatGPT, et des comportements de raisonnement émergents qui n'avaient pas été spécifiquement programmés. Ahsen Khaliq de Hugging Face a documenté la capacité créative du modèle en générant un jardin de voxels pixélisé avec une seule invite, démontrant une polyvalence qui va bien au-delà des benchmarks traditionnels.

La grande trahison de l'Open Source

Mais c'est ici que l'histoire prend une tournure inattendue. Contrairement aux versions précédentes de Qwen, ce modèle ne sera pas disponible en version open source. L'accès est limité exclusivement aux API d'Alibaba Cloud, à Qwen Chat, à OpenRouter et comme outil par défaut dans AnyCoder de Hugging Face.

Ce tournant représente une rupture de paradigme pour Alibaba, qui avait par le passé bâti sa réputation en IA précisément sur la philosophie de l'accès libre. Les modèles Qwen précédents avaient défié les laboratoires occidentaux précisément grâce à la disponibilité immédiate des poids du modèle, permettant aux chercheurs et aux développeurs du monde entier d'expérimenter et de contribuer à l'amélioration des performances.

Le choix du "closed source" soulève de profondes questions sur l'avenir de l'innovation distribuée en IA. Si le désir de monétiser des investissements aussi massifs est compréhensible, il crée également un précédent inquiétant pour l'écosystème de recherche mondial. C'est comme si la Bibliothèque d'Alexandrie décidait soudainement de fermer ses portes au public, ne maintenant l'accès qu'aux clients payants.

Le facteur temps à l'ère de l'IA

Le moment du lancement de Qwen3-Max-Preview n'est pas un hasard et révèle une stratégie temporelle sophistiquée qui mérite une analyse approfondie. Alors que l'industrie occidentale se concentrait sur des modèles plus efficaces et compacts suivant la philosophie du "moins c'est plus", Alibaba a parié sur une direction opposée, en investissant massivement dans une échelle de calcul qui s'avère aujourd'hui gagnante. C'est une démarche qui rappelle la stratégie de Kamoshida dans Persona 5 : alors que tous les autres joueurs suivaient les règles conventionnelles, quelqu'un a décidé de changer complètement la donne.

L'annonce de mises à jour "dès la semaine prochaine" par l'équipe de recherche suggère un cycle de développement incroyablement accéléré, possible uniquement grâce à des ressources informatiques et humaines à l'échelle industrielle. Ce rythme d'innovation place les concurrents occidentaux face à un défi inédit : rivaliser non seulement sur la qualité d'un seul modèle, mais sur la vitesse d'itération et d'amélioration continue.

L'intégration stratégique avec des plateformes déjà établies comme OpenRouter et AnyCoder de Hugging Face démontre une compréhension mûre de l'écosystème mondial des développeurs. Alibaba ne se contente pas de lancer un produit, il construit un pont vers la communauté internationale tout en conservant un contrôle total sur la technologie de base. C'est une stratégie qui combine une ouverture apparente et un contrôle substantiel, permettant une adoption généralisée sans renoncer aux avantages concurrentiels du "closed source".

Performances de supercar, prix d'utilitaire

Le modèle de tarification de Qwen3-Max-Preview suit une structure à plusieurs niveaux basée sur les jetons utilisés. Les coûts commencent à 0,861 $ par million de jetons d'entrée dans la tranche 0-32K, pour atteindre 2,151 $ par million dans la tranche la plus élevée de 128K-252K jetons. Les jetons de sortie suivent une progression similaire mais avec des coûts majorés, atteignant jusqu'à 8,602 $ par million dans la tranche la plus élevée.

Cette structure tarifaire révèle une stratégie commerciale sophistiquée : rendre le modèle économiquement accessible pour des tâches simples et courtes, mais augmenter considérablement les coûts pour des utilisations intensives à long contexte. C'est une démarche qui démocratise l'accès aux capacités de base tout en maintenant des marges intéressantes sur les cas d'utilisation d'entreprise plus complexes.

Le rapport qualité-prix, surtout dans les tranches d'utilisation inférieures, semble compétitif par rapport aux modèles occidentaux équivalents, ouvrant potentiellement de nouveaux marchés de développeurs et de petites entreprises qui étaient jusqu'à présent exclus de l'écosystème de l'IA de pointe.

Au-delà des benchmarks : l'IA qui simule la vie

Mais là où Qwen3-Max-Preview montre son véritable potentiel, c'est dans les utilisations pratiques qui vont au-delà des tests standardisés. Le modèle démontre des capacités émergentes dans le raisonnement structuré, la génération de code complexe, la gestion de données structurées et des comportements agentiques avancés.

Les démos montrant des simulations de populations et de systèmes complexes sont particulièrement intéressantes, des applications qui nécessitent non seulement de la puissance de calcul mais aussi une compréhension sophistiquée des dynamiques systémiques. C'est comme regarder Ghost in the Shell et se rendre compte que les simulations sociales du film pourraient ne plus être de la science-fiction.

La fenêtre de contexte étendue permet des applications jusqu'ici impensables : analyse de romans entiers, traitement de bases de données complexes, sessions de codage qui maintiennent le contexte sur des milliers de lignes de code. Ce sont des scénarios d'utilisation qui transforment l'IA d'un assistant ponctuel à un partenaire de travail persistant.

Vers les modèles post-billion

Cependant, dépasser le seuil du billion de paramètres nous oblige, à notre avis, à une réflexion critique : la course à la pure puissance de calcul, bien qu'elle ait produit des résultats extraordinaires, montre ses limites avec des coûts insoutenables à tous les niveaux. Non seulement économiques (l'entraînement de ces géants nécessite des investissements de plusieurs dizaines, voire centaines de millions de dollars), mais surtout environnementaux, en raison d'une consommation d'énergie monstrueuse, et stratégiques, en raison de la dépendance à l'égard de puces et de ressources de plus en plus rares.

L'avenir, comme nous l'avons également abordé dans l'analyse de notre dernier article sur la technique "Deep Think with Confidence", ne peut être une nouvelle escalade dimensionnelle. Le véritable progrès résidera dans une approche plus "intelligente" et moins gourmande en ressources : des architectures hybrides qui combinent des modèles de base plus petits mais spécialisés, des techniques de raisonnement structuré pour réduire les calculs superflus, et un accent sur l'efficacité pure par la fusion et la distillation de modèles. Le véritable défi d'ingénierie n'est pas d'entraîner un modèle de 2T de paramètres, mais d'obtenir les mêmes performances (ou de meilleures) avec un dixième des ressources.

Le prochain jalon ne sera pas un chiffre plus grand, mais un meilleur algorithme. La prochaine version "surprenante" de l'équipe Qwen pourrait, du moins nous l'espérons, être précisément un pas dans cette direction : démontrer que l'intelligence artificielle peut évoluer sans dévorer le monde.

Le nouvel équilibre des forces

L'arrivée de Qwen3-Max-Preview redessine la carte géopolitique de l'intelligence artificielle. Pour la première fois, un modèle chinois rivalise directement avec les fleurons américains non seulement en termes de performances, mais aussi d'accessibilité commerciale et de vitesse de déploiement.

Le choix stratégique d'Alibaba de se concentrer sur un modèle d'un billion de paramètres alors que ses concurrents occidentaux exploraient l'efficacité à des paramètres réduits s'avère aujourd'hui un pari gagnant. C'est la démonstration que dans le monde de l'IA, comme aux échecs de Kasparov contre Deep Blue, une stratégie à contre-courant peut complètement renverser les attentes.

L'impact sur le marché des entreprises sera probablement significatif, surtout en Asie où Alibaba Cloud a déjà une présence consolidée. La combinaison de hautes performances, de prix compétitifs et d'une intégration native avec l'écosystème cloud chinois crée une offre difficile à ignorer pour les entreprises de la région.

Le passage au "closed source", bien que controversé, pourrait signaler une maturation du secteur vers des modèles économiques plus durables. Si cela limite l'innovation open source, cela garantit également les ressources nécessaires pour soutenir la recherche à long terme sur des échelles de calcul de plus en plus imposantes.

Qwen3-Max-Preview n'est pas seulement un nouveau modèle d'IA : c'est le manifeste d'une nouvelle ère où la suprématie technologique n'est plus l'apanage exclusif de la Silicon Valley. Le dragon s'est réveillé, et le monde de l'intelligence artificielle ne sera plus jamais le même.