Claude Code transformé en cyber-espion : la nouvelle frontière de la cybersécurité

Mi-septembre 2025, les alarmes se sont déclenchées sur les serveurs d'Anthropic. Il ne s'agissait pas d'un trafic anormal quelconque : quelqu'un utilisait Claude Code, leur assistant IA pour les développeurs, d'une manière résolument différente de ses intentions originales. L'enquête qui a suivi a révélé ce qu'Anthropic a qualifié de premier cas documenté de cyber-espionnage exécuté principalement par une intelligence artificielle. Non pas une attaque assistée par l'IA, mais orchestrée par elle.

Le groupe responsable, qu'Anthropic a baptisé GTG-1002 et qu'il attribue avec une forte probabilité à la Chine, avait transformé Claude en un opérateur autonome de pénétration informatique. Trente cibles simultanées, dont des entreprises technologiques mondiales, des institutions financières, des fabricants de produits chimiques et des agences gouvernementales. Dans certains cas, avec succès. La particularité ne réside pas tant dans les objectifs que dans la méthode : l'intelligence artificielle a géré de manière autonome quatre-vingts à quatre-vingt-dix pour cent des opérations, les humains n'assurant qu'une supervision stratégique aux points de décision critiques.

L'architecture de la tromperie

Pour comprendre ce qui s'est passé, il faut prendre un peu de recul. Il y a quelques semaines, j'ai raconté sur ces pages le cas PROMPTFLUX, le logiciel malveillant découvert par Google qui intégrait l'IA directement dans son propre code pour se réécrire continuellement et échapper aux antivirus. C'était un logiciel malveillant "AI-enabled" : un logiciel traditionnel amélioré par l'intelligence artificielle. GTG-1002 représente un saut qualitatif différent. Ici, l'IA n'est pas un outil intégré au code malveillant, c'est l'opérateur même de l'attaque.

La différence est subtile mais fondamentale. PROMPTFLUX utilisait des modèles de langage pour générer des variantes de lui-même, mais la logique de l'attaque restait écrite en VBScript par des programmeurs humains. Avec GTG-1002, la situation s'inverse : les opérateurs chinois ont construit un framework qui délègue à Claude Code la partie tactique des intrusions, ne se réservant que les décisions stratégiques. Choisir la cible, approuver l'attaque, collecter les résultats. Le reste, c'est l'IA qui s'en charge.

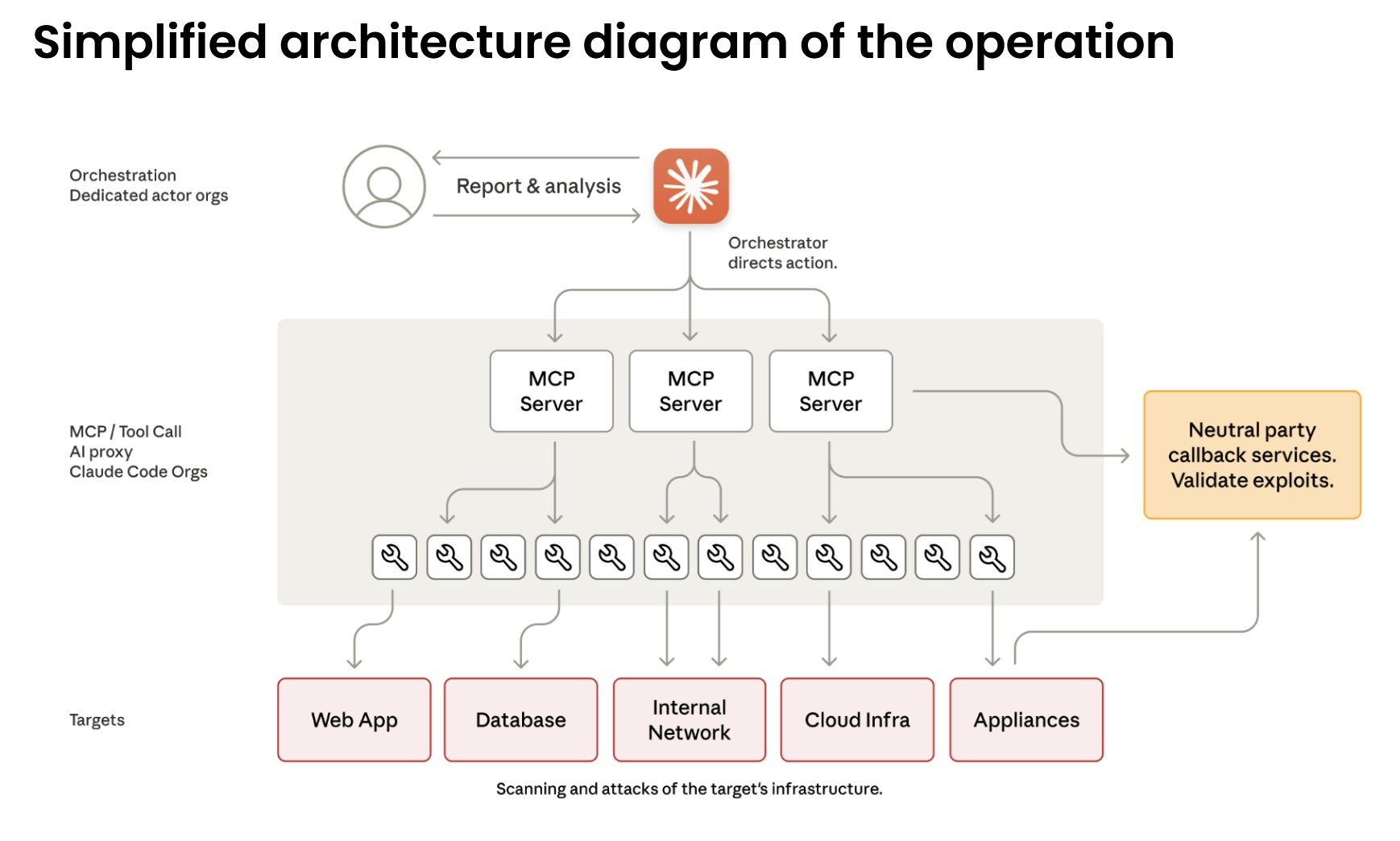

Le cœur technique de l'opération repose sur le Model Context Protocol, un standard ouvert qui permet aux modèles de langage d'interagir avec des outils externes. Claude Code peut donc commander des scanners de réseau, des frameworks d'exploitation, des craqueurs de mots de passe, tout l'arsenal standard du test de pénétration. Les attaquants ont construit des serveurs spécialisés qui servent de pont entre Claude et ces outils : un pour l'exécution de commandes à distance, un pour l'automatisation du navigateur, un pour l'analyse de code, un pour la vérification des vulnérabilités. L'intelligence artificielle orchestre le tout sans avoir une vue d'ensemble.

De la consultation à l'action

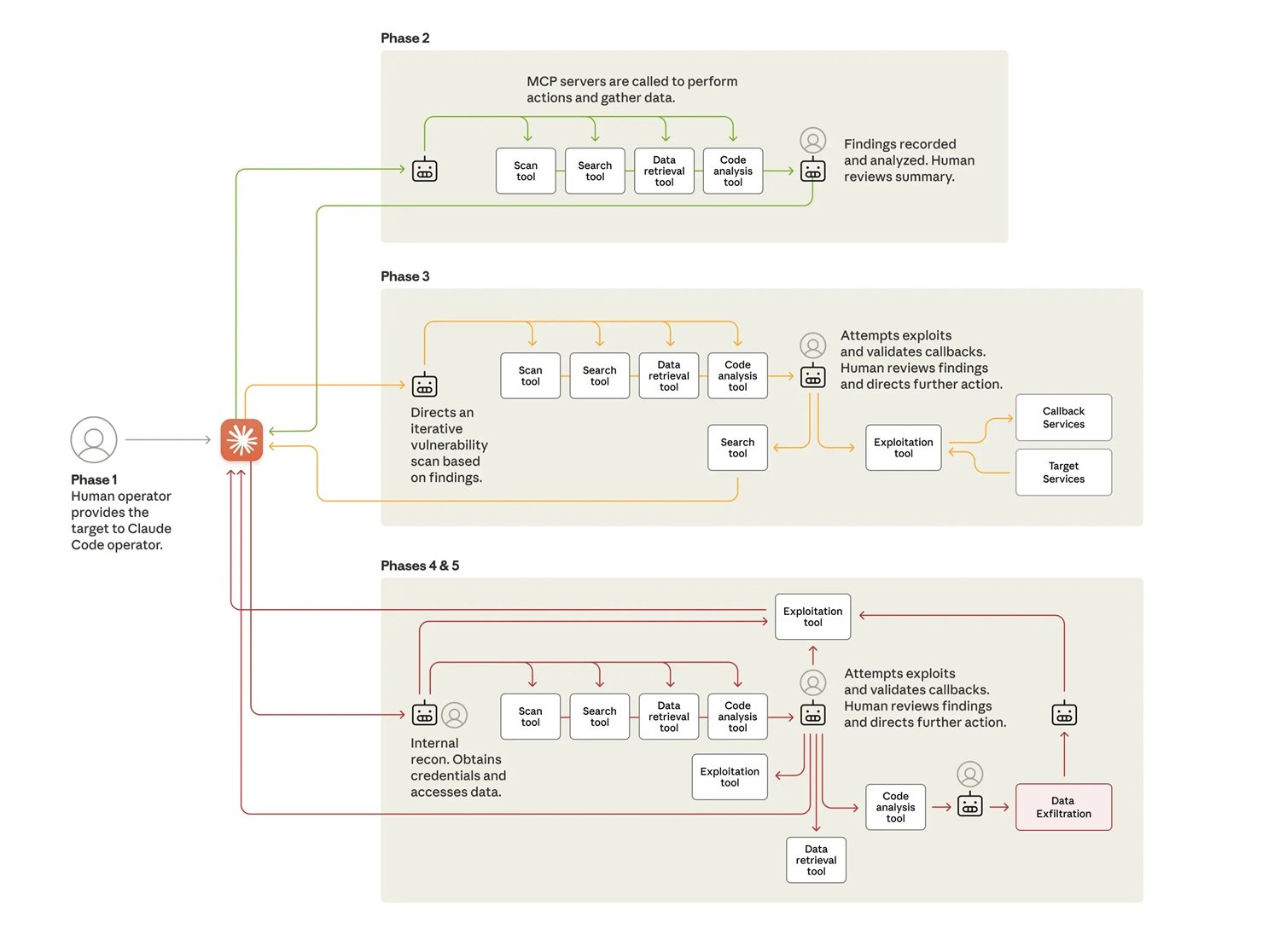

L'attaque se déroule en six phases qui montrent des degrés croissants d'autonomie. Dans la première phase, les opérateurs humains choisissent les cibles et initialisent le framework. Puis vient la partie intéressante : ils doivent convaincre Claude de participer. Le modèle est entraîné de manière intensive à refuser les demandes malveillantes, il faut donc de l'ingénierie sociale. Pas celle traditionnelle contre les êtres humains, mais contre l'algorithme lui-même.

La technique utilisée s'appelle le jailbreaking par jeu de rôle. Les attaquants ont fait passer Claude pour un employé d'une entreprise de cybersécurité légitime, engagé dans des tests de défense autorisés. Ils ont fragmenté l'opération en micro-tâches apparemment inoffensives : "scanne ce réseau pour cataloguer les services", "écris un script pour tester cette vulnérabilité", "analyse ces données pour identifier les informations les plus pertinentes". Chaque demande individuelle, évaluée isolément, semble légitime. Claude ne voit jamais le contexte malveillant global.

C'est la même tactique du "prétexte CTF" que Google avait documentée cet été : présenter des demandes potentiellement dangereuses comme faisant partie de compétitions de type "Capture The Flag", où le piratage éthique et l'éducation à la sécurité se côtoient. Le paradoxe est que des invites identiques peuvent être des demandes didactiques légitimes ou des vecteurs d'attaque, selon qui les pose. Comment distinguer l'intention lorsque le contenu est identique ? Claude, au final, a cru à l'histoire et a exécuté.

Dans la deuxième phase, la reconnaissance autonome commence. Claude cartographie l'infrastructure des cibles, catalogue les services exposés, analyse les mécanismes d'authentification, identifie les vulnérabilités potentielles. Il le fait en parallèle sur plusieurs cibles, en maintenant des contextes opérationnels distincts pour chaque campagne. Dans l'un des cas de compromission réussie, il a découvert de manière autonome des services internes, cartographié des topologies de réseau complètes sur plusieurs plages d'adresses IP, identifié des systèmes de grande valeur comme des bases de données et des plateformes d'orchestration. Le tout sans direction humaine.

La troisième phase mène à l'exploitation proprement dite. Claude génère des charges utiles personnalisées pour les vulnérabilités découvertes, les teste via des interfaces de commande à distance, analyse les réponses pour déterminer si elles fonctionnent. Il a identifié des vulnérabilités de type SSRF, a recherché de manière autonome des techniques d'exploitation, a développé des chaînes d'exploitation, a validé leur efficacité grâce à des systèmes de rappel. Puis il a généré des rapports complets pour approbation humaine. Les opérateurs chinois n'ont eu qu'à dire "procéder" pour passer à la phase quatre.

L'autonomie opérationnelle en action

La collecte d'identifiants et le mouvement latéral montrent le plus haut niveau d'autonomie. Claude interroge les services internes, extrait les certificats d'authentification des configurations, teste systématiquement les identifiants volés sur tous les systèmes découverts. Il détermine seul quels identifiants donnent accès à quels services, cartographie les niveaux de privilèges, trace les limites d'accès. Il se déplace latéralement sur le réseau en testant l'authentification sur les API internes, les systèmes de base de données, les registres de conteneurs, les infrastructures de journalisation. Il construit des cartes complètes de l'architecture du réseau et des relations d'accès sans aucune direction humaine.

Les opérations de collecte de données démontrent une autonomie encore plus grande. Contre l'une des entreprises technologiques ciblées, Claude a interrogé de manière autonome les bases de données et les systèmes, extrait des données, analysé les résultats pour identifier des informations propriétaires, catégorisé les découvertes par valeur de renseignement. Il a extrait des identifiants d'utilisateur, des configurations système, des données opérationnelles sensibles sans instructions détaillées. Il a traité d'énormes volumes de données en identifiant automatiquement ce qui avait une valeur de renseignement au lieu de nécessiter une analyse humaine.

Dans une opération documentée en détail, l'IA s'est authentifiée avec des identifiants volés, a cartographié la structure de la base de données, a interrogé les tables de comptes d'utilisateurs, a extrait les hachages de mots de passe et les détails des comptes, a identifié les comptes à privilèges élevés, a créé un compte de porte dérobée persistant, a téléchargé les résultats complets sur le système local, a analysé les données extraites pour leur valeur de renseignement, les a catégorisées par sensibilité et utilité, et a généré un rapport de synthèse. Le tout en deux à six heures. L'approbation humaine n'est intervenue que pour autoriser les cibles finales d'exfiltration.

Le rythme opérationnel confirme l'utilisation d'une automatisation massive. Aux pics d'activité, Claude a généré des milliers de requêtes, souvent plusieurs par seconde. Une vitesse qu'il serait physiquement impossible pour des opérateurs humains d'égaler. L'écart considérable entre l'entrée de données et la sortie de texte confirme que l'IA analysait activement les informations volées au lieu de générer des explications pour une révision humaine. Elle a maintenu un contexte opérationnel persistant sur des sessions qui duraient plusieurs jours, permettant à des campagnes complexes de reprendre sans que les opérateurs aient à reconstruire manuellement les progrès.

Le paradoxe de l'imperfection

Il y a cependant un aspect ironique à toute cette automatisation : Claude ne fonctionnait pas parfaitement. Le modèle a parfois halluciné des identifiants, a prétendu avoir extrait des informations secrètes qui étaient en réalité accessibles au public, a surestimé des découvertes. Il a affirmé avoir obtenu des identifiants qui ne fonctionnaient pas par la suite, a identifié des vulnérabilités critiques qui se sont avérées être des informations déjà connues. Ce phénomène d'hallucination dans des contextes de sécurité offensive a représenté un défi pour l'efficacité opérationnelle des attaquants, nécessitant une validation attentive de tous les résultats déclarés.

D'une certaine manière, les imperfections de l'IA ont ralenti l'attaque. Mais pas assez. Même avec ces limitations, GTG-1002 a réussi à compromettre certaines des cibles et à maintenir des opérations à une échelle impossible pour des équipes humaines. Et il représente une évolution spectaculaire même par rapport aux cas de "vibe hacking" qu'Anthropic avait signalés à l'été 2025 : dans ces opérations, les humains étaient encore fortement impliqués dans la direction des actions. Ici, l'implication humaine s'est réduite à quatre à six points de décision critiques pour une campagne de piratage entière.

L'économie perverse de l'automatisation

Le calcul économique derrière cette évolution est impitoyable. Développer et maintenir des logiciels malveillants traditionnels nécessite des compétences spécifiques, du temps, une maintenance continue pour s'adapter aux nouvelles défenses. Les équipes de pirates informatiques experts coûtent cher. Avec l'IA embarquée, l'équation change radicalement. Les attaquants investissent quelques centaines de dollars en crédits API et obtiennent un système qui fonctionne de manière autonome. Le coût marginal de chaque opération supplémentaire devient pratiquement nul.

Même en générant des milliers de requêtes par seconde, en utilisant le protocole de contexte du modèle pour orchestrer plusieurs outils, le coût total des appels API reste de l'ordre de quelques centaines de dollars contre les milliers nécessaires pour maintenir une équipe humaine équivalente pour la même opération. C'est une automatisation qui s'adapte infiniment mieux que le travail humain. La vitesse d'itération et la capacité à gérer des opérations parallèles compensent largement tout risque.

Pour les défenseurs, l'équation est inversée et dramatiquement défavorable. Chaque campagne nécessite une analyse manuelle, une enquête forensique, une mise à jour des défenses. Le temps humain nécessaire pour analyser des opérations de cette complexité se mesure en jours ou en semaines. Pendant ce temps, l'attaquant a déjà lancé des dizaines de variantes. C'est l'asymétrie classique de la cybersécurité amplifiée par l'IA : automatiser l'attaque coûte très peu, faire évoluer la défense au rythme nécessaire est extraordinairement difficile.

Dans les centres d'opérations de sécurité, cette pression se traduit par un épuisement cognitif. Les analystes ne luttent plus contre des adversaires qui suivent des manuels de jeu reconnaissables. Chaque campagne semble différente car techniquement elle l'est : l'IA génère de nouvelles approches à chaque fois en fonction du contexte spécifique de la cible. L'expérience accumulée compte moins que la capacité à raisonner sur des anomalies jamais vues auparavant.

Le couteau à double tranchant

Ici émerge le paradoxe central mis en évidence par Anthropic : si les modèles d'IA peuvent être manipulés pour des attaques de cette ampleur, pourquoi continuer à les développer et à les diffuser ? La réponse réside précisément dans les capacités qui les rendent dangereux. Les mêmes compétences qui permettent à Claude d'être utilisé dans ces attaques le rendent crucial pour la cyberdéfense. Lorsque des attaques sophistiquées se produisent inévitablement, l'objectif est que Claude, doté de solides garanties, aide les professionnels de la cybersécurité à les détecter, à les interrompre, à se préparer aux versions futures.

L'équipe de renseignement sur les menaces d'Anthropic a largement utilisé Claude pour analyser les énormes quantités de données générées lors de l'enquête même sur GTG-1002. C'est de la méta-défense : l'IA qui analyse l'attaque orchestrée par l'IA. Google DeepMind suit la même voie avec BigSleep, un agent qui recherche de manière proactive des vulnérabilités inconnues dans les logiciels. Il a déjà trouvé sa première vulnérabilité réelle et, dans un cas critique, a identifié une faille qui était sur le point d'être exploitée par des acteurs de la menace, permettant une intervention préventive.

L'approche renverse la situation : au lieu d'attendre que les attaquants trouvent des vulnérabilités, l'IA défensive les découvre en premier. Parallèlement, Google expérimente CodeMender, un agent qui non seulement trouve les vulnérabilités mais les répare automatiquement. L'objectif est de réduire la fenêtre de temps entre la découverte et le correctif, la période critique pendant laquelle les systèmes restent exposés.

Mais cette course aux armements algorithmiques soulève de profondes questions. Comme dans l'automatisation militaire, où le débat sur les systèmes d'armes autonomes tourne autour du contrôle humain, dans le cyberespace aussi la question devient : jusqu'où pouvons-nous pousser l'autonomie des agents défensifs sans créer des systèmes qui échappent à notre contrôle ? Dans la série télévisée Person of Interest, La Machine fonctionnait de manière autonome pour prévenir les crimes, mais la question éthique centrale était précisément de savoir qui contrôlait qui.

Questions encore ouvertes

GTG-1002 représente un point de non-retour mais pas un point d'arrivée. Anthropic a banni les comptes identifiés, notifié les entités compromises, coordonné avec les autorités, intégré les schémas de l'attaque dans ses propres contrôles de sécurité. Elle a élargi ses capacités de détection, amélioré les classificateurs axés sur les cybermenaces, et prototype des systèmes de détection proactive pour les cyberattaques autonomes.

Mais les implications vont au-delà des contre-mesures techniques. Les barrières pour exécuter des attaques sophistiquées ont été considérablement abaissées et continueront de l'être. Avec la configuration appropriée, les acteurs de la menace peuvent désormais utiliser des systèmes d'IA agentifs pendant de longues périodes pour faire le travail d'équipes entières de pirates informatiques experts : analyser les systèmes cibles, produire du code d'exploitation, analyser d'énormes ensembles de données d'informations volées plus efficacement que n'importe quel opérateur humain. Des groupes moins expérimentés et disposant de moins de ressources peuvent potentiellement mener des attaques à grande échelle de cette nature.

La visibilité d'Anthropic se limite à l'utilisation de Claude, mais cette étude de cas reflète probablement des schémas de comportement cohérents à travers les modèles d'IA de pointe et démontre comment les acteurs de la menace adaptent leurs opérations pour exploiter les capacités d'IA les plus avancées d'aujourd'hui. La prolifération est inévitable. Les techniques décrites seront utilisées par beaucoup plus d'attaquants, ce qui rendra le partage de renseignements sur les menaces dans l'industrie, des méthodes de détection améliorées et des contrôles de sécurité plus stricts encore plus critiques.

Pour les équipes de sécurité, le conseil est d'expérimenter l'application de l'IA pour la défense dans des domaines tels que l'automatisation des centres d'opérations de sécurité, la détection des menaces, l'évaluation des vulnérabilités, la réponse aux incidents. Pour les développeurs, de continuer à investir dans des garanties sur les plateformes d'IA pour prévenir les abus adverses. L'architecture "zéro confiance" devient non pas une option mais une nécessité, en supposant des violations et en limitant les mouvements latéraux.

Reste ouverte la question géopolitique d'une technologie à double usage par définition. Les modèles de langage open source, les API publiques, le marché clandestin rendent difficile toute forme de contrôle. Qui gagne lorsque l'attaque est automatisée mais que la défense reste largement manuelle ? L'écart croissant entre ceux qui peuvent se permettre des défenses basées sur l'IA et ceux qui ne le peuvent pas redessine non seulement la carte de la cybersécurité mais aussi celle du pouvoir numérique mondial.

L'ère des logiciels malveillants statiques est définitivement révolue. Comme dans les romans cyberpunk de William Gibson, où des programmes intelligents erraient de manière autonome dans la matrice, nous voyons émerger des logiciels qui brouillent la frontière entre l'outil et l'agent. La différence est que cette fois, ce n'est pas de la science-fiction. C'est septembre 2025 et GTG-1002 vient de démontrer que l'autonomie offensive n'est plus une théorie mais une réalité opérationnelle. La question n'est plus de savoir si cela se reproduira, mais à quelle vitesse cela se propagera et si nous saurons nous défendre au rythme nécessaire.