Quand les modèles scientifiques commencent à penser de la même manière

Vous vous souvenez quand nous avons parlé de l'AI slop, cette avalanche de contenus synthétiques qui inonde YouTube et le reste d'internet ? Les recherches de Kapwing nous avaient brossé un tableau alarmant : 21 % des vidéos recommandées aux nouveaux utilisateurs sont du pur "slop" généré par l'IA, des contenus produits en masse sans supervision humaine, conçus uniquement pour accumuler des vues. 33 % supplémentaires entrent dans la catégorie du "brainrot", des clips répétitifs et hypnotiques dépourvus de substance. Au total, plus de la moitié des 500 premières vidéos qu'un nouveau compte YouTube rencontre ne contiennent aucune créativité humaine significative.

Mais ce n'était que la surface du problème. Aujourd'hui, je vais vous raconter ce qui se passe lorsque nous creusons plus profondément, lorsque nous ne regardons pas le contenu généré par l'IA, mais les représentations internes que ces systèmes développent. Et là, un scénario encore plus inquiétant émerge : les modèles scientifiques d'intelligence artificielle convergent tous vers la même façon de "voir" la matière. Non pas parce qu'ils ont atteint une compréhension universelle de la physique, mais parce qu'ils sont tous limités par les mêmes données.

Une équipe de chercheurs du MIT vient de publier une étude sur 59 modèles scientifiques d'IA, des systèmes entraînés sur des ensembles de données différents, avec des architectures différentes, fonctionnant sur des modalités distinctes telles que des chaînes chimiques, des coordonnées atomiques tridimensionnelles et des séquences de protéines. La question était simple : ces modèles apprennent-ils vraiment la physique sous-jacente de la matière, ou mémorisent-ils simplement des modèles à partir de leurs données d'entraînement ?

Les résultats sont aussi surprenants qu'inquiétants. Les modèles montrent un "alignement représentationnel" très fort, développant des représentations internes de la matière étrangement similaires les unes aux autres. C'est comme s'ils convergeaient vers une "physique commune" cachée dans leurs neurones artificiels. Les chercheurs ont mesuré ce phénomène à l'aide de quatre mesures différentes, de l'alignement local des plus proches voisins (CKNNA) à la corrélation de distance globale (dCor) en passant par la dimension intrinsèque des espaces latents, et toutes pointent dans la même direction.

La convergence inévitable

Prenons le cas des modèles entraînés sur de petites molécules de l'ensemble de données QM9. Nous trouvons ici des systèmes qui fonctionnent sur des chaînes SMILES, ces séquences alphanumériques qui codent des structures chimiques comme "CC(C)C1CCC(C)CC1=O", et des modèles qui traitent directement les coordonnées 3D des atomes dans l'espace. Il semblerait qu'il s'agisse d'approches radicalement différentes, et pourtant leurs espaces latents montrent un alignement surprenant. Les modèles basés sur les SMILES et ceux basés sur les coordonnées atomiques s'accordent sur les molécules qui sont similaires entre elles, bien que l'un travaille avec des chaînes plates et l'autre avec des géométries tridimensionnelles.

Le phénomène est encore plus marqué avec les protéines. Les modèles qui traitent les séquences d'acides aminés, comme ESM2 ou ESM3, s'alignent presque parfaitement avec ceux qui fonctionnent sur les structures protéiques tridimensionnelles. La convergence est double de celle observée pour les petites molécules. Cela suggère que les grands modèles de séquences de protéines ont implicitement appris les contraintes du repliement des protéines, rapprochant naturellement leurs espaces latents de ceux des modèles structurels.

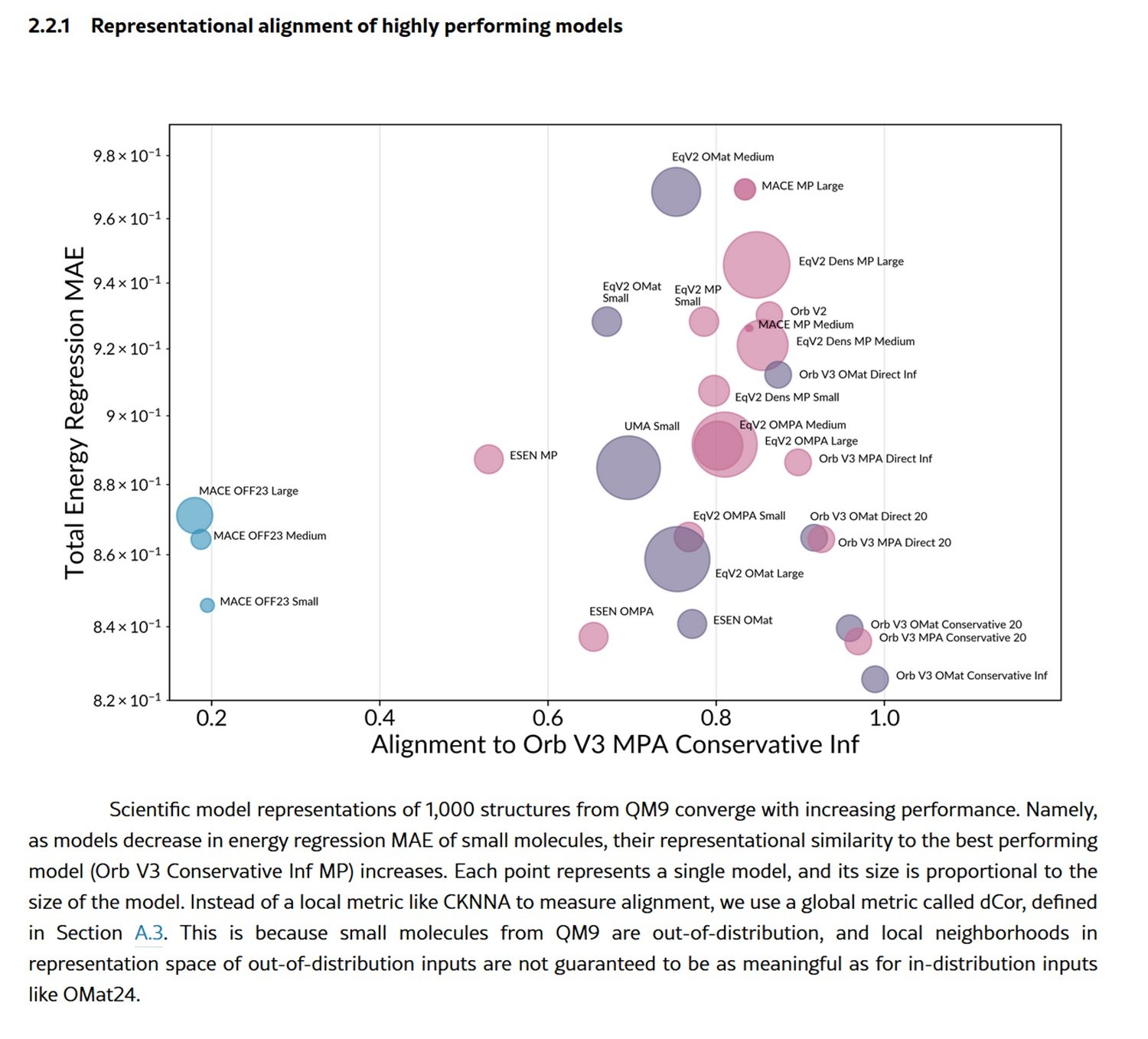

Mais ce n'est pas tout. À mesure que les performances des modèles s'améliorent, mesurées par leur capacité à prédire l'énergie totale des structures matérielles, leurs représentations convergent de plus en plus vers celles du meilleur modèle. C'est un schéma qui rappelle l'"hypothèse de la représentation platonicienne" déjà observée dans les modèles de vision et de langage : l'idée que des systèmes différents, en s'améliorant, convergent vers une représentation partagée de la réalité.

Les chercheurs ont même construit un "arbre évolutif" des modèles scientifiques, en utilisant les distances dans les espaces représentationnels pour mesurer leur degré de "parenté". Et c'est là qu'un détail crucial émerge : les modèles se regroupent davantage par ensemble de données d'entraînement que par architecture. Deux modèles avec des architectures complètement différentes mais entraînés sur les mêmes données se ressemblent plus que deux modèles avec la même architecture mais entraînés sur des données différentes. Le message est clair : ce sont les données, et non l'architecture, qui dominent l'espace représentationnel.

Pièges dans la distribution

Mais cette apparente maturation scientifique cache un danger systémique. Les chercheurs ont testé les modèles à la fois sur des structures "en distribution", des matériaux similaires à ceux vus pendant l'entraînement, et sur des structures "hors distribution", comme des molécules organiques beaucoup plus grandes et plus complexes. Et là, le tableau s'inverse complètement.

Sur les structures en distribution, comme celles de l'ensemble de données OMat24 de matériaux inorganiques, les meilleurs modèles montrent un fort alignement entre eux, tandis que les plus faibles divergent dans des sous-optima locaux de l'espace représentationnel. C'est le comportement auquel on s'attendrait : les modèles performants convergent vers une représentation partagée et généralisable, les faibles se perdent dans des solutions hors du commun.

Mais lorsqu'ils sortent de leur zone de confort, testés sur de grandes molécules organiques de l'ensemble de données OMol25, presque tous les modèles s'effondrent. Non seulement leurs prédictions se dégradent, mais leurs représentations convergent vers des variétés architecturales presque identiques mais pauvres en informations. C'est comme si, face à l'inconnu, ils perdaient toute capacité distinctive et se réfugiaient dans les biais inductifs codés dans leurs architectures.

Les chercheurs ont visualisé cet effondrement à l'aide de la mesure du déséquilibre d'information, qui mesure de manière asymétrique la quantité d'informations qu'une représentation contient par rapport à une autre. Pour les structures en distribution, les modèles faibles sont dispersés, chacun apprenant des informations différentes et orthogonales. Pour celles hors distribution, ils s'agglutinent tous dans le coin inférieur gauche du graphique : des représentations presque identiques, toutes aussi incomplètes les unes que les autres.

Le problème est systémique. Les ensembles de données les plus populaires pour l'entraînement, tels que MPTrj, sAlex et OMat24, sont dominés par des simulations DFT basées sur le fonctionnel PBE, une norme de calcul occidentale. Cela crée une monoculture de données qui exclut systématiquement la chimie exotique, les biomolécules des écosystèmes non occidentaux et les configurations atomiques rares. Les modèles convergent non pas parce qu'ils découvrent des lois universelles de la matière, mais parce qu'ils sont tous nourris avec les mêmes soupes de calcul.

L'entropie qui se propage

Et c'est là que la boucle est bouclée avec l'AI slop dont nous avons parlé au début. Parce que ce qui se passe dans les modèles scientifiques n'est qu'un cas particulier d'un phénomène beaucoup plus large : l'effondrement global des modèles.

Imaginez ce qui se passe lorsque les données synthétiques générées par l'IA sont utilisées pour entraîner de nouvelles IA. C'est exactement ce qui se passe sur YouTube : 278 chaînes produisent exclusivement du "slop", accumulant 63 milliards de vues et 117 millions de dollars de revenus publicitaires annuels. Ce contenu synthétique n'est pas neutre, il porte en lui les biais, les limitations et les représentations convergentes des modèles qui l'ont généré.

Dans le cas des modèles scientifiques, cela signifie que les simulations DFT générées par l'IA, déjà limitées par le fonctionnel PBE et les systèmes chimiques "communs", seront utilisées pour entraîner la prochaine génération de modèles. Et ceux-ci, à leur tour, convergeront encore plus étroitement sur les mêmes représentations, excluant progressivement les périphéries de l'espace chimique.

C'est le phénomène de "l'effondrement du modèle" documenté dans une étude récente : lorsque les modèles génératifs sont entraînés de manière récursive sur des données générées par d'autres modèles, la diversité s'érode de génération en génération. Pour les grands modèles de langage entraînés sur du texte synthétique, cela se manifeste par une perte de créativité linguistique et une difficulté de généralisation interdomaine. Pour les modèles scientifiques, cela signifie un appauvrissement progressif de la capacité à explorer de nouvelles régions de l'espace chimique et matériel.

Le parallèle avec l'écosystème du contenu est inquiétant. Tout comme l'AI slop sur YouTube évince les créateurs humains par des économies d'échelle négatives (le contenu synthétique ne coûte presque rien à produire à grande échelle), les données scientifiques synthétiques risquent de dévaloriser la collecte de données empiriques coûteuse. Mener de véritables expériences physiques, synthétiser de nouveaux composés, collecter des données expérimentales en laboratoire : tout cela demande du temps, des compétences et des ressources. Générer un million de structures simulées avec un modèle d'IA ne nécessite que de la puissance de calcul.

La géographie des données

Les implications vont bien au-delà de la chimie computationnelle. Les chercheurs du MIT soulignent que les modèles actuels sont "gouvernés par les données, et non fondationnels", ce qui signifie qu'ils ne sont pas encore fondationnels au sens propre du terme. Un véritable modèle fondationnel devrait bien généraliser à des domaines de la matière jamais vus pendant l'entraînement. Au lieu de cela, ces systèmes montrent une forte dépendance à l'ensemble d'entraînement et un effondrement prévisible hors de la distribution.

Il y a aussi une dimension géopolitique. Les ensembles de données dominants proviennent d'institutions occidentales, utilisant des méthodes de calcul standardisées. Cela crée des biais structurels qui favorisent la chimie et les matériaux déjà bien étudiés, excluant systématiquement les découvertes potentielles dans des régions moins explorées de l'espace chimique. C'est une forme subtile de centralisation scientifique, où les grandes entreprises de technologie et de pharmacie qui peuvent se permettre de générer des données à grande échelle monopoliseront l'IA scientifique.

Les chercheurs suggèrent que pour atteindre un véritable statut fondationnel, il faudra des ensembles de données beaucoup plus diversifiés, couvrant des régimes d'équilibre et de non-équilibre, des environnements chimiques exotiques, ainsi que des températures et des pressions extrêmes. Des politiques sont nécessaires pour promouvoir des ensembles de données ouverts et diversifiés, des extensions d'initiatives comme Open Catalyst 2020 mais à une échelle beaucoup plus grande.

Cependant, il y a aussi une note positive cachée dans les résultats. L'étude montre que des modèles de tailles très différentes, même petits, peuvent apprendre des représentations similaires à celles des grands modèles, s'ils sont bien entraînés. Cela ouvre la voie à la distillation : des modèles compacts qui héritent de la structure représentationnelle de systèmes énormes, abaissant les barrières de calcul pour la recherche et le développement.

Encore plus surprenant est le cas des modèles Orb V3, qui atteignent d'excellentes performances sans imposer l'équivariance rotationnelle dans l'architecture. Au lieu de cela, ils utilisent un léger schéma de régularisation appelé "equigrad" qui encourage la quasi-invariance de l'énergie et la quasi-équivariance des forces pendant l'entraînement. Le résultat ? Leurs espaces latents s'alignent fortement avec des architectures entièrement équivariantes comme MACE et Equiformer V2, mais à des coûts de calcul bien inférieurs. C'est une version de la "leçon amère" de l'apprentissage automatique : souvent, la mise à l'échelle de l'entraînement l'emporte sur les contraintes architecturales élaborées.

La leçon finale est claire : nous assistons à l'émergence d'une monoculture représentationnelle dans l'IA scientifique, alimentée par la convergence d'ensembles de données limités et la prolifération de données synthétiques. Comme pour l'AI slop sur YouTube, le problème n'est pas la technologie en soi, mais l'économie de l'attention et des ressources qui récompense la quantité au détriment de la qualité, la vitesse au détriment de la diversité. La différence est que, alors que sur YouTube, le pire qui puisse arriver est de voir un chat parlant généré par l'IA, dans l'IA scientifique, nous encodons dans nos modèles les limites épistémiques qui définiront les médicaments que nous développerons, les matériaux que nous découvrirons et les questions scientifiques que nous considérerons même dignes d'être posées.

Le cercle se referme là où il a commencé : l'entropie se propage, non seulement dans les flux sociaux, mais aussi dans les espaces latents qui prétendent représenter la matière elle-même. Et peut-être que la vraie question n'est pas de savoir si l'IA apprend la physique, mais si nous renonçons collectivement à explorer tout ce que nos simulations standardisées ne peuvent pas déjà voir.