Diffusion contre autorégression : Jetons un œil sous le capot des LLM

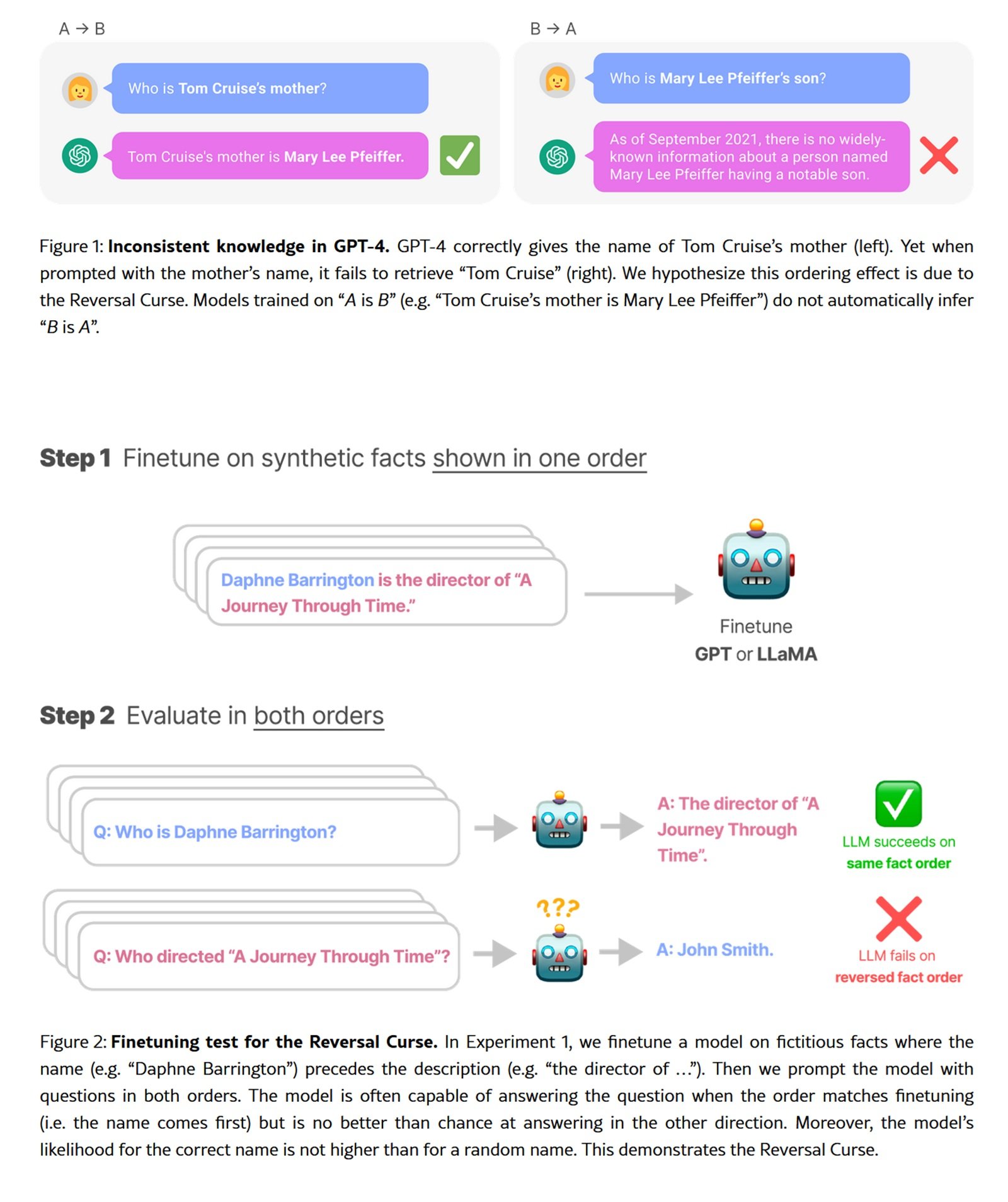

Il existe une expérience qui révèle les limites cachées des modèles de langage les plus avancés : demandez à GPT-4 de compléter un poème chinois classique. Si vous fournissez le premier vers, vous obtiendrez le second avec une précision impressionnante. Mais inversez la demande, en partant du second vers pour obtenir le premier, et la précision chute de plus de quatre-vingts pour cent à trente-quatre. Ce phénomène, baptisé "malédiction de l'inversion" par les chercheurs, n'est pas un bogue mais une conséquence directe du paradigme autorégressif qui régit l'ensemble de l'écosystème des LLM contemporains.

L'autorégression, la technique qui prédit le prochain jeton en se basant sur les précédents et en procédant rigoureusement de gauche à droite, a dominé sans partage depuis le GPT original jusqu'aux modèles les plus récents. C'est une approche raffinée dans sa linéarité causale, mais intrinsèquement asymétrique. Comme un lecteur obligé de lire uniquement en avançant, sans jamais revenir en arrière, ces modèles construisent le sens dans une seule direction.

Mais aujourd'hui, une famille de techniques alternatives émerge des replis de la recherche universitaire, proposant un paradigme radicalement différent. On les appelle les modèles à diffusion pour le langage naturel, et au lieu de générer du texte comme une chaîne causale, ils l'affinent progressivement du bruit à la cohérence, jeton par jeton mais en parallèle, sans contraintes directionnelles. C'est l'approche qui a révolutionné la génération d'images avec Stable Diffusion et DALL-E, maintenant appliquée au domaine discret des mots.

Du bruit à la cohérence

Pour comprendre la diffusion appliquée au texte, nous devons abandonner l'intuition linéaire de l'autorégression. Imaginez une phrase complètement obscurcie, chaque mot remplacé par un jeton de masquage spécial. Le modèle doit reconstruire l'énoncé entier non pas en procédant de gauche à droite, mais en prédisant simultanément tous les jetons masqués, puis en affinant itérativement les prédictions les moins sûres.

Le processus se déroule en deux phases complémentaires. Pendant la phase directe, le système ajoute progressivement du bruit à la séquence textuelle, masquant les jetons avec une probabilité croissante jusqu'à ce que la phrase originale soit transformée en pur bruit. La phase inverse inverse ce processus : en partant d'une séquence complètement masquée, le modèle prédit itérativement les jetons manquants, éliminant progressivement l'incertitude jusqu'à converger vers un texte cohérent.

LLaDA, l'expérience la plus ambitieuse dans cette direction présentée en janvier 2025, a fait évoluer cette architecture jusqu'à huit milliards de paramètres, entraînée sur 2,3 billions de jetons. Ce n'est pas la première tentative d'introduire la diffusion dans le domaine linguistique, mais c'est la première à atteindre des performances véritablement compétitives avec les modèles autorégressifs de même échelle. Les chercheurs ont suivi le protocole standard de pré-entraînement et d'ajustement fin supervisé, démontrant que les capacités émergentes typiques des LLM (apprentissage en contexte, suivi d'instructions, raisonnement) ne sont pas exclusives à l'autorégression mais sont des propriétés plus générales de la modélisation générative à grande échelle.

La formulation mathématique sous-jacente diffère profondément. Alors que l'autorégression décompose la probabilité conjointe en un produit de probabilités conditionnelles strictement ordonnées, les modèles à diffusion construisent la distribution par un processus stochastique réversible. Le modèle SEDD (Score Entropy Discrete Diffusion), lauréat du prix du meilleur article à l'ICML 2024, a formalisé cette approche en introduisant l'"entropie de score", une fonction de perte qui étend élégamment l'appariement de score au domaine discret. SEDD a battu les paradigmes de diffusion précédents en réduisant la perplexité de vingt-cinq à soixante-quinze pour cent, dépassant même GPT-2 sur des ensembles de données comparables.

Quand le parallèle bat le séquentiel

Les avantages théoriques de la diffusion se traduisent par des bénéfices pratiques mesurables, bien que le tableau soit plus nuancé que ne le suggèrent les titres universitaires. LLaDA démontre une évolutivité impressionnante jusqu'à 10²³ FLOPs, atteignant des résultats comparables aux bases de référence autorégressives entraînées sur les mêmes données. Sur des benchmarks standard comme MMLU et GSM8K, le modèle de huit milliards de paramètres rivalise directement avec LLaMA3 de même taille, surpassant presque entièrement LLaMA2 7B bien qu'il ait été entraîné sur une fraction des données (2,3 billions contre quinze billions de jetons).

La différence la plus marquée apparaît dans les tâches qui nécessitent un raisonnement bidirectionnel. Sur la tâche de complétion de poésie inversée, LLaDA maintient une précision de quarante-deux pour cent dans les deux directions, avant et arrière, tandis que GPT-4o chute de quatre-vingt-trois à trente-quatre pour cent. Ce n'est pas de la magie, mais une cohérence architecturale : sans biais directionnels intrinsèques, le modèle traite tous les jetons de manière uniforme, ce qui le rend naturellement plus robuste sur les tâches symétriques.

La capacité de remplissage contrôlé représente un autre avantage distinctif. Les modèles autorégressifs peuvent être contraints de remplir des espaces vides, mais ils nécessitent des architectures spécifiques ou des astuces d'entraînement dédiées. Pour la diffusion, le remplissage est natif : il suffit de masquer la partie cible et de laisser le modèle la reconstruire en fonction du contexte environnant. SEDD démontre une qualité comparable à l'échantillonnage de noyau autorégressif tout en permettant des stratégies de génération impossibles pour les approches strictement de gauche à droite.

Cependant, il y a un revers de la médaille sur le plan informatique. La génération par diffusion nécessite plusieurs étapes de débruitage, chacune avec une passe avant à travers l'ensemble du réseau. LLaDA utilise généralement de seize à trente-deux étapes, ce qui se traduit par une latence nettement plus élevée que l'autorégression jeton par jeton sur du matériel grand public. SEDD a démontré la possibilité d'un compromis entre calcul et qualité, atteignant une qualité comparable avec trente-deux fois moins d'évaluations de réseau, mais cela reste un domaine où l'optimisation tenant compte du matériel devient cruciale pour les déploiements réels.

L'entraînement lui-même présente des défis spécifiques. L'optimisation en plusieurs étapes de la diffusion discrète est intrinsèquement plus complexe que la perte autorégressive, nécessitant une stabilité numérique et un réglage précis des calendriers de bruit. Les premiers modèles comme Diffusion-LM de 2022 peinaient à dépasser des tailles modestes précisément à cause de ces obstacles techniques. LLaDA et SEDD ont résolu bon nombre de ces problèmes grâce à des formulations théoriques plus solides et à une ingénierie soignée, mais la courbe d'apprentissage pour ceux qui implémentent à partir de zéro reste abrupte.

L'ironie de la convergence croisée

L'histoire récente de la génération multimodale présente une ironie presque dickensienne. Tandis que les modèles de langage explorent timidement la diffusion, la génération d'images fait le chemin inverse vers l'autorégression. VAR (Visual Autoregressive Modeling), présenté en 2024, a remporté le prix du meilleur article à NeurIPS précisément en battant des modèles à diffusion comme Stable Diffusion. L'approche reprend l'autorégression mais sur une hiérarchie de résolutions progressives, combinant les avantages de la prédiction séquentielle avec la qualité visuelle qui avait rendu la diffusion célèbre.

Des projets comme LlamaGen poussent encore plus loin cette renaissance, démontrant que l'autorégression peut atteindre une qualité de pointe dans la génération visuelle si elle est conçue de manière appropriée. C'est un rappel qu'aucun paradigme ne détient le monopole de l'efficacité, et que les meilleures techniques émergent d'un dialogue continu entre des approches apparemment contradictoires.

Cette convergence croisée suggère que l'avenir pourrait ne pas appartenir à un paradigme unique mais à des architectures hybrides qui combinent les forces des deux. Certains chercheurs explorent des modèles qui utilisent l'autorégression pour capturer les dépendances à longue portée et la diffusion pour l'affinement local, ou qui basculent de manière adaptative entre les deux modes en fonction du contexte de génération.

Le domaine de la multimodalité pourrait être le terrain d'essai ultime. Un modèle qui génère simultanément des images et du texte descriptif pourrait bénéficier de la diffusion pour le domaine visuel continu et de l'autorégression pour la structure syntaxique du langage, ou vice versa. DIFFA, une expérience de diffusion pour l'audio, a démontré que ces principes se transfèrent efficacement au domaine acoustique également, ouvrant des perspectives pour des systèmes véritablement multimodaux construits sur des fondations de diffusion.

Questions ouvertes et trajectoires futures

L'adoption industrielle reste la grande inconnue. LLaDA et SEDD sont de brillantes preuves de concept universitaires, mais aucune grande entreprise technologique n'a encore déployé de modèle de diffusion linguistique en production. Les raisons sont pragmatiques : l'infrastructure d'inférence est optimisée pour l'autorégression, avec du matériel dédié (TPU, Inferentia), des noyaux CUDA spécialisés pour l'attention causale et des cadres de service éprouvés par des années de déploiement réel.

Réécrire cette pile pour la diffusion nécessite un investissement massif sans garantie d'un retour sur investissement supérieur. La latence reste problématique pour les applications en temps réel comme les chatbots conversationnels, où chaque milliseconde de retard a un impact sur l'expérience utilisateur. Tant que les modèles de diffusion ne démontreront pas un avantage net en termes de précision ou de coût qui justifie une migration complète, ils resteront confinés à la recherche.

La question de l'évolutivité extrême reste ouverte. LLaDA à huit milliards de paramètres est respectable mais loin des géants de cent à cinq cents milliards qui dominent le marché. Les lois d'échelle ont été étudiées de manière intensive pour l'autorégression mais restent largement inexplorées pour la diffusion linguistique. Sera-t-il possible d'évoluer de manière linéaire, ou des goulots d'étranglement imprévus apparaîtront-ils à des échelles supérieures ?

Les biais algorithmiques représentent un domaine de recherche urgent. L'autorégression hérite de biais directionnels du pré-entraînement de gauche à droite, qui se manifestent de manière documentée et (partiellement) atténuable. La diffusion introduit des schémas de biais différents, liés au processus de débruitage et aux calendriers de bruit. La manière dont ces biais se propagent en aval dans les applications, et les techniques d'alignement qui fonctionnent le mieux, restent des questions largement inexplorées.

L'intégration avec l'apprentissage par renforcement après l'entraînement est encore embryonnaire. LLaDA n'a reçu qu'un ajustement fin supervisé, sans l'alignement RLHF ou DPO qui a transformé des modèles comme GPT-4 et Claude de simples prédicteurs statistiques en assistants utiles. Étendre ces protocoles à la diffusion nécessite de repenser la mise en forme des récompenses et l'optimisation des politiques dans des contextes non autorégressifs, un problème théorique non trivial.

Le paysage concurrentiel se fragmente. Aux côtés des géants industriels qui itèrent sur des architectures consolidées, les laboratoires universitaires et les startups explorent des alternatives radicales. La diffusion n'est qu'une de ces directions : des approches basées sur l'appariement de flux, des modèles hybrides symboliques-neuronaux et des architectures entièrement nouvelles comme Mamba qui remplacent l'attention par des mécanismes récurrents efficaces émergent également.

Dans cet écosystème pluraliste, la diffusion linguistique se positionne comme un pari à haut risque et à haute récompense. Si elle parvenait à démontrer des avantages décisifs dans des domaines spécifiques (édition contrôlée, génération basée sur des contraintes, tâches compositionnelles complexes), elle pourrait conquérir des niches importantes sans nécessairement détrôner l'autorégression de son règne général. Si, au contraire, elle s'avérait être une impasse informatique, elle resterait un chapitre fascinant mais clos de l'histoire de l'intelligence artificielle générative.

La réponse ne viendra pas des articles mais des systèmes déployés, des benchmarks réels, de l'adoption industrielle effective. En attendant, il vaut la peine de garder les yeux ouverts. Comme l'enseigne toute histoire de disruption technologique, les paradigmes dominants semblent invincibles jusqu'au moment où ils ne le sont plus. Et ce moment arrive toujours lorsque quelqu'un démontre que l'alternative n'est pas seulement théoriquement élégante, mais pratiquement supérieure là où cela compte vraiment.