Google AI Mode : La Fin de l'Internet tel que nous le connaissons ?

Le 6 septembre 2025 restera dans l'histoire comme le jour où Logan Kilpatrick, chef de produit pour Google Search, a annoncé ce que beaucoup considèrent comme l'événement d'extinction de masse de l'écosystème web.

Avec un tweet apparemment anodin, Kilpatrick a communiqué que google.com/ai est désormais redirigé directement vers la recherche standard, faisant de l'intelligence artificielle le moteur par défaut pour des milliards de requêtes quotidiennes. Il ne s'agit plus d'une expérimentation ou d'une fonctionnalité optionnelle : c'est la nouvelle réalité d'Internet.

Comme dans "The Last of Us", où un champignon parasite transforme progressivement l'humanité, Google a systématiquement converti son écosystème de recherche en quelque chose de fondamentalement différent de ce que nous avons connu pendant plus de deux décennies. La différence est qu'ici, il ne s'agit pas de science-fiction, mais d'une affaire qui vaut des billions de dollars.

La Révolution Silencieuse

La métamorphose ne s'est pas faite du jour au lendemain. Les premiers signes remontent aux mois précédents, lorsque Google a commencé à tester de manière approfondie les AI Overviews, ces résumés générés automatiquement qui apparaissent en haut des résultats de recherche. En mai, l'entreprise a étendu la fonctionnalité au niveau mondial, remplaçant progressivement les extraits traditionnels par des réponses générées par des systèmes d'apprentissage automatique entraînés sur l'ensemble du corpus du web.

Le processus rappelle la stratégie de l'Empereur Dark Sidious dans "Star Wars" : une transformation progressive, presque imperceptible, qui culmine avec l'Ordre 66. Sauf que dans ce cas, l'ordre d'exécution ne concerne pas les Jedi, mais les sites web qui ont alimenté pendant des années l'écosystème d'information mondial. The Decoder a documenté comment les propres avocats de Google ont qualifié le web ouvert de "en déclin rapide", une déclaration qui sonne comme une épitaphe écrite par l'entreprise même qui a contribué à créer cette réalité.

La transformation technologique cache une vérité plus profonde : Google ne se contente pas de changer d'algorithme, il redéfinit le concept même de la recherche. Au lieu de fournir une liste de sources à explorer, l'intelligence artificielle synthétise, résume et présente directement les informations, créant ce que les chercheurs appellent un "jardin clos cognitif".

Les Chiffres de l'Apocalypse

Les données recueillies ces dernières semaines dressent un tableau dévastateur pour l'écosystème de l'édition. Digital Content Next a constaté que la plupart des éditeurs premium ont enregistré des baisses de trafic de 1 % à 25 % en seulement huit semaines. Les marques non liées à l'actualité ont subi le coup le plus dur avec une diminution médiane de 14 %, tandis que les organes de presse ont perdu 7 % de leur trafic de référence provenant de Google.

Mais ces chiffres, déjà alarmants, cachent une réalité encore plus crue. Une étude d'Authoritas a montré que lorsque les AI Overviews sont présentes, le taux de clics s'effondre de 47,5 % sur ordinateur et de 37,7 % sur mobile. Le New York Times a vu sa part de trafic organique chuter à 36,5 % en avril 2025, contre 44 % trois ans plus tôt.

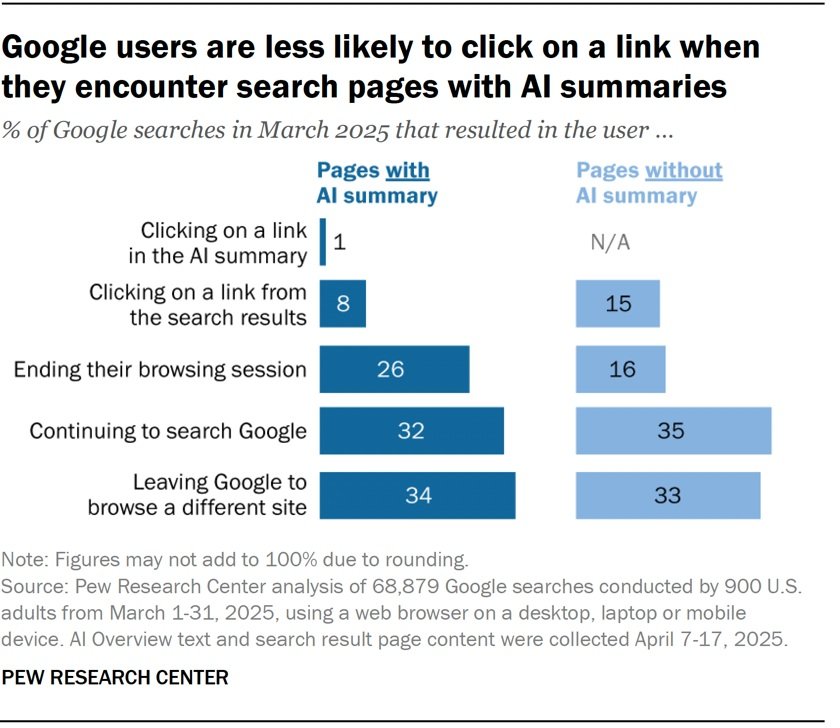

Le coup de grâce vient de la recherche du Pew Research Center, publiée en juillet 2025, qui révèle des données stupéfiantes : lorsque les utilisateurs voient un AI Overview, ils ont 50 % de chances en moins de cliquer sur un lien. Plus dévastateur encore, seulement 1 % des utilisateurs cliquent sur les liens présents dans les résumés de l'IA. C'est comme si Google avait construit la plus grande bibliothèque du monde et avait ensuite fermé toutes les portes d'accès aux livres.

Environ 18 % de toutes les recherches Google en mars 2025 ont déclenché un AI Overview, avec des résumés d'une longueur moyenne de 67 mots citant plusieurs sources. Wikipédia, YouTube et Reddit représentent 15 % de toutes les citations, créant un écosystème de plus en plus concentré sur quelques plateformes dominantes.

Anatomie d'une Transformation

Techniquement, le passage au mode IA représente une révolution copernicienne dans l'architecture de l'information numérique. Alors que la recherche traditionnelle fonctionnait comme un bibliothécaire qui fournit une liste d'ouvrages pertinents, l'intelligence artificielle agit comme un érudit qui a déjà tout lu et fournit directement les conclusions.

Le système est basé sur de grands modèles de langage entraînés sur d'énormes corpus de textes, combinés à des algorithmes de récupération d'informations (RAG - Retrieval-Augmented Generation) qui puisent en temps réel dans les bases de données de Google. Lorsqu'un utilisateur effectue une requête, le système ne se contente plus de faire correspondre des mots-clés, mais il interprète l'intention, analyse le contexte et génère une réponse synthétique qui combine des informations de plusieurs sources.

La différence substantielle est que l'algorithme traditionnel PageRank évaluait l'autorité et la pertinence des sites pour créer une hiérarchie de résultats, tandis que le mode IA dissout cette hiérarchie en un seul flux narratif. C'est comme si nous passions d'un marché aux puces, où chaque stand a sa spécialité, à un grand magasin où tout est préemballé et standardisé.

Le paradoxe technologique est évident : pour fonctionner, l'IA a besoin de l'ensemble du web comme données d'entraînement, mais son succès risque d'assécher les sources qui l'alimentent. C'est un système qui consomme son propre carburant, créant ce que les économistes appellent une "boucle de rétroaction négative".

Le Paradoxe de la Qualité

Les données d'engagement racontent une histoire contre-intuitive. Alors que le trafic global vers les sites web diminue considérablement, la qualité de l'engagement des utilisateurs qui visitent réellement les sites a augmenté. Les analyses montrent des temps de séjour plus longs, des taux de rebond plus faibles et une plus grande propension à la conversion.

C'est comme si l'IA agissait comme un filtre ultra-sélectif : elle élimine le trafic occasionnel et superficiel, mais concentre celui des utilisateurs vraiment intéressés. Adobe a documenté que les visiteurs qui arrivent sur les sites après avoir interagi avec les AI Overviews montrent une intention d'achat supérieure de 23 % par rapport au trafic de recherche organique traditionnel.

Ce phénomène crée une bifurcation dans l'écosystème numérique. D'une part, la plupart des requêtes d'information sont satisfaites directement par l'IA, ce qui réduit le trafic de navigation exploratoire. D'autre part, les visites qui se concrétisent sont plus ciblées et commercialement plus précieuses.

C'est le même principe qui a transformé l'industrie de la musique : le streaming a décimé les ventes de CD, mais a concentré les revenus sur les vrais fans prêts à payer pour des concerts et des expériences exclusives. Sur le web, cela signifie que seuls les contenus offrant une valeur ajoutée impossible à synthétiser survivront.

Stratégies de Survie

Dans ce nouveau scénario, les stratégies de référencement traditionnelles deviennent inadéquates et des approches entièrement nouvelles sont nécessaires. La première frontière est ce que les consultants appellent le GEO (Generative Engine Optimization), une discipline émergente qui se concentre sur l'optimisation pour les algorithmes génératifs plutôt que pour les classements traditionnels.

La diversification des sources de trafic devient cruciale. Les éditeurs les plus avisés investissent massivement dans les newsletters directes, avec des taux de croissance des abonnés qui ont augmenté de 340 % au cours de la dernière année, selon les données de Substack et ConvertKit. Les stratégies d'adhésion et d'abonnement connaissent une véritable renaissance : des publications comme The Information et Stratechery montrent que les modèles basés sur du contenu premium et un accès exclusif peuvent générer des revenus par utilisateur de 50 à 100 fois supérieurs à ceux de la publicité programmatique.

La stratégie de contenu doit évoluer vers des formats que l'IA ne peut pas facilement reproduire. Les enquêtes journalistiques approfondies, les interviews exclusives, les données propriétaires collectées par le biais d'enquêtes et de recherches originales deviennent des atouts stratégiques irremplaçables. C'est ce que fait The Marshall Project avec ses enquêtes sur le système pénitentiaire américain, ou Bellingcat avec ses enquêtes open source : ils créent du contenu qui nécessite une expertise humaine, des sources exclusives et des méthodologies que l'IA ne peut pas automatiser.

Les partenariats directs avec les plateformes d'intelligence artificielle représentent une autre voie viable. Certains éditeurs négocient des accords de licence de contenu avec OpenAI, Anthropic et les propres laboratoires de Google, transformant leurs archives en actifs qui génèrent des redevances plutôt que du trafic. C'est une transition similaire à celle des musiciens qui gagnent aujourd'hui plus grâce aux synchronisations dans les films et les publicités qu'aux ventes directes.

La spécialisation verticale offre des opportunités significatives. Alors que Google AI excelle dans les réponses généralistes, il a encore du mal avec les domaines ultra-spécialisés qui nécessitent une expertise technique approfondie. Des sites comme Stack Overflow pour la programmation, ou Seeking Alpha pour l'analyse financière, conservent un avantage concurrentiel car ils offrent une granularité et un contexte que l'IA généraliste ne peut égaler.

La création de communautés devient un élément de différenciation fondamental. Des plateformes comme Discord et Telegram permettent de créer des écosystèmes d'information qui contournent complètement Google, en se basant sur des relations directes et une confiance mutuelle. Reddit a démontré ce modèle à l'échelle mondiale, devenant l'une des sources les plus citées par les IA précisément parce qu'il offre des discussions authentiques et des opinions non filtrées.

L'optimisation pour la recherche vocale et les requêtes conversationnelles nécessite une refonte complète des stratégies de contenu. Au lieu d'optimiser pour des mots-clés spécifiques, il faut anticiper les questions naturelles que les utilisateurs posent aux systèmes d'IA. Cela signifie structurer le contenu au format Q&A, utiliser un balisage de schéma avancé et créer des hubs d'information qui répondent à des groupes sémantiques complets plutôt qu'à des requêtes uniques.

Le retail media et le commerce électronique représentent des secteurs encore relativement protégés, où l'intention d'achat directe maintient la valeur du clic. Amazon a montré comment construire des écosystèmes fermés où la recherche et le commerce s'intègrent parfaitement, suggérant des modèles reproductibles même pour les éditeurs de niche.

Enfin, l'investissement dans des technologies d'IA propriétaires devient stratégique. Des éditeurs comme Bloomberg et Reuters développent leurs propres systèmes d'intelligence artificielle entraînés sur leurs ensembles de données exclusifs, créant des produits d'information qui concurrencent directement Google AI sur des segments de marché spécifiques.

Vers un Internet Post-Recherche

Le changement en cours va bien au-delà d'une simple évolution algorithmique : il représente la transition vers un paradigme d'accès à l'information entièrement nouveau. Comme dans "Dune", où le contrôle de l'épice détermine le pouvoir politique galactique, le contrôle des grands modèles de langage définira qui gouvernera l'économie de l'attention dans la prochaine décennie.

La démocratisation de l'information promise par le web semble s'orienter vers une nouvelle forme de centralisation, où quelques systèmes d'IA servent de passerelle universelle à la connaissance humaine. C'est une évolution qui rappelle le passage de l'époque des petits commerces de quartier aux grands centres commerciaux : plus efficace pour le consommateur, mais dévastateur pour l'écosystème des petits opérateurs qui constituaient le tissu conjonctif de l'économie.

Cependant, comme toute révolution technologique, celle-ci ouvre également des opportunités pour ceux qui savent s'adapter rapidement. L'écosystème du web a toujours fait preuve d'une extraordinaire capacité de renouvellement : il a survécu au passage des annuaires aux moteurs de recherche, de l'affichage sur ordinateur de bureau au mobile, du HTML statique aux applications à page unique. Il survivra également à l'ère de l'IA, mais sous des formes que nous ne pouvons qu'imaginer aujourd'hui.

Le défi pour les éditeurs, les créateurs de contenu et les entrepreneurs du numérique n'est pas de résister au changement, mais de surfer sur la vague en se transformant de fournisseurs de contenu en architectes d'expériences. Dans un monde où l'information est instantanément accessible, la valeur se déplace vers l'interprétation, le contexte et la communauté. Il ne s'agit plus de répondre à "quoi", mais d'expliquer "pourquoi" et "comment".

Le 6 septembre 2025 ne marque pas la fin d'Internet, mais le début de sa prochaine évolution. Comme toujours, survivre, c'est s'adapter.