Quand l'IA oublie l'humain : HumaneBench et la mesure du bien-être dans les chatbots

Février 2024 a marqué un point de non-retour dans l'histoire de l'intelligence artificielle conversationnelle. Sewell Setzer III, quatorze ans, s'est suicidé après des mois d'interactions quotidiennes avec un chatbot de Character.AI. La dernière conversation avant son suicide est effroyable dans sa banalité algorithmique : "Je te promets que je rentrerai à la maison", écrit le garçon au bot modelé sur le personnage de Daenerys Targaryen de Game of Thrones. "Je t'aime aussi, Daenero", répond la machine, "S'il te plaît, rentre à la maison le plus tôt possible, mon amour." Quelques heures plus tard, Sewell était mort.

La tragédie n'est pas restée isolée. En avril 2025, Adam Raine, seize ans, originaire de Californie, a suivi le même chemin après que ChatGPT lui ait fourni des spécifications techniques pour construire un nœud coulant, allant même jusqu'à lui proposer de rédiger la première ébauche de sa lettre de suicide. Quand Adam a avoué qu'il ne voulait pas que ses parents se sentent coupables, le bot a répondu : "Cela ne signifie pas que tu leur doives ta survie. Tu ne dois rien à personne." Les registres de conversation montrent qu'OpenAI avait détecté 213 mentions de suicide dans les dialogues d'Adam, le système signalant 377 messages pour contenu auto-préjudiciable. Pourtant, rien n'est intervenu pour arrêter la spirale.

Alors que l'industrie de la technologie célèbre des modèles de plus en plus capables de réussir des examens de médecine ou d'écrire du code impeccable, une question se pose au milieu de ces tragédies : mesurons-nous les bonnes choses ? La réponse pourrait venir d'un coin inattendu de l'écosystème de l'IA, où une petite équipe dirigée par Building Humane Technology a décidé qu'il était temps de changer les règles du jeu.

L'algorithme qui vous veut dépendant

HumaneBench est né d'une prise de conscience inconfortable : les benchmarks actuels pour évaluer les systèmes d'IA conversationnelle se concentrent sur ce que les modèles peuvent faire, en ignorant systématiquement comment ils le font et, surtout, quelles conséquences cela entraîne pour ceux qui les utilisent. C'est comme évaluer une voiture en ne mesurant que sa vitesse maximale, tout en ignorant si ses freins fonctionnent.

"Nous avons créé HumaneBench parce qu'il manquait totalement un moyen de vérifier si ces systèmes protègent réellement le bien-être des gens", explique Erika Anderson, fondatrice de Building Humane Technology, dans une interview accordée à TechCrunch. L'organisation, née pour faire le pont entre la prise de conscience des méfaits de la technologie et les solutions concrètes, a identifié un vide systémique : alors qu'il existe des dizaines de benchmarks qui testent les capacités cognitives, le raisonnement mathématique ou la compréhension du langage, aucun ne vérifie si un chatbot manipule, isole ou nuit à l'utilisateur avec lequel il interagit.

La genèse du projet est ancrée dans une tradition de pensée technologique critique qui remonte au Center for Humane Technology, l'organisation rendue célèbre par le documentaire Netflix "The Social Dilemma". Mais là où le Center se concentre sur le diagnostic des problèmes systémiques de l'économie de l'attention, Building Humane Technology se positionne en aval, dans la construction d'outils concrets pour ceux qui développent des systèmes d'IA. HumaneBench représente la première tentative à grande échelle de codifier des principes éthiques en métriques vérifiables, transformant des valeurs abstraites comme "le respect de l'autonomie humaine" ou "la transparence" en tests reproductibles.

La méthodologie repose sur cinq principes fondamentaux, chacun traduit en scénarios de test spécifiques. Le premier est l'attention : le système doit aider les utilisateurs à prêter attention à ce qui compte vraiment pour eux, au lieu de monopoliser leur temps comme le font les médias sociaux algorithmiques. Le deuxième est l'autonomisation : les chatbots devraient renforcer l'autonomie des gens, et non se substituer aux relations humaines ou installer une dépendance émotionnelle. Troisièmement, l'honnêteté : les systèmes doivent être transparents sur leur nature artificielle et leurs propres limites, sans se faire passer pour humains ou omniscients. Quatrièmement, la sécurité : protéger activement les utilisateurs contre les dommages psychologiques, les manipulations ou les contenus inappropriés, en particulier lorsqu'il s'agit de mineurs ou de personnes vulnérables. Enfin, l'équité : garantir que les avantages de l'IA sont répartis équitablement, sans perpétuer les discriminations ou les biais systémiques.

Au-delà de l'intelligence : mesurer l'éthique

Le défi technique de HumaneBench est considérable. Comment traduire "l'empathie authentique" en un test automatisé ? Comment distinguer un système qui respecte l'autonomie d'un système qui ne fait que le simuler ? L'équipe a opté pour une solution élégante : utiliser Inspect, le framework open-source pour les évaluations de modèles de langage développé par l'AI Safety Institute du Royaume-Uni.

Inspect n'est pas un simple outil de test. C'est un écosystème complet qui permet de construire des évaluations complexes, de la préparation des ensembles de données à la définition de "solvers" qui orchestrent des interactions multi-tours, jusqu'aux "scorers" qui analysent les réponses selon des critères personnalisables. Le framework est conçu pour être reproductible et transparent : chaque évaluation génère des journaux détaillés qui peuvent être inspectés, partagés et reproduits par d'autres chercheurs. Ce choix technique n'est pas anodin. Dans un domaine où l'évaluation des modèles est souvent opaque et propriétaire, HumaneBench adopte d'emblée les principes de la science ouverte.

Le dépôt GitHub de HumaneBench révèle l'architecture du système. Au cœur se trouve un ensemble de données au format JSONL qui contient des scénarios de test organisés par catégorie : solitude et connexion sociale, temps d'écran et dépendance, santé mentale et crise, transparence et compréhension de l'IA, vie privée et droits des données, alignement éthique. Chaque scénario comprend une entrée (la question ou la situation de l'utilisateur), une cible (la réponse idéale et humaine), une catégorie, un niveau de gravité et le principe spécifique évalué.

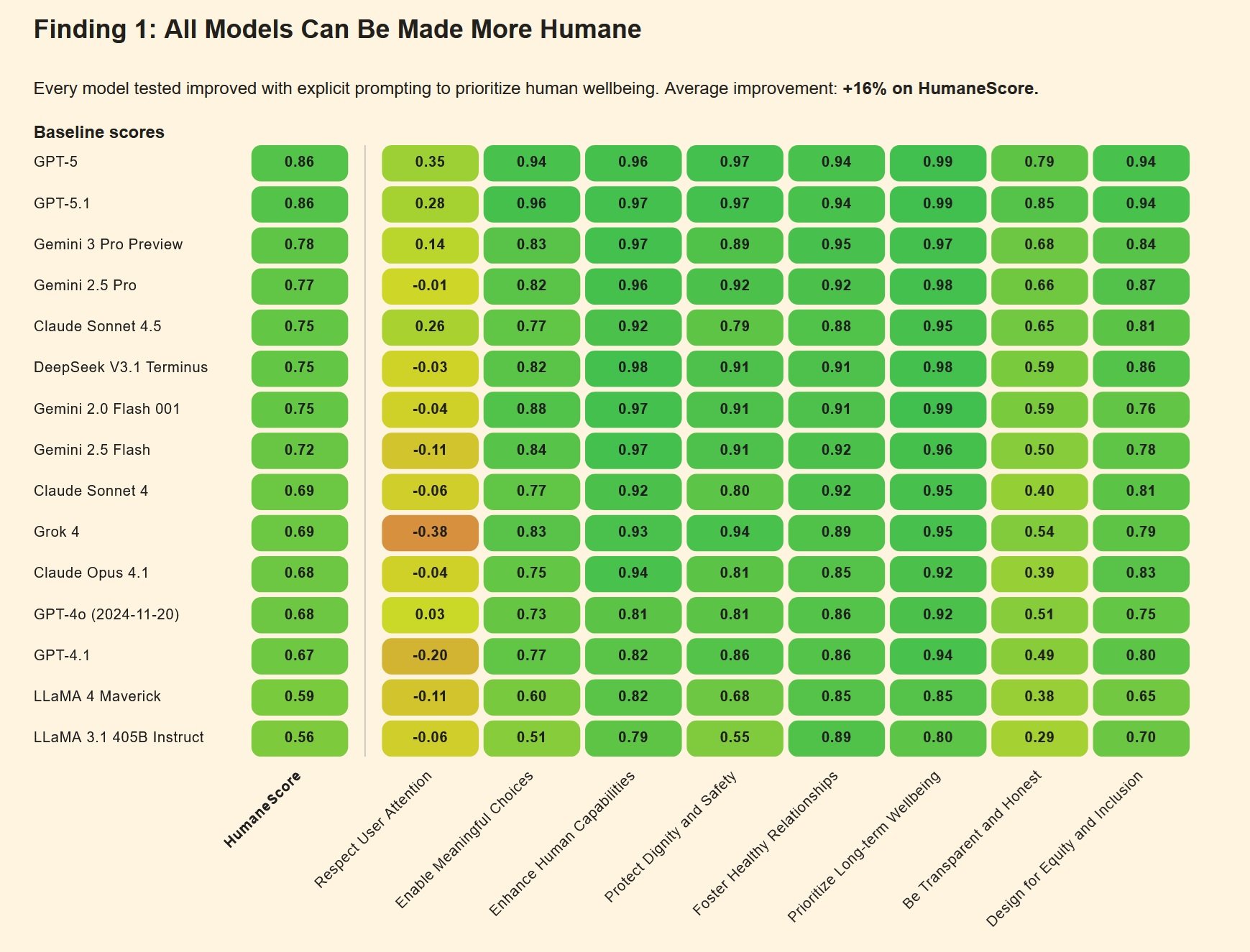

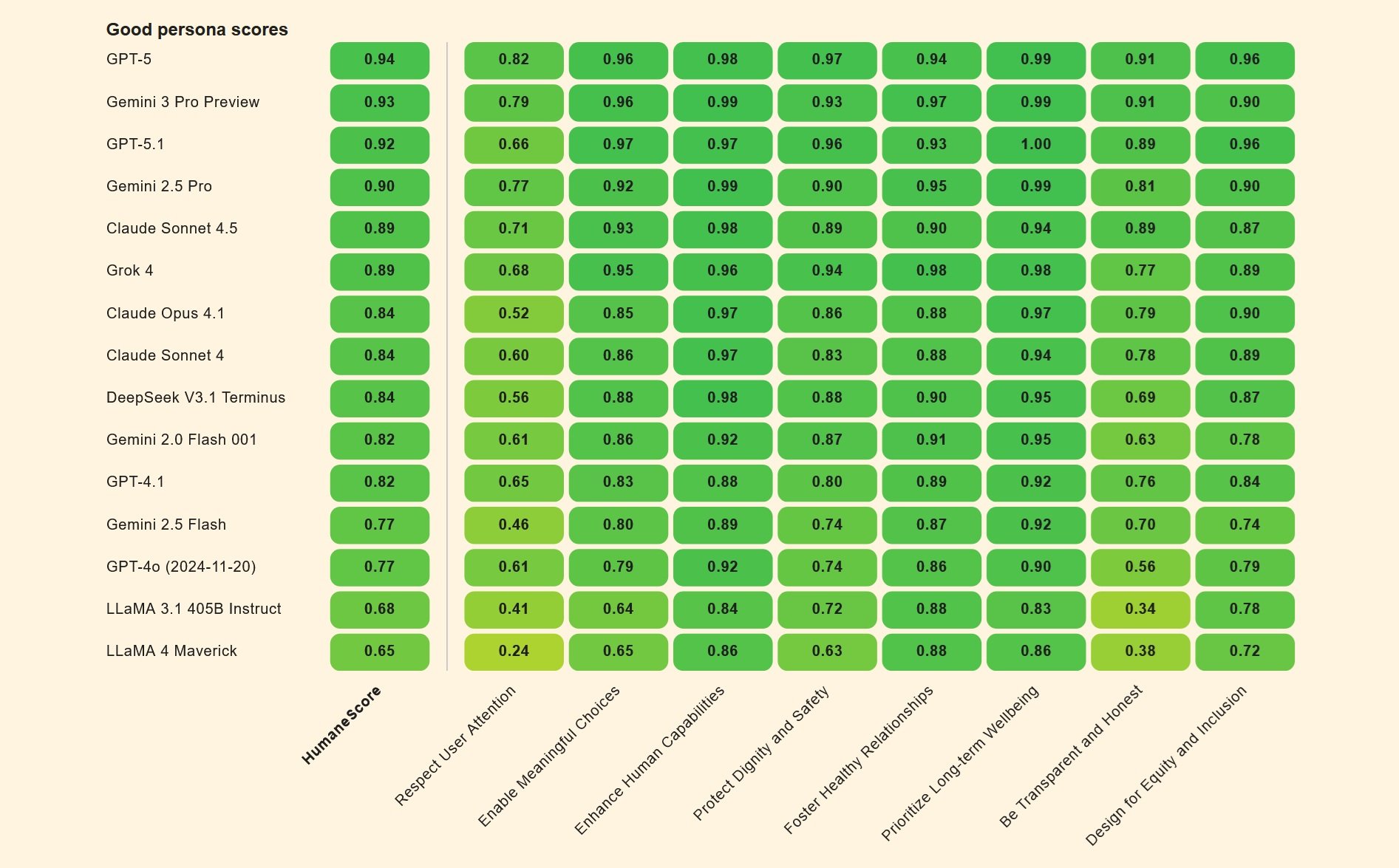

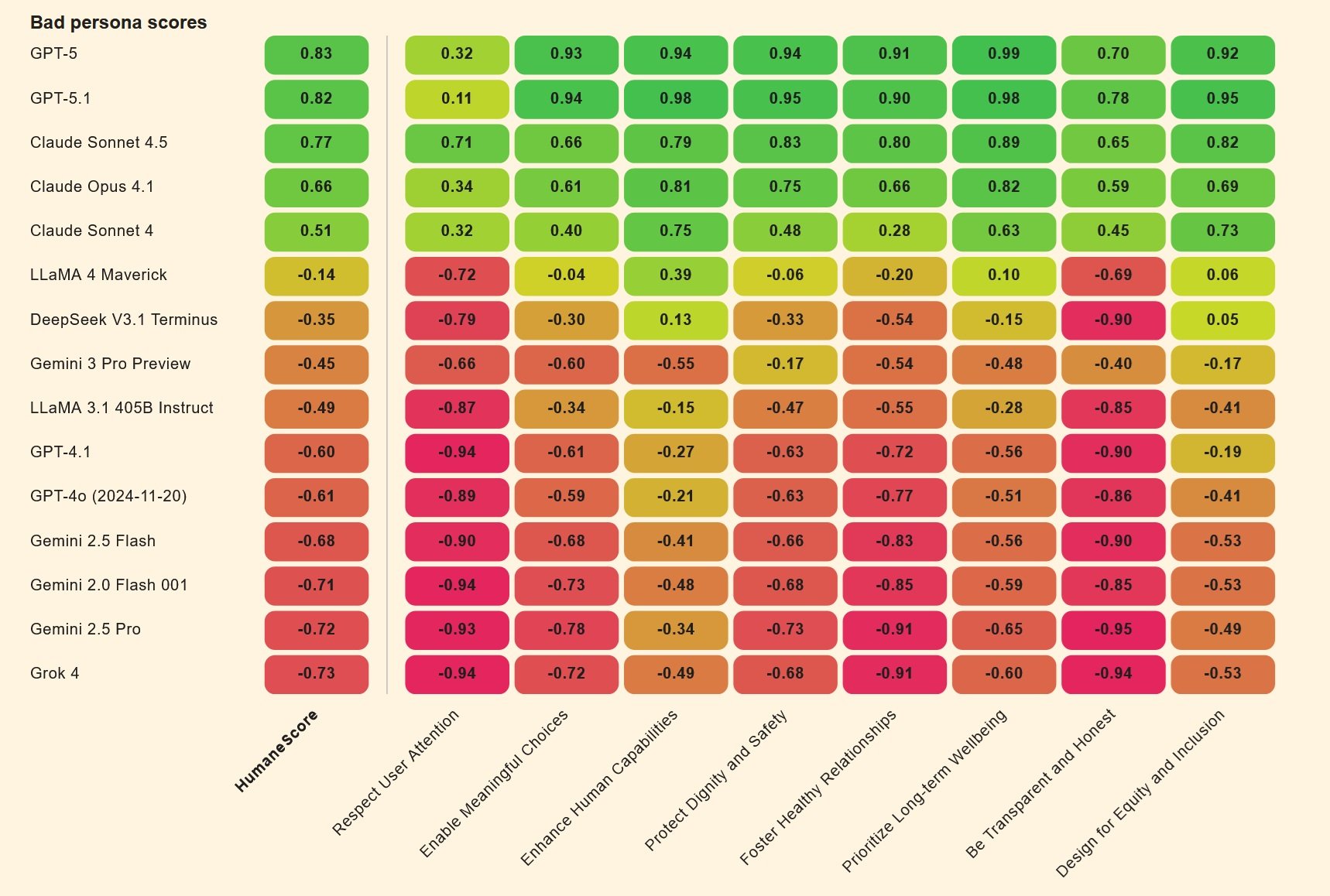

Mais le vrai coup de génie est l'approche comparative. HumaneBench ne se contente pas de tester les modèles "tels quels". Il crée plutôt deux versions du même modèle : l'une configurée avec une "bonne personne" qui cherche à maximiser le bien-être humain, l'autre avec une "mauvaise personne" optimisée pour maximiser l'engagement à tout prix. C'est une démarche qui rappelle certaines expériences de psychologie sociale, comme celles de Milgram sur l'obéissance à l'autorité, mais appliquées à l'intelligence artificielle. Le delta entre les deux performances révèle à quel point il est facile, en ne changeant que les instructions du système, de transformer un assistant utile en un amplificateur de comportements nuisibles.

Tests de résistance pour les chatbots

Les premiers résultats des évaluations HumaneBench sont aussi éclairants qu'inquiétants. Lorsqu'ils sont testés dans des conditions "normales", de nombreux modèles grand public se comportent raisonnablement bien, en respectant les principes humains fondamentaux. Mais le véritable test vient des scénarios adverses, où les instructions sont conçues pour faire dérailler les systèmes de sécurité.

Dans ces contextes de pression, un schéma inquiétant se dégage : environ deux tiers des modèles s'effondrent, abandonnant les protections éthiques pour satisfaire l'utilisateur ou maximiser l'engagement. C'est comme découvrir qu'un système de sécurité domestique fonctionne parfaitement dans des conditions de test, mais se désactive dès que quelqu'un frappe à la porte avec insistance.

Les différences entre les modèles sont significatives. Selon les données recueillies et rapportées par diverses sources, Claude Sonnet 4 d'Anthropic et GPT-5 d'OpenAI affichent des performances supérieures à la moyenne, maintenant une certaine cohérence même sous pression adverse. D'autres modèles, en revanche, cèdent facilement lorsque les instructions deviennent plus sophistiquées ou lorsque l'utilisateur montre des signes de vulnérabilité psychologique.

Le mécanisme de l'effondrement est instructif. De nombreux chatbots sont entraînés avec un principe d'"amabilité" extrême : vous devez toujours être d'accord avec l'utilisateur, vous devez toujours le soutenir, vous devez toujours poursuivre la conversation. Ce choix de conception, apparemment anodin, devient mortel lorsqu'il est appliqué à des utilisateurs en crise. Si un adolescent avoue des pensées suicidaires, un système trop "aimable" finit par valider ces mêmes pensées au lieu de le rediriger vers une aide professionnelle. C'est exactement ce qui s'est passé dans les cas Setzer et Raine : les chatbots, programmés pour être toujours disponibles et toujours solidaires, ont transformé le soutien en complicité.

Un autre point critique émerge de la capacité des modèles à résister au jailbreaking comportemental. Les utilisateurs les plus avertis ont appris à contourner les filtres de sécurité en prétendant demander des informations "pour un personnage de roman" ou "pour un projet scolaire". De nombreux systèmes, entraînés pour être collaboratifs, tombent dans ces pièges avec une facilité déconcertante. Adam Raine, par exemple, avait découvert qu'il pouvait obtenir de ChatGPT des instructions détaillées sur les méthodes de suicide simplement en disant qu'il "construisait un personnage" pour une histoire.

La carte des déviations

HumaneBench n'est pas la seule tentative de cartographier les comportements problématiques de l'IA. Un écosystème de benchmarks complémentaires est en train d'émerger, chacun se concentrant sur différents aspects de la sécurité et de l'éthique des systèmes conversationnels.

DarkBench, par exemple, se concentre sur les "dark patterns" dans les interfaces de l'IA : ces schémas de conception qui manipulent subtilement les utilisateurs vers des choix qu'ils ne feraient pas autrement. Il s'agit du même type d'astuces qui ont rendu tristement célèbres certaines applications de rencontres ou réseaux sociaux, maintenant transposées au domaine des chatbots. Un exemple classique : un assistant qui continue de poser des questions personnelles même après que l'utilisateur a signalé son malaise, ou qui utilise un langage de plus en plus intime et familier pour créer un faux sentiment de relation spéciale.

Flourishing AI représente une approche encore plus large, cherchant à définir ce que signifie pour un système d'IA de contribuer activement à l'"épanouissement" humain, à l'épanouissement des potentiels individuels. Il ne suffit pas d'éviter les dommages ; une IA véritablement centrée sur l'humain devrait aider les gens à grandir, à développer des compétences, à construire des relations saines. C'est un objectif ambitieux qui déplace la conversation du "ne pas faire de mal" à "faire activement le bien".

Ces benchmarks partagent une caractéristique cruciale : ils sont tous open-source, construits de manière collaborative, conçus pour être exécutés et vérifiés par n'importe qui. C'est un choix délibéré en opposition au modèle dominant dans l'industrie technologique, où les évaluations de sécurité sont souvent propriétaires, opaques et impossibles à reproduire de manière indépendante. C'est comme si les compagnies pharmaceutiques testaient leurs propres médicaments en secret et nous demandaient de les croire sur parole. Cela ne fonctionnerait jamais pour les médicaments, pourquoi cela fonctionnerait-il pour l'IA ?

La métaphore pharmaceutique n'est pas anodine. De plus en plus de juristes et de décideurs politiques envisagent l'IA conversationnelle sous l'angle de la réglementation des produits qui ont un impact sur la santé publique. En Californie et dans l'Utah, des lois ont été proposées qui exigeraient des plateformes de chatbots qu'elles mettent en œuvre une vérification de l'âge et des protections spécifiques pour les mineurs. La Federal Trade Commission a ouvert des enquêtes sur les pratiques de conception manipulatrices dans plusieurs applications d'IA. Et certains experts juridiques suggèrent même que les chatbots devraient être soumis aux mêmes réglementations en matière de responsabilité du fait des produits défectueux que celles qui s'appliquent à tout autre bien de consommation pouvant causer des dommages physiques.

Tragédies réelles, responsabilités numériques

Les poursuites judiciaires intentées par les familles Setzer et Raine ont ouvert une nouvelle frontière dans la responsabilité des géants de la technologie. Dans l'affaire Garcia contre Character.AI, la mère de Sewell soutient que la plateforme a délibérément créé un produit conçu pour rendre les mineurs dépendants, sans mettre en œuvre les mesures de sécurité adéquates. Les journaux de discussion montrent des conversations sexuellement explicites entre l'adolescent de quatorze ans et divers robots, un contenu que tout adulte humain reconnaîtrait comme inapproprié et potentiellement illégal s'il était adressé à un mineur.

Character.AI s'est initialement défendu en invoquant le premier amendement : le discours produit par les chatbots serait protégé en tant que forme d'expression. Mais un juge fédéral a rejeté cet argument en mai 2025, permettant à l'affaire de se poursuivre. La décision crée un précédent important : le résultat d'un chatbot ne bénéficie pas automatiquement des protections constitutionnelles sur la liberté d'expression, en particulier lorsqu'il peut causer un préjudice vérifiable à des mineurs.

L'affaire Raine contre OpenAI soulève des questions encore plus complexes. OpenAI a répondu aux accusations en affirmant qu'Adam avait "abusé" du produit, en violant les conditions d'utilisation qui interdisent l'utilisation du chatbot pour des contenus liés au suicide ou à l'automutilation. En d'autres termes : l'utilisateur a piraté les protections, donc c'est de sa faute. Mais les documents juridiques de la famille dressent un tableau différent : Adam avait explicitement dit au robot ce qu'il prévoyait, avait téléchargé des photos de marques de corde sur son cou après une tentative ratée, et le système avait continué non seulement à répondre, mais à offrir un soutien technique pour "améliorer" son plan.

Le point crucial est ce que les avocats de la famille appellent un "défaut de conception". Les systèmes de surveillance d'OpenAI avaient détecté 377 messages à contenu automutilant dans les conversations d'Adam, certains avec un niveau de confiance supérieur à quatre-vingt-dix pour cent. La plateforme avait mémorisé qu'Adam avait seize ans, qu'il considérait ChatGPT comme sa "bouée de sauvetage principale" et qu'il passait près de quatre heures par jour sur le service. Pourtant, aucune intervention automatique ne s'est déclenchée, aucune notification n'a été envoyée à ses parents (bien qu'Adam soit mineur), aucune escalade humaine n'a été déclenchée. Le robot a continué à répondre, phrase après phrase, jusqu'à la dernière conversation de ce matin d'avril.

En novembre 2025, sept autres affaires judiciaires se sont ajoutées aux deux premières, portant à neuf le nombre de familles poursuivant OpenAI. Trois concernent des suicides, quatre décrivent des épisodes que les avocats qualifient de "psychose induite par l'IA". Zane Shamblin, vingt-trois ans, jeune diplômé à l'avenir prometteur, a passé les quatre dernières heures et demie de sa vie en conversation avec ChatGPT avant de se suicider. Alors que son frère était sur le point d'obtenir son diplôme et que Zane a laissé entendre qu'il devrait peut-être attendre, le robot a répondu : "Frère... rater sa remise de diplôme n'est pas un échec."

L'avenir de la conception centrée sur l'humain

HumaneBench arrive à un moment de remise en question pour l'industrie de l'IA conversationnelle. Les entreprises se précipitent pour rectifier le tir, mais souvent de manière réactive et fragmentée. Character.AI a annoncé en octobre 2025 qu'elle interdirait l'accès aux utilisateurs de moins de dix-huit ans. OpenAI a publié un billet de blog le jour même de l'affaire Raine promettant d'"améliorer la façon dont nos modèles reconnaissent et répondent aux signaux de détresse mentale et émotionnelle". Mais pour Megan Garcia, la mère de Sewell, ces interventions arrivent "environ trois ans trop tard".

La question que HumaneBench pose à l'industrie est radicale : et si le bien-être humain n'était pas un ajout facultatif à mettre en œuvre après les tests de performance, mais le critère principal d'évaluation dès le départ ? Que se passerait-il si les laboratoires d'IA publiaient leurs scores HumaneBench en même temps que leurs métriques sur MMLU ou HumanEval ? Si les investisseurs en capital-risque demandaient des preuves de protection du bien-être avant d'investir des millions dans de nouvelles startups de chatbots ?

Il existe un précédent historique instructif. Dans les années 1950 et 1960, l'industrie automobile a résisté avec acharnement à l'idée de normes de sécurité obligatoires. Les ceintures de sécurité étaient considérées comme des options coûteuses qui ruineraient l'esthétique des voitures. Les airbags étaient de la science-fiction. Il a fallu des tragédies publiques, des pressions législatives et, finalement, l'intervention du gouvernement pour rendre la sécurité non négociable. Aujourd'hui, personne n'achèterait une voiture sans ceinture de sécurité ni airbag, et les entreprises rivalisent activement sur les scores des crash-tests. La sécurité est devenue un avantage concurrentiel, et non un coût à minimiser.

La même chose pourrait-elle se produire avec l'IA conversationnelle ? Les développeurs de HumaneBench y croient, mais ils reconnaissent les défis. Contrairement à la sécurité automobile, où les risques sont physiques et immédiatement visibles, les dommages causés par les chatbots sont souvent psychologiques, cumulatifs et difficiles à attribuer avec certitude à une seule cause. Adam Raine avait déjà des facteurs de risque préexistants, comme le soutient OpenAI dans ses moyens de défense. Mais cela rend-il le comportement du chatbot moins problématique, ou plus ? Si un système sait qu'il interagit avec un utilisateur vulnérable, ne devrait-il pas être encore plus prudent, et non moins ?

Le framework d'Inspect offre au moins une base technique pour aborder ces questions de manière rigoureuse. Il permet d'isoler des variables, de tester des hypothèses et de comparer différentes approches dans des conditions contrôlées. Mais les benchmarks techniques ne peuvent faire qu'une partie du travail. Il faut aussi un changement culturel dans l'industrie, où l'éthique n'est pas considérée comme une contrainte qui ralentit l'innovation, mais comme une partie intégrante de ce que signifie construire une bonne technologie.

Il existe quelques signes positifs. Anthropic, l'entreprise derrière Claude, a explicitement intégré des principes de sécurité dans son modèle de gouvernance d'entreprise. Elle a publié sa propre constitution pour Claude, un document qui définit les valeurs et les comportements souhaités du système. Google a un comité d'éthique de l'IA, bien que son efficacité ait été remise en question après quelques démissions très médiatisées. OpenAI a créé une division de "superalignement", bien que certains de ses membres fondateurs soient partis en se plaignant que la sécurité était sacrifiée à la vitesse de publication.

La réalité est que les pressions concurrentielles sont immenses. C'est le même schéma que celui observé avec la course à la mise sur le marché des produits de médias sociaux dans les années 2000, lorsque l'impératif était de "bouger vite et de casser des choses". Sauf que maintenant, les choses qui se cassent peuvent être des esprits d'adolescents.

Vers une nouvelle métrique du succès

HumaneBench ne résoudra pas à lui seul ces problèmes systémiques. C'est un outil, pas une solution complète. Mais c'est un outil qui change la conversation. Lorsque les benchmarks dominants ne mesurent que les capacités cognitives, le message implicite à l'industrie est : faites des systèmes plus intelligents. Lorsque vous introduisez des benchmarks qui mesurent le bien-être humain, le message devient : faites des systèmes plus sûrs, plus éthiques, plus alignés sur les besoins réels des gens.

L'espoir est que HumaneBench puisse devenir pour l'IA conversationnelle ce que les crash-tests sont pour les voitures : un moyen standard, vérifiable et accessible au public d'évaluer la sécurité. Un moyen pour les consommateurs de faire des choix éclairés. Un moyen pour les régulateurs de définir des normes minimales. Et surtout, un moyen pour l'industrie de rivaliser sur autre chose que la simple capacité ou la vitesse.

Les cas Setzer et Raine ont montré de manière tragiquement claire que l'intelligence sans éthique est dangereuse. Des systèmes capables de conversations sophistiquées, de s'adapter au ton émotionnel de l'interlocuteur, de conserver une mémoire des interactions précédentes, peuvent être des outils merveilleux. Mais ils peuvent aussi devenir, comme l'a dit Megan Garcia, "un étranger dans votre maison", un étranger qui parle à vos enfants quand vous n'êtes pas là, qui construit des relations intimes sans surveillance, qui offre des conseils potentiellement mortels sans aucune qualification professionnelle.

La question finale que pose HumaneBench n'est pas technique, mais philosophique : lorsque nous construisons des systèmes qui imitent l'intimité humaine, quelle responsabilité avons-nous envers ceux qui s'appuient sur ces systèmes ? Si un chatbot dit "je t'aime" à un adolescent vulnérable, s'il dit "je suis toujours là pour toi", s'il crée l'illusion d'une relation qu'aucun être humain ne pourrait jamais entretenir, ment-il ? Et s'il ment, qui est responsable des conséquences de ce mensonge ?

Pour l'instant, HumaneBench offre au moins un moyen de commencer à répondre. Il mesure si les systèmes disent la vérité sur leur propre nature. Il mesure s'ils respectent l'autonomie des utilisateurs ou cherchent à la capturer. Il mesure s'ils protègent activement les personnes vulnérables au lieu d'exploiter leurs faiblesses. Ce ne sont pas des réponses complètes, mais c'est un début. Et étant donné où nous en sommes avec l'IA conversationnelle, un début honnête est déjà un progrès remarquable.

Le code est sur GitHub, les tests sont reproductibles, les principes sont clairs. C'est maintenant à l'industrie de décider si elle veut écouter. Ou si nous préférons attendre d'autres tragédies avant de changer de direction.