LongCat-Video, le géant silencieux de la génération vidéo OpenSource

Meituan publie un modèle de 13,6 milliards de paramètres qui génère des vidéos pouvant durer jusqu'à cinq minutes. Dans le chaos de l'IA vidéo, une solution technique élégante arrive, défiant les géants propriétaires avec efficacité et transparence. Alors que le monde de la technologie était occupé à digérer les controverses sur le droit d'auteur de Sora 2 et à se mesurer aux limitations d'accès de Veo 3, fin octobre 2025, l'équipe LongCat de Meituan a publié LongCat-Video avec la discrétion de ceux qui savent avoir quelque chose de solide entre les mains mais ne ressentent pas le besoin de le crier sur tous les toits.

Pas de keynotes spectaculaires, pas de démos préparées en laboratoire avec un cherry-picking suspect, juste un dépôt GitHub, les poids du modèle sur Hugging Face et un article technique détaillé sur arXiv. Comme pour dire : voici le code, voici le modèle, à vous de jouer.

Et le modèle, à y regarder de plus près, est tout sauf modeste. Avec 13,6 milliards de paramètres et la capacité de générer des vidéos allant jusqu'à cinq minutes tout en maintenant la cohérence temporelle et la qualité visuelle, LongCat-Video s'attaque à l'un des problèmes les plus tenaces de l'IA vidéo générative : comment éviter qu'une longue vidéo ne se transforme en une dérive psychédélique d'artefacts, de dérive des couleurs et d'incohérences narratives. C'est le genre de problème qui semble anodin jusqu'à ce qu'on s'y heurte, comme de réaliser qu'écrire une longue histoire est plus difficile que d'enchaîner des paragraphes courts.

Le problème que personne n'avait vraiment résolu

Le paysage de la génération vidéo par IA en 2025 ressemble à une course à l'armement où tout le monde mise sur le même critère : à quel point pouvez-vous rendre un clip de cinq secondes photoréaliste ? Sora, Veo, Movie Gen ont placé la barre de la qualité visuelle à des niveaux impressionnants, mais restent contraints à des durées courtes ou en tout cas limitées. Quand OpenAI a annoncé Sora 2 avec ses vingt secondes de génération maximale, cela semblait être un jalon. Mais vingt secondes, en termes de narration visuelle, c'est à peine plus qu'un plan d'ouverture. On ne raconte pas grand-chose en vingt secondes, tout au plus on évoque.

Le monde de l'open source, de son côté, se débat entre des projets ambitieux mais des ressources limitées. HunyuanVideo de Tencent atteint dix secondes avec des résultats solides, Mochi se concentre sur l'animation d'images statiques, Open-Sora peine à répliquer l'original propriétaire. Tous partagent la même limite : au-delà d'une certaine durée, la cohérence temporelle s'effondre comme un soufflé mal cuit. Les images commencent à dévier dans leurs couleurs, les objets se multiplient ou disparaissent, les mouvements perdent leur continuité physique. C'est le phénomène que les chercheurs appellent "dérive temporelle" et qui apparaît simplement aux utilisateurs comme des vidéos qui semblent générées par une intelligence artificielle sous l'effet de substances psychoactives.

LongCat-Video aborde ce problème sous un angle différent. Au lieu de tout miser sur la perfection photoréaliste de clips très courts, l'équipe de Meituan a conçu une architecture qui privilégie la cohérence temporelle étendue. L'idée est aussi simple que puissante : si vous entraînez explicitement un modèle sur la capacité à continuer des vidéos existantes, c'est-à-dire à générer des images successives qui conservent une cohérence avec les précédentes, ce modèle apprend implicitement à gérer de longues dépendances temporelles. C'est un peu la différence entre un sprinteur et un marathonien : le premier explose sur cent mètres, le second répartit son effort sur des distances qui feraient s'effondrer le sprinteur.

Meituan n'est pas un nom familier pour ceux qui ne suivent pas le marché technologique chinois, mais il s'agit de l'une des plus grandes plateformes de services locaux de Chine, avec des compétences approfondies en apprentissage automatique appliqué à des problèmes à l'échelle industrielle. L'équipe LongCat a travaillé sur ce projet en se concentrant sur un objectif élégant d'un point de vue technique : créer un modèle unifié capable de gérer trois tâches différentes, text-to-video, image-to-video et continuation de vidéo, sans architectures séparées ni pipelines compliqués. Un peu comme concevoir un moteur qui fonctionne aussi bien à l'essence, au diesel qu'à l'électricité, au lieu d'avoir trois moteurs différents.

Une architecture conçue pour la durée

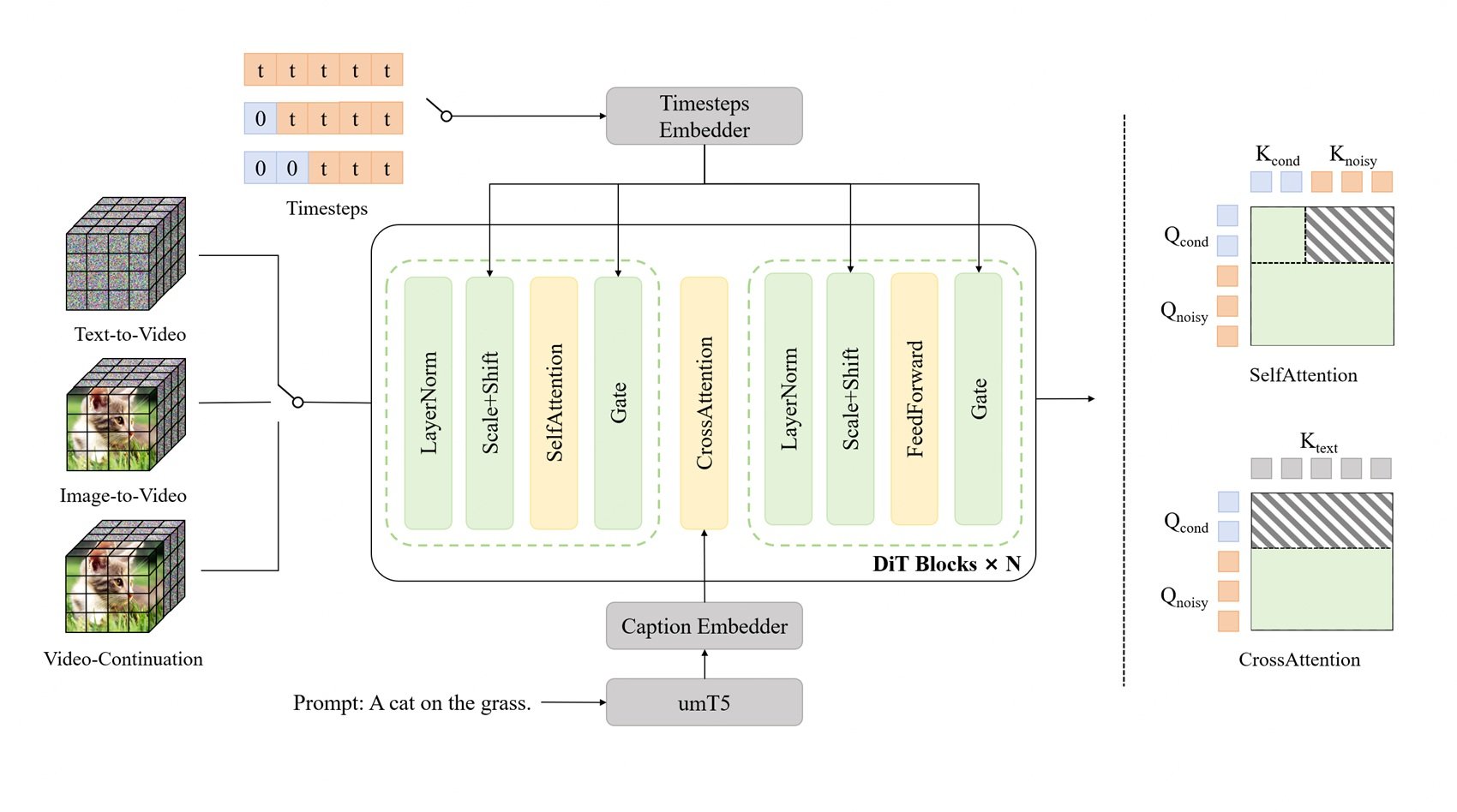

Sous le capot, LongCat-Video est basé sur un transformateur de diffusion, ou DiT, la même famille architecturale qui a fait de Sora une référence dans le secteur. Les DiT sont une variante des transformateurs originaux adaptés aux processus de diffusion, cette technique de génération qui fonctionne en ajoutant progressivement du bruit à une image puis en apprenant à le supprimer de manière contrôlée. Pensez à la restauration d'une fresque ancienne : d'abord, vous recouvrez tout d'une couche de saleté virtuelle, puis vous apprenez à l'enlever pour révéler l'image sous-jacente. Les modèles de diffusion font exactement cela, mais en sens inverse : ils partent du bruit pur et le "nettoient" jusqu'à obtenir l'image souhaitée.

Le problème avec les longues vidéos, c'est que chaque image ajoutée multiplie de façon exponentielle la complexité de calcul. Une vidéo de cinq minutes à 30 ips représente 9 000 images, et chaque image doit être cohérente avec toutes les autres. La mémoire requise explose, les temps de génération deviennent prohibitifs et le risque d'erreurs accumulées augmente. C'est comme jouer au téléphone arabe avec neuf mille personnes : même une erreur microscopique à l'image 100 s'amplifie de façon spectaculaire à l'image 9 000.

LongCat-Video résout ce problème avec l'attention parcimonieuse par blocs (Block Sparse Attention), un mécanisme qui, au lieu de faire en sorte que chaque image prête attention à toutes les autres images simultanément (une opération de calcul dévastatrice), crée des blocs d'attention locale. Chaque image prête attention principalement aux images voisines et à une sélection stratégique d'images éloignées. C'est comme regarder un panorama : vous avez une vision nette de ce qui est proche, une vision périphérique de ce qui se trouve sur les côtés et des points d'ancrage visuels sur la ligne d'horizon. Vous ne voyez pas tout avec la même netteté, mais le cerveau reconstruit une perception cohérente de l'espace. Le Block Sparse Attention fait la même chose avec les vidéos.

L'autre innovation clé est la stratégie "du grossier au fin" (coarse-to-fine), qui opère à la fois sur l'axe temporel et spatial. Au lieu de générer immédiatement des vidéos haute résolution avec toutes les images, le modèle génère d'abord une version basse résolution avec moins d'images, capturant la structure narrative et les mouvements principaux. Ensuite, dans une deuxième phase, il affine cette ébauche en augmentant progressivement la résolution spatiale et la fréquence d'images temporelle. C'est comme travailler sur une animation traditionnelle : d'abord, vous dessinez les images clés principales qui définissent les poses et les mouvements clés, puis vous ajoutez les intermédiaires qui rendent le tout fluide, et enfin vous coloriez et peaufinez les détails.

Cette stratégie n'est pas seulement efficace en termes de calcul, elle est aussi plus alignée sur la façon dont fonctionne la narration visuelle humaine. Lorsque vous imaginez une scène, vous ne la visualisez pas immédiatement image par image en 4K : vous avez d'abord une idée approximative de la composition, des mouvements principaux, de l'atmosphère générale. Ensuite, vous ajoutez des détails, perfectionnez les mouvements, définissez les textures. L'approche "du grossier au fin" reproduit ce processus cognitif.

Le pré-entraînement natif sur les tâches de continuation de vidéo est l'ingrédient secret qui lie le tout. Pendant l'entraînement, le modèle a vu des centaines de milliers d'heures de vidéo où la tâche n'était pas de générer à partir de zéro, mais de continuer des séquences existantes en maintenant une cohérence stylistique, narrative et physique. Il a appris ce que signifie la continuité temporelle de la manière la plus directe possible : en le faisant, de manière itérative, pendant des milliers d'heures. C'est comme apprendre à écrire des suites en lisant des romans puis en écrivant les chapitres suivants : on apprend implicitement ce que signifie maintenir une cohérence de ton, de personnages, de décor.

Trois tâches, un seul modèle

L'un des choix architecturaux les plus élégants de LongCat-Video est l'approche unifiée des trois tâches principales : la génération text-to-video à partir de zéro, l'animation image-to-video d'images statiques et la continuation de vidéo pour étendre les clips existants. La plupart des systèmes abordent ces tâches avec des modèles distincts ou des pipelines élaborés qui assemblent différents composants. LongCat-Video les gère tous en les distinguant simplement par le nombre d'images conditionnelles en entrée.

En text-to-video pur, le modèle part de zéro image conditionnelle et génère tout en se basant uniquement sur l'invite textuelle. C'est le cas d'utilisation le plus difficile car vous n'avez pas d'ancrages visuels, vous devez créer la composition, les mouvements, le style et la cohérence exclusivement à partir de l'interprétation du texte. C'est comme dire à quelqu'un "peins-moi une tempête en mer" sans montrer de références : il doit tout imaginer.

En image-to-video, vous fournissez une image initiale comme condition et le modèle génère les images suivantes qui animent cette image. Ici, la tâche est plus contrainte : vous avez déjà la composition, le style, l'éclairage définis par l'image initiale, il vous suffit d'ajouter un mouvement cohérent. C'est comme si la première prise d'un film était déjà tournée et que vous deviez décider de la suite de la scène.

En continuation de vidéo, vous fournissez un segment vidéo entier et demandez au modèle de le prolonger. C'est techniquement le cas le plus contraint mais il exige une cohérence temporelle maximale : vous devez respecter non seulement le style et la composition, mais aussi la physique des mouvements déjà présents, la trajectoire des objets, l'évolution de la scène. C'est comme écrire le troisième acte d'une histoire dont les deux premiers sont déjà écrits : vous avez une marge de créativité, mais vous devez respecter les personnages, l'intrigue et le ton déjà établis.

L'architecture unifiée signifie que le modèle n'a pas besoin de modules distincts pour gérer ces cas. En interne, le text-to-video est simplement une continuation de vidéo avec zéro image conditionnelle, l'image-to-video est une continuation de vidéo avec une image conditionnelle, et ainsi de suite. Cela réduit non seulement la complexité technique, car vous maintenez une seule base de code et un seul pipeline d'entraînement, mais cela améliore également la qualité car le modèle partage les représentations et les capacités entre les différentes tâches. Les compétences acquises pour prolonger de longues vidéos aident à la génération à partir de zéro, et vice versa.

Pour les développeurs et les chercheurs, cette approche est une bénédiction. Au lieu de devoir configurer des pipelines complexes qui appellent différents modèles pour différentes tâches, vous installez un seul modèle et changez simplement le nombre d'images que vous fournissez en entrée. Vous voulez générer à partir du texte ? Zéro image. Vous voulez animer une image ? Une image. Vous voulez prolonger une vidéo ? La vidéo entière. La simplicité est sous-estimée en ingénierie logicielle, mais quiconque a débogué des pipelines complexes sait à quel point il est avantageux d'avoir moins de composants en mouvement.

Les chiffres parlent, mais ne crient pas

Lorsqu'il s'agit de modèles génératifs, les benchmarks sont un terrain miné. Chaque entreprise a ses propres tests internes, optimisés pour faire briller ses modèles, et les tests publics comme VBench tentent d'offrir des évaluations objectives mais ne capturent que certaines dimensions de la qualité perçue. LongCat-Video navigue dans ces chiffres avec des résultats solides mais pas époustouflants, ce qui est exactement ce que l'on attend d'un modèle open source développé avec une fraction des ressources des géants de la technologie.

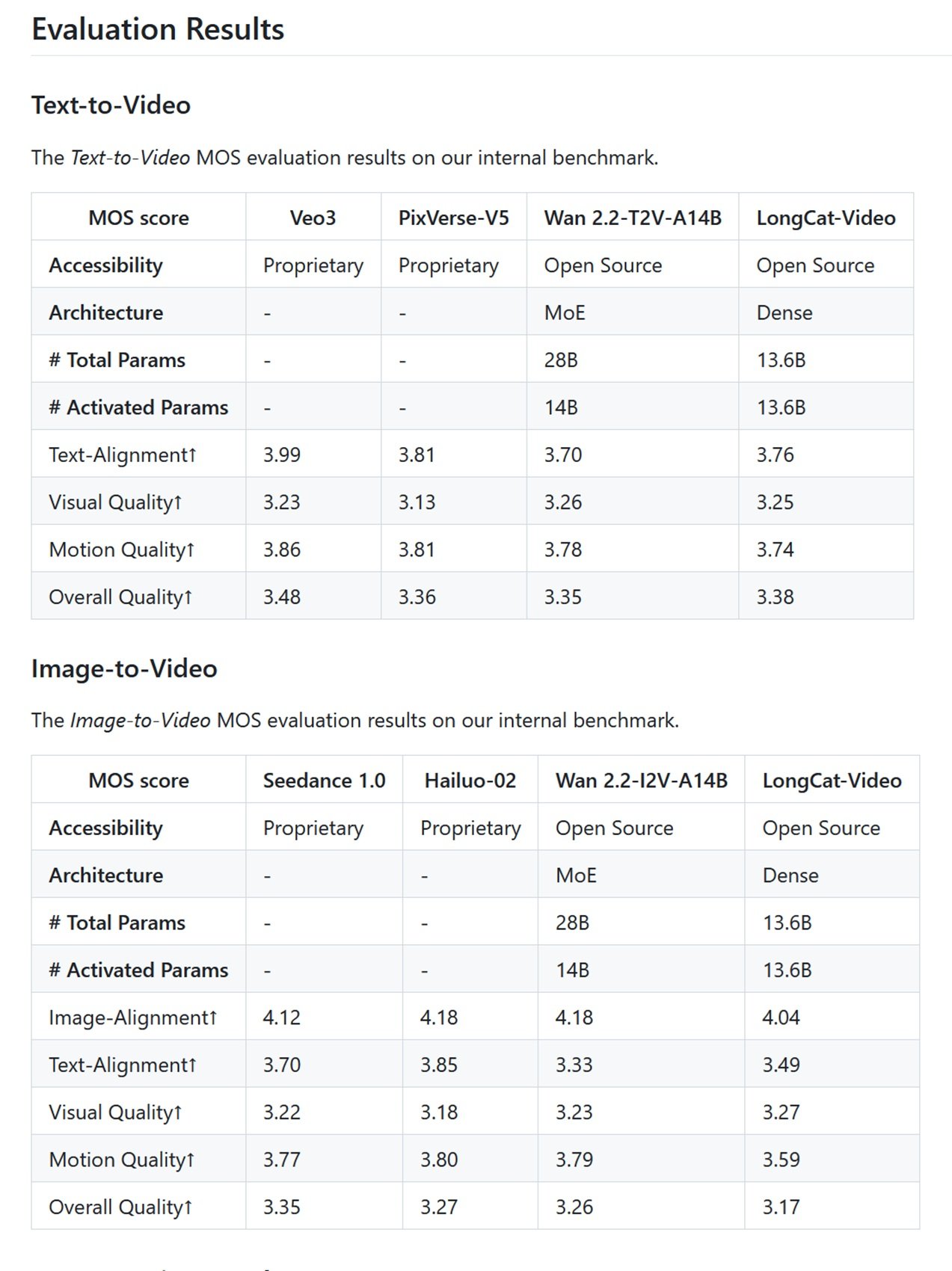

Sur les benchmarks internes de Meituan basés sur le score d'opinion moyen (Mean Opinion Score), où des évaluateurs humains jugent des vidéos sur une échelle de 1 à 5, LongCat-Video obtient 3,25 pour la qualité visuelle en text-to-video et 3,27 en image-to-video. Pour situer le contexte : Veo 3 obtient 3,51, Sora 2 est à 3,49. Ce n'est pas un écart énorme, mais il existe. Dans les métriques d'alignement du texte, où l'on mesure la correspondance entre la vidéo générée et l'invite textuelle, LongCat-Video obtient 3,76, tandis que les principaux acteurs propriétaires frôlent les 4,0. En bref, le modèle est compétitif mais ne domine pas.

Sur VBench, le benchmark public le plus respecté du secteur qui évalue 16 dimensions différentes de la qualité vidéo, LongCat-Video se comporte particulièrement bien en matière de cohérence temporelle et de compréhension du bon sens, où il se classe premier parmi les modèles open source avec un score de 70,94 %. C'est significatif car le bon sens, la capacité à générer des vidéos qui respectent la physique, la logique spatiale et la cohérence narrative de base, est traditionnellement le talon d'Achille des modèles génératifs. Un modèle peut générer des textures photoréalistes et des mouvements fluides, mais s'il fait passer une personne à travers un mur ou léviter des objets sans raison, le résultat est déroutant.

La comparaison avec les concurrents open source révèle un scénario intéressant. HunyuanVideo, qui a une taille similaire avec environ 13 milliards de paramètres, est optimisé pour des vidéos plus courtes mais avec une qualité visuelle légèrement supérieure sur des clips de trois secondes. Mochi se concentre sur la vitesse de génération avec 10 milliards de paramètres et une architecture asymétrique qui privilégie l'efficacité. Open-Sora, la tentative de la communauté de répliquer l'architecture originale d'OpenAI, est à la traîne sur presque toutes les métriques. CogVideoX-5B, développé par l'Université de Tsinghua, a des performances comparables à celles de LongCat sur les vidéos courtes mais ne prend pas en charge les générations de plus de dix secondes. LTX-Video de Lightricks a introduit la promesse de la génération en temps réel, mais avec des vidéos limitées à quelques secondes.

Comme nous l'avons déjà évoqué dans l'article sur Ovi et l'écosystème open source de la génération vidéo, le paysage est fragmenté entre des projets qui optimisent la qualité absolue, la vitesse de génération ou la durée des vidéos. LongCat-Video s'insère dans ce paysage avec une proposition claire : je ne suis pas le plus rapide, je ne suis pas le plus photoréaliste, mais je peux générer de longues vidéos en maintenant la cohérence. C'est un positionnement intelligent, car la durée est encore un différenciateur fort. Ovi a démontré l'importance de l'intégration audio-vidéo native, CogVideoX a misé sur la cohérence temporelle sur dix secondes, LongCat-Video étend cette capacité à plusieurs minutes.

Le point critique est qu'aucun de ces modèles open source ne bat encore les systèmes propriétaires en qualité absolue. Sora 2 génère des vidéos plus photoréalistes, Veo 3 a un style cinématographique plus raffiné, Movie Gen intègre l'audio et la musique avec une qualité professionnelle. Mais tous ces modèles sont des boîtes noires inaccessibles, fermées derrière des API payantes ou des listes d'attente interminables. Vous ne pouvez pas les étudier, vous ne pouvez pas les modifier, vous ne pouvez pas vérifier sur quelles données ils ont été entraînés. C'est comme un buffet à volonté où la nourriture semble meilleure mais vous ne savez pas ce qu'il y a dedans, alors qu'au restaurant open source, vous voyez la cuisine ouverte et connaissez chaque ingrédient.

Open source, mais à quel prix ?

Dire que LongCat-Video est open source semble démocratique et accessible, mais la réalité matérielle raconte une histoire plus nuancée. Pour générer des vidéos à 720p et 30 ips dans un délai raisonnable, il faut au moins 60 Go de VRAM, ce qui signifie des configurations multi-GPU ou des cartes de niveau entreprise comme les NVIDIA A100 ou H100. Une seule A100 coûte le prix d'une citadine d'occasion, et même avec des optimisations comme la quantification 8 bits qui réduit les besoins à environ 18 Go sur une RTX 4090, on parle toujours de matériel haut de gamme pour passionnés.

Cela soulève la question cruciale : démocratiser le code mais exiger du matériel à quatre ou cinq mille euros, est-ce une véritable démocratisation ou juste une illusion pour ceux qui peuvent se permettre les GPU ? La réponse dépend de qui vous êtes. Pour un amateur seul ou un créatif indépendant, LongCat-Video reste probablement hors de portée à moins d'utiliser des services cloud, ce qui réintroduit des coûts mensuels pas très éloignés des abonnements aux modèles propriétaires. Pour un studio de création de petite ou moyenne taille, un laboratoire universitaire ou une startup technologique, dépenser quelques milliers d'euros en matériel est un investissement ponctuel qui donne un contrôle total et des coûts d'exploitation prévisibles. Pas d'abonnements qui augmentent, pas d'API qui changent de conditions, pas de risque que le service soit interrompu.

La licence MIT sous laquelle est publié LongCat-Video est la plus permissive possible : vous pouvez l'utiliser commercialement, le modifier, l'intégrer dans des produits propriétaires, sans redevances ni contraintes d'attribution obligatoires au-delà de l'avis de droit d'auteur. C'est la licence qui dit "faites ce que vous voulez, c'est la liberté maximale que nous pouvons vous donner". En comparaison, certains modèles open source utilisent des licences plus restrictives qui limitent l'utilisation commerciale ou imposent des clauses de partage des modifications.

Le dépôt GitHub contient non seulement les poids du modèle mais aussi la documentation complète pour l'entraînement, l'inférence et le réglage fin. Il y a des exemples de code pour chaque tâche prise en charge, des scripts pour l'optimisation sur différentes configurations matérielles, et même des guides pour le déploiement en production. Ce n'est pas du "plug-and-play" comme ouvrir un navigateur et utiliser Sora, mais c'est complet et bien documenté. Une équipe ayant des compétences en apprentissage automatique peut être opérationnelle en quelques jours, et non en quelques mois.

La véritable accessibilité de l'open source dans l'IA vidéo passe cependant par une réduction progressive des besoins matériels, ce qui s'est toujours produit historiquement. Les modèles de transformateurs de langage qui nécessitaient des fermes de serveurs il y a cinq ans fonctionnent aujourd'hui sur des ordinateurs portables. L'optimisation logicielle, les techniques de quantification, les accélérateurs spécialisés compriment constamment les besoins. Dans un an, LongCat-Video ou ses descendants pourraient fonctionner sur des configurations grand public de milieu de gamme. Dans deux ans, peut-être sur des smartphones phares. La trajectoire technologique va toujours vers la miniaturisation et l'efficacité.

En attendant, LongCat-Video n'est pas le messie qui démocratise la génération vidéo par IA pour tous, mais c'est un pas concret vers des vidéos génératives longues, accessibles et modifiables pour ceux qui ont les compétences et les ressources pour l'utiliser. C'est une contribution importante à cet écosystème open source qui, comme la scène indépendante du début des années 2000, construit des alternatives concrètes aux produits grand public non pas pour les surpasser en budget ou en paillettes, mais pour offrir liberté, contrôle et transparence à ceux qui les recherchent. Et parfois, comme l'enseigne l'histoire de la technologie, ce sont précisément ces alternatives de "garage band" qui inventent les idées qui deviendront grand public demain.