Le Duel de l'Ère Numérique : L'IA tuera-t-elle les Programmeurs ?

Entre les prophéties apocalyptiques d'Eric Schmidt et le réalisme pragmatique des experts du secteur, où s'arrête le battage médiatique et où commence la réalité ?

Si l'industrie technologique était un film de science-fiction, nous serions en train de vivre cette scène cruciale où les robots commencent à remplacer les humains. Mais contrairement à "Blade Runner" ou "I, Robot", il n'y a ni Harrison Ford ni Will Smith pour sauver la situation. Il n'y a qu'Eric Schmidt, ancien PDG de Google, qui prophétise la fin des programmeurs d'ici un an, et de l'autre côté des experts comme Salvatore Sanfilippo qui lèvent les mains en criant "Un instant, arrêtez tout !".

La bataille a commencé, et les projectiles sont des déclarations au vitriol, des recherches universitaires et beaucoup, beaucoup de confusion. Dans cette guerre de bits et d'algorithmes, cependant, la vérité est décidément plus complexe que ce que les titres sensationnalistes veulent nous faire croire. Allons-y dans l'ordre, car lorsqu'on parle de l'avenir de millions de développeurs dans le monde, chaque mot compte.

Le Prophète de l'Apocalypse : Les Visions d'Eric Schmidt

Eric Schmidt n'est pas n'importe qui qui parle depuis le café du coin. C'est l'homme qui a dirigé Google pendant une décennie, transformant un moteur de recherche universitaire en le géant technologique qui domine le web. Quand il parle, le secteur écoute. Et ce qu'il a dit récemment a fait dresser les cheveux sur la tête de plus d'un programmeur.

"Nous, en tant que secteur, pensons que l'année prochaine, la grande majorité des programmeurs seront remplacés par des programmeurs IA", a déclaré Schmidt avec l'assurance de quelqu'un qui a vu naître et grandir l'ère numérique. Il ne s'est pas arrêté là : il a prédit des mathématiciens de niveau universitaire créés par l'intelligence artificielle et un avenir où se demander "dans quel langage programmes-tu ?" devient une question aussi obsolète que "combien de tours fait ton disque vinyle ?".

Sa vision du monde est celle d'un avenir dominé par des "agents" IA qui gèrent tout, de l'achat d'une maison aux poursuites judiciaires contre l'entrepreneur défaillant. Schmidt décrit ce scénario avec le naturel de quelqu'un qui commande un café : "Je veux acheter une autre maison. Je dis : 'Trouve-moi une maison dans la région métropolitaine de DC. Regarde les règlements de construction'. C'est un agent. 'Examine toutes les normes. Découvre la taille de la maison que je peux construire'. C'est un autre agent." Le processus se poursuit jusqu'à la chute finale qui sonne comme une punchline de sitcom : "à la fin, tu poursuis l'entrepreneur pour manquement".

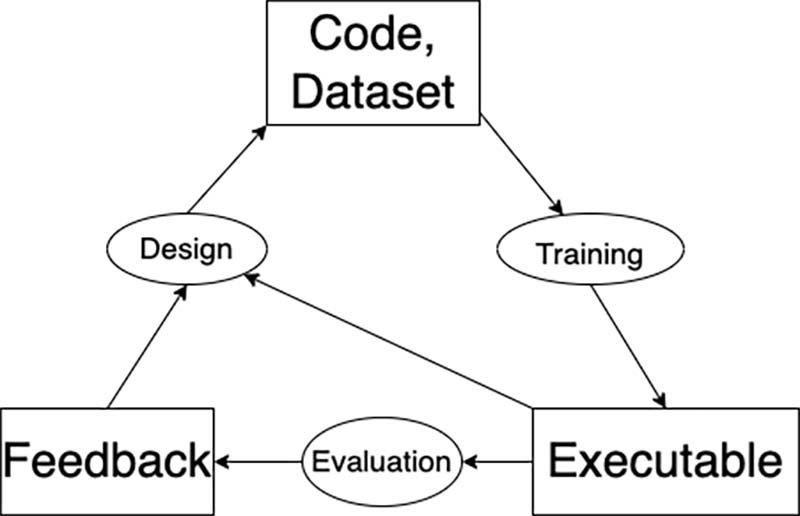

Le cœur de son argumentation réside dans ce qu'il appelle "l'auto-amélioration récursive". Selon Schmidt, aujourd'hui déjà, environ 10 à 20 % du code développé par les laboratoires de recherche d'OpenAI et d'Anthropic est généré automatiquement par leurs propres systèmes. C'est un peu comme si HAL 9000 de "2001 : L'Odyssée de l'espace" avait appris non seulement à parler, mais aussi à se reprogrammer lui-même.

Mais Schmidt, avec une blague qui trahit peut-être plus de vérité qu'il ne le voudrait, définit tout cela comme "le consensus de San Francisco parce que tous ceux qui y croient sont à San Francisco. C'est peut-être l'eau". Une phrase qui fait sourire mais qui cache une question inquiétante : assistons-nous vraiment à une révolution mondiale ou sommes-nous dans une bulle technologique qui déforme la perception de la réalité ?

La Voix de la Dissidence : Sanfilippo et le Réalisme Technique

De l'autre côté du ring intellectuel, Salvatore Sanfilippo - créateur de Redis et l'une des voix les plus autorisées dans le monde du développement logiciel - contre-attaque avec des arguments qui plongent leurs racines dans l'expérience directe du code. Dans son intervention vidéo, Sanfilippo démonte pièce par pièce les prédictions apocalyptiques, en faisant appel à Matt Garman, PDG d'Amazon Web Services, comme témoin d'exception.

La thèse de Sanfilippo est aussi simple que dévastatrice pour les prophètes du malheur technologique : programmer, ce n'est pas seulement écrire du code. C'est comprendre des problèmes complexes, les traduire en solutions élégantes, gérer des équipes, communiquer avec des clients qui ne savent souvent même pas ce qu'ils veulent vraiment. C'est comme la différence entre savoir jouer du piano et composer une symphonie : techniquement, on utilise les mêmes touches, mais l'univers créatif et intellectuel qui sépare les deux activités est abyssal.

Garman, qui dirige la plus grande plateforme cloud au monde, maintient une approche pragmatique qui fait contrepoids aux visions schmidtiennes. Tout en reconnaissant que l'IA changera la façon de programmer, il ne parle pas de remplacement total mais d'évolution du rôle. C'est un peu comme lorsque les traitements de texte ont remplacé les machines à écrire : les journalistes n'ont pas disparu, ils ont simplement changé d'outils de travail.

L'argument de Sanfilippo touche au cœur du problème : l'IA actuelle excelle à générer du code lorsque le problème est bien défini, mais le travail du programmeur commence bien avant d'ouvrir l'éditeur de texte. Il commence lorsque le client dit "je veux une application comme Facebook mais pour les chats" et que le développeur doit transformer cette demande surréaliste en spécifications techniques concrètes.

Le Chœur des Experts : Voix du Front Technologique

Le débat s'enrichit d'autres voix autorisées, créant un chœur qui va du catastrophisme à l'optimisme prudent. Emad Mostaque, ancien PDG de Stability AI, rejoint le camp des pessimistes avec une prédiction encore plus radicale : selon ses déclarations, d'ici cinq ans, il n'y aura plus de programmeurs humains. Mostaque cite un chiffre qui donne à réfléchir : 41 % du code sur GitHub est déjà généré par l'intelligence artificielle.

Cependant, en bon Sherlock Holmes technologique, je n'ai pas retrouvé le chiffre spécifique de 41 % cité par Mostaque. La plateforme GitHub parle plutôt de mesures différentes : une augmentation de 55 % de la vitesse d'accomplissement des tâches et des améliorations qualitatives sur huit dimensions différentes du code. Mais le point n'est pas tant l'exactitude du chiffre que le concept qui le sous-tend. Comme c'est souvent le cas dans le monde de la technologie, les chiffres précis deviennent moins importants que la direction de la tendance, et cette direction est aussi sans équivoque qu'une scène de poursuite dans un film d'action : l'IA gagne du terrain à une vitesse impressionnante.

Mais ces chiffres, apparemment écrasants, méritent une analyse plus approfondie. C'est comme dire que 41 % des mots de cet article ont été suggérés par le correcteur orthographique de l'ordinateur : techniquement, cela pourrait être vrai, mais c'est fondamentalement sans pertinence pour le processus créatif et intellectuel qui sous-tend l'écriture. Le code généré par l'IA est souvent du boilerplate, des fonctions standard, des extraits répétitifs - la partie mécanique du travail, pas celle qui demande de l'ingéniosité et de la créativité.

Jensen Huang de Nvidia, pour sa part, ajoute une pièce intéressante au puzzle en soutenant que l'IA pourrait éliminer la nécessité d'étudier la programmation au sens traditionnel. Mais là aussi, comme c'est souvent le cas dans les déclarations des PDG des grandes entreprises technologiques, il y a une simplification qui sent le marketing. C'est un peu comme dire que, comme il existe des navigateurs GPS, il n'est plus nécessaire de savoir lire une carte : vrai jusqu'à ce que le satellite perde le signal.

Les voix plus modérées du secteur, comme le rapportent plusieurs analyses spécialisées, parlent de collaboration homme-machine plutôt que de remplacement complet. Il est intéressant de noter une tendance : plus les experts sont proches du code au quotidien, plus ils ont tendance à être sceptiques quant aux prédictions apocalyptiques. C'est comme si ceux qui ont les mains dans le cambouis savaient faire la différence entre la farine et le pain fini.

La Réalité des Chiffres : Décrypter le Code des Données

Lorsqu'on parle de révolutions technologiques, les chiffres peuvent être des alliés précieux ou des ennemis insidieux, selon la façon dont on les interprète. Le fameux chiffre cité par Mostaque - 41 % du code sur GitHub généré par l'IA - mérite une analyse forensique digne de "CSI : Cyber".

Ce chiffre, impressionnant à première vue, ne raconte qu'une partie de l'histoire. Il est vrai que l'IA excelle à générer du code standardisé, des fonctions communes, des modèles répétitifs. Mais c'est un peu comme dire qu'un orchestre a été remplacé parce que 41 % des notes jouées sont des Do, des Ré et des Mi. Les notes sont importantes, mais la symphonie naît de l'arrangement, de l'interprétation, de la créativité qui les relie.

Le concept d'"auto-amélioration récursive" que Schmidt présente comme la clé de voûte de l'avenir mérite un examen technique plus sérieux. L'idée que l'IA puisse s'améliorer de manière récursive jusqu'à atteindre une superintelligence est aussi fascinante que controversée. C'est le Saint Graal de l'intelligence artificielle, mais aussi son Frankenstein. Les experts en alignement de l'IA sont divisés : certains voient ce scénario comme inévitable et imminent, d'autres le considèrent comme un mirage à des années-lumière de la réalité actuelle.

La vérité, comme c'est souvent le cas en science, se situe probablement dans une zone grise. L'IA actuelle est très douée pour les tâches spécifiques et bien définies, mais elle a encore du mal avec la compréhension contextuelle, la créativité authentique, la gestion de l'ambiguïté - toutes des compétences qui sont le pain quotidien d'un programmeur expérimenté.

Le Paradoxe de l'Automatisation : Quand les Robots ont Besoin des Humains

Il y a un paradoxe fascinant dans l'histoire de la technologie qui mérite d'être raconté : plus nous automatisons les processus, plus nous avons besoin de personnes qualifiées pour gérer l'automatisation. C'est comme dans "Matrix" - quelqu'un doit bien programmer la Matrice, non ? Et ce quelqu'un, pour l'instant, c'est encore nous, les humains.

Chaque révolution technologique de l'histoire a suivi ce schéma : elle a détruit certains emplois, en a transformé d'autres et en a créé de entièrement nouveaux. Les tisserands du XIXe siècle craignaient que les métiers à tisser mécaniques ne les mettent tous au chômage, et pourtant l'industrie textile moderne emploie des millions de personnes dans le monde. Des rôles différents, des compétences différentes, mais toujours des personnes.

Dans le cas de la programmation, nous assistons à une transformation similaire. Les programmeurs de demain n'écriront peut-être pas du code ligne par ligne comme le faisaient leurs collègues des années 80. Ils pourraient devenir des "chuchoteurs d'IA", des spécialistes de la communication avec l'intelligence artificielle, de la définition d'architectures complexes, de la gestion de l'interaction entre les systèmes automatisés et les besoins humains réels.

C'est un peu comme l'évolution des premiers ordinateurs gigantesques qui occupaient des pièces entières aux smartphones modernes. La technologie a radicalement changé, mais le besoin de personnes qui comprennent comment l'utiliser, comment l'optimiser, comment résoudre les problèmes lorsqu'elle se bloque, est resté intact. En fait, il a augmenté.

La programmation du futur ressemblera probablement plus à la réalisation cinématographique : le réalisateur ne filme pas personnellement chaque plan, ne déplace pas chaque caméra, n'enregistre pas chaque réplique. Mais il a la vision d'ensemble, coordonne des spécialistes, prend des décisions créatives et techniques qu'aucune machine ne peut prendre à sa place. Spielberg utilise des effets spéciaux informatisés, mais "E.T." continue d'émouvoir le public pour des raisons qui vont bien au-delà de la technologie utilisée pour le créer.

Au-delà de la Prophétie : Scénarios Réalistes pour l'Avenir

Essayons d'imaginer des scénarios plus réalistes, moins hollywoodiens que les prédictions apocalyptiques mais aussi moins conservateurs que le "rien ne changera jamais". Au cours de la prochaine décennie, nous assisterons probablement à une stratification du marché du travail dans la programmation.

Au niveau de base, de nombreuses tâches répétitives seront effectivement automatisées. De même que les guichets automatiques ont réduit le nombre de caissiers mais n'ont pas éliminé les banques, l'IA réduira la demande pour certains types de programmation de routine. Les développeurs juniors qui se limitaient à mettre en œuvre des spécifications détaillées pourraient se trouver en difficulté.

Au niveau intermédiaire, de nouvelles figures professionnelles émergeront : des ingénieurs de prompts, des formateurs d'IA, des développeurs hybrides qui sauront orchestrer des systèmes d'intelligence artificielle pour créer des solutions complexes. C'est comme lorsque les concepteurs de sites web sont nés dans les années 90 - une profession qui n'existait pas auparavant mais qui est devenue essentielle avec l'évolution de la technologie.

Au niveau supérieur, les architectes système, les responsables techniques et les directeurs techniques continueront d'être fondamentaux. Les outils peuvent changer, mais le besoin de personnes qui comprennent les systèmes complexes, qui savent traduire les besoins de l'entreprise en solutions techniques, qui gèrent des équipes et des projets, restera intact. C'est comme dire que l'existence du GPS n'a pas éliminé le besoin d'ingénieurs civils pour concevoir les routes.

La Leçon de l'Histoire : Des Machines à Vapeur à l'IA

L'histoire de la technologie nous offre de précieuses leçons pour interpréter le moment actuel. Lorsque les premiers appareils photo sont arrivés, les peintres ont craint pour leur avenir. Résultat ? La peinture n'a pas disparu, elle a évolué. L'impressionnisme, l'expressionnisme, l'art abstrait sont nés. Les peintres ont cessé de se limiter à reproduire la réalité et ont commencé à l'interpréter.

Lorsque les ordinateurs ont commencé à faire des calculs complexes, de nombreux mathématiciens ont craint de devenir obsolètes. Résultat ? Les mathématiques sont devenues plus puissantes, plus créatives, plus ambitieuses. Les mathématiciens ont cessé de perdre du temps en calculs répétitifs et ont commencé à explorer des théorèmes plus complexes, à développer de nouvelles branches de la science.

La programmation pourrait suivre une trajectoire similaire. Les développeurs du futur pourraient cesser de se soucier de la syntaxe et se concentrer sur l'architecture, l'expérience utilisateur, l'innovation. Ils pourraient devenir plus semblables à des compositeurs qu'à des copistes, plus semblables à des chefs qu'à des cuisiniers.

Conclusions : Néo, il n'y a pas de cuillère

À la fin de ce voyage entre prophéties technologiques et réalité quotidienne, une vérité aussi simple que profonde émerge : il n'y a pas de cuillère. Comme le dirait Néo dans "Matrix", le problème n'est pas de plier la cuillère, c'est de comprendre que la cuillère n'existe pas. Il n'y a pas de remplacement net, total, immédiat. Il y a une évolution continue, complexe, pleine de nuances.

Eric Schmidt a raison lorsqu'il parle de transformation radicale. L'IA changera la façon de programmer plus profondément que beaucoup ne l'imaginent. Mais il se trompe sur le calendrier et les modalités. La révolution ne sera pas une explosion, ce sera une évolution. Ce ne sera pas un "game over" pour les programmeurs, ce sera un "level up" pour tout le secteur.

Salvatore Sanfilippo a raison lorsqu'il souligne la complexité du travail de développement. Programmer, c'est bien plus qu'écrire du code, et cette complexité protégera de nombreux professionnels du remplacement automatique. Mais peut-être sous-estime-t-il la vitesse du changement technologique et la capacité de l'IA à apprendre même des tâches complexes.

La vérité, comme toujours lorsqu'il s'agit de l'avenir, se situe au milieu. Les programmeurs de demain seront différents de ceux d'aujourd'hui, ils utiliseront des outils différents, ils feront face à des défis différents. Mais ils continueront d'exister, car derrière chaque système automatisé, il y a toujours besoin d'intelligence humaine pour le concevoir, le gérer, l'améliorer.

Comme toutes les évolutions biologiques et technologiques, les plus adaptables survivront, pas les plus forts. Ceux qui sauront surfer sur la vague de l'IA au lieu de la subir, ceux qui apprendront à collaborer avec les machines au lieu de rivaliser avec elles, ceux qui conserveront la curiosité et la capacité d'apprendre en continu, auront un avenir radieux devant eux.

Le grand duel entre les programmeurs et l'intelligence artificielle, au final, pourrait se révéler être ce qu'il a toujours été : non pas une guerre, mais une danse. Et dans les meilleures danses, des partenaires différents se déplacent ensemble, chacun avec ses propres forces, créant quelque chose de plus beau que ce qu'ils pourraient créer seuls.