Les Small Language Models vont-ils conquérir 2026 ?

Andy Markus est le Chief Data Officer d'AT&T, pas vraiment du genre à se laisser emporter par l'enthousiasme. Lorsqu'il a déclaré dans une interview fin 2025 que les Small Language Models affinés deviendraient "la grande tendance de 2026", de nombreux observateurs ont haussé un sourcil. Pourtant, ce sourcil pourrait être justifié : 2025 a marqué un revirement par rapport au mantra "plus c'est gros, mieux c'est" qui a dominé l'IA ces trois dernières années.

C'est le même changement de paradigme que nous avons documenté lorsque le MIT a démontré comment les modèles peuvent apprendre à penser moins et mieux grâce à l'allocation dynamique des ressources, ou lorsque Harvard a révélé que les capacités de raisonnement étaient déjà présentes dans les modèles de base, il suffisait de les extraire de la bonne manière. Même des géants comme Samsung et Microsoft ont investi dans des techniques qui privilégient l'intelligence algorithmique à la force brute, comme le montrent l'approche TRM pour la recherche ciblée et DeepConf pour l'auto-correction basée sur la confiance. La question est maintenant la suivante : les SLM représentent-ils une avancée pragmatique ou une énième bulle destinée à se dégonfler ? Et surtout, qui gagne et qui perd dans ce nouvel équilibre ?

Anatomie d'un modèle compact

Définir ce qu'est un Small Language Model n'est pas aussi trivial qu'il y paraît. Si vous demandez à dix chercheurs, vous obtiendrez au moins douze réponses différentes. Le seuil le plus communément accepté se situe autour de dix milliards de paramètres, mais c'est une convention aussi arbitraire que la limite entre une planète naine et une planète. Ce qui compte vraiment, c'est la déployabilité : un SLM est un modèle conçu pour fonctionner efficacement sur du matériel grand public ou des appareils de pointe, en consommant peu de mémoire et en produisant des réponses avec une latence inférieure à la seconde.

Contrairement aux LLM, qui sont essentiellement des modèles de transformateurs mis à l'échelle à un degré incroyable et entraînés sur des téraoctets de données, les SLM sont nés d'une refonte architecturale. La technique la plus courante est la distillation des connaissances : un modèle "enseignant" massif transfère ses connaissances à un "étudiant" compact, qui apprend à reproduire le comportement du géant en utilisant une fraction des ressources. C'est comme si Richard Feynman avait compressé ses connaissances en physique dans un livret de poche sans en perdre l'essence. Mais cela ne s'arrête pas là. L'élagage élimine les connexions neuronales redondantes, comme un jardinier qui taille un arbre pour le faire pousser plus sainement. La quantification réduit la précision numérique des poids : au lieu de représenter chaque nombre avec 32 bits, vous en utilisez 8, 4, ou même 1,58 bit comme dans le récent BitNet, ce qui donne des modèles qui occupent un dixième de l'espace d'origine avec des pertes de précision étonnamment faibles.

Les architectures hybrides représentent la frontière la plus intéressante. Des modèles comme le Samba-CoE de SambaNova Systems combinent des modèles d'espace d'états, qui traitent les séquences de manière linéaire sans l'explosion de complexité quadratique typique de l'attention, avec des mécanismes d'attention sélective appliqués uniquement là où c'est nécessaire. Le résultat est des modèles qui peuvent s'adapter à des contextes de millions de jetons tout en maintenant une vitesse d'inférence presque constante. Ce ne sont pas des LLM rétrécis : ce sont des systèmes repensés de A à Z pour maximiser le rapport performance/efficacité.

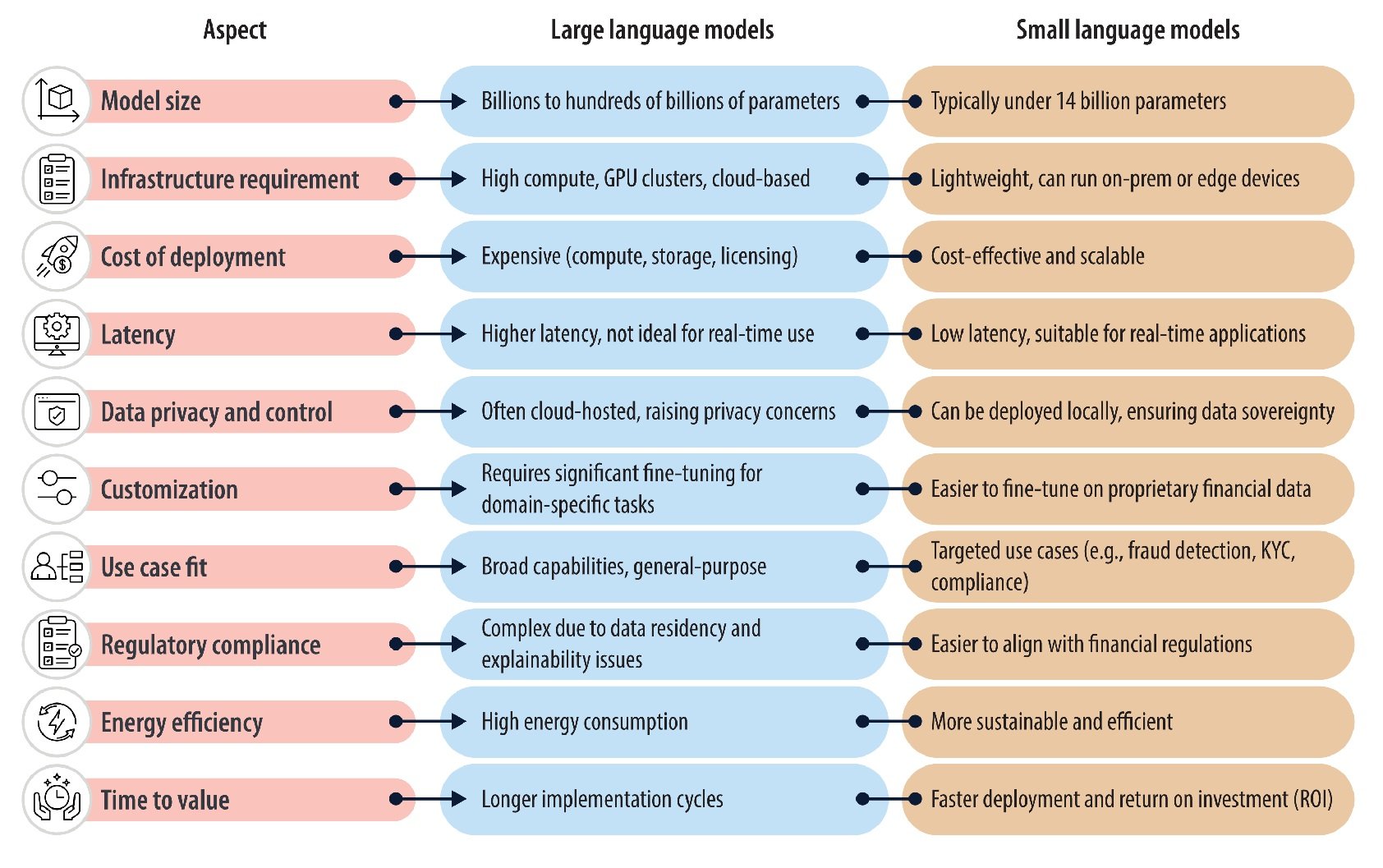

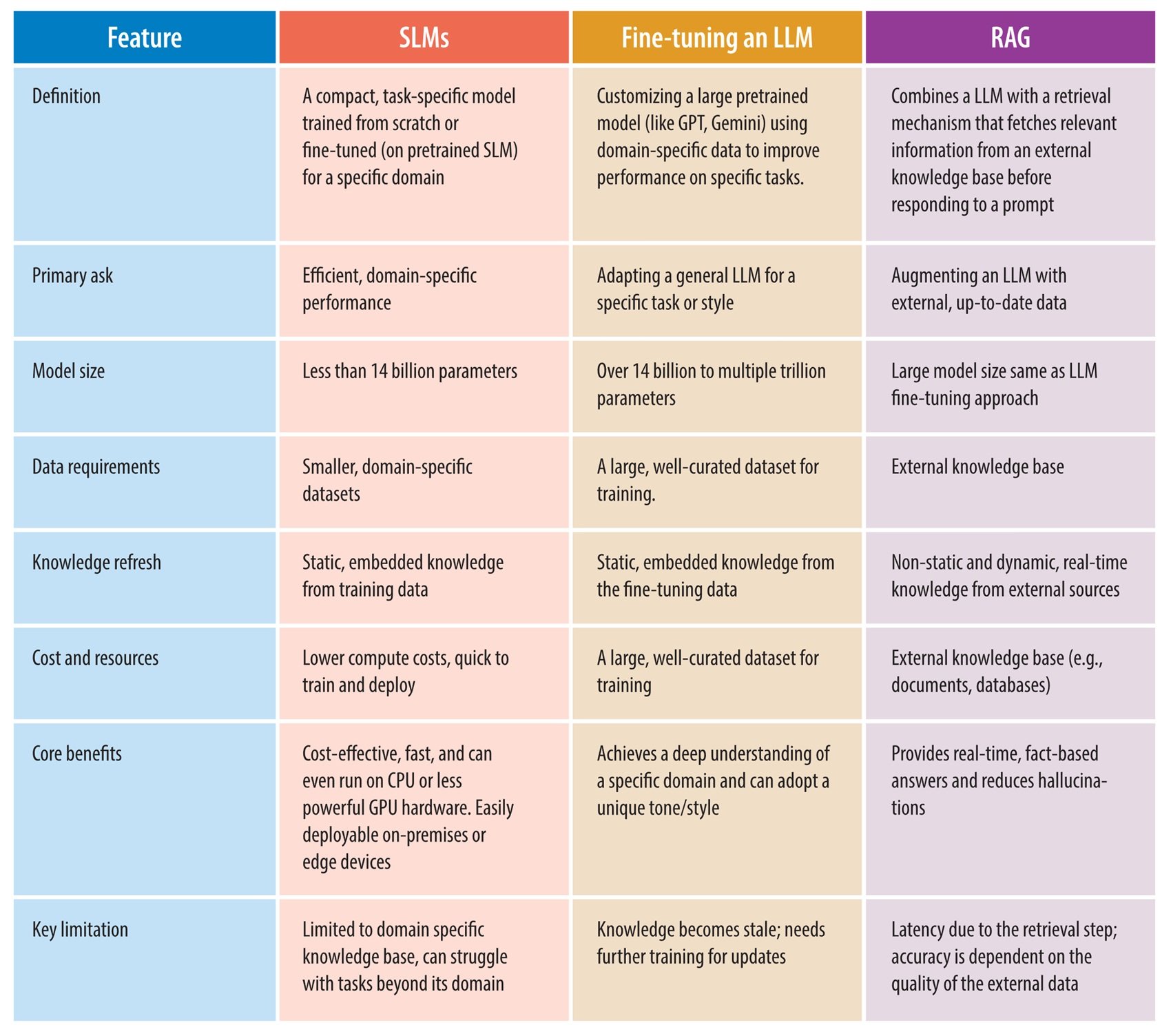

La comparaison qui compte : SLM vs LLM

Les différences structurelles se traduisent par des compromis opérationnels précis. Sur le plan des performances pures, l'écart s'est considérablement réduit au cours des douze derniers mois. Le Phi-3.5-Mini de Microsoft, avec ses trois virgule huit milliards de paramètres, égale le GPT-3.5 sur des benchmarks mathématiques comme le GSM8K en utilisant quatre-vingt-dix-huit pour cent de puissance de calcul en moins, selon des données publiées par Microsoft Research à la mi-2025. Le Llama 3.2 de trois milliards de paramètres bat des modèles de soixante-dix milliards sur des tâches spécifiques à un domaine après un affinage ciblé. Mais lorsqu'il s'agit de raisonnement complexe multi-domaines ou de requêtes nécessitant une vaste connaissance générale, les LLM conservent un net avantage : GPT-4 ou Claude Sonnet résolvent des problèmes qui nécessitent des concaténations logiques profondes avec une précision qu'aucun SLM actuel n'atteint en mode zéro-shot.

La latence est le domaine où les SLM brillent sans compromis. Un modèle de sept milliards de paramètres génère des jetons en temps réel sur un seul GPU grand public, avec des retards mesurables en dizaines de millisecondes. Un modèle de cent cinquante milliards de paramètres nécessite des clusters multi-GPU et introduit des retards de plusieurs secondes rien que pour initialiser l'inférence. Pour les applications en temps réel comme les assistants vocaux, le contrôle robotique ou la surveillance industrielle, cette différence n'est pas négligeable : c'est la frontière entre l'utilisable et l'inutile.

Sur le plan économique, les chiffres racontent des histoires divergentes. L'entraînement de GPT-3 a coûté plus de cent millions de dollars selon des estimations prudentes, nécessitant des mois de calcul sur des milliers de GPU. L'affinage d'un modèle de sept milliards de paramètres sur une tâche spécifique peut coûter quelques milliers de dollars sur un seul GPU A100 loué pour quelques jours. Mais il y a un compromis caché : les LLM sont des généralistes extraordinaires ; un seul modèle sert à mille cas d'utilisation. Un SLM affiné excelle dans son domaine mais s'effondre dès que l'on sort de son périmètre d'entraînement. Il faut donc des batteries de SLM spécialisés là où un seul LLM aurait suffi, déplaçant la complexité de l'entraînement à l'orchestration.

Le véritable tournant est la généralisation contre la spécialisation. Les LLM sont le couteau suisse de l'IA : ils font tout décemment. Les SLM sont des scalpels chirurgicaux : ils excellent dans des tâches précises et échouent lamentablement hors contexte. Cette dichotomie pousse l'industrie vers des architectures hybrides : un SLM filtre les requêtes de routine, et un LLM n'intervient que sur les cas limites complexes. C'est le modèle en cascade que des startups comme Anthropic explorent dans leurs piles de production.

Quand utiliser quoi : la boussole décisionnelle

Les scénarios idéaux pour les SLM ressortent clairement de l'analyse des déploiements de 2025. L'informatique en périphérie est leur habitat naturel : appareils IoT avec des puces ARM à faible consommation, smartphones traitant des données sensibles sans les envoyer dans le cloud, voitures autonomes qui doivent réagir en quelques millisecondes sans dépendre d'une connectivité incertaine. Chaque application où la latence du réseau ou la confidentialité des données sont des contraintes strictes devient le territoire des SLM. Dans le secteur de la santé, les dispositifs médicaux dotés de SLM intégrés analysent les signes vitaux en temps réel, détectant les anomalies sans jamais transmettre les données des patients au-delà du périmètre local, contournant ainsi une grande partie de la complexité liée à la protection de la vie privée et à la sécurité des informations de santé. Dans la finance, les terminaux de paiement avec détection de fraude sur l'appareil bloquent les transactions suspectes en quelques millisecondes, bien avant qu'une API cloud puisse répondre.

Les applications spécifiques à un domaine où l'affinage excelle sont un autre point fort. Un modèle de trois milliards de paramètres entraîné sur des millions de contrats juridiques italiens surpasse GPT-4 dans l'extraction de clauses spécifiques de documents techniques car il a vu des variations linguistiques que le géant généraliste n'a jamais rencontrées. Un SLM affiné sur une base de code d'entreprise interne comprend mieux les conventions de nommage, les modèles architecturaux et les dépendances héritées que Copilot. Mais attention : ces avantages s'évaporent dès que vous changez de domaine. Ce modèle juridique impeccable pour les contrats commerciaux échouera lamentablement sur les contrats de droit administratif s'il ne les a pas vus dans son ensemble d'entraînement.

Lorsqu'un LLM est encore nécessaire, la réponse est tout aussi claire. Raisonnement en plusieurs étapes qui enchaîne la logique de différents domaines, recherche exploratoire où vous ne savez pas ce que vous cherchez jusqu'à ce que vous le trouviez, et étendue des connaissances générales pour des conversations qui sautent de la physique quantique aux recettes de cuisine. Les SLM sont des spécialistes brillants ; les LLM sont des généralistes indispensables. La frontière pragmatique consiste à comprendre qu'ils ne sont pas des alternatives mais des compléments. Sebastian Raschka, responsable de la recherche chez Lightning AI, le résume ainsi : les progrès en 2026 viendront davantage de l'optimisation de l'inférence que de l'augmentation de l'entraînement. Il s'agit d'un changement de perspective radical pour une industrie obsédée par le mantra "l'échelle est tout ce dont vous avez besoin".

L'impact environnemental complète le tableau décisionnel. Nous avons documenté en détail comment la consommation d'eau de l'IA devient un problème systémique : l'entraînement de GPT-3 a consommé mille trois cent quatre-vingt-sept mégawattheures, soit suffisamment d'énergie pour cent vingt foyers américains pendant une année entière. Chaque requête à ChatGPT nécessite trente millilitres d'eau pour le refroidissement des serveurs et 0,42 wattheure d'électricité. Avec sept cents millions de requêtes quotidiennes, l'échelle devient alarmante : l'énergie nécessaire pour trente-cinq mille foyers par an. Les SLM réduisent cette empreinte de quarante pour cent selon les données de l'industrie de 2025, non pas par magie mais par la physique élémentaire : moins de paramètres signifient moins de calculs, moins de mémoire et moins de chaleur à dissiper. Melanie Nakagawa, directrice du développement durable de Microsoft, l'a dit clairement : l'intensité énergétique nous pousse à accélérer l'efficacité. Ce n'est pas de l'écoblanchiment ; c'est la survie concurrentielle dans un monde où les coûts énergétiques deviennent le principal obstacle à la mise à l'échelle.

La galaxie des modèles : qui est sur le terrain

Le paysage des SLM au début de 2026 est étonnamment dense. La famille Phi de Microsoft domine les conversations d'entreprise : Phi-4-mini intègre des capacités de raisonnement multimodal, traitant des images et du texte tout en maintenant sa taille en dessous de quatre milliards de paramètres. Meta a sorti Llama 3.2 en variantes d'un et trois milliards de paramètres, avec des versions de vision qui acceptent nativement les entrées visuelles. Google a répondu avec Gemma 3n, spécifiquement optimisé pour le déploiement sur appareil sur les smartphones Android avec prise en charge de plus de cent quarante langues, visant à démocratiser l'IA multilingue sur les marchés émergents.

Qwen 3 d'Alibaba est le phénomène le plus intéressant : la version de quatorze milliards de paramètres a dépassé Llama en téléchargements sur HuggingFace pendant trois mois consécutifs entre septembre et novembre 2025, signalant un virage de la communauté open-weight vers des modèles plus efficaces. Les variantes plus petites de 0,6 et 1,8 milliard ont connu une adoption massive en Chine pour des applications de pointe où la consommation d'énergie est une contrainte principale. Mistral AI a lancé Ministral 3, optimisé pour l'inférence en périphérie avec une quantification agressive qui maintient une qualité surprenante. Comme nous l'avons analysé en discutant de la stratégie de Mistral avec Devstral, les startups européennes parient sur l'efficacité et la spécialisation pour concurrencer les géants américains qui dominent la mise à l'échelle verticale.

HuggingFace a contribué à SmolLM3, accompagné d'un plan d'ingénierie complet documentant chaque aspect du pipeline d'entraînement. C'est une expérience de transparence radicale : jeu de données, hyperparamètres, études d'ablation, tout est public. L'objectif déclaré est d'abaisser les barrières à l'entrée pour les chercheurs et les petites entreprises qui souhaitent entraîner des SLM personnalisés sans réinventer la roue à chaque fois. La distinction entre les modèles open-source et propriétaires s'estompe : même des géants comme Microsoft et Google publient des variantes de leurs SLM avec des licences permissives, conscients que l'écosystème créé par une communauté active vaut plus que le verrouillage propriétaire.

L'empreinte écologique qui fait la différence

Les chiffres de l'impact environnemental méritent un examen plus approfondi car ils deviennent un moteur de compétitivité et pas seulement une question éthique. Microsoft a enregistré une augmentation de trente-quatre pour cent de sa consommation d'eau entre 2021 et 2022, une augmentation presque entièrement attribuable à l'expansion de son infrastructure d'IA. Google a documenté des schémas similaires dans ses centres de données. Le problème est systémique : les modèles de langage massifs génèrent de la chaleur qui doit être dissipée, et les systèmes de refroidissement les plus efficaces utilisent l'évaporation de l'eau. Plus vous entraînez de paramètres, plus vous produisez de chaleur, plus vous consommez d'eau.

Les SLM interviennent sur les deux fronts. Pendant l'entraînement, un modèle de sept milliards de paramètres nécessite des ordres de grandeur moins d'énergie qu'un modèle de soixante-dix. Mais c'est pendant l'inférence que l'impact augmente de façon spectaculaire : des milliards de requêtes quotidiennes sur des modèles compacts au lieu de géants produisent d'énormes économies cumulées. Le benchmark SLM-Bench publié fin 2025 est le premier cadre systématique pour mesurer les compromis entre précision et durabilité, introduisant des métriques qui pondèrent les performances et l'efficacité énergétique avec la même priorité. Des entreprises comme Hugging Face l'intègrent déjà dans leurs hubs de modèles pour permettre aux développeurs de faire des choix éclairés.

Mais il y a une tournure paradoxale qui est rarement discutée. Si les SLM réduisent tellement le coût par requête, le risque est un effet rebond : les entreprises pourraient multiplier leur utilisation parce que "c'est bon marché", annulant les avantages environnementaux par une explosion du volume. C'est le même mécanisme qui a anéanti les gains d'efficacité énergétique des voitures : des moteurs plus efficaces ont conduit à conduire plus et à acheter des VUS plus lourds. Une véritable durabilité nécessitera non seulement des modèles plus efficaces, mais aussi une gouvernance sur la quantité et la manière dont nous les utilisons.

Du laboratoire aux usines : études de cas réels

Les déploiements en entreprise racontent des histoires plus concrètes que les spéculations théoriques, bien que la documentation des détails spécifiques reste un défi dans le monde de l'entreprise où les implémentations d'IA sont souvent couvertes par des accords de non-divulgation. Ce qui ressort clairement des rapports de l'industrie et des déclarations publiques, c'est un modèle d'adoption qui privilégie l'efficacité, la confidentialité et la spécialisation.

Dans le secteur financier, JPMorgan Chase a déployé COiN (Contract Intelligence), un petit modèle de langage spécialisé dans l'analyse automatique des contrats de prêts commerciaux, un processus traditionnellement géré manuellement par des équipes juridiques. En entraînant COiN sur des milliers de documents juridiques et de dépôts réglementaires, la banque a réduit les délais d'examen des contrats de plusieurs semaines à quelques heures, tout en maintenant une grande précision et une traçabilité de la conformité. Cela a permis de réaffecter les ressources juridiques à des tâches nécessitant un jugement humain complexe, tout en garantissant une adhésion constante aux normes réglementaires en évolution.

La détection de la fraude est un autre terrain fertile pour les SLM d'entreprise. Comme l'ont documenté Infosys et Lumenalta, les institutions bancaires entraînent des modèles compacts sur des schémas frauduleux spécifiques pour analyser les transactions et identifier les activités suspectes presque instantanément. L'efficacité et la grande précision permettent de réduire considérablement les faux positifs tout en augmentant les taux de détection. Les SLM dans ce domaine sont utilisés pour la prévention de la prise de contrôle de compte, en analysant les schémas de connexion et les changements de comportement en temps réel, pour identifier les activités de blanchiment d'argent en automatisant des tâches qui nécessitaient traditionnellement une intervention manuelle importante, et pour la détection de la fraude dans les paiements numériques où ils excellent dans la reconnaissance rapide des schémas.

Le principal avantage de l'utilisation des SLM pour la prévention de la fraude réside dans leur capacité à être continuellement mis à jour et affinés en fonction de nouveaux schémas de menaces, ce qui permet aux banques de garder une longueur d'avance sur les schémas frauduleux émergents tout en maintenant leur efficacité opérationnelle. FinBERT, un modèle de transformateur méticuleusement entraîné sur des données financières diversifiées telles que des transcriptions d'appels de résultats, des articles de presse financière et des rapports de marché, est un autre exemple concret de spécialisation efficace. Cet entraînement spécifique au domaine permet à FinBERT de détecter avec précision les sentiments dans les documents financiers, en identifiant des tons nuancés comme positifs, négatifs ou neutres qui guident souvent le comportement des investisseurs et des marchés.

Dans le secteur de la santé, l'adoption est plus prudente en raison des contraintes réglementaires, mais elle s'accélère. Comme le rapporte TechTarget, les déploiements sur des dispositifs médicaux analysent localement les données des capteurs portables pour une identification proactive des risques pour la santé, garantissant la confidentialité et permettant une surveillance continue. Les SLM aident les cliniciens en fournissant des recommandations thérapeutiques ou en résumant les dossiers médicaux, en opérant toujours sur des infrastructures séparées qui n'envoient jamais de données sensibles au-delà de périmètres contrôlés.

Dans le secteur manufacturier, les capteurs dotés de SLM intégrés détectent les défauts grâce à une analyse qui a lieu directement sur le site de production au lieu de centres de données distants, garantissant des temps de réponse de l'ordre de la milliseconde au lieu de la seconde, un fonctionnement continu en cas de connectivité Internet limitée et une dépendance réduite à la bande passante et au cloud. Ce modèle est particulièrement pertinent pour les industries où la latence du réseau serait inacceptable pour un contrôle qualité en temps réel.

Gartner a prédit en avril 2025 que d'ici 2027, les organisations mettront en œuvre des modèles d'IA de petite taille et spécifiques à des tâches avec un volume d'utilisation au moins trois fois supérieur à celui des modèles de langage de grande taille à usage général. La prévision est basée sur une enquête auprès de huit cents directeurs de la technologie européens et nord-américains, dont beaucoup citent la conformité et les coûts opérationnels comme principaux moteurs.

Mais les déploiements ne sont pas sans défis concrets. L'intégration des SLM dans les systèmes existants nécessite une refactorisation substantielle de l'architecture existante. Garantir la qualité des données pour l'affinage reste aussi complexe que pour les LLM, et souvent plus critique étant donné que des ensembles de données plus petits amplifient l'impact des données sales ou biaisées. La gouvernance de dizaines de modèles spécialisés introduit une nouvelle surcharge opérationnelle : elle nécessite une orchestration sophistiquée pour décider quel modèle invoquer pour quelle requête, une surveillance distincte pour chacun et la gestion des versions sur des déploiements distribués.

L'Allemagne est en tête de l'adoption européenne avec un taux de croissance annuel composé de 32,5 % prévu entre 2025 et 2035 pour les déploiements de LLM et de SLM, tiré par les secteurs de la fabrication et de l'aérospatiale où l'informatique en périphérie est une exigence technique non négociable et où la culture de l'ingénierie allemande privilégie le déterminisme et la validation, caractéristiques natives des SLM sur site. Le marché mondial des SLM, évalué à neuf cent trois millions de dollars en 2025, devrait atteindre 5,45 milliards d'ici 2032, avec un TCAC de vingt-huit virgule sept pour cent, ce qui reflète un déplacement des investissements vers des modèles d'IA qui s'alignent sur les contraintes opérationnelles et les exigences de sécurité.

Le cadre réglementaire : entre la loi sur l'IA et le déploiement sur l'appareil

Les SLM sur l'appareil se glissent dans une zone grise intéressante du paysage réglementaire européen. La loi sur l'IA fait la distinction entre les systèmes à haut risque qui nécessitent des audits stricts et les applications à faible risque avec des obligations réduites. Un modèle qui traite des données sensibles entièrement sur un appareil local, sans transfert vers des serveurs externes, contourne une partie de la complexité réglementaire simplement parce que les données ne "voyagent" pas. Pour les secteurs réglementés comme la santé et la finance, où le RGPD et l'HIPAA imposent des contraintes strictes sur le transfert de données, cette architecture devient un avantage concurrentiel ainsi qu'une exigence de conformité.

Les audits de conformité sur les SLM sont paradoxalement plus simples que ceux sur les LLM basés sur le cloud. Avec un modèle compact dont la distribution est verrouillée sur du matériel contrôlé, il est possible d'inspecter le comportement et les modes de défaillance. Avec un LLM de plusieurs centaines de milliards servi par une infrastructure distribuée qui change constamment, garantir la reproductibilité devient un cauchemar d'ingénierie. L'Allemagne est en train de devenir une plaque tournante européenne pour les SLM conformes précisément pour cette raison : la culture de l'ingénierie allemande privilégie le déterminisme et l'audit, des compétences qui sont des caractéristiques natives des SLM sur site.

Mais aux États-Unis, le tableau est plus fragmenté. Le décret présidentiel de Trump de novembre 2025 a cherché à empêcher le patchwork de réglementations étatiques qui était en train d'émerger, avec la Californie, New York et le Texas qui légiféraient indépendamment. La tension se situe entre l'innovation fédérale et le contrôle étatique, l'IA devenant un champ de bataille constitutionnel sur la division des pouvoirs. Une pétition du Future of Life Institute en octobre 2025, signée par des milliers de chercheurs et de personnalités politiques de tous bords, y compris Steve Bannon et Susan Rice, a demandé de ralentir la course à la superintelligence artificielle sans une gouvernance adéquate. Les SLM apparaissent dans ce contexte comme un compromis possible : suffisamment puissants pour être utiles, suffisamment limités pour être contrôlables.

Le 2026 à venir : battage médiatique ou tournant ?

Les prévisions vérifiables pour 2026 convergent sur quelques schémas. Andy Markus d'AT&T n'est pas isolé dans son optimisme concernant les SLM : Sebastian Raschka, Yann LeCun et d'autres responsables de la recherche ont publiquement déplacé l'accent de "jusqu'où pouvons-nous aller" à "à quel point pouvons-nous être efficaces". Ce changement rhétorique reflète des pressions économiques réelles : les coûts de l'énergie augmentent plus rapidement que les courbes de la loi de Moore, et les investisseurs commencent à exiger des retours sur les milliards dépensés dans des clusters de GPU.

L'évolution attendue est de "parler" à "faire" : des modèles qui non seulement génèrent du texte, mais exécutent également des actions, orchestrent des flux de travail et interagissent avec des outils externes. Meta devrait sortir Llama 4 Scout au premier trimestre 2026, avec une conscience native de l'écran qui permet au modèle de "voir" ce qui se passe sur un appareil et d'intervenir de manière proactive. Cela nécessite une très faible latence et une efficacité énergétique au niveau d'un smartphone, le territoire naturel des SLM. Les SLM personnalisés avec un affinage continu représentent une autre frontière : des modèles qui s'adaptent continuellement au contexte spécifique de l'utilisateur ou de l'organisation sans nécessiter un coûteux réentraînement par lots.

La mise à l'échelle au moment de l'inférence devient une priorité architecturale. Au lieu d'entraîner des modèles de plus en plus grands, l'industrie investit dans des techniques qui permettent aux modèles existants de "penser plus longtemps" sur des problèmes difficiles en allouant dynamiquement le calcul. C'est le schéma que nous avons vu émerger avec l'allocation adaptative du MIT et avec le raisonnement markovien de Harvard, où l'intelligence algorithmique au moment du test rivalise avec la force brute de l'entraînement. Les SLM bénéficient particulièrement de ces approches car ils partent d'une base de référence plus efficace.

Le protocole de contexte de modèle d'Anthropic devient la norme de facto pour l'IA agentique, permettant à différents modèles de communiquer et de se coordonner. Dans cet écosystème, des batteries de SLM spécialisés orchestrés par un contrôleur central pourraient surpasser les LLM généralistes uniques. Les modèles du monde, des systèmes qui apprennent des représentations causales de l'environnement au lieu de schémas statistiques purs, apparaissent comme un complément et non un substitut : un modèle du monde prédit les conséquences des actions, un SLM linguistique les verbalise et interagit avec l'utilisateur.

DeepSeek-R1 et d'autres modèles de raisonnement sortis fin 2025 sont techniquement encore des LLM mais signalent un virage vers l'optimisation : ils utilisent un mélange d'experts pour n'activer qu'un sous-ensemble de paramètres par requête, réduisant le calcul effectif tout en maintenant une capacité totale élevée. C'est un hybride entre la philosophie des LLM et des SLM. Le fait que Qwen surpasse Llama dans les téléchargements de la communauté open-weight signale une préférence pour l'efficacité. L'adoption par Mistral de l'architecture DeepSeek V3 montre une pollinisation croisée entre les approches : les meilleures idées se propagent rapidement, quelle que soit leur origine.

Les questions qui restent ouvertes

2026 sera-t-il vraiment l'année des SLM, ou assisterons-nous à une coexistence hybride ? L'histoire de l'IA suggère la prudence avec les proclamations définitives. Chaque vague technologique passe par des cycles prévisibles : battage médiatique initial, désillusion lorsque la réalité ne correspond pas aux attentes, et consolidation pragmatique où la technologie trouve ses cas d'utilisation réels. Les SLM résolvent de véritables problèmes de coût, de latence, de confidentialité et de durabilité, mais ils ne remplacent pas les LLM sur tous les fronts. La question pertinente n'est pas "SLM ou LLM" mais "quel outil pour quelle tâche".

Le principal risque est de surestimer les capacités et de sous-estimer les difficultés d'intégration. Le déploiement d'un SLM sur un appareil de pointe semble simple jusqu'à ce que vous soyez confronté à la gestion du contrôle des versions sur des milliers d'appareils hétérogènes, au débogage des modes de défaillance sur du matériel avec une télémétrie limitée et à la gouvernance de modèles qui évoluent indépendamment. L'industrie a encore peu d'expérience opérationnelle de cette complexité. D'un autre côté, l'opportunité est une véritable démocratisation : les petites entreprises et les chercheurs sans budgets de centres de données peuvent désormais rivaliser avec l'innovation algorithmique au lieu de la force brute.

Sebastian Raschka le résume ainsi : les progrès de 2026 viendront davantage de l'inférence que de l'entraînement. C'est une déclaration radicale pour une industrie qui a passé les cinq dernières années obsédée par les lois de l'échelle pendant l'entraînement. Mais les signaux économiques soutiennent ce changement : les marges se réduisent pour ceux qui servent des LLM géants, tandis que ceux qui optimisent une inférence efficace voient leurs coûts d'exploitation baisser. La durabilité n'est plus un luxe mais un impératif commercial.

La question finale pour le lecteur est pragmatique et inconfortable : dans votre organisation, combien de requêtes que vous envoyez à GPT-4 nécessitent vraiment un modèle de cinq cents milliards de paramètres ? Combien pourraient être gérées par un Phi-3 affiné à un dixième du coût et un centième de la latence ? Si la réponse est "la plupart", alors peut-être qu'Andy Markus et Sebastian Raschka ont raison. 2026 pourrait en effet être l'année où l'industrie cessera de courir après l'échelle pour l'échelle et commencera à se demander : combien suffit ?