L'IA comme Outil et non comme Oracle : le cas Deloitte et l'illusion de l'infaillibilité

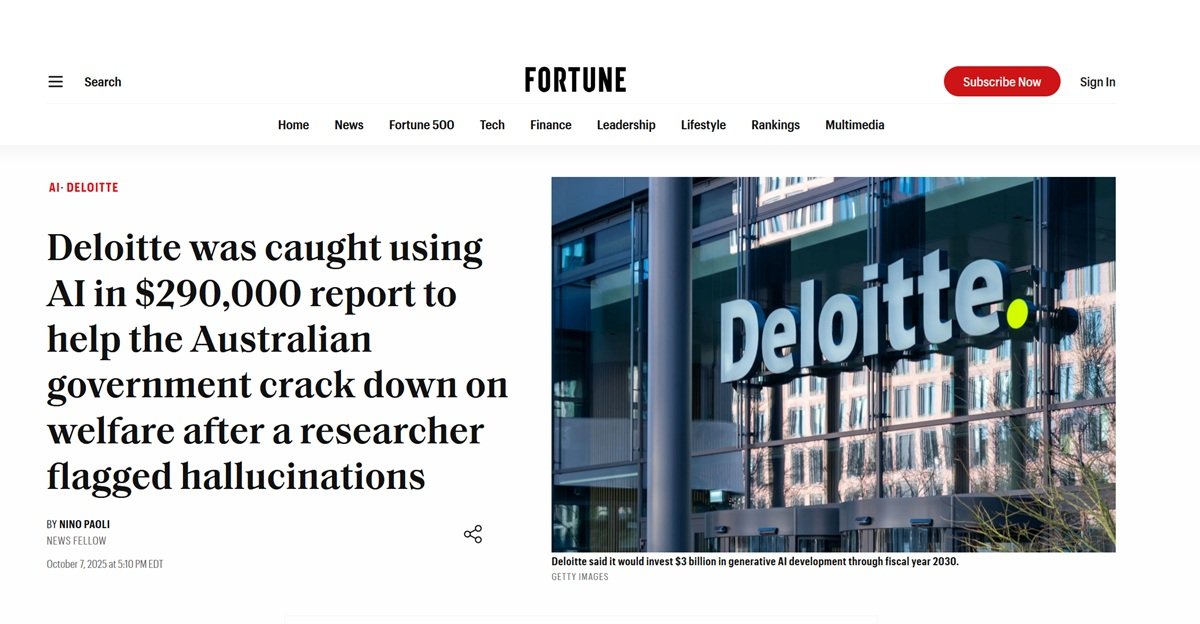

Août 2025. Christopher Rudge, chercheur à l'Université de Sydney et directeur adjoint du centre de recherche Sydney Health Law, lit un volumineux rapport de 237 pages publié quelques semaines plus tôt par le gouvernement australien.

Le document, commandé par le ministère de l'Emploi et des Relations de travail au géant du conseil Deloitte pour la modique somme de 439 000 dollars australiens, devait vérifier le "Cadre de conformité ciblé", un système automatisé qui contrôle le versement des prestations sociales. En parcourant les pages denses de références universitaires et jurisprudentielles, quelque chose cloche. Une citation en particulier attire son attention : une décision de la Cour fédérale qui devrait être la pierre angulaire de l'argumentation. Rudge va vérifier. La décision n'existe pas. Elle n'a jamais existé.

Comme un détective qui tire un fil et se retrouve avec un écheveau entier, le chercheur commence à creuser. Les citations fantômes se multiplient : des articles universitaires jamais publiés, des décisions de justice jamais rendues, des références bibliographiques qui ne mènent nulle part. Il ne s'agit pas d'erreurs occasionnelles ou de fautes de frappe. C'est tout un château construit sur des fondations inexistantes, avec la précision formelle et l'assurance typiques des documents professionnels de haut niveau. Rudge signale tout aux médias et au gouvernement. Le résultat ? L'un des scandales les plus embarrassants de l'histoire récente du conseil aux entreprises et une étude de cas parfaite sur la manière de ne pas utiliser l'intelligence artificielle.

L'aveu de culpabilité et le prix de la négligence

La réaction de Deloitte, il faut le dire, ne s'est pas fait attendre. Fin septembre 2025, la société a publiquement reconnu avoir utilisé Azure OpenAI GPT-4o pour la rédaction initiale du document. Pas un outil de support marginal, pas un assistant pour les brouillons : le modèle de langage avait généré de larges sections du rapport, y compris les citations, qui se sont ensuite retrouvées dans le document final sans vérification adéquate. L'aveu a été accompagné d'une version corrigée du rapport, expurgée des citations inventées, et de l'annonce d'un remboursement partiel au gouvernement australien. Mais le mal, comme on dit, était fait.

Ce qui rend le cas Deloitte particulièrement significatif, ce n'est pas tant l'erreur technologique en soi, mais l'attitude qui l'a rendue possible. Nous parlons de l'une des quatre grandes sociétés de conseil mondiales, une organisation dotée de processus d'assurance qualité stratifiés, d'auditeurs expérimentés et de partenaires responsables. Pourtant, quelque part le long de la chaîne de production, quelqu'un a décidé que le texte généré par GPT-4o était suffisamment fiable pour ne pas nécessiter une vérification approfondie des sources. C'est comme si un archéologue publiait une découverte sensationnelle en se basant sur les rumeurs du quartier au lieu des fouilles, ou comme si Borges avait écrit sa bibliothèque de Babel non pas comme une fiction littéraire mais comme un véritable catalogue. Sauf qu'ici, il n'y a pas d'ironie postmoderne : il y a un rapport gouvernemental de près d'un demi-million de dollars qui aurait dû guider les politiques publiques.

L'épidémie silencieuse des hallucinations numériques

Le cas Deloitte n'est pas un cygne noir, une anomalie isolée dans le paysage de l'adoption de l'IA. C'est plutôt la pointe la plus visible d'un iceberg qui émerge avec une clarté croissante. En mai 2023, un avocat de New York nommé Steven Schwartz s'est retrouvé sous les feux des projecteurs pour avoir cité dans un recours en justice six affaires précédentes entièrement inventées par ChatGPT. Le juge Kevin Castel n'a pas apprécié et a infligé des sanctions. En septembre 2025, un avocat californien, Amir Mostafavi, a reçu une amende historique de la Cour d'appel après qu'il est apparu que 21 des 23 citations de son mémoire étaient fausses, générées par ChatGPT et jamais vérifiées.

Le problème ne concerne pas seulement le conseil et les professions juridiques. Il y a quelques jours, le journal italien "La Provincia" de Civitavecchia a publié un article d'actualité qui se terminait par une phrase révélatrice : "Voulez-vous que je le transforme en un article à publier dans un journal (avec titre, chapô et mise en page journalistique) ou en une version plus narrative pour un magazine d'investigation ?". C'était la sortie sans équivoque de ChatGPT, qui s'est retrouvée imprimée sans que personne ne s'aperçoive qu'il ne s'agissait pas d'un texte rédactionnel mais de l'invite de clôture typique de l'assistant IA.

L'incident, aussi embarrassant soit-il, est significatif non pas pour la gaffe elle-même, mais pour ce qu'il révèle : même dans le journalisme, un domaine où la vérification des sources devrait être l'ADN professionnel, la tentation de déléguer l'écriture à l'IA sans une supervision adéquate produit des dérapages. Le rédacteur en chef a parlé d'"erreur humaine" et a annoncé des procédures plus strictes, mais le schéma est le même que celui observé avec Deloitte : des outils puissants utilisés à la légère, dans la conviction que la forme impeccable du texte généré correspond à un contenu fiable. La différence est qu'ici, l'erreur était si flagrante qu'elle était immédiatement visible, alors que des citations universitaires inventées ou des références jurisprudentielles fausses peuvent passer inaperçues pendant des mois.

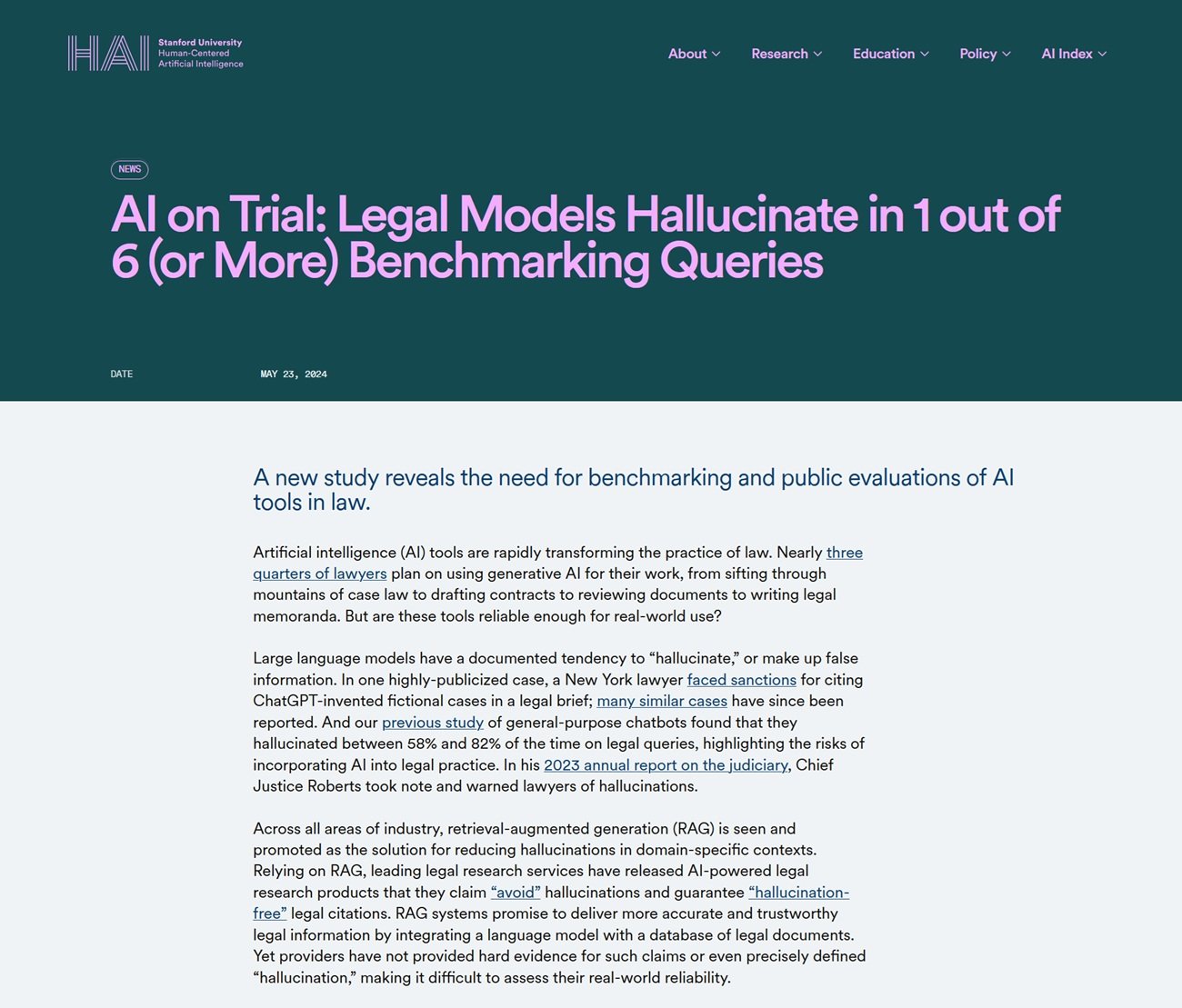

Mais le phénomène va bien au-delà des cas qui ont fait la une des journaux ou qui ont été générés par des journaux. Selon une étude de Stanford publiée en 2025, même les modèles de langage spécialisés pour le secteur juridique produisent des hallucinations dans au moins un cas sur six, tandis que les chatbots généralistes atteignent des taux d'erreur compris entre 58 % et 82 % lorsqu'ils sont interrogés sur des questions juridiques. Un chercheur en droit du nom de Damien Charlotin a identifié trois types récurrents de ces hallucinations : les citations d'affaires entièrement inventées, les citations correctes d'affaires réelles avec un contenu falsifié, et la plus insidieuse de toutes, les citations formellement exactes mais qui ne soutiennent absolument pas l'argument pour lequel elles sont invoquées.

Ce dernier type est particulièrement dangereux car il passe outre la vérification superficielle. L'affaire existe, la citation est formatée correctement, mais si vous allez effectivement lire la décision, vous découvrez qu'elle dit tout autre chose. C'est comme si le Necronomicon de Lovecraft citait des œuvres réellement existantes de Poe et de Bierce, mais en leur attribuant un contenu complètement différent : la forme est parfaite, la substance est fantasmagorique.

Anatomie d'une hallucination : pourquoi l'IA invente-t-elle avec une telle assurance ?

Pour comprendre ce qui s'est passé dans l'affaire Deloitte, il faut prendre du recul et comprendre comment fonctionnent réellement les grands modèles de langage comme GPT-4o. Ces systèmes sont d'extraordinaires machines de prédiction statistique du langage : étant donné un contexte, ils calculent quelle séquence de mots est la plus susceptible d'être cohérente avec ce contexte, en se basant sur des milliards d'exemples vus pendant l'entraînement. Ils sont incroyablement doués pour capturer des modèles, des structures rhétoriques, des conventions d'écriture. Lorsque vous leur demandez de générer une citation universitaire dans le bon format, avec les auteurs, le titre, l'année et la revue, le modèle sait parfaitement comment cette citation devrait apparaître. Il a vu des milliers d'exemples similaires.

Mais c'est là que réside le problème fondamental : le modèle ne sait pas si cette citation existe réellement. Il n'a pas accès à une base de données de vérification, il ne vérifie pas si l'article "Smith, J. (2023). AI Governance in Welfare Systems. Journal of Public Administration" a déjà été publié. Il génère simplement une chaîne de texte qui ressemble à une citation plausible, en se basant sur des modèles linguistiques. C'est comme un faussaire si doué qu'il peut recréer à la perfection le style de Vermeer, mais qui n'a jamais vu le tableau original parce qu'il n'existe pas : il crée un faux d'une œuvre imaginaire.

Cette caractéristique des LLM est connue dans la littérature technique sous le nom d'"hallucination", un terme peut-être trop poétique pour décrire ce qui est essentiellement un bogue de conception. Les modèles de langage ont été optimisés pour être convaincants, fluides et cohérents dans la forme. La vérité factuelle est une propriété émergente, et non l'objectif principal de l'architecture. Lorsque le contexte fournit suffisamment d'informations vérifiables, les modèles modernes comme GPT-4o peuvent être étonnamment précis. Mais lorsqu'ils doivent "combler les vides", lorsque la base de données d'entraînement ne contient pas la réponse exacte, ils passent sans transition de la restitution de faits mémorisés à l'invention plausible. Et ils le font avec le même ton assertif, la même mise en forme impeccable, le même registre professionnel.

Le vrai problème : l'illusion de l'infaillibilité

Le cœur du désastre de Deloitte n'est pas technologique mais culturel. C'est l'attitude avec laquelle l'outil a été abordé. Quelque part dans cette chaîne de production du rapport, une décision a été prise : considérer GPT-4o non pas comme un générateur de brouillons à vérifier mot pour mot, mais comme une source fiable, une sorte de nègre littéraire expert qui produisait un contenu déjà prêt à être publié. C'est une erreur de catégorie fondamentale, comparable à confondre un simulateur de vol avec un véritable avion : la similitude superficielle masque des différences substantielles et critiques.

Cette attitude acritique est alimentée par un discours dangereux qui entoure l'intelligence artificielle contemporaine. Les entreprises technologiques, naturellement intéressées à maximiser l'adoption, ont tendance à mettre l'accent sur les capacités de leurs systèmes en les présentant comme quasi omniscients. Le marketing parle de "raisonnement", de "compréhension", de systèmes qui "pensent" et "comprennent". Cette anthropomorphisation délibérée crée des attentes irréalistes et fait baisser la garde. Si l'IA "comprend" mon problème, pourquoi devrais-je douter de ses réponses ?

L'affaire documentée par NPR concernant les avocats de MyPillow est exemplaire à cet égard. Des professionnels du droit, formés à la pensée critique et à la vérification des sources, ont confié à ChatGPT la recherche jurisprudentielle, puis ont déposé les actes sans les vérifier. Non par mauvaise foi, mais parce que l'interface conversationnelle du chatbot, son assurance formelle, la cohérence de ses réponses ont créé une illusion de compétence. Le système n'a jamais dit "attention, cette citation pourrait être inventée". Il a simplement généré un texte plausible, comme il a été conçu pour le faire.

Les implications systémiques : au-delà de l'embarras de l'entreprise

En ce qui concerne le rapport Deloitte, les conséquences vont bien au-delà de l'embarras d'une multinationale et du remboursement de quelques centaines de milliers de dollars. Le document devait vérifier un système automatisé qui influe sur l'octroi de l'aide sociale à des personnes vulnérables. Des recommandations politiques fondées sur des bases inexistantes auraient pu guider des décisions ayant un impact réel sur la vie des citoyens. Si le cadre de conformité ciblé avait été modifié en suivant des suggestions basées sur de fausses citations, les effets se seraient propagés à travers toute la chaîne du système social.

Cela soulève une question plus large sur la confiance épistémique dans les sociétés contemporaines. Nous vivons à une époque où la vérification directe des sources est de plus en plus difficile pour le citoyen moyen. Nous nous fions nécessairement à des intermédiaires considérés comme fiables : universités, journaux, sociétés de conseil, institutions gouvernementales. Lorsque ces intermédiaires commencent à déléguer la production de connaissances à des systèmes qui inventent avec désinvolture, sans mettre en œuvre des protocoles de vérification rigoureux, toute la chaîne de confiance se fissure. Ce n'est pas de la paranoïa complotiste de noter que si Deloitte peut livrer au gouvernement australien un rapport rempli de citations fantômes, d'autres documents similaires pourraient circuler sans être découverts dans d'autres contextes.

Le Washington Post a documenté comment les juges américains réagissent avec une sévérité croissante à ces cas, en infligeant des sanctions de plus en plus lourdes. Mais les amendes infligées aux avocats négligents ne sont que des pansements sur une blessure plus profonde. Le problème structurel est que nous traversons une phase de transition technologique sans avoir encore développé les protocoles culturels et professionnels appropriés. C'est comme si l'imprimerie à caractères mobiles avait été inventée mais que les conventions éditoriales modernes, de la relecture par les pairs à la bibliographie vérifiée, n'existaient pas encore.

La leçon méthodologique : des outils, pas des oracles

La technologie de l'intelligence artificielle générative est extraordinairement puissante. GPT-4o et ses contemporains peuvent accélérer considérablement les processus créatifs, synthétiser de vastes corpus d'informations, suggérer des liens non évidents et générer de multiples variantes d'un texte en quelques secondes. Utilisés correctement, ils sont des multiplicateurs de capacités humaines. Le problème surgit lorsqu'ils sont traités comme des substituts au jugement humain plutôt que comme des amplificateurs.

La distinction est cruciale. Un amplificateur améliore ce qui existe déjà : si vous avez de l'expertise, l'IA peut vous rendre plus rapide et plus efficace. Mais si vous déléguez complètement votre expertise à l'outil, l'amplification fonctionne aussi pour la négligence et l'erreur. C'est le paradoxe de la rétroaction positive : l'IA vous permet de produire plus, mais si "plus" inclut du contenu non vérifié, vous ne faites que multiplier la quantité de déchets qui circulent dans le système.

Dans le contexte spécifique du conseil professionnel, cela signifie réinitialiser complètement le flux de travail. Lorsque Deloitte a admis ce qui s'était passé, elle a également annoncé la mise en œuvre de protocoles plus stricts pour l'utilisation de l'IA. Mais quels devraient être ces protocoles ? La réponse émerge clairement de l'échec lui-même : chaque citation générée par l'IA doit être vérifiée manuellement. Chaque affirmation factuelle doit être vérifiée par rapport à des sources primaires. Chaque argument doit pouvoir être retracé jusqu'à des documents réellement existants. En substance, le résultat de l'IA doit être traité comme un brouillon de qualité variable produit par un stagiaire brillant mais peu fiable, et non comme un produit fini.

Cette approche demande du temps et de l'attention, exactement les ressources que l'IA est censée faire économiser. Mais c'est le seul moyen d'éviter les catastrophes. Le gain d'efficacité de l'IA ne peut pas provenir du fait de sauter la phase de vérification, mais de l'accélération de la phase de génération du premier brouillon. Si Deloitte avait utilisé GPT-4o pour produire rapidement une structure initiale, puis avait consacré le temps gagné à une vérification méticuleuse, le résultat aurait été à la fois efficace et précis. Au lieu de cela, le temps a été "gagné" sur la mauvaise partie du processus, celle qui sépare le professionnalisme de la négligence.

Vers une culture de la responsabilité algorithmique

L'affaire Deloitte survient à un moment particulier de l'histoire de l'intelligence artificielle. Nous avons dépassé l'enthousiasme acritique des premiers adeptes, mais nous n'avons pas encore atteint une maturité généralisée dans l'utilisation de ces outils. Les organisations se trouvent dans un entre-deux inconfortable : la pression concurrentielle impose d'adopter l'IA pour ne pas rester à la traîne, mais les compétences pour l'utiliser de manière responsable sont inégalement réparties, souvent concentrées chez quelques spécialistes, tandis que la masse des utilisateurs traite les LLM comme des moteurs de recherche infaillibles.

Il faut une révolution culturelle plus que technologique. Les entreprises doivent cesser de considérer l'IA comme un avantage concurrentiel à mettre en œuvre rapidement et commencer à la voir comme une technologie à double usage qui nécessite une gouvernance rigoureuse. Cela signifie une formation sérieuse, et non des tutoriels de trois heures. Cela signifie des audits réguliers des processus dans lesquels l'IA est impliquée. Cela signifie, surtout, récompenser la prudence plutôt que la vitesse, valoriser ceux qui soulèvent des doutes méthodologiques plutôt que ceux qui livrent rapidement.

Le monde universitaire et professionnel réagit. De plus en plus de revues scientifiques exigent que les auteurs déclarent explicitement l'utilisation de l'IA, et beaucoup ont totalement interdit l'utilisation des LLM pour générer des sections substantielles des articles. Les tribunaux de plusieurs pays introduisent des règles qui exigent la certification de l'exactitude des citations dans les actes de procédure, avec la responsabilité personnelle des avocats. Ce sont des réponses nécessaires mais encore fragmentaires.

Il faut des normes industrielles transversales. Si un document professionnel contient du contenu généré par l'IA, cela devrait être clairement indiqué, avec une indication des sections concernées et des protocoles de vérification appliqués. Non pas pour stigmatiser l'utilisation de la technologie, mais pour rendre transparent le processus de production des connaissances. C'est le même principe qui nous fait exiger la liste des ingrédients sur les aliments ou la méthodologie dans les études scientifiques : non pas parce que nous supposons la mauvaise foi, mais parce que la transparence permet une évaluation et une confiance éclairées.

Ni apocalypse ni utopie : l'équilibre nécessaire

Il serait facile, en regardant l'affaire Deloitte et ses petits frères dans le monde juridique, de tomber dans deux rhétoriques opposées et tout aussi contre-productives. La première est l'apocalypse : l'IA nous inondera de faussetés, rendra impossible la distinction entre le vrai et le faux, et détruira la confiance épistémique sur laquelle reposent les sociétés complexes. La seconde est l'utopie : ce ne sont que des incidents de parcours, l'erreur est humaine (ou dans ce cas, de l'utilisateur humain), la technologie continuera de s'améliorer et ces problèmes disparaîtront d'eux-mêmes.

Les deux récits sont insuffisants. L'IA générative n'apporte pas l'apocalypse de la vérité, mais elle facilite certainement la production de contenu plausible mais faux à l'échelle industrielle. Ignorer ce risque est irresponsable. D'un autre côté, les problèmes ne se résoudront pas comme par magie avec la prochaine génération de modèles. Même si GPT-5 ou Claude-4 ont des taux d'hallucination plus faibles, ils ne seront jamais parfaits. Le but n'est pas d'attendre une IA infaillible, mais de développer des pratiques de travail qui supposent l'imperfection comme point de départ.

Christopher Rudge, le chercheur qui a révélé l'affaire, n'est pas un luddite anti-technologie. C'est un universitaire qui a simplement fait ce que toute personne confrontée à un document professionnel devrait faire : il a vérifié les sources. Son geste n'est pas héroïque, il est banalement professionnel. Le fait qu'il ait été nécessaire, que le système de contrôle qualité d'un des quatre grands n'ait pas intercepté ces citations fantômes, est le véritable scandale. Et la leçon est limpide : peu importe à quel point l'IA devient sophistiquée, la dernière ligne de défense contre l'erreur est toujours l'attention critique humaine.

Les 439 000 dollars australiens remboursés par Deloitte ne sont guère plus qu'une note de bas de page dans un bilan de plusieurs milliards. Le véritable coût de cette affaire est réputationnel, mais il pourrait se transformer en un avantage systémique s'il est lu correctement : non pas comme l'incident embarrassant d'une entreprise, mais comme le symptôme d'un problème répandu qui nécessite une réponse collective. Les outils sont neutres. C'est l'usage que nous en faisons qui définit s'ils amplifient notre intelligence ou notre négligence. Et ce choix reste, et doit rester, obstinément humain.