Moins c'est Mieux : La Révolution se poursuit avec le Modèle TRM

Dans le monde de l'intelligence artificielle, où la règle d'or semblait être "plus c'est grand, mieux c'est", une contre-narration émerge qui rappelle la fin de *L'Attaque des Titans : parfois, ce sont les plus petits titans qui cachent le vrai pouvoir. Samsung AI, par l'intermédiaire de son laboratoire SAIL à Montréal, vient de publier un article scientifique qui pourrait marquer un tournant dans notre façon de penser l'intelligence des machines.*

Il s'appelle le Tiny Recursive Model, abrégé en TRM, et avec ses misérables 7 millions de paramètres, il fait ce qui semblait impossible : battre systématiquement des colosses de centaines de milliards de paramètres dans des tâches de raisonnement complexe.

Pour mettre ces chiffres en perspective, nous parlons d'un modèle dix mille fois plus petit que GPT-4o ou Gemini 2.5 Pro qui parvient à obtenir des performances supérieures sur des benchmarks considérés parmi les plus difficiles pour l'intelligence artificielle. Sur le célèbre test ARC-AGI, celui que François Chollet a conçu pour mesurer la véritable généralisation intelligente plutôt que la simple mémorisation, TRM atteint 45 % de précision sur la première version et 8 % sur la seconde, des chiffres qui dépassent des modèles comme DeepSeek-R1, o3-mini d'OpenAI et même Gemini 2.5 Pro. Et il le fait en consommant une fraction infinitésimale des ressources de calcul.

Mais l'histoire de TRM ne commence pas ici. Pour vraiment comprendre ce qui rend cette approche révolutionnaire, nous devons faire un pas en arrière et regarder une tendance que nous suivons de près sur AITalk.it ces derniers mois : l'émergence d'une philosophie complètement différente dans la conception de l'intelligence artificielle, une qui privilégie l'astuce à la force brute.

L'ADN Rebelle : De HRM à TRM

Comme nous l'avons raconté il y a quelques mois, la petite startup de Singapour Sapient Intelligence avait déjà secoué le secteur avec son Hierarchical Reasoning Model. HRM avait réussi l'exploit de battre d'énormes modèles en utilisant à peine 27 millions de paramètres, grâce à une architecture directement inspirée du fonctionnement hiérarchique du cerveau humain. L'idée de base était révolutionnaire : au lieu de tout traiter en un seul passage linéaire comme le font les transformateurs traditionnels, HRM utilisait deux réseaux de neurones qui raisonnaient à des fréquences différentes, un rapide et un lent, en itérant récursivement sur le problème jusqu'à converger vers la solution correcte.

TRM, développé par Alexia Jolicoeur-Martineau et l'équipe de Samsung SAIL Montréal, reconnaît explicitement dans l'article être une évolution directe de HRM. Mais c'est une évolution qui fait ce que toute bonne suite devrait faire : elle prend les concepts gagnants et les pousse à l'extrême, en éliminant tout le superflu. Comme l'explique l'article original, l'analyse indépendante menée par la Fondation ARC Prize avait révélé que dans HRM, le véritable moteur des performances était la "supervision profonde", c'est-à-dire la capacité d'itérer et d'améliorer progressivement la réponse à travers plusieurs étapes de supervision, tandis que le raisonnement hiérarchique sur deux réseaux séparés contribuait de manière marginale.

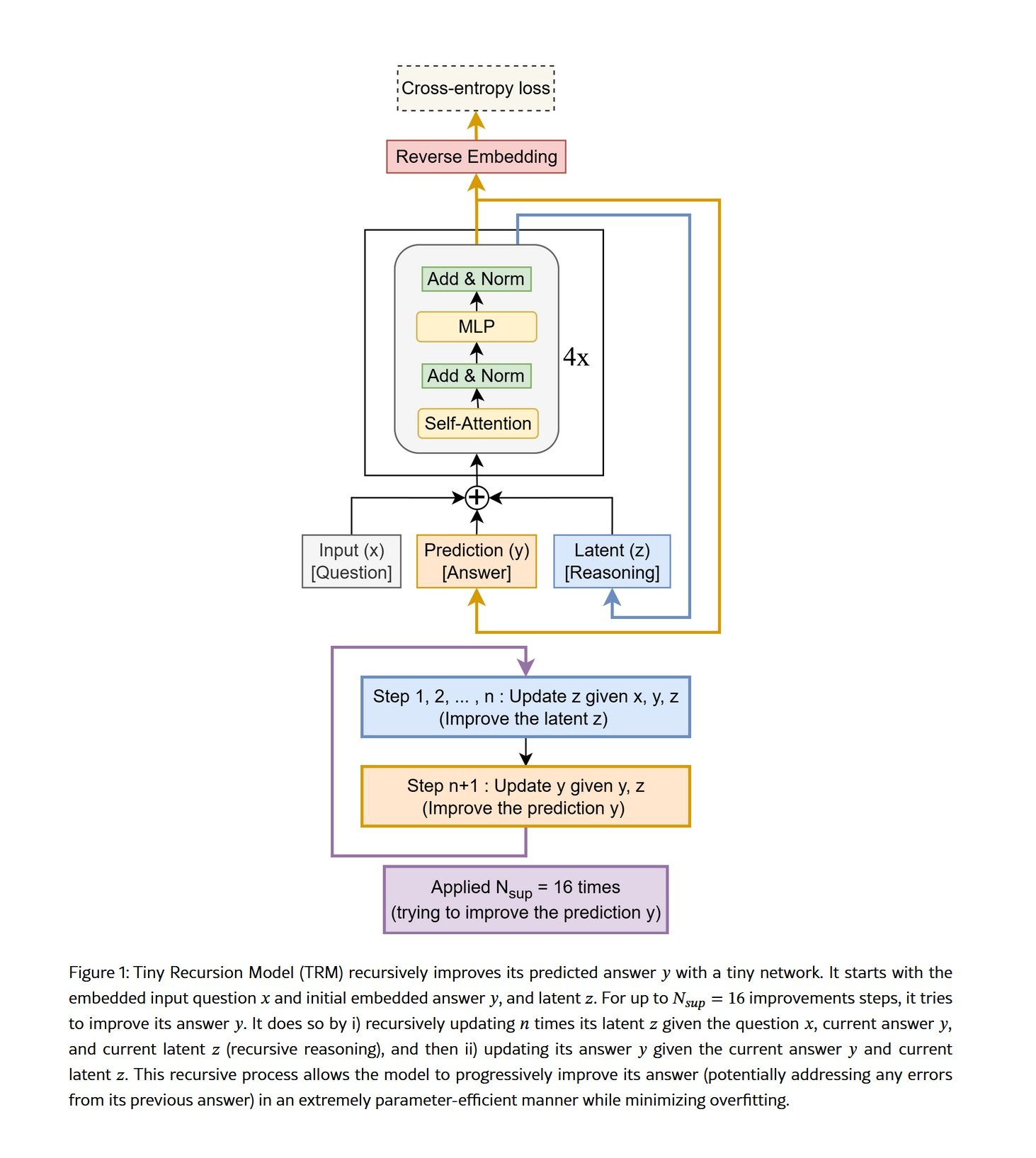

Partant de cette intuition, TRM simplifie radicalement l'architecture. Fini les justifications biologiques complexes, fini les théorèmes de points fixes, finie la hiérarchie à two niveaux. Reste l'essence pure du raisonnement récursif : un seul réseau minuscule de seulement deux couches qui itère sur lui-même, affinant progressivement à la fois son "raisonnement latent" et la réponse finale. C'est comme si, au lieu d'avoir une équipe d'experts travaillant à différents niveaux d'abstraction, vous aviez un seul génie qui se concentre intensément sur le problème, revoit continuellement sa propre pensée et affine la solution jusqu'à ce qu'elle soit parfaite.

Le mécanisme est élégant dans sa simplicité. TRM commence par une question codée, génère une première ébauche de réponse, puis entre dans ce que les chercheurs appellent un "processus récursif complet". Pendant un nombre prédéfini d'itérations, le réseau met à jour à plusieurs reprises son état latent interne, que l'on peut imaginer comme une sorte de "brouillon" mental où le modèle formule des hypothèses, vérifie les cohérences internes et construit une compréhension de plus en plus profonde du problème. Après ces itérations sur le raisonnement latent, le réseau met à jour la réponse finale en se basant sur cette compréhension affinée. Et puis il recommence, en améliorant encore à la fois le raisonnement et la réponse.

Ce qui rend cette approche particulièrement puissante, c'est que TRM n'a pas besoin d'externaliser sa pensée par le langage, comme le font les modèles basés sur la "chaîne de pensée". Il n'a pas besoin d'écrire "étape un, étape deux, étape trois" en texte explicite, avec tous les risques d'erreurs en cascade que cela comporte. Son raisonnement se déroule dans un espace latent interne, parallèle et compressé, où il peut maintenir simultanément plusieurs hypothèses et relations sans avoir à tout linéariser en une séquence de jetons. C'est la différence entre penser à la manière de résoudre un problème et devoir expliquer à voix haute chaque étape de son raisonnement tout en le faisant.

Les Chiffres qui Bouleversent les Certitudes

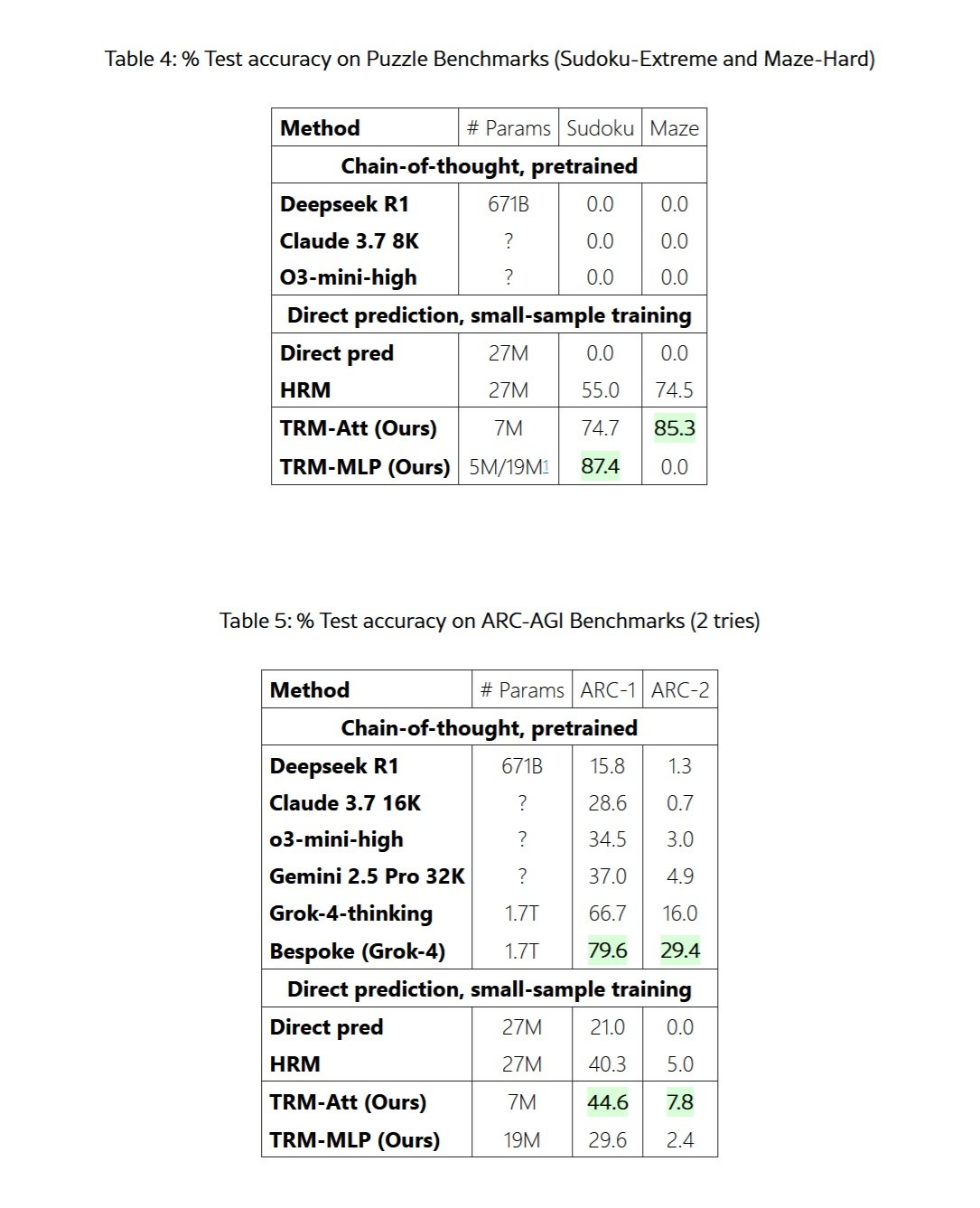

Les résultats rapportés dans l'article de Samsung ne laissent aucune place à une interprétation ambiguë. Sur des Sudokus de difficulté extrême, ceux qui mettent en crise même les experts humains, TRM atteint 87,4 % de précision contre 55 % pour son prédécesseur HRM et 0 % pour les LLM traditionnels avec chaîne de pensée. Zéro pour cent. Même DeepSeek-R1 avec ses 671 milliards de paramètres n'a pas réussi à résoudre un seul Sudoku difficile.

Sur l'ensemble de données Maze-Hard, qui consiste en des labyrinthes 30x30 particulièrement alambiqués où le chemin le plus court dépasse 110 cellules, TRM trouve la solution optimale dans 85,3 % des cas, améliorant les 74,5 % de HRM. Encore une fois, les LLM géants obtiennent un zéro pointé. Ce n'est pas qu'ils échouent de peu, ils n'arrivent tout simplement même pas à s'approcher d'une solution correcte.

Mais c'est sur les benchmarks ARC-AGI que la comparaison devient vraiment impitoyable. ARC-AGI, le benchmark créé par François Chollet pour mesurer la véritable intelligence générale plutôt que la capacité à mémoriser des modèles à partir des données d'entraînement, est conçu pour être facile pour un humain mais diaboliquement difficile pour l'IA actuelle. Chaque puzzle est unique, nécessitant une abstraction visuelle, un raisonnement causal et une généralisation à des situations jamais vues auparavant. Sur ARC-AGI-1, TRM atteint 44,6 % de précision, dépassant les 40,3 % de HRM mais aussi les 37 % de Gemini 2.5 Pro avec un calcul massif en temps de test, les 34,5 % de o3-mini-high et les 28,6 % de Claude 3.7 Sonnet avec un contexte de 16K jetons.

Sur ARC-AGI-2, la version encore plus difficile du benchmark sortie cette année, TRM obtient 7,8 % contre 5 % pour HRM, 4,9 % pour Gemini 2.5 Pro et 3 % pour o3-mini-high. Des chiffres qui semblent bas en valeur absolue, mais qui représentent des sauts de performance énormes dans un test où même les modèles les plus avancés peinent à dépasser le pourcentage à un chiffre.

Pour être juste et complet, nous devons mentionner que les modèles vraiment à la pointe comme Grok-4-thinking obtiennent 66,7 % sur ARC-AGI-1 et 16 % sur ARC-AGI-2, tandis que la version Bespoke basée sur Grok-4 atteint même 79,6 % et 29,4 %. Mais nous parlons d'un modèle avec 1,7 billion de paramètres, plus de deux cent quarante mille fois plus grand que TRM. C'est comme comparer une Smart Fortwo à un semi-remorque et découvrir que la Smart parvient tout de même à arriver la première sur certains parcours particulièrement sinueux.

Le véritable coup de maître, cependant, concerne l'efficacité de l'entraînement. Là où les grands LLM nécessitent des ensembles de données gigantesques extraits de tout Internet et des mois de traitement sur des clusters de milliers de GPU, TRM est entraîné avec à peine mille exemples par problème. Sur Sudoku-Extreme, l'entraînement complet prend moins de 36 heures sur un seul GPU L40S de 40 Go. Pour ARC-AGI, il faut environ trois jours sur quatre H100. Nous parlons de ressources accessibles à un laboratoire universitaire ou à une startup bien financée, et non d'infrastructures coûtant des dizaines de millions de dollars.

L'Intelligence Distribuée : Un Mouvement Souterrain

TRM n'est pas un cas isolé, mais fait partie d'un mouvement plus large qui émerge en marge de l'industrie de l'IA. Comme nous l'avons documenté ces derniers mois, il existe une tendance croissante parmi les startups aux budgets limités et les chercheurs indépendants à rechercher des solutions qui privilégient l'astuce architecturale à la pure puissance de calcul.

Prenons le cas de DeepConf, une technique découverte par Jiawei Zhao lors de son stage chez Meta en 2024. Zhao a montré que si, au lieu de demander à un LLM une seule réponse, vous lui faites générer plusieurs réponses alternatives, puis vous les faites discuter entre elles de manière structurée, et enfin vous agrégez les conclusions, vous obtenez d'énormes améliorations de performance sur des tâches de raisonnement complexe. Le principe sous-jacent est similaire à celui de TRM : itérer, réfléchir, affiner. Ce n'est pas seulement la taille de votre modèle qui compte, mais la manière dont vous l'utilisez.

Encore plus fascinant est le cas de MemVid, un projet expérimental qui aborde un problème complètement différent mais avec la même philosophie de base. Au lieu de construire des bases de données vectorielles de plus en plus gigantesques et coûteuses pour gérer la mémoire à long terme des IA, MemVid code les informations en codes QR et les compresse en fichiers vidéo MP4. Cela semble fou, mais cela fonctionne extraordinairement bien, en exploitant trente ans d'optimisations des codecs vidéo pour obtenir des taux de compression 50 à 100 fois meilleurs que les bases de données traditionnelles, tout en maintenant des recherches sémantiques en moins d'une seconde. Encore une fois, il ne s'agit pas de jeter plus de puissance de calcul sur le problème, mais de trouver une solution plus élégante et intelligente.

Ce qui unit toutes ces approches, c'est une vision fondamentalement différente de ce que signifie construire l'intelligence artificielle. L'industrie grand public, dominée par des géants comme OpenAI, Google et Anthropic, a suivi pendant des années le paradigme de la "mise à l'échelle" : plus de paramètres, plus de données, plus de calcul. La fameuse "loi de mise à l'échelle" suggérait que les performances s'amélioreraient de manière prévisible simplement en augmentant l'échelle. Et cela a fonctionné, pendant un certain temps. Mais maintenant, nous voyons des rendements décroissants de plus en plus évidents, ainsi que des coûts environnementaux et économiques qui deviennent insoutenables.

Le mouvement vers l'efficacité, en revanche, part d'un postulat différent : l'intelligence n'est pas seulement une question de quantité d'informations traitées, mais de qualité du traitement. C'est la différence entre lire mille livres à la hâte et en lire dix avec une attention profonde, en réfléchissant de manière critique à chaque passage, en faisant des liens et en révisant ses propres conclusions. TRM, DeepConf, MemVid et des dizaines d'autres projets émergents explorent tous des variations sur ce thème : itération, réflexion, optimisation architecturale.

L'Architecture de la Pensée Miniaturisée

Pour vraiment comprendre pourquoi TRM fonctionne si bien tout en étant si petit, nous devons nous pencher sur les détails techniques de l'architecture. Comme l'explique en détail l'article original, TRM se compose de quatre éléments essentiels : un module d'enchâssement qui transforme l'entrée en représentations vectorielles, un seul réseau récursif de seulement deux couches de transformateurs, un "brouillon" latent où se déroule le raisonnement interne, et un module de sortie qui transforme les représentations affinées en réponse finale.

La clé de voûte est le processus récursif complet. Contrairement à HRM qui s'appuyait sur le théorème de la fonction implicite avec une approximation en une seule étape pour justifier la rétropropagation uniquement à travers les deux dernières étapes, TRM rétropropage à travers l'ensemble du processus récursif. Cela élimine les hypothèses théoriques problématiques de HRM, qui ne pouvait pas garantir avoir effectivement atteint un point fixe, et fournit des gradients plus précis pour l'apprentissage.

Le processus fonctionne comme suit : en partant de la question enchâssée et d'une réponse initiale, TRM effectue n itérations sur sa variable latente z, qui représente son "raisonnement interne". À chaque itération, le réseau prend en entrée la question x, la réponse actuelle y et le raisonnement actuel z, et produit un raisonnement mis à jour. Cela se fait n fois de suite, disons 6 fois, ce qui permet au modèle de construire une compréhension de plus en plus affinée. Ensuite, en utilisant ce raisonnement affiné z et la réponse actuelle y, le réseau produit une nouvelle réponse y améliorée. Cela constitue un "processus récursif complet".

Mais cela ne s'arrête pas là. Grâce à la "supervision profonde", TRM peut effectuer jusqu'à 16 de ces processus récursifs complets en séquence, en partant à chaque fois de la réponse améliorée de l'étape précédente et en continuant à affiner. C'est comme si un étudiant résolvait un problème, revérifiait son travail, faisait des corrections, revérifiait à nouveau, faisait d'autres corrections, et ainsi de suite jusqu'à être complètement sûr de la solution. Avec n=6 itérations de raisonnement latent et 16 étapes de supervision, TRM effectue en fait environ 42 récursions de profondeur émulée, obtenant une capacité de raisonnement qui nécessiterait normalement un réseau beaucoup plus profond et complexe.

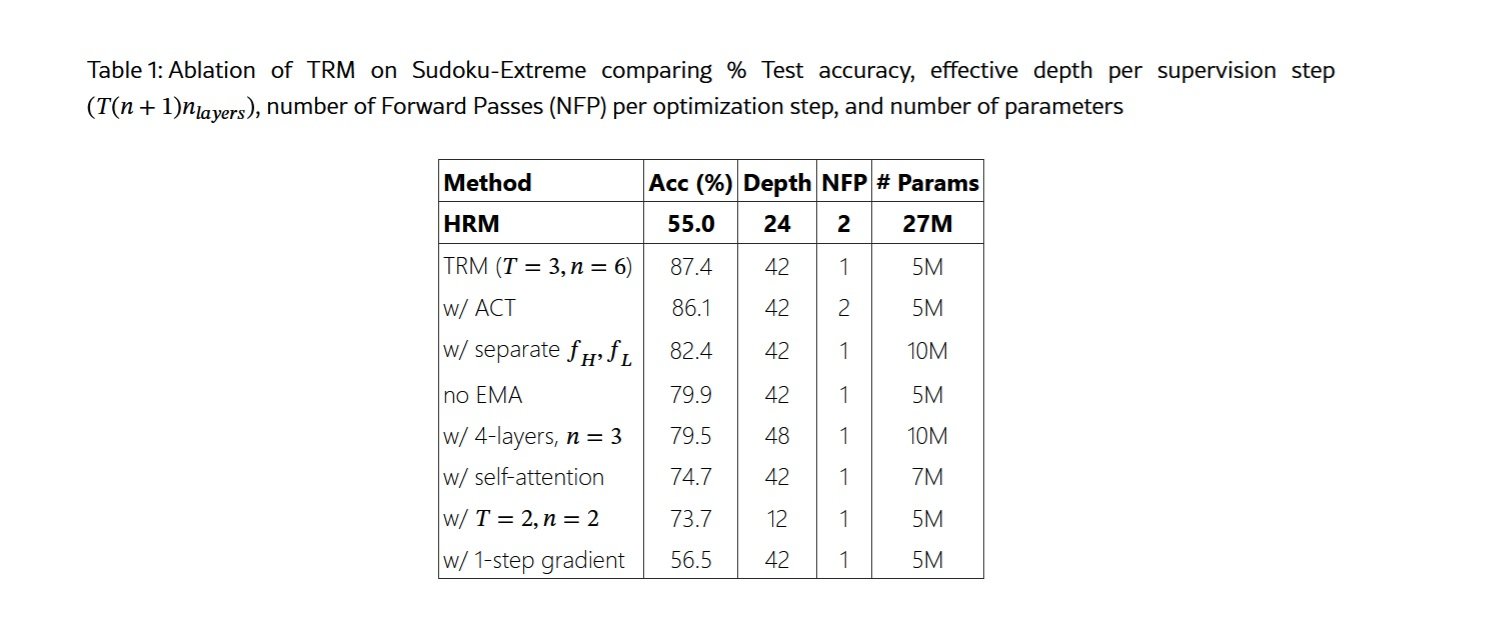

L'une des idées les plus contre-intuitives rapportées dans l'article concerne précisément la taille du réseau. Les chercheurs ont découvert que l'augmentation du nombre de couches détériore les performances en raison du surajustement sur les petits ensembles de données typiques des tâches de raisonnement. En réduisant de quatre à deux couches et en compensant avec plus de récursions, ils ont obtenu une amélioration de 79,5 % à 87,4 % sur Sudoku-Extreme, tout en divisant par deux le nombre de paramètres. Moins c'est vraiment plus quand on a très peu de données et qu'on recherche une véritable généralisation plutôt qu'une mémorisation.

Tout aussi intéressant est le choix d'éliminer le mécanisme d'attention pour les tâches avec des longueurs de contexte petites et fixes. S'inspirant du MLP-Mixer, TRM remplace l'auto-attention par de simples perceptrons multicouches appliqués sur la dimension de la séquence. Pour des grilles 9x9 comme dans le Sudoku, cela entraîne une amélioration de 74,7 % à 87,4 %. Cependant, pour les tâches avec des contextes plus larges comme les labyrinthes 30x30 ou ARC-AGI, l'auto-attention reste supérieure, ce qui démontre qu'il n'existe pas de solution universelle mais qu'il faut adapter l'architecture au problème spécifique.

Le Talon d'Achille et les Vrais Défis

Il serait malhonnête de présenter TRM comme une panacée universelle sans discuter de ses limites importantes. La première et la plus évidente concerne son domaine d'application : TRM est spécifiquement conçu pour les problèmes de raisonnement structuré avec des entrées et des sorties de forme fixe. Il ne peut pas discuter naturellement, il ne peut pas générer de texte créatif, il ne peut pas répondre à des questions ouvertes comme le fait ChatGPT. C'est un spécialiste chirurgical, pas un généraliste touche-à-tout.

La deuxième limitation concerne l'évolutivité du calcul pendant l'entraînement. La rétropropagation à travers 42 récursions nécessite beaucoup de mémoire, et l'article documente honnêtement comment l'augmentation excessive du nombre de récursions entraîne rapidement des erreurs de "Mémoire insuffisante" même sur des GPU de 80 Go. Cela impose une limite pratique à la profondeur de raisonnement que TRM peut atteindre, du moins avec les techniques d'entraînement actuelles.

Une troisième préoccupation concerne la généralisation au-delà des domaines d'entraînement. Oui, TRM généralise magnifiquement au sein de son domaine, résolvant des Sudokus ou des labyrinthes jamais vus auparavant avec une grande précision. Mais que se passe-t-il si vous lui présentez un type de puzzle complètement différent, ou si vous essayez de l'appliquer à une tâche qui n'entre pas dans la catégorie du "raisonnement structuré" ? L'article ne fournit pas de réponses définitives à ces questions, et il est plausible de penser que des réentraînements importants seraient probablement nécessaires.

De plus, TRM est intrinsèquement déterministe : pour une question donnée, il produit une seule réponse. Dans de nombreux contextes du monde réel, les questions ont plusieurs réponses valides ou nécessitent des explorations créatives de l'espace des solutions. Comme le notent les auteurs eux-mêmes dans les conclusions de l'article, l'extension de TRM à des tâches génératives nécessiterait des modifications architecturales substantielles.

Il y a aussi une question plus subtile mais importante : TRM nécessite toujours un entraînement supervisé avec des exemples étiquetés pour chaque nouvelle tâche. Il ne peut pas faire d'"apprentissage en quelques coups" comme le font les grands LLM, où vous pouvez décrire un nouveau problème avec quelques exemples et le modèle comprend immédiatement ce qu'il faut faire. Cela signifie que pour chaque nouveau domaine d'application, il faut collecter des données, concevoir des augmentations appropriées et effectuer un entraînement dédié.

Sur le plan pratique, il y a aussi la question de l'infrastructure et de l'écosystème. Les grands LLM bénéficient d'années de développement d'outils, de bibliothèques, de meilleures pratiques et d'une immense communauté de développeurs. TRM est un jeune projet open source, avec tous les défis que cela comporte en termes de documentation, de support, de débogage et d'intégration avec d'autres systèmes.

Le Contexte Économique : Pourquoi Maintenant ?

Pour comprendre pourquoi des approches comme TRM émergent en ce moment, nous devons examiner la réalité économique de l'IA en 2025. Les coûts d'entraînement et de déploiement des grands modèles de langage sont devenus prohibitifs pour quiconque n'est pas un géant de la technologie. Comme nous l'avons discuté dans l'article sur MemVid, la construction d'un petit centre de données d'IA coûte entre 10 et 50 millions de dollars, sans compter les coûts d'exploitation récurrents. Les bases de données vectorielles nécessaires pour gérer la mémoire à long terme de ces systèmes sont devenues des industries de plusieurs milliards de dollars, le marché atteignant 2,2 milliards de dollars en 2024.

Cette concentration de capital est en train de créer de facto une oligarchie de l'IA, où seules cinq ou six entreprises dans le monde peuvent se permettre de rivaliser au plus haut niveau. OpenAI a levé des milliards, Anthropic de même, et Google et Meta peuvent puiser dans les bénéfices de leurs activités principales. Mais pour les milliers de startups, de laboratoires universitaires et de chercheurs indépendants, la course à la mise à l'échelle est tout simplement hors de portée.

TRM et les approches similaires représentent une démocratisation de l'IA avancée. Avec quelques dizaines de milliers de dollars de ressources cloud, une petite équipe peut désormais entraîner des modèles qui battent les géants sur des tâches spécifiques. Cela abaisse considérablement les barrières à l'entrée et permet l'exploration d'un paysage beaucoup plus diversifié d'architectures et d'approches.

Il y a aussi une dimension environnementale qui ne peut être ignorée. Les centres de données qui entraînent les plus grands modèles consomment l'électricité de petites villes, avec des empreintes carbone mesurables en milliers de tonnes. Un modèle comme TRM, entraînable sur un seul GPU en moins de deux jours, a un impact environnemental littéralement dix mille fois inférieur. À une époque de prise de conscience croissante de la crise climatique, ce n'est pas une considération marginale.

Les Applications qui Changent les Règles

Où pourrait-il être judicieux de déployer TRM dans le monde réel ? La réponse se trouve dans les domaines où le raisonnement structuré profond est essentiel, où les données sont rares et où les ressources de calcul sont limitées.

Le premier domaine qui vient à l'esprit est la robotique, en particulier pour les appareils en périphérie qui doivent prendre des décisions complexes en temps réel sans pouvoir compter sur des connexions cloud constantes. Un robot industriel qui doit planifier des séquences de mouvements optimales, ou un drone autonome qui doit naviguer dans des environnements complexes, pourraient bénéficier énormément d'un modèle comme TRM qui peut "penser profondément" en utilisant des ressources de calcul minimales.

Dans le domaine médical, des tâches telles que le diagnostic de maladies rares ou la planification de stratégies thérapeutiques complexes nécessitent exactement le type de raisonnement abstrait et de généralisation dans lequel TRM excelle. Comme nous l'avons mentionné dans l'article sur HRM, des modèles similaires ont déjà démontré une précision de 97 % dans les prévisions climatiques saisonnières, ce qui suggère que la même approche pourrait fonctionner pour les prédictions médicales basées sur des modèles complexes.

L'éducation pourrait voir des applications fascinantes. Imaginez des systèmes de tutorat personnalisés qui peuvent vraiment "comprendre" où un étudiant bloque en mathématiques ou en physique, non pas simplement en fournissant la bonne réponse mais en guidant le raisonnement à travers des étapes logiques. TRM, avec sa capacité à itérer sur des problèmes complexes et sa transparence relative par rapport aux boîtes noires des LLM géants, pourrait être idéal pour ce type d'applications.

Dans le domaine de la cybersécurité, des tâches comme l'analyse de code malveillant, la détection de modèles d'attaque sophistiqués ou la vérification formelle de protocoles cryptographiques nécessitent un raisonnement profond sur des structures complexes. Ce sont exactement les contextes où un modèle petit mais intelligent bat un géant qui a vu tout Internet mais ne sait pas vraiment raisonner.

Enfin, il y a tout le monde de l'IA embarquée : appareils IoT, capteurs industriels, véhicules autonomes, où l'idée d'envoyer constamment des données vers le cloud pour traitement est irréalisable en raison de la latence, des coûts ou des contraintes de confidentialité. Comme nous l'avons vu avec MemVid et maintenant avec TRM, l'IA efficace ouvre des scénarios complètement nouveaux pour l'intelligence distribuée en périphérie du réseau.

Le Débat : Spécialistes contre Généralistes

L'émergence d'approches comme TRM ravive un débat fondamental dans l'IA : vaut-il mieux avoir des modèles gigantesques et généralistes qui font tout décemment, ou un écosystème de modèles spécialisés qui excellent dans leurs domaines spécifiques ?

Le paradigme actuel favorise les généralistes. OpenAI, Anthropic et Google misent tous sur des modèles de plus en plus grands et capables qui peuvent "tout" faire : écrire du code, analyser des images, mener des conversations naturelles, résoudre des problèmes mathématiques, etc. L'idée est qu'avec suffisamment de paramètres et suffisamment de données, une sorte d'intelligence générale émerge qui peut s'adapter à n'importe quelle tâche.

Mais cette stratégie a des coûts énormes. Chaque fois que GPT-5 ou Claude 4.5 sortent, ils nécessitent des ordres de grandeur de plus de ressources pour l'entraînement. La grande majorité de ces ressources sert à améliorer marginalement les performances sur des tâches qui ne nous intéressent peut-être même pas. Si vous utilisez GPT-4 principalement pour analyser des données scientifiques, vous payez quand même pour tout l'entraînement qui a servi à lui apprendre à écrire de la poésie, à jouer à des jeux de rôle textuels et à mille autres choses.

L'approche des spécialistes, que TRM représente, propose plutôt une architecture modulaire : des modèles petits et optimisés pour des tâches spécifiques, qui peuvent être combinés en systèmes plus complexes si nécessaire. Vous voulez un assistant IA complet ? Utilisez un petit LLM pour la compréhension du langage et la conversation, un TRM pour le raisonnement complexe, un modèle spécialisé pour la vision, un autre pour la génération de code. Chaque composant fait sa part exceptionnellement bien, et ensemble, ils couvrent un large éventail de capacités.

Cette approche modulaire présente des avantages significatifs au-delà de la pure efficacité. Elle permet des mises à jour indépendantes des composants, un débogage plus facile car vous savez exactement quel module échoue, et une transparence supérieure car le flux d'informations entre les modules spécialisés est plus traçable que la pensée impénétrable d'un géant monolithique.

Cependant, il y a aussi un inconvénient : les modèles généralistes présentent des capacités émergentes qui naissent de l'interaction de toutes leurs parties. Des phénomènes comme l'"apprentissage par transfert", où les connaissances acquises dans un domaine aident dans des domaines complètement différents, ou la capacité de "chaîne de pensée", où le modèle apprend spontanément à raisonner étape par étape, semblent nécessiter une certaine échelle. Si vous fragmentez trop, vous risquez de perdre cette magie émergente.

Mon sentiment est que nous assisterons à une convergence entre les deux approches. Les grands généralistes continueront d'exister pour les applications où ils sont vraiment nécessaires, mais la plupart des déploiements réels utiliseront probablement des systèmes hybrides : de petits modèles spécialisés pour les tâches critiques où l'efficacité compte, coordonnés par des modèles plus grands si nécessaire pour les tâches nécessitant une flexibilité extrême.

Au-delà des Benchmarks : Ce qui Manque Encore

Aussi impressionnants que soient les résultats de TRM sur les benchmarks, il est important de garder une perspective critique sur ce que ces chiffres nous disent vraiment et ce qu'ils laissent de côté. Les benchmarks comme ARC-AGI, aussi bien conçus soient-ils, restent des environnements contrôlés et artificiels. Le raisonnement dans le monde réel est souvent beaucoup plus complexe, ambigu et dépendant du contexte.

Une limitation fondamentale est le manque de robustesse aux entrées adverses. Les benchmarks publiés ont des formats bien définis, mais dans le monde réel, les entrées sont souvent bruitées, incomplètes ou délibérément trompeuses. Un système d'IA déployé en production doit gérer des utilisateurs qui posent des questions mal formulées, des données contenant des erreurs et des cas limites que personne n'avait prévus. Nous n'avons pas encore de données sur les performances de TRM dans ces scénarios.

Il y a ensuite la question de l'apprentissage continu. TRM est entraîné sur un ensemble de données statique puis gelé. Mais le monde réel change constamment : de nouveaux types de problèmes apparaissent, les règles des domaines évoluent, les normes changent. Les grands LLM peuvent être affinés ou mis à jour grâce à des techniques comme le RLHF, mais il n'est pas clair avec quelle facilité TRM peut s'adapter sans réentraînements complets.

L'explicabilité des choix est un autre domaine flou. Oui, TRM est plus transparent que les géants dans la mesure où nous pouvons observer comment son état latent évolue à travers les récursions. Mais cet état latent reste un vecteur multidimensionnel dans un espace qui ne correspond pas directement à des concepts humains interprétables. Lorsque TRM se trompe, avec quelle facilité pouvons-nous comprendre pourquoi et corriger le problème ?

Sur le plan de la sécurité, les modèles petits et efficaces comme TRM soulèvent de nouvelles questions. S'il devient possible d'entraîner des modèles très performants avec des ressources modestes, cela abaisse aussi considérablement les barrières pour les acteurs malveillants. Un groupe aux intentions malveillantes pourrait entraîner un TRM spécialisé dans des tâches telles que la recherche de vulnérabilités logicielles, la génération d'exploits ou l'optimisation de stratégies d'attaque. La démocratisation de l'IA est souhaitable, mais elle s'accompagne de responsabilités que la communauté doit encore pleinement assumer.

Enfin, il y a la question de l'évaluation elle-même. Les benchmarks actuels, aussi difficiles soient-ils, mesurent principalement les capacités de raisonnement abstrait sur des problèmes bien définis. Mais une grande partie de l'intelligence humaine concerne la capacité à naviguer dans l'ambiguïté, à gérer l'incertitude, à intégrer des connaissances de différents domaines et à raisonner sur des systèmes ouverts sans frontières nettes. Quelle part de cette intelligence plus nuancée TRM peut-il capturer ? L'article ne fournit pas de réponses, et il faudra probablement des années de recherche pour le découvrir.

La Frontière de la Recherche : Quelle est la Suite ?

En ce qui concerne l'avenir immédiat, il existe plusieurs directions prometteuses que la recherche sur les architectures récursives comme TRM pourrait explorer. La première et la plus évidente concerne l'extension aux tâches génératives. Comme mentionné dans l'article de Samsung, TRM produit actuellement des sorties déterministes, mais de nombreux problèmes du monde réel nécessitent l'exploration de l'espace des solutions, la génération de multiples alternatives et l'évaluation probabiliste des options. L'intégration de mécanismes d'échantillonnage et d'évaluation de l'incertitude dans TRM pourrait ouvrir des applications entièrement nouvelles.

Une deuxième frontière concerne l'apprentissage par transfert entre les domaines. Actuellement, TRM est entraîné séparément pour chaque tâche, mais il y a des indices dans l'article qui suggèrent des possibilités intéressantes. Le fait que la même architecture fonctionne exceptionnellement bien sur le Sudoku, les labyrinthes et les puzzles ARC-AGI, qui sont superficiellement très différents, suggère que TRM apprend quelque chose de plus fondamental sur le raisonnement abstrait. On pourrait imaginer un pré-entraînement sur un large éventail de tâches de raisonnement, suivi d'un affinage rapide sur des domaines spécifiques.

La troisième direction concerne l'intégration avec des systèmes symboliques. TRM fonctionne entièrement dans le domaine sous-symbolique des réseaux de neurones, mais de nombreux problèmes de raisonnement complexe dans le monde réel bénéficieraient de l'intégration avec des moteurs d'inférence logique, des solveurs de contraintes ou des planificateurs symboliques. Des systèmes hybrides qui combinent la capacité de TRM à apprendre des modèles à partir de données avec la précision et la vérifiabilité du raisonnement symbolique pourraient être extrêmement puissants.

Sur le front de l'efficacité, il y a encore une marge d'amélioration. L'article mentionne que l'augmentation du nombre de récursions entraîne rapidement des problèmes de mémoire, mais des techniques comme le "gradient checkpointing", la quantification ou des architectures plus économes en mémoire pourraient permettre des récursions encore plus profondes sur le même matériel. De même, des optimisations au niveau de la compilation et du matériel spécialisé pour les opérations récursives pourraient accélérer davantage l'entraînement et l'inférence.

Une direction particulièrement fascinante concerne le méta-apprentissage : entraîner TRM à apprendre à apprendre. Au lieu d'entraîner manuellement pour chaque nouvelle tâche, on pourrait imaginer un système qui, à partir de quelques centaines d'exemples d'un problème complètement nouveau, détermine automatiquement l'architecture optimale, le nombre de récursions nécessaires et les stratégies d'augmentation appropriées. Cela nécessiterait probablement un niveau d'abstraction supérieur, peut-être un "méta-TRM" qui raisonne sur la manière de configurer TRM pour des tâches spécifiques.

La Leçon de One Punch Man : Quand l'Entraînement de Base Bat le Talent Pur

Il y a une métaphore de la culture pop qui me vient à l'esprit en pensant à TRM. Dans One Punch Man, le protagoniste Saitama acquiert une force littéralement invincible non pas grâce à des pouvoirs spéciaux ou à des technologies avancées, mais grâce à un régime d'entraînement absurdement simple et répétitif : cent pompes, cent abdominaux, cent squats et dix kilomètres de course, chaque jour. Les autres héros avec leurs pouvoirs exotiques et complexes le regardent perplexes, mais Saitama les surpasse tous précisément grâce à cette répétition méthodique et obsessionnelle.

TRM est un peu comme ça. Là où les géants de l'IA accumulent des milliards de paramètres et des architectures de plus en plus élaborées, TRM prend un réseau minuscule de deux couches et le fait récurer sur lui-même encore et encore et encore, avec une patience quasi zen. Pas de théorèmes compliqués, pas de justifications biologiques élaborées, juste une récursion disciplinée et une supervision profonde. Et ça marche mieux.

Cette leçon a des implications qui vont au-delà de l'architecture spécifique de TRM. Elle suggère que dans le domaine de l'IA, comme dans beaucoup d'autres, nous avons peut-être atteint un point de rendements décroissants de la simple accumulation de complexité. L'élégance architecturale, la compréhension profonde des mécanismes d'apprentissage et l'optimisation intelligente pourraient apporter plus de gains que le simple fait de "tout faire en plus grand".

Vers une Écologie de l'Intelligence Artificielle

L'une des perspectives les plus intéressantes ouvertes par TRM et des approches similaires est l'idée d'une écologie de l'intelligence artificielle, plutôt qu'une monoculture dominée par quelques géants. Dans la nature, les écosystèmes les plus robustes et adaptatifs ne sont pas ceux dominés par un seul super-prédateur, mais ceux caractérisés par la diversité : d'innombrables espèces, chacune optimisée pour sa propre niche, qui interagissent dans des réseaux complexes de symbiose et de compétition.

Nous pourrions imaginer un avenir similaire pour l'IA. Au lieu d'une industrie où cinq entreprises contrôlent cinq modèles géants qui tentent de tout faire, nous pourrions avoir des milliers de modèles spécialisés, chacun excellent dans son propre domaine. TRM pour le raisonnement abstrait, MemVid pour la gestion efficace de la mémoire, des modèles spécialisés pour la vision, pour le langage naturel, pour la planification, pour l'apprentissage continu. Ces modèles pourraient être développés par une communauté mondiale de chercheurs, ouverts, vérifiables et composables.

Ce paradigme aurait d'énormes avantages. Premièrement, il réduirait la concentration de pouvoir que nous observons dans l'IA, où quelques entreprises contrôlent de facto l'accès à l'intelligence artificielle avancée. Deuxièmement, il permettrait une innovation beaucoup plus rapide, car de petites équipes pourraient contribuer à des améliorations de composants spécifiques sans avoir à rivaliser dans l'entraînement de modèles gigantesques. Troisièmement, il améliorerait la robustesse globale du système, car la défaillance d'un composant ne compromettrait pas l'ensemble de la pile.

Bien sûr, cela nécessiterait des infrastructures de coordination, des normes d'interopérabilité et des mécanismes de gouvernance qui n'existent pas actuellement. Mais des projets open source comme TRM sur GitHub posent les bases de cette vision, en démontrant qu'il est possible de développer et de partager ouvertement une IA avancée.

La Route à Suivre : Prédictions et Espoirs

En ce qui concerne les prochaines années, il est raisonnable de s'attendre à une explosion de variations et d'améliorations sur le thème du raisonnement récursif. TRM a montré que l'approche est viable et puissante, mais comme toute innovation significative, elle soulève plus de questions qu'elle n'en résout. D'autres laboratoires explorent déjà des variations : des modèles récursifs avec différents mécanismes d'attention, des architectures qui apprennent dynamiquement combien de récursions utiliser pour chaque problème, des systèmes qui combinent la récursion avec la récupération d'informations externes.

Sur le front industriel, je m'attends à une adoption relativement rapide dans des domaines spécifiques où les avantages de TRM sont écrasants. La robotique, les véhicules autonomes, les systèmes embarqués et les applications en périphérie où l'efficacité est essentielle sont des candidats évidents. Nous pourrions également voir des startups proposer des "TRM-as-a-Service" pour des tâches de raisonnement spécifiques, en concurrence avec les géants précisément sur la capacité à faire plus avec moins.

Dans le monde universitaire, TRM fournit un nouveau cadre pour explorer des questions fondamentales sur l'apprentissage et la généralisation. Pourquoi la récursion fonctionne-t-elle si bien ? Qu'est-ce que TRM apprend réellement dans l'espace latent pendant ses itérations ? Comment pouvons-nous caractériser formellement la classe de problèmes pour lesquels cette approche est optimale ? Ce sont des sujets de recherche qui occuperont les doctorants et les post-doctorants pendant des années.

Il y a aussi une dimension géopolitique à prendre en compte. La concentration de l'IA avancée dans quelques entreprises américaines et chinoises a créé des préoccupations en Europe et dans d'autres régions. Des approches comme TRM, qui abaissent considérablement les barrières à l'entrée, pourraient permettre à des pays disposant de moins de ressources de calcul de développer tout de même des capacités d'IA avancées. Cela pourrait rééquilibrer partiellement le paysage mondial de l'IA, avec des implications pour la concurrence économique, la sécurité nationale et la gouvernance internationale de la technologie.

Réflexions Finales : L'Intelligence Comme Processus, Pas Comme Produit

TRM nous rappelle une vérité fondamentale que l'industrie de l'IA avait peut-être oubliée dans sa course à la mise à l'échelle : l'intelligence n'est pas une question de taille, mais de processus. Peu importe la taille de votre modèle ou le nombre de paramètres qu'il contient. Ce qui compte, c'est la manière dont il traite l'information, dont il itère sur son propre raisonnement, dont il affine progressivement ses propres conclusions.

Cette intuition résonne avec notre expérience humaine. Les personnes les plus intelligentes que nous connaissons ne sont pas nécessairement celles qui ont le plus gros cerveau ou le plus de neurones. Ce sont celles qui pensent méthodiquement, qui considèrent les problèmes sous de multiples angles, qui revoient leurs propres conclusions, qui apprennent de leurs propres erreurs. En d'autres termes, ce sont celles qui itèrent efficacement sur leur propre processus de raisonnement.

S'il y a une leçon que nous pouvons tirer de l'émergence de TRM, de DeepConf, de MemVid et de la tendance plus large vers l'efficacité dans l'IA, c'est que l'avenir n'appartiendra pas nécessairement aux plus grands, mais aux plus astucieux. L'industrie se réveille lentement à la prise de conscience que jeter plus de ressources sur les problèmes a des rendements décroissants, et que l'innovation architecturale intelligente peut produire des sauts qualitatifs que la simple mise à l'échelle n'atteindra jamais.

Comme le petit Saitama de One Punch Man qui terrasse des monstres cosmiques avec son entraînement de base, ou comme le minuscule Luke Skywalker qui apprend que la Force n'est pas une question de taille, TRM nous montre que dans l'IA, le vieil adage est toujours d'actualité : ce n'est pas votre taille qui compte, c'est la manière dont vous utilisez ce que vous avez.

Et dans un monde où les ressources informatiques et environnementales sont de plus en plus sous pression, où la concentration du pouvoir technologique soulève des préoccupations démocratiques légitimes, et où l'accès à l'intelligence artificielle avancée pourrait déterminer le succès ou l'échec d'économies entières, cette leçon ne pourrait pas arriver à un moment plus opportun.

L'article de Samsung SAIL Montréal n'est pas seulement une innovation technique. C'est un manifeste pour une manière différente de penser l'intelligence artificielle, une qui privilégie l'élégance à la force brute, l'accessibilité à la concentration, la durabilité à la croissance indiscriminée. Si cette approche prend racine, et tous les indices suggèrent qu'elle le fera, nous pourrions considérer TRM comme le tournant où l'industrie de l'IA a finalement appris que plus petit peut vraiment être plus intelligent.