Das Virtuelle Krankenhaus: Wenn Künstliche Intelligenz zum Arzt wird

Das chinesische Agent Hospital simuliert täglich Tausende von Diagnosen in einer virtuellen Welt. Ist das die Zukunft der Medizin oder der Beginn einer Revolution, nach der niemand gefragt hat? Stellen Sie sich ein Krankenhaus vor, das rund um die Uhr, sieben Tage die Woche in Betrieb ist. Ärzte besuchen Patienten, ordnen Tests an, interpretieren Röntgenbilder, verschreiben Therapien. In wenigen Tagen behandeln sie zehntausend klinische Fälle und sammeln so eine Erfahrung, die in einer überfüllten Notaufnahme Jahre dauern würde. Es gibt nur ein Detail, das das alles beunruhigend macht: Keiner dieser Patienten existiert wirklich. Niemand leidet, niemand heilt, niemand stirbt. Es ist, als ob *Die Sims auf Emergency Room in einer Dimension getroffen wäre, in der niemand spielt, aber etwas lernt.*

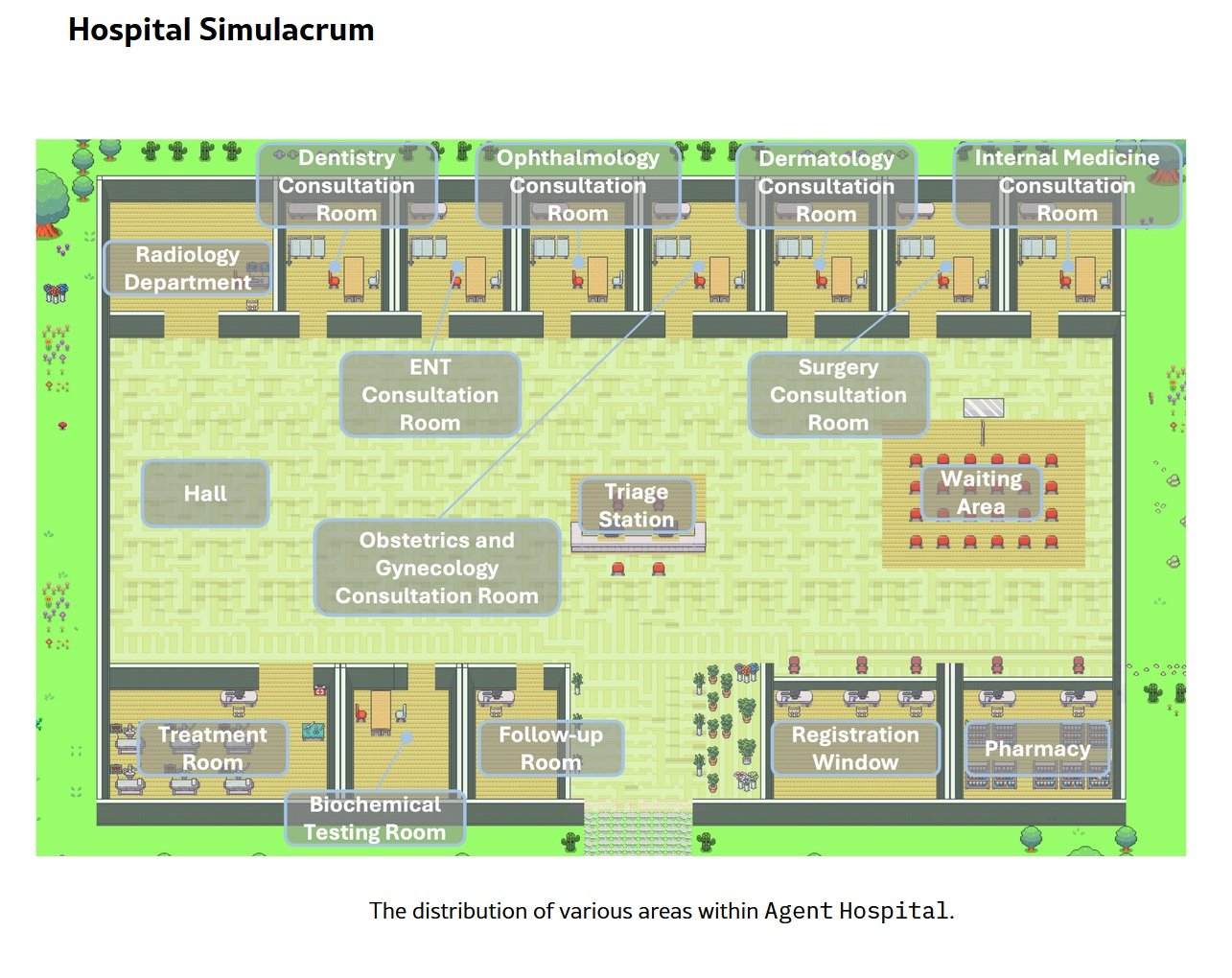

Das Agent Hospital der Tsinghua-Universität, das im April 2025 mit der ersten Integration im Pekinger Changgung-Krankenhaus offiziell eingeweiht wurde, ist mehr als nur ein akademisches Experiment. Es ist ein ganzes synthetisches Gesundheitssystem, in dem künstliche Intelligenzen trainieren, Ärzte zu sein, indem sie Wesen behandeln, die nur als Codezeilen existieren. Zweiundvierzig virtuelle Ärzte, einundzwanzig medizinische Fachgebiete, fünfhunderttausend Patienten, die nie geatmet haben. Die Frage ist nicht mehr, ob künstliche Intelligenz medizinische Diagnosen stellen kann: Die Frage ist, ob wir die Ärzte der Zukunft bauen oder ob wir gerade eine Büchse der Pandora geöffnet haben, die niemand mehr zu schließen weiß.

Anatomie einer Virtuellen Welt

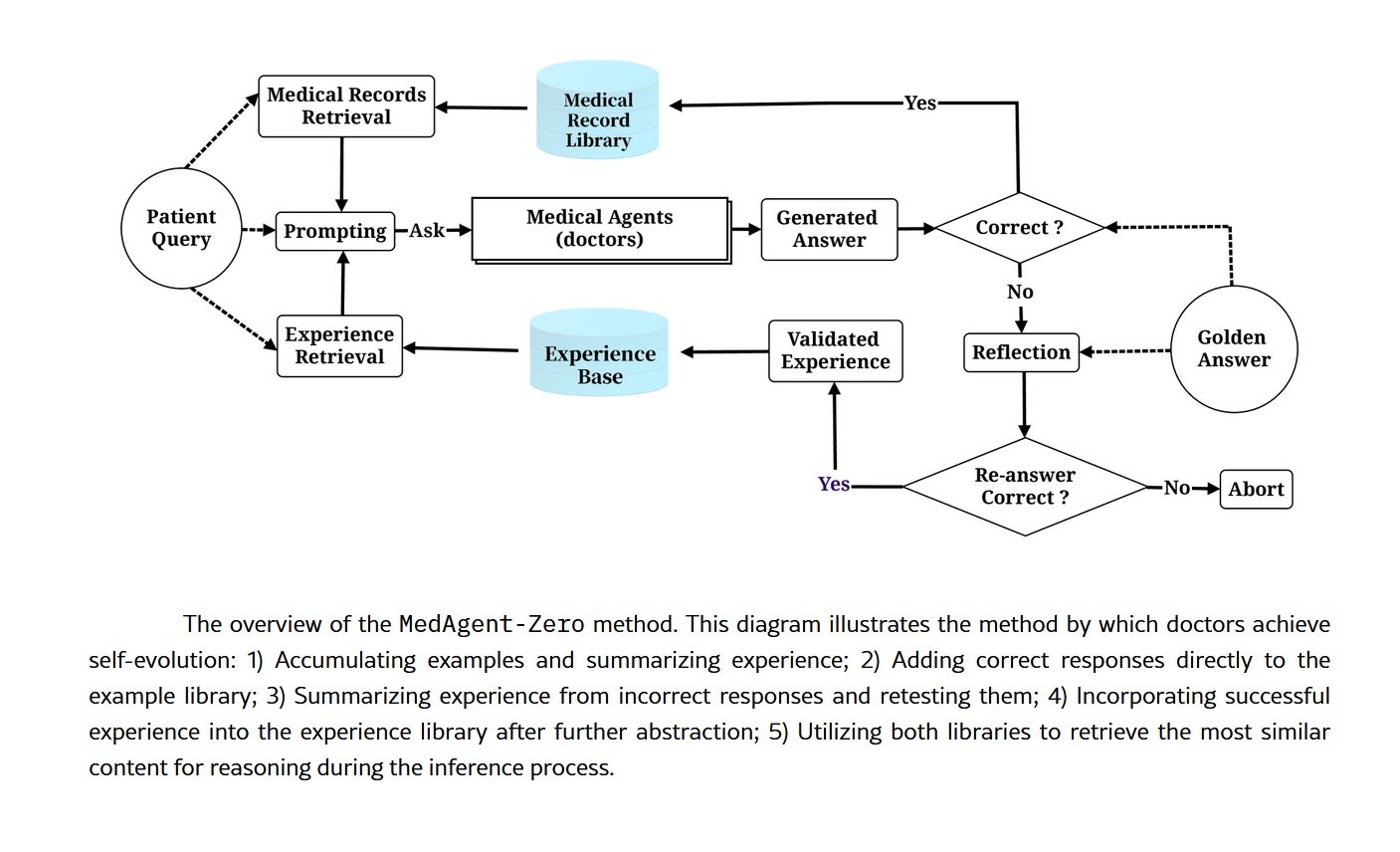

Unter der Haube des Agent Hospital steckt MedAgent-Zero, ein technisch hochentwickeltes Framework, das den traditionellen Ansatz für das Training medizinischer künstlicher Intelligenzen auf den Kopf stellt. Anstatt ein Modell mit statischen Datensätzen vergangener klinischer Fälle zu füttern, haben die Forscher der Tsinghua eine Umgebung geschaffen, in der KI-Agenten durch Handeln lernen, genau wie es Assistenzärzte aus Fleisch und Blut tun würden. Der Unterschied liegt im Maßstab und in der Geschwindigkeit: Was ein menschlicher Arzt in einer vierjährigen Facharztausbildung lernt, geschieht hier in Tagen kontinuierlicher Simulation.

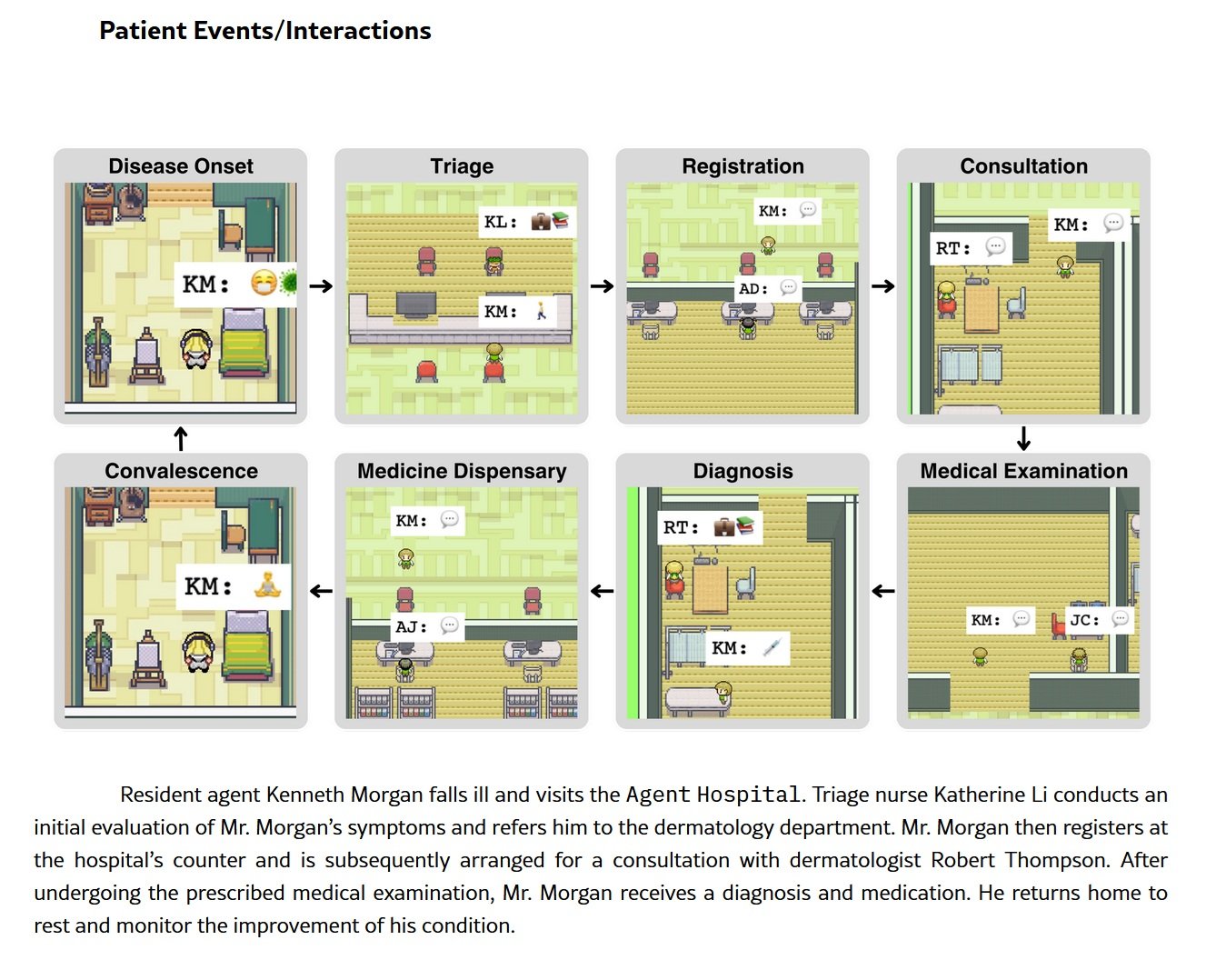

Die Architektur basiert auf großen Sprachmodellen, die für den Betrieb in einem ewigen Lernzyklus modifiziert wurden. Das System generiert autonom Profile von synthetischen Patienten mit Krankengeschichten, Symptomen und Laborergebnissen. Diese virtuellen Patienten betreten das Geisterkrankenhaus und werden den KI-Ärzten zugewiesen, die jeweils auf ein bestimmtes Gebiet spezialisiert sind: Kardiologie, Onkologie, Lungenheilkunde, Neurologie. Die Agenten führen Anamnesen durch, fordern diagnostische Tests an, interpretieren Daten, formulieren Diagnosen und schlagen Behandlungspläne vor. Nach jeder Interaktion bewertet ein Feedback-System die Richtigkeit der klinischen Entscheidungen, indem es sie mit etablierten Leitlinien und der Ground Truth des simulierten Falls vergleicht. Fehler werden zu Lektionen, Erfolge stärken die Entscheidungsmuster.

Die aktuellen Zahlen sind beeindruckend, aber nicht perfekt, und diese Ehrlichkeit in den Metriken ist vielleicht aussagekräftiger als die Prozentsätze selbst. In der Untersuchungsphase, also der Anamnese und Datenerhebung, erreicht das System eine Genauigkeit von 88 Prozent. In der Diagnosephase steigt sie auf 95,6 Prozent. Bei der Behandlungsplanung, der komplexesten Phase, da sie nicht nur die Identifizierung der Krankheit erfordert, sondern auch die Abwägung von therapeutischer Wirksamkeit, Nebenwirkungen, Komorbiditäten und Patientenpräferenzen, sinkt die Genauigkeit auf 77,6 Prozent. Im MedQA-Benchmark, der Fragen im Stil des USMLE (des US-amerikanischen medizinischen Staatsexamens) mit Schwerpunkt auf Atemwegserkrankungen verwendet, erreichte das System 93 Prozent.

Sind das Leistungen, die viele menschliche Ärzte blass aussehen lassen würden? Das kommt darauf an. 93 Prozent bei Multiple-Choice-Fragen sind für ein auf diese Art von Aufgabe optimiertes KI-System ausgezeichnet, aber nicht außergewöhnlich. 77 Prozent bei der Behandlungsplanung sind besorgniserregender: Das bedeutet, dass in fast einem von vier Fällen die vorgeschlagene Therapie nicht optimal ist. In einem echten Krankenhaus, mit echten Patienten, würde dieser Prozentsatz Tausende potenziell schwerwiegender Fehler bedeuten. Aber hier zeigt sich der wahre Wert der Simulation: Diese Fehler passieren in einer sicheren Umgebung, in der die einzige Konsequenz eine Anpassung der neuronalen Gewichte ist.

Die Zeitkompression ist die wahre Superkraft dieser Architektur. Was in der Medizin Jahre klinischer Erfahrung, die Exposition gegenüber Hunderten verschiedener Fälle und schlaflose Nächte im Dienst erfordert, wird hier in Rechenzyklen komprimiert. Ein KI-Arzt kann in einer Simulationswoche mehr Fälle von atypischer Lungenentzündung sehen als ein menschlicher Pneumologe in seiner gesamten Karriere in einem Provinzkrankenhaus. Das Problem ist zu verstehen, ob die Quantität der Exposition wirklich der Qualität der Kompetenz entspricht.

Vom Virtuellen zum Realen

Der Zeitplan für die Einführung des Agent Hospital erzählt eine Geschichte von schwindelerregender Beschleunigung. Die internen Tests begannen im November 2024, als das System noch auf die Labore der Tsinghua-Universität beschränkt war. Der öffentliche Pilotversuch startete im ersten Quartal 2025, wobei echte Ärzte begannen, mit den von der KI generierten Diagnosen in kontrollierten Szenarien zu interagieren. Im April 2025 erfolgte die operative Integration in das Pekinger Changgung-Krankenhaus, was den Übergang von einem akademischen Experiment zu einem effektiven klinischen Werkzeug markierte.

Hinter diesem Übergang steht Tairex, das Spin-off-Startup, das die Technologie unter der Marke Zijing AI Doctor vermarktet. Die 42 virtuellen Ärzte decken heute über 300 Krankheiten ab und sind in Pilotprogrammen aktiv, die von der Augenheilkunde über die Radiologie und die Lungenheilkunde bis hin zur Allgemeinmedizin reichen. Es handelt sich nicht um einfache medizinische Chatbots oder telefonische Triage-Systeme: Diese KI-Agenten sind in die realen Arbeitsabläufe der Krankenhäuser integriert, unterstützen menschliche Ärzte bei der Auswertung diagnostischer Bilder, schlagen Differentialdiagnosen vor und empfehlen evidenzbasierte Behandlungsprotokolle.

Das Wirtschaftsmodell hinter dieser Revolution ist zugleich ehrgeizig und pragmatisch. Die konservativsten Schätzungen sprechen von einer potenziellen Einsparung von 10-20 Prozent der gesamten Krankenhauskosten. Projiziert auf das Jahr 2050 allein im US-Gesundheitssystem würde dies eine Spanne zwischen 300 und 900 Milliarden Dollar pro Jahr bedeuten. Zahlen, die die Augen von Krankenhaus-CFOs und Healthtech-Investoren leuchten lassen, aber unbequeme Fragen aufwerfen: Optimieren wir die Patientenversorgung oder optimieren wir die Bilanzen?

Das erklärte Ziel der chinesischen Forscher ist zweifach und scheinbar edel. Einerseits soll die gesundheitliche Kluft in ländlichen Gebieten und Regionen mit einem Mangel an Fachärzten geschlossen werden, ein besonders akutes Problem in einem Land mit 1,35 Milliarden Einwohnern, die über ein riesiges Gebiet verteilt sind. Andererseits soll ein Trainingsgelände für sogenannte "KI-kollaborative Ärzte" geschaffen werden, eine neue Generation von Medizinern, die nicht gegen die künstliche Intelligenz arbeiten oder von ihr ersetzt werden, sondern lernen, sie als Instrument zur kognitiven Steigerung zu orchestrieren. Es ist eine verführerische, fast utopische Vision. Der Teufel steckt wie immer in der Umsetzung.

Die dunkle Seite des Algorithmus

Rechtliche Haftung im regulatorischen Vakuum

Der erste Riss im glänzenden Gebäude der medizinischen KI zeigt sich bei der Frage der Haftung. Wenn ein KI-Arzt eine Fehldiagnose stellt, wer ist dann verantwortlich? Der menschliche Arzt, der die Entscheidung beaufsichtigt (oder nicht beaufsichtigt) hat? Das Krankenhaus, das das System implementiert hat? Die Entwickler, die das Modell trainiert haben? Die Universität, die die Forschung durchgeführt hat? Die ehrliche Antwort ist: Niemand weiß es mit Sicherheit, denn die rechtlichen Rahmenbedingungen hinken der Technologie dramatisch hinterher.

Die US-amerikanische Food and Drug Administration stuft medizinische Algorithmen als Medizinprodukte ein, aber die bestehenden Kategorien erfassen nicht die dynamische Natur von auf maschinellem Lernen basierenden Systemen, die nach der Bereitstellung weiterlernen. Die europäische Medizinprodukteverordnung ist in diesen Aspekten noch vager. In China, wo das Agent Hospital Gestalt annimmt, ist die regulatorische Situation für westliche Beobachter undurchsichtig, aber offensichtlich nachsichtig genug, um diese groß angelegten Experimente zu ermöglichen.

Dann gibt es das Problem der informierten Einwilligung. Wenn ein Patient eine Station betritt, auf der diagnostische Entscheidungen von Algorithmen beeinflusst oder bestimmt werden, weiß er das? Wird ihm erklärt, dass sein Röntgenbild zuerst von einem KI-System analysiert und erst dann von einem menschlichen Radiologen überprüft wird? Dass der Behandlungsplan von einem künstlichen Agenten erstellt wurde, der an Patienten trainiert wurde, die nie existiert haben? Die Kluft zwischen theoretischer Transparenz und klinischer Alltagspraxis kann peinlich sein.

Das Risiko des medizinischen "Deskilling"

Die übermäßige Abhängigkeit von künstlicher Intelligenz ist kein dystopisches Zukunftsszenario: Sie ist ein gegenwärtiges und dokumentiertes Risiko. Wenn sich Ärzte daran gewöhnen, immer eine algorithmische Zweitmeinung zur Verfügung zu haben, erodieren ihre unabhängigen klinischen Fähigkeiten. Es ist dasselbe Prinzip, nach dem die neuen Generationen die Fähigkeit verloren haben, sich ohne GPS zu orientieren: Die Technologie wird zur kognitiven Krücke, und wenn sie fehlt, bricht die Leistung zusammen.

Die Auswirkungen auf Medizinstudenten sind potenziell noch gravierender. Wenn Assistenzärzte lernen, Diagnosen an der Seite von KI-Systemen zu stellen, die immer die Antwort vorschlagen, werden sie dann jemals das autonome klinische Denken entwickeln, das für den Einsatz in Kontexten erforderlich ist, in denen diese Technologie nicht verfügbar ist? Oder schaffen wir eine Generation von Ärzten, die nur mit den Stützrädern des künstlichen Assistenten funktionieren? Die Variabilität zwischen den Gesundheitseinrichtungen verschärft das Problem: Ein Arzt, der in einem hochtechnologischen Krankenhaus mit integriertem Agent Hospital ausgebildet wurde, könnte Schwierigkeiten haben, wenn er in eine ländliche Klinik mit begrenzten Ressourcen wechselt.

Algorithmische Verzerrungen und Repräsentativität

Fünfhunderttausend synthetische Patienten sind viel, aber repräsentieren sie die tatsächliche Vielfalt der menschlichen Bevölkerung? Die KI-Ärzte trainieren an Fällen, die von Modellen generiert werden, die unweigerlich Verzerrungen aus den Daten enthalten, auf denen sie vor-trainiert wurden. Wenn diese Daten bestimmte Bevölkerungsgruppen (typischerweise Männer, Kaukasier, mittleren Alters) überrepräsentieren und andere (Frauen, ethnische Minderheiten, ältere Menschen, Patienten mit multiplen Pathologien) unterrepräsentieren, perpetuiert und verstärkt das System die bestehenden Ungleichheiten.

Das Problem der Datensouveränität fügt eine weitere Komplexitätsebene hinzu. Die virtuellen Patienten des Agent Hospital wurden von Modellen generiert, die auf welchen Daten trainiert wurden? Stammen sie aus chinesischen, westlichen oder globalen Populationen? Sind seltene Krankheiten in asiatischen Populationen im Vergleich zu denen, die für andere geografische Gebiete typisch sind, überrepräsentiert? Und vor allem: Wenn diese Systeme in andere Länder exportiert und implementiert werden, werden sie bei genetisch und klinisch unterschiedlichen Populationen genauso gut funktionieren?

Der Elefant im Raum: die Empathie

Dong Jiahong, ein chinesischer Akademiker, der in der Debatte über das Agent Hospital zitiert wird, fasste den grundlegendsten Einwand mit einem Satz zusammen, der fast poetisch klingt: "Medizin ist die Wissenschaft der Liebe, aber künstliche Intelligenz bleibt kalt." Das ist kein Luddismus oder romantische Nostalgie: Es ist die Anerkennung, dass die Arzt-Patient-Beziehung Komponenten hat, die sich der algorithmischen Quantifizierung entziehen.

Ein KI-Arzt kann Symptome analysieren, Labordaten korrelieren, Diagnosen mit Konfidenzprozentsätzen mit drei Dezimalstellen vorschlagen. Er kann nicht den Blick eines Patienten erfassen, der aus Scham Informationen verbirgt, er kann nicht das Zögern in der Stimme von jemandem lesen, der Angst hat, Fragen zu stellen, er kann nicht den Trost einer menschlichen Präsenz im Moment der schlechten Nachricht bieten. Die menschliche Berührung ist kein romantisches optionales Extra in der Medizin: Sie ist ein integraler Bestandteil des therapeutischen Prozesses, der durch jahrzehntelange Forschung über den Placebo-Effekt, die Therapie-Compliance und die psychologischen Ergebnisse dokumentiert ist.

Wenn wir die Diagnose an künstliche Systeme delegieren, was geschieht dann mit dieser relationalen Dimension? Einige argumentieren, dass die Befreiung der Ärzte von rechnerischen Aufgaben ihnen ermöglichen würde, mehr Zeit für den menschlichen Aspekt zu widmen. Andere befürchten, dass die Medizin zunehmend zu einer körperlosen Erfahrung wird, bei der der Patient mit Bildschirmen und Algorithmen interagiert, während der menschliche Arzt zu einem distanzierten Supervisor wird, einem Qualitätskontrolleur, der von Maschinen generierte Berichte unterzeichnet.

Die Frage, die niemand stellt

Wer hat eigentlich nach dieser Revolution gefragt? Haben Patienten Demonstrationen organisiert, um mehr KI auf den Stationen zu haben? Haben Ärzte gestreikt, um virtuelle Agenten zu bekommen, die sie unterstützen? Die unbequeme Antwort ist, dass das Agent Hospital aus einer Agenda hervorgeht, die mehr mit wirtschaftlicher Effizienz und technologischer Zurschaustellung zu tun hat als mit von unten geäußerten Bedürfnissen. Es ist das Angebot, das die Nachfrage schafft, der klassische "Technology Push", getarnt als notwendige Innovation.

Das Paradox der Effizienz durchdringt den gesamten Diskurs über medizinische KI. Ist schneller immer besser? Ist eine korrekte Diagnose in dreißig Sekunden wirklich besser als eine korrekte Diagnose in zehn Minuten, wenn letztere ein Gespräch beinhaltet, das den Patienten beruhigt und Vertrauen aufbaut? Optimieren wir Metriken, die wirklich zählen, oder optimieren wir das, was leicht zu messen ist?

Cronenberg in eXistenZ erforschte den Moment, in dem die Simulation realer wird als die Realität, wenn die Grenzen zwischen den Existenzebenen verschwimmen und niemand mehr weiß, in welcher Dimension er operiert. Das Agent Hospital wirft eine strukturell ähnliche Frage auf: Wenn ein System, das an nicht existierenden Patienten trainiert wurde, beginnt, echte Menschen zu behandeln, wo ziehen wir die Grenze zwischen validierter Simulation und klinischer Praxis? Wer entscheidet, wann die virtuelle Zeitkompression genug Erfahrung generiert hat, um Jahrzehnten menschlicher Praxis zu entsprechen?

Die Perspektiven sind entlang geografischer und kultureller Achsen polarisiert. Die Dringlichkeit Chinas ist verständlich: eine schnell alternde Bevölkerung, ein chronischer Mangel an Fachärzten, enorme gesundheitliche Ungleichheiten zwischen den Küsten-Megastädten und den Binnenprovinzen. Für Peking ist das Agent Hospital kein philosophisches Experiment, sondern eine pragmatische Lösung für reale und unmittelbare Probleme. Die westliche Vorsicht spiegelt hingegen unterschiedliche Gesundheitssysteme, strengere rechtliche Rahmenbedingungen und eine größere Sensibilität (zumindest theoretisch) für die Autonomie des Patienten und die informierte Einwilligung wider.

Die letzte Frage ist brutal einfach: Bauen wir Werkzeuge für die Menschheit oder ersetzen wir die Menschheit durch Werkzeuge? Die Unterscheidung ist nicht akademisch. Im ersten Fall ist die medizinische KI ein Verstärker der menschlichen Fähigkeiten, eine Möglichkeit, die Kompetenz guter Ärzte zu erweitern und die Lücken der weniger vorbereiteten zu schließen. Im zweiten Fall ist es der Beginn eines Weges, auf dem der medizinische Beruf zunehmend automatisiert wird, auf dem klinische Entscheidungen von menschlichen kognitiven Prozessen zu überwachten algorithmischen Ketten migrieren.

Die dünner werdende Grenze

Das Agent Hospital ist ein Spiegel, der unsere Prioritäten als technologische Zivilisation widerspiegelt. Es zeigt, was wir bewerten (Effizienz, Skalierbarkeit, optimierte Kosten) und was wir bereit sind zu opfern (relationale Zeit, menschliche klinische Intuition, das Recht, von jemandem behandelt zu werden, der die Erfahrung von Krankheit und Heilung gemacht hat). Die Technologie an sich ist neutral, eine so abgedroschene Wahrheit, dass sie fast leer geworden ist. Aber die Umsetzung ist niemals neutral: Jede Entscheidung zur Bereitstellung offenbart ethische Annahmen, wirtschaftliche Verzerrungen, anthropologische Visionen.

Die zehntausend virtuellen Patienten, die heute die Geisterstationen von Tsinghua bevölkern, könnten morgen wir sein, die in Ambulanzen sitzen, in denen die erste Anamnese von einem KI-Agenten durchgeführt wird, in denen unser Röntgenbild von neuronalen Netzen gelesen wird, die an Millionen von synthetischen Bildern trainiert wurden, in denen uns der Behandlungsplan von einem menschlichen Arzt vorgestellt wird, der einfach nur validiert, was der Algorithmus bereits entschieden hat. Das ist keine Science-Fiction: Es ist bereits hier, in der Pilotphase, in kontrollierter Expansion, und wartet darauf, skaliert zu werden.

Die Frage ist nicht mehr, "ob" diese Zukunft kommen wird. Es ist, "wie" wir sie bewältigen werden, mit welchen Schutzmaßnahmen, mit wie viel Transparenz, mit welchem Gleichgewicht zwischen systemischer Effizienz und individueller Würde. Das Agent Hospital der Tsinghua-Universität ist nicht die Antwort: Es ist der Beginn des Gesprächs, das wir vor Jahren hätten beginnen sollen. Besser spät als nie, aber die Zeit drängt. Algorithmen lernen schnell. Wir Menschen, viel weniger.