Das Internet, das sich selbst frisst: Wenn KI Müll erzeugt, der andere KI füttert

Es gibt eine Szene in John Carpenters "Das Ding aus einer anderen Welt", in der das Alien irdische Organismen assimiliert und dabei immer schlechtere, immer weniger perfekte Kopien erstellt. Jede Iteration verliert etwas vom Original, bis die Unterscheidung zwischen authentisch und Replik unmöglich wird. Es ist ein starkes Bild, um zu beschreiben, was mit dem digitalen Ökosystem geschieht: Künstliche Intelligenz konsumiert menschliche Inhalte, um sie in immer korrupterer Form zu regenerieren, und befeuert so einen Kreislauf der fortschreitenden Verschlechterung, den Wissenschaftler als "Modellkollaps" bezeichnen, den wir aber einfacher als das sich selbst fressende Internet definieren könnten.

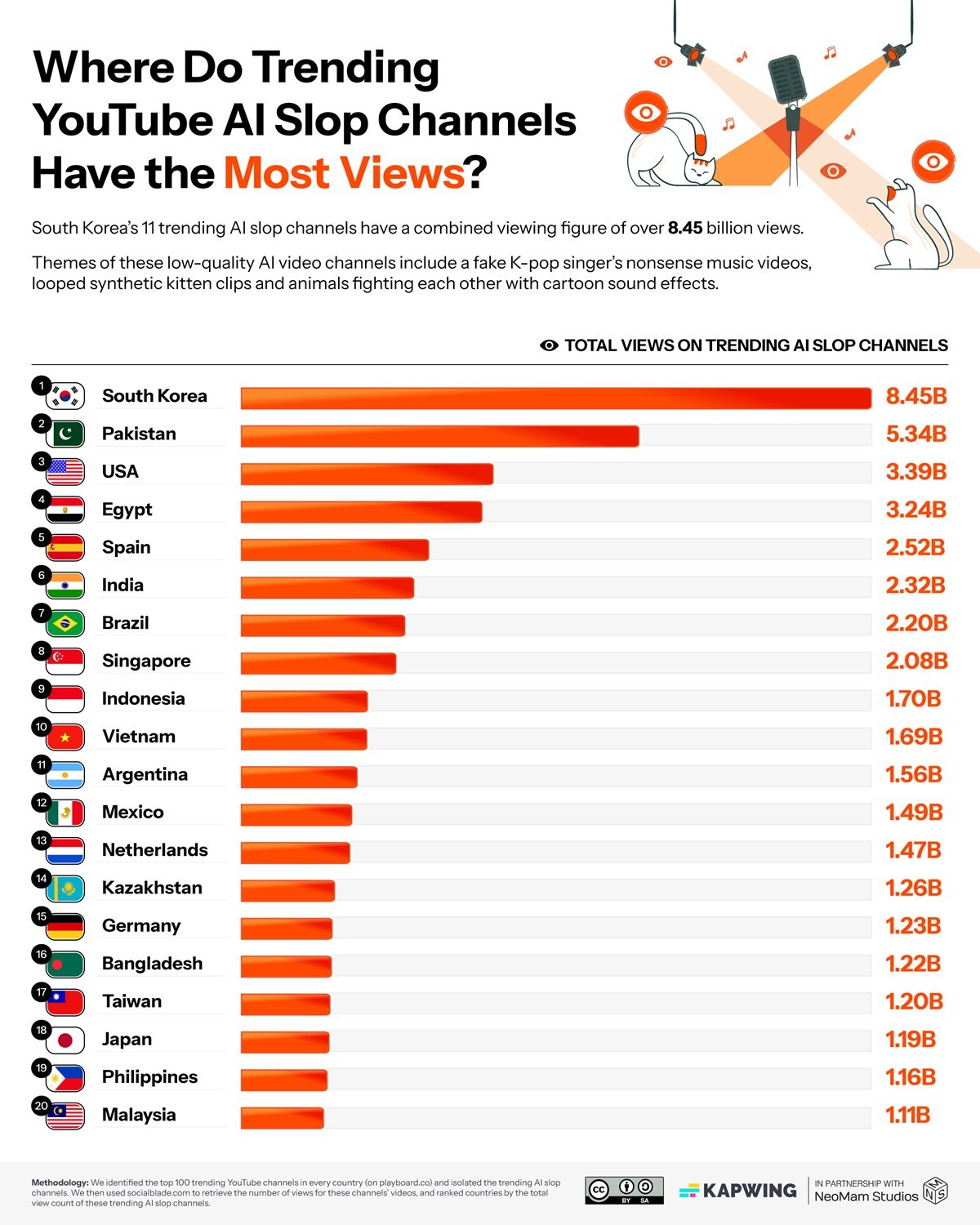

Die von Kapwing in ihrem neuesten Bericht gesammelten Zahlen haben die brutale Präzision einer medizinischen Diagnose: Zwischen 21 % und 33 % der Inhalte, die YouTube neuen Nutzern vorschlägt, sind das, was im Branchenjargon als "KI-Slop" bezeichnet wird, von künstlicher Intelligenz erzeugter Müll. Wir sprechen nicht von hochwertigen KI-Inhalten, sondern von jener industriellen Billigproduktion, die nur einen Zweck hat: die Maximierung der Aufrufe zur Erzielung von Werbeeinnahmen. Kanäle wie Cuentos Fascinantes in Spanien haben mit vollständig synthetischen Videos über zwanzig Millionen Abonnenten gewonnen, während diese Art von Inhalten in Südkorea acht Milliarden Aufrufe erreicht hat. Die "Slop"-Wirtschaft ist bereits einhundertsiebzehn Millionen Dollar pro Jahr wert, wobei einzelne Kanäle über vier Millionen umsetzen.

Die Maschine funktioniert einfach, aber effektiv. Die Algorithmen von YouTube belohnen Neuheit und sofortiges Engagement. KI-generierte Inhalte, die in Massen zu sehr geringen Kosten produziert werden, können die Plattform mit unendlichen Variationen desselben Themas sättigen. Ein traditioneller Schöpfer braucht Stunden oder Tage, um ein Video zu produzieren. Ein KI-System kann Dutzende in der gleichen Zeit ausspucken und mehrere Varianten testen, um diejenige zu identifizieren, die am besten funktioniert. 54 % der ersten Videos, die neue Nutzer sehen, gehören zu dieser Kategorie und schaffen eine Art verzerrtes Eingangstor zur Plattform.

Neal Mohan, CEO von YouTube, erklärte dem Time Magazine, dass künstliche Intelligenz "die nächste Grenze" für die Plattform darstellt. Bei einer im Oktober 2024 angekündigten Umstrukturierung hat YouTube seine Produkt- und Ingenieurabteilungen genau auf diese KI-zentrierte Vision ausgerichtet. Aber es gibt eine beunruhigende Inkonsistenz: Während das Unternehmen massiv in KI-Tools für Kreative investiert, verursachen seine eigenen automatisierten Moderationssysteme Massenblockaden legitimer Kanäle, wobei die Konten von Kreativen gesperrt werden, während die Kanäle, die ihre Inhalte gestohlen haben, aktiv bleiben. Es ist, als ob YouTube dasselbe Phänomen gleichzeitig füttert und bekämpft, gefangen in einem systemischen Widerspruch, der stark an die Dynamik eines Technologiemonopols erinnert, das die Europäische Union zu regulieren versucht.

Die wachsende Entropie

Aber das Problem des "Slop" ist nur die oberflächliche Manifestation von etwas viel Tieferem. Während YouTube sich mit synthetischen Videos füllt, hat LinkedIn einen noch kritischeren Punkt erreicht: laut der Analyse von Originality.AI sind 54 % der langen Beiträge auf der professionellen Plattform von künstlicher Intelligenz generiert. Ein Sprung von 189 % im Vergleich zur Zeit vor ChatGPT. Wir sprechen nicht von Schreibassistenz, sondern von vollständig künstlichen Inhalten, die als originelle Gedanken präsentiert werden. Die Algorithmen von LinkedIn belohnen nun diese massive Produktion und schaffen einen Feed, in dem die Unterscheidung zwischen authentisch und synthetisch immer schwieriger wird.

Das Problem ist nicht mehr nur qualitativ, sondern strukturell. Ein auf arXiv veröffentlichtes Papier dokumentiert wissenschaftlich das Phänomen des "Modellkollaps", die informationelle Entropie, die entsteht, wenn künstliche Intelligenzmodelle mit Daten trainiert werden, die von anderen KI-Modellen produziert wurden. Die Autoren zeigen, dass diese Praxis zu einem fortschreitenden Verlust an Vielfalt führt: Die semantische Vielfalt, gemessen in Bits pro Token, sinkt innerhalb weniger Trainingsiterationen von 4,2 auf 2,5. Es ist, als würde man Fotokopien von Fotokopien machen: Jede Generation verliert an Details, Nuancen, Komplexität.

Der Mechanismus ist heimtückisch. Aktuelle Modelle wurden mit Milliarden von Texten trainiert, die von Menschen über Jahrzehnte hinweg online produziert wurden. Aber diese Mine an Originaldaten geht zur Neige. Eine in Nature veröffentlichte Studie schätzt, dass das "Budget" an für das Training verfügbaren menschlichen Inhalten je nach Szenario zwischen 2026 und 2032 erschöpft sein wird. Danach müssen sich neue Modelle zwangsläufig auch von Inhalten ernähren, die von früheren KIs generiert wurden. Und hier schnappt die Falle zu: Jeder Trainingszyklus mit synthetischen Daten verstärkt Fehler, reduziert die Vielfalt, homogenisiert das Ergebnis. Wie in einer Population, die sich nur untereinander fortpflanzt, bricht die genetische Vielfalt zusammen.

Die digitale Ouroboros-Schlange

Der "Slop" von YouTube und der Modellkollaps sind keine getrennten Phänomene, sondern zwei Seiten derselben Medaille. Die heute generierten Müllvideos werden Teil der Datensätze, mit denen die Modelle von morgen trainiert werden. Die KI-Beiträge von LinkedIn werden indiziert, archiviert und als Trainingsmaterial verwendet. Es ist eine perfekte Rückkopplungsschleife: minderwertige Inhalte erzeugen korrupte Daten, die schlechtere Modelle hervorbringen, die wiederum noch schlechtere Inhalte erstellen. Eine Schlange, die sich in den eigenen Schwanz beißt, wie der alchemistische Ouroboros, aber ohne jegliches Versprechen auf Wiedergeburt.

Die praktischen Auswirkungen sind bereits messbar. Eine in JMIR veröffentlichte Studie hat ergeben, dass 5,3 Prozent der biomedizinischen Bildungsinhalte auf YouTube KI-generierte Informationen von zweifelhafter Qualität enthalten. Wir sprechen nicht von Unterhaltung, sondern von Material, das Ärzte, Studenten und Patienten konsultieren, um Gesundheitsentscheidungen zu treffen. Der "illusorische Wahrheitseffekt" ist gut dokumentiert: Die Wiederholung falscher oder ungenauer Informationen erhöht deren wahrgenommene Glaubwürdigkeit. Wenn YouTube weiterhin ungeprüfte KI-Inhalte verbreitet, bauen wir eine Desinformationsinfrastruktur auf, die immer schwieriger abzubauen sein wird.

Auf wirtschaftlicher Ebene schafft der "Slop" tiefgreifende Verzerrungen. Die einhundertsiebzehn Millionen Dollar, die er jährlich generiert, sind kein neuer Reichtum: Sie werden von legitimen Schöpfern zu denen umgeleitet, die verstanden haben, wie man das algorithmische System mit industrieller Billigproduktion "ausspielt". Es ist eine Form der adversen Selektion: Der Algorithmus belohnt diejenigen, die in Quantität produzieren, auf Kosten derer, die in Qualität produzieren, und schafft so einen perversen Anreiz, der das gesamte Ökosystem nach unten zieht. Und während dies geschieht, definieren Giganten wie Google ihre Beziehung zur KI weiterhin neu und investieren massiv in eine Technologie, die gleichzeitig droht, die Grundlagen des von ihnen mit aufgebauten Webs zu kannibalisieren.

Die Normalisierung ist vielleicht der heimtückischste Aspekt. Wenn die Hälfte der Inhalte auf LinkedIn KI ist und ein Drittel von YouTube "Slop", passt sich unser kritisches Urteilsvermögen an. Wir beginnen, diese Patina der Künstlichkeit, diesen Mangel an Authentizität zu erwarten. Das Risiko besteht darin, dass wir eine Generation von Nutzern darauf trainieren, nicht mehr zu unterscheiden, nicht mehr nach dem Original zu suchen. Und wenn man nicht mehr nach dem Original sucht, hört man auf, es zu schätzen und damit auch zu produzieren.

Die unsichtbaren Gewinner

Während das digitale Ökosystem mit Müll gefüllt wird und Modelle zusammenzubrechen drohen, gibt es eine Parallelwirtschaft, die genau von diesem Chaos profitiert. Nvidia schloss das dritte Geschäftsquartal 2026 mit siebenundfünfzig Milliarden Dollar Umsatz ab, ein Plus von zweiundsechzig Prozent gegenüber dem Vorjahr. Das Unternehmen kontrolliert 92 % des GPU-Marktes und monetarisiert jede einzelne KI-Generation, ob es sich nun um hochwertigen Inhalt oder "Slop" handelt. CEO Jensen Huang spricht von "unglaublicher Nachfrage" und "ausverkauften" Cloud-GPUs und prognostiziert Investitionen in die KI-Infrastruktur zwischen drei und vier Billionen Dollar bis 2030.

Es ist nicht nur Nvidia. Cloud-Anbieter wie AWS, Azure und Google Cloud stellen Unternehmen, die Modelle trainieren und Inhalte generieren, Milliarden in Rechnung. OpenAI und Anthropic sammeln Hunderte von Millionen an Finanzmitteln, während das Web mit den Inhalten gefüllt wird, die ihre Modelle produzieren. Es ist ein perfektes Paradoxon: Je mehr KI-Inhalte generiert werden, desto mehr Rechenleistung wird benötigt, um nachfolgende Modelle mit immer stärker verschmutzten Datensätzen zu trainieren, was zu steigenden Gewinnen für die Infrastruktur führt, die das Problem selbst befeuert. Die YouTube-"Slopper", die vier Millionen umsetzen, sind die sichtbare Spitze des Eisbergs. Unter der Oberfläche gibt es eine Industrie im Wert von mehreren zehn Milliarden, die jedes Watt an Energie monetarisiert, das für die Erzeugung und Verarbeitung von Inhalten aufgewendet wird, unabhängig von deren Qualität oder Nützlichkeit.

Auf dem Weg zu welchem Ökosystem

Aber es gibt konkrete Alternativen, die bereits funktionieren. Common Crawl, trotz der jüngsten Kontroversen um die Verwaltung von Paywalls, bleibt das größte öffentliche Archiv von Webdaten und wird in 64 % der Sprachmodelle verwendet. Der entscheidende Unterschied liegt in der Kuratierung: gefilterte Versionen wie C4 von Google oder Pile-CC von EleutherAI wenden aggressive Reinigungsprozesse an. NVIDIA hat Nemotron-CC entwickelt, einen 6,3 Billionen Token umfassenden Datensatz, der durch Ensembles von Klassifikatoren und synthetischen Umschreibungstechniken erstellt wurde, die die Qualität erhalten und gleichzeitig die Quantität erweitern.

Cohere Labs baut mit dem Aya-Projekt radikal andere Alternativen auf, einer Open-Science-Initiative, an der dreitausend Forscher aus 150 Ländern beteiligt waren, um manuell kuratierte mehrsprachige Datensätze in 101 Sprachen zu erstellen. Keine blinde Automatisierung, sondern menschliche Kuratierung in großem Maßstab. Der Data Provenance Explorer, der vom MIT und Cohere Labs entwickelt wurde, hat zweitausend der am häufigsten verwendeten Datensätze verfolgt und verifiziert und damit erstmals ein Rückverfolgbarkeitssystem geschaffen, das Lizenzen, Ersteller und die Herkunft der Daten dokumentiert. Plattformen wie Substack haben Wirtschaftsmodelle entwickelt, die verifizierte menschliche Authentizität belohnen und zeigen, dass es Märkte gibt, die bereit sind, für zertifizierte Originalinhalte zu bezahlen.

Das Wasserzeichen für KI-Inhalte bleibt eine teilweise, aber notwendige Lösung. Die Europäische Union hat mit dem KI-Gesetz begonnen, Transparenzpflichten aufzuerlegen. YouTube hat Kennzeichnungssysteme angekündigt, auch wenn die Umsetzung uneinheitlich bleibt. Aber das Problem ist nicht nur technologischer Natur. Es sind strukturelle Eingriffe erforderlich: Plattformen müssen Algorithmen überdenken, die sofortiges Engagement belohnen und perverse Anreize schaffen. Trainingsdatensätze erfordern eine extreme Kuratierung, die verifizierte menschliche Quellen bevorzugt. Und es sind massive Investitionen in die Medienkompetenz erforderlich: KI-Inhalte zu erkennen ist keine Option mehr, sondern eine grundlegende Kompetenz.

Der kritische Punkt ist, dass wir an einem Scheideweg stehen. Wir können den aktuellen Weg fortsetzen, auf dem jedes Jahr ein größerer Prozentsatz des Webs KI-generiert wird, auf dem Modelle mit dem Output anderer Modelle trainiert werden, auf dem die informationelle Vielfalt fortschreitend zusammenbricht, um ein homogenes, vorhersehbares, steriles digitales Ökosystem zu schaffen. Oder wir können jetzt eingreifen, mit intelligenter Regulierung, bewussten technischen Entscheidungen und einer erneuerten Wertschätzung für authentische menschliche Inhalte.

Die Wette von YouTube ist, dass KI die Kreation demokratisieren kann, indem sie technische Barrieren senkt und es jedem ermöglicht, ein Schöpfer zu werden. Aber wenn diese Demokratisierung hauptsächlich Müll produziert, der das Ökosystem verschmutzt und den Kollaps zukünftiger Modelle befeuert, demokratisieren wir nichts: Wir beschleunigen nur eine systemische Verschlechterung. Wie bei Carpenters Alien wird jede Kopie weniger perfekt als die vorherige. Und anders als im Film gibt es hier keinen Kurt Russell mit einem Flammenwerfer, der bereit ist, die Assimilation zu stoppen.

Die Frage ist nicht mehr, ob KI das Internet verändern wird. Diese Veränderung ist bereits im Gange. Die Frage ist: In was verwandeln wir es? In ein reicheres, vielfältigeres und zugänglicheres System oder in eine Echokammer, in der Maschinen hauptsächlich mit anderen Maschinen sprechen, während wir Menschen zu immer passiveren Zuschauern einer informationellen Verschlechterung werden, die wir in Gang gesetzt haben, die wir aber immer schwerer kontrollieren können?