Qwen3-Max-Preview: Der 1-Billionen-Parameter-Koloss

Der 5. September 2025 markiert einen Wendepunkt in der Entwicklung der globalen künstlichen Intelligenz. Alibaba hat offiziell Qwen3-Max-Preview vorgestellt, das erste Modell der Qwen-Familie, das die psychologische Schwelle von einer Billion Parametern überschreitet. Ein Meilenstein, der nicht nur numerisch ist, sondern den Eintritt Chinas in den exklusiven Club der technologischen Mächte darstellt, die in der Arena der generativen KI auf höchstem Niveau konkurrieren können.

Wie Akira, der im Meisterwerk von Otomo aus dem Kryostat erwacht, taucht dieser Rechenkoloss in einer Zeit auf, in der die Branche auf kompaktere und effizientere Modelle ausgerichtet schien. Die Entscheidung von Alibaba, hoch, sehr hoch zu zielen, ist eine Absichtserklärung, die die Markterwartungen umkehrt und den Wettlauf zu extremen Größen neu entfacht.

Eine Billion Gründe zum Staunen

Die Zahlen von Qwen3-Max-Preview sind selbst nach heutigen Maßstäben beeindruckend. Mit über 1 Billion Parametern verwaltet das Modell ein Kontextfenster von 262.144 Token, aufgeteilt in 258.048 Eingabe-Token und 32.768 Ausgabe-Token. Um diese Zahlen in Perspektive zu setzen, bedeutet dies, dass gleichzeitig das Äquivalent von etwa 500 Seiten Text verarbeitet werden kann, eine Fähigkeit, die bis gestern undenkbare Anwendungsszenarien eröffnet.

Die Architektur integriert auch Kontext-Caching-Funktionen, eine technische Lösung, die Multi-Turn-Sitzungen erheblich beschleunigt, indem sie die Latenz bei längeren Gesprächen reduziert. Es ist, als hätte man einen Assistenten, der sich nicht nur an alles erinnert, was man ihm gesagt hat, sondern es auch immer griffbereit hält, ohne jedes Mal von vorne anfangen zu müssen.

Binyuan Hui, Staff Research Scientist des Qwen-Teams, bestätigte, dass "Qwen-Max erfolgreich auf 1T-Parameter skaliert wurde und die Entwicklung weiter voranschreitet", was andeutet, dass diese Vorschauversion nur ein Vorgeschmack auf etwas noch Ehrgeizigeres sein könnte.

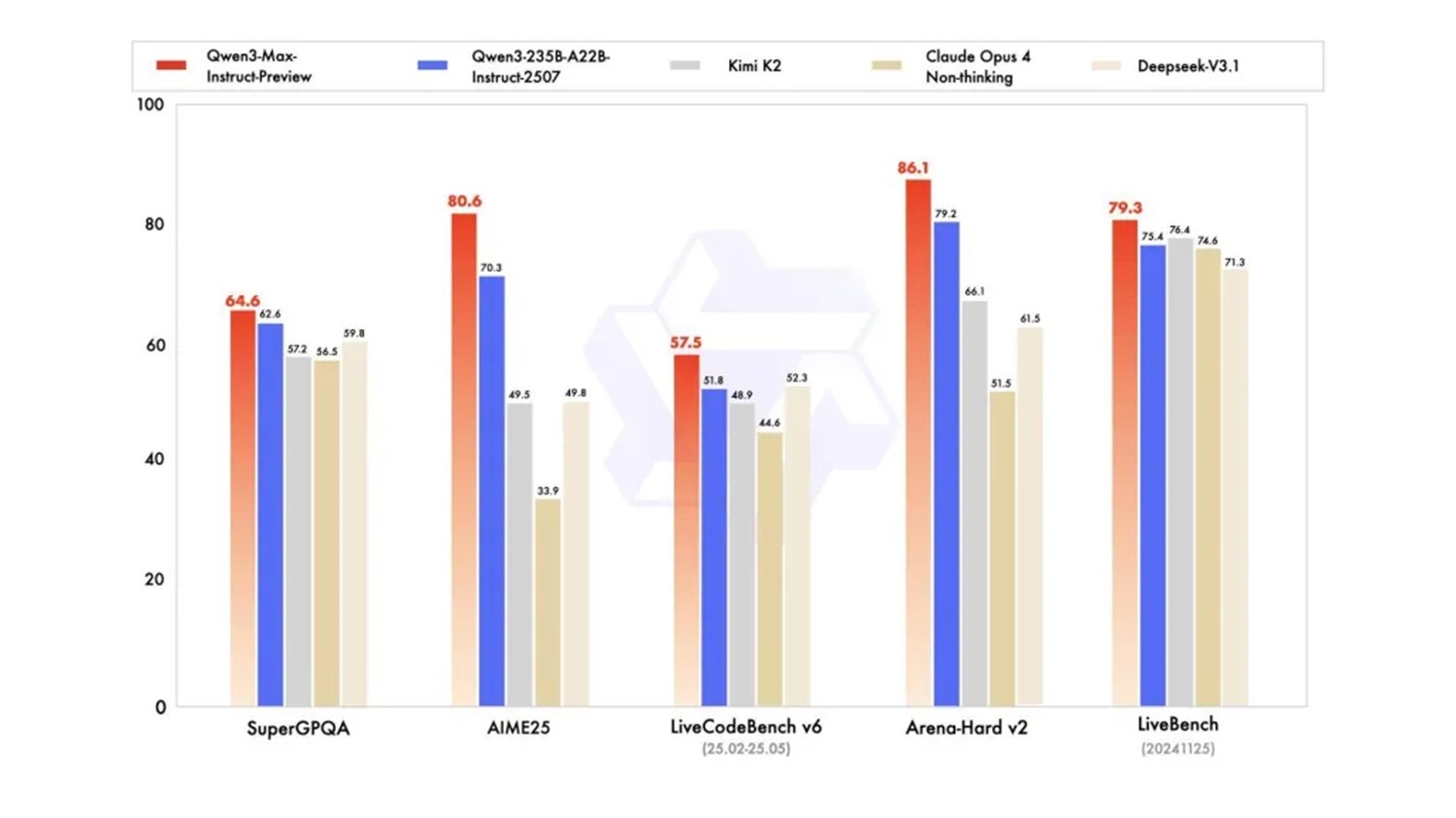

Wenn Saitama die Arena betritt

Die Benchmarks sprechen für sich und bescheinigen die Leistung dieses chinesischen Giganten. Qwen3-Max-Preview übertrifft das bisherige Flaggschiffmodell des Unternehmens, Qwen3-235B-A22B-2507, und konkurriert direkt mit den besten westlichen Modellen in standardisierten Tests wie SuperGPQA, AIME25, LiveCodeBench v6, Arena-Hard v2 und LiveBench.

Besonders bedeutsam ist der Vergleich mit Claude Opus 4, GPT-4 und anderen führenden Modellen, bei denen Qwen3-Max-Preview in mehreren Kategorien eine wettbewerbsfähige, wenn nicht sogar überlegene Leistung zeigt. Wie Saitama in One Punch Man ist dieses chinesische Modell fast aus dem Nichts aufgetaucht, um mit etablierten Champions zu konkurrieren und eine Rechenleistung zu bringen, die das Gleichgewicht der Branche neu definiert.

Frühe Tester berichten von überraschenden Antwortgeschwindigkeiten, die manchmal schneller sind als ChatGPT, und von emergenten Denkverhaltensweisen, die nicht speziell programmiert wurden. Ahsen Khaliq von Hugging Face dokumentierte die kreative Fähigkeit des Modells, indem er mit einem einzigen Prompt einen verpixelten Voxel-Garten erstellte und damit eine Vielseitigkeit demonstrierte, die weit über traditionelle Benchmarks hinausgeht.

Der große Verrat an Open Source

Aber hier nimmt die Geschichte eine unerwartete Wendung. Im Gegensatz zu früheren Qwen-Veröffentlichungen wird dieses Modell nicht als Open-Source-Version verfügbar sein. Der Zugriff ist ausschließlich auf die APIs von Alibaba Cloud, Qwen Chat, OpenRouter und als Standardwerkzeug in AnyCoder von Hugging Face beschränkt.

Dieser Schritt stellt einen Paradigmenwechsel für Alibaba dar, das in der Vergangenheit seinen Ruf in der KI genau auf der Philosophie des offenen Zugangs aufgebaut hatte. Frühere Qwen-Modelle hatten westliche Labore gerade wegen der sofortigen Verfügbarkeit der Modellgewichte herausgefordert, was Forschern und Entwicklern auf der ganzen Welt ermöglichte, zu experimentieren und zur Leistungsverbesserung beizutragen.

Die Entscheidung für Closed Source wirft tiefgreifende Fragen über die Zukunft der verteilten Innovation in der KI auf. Während der Wunsch, solch massive Investitionen zu monetarisieren, verständlich ist, schafft er auch einen besorgniserregenden Präzedenzfall für das globale Forschungsökosystem. Es ist, als würde die Bibliothek von Alexandria plötzlich ihre Türen für die Öffentlichkeit schließen und den Zugang nur für zahlende Kunden aufrechterhalten.

Der Zeitfaktor im Zeitalter der KI

Das Timing des Qwen3-Max-Preview-Starts ist kein Zufall und offenbart eine ausgeklügelte Zeitstrategie, die eine eingehende Analyse verdient. Während sich die westliche Industrie auf effizientere und kompaktere Modelle nach der Philosophie "weniger ist mehr" konzentrierte, setzte Alibaba auf die entgegengesetzte Richtung und investierte massiv in eine Rechenskala, die sich heute als gewinnbringend erweist. Es ist ein Schritt, der an die Strategie von Kamoshida in Persona 5 erinnert: Während alle anderen Spieler die konventionellen Regeln befolgten, entschied sich jemand, die Karten komplett neu zu mischen.

Die Ankündigung von Updates "bereits nächste Woche" durch das Forschungsteam deutet auf einen unglaublich beschleunigten Entwicklungszyklus hin, der nur dank Rechen- und Personalressourcen im industriellen Maßstab möglich ist. Dieses Innovationstempo stellt westliche Wettbewerber vor eine beispiellose Herausforderung: nicht nur bei der Qualität des einzelnen Modells zu konkurrieren, sondern auch bei der Geschwindigkeit der Iteration und der kontinuierlichen Verbesserung.

Die strategische Integration mit bereits etablierten Plattformen wie OpenRouter und AnyCoder von Hugging Face zeigt ein reifes Verständnis für das globale Entwickler-Ökosystem. Alibaba bringt nicht nur ein Produkt auf den Markt, sondern baut eine Brücke zur internationalen Gemeinschaft, behält aber die totale Kontrolle über die Basistechnologie. Es ist eine Strategie, die scheinbare Offenheit mit substanzieller Kontrolle kombiniert und eine breite Akzeptanz ermöglicht, ohne die Wettbewerbsvorteile von Closed Source aufzugeben.

Supersportwagen-Leistung, Kleinwagen-Preis

Das Preismodell für Qwen3-Max-Preview folgt einer gestaffelten Struktur, die auf den verwendeten Token basiert. Die Kosten beginnen bei 0,861 $ pro Million Eingabe-Token im Bereich von 0-32K und steigen auf 2,151 $ pro Million im höchsten Bereich von 128K-252K Token. Die Ausgabe-Token folgen einer ähnlichen Progression, jedoch mit erhöhten Kosten, die im höchsten Bereich bis zu 8,602 $ pro Million erreichen.

Diese Preisstruktur offenbart eine ausgeklügelte Geschäftsstrategie: das Modell für einfache und kurze Aufgaben wirtschaftlich zugänglich zu machen, aber die Kosten für intensive, langkontextuelle Nutzungen erheblich zu skalieren. Es ist ein Schritt, der den Zugang zu grundlegenden Fähigkeiten demokratisiert und gleichzeitig attraktive Margen bei komplexeren Unternehmensanwendungsfällen beibehält.

Das Preis-Leistungs-Verhältnis, insbesondere in den unteren Nutzungsstufen, erscheint im Vergleich zu gleichwertigen westlichen Modellen wettbewerbsfähig und könnte potenziell neue Märkte für Entwickler und kleine Unternehmen erschließen, die bisher vom Ökosystem der Spitzen-KI ausgeschlossen waren.

Jenseits der Benchmarks: KI, die das Leben simuliert

Aber wo Qwen3-Max-Preview sein wahres Potenzial zeigt, sind praktische Anwendungen, die über standardisierte Tests hinausgehen. Das Modell demonstriert emergente Fähigkeiten im strukturierten Denken, bei der Generierung komplexen Codes, bei der Handhabung strukturierter Daten und bei fortgeschrittenen agentischen Verhaltensweisen.

Besonders interessant sind die Demos, die Simulationen von Populationen und komplexen Systemen zeigen, Anwendungen, die nicht nur Rechenleistung, sondern auch ein ausgeklügeltes Verständnis systemischer Dynamiken erfordern. Es ist, als würde man Ghost in the Shell sehen und erkennen, dass die sozialen Simulationen des Films möglicherweise keine Science-Fiction mehr sind.

Das erweiterte Kontextfenster ermöglicht bisher undenkbare Anwendungen: Analyse ganzer Romane, Verarbeitung komplexer Datenbanken, Programmiersitzungen, die den Kontext über Tausende von Codezeilen hinweg beibehalten. Dies sind Anwendungsszenarien, die die KI von einem pünktlichen Assistenten zu einem beständigen Arbeitspartner machen.

Auf dem Weg zu Post-Trillionen-Modellen

Das Überschreiten der Billionen-Parameter-Schwelle zwingt uns jedoch unserer Meinung nach zu einer kritischen Reflexion: Der Wettlauf um reine Rechenleistung, obwohl er außergewöhnliche Ergebnisse erbracht hat, zeigt seine Schwächen mit untragbaren Kosten auf allen Ebenen. Nicht nur wirtschaftlich (das Training dieser Giganten erfordert Investitionen von zehn, wenn nicht hunderten von Millionen Dollar), sondern vor allem ökologisch, aufgrund des monströsen Energieverbrauchs, und strategisch, aufgrund der Abhängigkeit von immer knapper werdenden Chips und Ressourcen.

Die Zukunft, wie auch in der Analyse unseres letzten Artikels über die Technik "Deep Think with Confidence" behandelt, kann keine weitere dimensionale Eskalation sein. Der wahre Fortschritt wird in einem "intelligenteren" und weniger ressourcenhungrigen Ansatz liegen: hybride Architekturen, die kleinere, aber spezialisierte Grundlagenmodelle kombinieren, strukturierte Denktechniken zur Reduzierung überflüssiger Berechnungen und ein Fokus auf reine Effizienz durch Modellzusammenführung und Destillation. Die eigentliche technische Herausforderung besteht nicht darin, ein 2T-Parameter-Modell zu trainieren, sondern die gleiche (oder bessere) Leistung mit einem Zehntel der Ressourcen zu erzielen.

Der nächste Meilenstein wird keine größere Zahl sein, sondern ein besserer Algorithmus. Die nächste "überraschende" Veröffentlichung des Qwen-Teams könnte, so hoffen wir zumindest, genau ein Schritt in diese Richtung sein: zu zeigen, dass sich künstliche Intelligenz entwickeln kann, ohne die Welt zu verschlingen.

Das neue Kräfteverhältnis

Die Ankunft von Qwen3-Max-Preview zeichnet die geopolitische Karte der künstlichen Intelligenz neu. Zum ersten Mal konkurriert ein chinesisches Modell direkt mit amerikanischen Flaggschiffen, nicht nur in Bezug auf die Leistung, sondern auch auf die kommerzielle Zugänglichkeit und die Bereitstellungsgeschwindigkeit.

Die strategische Entscheidung von Alibaba, sich auf ein Billionen-Parameter-Modell zu konzentrieren, während westliche Wettbewerber die Effizienz bei reduzierten Parametern erforschten, erweist sich heute als gewinnbringende Wette. Es ist der Beweis, dass in der Welt der KI, wie im Schach von Kasparow gegen Deep Blue, eine Gegenstromstrategie die Erwartungen vollständig umkehren kann.

Die Auswirkungen auf den Unternehmensmarkt werden wahrscheinlich erheblich sein, insbesondere in Asien, wo Alibaba Cloud bereits eine konsolidierte Präsenz hat. Die Kombination aus hoher Leistung, wettbewerbsfähigen Preisen und nativer Integration in das chinesische Cloud-Ökosystem schafft ein Angebot, das für Unternehmen in der Region schwer zu ignorieren ist.

Der Wechsel zu Closed Source, obwohl umstritten, könnte eine Reifung der Branche hin zu nachhaltigeren Geschäftsmodellen signalisieren. Während dies die Open-Source-Innovation einschränkt, garantiert es andererseits die notwendigen Ressourcen, um die langfristige Forschung auf immer größeren Rechenskalen zu unterstützen.

Qwen3-Max-Preview ist nicht nur ein neues KI-Modell: Es ist das Manifest einer neuen Ära, in der die technologische Vormachtstellung nicht mehr ausschließlich dem Silicon Valley vorbehalten ist. Der Drache ist erwacht, und die Welt der künstlichen Intelligenz wird nie wieder dieselbe sein.