Werden Small Language Models das Jahr 2026 erobern?

Andy Markus ist Chief Data Officer bei AT&T, nicht gerade der Typ, der sich von Begeisterung mitreißen lässt. Als er in einem Interview Ende 2025 erklärte, dass feinabgestimmte Small Language Models "der große Trend des Jahres 2026" werden würden, zogen viele Beobachter eine Augenbraue hoch. Doch diese Augenbraue könnte gerechtfertigt sein: 2025 markierte eine Kehrtwende gegenüber dem Mantra "größer ist besser", das die KI in den letzten drei Jahren dominiert hat.

Es ist derselbe Paradigmenwechsel, den wir dokumentiert haben, als das MIT demonstrierte, wie Modelle lernen können, weniger und besser zu denken durch dynamische Ressourcenzuweisung, oder als Harvard enthüllte, dass Denkfähigkeiten bereits in den Basismodellen vorhanden waren, sie mussten nur richtig extrahiert werden. Sogar Giganten wie Samsung und Microsoft haben in Techniken investiert, die algorithmische Intelligenz gegenüber roher Gewalt bevorzugen, wie der TRM-Ansatz für gezieltes Retrieval und DeepConf für vertrauensbasierte Selbstkorrektur zeigen. Die Frage ist nun: Stellen SLMs einen pragmatischen Durchbruch dar oder nur eine weitere Blase, die dazu bestimmt ist, zu platzen? Und vor allem, wer gewinnt und wer verliert in diesem neuen Gleichgewicht?

Anatomie eines kompakten Modells

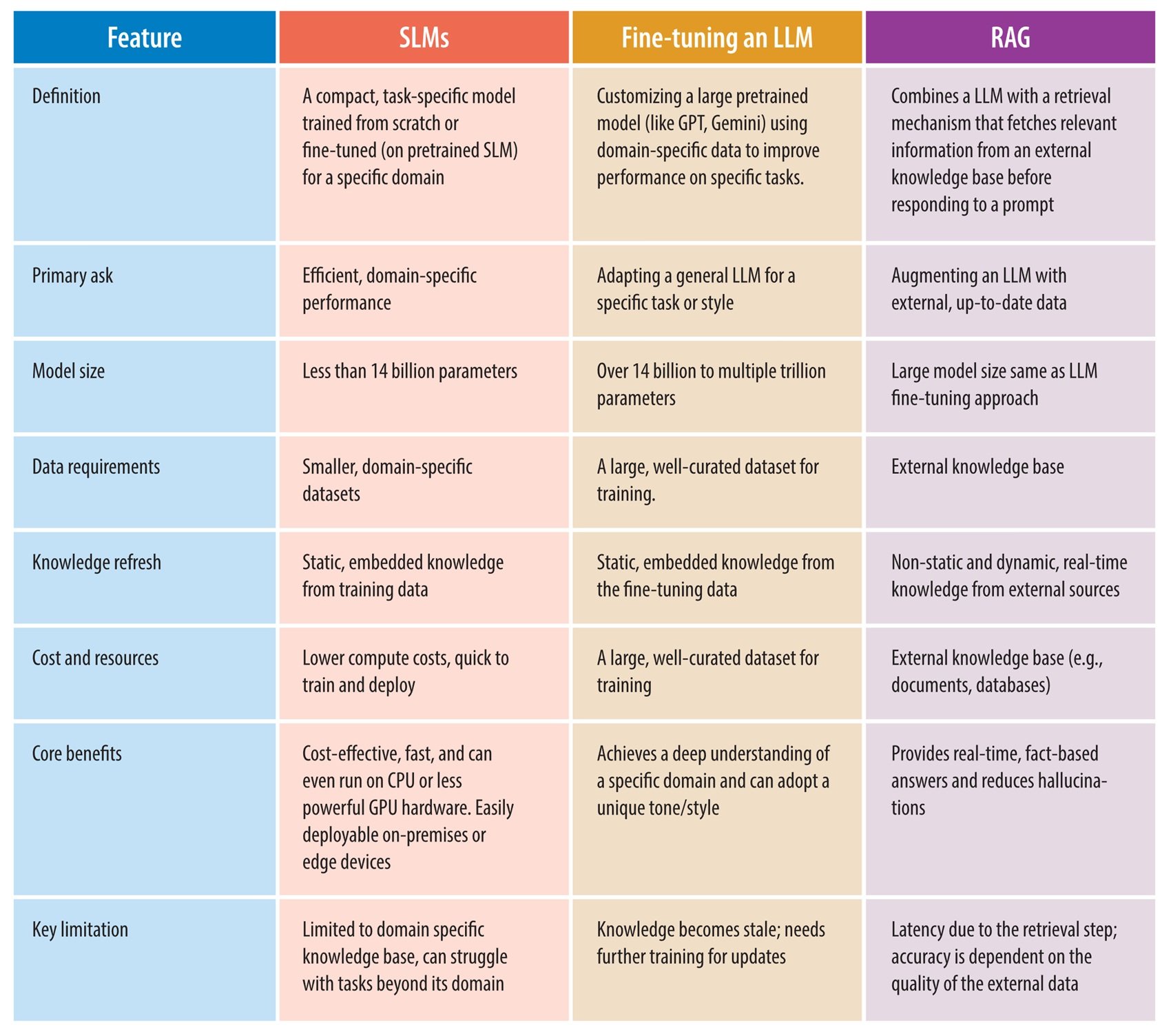

Die Definition, was ein Small Language Model ist, ist nicht so trivial, wie es scheint. Wenn Sie zehn Forscher fragen, erhalten Sie mindestens zwölf verschiedene Antworten. Die am häufigsten akzeptierte Schwelle liegt bei etwa zehn Milliarden Parametern, aber das ist eine ebenso willkürliche Konvention wie die Grenze zwischen einem Zwergplaneten und einem Planeten. Was wirklich zählt, ist die Einsetzbarkeit: Ein SLM ist ein Modell, das darauf ausgelegt ist, effizient auf Consumer-Hardware oder Edge-Geräten zu laufen, wenig Speicher zu verbrauchen und Antworten mit einer Latenz von unter einer Sekunde zu erzeugen.

Im Gegensatz zu LLMs, die im Wesentlichen bis ins Unglaubliche skalierte Transformer-Modelle sind und auf Terabytes von Daten trainiert wurden, entstehen SLMs aus einer architektonischen Neugestaltung. Die am weitesten verbreitete Technik ist die Wissensdestillation: Ein massives "Lehrer"-Modell überträgt sein Wissen an einen kompakten "Schüler", der lernt, das Verhalten des Riesen mit einem Bruchteil der Ressourcen zu replizieren. Es ist, als hätte Richard Feynman sein Physikwissen in ein Taschenbuch komprimiert, ohne die Essenz zu verlieren. Aber das ist noch nicht alles. Pruning eliminiert redundante neuronale Verbindungen, wie ein Gärtner, der einen Baum beschneidet, damit er gesünder wächst. Die Quantisierung reduziert die numerische Präzision der Gewichte: Anstatt jede Zahl mit 32 Bit darzustellen, verwendet man 8, 4 oder sogar 1,58 Bit wie im jüngsten BitNet, was zu Modellen führt, die ein Zehntel des ursprünglichen Speicherplatzes beanspruchen und dabei erstaunlich geringe Genauigkeitsverluste aufweisen.

Hybride Architekturen stellen die interessanteste Grenze dar. Modelle wie Samba-CoE von SambaNova Systems kombinieren State Space Models, die Sequenzen linear ohne die für die Aufmerksamkeit typische quadratische Komplexitätsexplosion verarbeiten, mit selektiven Aufmerksamkeitsmechanismen, die nur dort angewendet werden, wo sie benötigt werden. Das Ergebnis sind Modelle, die auf Kontexte von Millionen von Token skalieren und dabei eine nahezu konstante Inferenzgeschwindigkeit beibehalten. Sie sind keine verkleinerten LLMs: Es sind von Grund auf neu gedachte Systeme, um das Verhältnis von Leistung zu Effizienz zu maximieren.

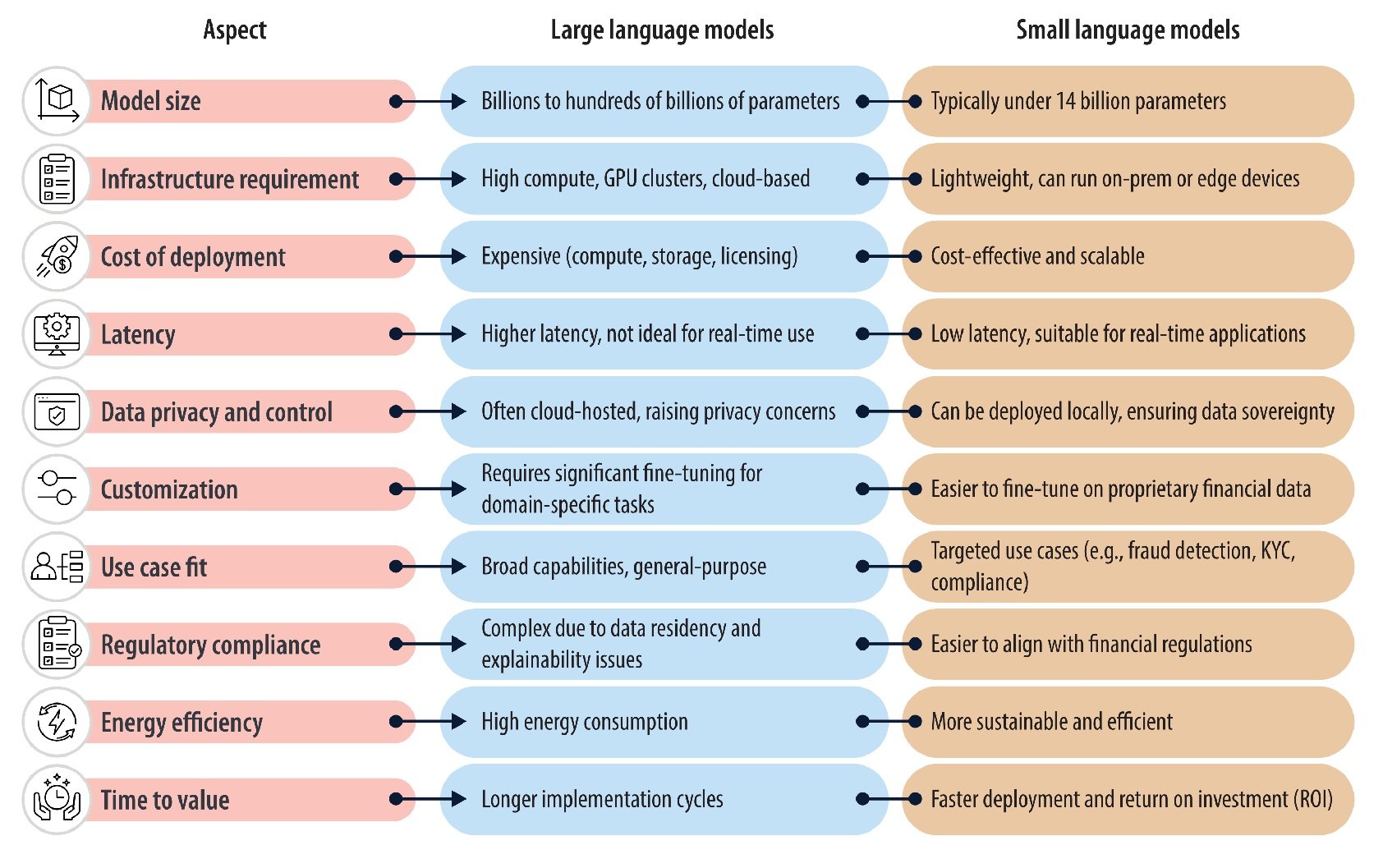

Der Vergleich, der zählt: SLM vs. LLM

Die strukturellen Unterschiede führen zu präzisen operativen Kompromissen. An der reinen Leistungsfront hat sich die Lücke in den letzten zwölf Monaten drastisch verringert. Microsofts Phi-3.5-Mini mit seinen drei Komma acht Milliarden Parametern erreicht auf mathematischen Benchmarks wie GSM8K die gleiche Leistung wie GPT-3.5 und verbraucht dabei achtundneunzig Prozent weniger Rechenleistung, laut Daten, die von Microsoft Research Mitte 2025 veröffentlicht wurden. Llama 3.2 mit drei Milliarden Parametern schlägt Modelle mit siebzig Milliarden Parametern bei domänenspezifischen Aufgaben nach gezielter Feinabstimmung. Wenn es jedoch um komplexes, domänenübergreifendes Denken oder um Anfragen geht, die ein breites Allgemeinwissen erfordern, behalten LLMs einen klaren Vorteil: GPT-4 oder Claude Sonnet lösen Probleme, die tiefe logische Verkettungen erfordern, mit einer Genauigkeit, die kein aktuelles SLM im Zero-Shot-Modus erreicht.

Die Latenz ist der Bereich, in dem SLMs ohne Kompromisse glänzen. Ein Modell mit sieben Milliarden Parametern generiert Token in Echtzeit auf einer einzigen Consumer-GPU mit Verzögerungen, die in zehn Millisekunden messbar sind. Ein Modell mit einhundertfünfzig Milliarden Parametern erfordert Multi-GPU-Cluster und führt bereits bei der Initialisierung der Inferenz zu Verzögerungen von Sekunden. Für Echtzeitanwendungen wie Sprachassistenten, Robotersteuerung oder industrielle Überwachung ist dieser Unterschied nicht unerheblich: Er ist die Grenze zwischen nutzbar und unbrauchbar.

Auf der wirtschaftlichen Seite erzählen die Zahlen unterschiedliche Geschichten. Das Training von GPT-3 kostete nach konservativen Schätzungen über einhundert Millionen Dollar und erforderte monatelange Berechnungen auf Tausenden von GPUs. Die Feinabstimmung eines Modells mit sieben Milliarden Parametern für eine spezifische Aufgabe kann einige tausend Dollar auf einer einzigen A100-GPU kosten, die für ein paar Tage gemietet wird. Aber es gibt einen versteckten Kompromiss: LLMs sind außergewöhnliche Generalisten; ein Modell bedient tausend Anwendungsfälle. Ein feinabgestimmtes SLM brilliert in seiner Domäne, bricht aber zusammen, sobald man den Trainingsbereich verlässt. Man benötigt also Batterien von spezialisierten SLMs, wo ein einziges LLM ausgereicht hätte, was die Komplexität vom Training zur Orchestrierung verlagert.

Die eigentliche Wasserscheide ist Generalisierung versus Spezialisierung. LLMs sind das Schweizer Taschenmesser der KI: Sie machen alles anständig. SLMs sind chirurgische Skalpelle: Sie brillieren bei präzisen Aufgaben und versagen kläglich außerhalb des Kontexts. Diese Dichotomie treibt die Industrie zu hybriden Architekturen: Ein SLM filtert Routineanfragen, ein LLM greift nur bei komplexen Grenzfällen ein. Dies ist das Kaskadenmuster, das Start-ups wie Anthropic in ihren Produktionsstacks erforschen.

Wann was verwenden: Der Entscheidungskompass

Die idealen Szenarien für SLMs ergeben sich deutlich aus der Analyse der Implementierungen des Jahres 2025. Edge Computing ist ihr natürliches Terrain: IoT-Geräte mit stromsparenden ARM-Chips, Smartphones, die sensible Daten verarbeiten, ohne sie in die Cloud zu senden, autonome Autos, die in Millisekunden reagieren müssen, ohne von einer unsicheren Konnektivität abhängig zu sein. Jede Anwendung, bei der Netzwerklatenz oder Datenschutz strenge Einschränkungen darstellen, wird zum SLM-Territorium. Im Gesundheitswesen analysieren medizinische Geräte mit eingebetteten SLMs Vitalparameter in Echtzeit und erkennen Anomalien, ohne jemals Patientendaten über den lokalen Bereich hinaus zu übertragen, wodurch ein Großteil der Komplexität beim Schutz der Privatsphäre und der Sicherheit von Gesundheitsinformationen umgangen wird. Im Finanzwesen blockieren Zahlungsterminals mit geräteinterner Betrugserkennung verdächtige Transaktionen in Millisekunden, lange bevor eine Cloud-API antworten könnte.

Domänenspezifische Anwendungen, bei denen die Feinabstimmung hervorragende Ergebnisse liefert, sind die andere Stärke. Ein Modell mit drei Milliarden Parametern, das auf Millionen von italienischen Rechtsverträgen trainiert wurde, übertrifft GPT-4 bei der Extraktion spezifischer Klauseln aus technischen Dokumenten, da es sprachliche Variationen gesehen hat, die der generalistische Riese nie angetroffen hat. Ein SLM, das auf einer internen Unternehmenscodebasis feinabgestimmt ist, versteht Namenskonventionen, Architekturmuster und Legacy-Abhängigkeiten besser als Copilot. Aber Vorsicht: Diese Vorteile verflüchtigen sich, sobald man die Domäne wechselt. Dasselbe legale Modell, das bei Handelsverträgen tadellos ist, versagt kläglich bei Verwaltungsrechtsverträgen, wenn es diese nicht im Trainingssatz gesehen hat.

Wann man noch ein LLM benötigt, ist die Antwort ebenso klar. Mehrstufiges Denken, das Logik aus verschiedenen Domänen miteinander verknüpft, explorative Forschung, bei der man nicht weiß, wonach man sucht, bis man es findet, und die Breite des Allgemeinwissens für Gespräche, die von Quantenphysik zu Kochrezepten springen. SLMs sind brillante Spezialisten; LLMs sind unverzichtbare Generalisten. Die pragmatische Grenze besteht darin, zu verstehen, dass sie keine Alternativen, sondern Ergänzungen sind. Sebastian Raschka, Forschungsleiter bei Lightning AI, fasst es so zusammen: Der Fortschritt im Jahr 2026 wird mehr von der Optimierung der Inferenz als von der Vergrößerung des Trainings kommen. Dies ist ein radikaler Perspektivenwechsel für eine Branche, die von dem Mantra "Skalierung ist alles, was man braucht" besessen ist.

Die Umweltauswirkungen vervollständigen das Entscheidungsbild. Wir haben detailliert dokumentiert, wie der Wasserverbrauch der KI zu einem systemischen Problem wird: Das Training von GPT-3 verbrauchte eintausenddreihundertsiebenundachtzig Megawattstunden, genug Energie für einhundertzwanzig amerikanische Haushalte für ein ganzes Jahr. Jede einzelne Anfrage an ChatGPT erfordert dreißig Milliliter Wasser zur Kühlung der Server und 0,42 Wattstunden Strom. Bei siebenhundert Millionen täglichen Anfragen wird das Ausmaß alarmierend: Energie für fünfunddreißigtausend Haushalte pro Jahr. SLMs reduzieren diesen Fußabdruck um vierzig Prozent laut Branchendaten von 2025, nicht durch Magie, sondern durch elementare Physik: Weniger Parameter bedeuten weniger Berechnungen, weniger Speicher und weniger abzuführende Wärme. Melanie Nakagawa, Chief Sustainability Officer von Microsoft, hat es deutlich gesagt: Die Energieintensität zwingt uns, die Effizienz zu beschleunigen. Das ist kein Greenwashing; es ist wettbewerbsfähiges Überleben in einer Welt, in der die Energiekosten zum größten Hindernis für die Skalierung werden.

Die Modellgalaxie: Wer ist auf dem Spielfeld

Die SLM-Landschaft Anfang 2026 ist überraschend dicht. Die Phi-Familie von Microsoft dominiert die Unternehmensgespräche: Phi-4-mini integriert multimodale Denkfähigkeiten, verarbeitet Bilder und Text und behält dabei eine Größe von unter vier Milliarden Parametern bei. Meta hat Llama 3.2 in Varianten mit einem und drei Milliarden Parametern veröffentlicht, mit Vision-Versionen, die visuelle Eingaben nativ akzeptieren. Google hat mit Gemma 3n geantwortet, das speziell für den geräteinternen Einsatz auf Android-Smartphones mit Unterstützung für über einhundertvierzig Sprachen optimiert ist und darauf abzielt, die mehrsprachige KI in Schwellenländern zu demokratisieren.

Alibabas Qwen 3 ist das interessanteste Phänomen: Die Version mit vierzehn Milliarden Parametern übertraf Llama bei den Downloads auf HuggingFace drei Monate in Folge zwischen September und November 2025, was auf einen Wandel in der Open-Weight-Community hin zu effizienteren Modellen hindeutet. Die kleineren Varianten mit 0,6 und 1,8 Milliarden Parametern fanden in China massive Verbreitung für Edge-Anwendungen, bei denen der Energieverbrauch eine primäre Einschränkung darstellt. Mistral AI hat Ministral 3 auf den Markt gebracht, das für die Inferenz am Edge mit aggressiver Quantisierung optimiert ist und eine überraschende Qualität beibehält. Wie wir bei der Diskussion über die Strategie von Mistral mit Devstral analysiert haben, setzen europäische Start-ups auf Effizienz und Spezialisierung, um mit den amerikanischen Giganten zu konkurrieren, die die vertikale Skalierung dominieren.

HuggingFace hat SmolLM3 beigesteuert, begleitet von einem vollständigen technischen Entwurf, der jeden Aspekt der Trainingspipeline dokumentiert. Es ist ein Experiment radikaler Transparenz: Datensatz, Hyperparameter, Ablationsstudien – alles öffentlich. Das erklärte Ziel ist es, die Eintrittsbarrieren für Forscher und kleine Unternehmen zu senken, die benutzerdefinierte SLMs trainieren möchten, ohne das Rad jedes Mal neu zu erfinden. Die Unterscheidung zwischen Open-Source- und proprietären Modellen verschwimmt: Selbst Giganten wie Microsoft und Google veröffentlichen Varianten ihrer SLMs mit freizügigen Lizenzen, da sie wissen, dass das von einer aktiven Community geschaffene Ökosystem mehr wert ist als ein proprietärer Lock-in.

Der ökologische Fußabdruck, der den Unterschied macht

Die Zahlen zur Umweltauswirkung verdienen eine genauere Betrachtung, da sie zu einem Wettbewerbsfaktor und nicht nur zu einer ethischen Frage werden. Microsoft verzeichnete zwischen 2021 und 2022 einen Anstieg des Wasserverbrauchs um vierunddreißig Prozent, ein Anstieg, der fast ausschließlich auf den Ausbau der KI-Infrastruktur zurückzuführen ist. Google hat ähnliche Muster in seinen Rechenzentren dokumentiert. Das Problem ist systemisch: Massive Sprachmodelle erzeugen Wärme, die abgeführt werden muss, und die effizientesten Kühlsysteme verwenden Wasserverdunstung. Je mehr Parameter Sie trainieren, desto mehr Wärme erzeugen Sie, desto mehr Wasser verbrauchen Sie.

SLMs greifen an beiden Fronten ein. Während des Trainings benötigt ein Modell mit sieben Milliarden Parametern um Größenordnungen weniger Energie als eines mit siebzig. Aber während der Inferenz skaliert die Auswirkung dramatisch: Milliarden von täglichen Anfragen an kompakte Modelle anstelle von Riesen führen zu enormen kumulativen Einsparungen. Das Ende 2025 veröffentlichte SLM-Bench-Benchmark ist das erste systematische Framework zur Messung der Kompromisse zwischen Genauigkeit und Nachhaltigkeit und führt Metriken ein, die Leistung und Energieeffizienz mit gleicher Priorität bewerten. Unternehmen wie Hugging Face integrieren es bereits in ihre Modell-Hubs, um Entwicklern eine bewusste Auswahl zu ermöglichen.

Aber es gibt eine paradoxe Wendung, die selten diskutiert wird. Wenn SLMs die Kosten pro Anfrage so stark senken, besteht die Gefahr eines Rebound-Effekts: Unternehmen könnten die Nutzung vervielfachen, weil es "billig ist", und so die Umweltvorteile durch eine Explosion des Volumens zunichtemachen. Es ist derselbe Mechanismus, der die Energieeffizienzgewinne bei Autos zunichtegemacht hat: Effizientere Motoren führten zu mehr Autofahrten und dem Kauf schwererer SUVs. Echte Nachhaltigkeit erfordert nicht nur effizientere Modelle, sondern auch eine Governance darüber, wie viel und wie wir sie verwenden.

Vom Labor in die Fabriken: Echte Fallstudien

Unternehmenseinsätze erzählen konkretere Geschichten als theoretische Spekulationen, obwohl die Dokumentation spezifischer Details in der Unternehmenswelt, in der KI-Implementierungen oft durch NDAs abgedeckt sind, eine Herausforderung bleibt. Was aus Branchenberichten und öffentlichen Erklärungen klar hervorgeht, ist ein Adoptionsmuster, das Effizienz, Datenschutz und Spezialisierung bevorzugt.

Im Finanzsektor hat JPMorgan Chase COiN (Contract Intelligence) eingesetzt, ein Small Language Model, das auf die automatische Analyse von gewerblichen Kreditverträgen spezialisiert ist, ein Prozess, der traditionell manuell von Rechtsteams durchgeführt wird. Durch das Training von COiN an Tausenden von Rechtsdokumenten und aufsichtsrechtlichen Einreichungen hat die Bank die Überprüfungszeiten für Verträge von mehreren Wochen auf wenige Stunden reduziert und dabei eine hohe Genauigkeit und Nachverfolgbarkeit der Compliance beibehalten. Dies ermöglichte es, juristische Ressourcen auf Aufgaben umzuverteilen, die ein komplexes menschliches Urteilsvermögen erfordern, und gleichzeitig eine konstante Einhaltung der sich entwickelnden regulatorischen Standards zu gewährleisten.

Die Betrugserkennung ist ein weiteres fruchtbares Feld für Unternehmens-SLMs. Wie von Infosys und Lumenalta dokumentiert, trainieren Bankinstitute kompakte Modelle auf spezifischen betrügerischen Mustern, um Transaktionen zu analysieren und verdächtige Aktivitäten fast augenblicklich zu identifizieren. Effizienz und hohe Genauigkeit reduzieren Fehlalarme erheblich und erhöhen gleichzeitig die Erkennungsraten. SLMs in diesem Bereich werden zur Verhinderung von Kontoübernahmen eingesetzt, indem sie Anmeldemuster und Verhaltensänderungen in Echtzeit analysieren, zur Identifizierung von Geldwäscheaktivitäten durch Automatisierung von Aufgaben, die traditionell einen erheblichen manuellen Eingriff erforderten, und zur Betrugserkennung bei digitalen Zahlungen, wo sie sich durch die schnelle Erkennung von Mustern auszeichnen.

Der entscheidende Vorteil bei der Verwendung von SLMs zur Betrugsprävention liegt in ihrer Fähigkeit, kontinuierlich auf der Grundlage neuer Bedrohungsmuster aktualisiert und feinabgestimmt zu werden, was es den Banken ermöglicht, aufkommenden betrügerischen Schemata einen Schritt voraus zu sein und gleichzeitig die betriebliche Effizienz aufrechtzuerhalten. FinBERT, ein Transformer-Modell, das sorgfältig auf diversifizierten Finanzdaten wie Transkripten von Gewinnmitteilungen, Finanznachrichtenartikeln und Marktberichten trainiert wurde, ist ein weiteres konkretes Beispiel für eine effektive Spezialisierung. Dieses domänenspezifische Training ermöglicht es FinBERT, die Stimmung in Finanzdokumenten genau zu erkennen und nuancierte Töne wie positiv, negativ oder neutral zu identifizieren, die oft das Verhalten von Investoren und Märkten beeinflussen.

Im Gesundheitswesen ist die Einführung aufgrund regulatorischer Beschränkungen vorsichtiger, beschleunigt sich aber. Wie von TechTarget berichtet, analysieren Implementierungen auf medizinischen Geräten Daten von tragbaren Sensoren lokal zur proaktiven Identifizierung von Gesundheitsrisiken, um die Privatsphäre zu gewährleisten und eine kontinuierliche Überwachung zu ermöglichen. SLMs unterstützen Kliniker, indem sie therapeutische Empfehlungen geben oder Krankenakten zusammenfassen, wobei sie immer auf getrennten Infrastrukturen arbeiten, die niemals sensible Daten über kontrollierte Bereiche hinaus senden.

In der Fertigung erkennen Sensoren mit eingebetteten SLMs Fehler mit einer Analyse, die direkt am Produktionsstandort statt in entfernten Rechenzentren stattfindet, was Reaktionszeiten von Millisekunden anstelle von Sekunden, einen kontinuierlichen Betrieb bei eingeschränkter Internetverbindung und eine geringere Abhängigkeit von Bandbreite und Cloud gewährleistet. Dieses Muster ist besonders relevant für Branchen, in denen eine Netzwerklatenz für die Echtzeit-Qualitätskontrolle inakzeptabel wäre.

Gartner prognostizierte im April 2025, dass bis 2027 Organisationen kleine, aufgabenspezifische KI-Modelle mit einem Nutzungsvolumen implementieren werden, das mindestens dreimal so hoch ist wie das von Allzweck-Großsprachmodellen. Die Prognose basiert auf einer Umfrage unter achthundert europäischen und nordamerikanischen CTOs, von denen viele Compliance und Betriebskosten als Haupttreiber nennen.

Aber die Implementierungen sind nicht ohne konkrete Herausforderungen. Die Integration von SLMs in Altsysteme erfordert eine erhebliche Umgestaltung der bestehenden Architektur. Die Gewährleistung der Datenqualität für die Feinabstimmung bleibt so komplex wie bei LLMs und ist oft kritischer, da kleinere Datensätze die Auswirkungen von schmutzigen oder voreingenommenen Daten verstärken. Die Verwaltung von Dutzenden von spezialisierten Modellen führt zu einem neuen operativen Mehraufwand: Es erfordert eine ausgeklügelte Orchestrierung, um zu entscheiden, welches Modell für welche Anfrage aufgerufen werden soll, eine separate Überwachung für jedes und die Verwaltung der Versionierung bei verteilten Implementierungen.

Deutschland führt die europäische Einführung mit einer jährlichen Wachstumsrate von 32,5 % an, die zwischen 2025 und 2035 für LLM- und SLM-Implementierungen erwartet wird, angetrieben von den Fertigungs- und Luft- und Raumfahrtsektoren, in denen Edge Computing eine nicht verhandelbare technische Anforderung ist und in denen die deutsche Ingenieurkultur Determinismus und Validierung bevorzugt, native Eigenschaften von On-Premise-SLMs. Der globale SLM-Markt, der 2025 auf neunhundertdrei Millionen Dollar geschätzt wird, soll bis 2032 5,45 Milliarden erreichen, mit einer CAGR von achtundzwanzig Komma sieben Prozent, was einen Wandel bei den Investitionen hin zu KI-Modellen widerspiegelt, die sich an betrieblichen Einschränkungen und Sicherheitsanforderungen ausrichten.

Der rechtliche Rahmen: Zwischen dem KI-Gesetz und dem Einsatz auf dem Gerät

Geräteinterne SLMs bewegen sich in einer interessanten Grauzone der europäischen Regulierungslandschaft. Das KI-Gesetz unterscheidet zwischen Hochrisikosystemen, die strenge Audits erfordern, und risikoarmen Anwendungen mit reduzierten Verpflichtungen. Ein Modell, das sensible Daten vollständig auf einem lokalen Gerät verarbeitet, ohne Übertragung an externe Server, umgeht einen Teil der regulatorischen Komplexität einfach dadurch, dass die Daten nicht "reisen". Für regulierte Sektoren wie das Gesundheits- und Finanzwesen, in denen die DSGVO und HIPAA strenge Beschränkungen für die Datenübertragung vorsehen, wird diese Architektur zu einem Wettbewerbsvorteil und zu einer Compliance-Anforderung.

Compliance-Audits bei SLMs sind paradoxerweise einfacher als bei cloudbasierten LLMs. Bei einem kompakten Modell mit gesperrter Verteilung auf kontrollierter Hardware ist die Überprüfung des Verhaltens und der Fehlermodi machbar. Bei einem LLM mit Hunderten von Milliarden, das von einer verteilten Infrastruktur bedient wird, die sich ständig ändert, wird die Gewährleistung der Reproduzierbarkeit zu einem technischen Albtraum. Deutschland entwickelt sich aus genau diesem Grund zu einem europäischen Zentrum für konforme SLMs: Die deutsche Ingenieurkultur bevorzugt Determinismus und Auditierung, Fähigkeiten, die native Eigenschaften von On-Premise-SLMs sind.

Aber in den Vereinigten Staaten ist das Bild fragmentierter. Trumps Executive Order vom November 2025 versuchte, den Flickenteppich staatlicher Vorschriften zu verhindern, der im Entstehen begriffen war, wobei Kalifornien, New York und Texas unabhängig voneinander Gesetze erließen. Die Spannung besteht zwischen föderaler Innovation und staatlicher Kontrolle, wobei die KI zu einem konstitutionellen Schlachtfeld über die Gewaltenteilung wird. Eine Petition des Future of Life Institute im Oktober 2025, die von Tausenden von Forschern und parteiübergreifenden politischen Persönlichkeiten, darunter Steve Bannon und Susan Rice, unterzeichnet wurde, forderte eine Verlangsamung des Wettlaufs um künstliche Superintelligenz ohne angemessene Governance. SLMs tauchen in diesem Kontext als möglicher Kompromiss auf: leistungsstark genug, um nützlich zu sein, begrenzt genug, um kontrollierbar zu sein.

Das kommende Jahr 2026: Hype oder Durchbruch?

Überprüfbare Vorhersagen für 2026 konvergieren auf einige Muster. Andy Markus von AT&T ist mit seinem Optimismus bezüglich SLMs nicht allein: Sebastian Raschka, Yann LeCun und andere Forschungsleiter haben den Fokus öffentlich von "wie groß können wir werden" auf "wie effizient können wir sein" verlagert. Dieser rhetorische Wandel spiegelt den realen wirtschaftlichen Druck wider: Die Energiekosten steigen schneller als die Kurven des Mooreschen Gesetzes, und die Investoren beginnen, Renditen für die Milliarden zu fordern, die in GPU-Cluster investiert wurden.

Die erwartete Entwicklung geht von "reden" zu "handeln": Modelle, die nicht nur Text generieren, sondern auch Aktionen ausführen, Workflows orchestrieren und mit externen Tools interagieren. Es wird erwartet, dass Meta im ersten Quartal 2026 Llama 4 Scout veröffentlichen wird, mit nativer Bildschirmwahrnehmung, die es dem Modell ermöglicht, zu "sehen", was auf einem Gerät passiert, und proaktiv einzugreifen. Dies erfordert eine sehr geringe Latenz und eine Energieeffizienz auf Smartphone-Niveau, das natürliche Terrain für SLMs. Personalisierte SLMs mit kontinuierlicher Feinabstimmung stellen eine weitere Grenze dar: Modelle, die sich kontinuierlich an den spezifischen Kontext des Benutzers oder der Organisation anpassen, ohne ein kostspieliges Batch-Retraining zu erfordern.

Die Skalierung zur Inferenzzeit wird zu einer architektonischen Priorität. Anstatt immer größere Modelle zu trainieren, investiert die Branche in Techniken, die es bestehenden Modellen ermöglichen, bei schwierigen Problemen "länger nachzudenken", indem sie die Berechnung dynamisch zuweisen. Dies ist das Muster, das wir mit der adaptiven Zuweisung des MIT und mit dem Markovschen Denken von Harvard entstehen sehen, bei dem die algorithmische Intelligenz zur Testzeit mit der rohen Gewalt des Trainings konkurriert. SLMs profitieren besonders von diesen Ansätzen, da sie von einer effizienteren Basis ausgehen.

Das Model Context Protocol von Anthropic wird zum De-facto-Standard für agentenhafte KI und ermöglicht es verschiedenen Modellen, zu kommunizieren und sich zu koordinieren. In diesem Ökosystem könnten Batterien von spezialisierten SLMs, die von einem zentralen Controller orchestriert werden, einzelne generalistische LLMs übertreffen. Weltmodelle, Systeme, die kausale Repräsentationen der Umgebung anstelle von reinen statistischen Mustern lernen, erweisen sich als Ergänzung, nicht als Ersatz: Ein Weltmodell sagt die Konsequenzen von Handlungen voraus, ein sprachliches SLM verbalisiert sie und interagiert mit dem Benutzer.

DeepSeek-R1 und andere Ende 2025 veröffentlichte Denkmodelle sind technisch gesehen immer noch LLMs, signalisieren aber einen Wandel hin zur Optimierung: Sie verwenden eine Mischung von Experten, um nur eine Teilmenge von Parametern pro Anfrage zu aktivieren, wodurch die effektive Berechnung reduziert wird, während die Gesamtkapazität hoch bleibt. Es ist ein Hybrid aus der Philosophie von LLM und SLM. Dass Qwen Llama bei den Downloads der Open-Weight-Community übertrifft, signalisiert eine Präferenz für Effizienz. Die Übernahme der DeepSeek-V3-Architektur durch Mistral zeigt eine gegenseitige Befruchtung der Ansätze: Die besten Ideen verbreiten sich schnell, unabhängig davon, wer sie hervorbringt.

Die offenen Fragen

Wird 2026 wirklich das Jahr der SLMs sein, oder werden wir eine hybride Koexistenz erleben? Die Geschichte der KI legt nahe, bei endgültigen Proklamationen vorsichtig zu sein. Jede technologische Welle durchläuft vorhersehbare Zyklen: anfänglicher Hype, Ernücherung, wenn die Realität nicht mit den Erwartungen übereinstimmt, und pragmatische Konsolidierung, bei der die Technologie ihre realen Anwendungsfälle findet. SLMs lösen echte Probleme in Bezug auf Kosten, Latenz, Datenschutz und Nachhaltigkeit, ersetzen aber nicht LLMs an allen Fronten. Die relevante Frage ist nicht "SLM oder LLM", sondern "welches Werkzeug für welche Aufgabe".

Das Hauptrisiko besteht darin, die Fähigkeiten zu überschätzen und die Schwierigkeiten bei der Integration zu unterschätzen. Die Bereitstellung eines SLM auf einem Edge-Gerät scheint einfach, bis man sich mit der Verwaltung der Versionskontrolle auf Tausenden von heterogenen Geräten, dem Debuggen von Fehlermodi auf Hardware mit begrenzter Telemetrie und der Governance von Modellen, die sich unabhängig voneinander entwickeln, auseinandersetzen muss. Die Branche hat noch wenig operative Erfahrung mit dieser Komplexität. Andererseits ist die Chance eine echte Demokratisierung: Kleine Unternehmen und Forscher ohne Rechenzentrumsbudgets können jetzt mit algorithmischer Innovation anstelle von roher Skalierung konkurrieren.

Sebastian Raschka fasst es zusammen: Der Fortschritt im Jahr 2026 wird mehr von der Inferenz als vom Training kommen. Dies ist eine radikale Aussage für eine Branche, die die letzten fünf Jahre damit verbracht hat, von Skalierungsgesetzen während des Trainings besessen zu sein. Aber die wirtschaftlichen Signale unterstützen diesen Wandel: Die Margen für diejenigen, die riesige LLMs bedienen, schrumpfen, während diejenigen, die eine effiziente Inferenz optimieren, ihre Betriebskosten sinken sehen. Nachhaltigkeit ist nicht mehr nur ein nettes Extra, sondern ein geschäftlicher Imperativ.

Die letzte Frage für den Leser ist pragmatisch und unbequem: Wie viele der Anfragen, die Sie in Ihrer Organisation an GPT-4 senden, erfordern wirklich ein Modell mit fünfhundert Milliarden Parametern? Wie viele könnten von einem feinabgestimmten Phi-3 zu einem Zehntel der Kosten und einem Hundertstel der Latenz bearbeitet werden? Wenn die Antwort "die meisten" lautet, dann haben Andy Markus und Sebastian Raschka vielleicht Recht. 2026 könnte wirklich das Jahr sein, in dem die Branche aufhört, der Skalierung um der Skalierung willen nachzujagen, und anfängt zu fragen: Wie viel ist genug?