L'Ospedale Virtuale: Quando l'Intelligenza Artificiale diventa Dottore

L'Agent Hospital cinese simula migliaia di diagnosi al giorno in un mondo virtuale. È il futuro della medicina o l'inizio di una rivoluzione che nessuno ha chiesto? Immaginate un ospedale che funziona ventiquattro ore su ventiquattro, sette giorni su sette. I medici visitano pazienti, ordinano esami, interpretano radiografie, prescrivono terapie. In pochi giorni trattano diecimila casi clinici, accumulando un'esperienza che richiederebbe anni in un pronto soccorso affollato. C'è solo un dettaglio che rende tutto questo inquietante: nessuno di quei pazienti esiste davvero. Nessuno soffre, nessuno guarisce, nessuno muore. È come se *The Sims avesse incontrato E.R. in una dimensione dove nessuno sta giocando, ma qualcosa sta imparando.*

L'Agent Hospital della Tsinghua University, inaugurato ufficialmente nell'aprile 2025 con la prima integrazione presso il Beijing Changgung Hospital, rappresenta qualcosa di più di un esperimento accademico. È un intero ecosistema sanitario sintetico dove intelligenze artificiali si allenano a essere medici curando entità che esistono solo come stringhe di codice. Quarantadue dottori virtuali, ventuno specialità mediche, cinquecentomila pazienti che non hanno mai respirato. La domanda non è più se l'intelligenza artificiale possa fare diagnosi mediche: la domanda è se stiamo costruendo i medici del futuro o se abbiamo appena aperto un vaso di Pandora che nessuno sa come richiudere.

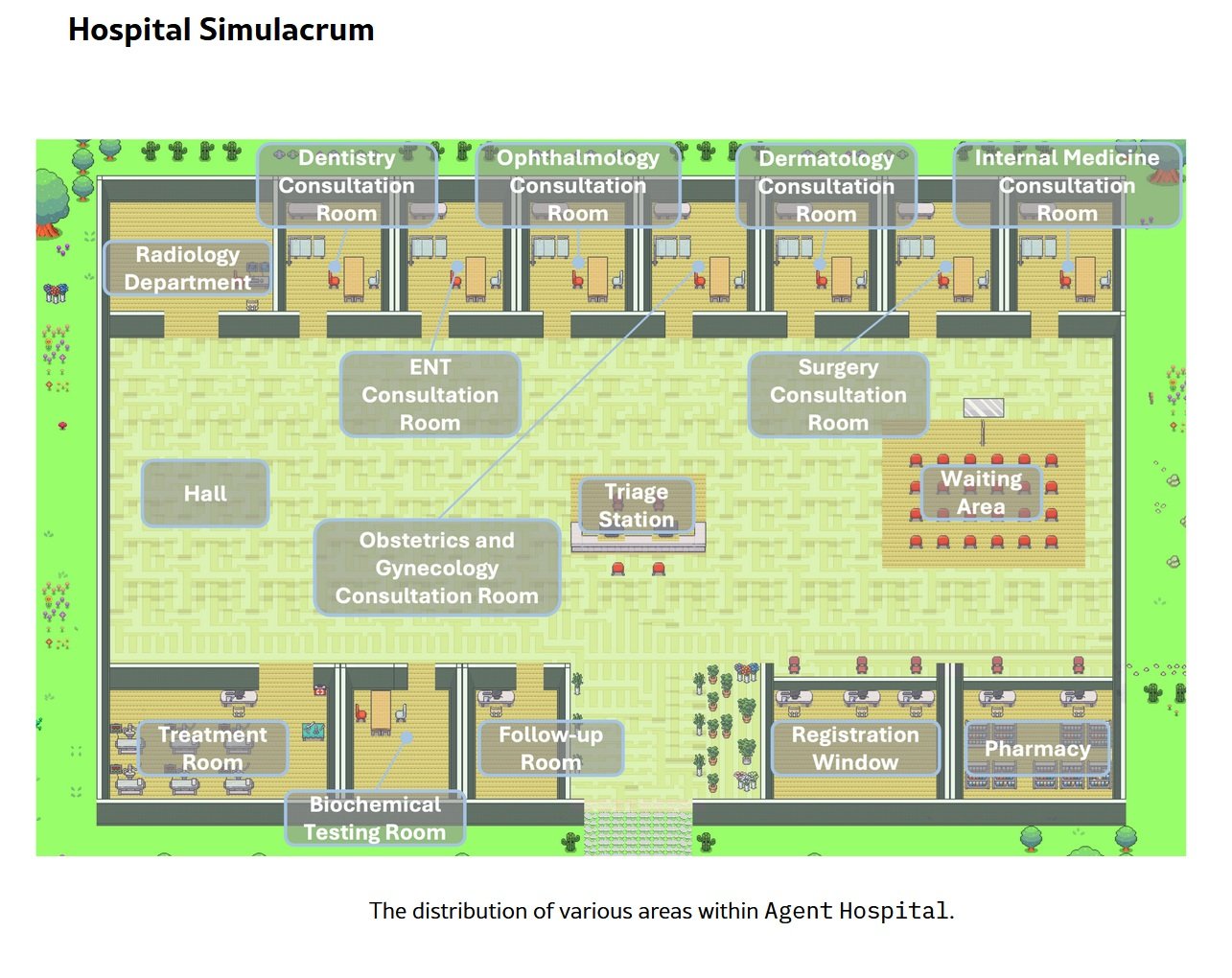

Anatomia di un Mondo Virtuale

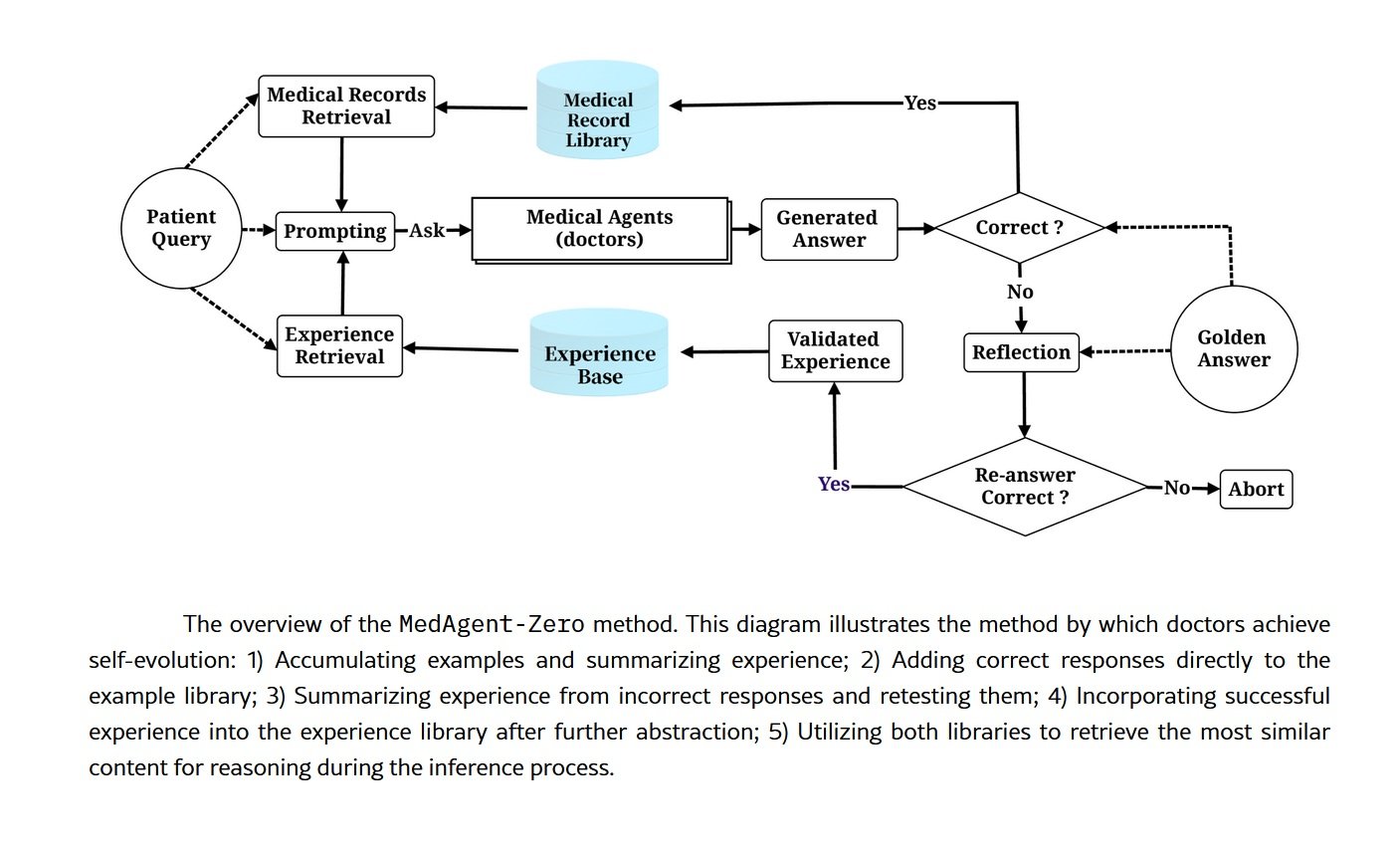

Sotto il cofano dell'Agent Hospital c'è MedAgent-Zero, un framework tecnicamente sofisticato che ribalta l'approccio tradizionale all'addestramento delle intelligenze artificiali mediche. Invece di nutrire un modello con dataset statici di casi clinici passati, i ricercatori della Tsinghua hanno costruito un ambiente dove gli agenti AI imparano facendo, esattamente come farebbero specializzandi in carne e ossa. La differenza è nella scala e nella velocità: quello che a un medico umano richiederebbe una residency di quattro anni, qui avviene in giorni di simulazione continua.

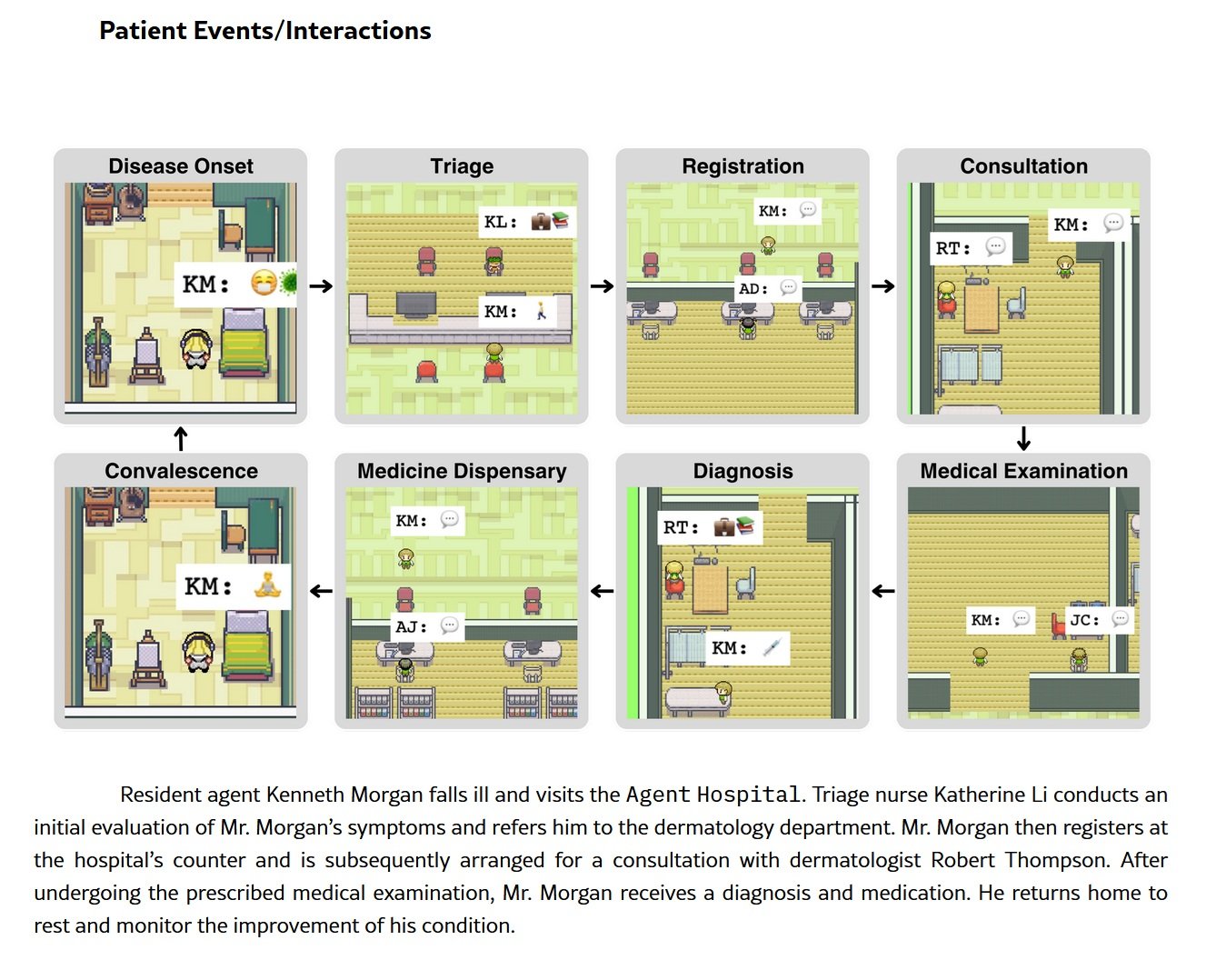

L'architettura si basa su large language models modificati per operare in un ciclo perpetuo di apprendimento. Il sistema genera autonomamente profili di pazienti sintetici con storie cliniche, sintomi, risultati di laboratorio. Questi pazienti virtuali entrano nell'ospedale fantasma e vengono assegnati agli AI doctors, ognuno specializzato in un'area specifica: cardiologia, oncologia, medicina respiratoria, neurologia. Gli agenti conducono anamnesi, richiedono esami diagnostici, interpretano dati, formulano diagnosi e propongono piani terapeutici. Dopo ogni interazione, un sistema di feedback valuta la correttezza delle decisioni cliniche confrontandole con linee guida consolidate e con il ground truth del caso simulato. Gli errori diventano lezioni, i successi rafforzano i pattern decisionali.

I numeri attuali sono impressionanti ma non perfetti, e questa onestà nelle metriche è forse più significativa delle percentuali stesse. Nell'examination phase, quella dell'anamnesi e della raccolta dati, il sistema raggiunge l'ottantotto percento di accuratezza. Nella diagnosis phase sale al novantacinque virgola sei percento. Nel treatment planning, la fase più complessa perché richiede non solo di identificare la malattia ma di bilanciare efficacia terapeutica, effetti collaterali, patologie e preferenze del paziente, l'accuratezza scende al settantasette virgola sei percento. Sul benchmark MedQA, che utilizza domande in stile USMLE (l'esame di abilitazione medica statunitense) focalizzate su malattie respiratorie, il sistema ha toccato il novantatré percento.

Sono performance che farebbero impallidire molti medici umani? Dipende. Un novantatré percento su domande a scelta multipla è eccellente ma non straordinario per un AI system ottimizzato su quel tipo di task. Il settantasette percento nel treatment planning è più preoccupante: significa che in quasi un caso su quattro, la terapia proposta non è ottimale. In un ospedale reale, con pazienti reali, questa percentuale rappresenterebbe migliaia di errori potenzialmente gravi. Ma è qui che emerge il vero valore della simulazione: quegli errori avvengono in un ambiente sicuro, dove l'unica conseguenza è un aggiustamento dei pesi neurali.

La compressione temporale è il vero superpotere di questa architettura. Quello che in medicina richiede anni di esperienza clinica, esposizione a centinaia di casi diversi, notti insonni in guardia, qui si condensa in cicli computazionali. Un AI doctor può vedere in una settimana di simulazione più casi di polmonite atipica di quanti ne vedrebbe uno pneumologo umano in una carriera intera in un ospedale di provincia. Il problema è capire se quantità di esposizione equivale davvero a qualità di competenza.

Dal Virtuale al Reale

La timeline di deployment dell'Agent Hospital racconta una storia di accelerazione vertiginosa. I test interni sono iniziati a novembre 2024, quando il sistema era ancora confinato nei laboratori della Tsinghua. Il pilot pubblico è partito nel primo trimestre del 2025, con medici reali che hanno iniziato a interagire con le diagnosi generate dall'AI in scenari controllati. Ad aprile 2025 è arrivata l'integrazione operativa con il Beijing Changgung Hospital, segnando il passaggio da esperimento accademico a strumento clinico effettivo.

Dietro questa transizione c'è Tairex, la startup spin-off che ha commercializzato la tecnologia sotto il brand Zijing AI Doctor. I quarantadue medici virtuali oggi coprono oltre trecento malattie e sono attivi in pilot programs che spaziano dall'oftalmologia alla radiologia, dalla medicina respiratoria alla medicina generale. Non si tratta di semplici chatbot medici o di sistemi di triage telefonico: questi agenti AI sono integrati nei flussi di lavoro ospedalieri reali, affiancano medici umani nella lettura di imaging diagnostico, suggeriscono diagnosi differenziali, propongono protocolli terapeutici basati su evidenze aggiornate.

Il modello economico dietro questa rivoluzione è insieme ambizioso e pragmatico. Le stime più conservative parlano di un potenziale risparmio del dieci-venti percento sui costi ospedalieri complessivi. Proiettato al 2050 nel solo sistema sanitario statunitense, questo si tradurrebbe in un range tra trecento e novecento miliardi di dollari all'anno. Numeri che fanno brillare gli occhi dei CFO ospedalieri e degli investitori in healthtech, ma che sollevano domande scomode: stiamo ottimizzando la cura dei pazienti o stiamo ottimizzando i bilanci?

L'obiettivo dichiarato dai ricercatori cinesi è duplice e apparentemente nobile. Da un lato colmare il gap sanitario nelle aree rurali e nelle regioni sottodotate di personale medico specializzato, un problema particolarmente acuto in un paese con milletrecentocinquanta milioni di abitanti distribuiti su un territorio vasto quanto l'Europa. Dall'altro creare un training ground per quella che chiamano "AI-collaborative physicians", una nuova generazione di medici che non lavora contro l'intelligenza artificiale né viene sostituita da essa, ma impara a orchestrarla come uno strumento di potenziamento cognitivo. È una visione seducente, quasi utopica. Il diavolo, come sempre, si nasconde nell'implementazione.

Il Lato Oscuro dell'Algoritmo

Responsabilità Legale nel Vuoto Normativo

La prima crepa nell'edificio scintillante dell'AI medica si apre sulla questione della responsabilità. Quando un AI doctor sbaglia una diagnosi, chi risponde? Il medico umano che ha supervisionato (o non ha supervisionato) la decisione? L'ospedale che ha implementato il sistema? Gli sviluppatori che hanno addestrato il modello? L'università che ha condotto la ricerca? La risposta onesta è: nessuno lo sa con certezza, perché i framework normativi sono drammaticamente indietro rispetto alla tecnologia.

La Food and Drug Administration statunitense classifica gli algoritmi medici come dispositivi medici, ma le categorie esistenti non catturano la natura dinamica dei sistemi basati su machine learning che continuano a imparare dopo il deployment. Il Medical Device Regulation europeo è ancora più vago su questi aspetti. In Cina, dove l'Agent Hospital sta prendendo forma, la situazione normativa è opaca per gli osservatori occidentali ma evidentemente permissiva abbastanza da consentire queste sperimentazioni su larga scala.

C'è poi il problema del consenso informato. Quando un paziente entra in un reparto dove le decisioni diagnostiche sono influenzate o determinate da algoritmi, lo sa? Gli viene spiegato che la sua radiografia sarà analizzata prima da un sistema AI e solo dopo verificata da un radiologo umano? Che il piano terapeutico è stato generato da un agente artificiale addestrato su pazienti che non sono mai esistiti? Il gap tra trasparenza teorica e pratica clinica quotidiana può essere imbarazzante.

Il Rischio del Deskilling Medico

L'eccessiva dipendenza dall'intelligenza artificiale non è uno scenario distopico futuro: è un rischio presente e documentato. Quando i medici si abituano ad avere sempre disponibile un secondo parere algoritmico, le loro competenze cliniche indipendenti si erodono. È lo stesso principio per cui le nuove generazioni hanno perso la capacità di orientarsi senza GPS: la tecnologia diventa stampella cognitiva e, quando manca, crollano le performance.

L'impatto sui tirocinanti medici è potenzialmente ancora più grave. Se gli specializzandi imparano a diagnosticare affiancati da AI systems che suggeriscono sempre la risposta, svilupperanno mai il ragionamento clinico autonomo necessario per operare in contesti dove quella tecnologia non è disponibile? O stiamo creando una generazione di medici che funzionano solo con le ruotine dell'assistente artificiale? La variabilità tra strutture sanitarie aggrava il problema: un medico addestrato in un ospedale iper-tecnologico con Agent Hospital integrato potrebbe trovarsi in difficoltà quando si sposta in una clinica rurale con risorse limitate.

Bias Algoritmici e Rappresentatività

Cinquecentomila pazienti sintetici sono tanti, ma rappresentano la diversità reale della popolazione umana? Gli AI doctors si allenano su casi generati da modelli che hanno inevitabilmente bias incorporati dai dati su cui sono stati pre-addestrati. Se quei dati sovra-rappresentano alcune popolazioni (tipicamente maschi, caucasici, di mezza età) e sotto-rappresentano altre (donne, minoranze etniche, anziani, pazienti con patologie multiple), il sistema perpetua e amplifica le disparità esistenti.

Il problema della sovranità dei dati aggiunge un ulteriore livello di complessità. I pazienti virtuali dell'Agent Hospital sono stati generati da modelli addestrati su quali dati? Provengono da popolazioni cinesi, occidentali, globali? Le malattie rare nelle popolazioni asiatiche sono sovra-rappresentate rispetto a quelle tipiche di altre aree geografiche? E soprattutto: quando questi sistemi verranno esportati e implementati in altri paesi, funzioneranno altrettanto bene su popolazioni geneticamente e clinicamente diverse?

L'Elefante nella Stanza: l'Empatia

Dong Jiahong, accademico cinese citato nel dibattito sull'Agent Hospital, ha sintetizzato l'obiezione più fondamentale con una frase che suona quasi poetica: "La medicina è la scienza dell'amore, ma l'intelligenza artificiale rimane fredda". Non è luddismo o nostalgia romantica: è il riconoscimento che la relazione medico-paziente ha componenti che sfuggono alla quantificazione algoritmica.

Un AI doctor può analizzare sintomi, correlare dati di laboratorio, suggerire diagnosi con percentuali di confidenza a tre cifre decimali. Non può cogliere lo sguardo di un paziente che nasconde informazioni per vergogna, non può leggere l'esitazione nella voce di chi ha paura di fare domande, non può offrire il conforto di una presenza umana nel momento della cattiva notizia. Il tocco umano non è un optional romantico della medicina: è parte integrante del processo terapeutico, documentato da decenni di ricerca su effetto placebo, compliance terapeutica, outcomes psicologici.

Quando deleghiamo la diagnosi a sistemi artificiali, cosa succede a quella dimensione relazionale? Alcuni sostengono che liberare i medici dai compiti computazionali permetterebbe loro di dedicare più tempo all'aspetto umano. Altri temono che la medicina diventi progressivamente un'esperienza disincarnata, dove il paziente interagisce con schermi e algoritmi mentre il medico umano diventa un supervisore distante, un quality controller che firma report generati da macchine.

La Domanda che Nessuno Fa

Chi ha effettivamente chiesto questa rivoluzione? I pazienti hanno organizzato manifestazioni per avere più AI nei reparti? I medici hanno scioperato per ottenere agenti virtuali che li affianchi? La risposta scomoda è che l'Agent Hospital nasce da un'agenda che ha più a che fare con efficienza economica e showcase tecnologico che con necessità espresse dal basso. È l'offerta che crea la domanda, il classico technology push mascherato da innovazione necessaria.

Il paradosso dell'efficienza permea tutto il discorso sull'AI medica. Più veloce è sempre meglio? Una diagnosi corretta in trenta secondi è davvero superiore a una diagnosi corretta in dieci minuti se la seconda include una conversazione che tranquillizza il paziente e costruisce fiducia? Stiamo ottimizzando metriche che contano davvero o stiamo ottimizzando quello che è facile misurare?

Cronenberg in eXistenZ esplorava il momento in cui la simulazione diventa più reale della realtà, quando i confini tra livelli di esistenza si dissolvono e nessuno sa più in quale dimensione sta operando. L'Agent Hospital pone una questione strutturalmente simile: quando un sistema addestrato su pazienti inesistenti inizia a curare persone reali, dove tracciamo il confine tra simulazione validata e pratica clinica? Chi decide quando la compressione temporale virtuale ha generato abbastanza esperienza da equivalere ai decenni di pratica umana?

Le prospettive sono polarizzate lungo assi geografici e culturali. L'urgenza cinese è comprensibile: una popolazione che invecchia rapidamente, una carenza cronica di medici specializzati, disparità sanitarie enormi tra megalopoli costiere e province interne. Per Pechino, l'Agent Hospital non è un esperimento filosofico ma una soluzione pragmatica a problemi reali e immediati. La cautela occidentale, invece, riflette sistemi sanitari diversi, framework normativi più stringenti, una sensibilità maggiore (almeno in teoria) verso autonomia del paziente e consenso informato.

L'interrogativo finale è brutalmente semplice: stiamo costruendo strumenti per l'umanità o stiamo sostituendo l'umanità con strumenti? La distinzione non è accademica. Nel primo caso, l'AI medica è un amplificatore delle capacità umane, un modo per estendere la competenza dei bravi medici e colmare i gap dei meno preparati. Nel secondo caso, è l'inizio di un percorso dove la professione medica diventa progressivamente automatizzata, dove le decisioni cliniche migrano da processi cognitivi umani a catene algoritmiche supervisionate.

Il Confine che Si Assottiglia

L'Agent Hospital è uno specchio che riflette le nostre priorità come civiltà tecnologica. Mostra cosa valutiamo (efficienza, scalabilità, costi ottimizzati) e cosa siamo disposti a sacrificare (tempo relazionale, intuizione clinica umana, il diritto di essere curati da qualcuno che ha vissuto l'esperienza della malattia e della guarigione). La tecnologia in sé è neutra, una verità così abusata da essere diventata quasi vuota. Ma l'implementazione non è mai neutra: ogni scelta di deployment rivela assunzioni etiche, bias economici, visioni antropologiche.

I diecimila pazienti virtuali che oggi popolano i reparti fantasma della Tsinghua potrebbero essere noi domani, seduti in ambulatori dove la prima anamnesi la fa un agente AI, dove la nostra radiografia viene letta da reti neurali addestrate su milioni di immagini sintetiche, dove il piano terapeutico ci viene presentato da un medico umano che sta semplicemente validando quello che l'algoritmo ha già deciso. Non è fantascienza: è già qui, in fase di pilot, in espansione controllata, in attesa di scalare.

La domanda non è più "se" questo futuro arriverà. È "come" lo gestiremo, con quali salvaguardie, con quanta trasparenza, con quale bilanciamento tra efficienza sistemica e dignità individuale. L'Agent Hospital della Tsinghua non è la risposta: è l'inizio della conversazione che avremmo dovuto iniziare anni fa. Meglio tardi che mai, ma il tempo stringe. Gli algoritmi imparano velocemente. Noi umani, molto meno.