L'AI ti rende più abile, non più saggio. Sovrastimare le proprie conoscenze

Immaginate di sostenere il test d'ammissione alla facoltà di legge americana con ChatGPT al vostro fianco. I risultati migliorano sensibilmente: tre punti in più rispetto a chi affronta l'esame da solo. Eppure, quando vi viene chiesto di valutare la vostra performance, sbagliate di quattro punti per eccesso. Non solo: più conoscete tecnicamente il funzionamento dell'intelligenza artificiale, più questa illusione di competenza si amplifica. Benvenuti nel paradosso della cognizione aumentata, dove diventare più bravi significa contemporaneamente perdere la capacità di capire quanto siamo davvero bravi.

Il paradosso della performance aumentata

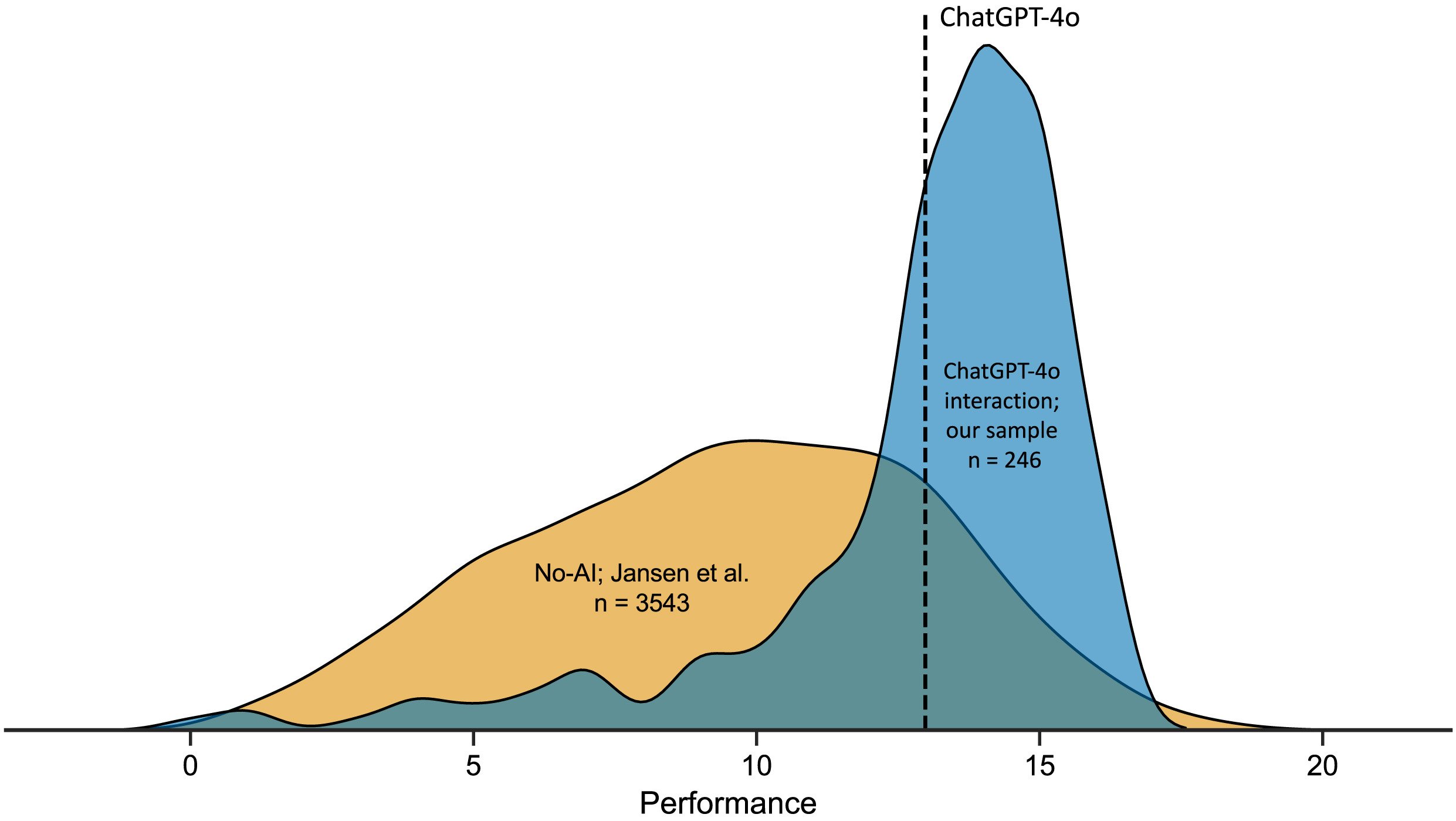

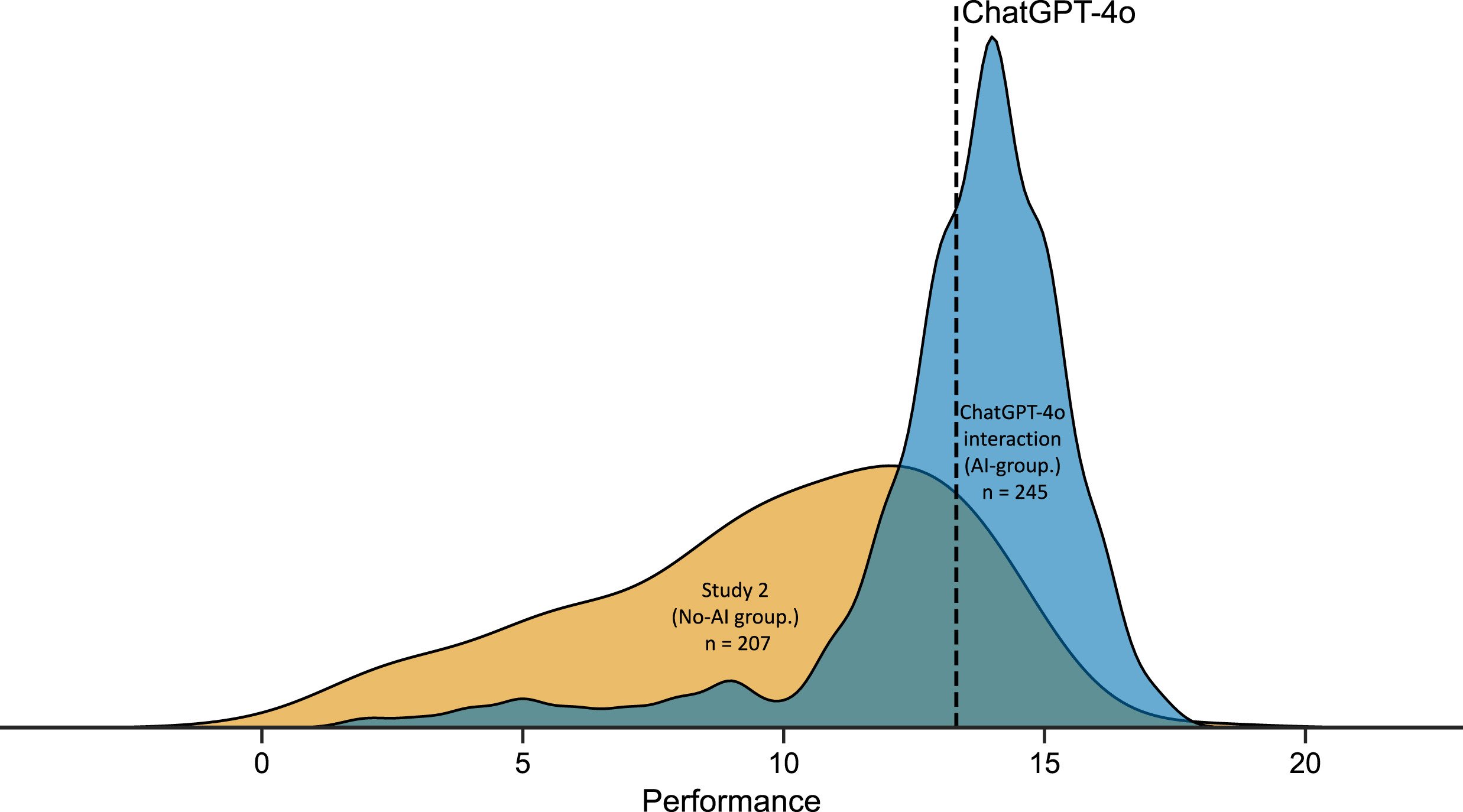

La ricerca condotta dall'Università di Aalto e pubblicata su Computers in Human Behavior ha sottoposto 246 partecipanti a venti quesiti di ragionamento logico tratti dal LSAT, il test standardizzato per l'accesso alle scuole di legge americane. Metà del campione poteva consultare ChatGPT-4o liberamente durante la risoluzione, l'altra metà procedeva in autonomia. I numeri raccontano una storia ambivalente: chi usava l'AI otteneva punteggi medi di 12,98 su 20, contro i 9,45 di chi lavorava senza assistenza. Un miglioramento del 37% che, sulla carta, confermerebbe le promesse dell'intelligenza aumentata.

Ma c'è un dettaglio scomodo. Quando ai partecipanti del gruppo AI veniva chiesto di stimare quante risposte avessero fornito correttamente, la media delle loro previsioni si attestava a 16,50 su 20. Una sovrastima sistematica di circa quattro punti, doppia rispetto al gruppo di controllo. Come se l'accesso a uno strumento potente avesse non solo potenziato le loro capacità effettive, ma contemporaneamente distorto la percezione di quelle capacità in misura ancora maggiore.

Il fenomeno ricorda quella sensazione che tutti abbiamo provato scrollando Wikipedia alle tre di notte: dopo aver letto tre articoli sull'esoscheletro dei crostacei, ci sentiamo improvvisamente esperti di biologia marina. Gli psicologi chiamano questo meccanismo "illusione di profondità esplicativa", e funziona così: quando un'informazione è facilmente accessibile, il nostro cervello la confonde con informazione posseduta. Nel caso dell'AI, però, l'effetto è amplificato dalla natura conversazionale dell'interazione: ChatGPT non si limita a restituire un dato, costruisce una narrazione articolata che mima il processo cognitivo stesso.

Daniela Fernandes, prima autrice dello studio, ha osservato che la maggioranza dei partecipanti interagiva con ChatGPT in modo sorprendentemente superficiale. Il 46% inviava un solo prompt per problema, copiando la domanda nell'interfaccia e accettando la risposta senza ulteriori approfondimenti. Come affidarsi al primo risultato di una ricerca Google senza verificare le fonti, ma con conseguenze più subdole: non stai solo delegando la ricerca dell'informazione, stai esternalizzando il processo di ragionamento stesso.

La scomparsa dell'effetto Dunning-Kruger

Per decenni, uno dei fenomeni più studiati in psicologia cognitiva è stato l'effetto Dunning-Kruger: quella sistematica tendenza degli individui meno competenti a sopravvalutare drasticamente le proprie abilità, mentre i più preparati tendono a una modesta sottostima. È il principio che spiega perché il collega che sa a malapena aprire un foglio Excel si offre con sicurezza per gestire il database aziendale, mentre l'ingegnere informatico esita prima di dare un parere.

Nei test di ragionamento logico condotti senza AI, questo pattern emerge con regolarità matematica: chi si colloca nel profilo più basso di performance tende a credere di appartenere alla fascia medio-alta, chi eccelle spesso si posiziona più in basso di dove meriterebbe. È un effetto di calibrazione inversamente proporzionale alla competenza effettiva, alimentato da quello che i ricercatori chiamano "metacognitive noise": il rumore di fondo che interferisce con la nostra capacità di autovalutazione.

Ma quando i ricercatori di Aalto hanno applicato un modello computazionale bayesiano ai dati del gruppo che usava ChatGPT, hanno scoperto qualcosa di inatteso. L'effetto Dunning-Kruger semplicemente scompariva. Non veniva ridotto o attenuato: cessava di esistere come pattern statisticamente rilevante. Tutti i partecipanti, indipendentemente dalla loro performance effettiva, mostravano livelli simili di sovrastima. Come se l'AI avesse livellato non solo le competenze, ma anche l'incapacità di valutarle accuratamente.

Il meccanismo sottostante è controintuitivo ma logico. L'effetto Dunning-Kruger emerge dalla correlazione tra abilità nel compito e abilità metacognitiva, cioè la capacità di monitorare la qualità del proprio ragionamento. Chi è bravo a risolvere problemi logici è anche bravo a riconoscere quando la sua soluzione regge o crolla. Ma quando ChatGPT entra in gioco, questa correlazione si spezza: l'AI fornisce output di qualità relativamente uniforme a tutti, indipendentemente dalla capacità del singolo utente di valutarne la validità. Il risultato è una performance livellata verso l'alto e una metacognizione livellata verso il basso. Tutti migliorano, ma nessuno sa davvero di quanto.

Robin Welsch, psicologo cognitivo e supervisore della ricerca, ha osservato che questo rappresenta un ribaltamento dell'ipotesi di aumento cognitivo formulata negli anni '60 da Doug Engelbart. L'idea originale era che le tecnologie potessero amplificare l'intelletto umano mantenendo o migliorando la consapevolezza critica. Invece, stiamo assistendo a un'amplificazione asimmetrica: le capacità crescono, la saggezza ristagna.

L'alfabetizzazione tecnologica come boomerang

Se esiste un risultato dello studio che rovescia le assunzioni comuni sul rapporto tra competenza e uso consapevole della tecnologia, è la correlazione tra alfabetizzazione AI e accuratezza metacognitiva. I ricercatori hanno misurato l'alfabetizzazione AI dei partecipanti usando la scala SNAIL (Scale for the assessment of non-experts' AI literacy), che valuta tre dimensioni: comprensione tecnica del funzionamento dei sistemi, capacità di valutazione critica degli output e abilità nell'applicazione pratica.

Quello che ci si aspetterebbe è una relazione positiva: chi conosce meglio l'AI dovrebbe usarla in modo più consapevole, riconoscerne i limiti, calibrare meglio la fiducia nei suoi suggerimenti. Invece, i dati mostrano l'opposto. I partecipanti con punteggi più alti nella dimensione di "comprensione tecnica" erano sistematicamente meno accurati nelle autovalutazioni. Più sapevano di prompt engineering, temperatura dei modelli e architetture transformer, più sopravvalutavano la qualità del loro lavoro con l'AI.

È un effetto che ricorda quella scena di Primer, il film di culto di Shane Carruth sul viaggio nel tempo, dove i protagonisti diventano così immersi nella complessità tecnica della loro macchina che perdono completamente di vista le implicazioni di ciò che stanno costruendo. La familiarità con il meccanismo non garantisce la saggezza nell'uso. Anzi, può creare una falsa sensazione di controllo: "So come funziona questa cosa, quindi posso fidarmi dei risultati che mi dà".

Thomas Kosch, esperto di interazione uomo-macchina e coautore dello studio, suggerisce che questo paradosso derivi da un equivoco fondamentale su cosa significhi "conoscere" un sistema AI. Comprendere tecnicamente un large language model significa sapere che processa testo tramite layer di attenzione, che predice il token successivo per massimizzazione probabilistica, che può essere fine-tuned su dataset specifici. Ma questa conoscenza procedurale non si traduce automaticamente in consapevolezza epistemica: sapere quando il modello sta producendo una risposta affidabile e quando sta semplicemente generando testo plausibile.

Il gruppo di ricerca ha trovato una correlazione positiva tra tutti e tre i fattori della scala SNAIL e la confidenza media dei partecipanti. Chi sapeva di più si sentiva più sicuro. Ma questa sicurezza non si traduceva in una migliore capacità di discriminare tra risposte corrette e incorrette: l'area sotto la curva ROC, che misura quanto bene i giudizi di confidenza predicono l'accuratezza effettiva, rimaneva stabile o addirittura diminuiva con l'aumentare dell'alfabetizzazione AI. Più sai, più ti fidi, ma non necessariamente meglio giudichi.

Il collasso della metacognizione

Per capire quanto sia profondo il deficit metacognitivo indotto dall'uso dell'AI, i ricercatori hanno analizzato non solo le stime globali di performance (quante domande credi di aver risolto correttamente?), ma anche i giudizi di confidenza passo passo: dopo ogni singolo problema, i partecipanti valutavano su una scala da 0 a 100 quanto fossero sicuri della loro risposta.

In condizioni normali, questi giudizi dovrebbero essere predittivi: alta confidenza per le risposte corrette, bassa per quelle sbagliate. È il segnale che il sistema metacognitivo sta funzionando, che esiste un loop di feedback tra processo decisionale e monitoraggio della qualità di quel processo. Ma nel gruppo che usava ChatGPT, questa correlazione risultava significativamente attenuata. La confidenza media per le risposte corrette era solo marginalmente più alta di quella per le risposte sbagliate, con un AUC medio di 0,62, appena sopra il livello di casualità e ben sotto la soglia di 0,70 che gli psicologi considerano indice di "moderata sensibilità metacognitiva".

In pratica, i partecipanti si sentivano sicuri più o meno sempre, indipendentemente dal fatto che stessero fornendo la risposta giusta o sbagliata. Come guidare con il cruscotto coperto: il veicolo funziona, ma non hai idea se stai andando a trenta o a centotrenta all'ora.

Questo collasso della sensibilità metacognitiva ha implicazioni che vanno ben oltre i test di logica. Pensate a un medico che usa un sistema di AI diagnostica: se la sua capacità di distinguere tra diagnosi affidabili e diagnosi dubbie viene compromessa dalla facilità con cui l'AI produce output formalmente convincenti, il risultato non è un miglioramento della pratica clinica ma un potenziale aumento del rischio. O a uno studente che prepara un esame usando ChatGPT per risolvere problemi: se l'accesso immediato alle soluzioni lo convince di aver compreso la materia, si presenterà all'esame con un senso di preparazione illusorio.

Il fenomeno è aggravato da quella che Stephen Fleming, neuroscienziato della cognizione all'University College London, chiama "fluency heuristic": quando un'informazione è processata rapidamente e senza sforzo, il cervello la interpreta come segnale di competenza. ChatGPT restituisce risposte elaborate, articolate, formattate impeccabilmente e quasi istantaneamente. Ogni aspetto di questa esperienza urla "questo è corretto" al nostro sistema intuitivo, bypassando l'analisi deliberativa che normalmente attiviamo di fronte a informazioni incerte.

Ripensare le interfacce intelligenti

La domanda diventa allora: se l'AI migliora effettivamente le performance ma deteriora la consapevolezza critica, come progettiamo sistemi che mantengano i benefici minimizzando i danni? La risposta non può limitarsi a "usiamola meno" o "fidiamoci di meno". Il genio è uscito dalla lampada, e decine di milioni di persone usano quotidianamente strumenti come ChatGPT, Claude, Gemini per ragionare, scrivere, risolvere problemi.

I ricercatori propongono quello che chiamano "explain-back micro-task" (micro-attività di spiegazione): prima di accettare una risposta generata dall'AI, l'utente deve riformularla con parole proprie, esplicitando la logica sottostante. È una tecnica che forza il passaggio da un apprendimento superficiale, basato sul riconoscimento di pattern, a uno profondo, basato sulla comprensione strutturale. Se chiedi a ChatGPT di risolvere un problema di fisica e poi devi spiegare a parole tue perché quella soluzione funziona, il sistema ti costringe a un confronto diretto con la tua effettiva comprensione.

Un'altra direzione promettente riguarda la calibrazione esplicita della confidenza. Invece di lasciare che l'utente desuma implicitamente l'affidabilità di una risposta dal tono assertivo del modello, l'interfaccia potrebbe visualizzare metriche di incertezza: quanto il modello è "sicuro" della risposta in termini di distribuzione di probabilità, se esistono risposte alternative plausibili, quanto la domanda si discosta dal training set. Non è una soluzione perfetta perché gli utenti tendono comunque a ignorare questi segnali quando l'output appare convincente, ma almeno introduce un elemento di frizione cognitiva.

Gli esperti di human-AI interaction stanno anche esplorando architetture più radicali, come gli agenti metacognitivi: sistemi AI secondari il cui compito non è aiutarti a risolvere il problema, ma monitorare come stai risolvendo il problema con l'aiuto della prima AI. Una sorta di supervisore cognitivo che interviene quando rileva pattern di overreliance o accettazione acritica. Suona fantascienza, ma alcuni esperimenti preliminari mostrano riduzioni significative della sovrastima di performance quando questo tipo di impalcatura metacognitiva viene implementata.

Falk Lieder, ricercatore all'Istituto Max Planck, ha proposto un framework ancora più ambizioso: interfacce che si adattano dinamicamente al livello di competenza metacognitiva dell'utente. Quando il sistema rileva che ti stai fidando troppo ciecamente degli output, aumenta il livello di ambiguità delle risposte, inserisce segnali di incertezza più marcati, ti chiede di giustificare le tue scelte. Quando invece dimostri capacità critica, si ritrae e lascia più autonomia. È un modello che ribalta la logica attuale, dove l'AI cerca di essere sempre più fluida e di assistenza, per introdurre invece una strategia di "assistenza calibrata".

Il rischio, naturalmente, è che questi interventi creino attriti tali da rendere gli strumenti meno appetibili. Se ogni volta che chiedo a ChatGPT di aiutarmi con un problema devo passare attraverso un quiz metacognitivo prima di vedere la risposta, è probabile che smetterò di usarlo. Ma forse è proprio questo il punto: l'obiettivo non dovrebbe essere massimizzare l'engagement con l'AI, ma ottimizzare l'aumento cognitivo nel senso più pieno, inclusa la dimensione metacognitiva.

Janet Rafner, che studia le implicazioni sociotecniche dell'AI al Copenhagen Institute, suggerisce che il problema richiede soluzioni su più livelli. A breve termine, design migliori per le interfacce. A medio termine, programmi educativi che insegnino non solo l'alfabetizzazione AI tecnica ma anche quella metacognitiva. A lungo termine, una riconsiderazione culturale di cosa significhi competenza in un mondo dove l'accesso a capacità cognitive esterne è ubiquo. È una sfida che ricorda quella affrontata dalla scrittura stessa millenni fa: quando hai a disposizione la memoria esterna della parola scritta, cosa succede alla memoria interna? E soprattutto, cosa succede alla tua consapevolezza di cosa ricordi davvero e cosa hai solo trascritto?

La ricerca dell'Università di Aalto non offre soluzioni definitive, ma identifica con precisione un problema che rischiava di rimanere sommerso sotto l'entusiasmo per i guadagni di performance. L'AI ci rende più intelligenti nel senso computazionale: risolviamo più problemi, più velocemente, con meno errori. Ma non ci rende più saggi nel senso metacognitivo: non miglioriamo nella capacità di valutare criticamente i nostri stessi processi cognitivi, di riconoscere quando stiamo davvero comprendendo e quando stiamo solo simulando comprensione.

È la differenza tra Deckard e i replicanti in Blade Runner: tutti possiedono memorie, ma solo alcuni sanno quali sono autenticamente proprie. Nel nostro caso, tutti otteniamo risposte migliori con l'AI, ma rischiamo di perdere la capacità di distinguere tra comprensione genuina e competenza mutuata. E in un mondo dove sempre più decisioni importanti vengono prese con l'assistenza di sistemi intelligenti, quella distinzione potrebbe fare tutta la differenza.