La sete dell'intelligenza artificiale: come i datacenter stanno riscrivendo la geografia dell'acqua

Quando ChatGPT genera una risposta di venti righe, probabilmente non pensiamo all'acqua. Eppure, da qualche parte nel mondo, un datacenter sta evaporando circa mezzo litro di acqua per permettere a quella conversazione di esistere. Non è una metafora: è termodinamica pura. L'intelligenza artificiale, quella che sembra così eterea e immateriale quando fluttua sui nostri schermi, affonda le sue radici in una realtà fisica fatta di silicio, elettricità e, sempre più, di acqua.

Il legame tra pensiero artificiale e risorse idriche non è immediato da comprendere, ma ha una logica ferrea. I modelli di linguaggio, le reti neurali per il riconoscimento di immagini, i sistemi di raccomandazione che orchestrano il nostro consumo digitale: tutto questo richiede calcolo. E il calcolo genera calore. Come osservava già William Gibson nei suoi romanzi cyberpunk degli anni Ottanta, la tecnologia non abita un piano astratto e perfetto, ma si incarna sempre in un substrato materiale con tutti i suoi limiti fisici. Il silicio dei chip NVIDIA H100 e A100, quelli che alimentano ChatGPT, Claude, Midjourney e tutti gli altri servizi di AI generativa, può raggiungere temperature superiori a 80 gradi Celsius quando opera a piena capacità. Senza un sistema di raffreddamento efficace, questi chip si spegnerebbero in pochi minuti, fondendo letteralmente.

Anatomia della sete digitale

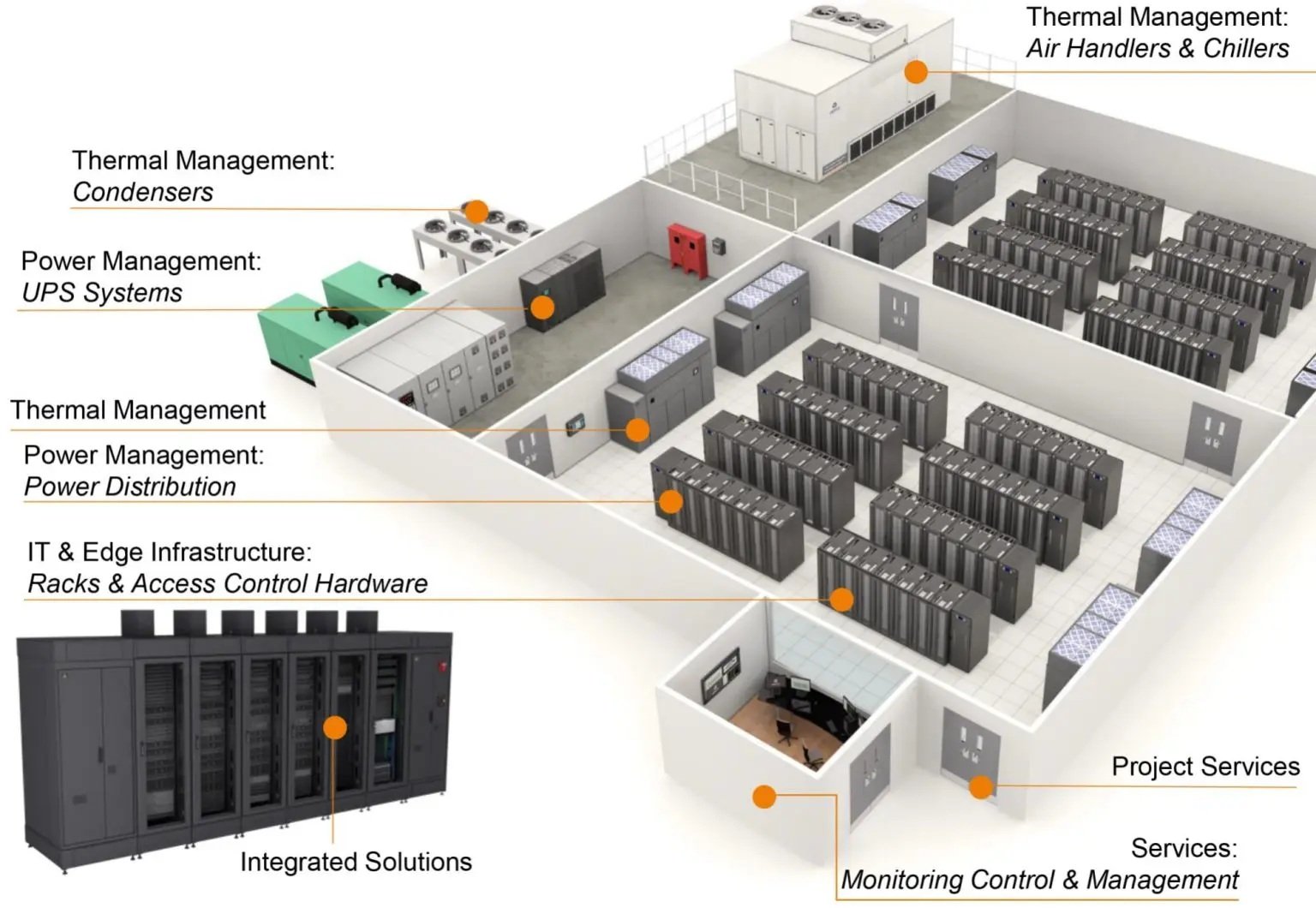

Per comprendere perché l'AI beve acqua, dobbiamo entrare nel ventre di un datacenter moderno. Immaginiamo una sala grande quanto un campo da calcio, riempita di rack metallici alti due metri. Ogni rack contiene decine di server, ogni server ospita processori e GPU che eseguono miliardi di operazioni al secondo. L'aria è costantemente attraversata da un ronzio profondo, quello delle ventole che tentano disperatamente di disperdere il calore. Ma l'aria da sola, ormai, non basta più.

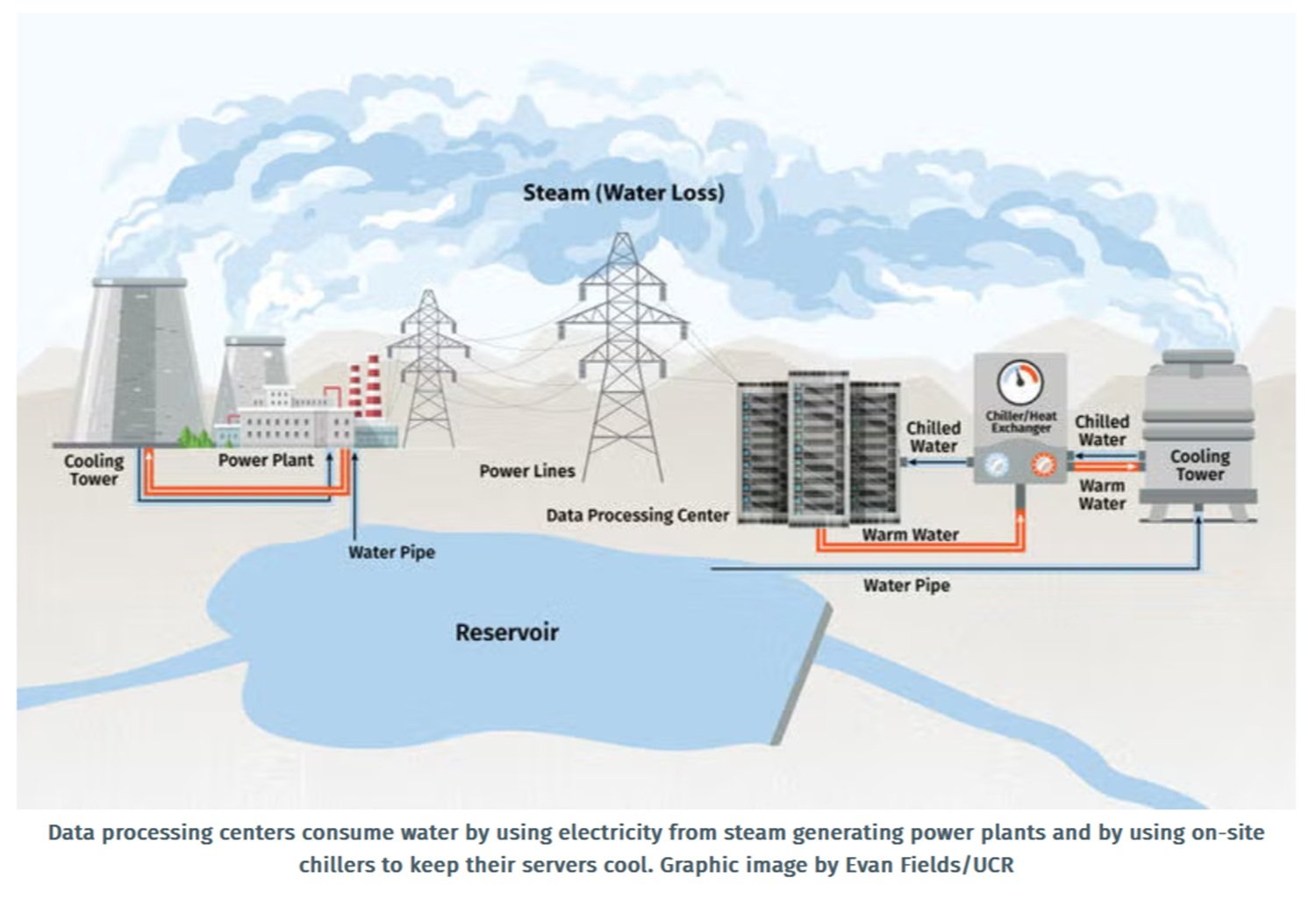

I datacenter consumano acqua principalmente attraverso due meccanismi: quello diretto e quello indiretto. Il consumo diretto avviene quando l'acqua viene utilizzata nei sistemi di raffreddamento evaporativo, dove l'acqua evapora nelle torri di raffreddamento sottraendo calore all'ambiente. È lo stesso principio che ci fa sudare quando abbiamo caldo: l'evaporazione rimuove energia termica. In un datacenter, l'acqua circola attraverso scambiatori di calore, assorbe il calore generato dai server, e poi viene pompata verso torri di raffreddamento dove evapora nell'atmosfera. Il consumo indiretto è più sottile ma altrettanto significativo: riguarda l'acqua utilizzata per produrre l'elettricità che alimenta i datacenter, soprattutto quando proviene da centrali termiche che usano acqua per raffreddare i loro sistemi.

L'industria misura l'efficienza idrica attraverso una metrica chiamata WUE, o Water Usage Effectiveness. Si calcola dividendo il volume totale annuo di acqua consumata (in litri) per l'energia IT utilizzata (in kilowattora). Un WUE di 0,30 litri per kWh, il valore medio raggiunto da Microsoft nel 2024, significa che per ogni kilowattora di energia consumata dai server, 0,30 litri di acqua evaporano. Può sembrare poco, ma quando moltiplichiamo per i gigawatt consumati da un datacenter moderno, i numeri diventano vertiginosi.

La situazione si è aggravata con l'avvento dell'AI. I workload di machine learning sono molto più intensivi dei carichi tradizionali: un'interrogazione a GPT-4 richiede circa 10 volte più potenza di calcolo di una ricerca su Google. Secondo uno studio pubblicato nel 2023 da ricercatori dell'Università della California Riverside e del Texas, addestrare GPT-3 ha consumato circa 700.000 litri d'acqua, l'equivalente di quanto necessario per produrre 320 automobili Tesla. E quello era GPT-3: i modelli successivi sono ordini di grandezza più grandi e assetati.

Il problema è che non tutti i datacenter sono uguali. La quantità d'acqua che consumano dipende da fattori variabili: il clima locale, l'efficienza delle infrastrutture, il tipo di carichi di lavoro. Un datacenter in Arizona, dove le temperature estive superano i 40 gradi, consumerà molta più acqua di uno in Finlandia, dove l'aria fredda può essere sfruttata per raffreddamento naturale buona parte dell'anno. Questa variabilità rende difficile fare stime precise, ma rende anche evidente che la geografia conta: costruire un datacenter nel deserto ha un costo idrico molto diverso da costruirlo vicino al Circolo Polare Artico.

I numeri del presente

Quanto beve l'intelligenza artificiale, esattamente? La Commissione Europea stima che nel 2024 i datacenter europei abbiano consumato circa 70 terawattora di elettricità. L'International Energy Agency proietta che questa cifra crescerà fino a 115 terawattora entro il 2030, con l'AI come principale driver di crescita. A livello globale, la IEA calcola che i datacenter siano responsabili di circa 415 terawattora all'anno, pari all'1,5% del consumo elettrico mondiale, un numero destinato a raddoppiare verso 945 terawattora entro la fine del decennio.

Ma l'elettricità è solo metà della storia. Google ha rivelato che nel 2024 i suoi datacenter hanno consumato complessivamente circa 6,6 miliardi di galloni d'acqua (25,1 miliardi di litri), con un consumo netto di 5,2 miliardi di galloni dopo aver sottratto l'acqua scaricata. Il datacenter più assetato dell'azienda si trova a Council Bluffs, Iowa, dove nel 2024 sono stati consumati 1 miliardo di galloni, abbastanza per rifornire tutti i residenti dell'Iowa per cinque giorni. Al contrario, il datacenter di Pflugerville, Texas, ha consumato solo 10.000 galloni, dimostrando quanto le scelte tecnologiche e climatiche possano fare la differenza.

Meta ha comunicato che i suoi datacenter hanno consumato 663 milioni di galloni d'acqua (2,5 miliardi di litri) nel 2023, con il 95% del consumo totale dell'azienda concentrato proprio nelle infrastrutture digitali. Microsoft, che gestisce circa 300 datacenter globalmente, ha registrato un consumo medio di circa 33 milioni di galloni per datacenter all'anno prima delle recenti ottimizzazioni.

Questi numeri, impressionanti in valore assoluto, diventano ancora più significativi quando li confrontiamo con il consumo locale. A The Dalles, Oregon, dove Google gestisce uno dei suoi datacenter più grandi, l'azienda consuma il 29% dell'intera fornitura idrica cittadina. Nel 2021, il datacenter ha utilizzato 355 milioni di galloni, un consumo triplicato rispetto al 2017 quando si fermava a 124 milioni. La città, situata lungo il Columbia River ma in una regione meteorologicamente arida, ha dovuto affrontare una battaglia legale di 13 mesi prima che questi dati venissero resi pubblici: Google e il comune sostenevano che fossero "segreti commerciali". Solo dopo l'intervento del distretto giudiziario e la pressione del Reporters Committee for Freedom of the Press, i numeri sono stati divulgati.

Geografia del conflitto: dove l'acqua incontra i chip

La tensione tra sviluppo tecnologico e risorse idriche non è un problema astratto: si manifesta in conflitti tangibili, con nomi e coordinate geografiche precise. The Dalles rappresenta un caso emblematico, ma non è isolato. In tutto il mondo occidentale, comunità locali si trovano a dover negoziare tra promesse economiche e sostenibilità ambientale.

A Newton County, in Georgia, Meta ha costruito un datacenter che consuma circa il 10% dell'acqua dell'intera contea. In Aragona, Spagna, Amazon ha richiesto un aumento del 48% nel proprio consumo idrico per espandere le sue strutture, portando il totale a oltre 500 milioni di litri all'anno in una regione già colpita da siccità ricorrenti. Le autorità locali hanno dovuto bilanciare i 1.200 posti di lavoro promessi con le proteste di agricoltori e ambientalisti.

Il Texas rappresenta forse il campo di battaglia più intenso. L'Houston Advanced Research Center ha stimato che tra il 2025 e il 2030 i datacenter dello stato consumeranno tra 49 e 399 miliardi di galloni d'acqua, una forbice enorme che riflette l'incertezza sullo sviluppo dell'AI. Microsoft sta costruendo un impianto a Goodyear, Arizona, che ha scatenato critiche feroci: in una regione che affronta una "megadrought" ventennale, secondo il Professor Christopher Castro dell'Università dell'Arizona, un singolo datacenter che consuma 1,75 milioni di galloni al giorno appare a molti come un'assurdità ecologica.

La questione non riguarda solo la quantità assoluta, ma anche la competizione per risorse scarse. Uno studio del Virginia Tech ha rivelato che un quinto dei datacenter americani attinge da bacini idrici già sotto stress, classificati come moderatamente o altamente stressati. In questi contesti, ogni gallone utilizzato per raffreddare chip è un gallone sottratto all'agricoltura, agli ecosistemi fluviali, al consumo domestico. Il Dog River, che rifornisce The Dalles, ospita specie ittiche in via di estinzione: il raddoppio del consumo cittadino tra 2002 e 2021, dovuto principalmente a Google, ha messo questi ecosistemi a rischio concreto.

La dinamica ricorda, per certi versi, le tensioni attorno all'estrazione di litio in Sudamerica: tecnologie che promettono un futuro più sostenibile (veicoli elettrici lì, efficienza computazionale qui) che però estraggono il loro prezzo da comunità locali e ambienti fragili. Non è un caso che a The Dalles alcuni residenti abbiano cominciato a chiamare Google "vampiro d'acqua", come riportato da IT Pro.

Soluzioni terrestri: dall'aria al liquido

Di fronte alla crescita esponenziale della domanda, l'industria dei datacenter sta esplorando soluzioni che vanno dall'ottimizzazione incrementale alla rivoluzione radicale. Le strategie si possono classificare lungo uno spettro che va dall'evolutivo al dirompente.

L'approccio più conservativo è il miglioramento dei sistemi esistenti. Microsoft ha annunciato nel 2024 di aver ridotto il suo WUE del 39% rispetto al 2021, raggiungendo 0,30 litri per kilowattora attraverso audit operativi che hanno eliminato il 90% delle istanze di spreco idrico e l'espansione dell'uso di acqua riciclata o recuperata in Texas, Washington, California e Singapore. Google ha ottimizzato i suoi sistemi di raffreddamento evaporativo al punto che il datacenter di Pflugerville, Texas, consuma solo 10.000 galloni annui, un risultato ottenuto sfruttando il clima locale e tecnologie avanzate di gestione termica.

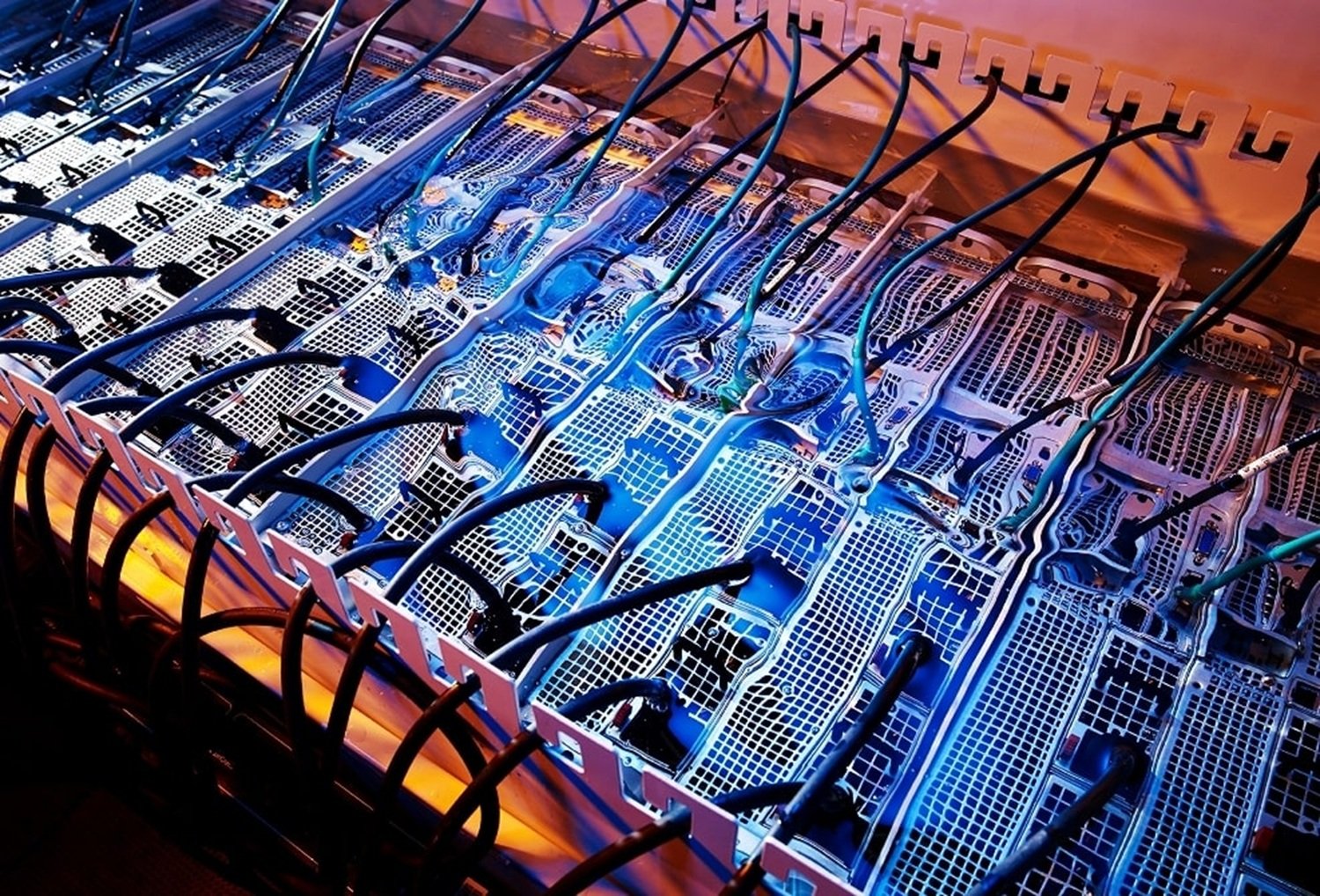

Ma l'innovazione più significativa riguarda il passaggio al raffreddamento liquido diretto. A differenza dei sistemi evaporativi tradizionali, il liquid cooling porta il refrigerante a contatto diretto con i componenti che generano calore, eliminando o riducendo drasticamente l'evaporazione. Esistono diverse varianti di questa tecnologia: il direct-to-chip liquid cooling, dove tubi sottili trasportano liquido refrigerante direttamente sui processori; il rear-door heat exchanger, dove scambiatori di calore sono montati sul retro dei rack; e l'immersion cooling, dove interi server vengono immersi in fluidi dielettrici non conduttivi.

Microsoft ha annunciato ad agosto 2024 che tutti i suoi nuovi datacenter utilizzeranno design a "zero evaporazione d'acqua per il raffreddamento". Il sistema ricicla l'acqua in un circuito chiuso: il liquido assorbe calore dai chip, viene raffreddato da chiller, e ritorna in circolo senza mai evaporare. Questa tecnologia, che sarà pilotata a Phoenix e Mt. Pleasant nel Wisconsin a partire dal 2026, dovrebbe evitare l'evaporazione di oltre 125 milioni di litri all'anno per datacenter. I siti progettati con questo sistema entreranno in funzione dalla fine del 2027.

L'immersion cooling rappresenta il limite estremo di questo approccio. I server vengono letteralmente immersi in vasche piene di olio dielettrico, fluidi sintetici che non conducono elettricità ma trasferiscono calore in modo estremamente efficiente. Intel ha condotto esperimenti con 24 server Xeon immersi in olio sintetico nel suo laboratorio di Hillsboro, Oregon. Google ha testato immersion cooling per i suoi chip TPU v5p. Il mercato globale dell'immersion cooling, valutato 426,56 milioni di dollari nel 2024, dovrebbe raggiungere 2,9 miliardi entro il 2033, con una crescita annua del 23,81%.

Il liquid cooling complessivo, includendo tutte le varianti, mostra numeri ancora più impressionanti. Secondo Verified Market Research, il mercato è passato da 5,65 miliardi di dollari nel 2024 a una proiezione di 48,42 miliardi entro il 2034, con un tasso di crescita annuale del 23,96%. NVIDIA ha specificato che i suoi chip GB200 di nuova generazione richiederanno raffreddamento liquido direct-to-chip, sancendo di fatto la transizione come inevitabile per i carichi AI di prossima generazione.

Ma il liquid cooling porta con sé sfide proprie. L'investimento iniziale può superare i 50.000 dollari per rack, circa il triplo di un sistema ad aria equivalente. Mancano ancora standard uniformi: ASHRAE e TIA hanno rilasciato linee guida, ma i formati dei connettori, i protocolli dei sensori e le chimiche dei refrigeranti variano tra fornitori, rischiando di creare ecosistemi proprietari che ostacolano aggiornamenti futuri. L'installazione in datacenter esistenti richiede ristrutturazioni complesse, canaline, supporti strutturali rinforzati, sistemi di rilevamento perdite, che spesso rendono più pratico costruire da zero.

Visioni estreme: dall'oceano all'orbita

Quando le soluzioni convenzionali sembrano insufficienti, la tecnologia tende a esplorare frontiere più radicali. Nel caso dei datacenter, questo ha significato guardare oltre i confini terrestri tradizionali: sott'acqua e nello spazio.

Il Project Natick di Microsoft, lanciato nel 2018, rappresenta probabilmente l'esperimento più noto di datacenter sottomarino. L'idea aveva una logica affascinante: immergere un container cilindrico con 864 server a 36 metri di profondità al largo delle isole Orkney, in Scozia, sfruttando l'acqua marina fredda come refrigerante naturale infinito. Il progetto ha dimostrato che i server subacquei possono essere più affidabili di quelli terrestri, i tassi di guasto erano un ottavo rispetto agli impianti convenzionali, probabilmente perché l'ambiente ermetico, privo di ossigeno e umidità, riduce corrosione e sbalzi termici.

Tuttavia, Project Natick è stato ufficialmente chiuso nel 2024. Le ragioni sono complesse: l'accessibilità per manutenzione era problematica, i costi di installazione e recupero proibitivi per deployment su larga scala, e le incertezze regolatorie sullo sfruttamento degli spazi oceanici hanno reso il modello poco scalabile. Microsoft ha dichiarato di aver appreso lezioni preziose sulla dissipazione termica e sulla durabilità hardware, ma ha deciso di concentrare gli sforzi sul liquid cooling convenzionale anziché perseguire infrastrutture subacquee.

Se l'oceano si è rivelato più complicato del previsto, lo spazio sta emergendo come frontiera genuinamente attiva. A novembre 2024, China Telecom ha lanciato Starcloud-1, il primo satellite datacenter commerciale equipaggiato con GPU NVIDIA H100, progettato per eseguire workload AI in orbita terrestre bassa. L'idea è sfruttare il vuoto spaziale come dissipatore termico perfetto: il calore viene irradiato direttamente nello spazio attraverso radiatori, senza necessità di acqua o aria.

Google sta sviluppando Project Suncatcher, previsto per il 2027, che mira a combinare pannelli solari orbitali con capacità di calcolo, eliminando completamente la dipendenza da reti elettriche terrestri. Diverse startup, tra cui Lumen Orbit e Orbital Assembly, stanno progettando datacenter spaziali commerciali che potrebbero entrare in orbita entro il 2030.

Ma anche qui, la realtà fisica impone limiti severi. Un paper intitolato "Dirty Bits in Low-Earth Orbit" ha evidenziato problemi critici: i costi di lancio rimangono proibitivi (circa 10.000 dollari per chilogrammo in orbita bassa, anche con SpaceX); le radiazioni cosmiche danneggiano i componenti elettronici molto più rapidamente che sulla Terra; la manutenzione è praticamente impossibile una volta in orbita; e la latenza nelle comunicazioni con la superficie, anche se minima, è comunque superiore a quella di datacenter terrestri connessi via fibra ottica.

Per quanto affascinanti, queste soluzioni estreme evidenziano soprattutto quanto sia difficile il problema centrale: gestire enormi quantità di calore in modo sostenibile. Il fatto che si consideri seriamente di mandare server nello spazio dice molto sulla pressione che l'industria sta affrontando.

Domande aperte: il futuro incerto

Dopo aver mappato il presente e intravisto possibili futuri, rimaniamo con interrogativi che non ammettono risposte facili. Il primo riguarda la trasparenza. Nonostante i progressi nella divulgazione, Google e Microsoft ora pubblicano dati facility-level, Meta fornisce reportistica dettagliata, molte aziende continuano a considerare il consumo idrico informazione proprietaria. Amazon Web Services, il più grande provider cloud mondiale, fornisce dati aggregati minimi. La Commissione Europea ha introdotto obblighi di monitoraggio e reporting per datacenter con consumo significativo, ma l'attuazione rimane frammentaria. Senza trasparenza completa, è impossibile per comunità locali, regolatori e cittadini valutare realmente l'impatto e prendere decisioni informate.

Il secondo interrogativo riguarda i trade-off tra obiettivi ambientali. Il raffreddamento liquido riduce drasticamente il consumo idrico, ma può aumentare leggermente il consumo elettrico, nel caso di Microsoft, l'incremento è definito "nominale", ma i dettagli quantitativi restano vaghi. Se quell'elettricità proviene da fonti fossili, stiamo semplicemente spostando il problema dall'acqua all'atmosfera? Inoltre, i fluidi dielettrici usati nell'immersion cooling sollevano preoccupazioni: alcuni contengono PFAS (sostanze perfluoroalchiliche), i cosiddetti "forever chemicals" che persistono nell'ambiente per secoli. L'industria sta sviluppando alternative vegetali, ma la transizione è lenta.

Terzo: la questione della governance locale. Chi decide se un datacenter può essere costruito in una regione già in stress idrico? The Dalles ha concesso a Google sgravi fiscali per 260 milioni di dollari e accesso privilegiato all'acqua in cambio di investimenti e posti di lavoro. Ma i residenti lamentano che le decisioni sono state prese senza consultazione adeguata, con accordi di non divulgazione che hanno impedito il dibattito pubblico. Come bilanciare sviluppo economico e protezione delle risorse comuni? Le strutture di governance esistenti sembrano inadeguate per gestire infrastrutture globali con impatti locali così intensi.

Quarto: la scalabilità delle soluzioni. Anche supponendo che il liquid cooling diventi standard universale entro il 2030, eliminerà il problema? Le proiezioni IEA indicano che la domanda di capacità computazionale continuerà a crescere esponenzialmente, non solo per AI, ma per IoT, 5G, realtà aumentata, calcolo quantistico. Ogni nuova tecnologia promette di essere "più efficiente", ma il volume assoluto di calcolo cresce più velocemente dell'efficienza. È il paradosso di Jevons applicato all'era digitale: aumentare l'efficienza energetica spesso porta a maggior consumo totale, perché rende il calcolo più economico e quindi più utilizzato.

Infine, c'è la questione etica più profonda. Quanto vale una query a ChatGPT? Quanto vale un video generato da Sora? Se produrre un'immagine con Midjourney consuma l'equivalente idrico di una doccia breve, come dovremmo pensare al nostro uso quotidiano di questi strumenti? Non proponiamo risposte moralistiche, la tecnologia non è né buona né cattiva intrinsecamente, ma la consapevolezza del costo materiale dovrebbe informare le nostre scelte, sia come individui che come società.

L'intelligenza artificiale ci ha abituati a pensare in termini di astrazioni: modelli, parametri, token, latenza. Ma sotto quelle astrazioni pulsa una realtà fisica fatta di acqua che evapora, elettricità che scorre, silicio che si riscalda. The Dalles, con le sue torri di raffreddamento che sbuffano vapore lungo il Columbia River, è tanto parte dell'infrastruttura dell'AI quanto gli algoritmi di OpenAI o i chip di NVIDIA. Forse è il momento di smettere di pensare al cloud come a qualcosa di etereo, e iniziare a vederlo per quello che è: una rete materiale con conseguenze materiali, che beve, suda e assetata continua a crescere.