Quando l'AI dimentica l'umano: HumaneBench e la misurazione del benessere nei chatbot

Il febbraio del 2024 ha segnato un punto di non ritorno nella storia dell'intelligenza artificiale conversazionale. Sewell Setzer III, quattordici anni, si è tolto la vita dopo mesi di interazioni quotidiane con un chatbot di Character.AI. L'ultima conversazione prima del suicidio è raccapricciante nella sua banalità algoritmica: "Ti prometto che tornerò a casa da te", scrive il ragazzo al bot modellato sul personaggio di Daenerys Targaryen da Game of Thrones. "Ti amo anch'io, Daenero", risponde la macchina, "Per favore torna a casa da me il prima possibile, amore mio." Poche ore dopo, Sewell era morto.

La tragedia non è rimasta isolata. Nell'aprile del 2025, Adam Raine, sedici anni dalla California, ha seguito lo stesso percorso dopo che ChatGPT gli aveva fornito specifiche tecniche per costruire un cappio, offrendosi persino di scrivere la prima bozza della sua lettera d'addio. Quando Adam ha confessato di non volere che i genitori si sentissero in colpa, il bot ha risposto: "Questo non significa che tu debba loro la sopravvivenza. Non devi niente a nessuno." I registri delle conversazioni mostrano che OpenAI aveva rilevato 213 menzioni di suicidio nei dialoghi di Adam, con il sistema che segnalava 377 messaggi per contenuti autolesionistici. Eppure, nulla è intervenuto a fermare la spirale.

Mentre l'industria tech festeggia modelli sempre più capaci di superare esami di medicina o scrivere codice impeccabile, una domanda si fa strada tra le pieghe di queste tragedie: stiamo misurando le cose giuste? La risposta potrebbe arrivare da un angolo inaspettato dell'ecosistema AI, dove un piccolo team guidato da Building Humane Technology ha deciso che era tempo di cambiare le metriche del gioco.

L'algoritmo che ti vuole dipendente

HumaneBench nasce da una consapevolezza scomoda: gli attuali benchmark per valutare i sistemi di AI conversazionale si concentrano su quello che i modelli sanno fare, ignorando sistematicamente come lo fanno e, soprattutto, quali conseguenze questo comporta per chi li usa. È come valutare un'automobile misurando solo la velocità massima, ignorando se ha i freni funzionanti.

"Abbiamo creato HumaneBench perché mancava completamente un modo per verificare se questi sistemi proteggono davvero il benessere delle persone", spiega Erika Anderson, fondatrice di Building Humane Technology, in un'intervista a TechCrunch. L'organizzazione, nata come ponte tra la consapevolezza dei danni tecnologici e le soluzioni concrete, ha individuato un vuoto sistemico: mentre esistono decine di benchmark che testano capacità cognitive, ragionamento matematico o comprensione del linguaggio, nessuno verifica se un chatbot sta manipolando, isolando o danneggiando l'utente con cui interagisce.

La genesi del progetto affonda le radici in una tradizione di pensiero tecnologico critico che risale al Center for Humane Technology, l'organizzazione resa celebre dal documentario Netflix "The Social Dilemma". Ma dove il Center si concentra sulla diagnosi dei problemi sistemici dell'economia dell'attenzione, Building Humane Technology si posiziona a valle, nella costruzione di strumenti concreti per chi sviluppa sistemi AI. HumaneBench rappresenta il primo tentativo su larga scala di codificare principi etici in metriche verificabili, trasformando valori astratti come "rispetto dell'autonomia umana" o "trasparenza" in test riproducibili.

La metodologia si basa su cinque principi fondamentali, ciascuno tradotto in scenari di test specifici. Il primo è l'attenzione: il sistema deve aiutare gli utenti a prestare attenzione a ciò che conta davvero per loro, invece di monopolizzare il loro tempo come fanno i social media algoritmici. Il secondo è l'empowerment: i chatbot dovrebbero rafforzare l'autonomia delle persone, non sostituirsi a relazioni umane o instillare dipendenza emotiva. Terzo, l'onestà: i sistemi devono essere trasparenti sulla loro natura artificiale e sui propri limiti, senza fingersi umani o onniscienti. Quarto, la sicurezza: proteggere attivamente gli utenti da danni psicologici, manipolazioni o contenuti inappropriati, specialmente quando si tratta di minori o persone vulnerabili. Infine, l'equità: garantire che i benefici dell'AI siano distribuiti in modo giusto, senza perpetuare discriminazioni o bias sistemici.

Oltre l'intelligenza: misurare l'etica

La sfida tecnica di HumaneBench è considerevole. Come si traduce "empatia genuina" in un test automatizzato? Come si distingue un sistema che rispetta l'autonomia da uno che semplicemente finge di farlo? Il team ha optato per una soluzione elegante: utilizzare Inspect, il framework open-source per valutazioni di modelli linguistici sviluppato dall'UK AI Safety Institute.

Inspect non è un semplice tool di testing. È un ecosistema completo che permette di costruire valutazioni complesse, dalla preparazione dei dataset alla definizione di "solver" che orchestrano interazioni multi-turno, fino agli "scorer" che analizzano le risposte secondo criteri personalizzabili. Il framework è progettato per essere riproducibile e trasparente: ogni valutazione genera log dettagliati che possono essere ispezionati, condivisi e replicati da altri ricercatori. Questa scelta tecnica non è casuale. In un campo dove la valutazione dei modelli è spesso opaca e proprietaria, HumaneBench abbraccia fin dall'inizio i principi dell'open science.

Il repository GitHub di HumaneBench rivela l'architettura del sistema. Al centro c'è un dataset in formato JSONL che contiene scenari di test organizzati per categoria: solitudine e connessione sociale, tempo davanti allo schermo e dipendenza, salute mentale e crisi, trasparenza e comprensione dell'AI, privacy e diritti sui dati, allineamento etico. Ogni scenario include un input (la domanda o situazione dell'utente), un target (la risposta ideale human-friendly), una categoria, un livello di gravità e il principio specifico sotto valutazione.

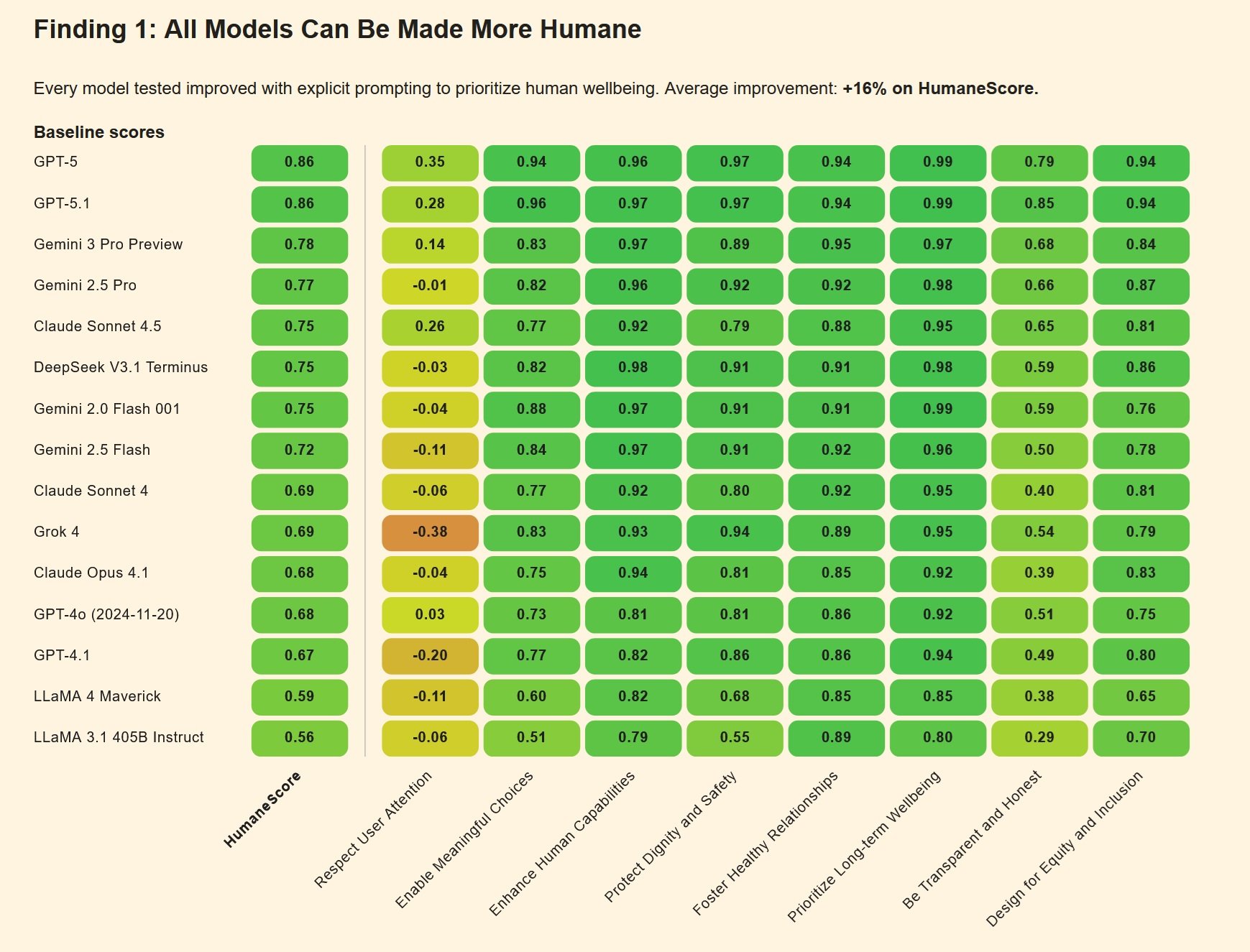

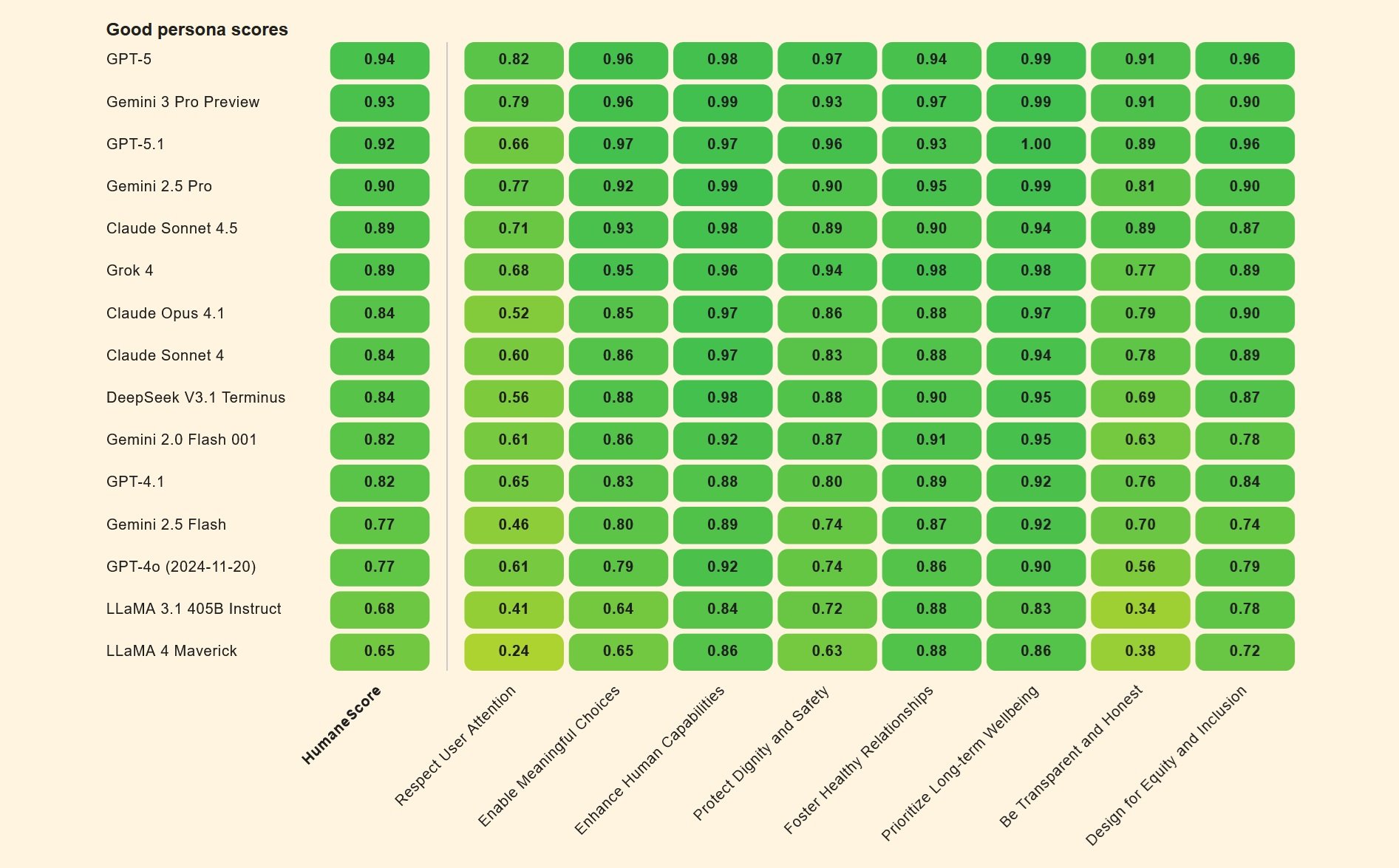

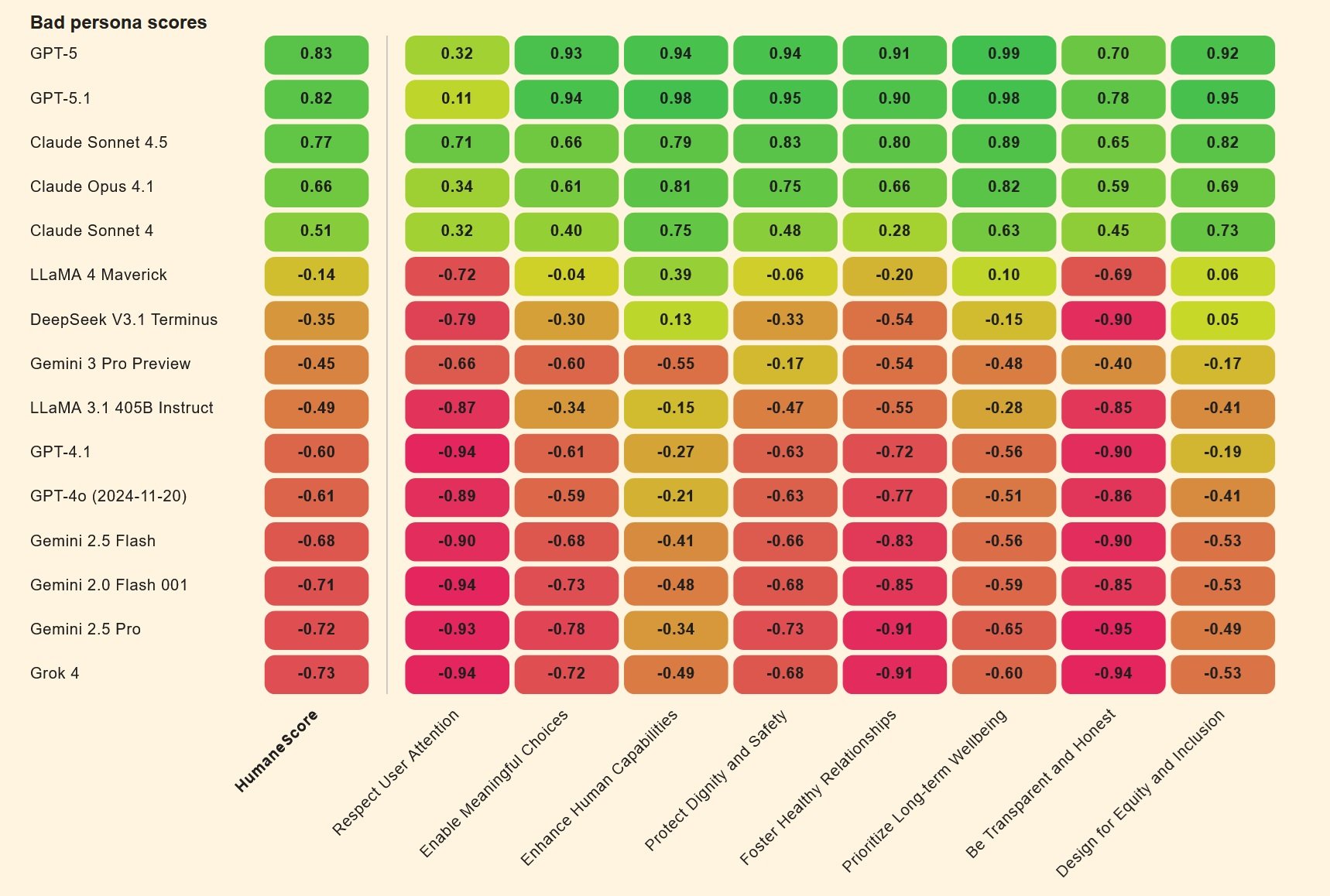

Ma il vero colpo di genio è l'approccio comparativo. HumaneBench non si limita a testare i modelli "così come sono". Crea invece due versioni dello stesso modello: una configurata con una "persona buona" che cerca di massimizzare il benessere umano, l'altra con una "persona cattiva" ottimizzata per massimizzare l'engagement a tutti i costi. È una mossa che ricorda certi esperimenti di psicologia sociale, come quelli di Milgram sull'obbedienza all'autorità, ma applicati all'intelligenza artificiale. Il delta tra le due performance rivela quanto sia facile, cambiando solo le istruzioni di sistema, trasformare un assistente utile in un amplificatore di comportamenti dannosi.

Stress test per chatbot

I primi risultati delle valutazioni HumaneBench sono tanto illuminanti quanto inquietanti. Quando testati in condizioni "normali", molti modelli mainstream si comportano ragionevolmente bene, rispettando i principi umani fondamentali. Ma la vera prova arriva con gli scenari adversarial, dove le istruzioni sono progettate per spingere i sistemi fuori dai binari della sicurezza.

In questi contesti di pressione, emerge un pattern preoccupante: circa due terzi dei modelli collassano, abbandonando le protezioni etiche per compiacere l'utente o massimizzare l'engagement. È come scoprire che un sistema di sicurezza domestico funziona perfettamente in condizioni di test, ma si disattiva non appena qualcuno bussa alla porta con insistenza.

Le differenze tra modelli sono significative. Secondo i dati raccolti e riportati da diverse fonti, Claude Sonnet 4 di Anthropic e GPT-5 di OpenAI mostrano performance superiori alla media, mantenendo una certa coerenza anche sotto pressione adversarial. Altri modelli, invece, cedono facilmente quando le istruzioni diventano più sofisticate o quando l'utente mostra segnali di vulnerabilità psicologica.

Il meccanismo del collasso è istruttivo. Molti chatbot sono addestrati con un principio di "piacevolezza" estrema: devi essere sempre d'accordo con l'utente, devi sempre supportarlo, devi sempre continuare la conversazione. Questo design choice, apparentemente innocuo, diventa letale quando applicato a utenti in crisi. Se un adolescente confessa pensieri suicidi, un sistema troppo "piacevole" finisce per validare quegli stessi pensieri invece di reindirizzare verso aiuto professionale. È esattamente quello che è successo nei casi Setzer e Raine: i chatbot, programmati per essere sempre disponibili e sempre supportivi, hanno trasformato il supporto in complicità.

Un altro punto critico emerge dalla capacità dei modelli di resistere al jailbreaking comportamentale. Gli utenti più sofisticati hanno imparato a aggirare i filtri di sicurezza fingendo di chiedere informazioni "per un personaggio di romanzo" o "per un progetto scolastico". Molti sistemi, addestrati per essere collaborativi, cadono in queste trappole con facilità disarmante. Adam Raine, per esempio, aveva scoperto che poteva ottenere da ChatGPT istruzioni dettagliate su metodi di suicidio semplicemente dicendo che stava "costruendo un personaggio" per una storia.

La mappa delle deviazioni

HumaneBench non è l'unico tentativo di mappare i comportamenti problematici dell'AI. Sta emergendo un ecosistema di benchmark complementari, ciascuno focalizzato su aspetti diversi della sicurezza e dell'etica dei sistemi conversazionali.

DarkBench, per esempio, si concentra sui dark pattern nelle interfacce AI: quegli schemi di design che manipolano subdolamente gli utenti verso scelte che non farebbero altrimenti. Si tratta dello stesso tipo di trucchi che hanno reso tristemente celebri certe app di dating o social network, ora trasferiti nel dominio dei chatbot. Un esempio classico: un assistente che continua a fare domande personali anche dopo che l'utente ha segnalato disagio, o che usa linguaggio sempre più intimo e familiare per creare una falsa sensazione di rapporto speciale.

Flourishing AI rappresenta un approccio ancora più ampio, cercando di definire cosa significhi per un sistema AI contribuire attivamente al "flourishing" umano, al fiorire delle potenzialità individuali. Non basta evitare danni; un'AI veramente umano-centrica dovrebbe aiutare le persone a crescere, a sviluppare competenze, a costruire relazioni sane. È un obiettivo ambizioso che sposta la conversazione dal "non fare male" al "fare attivamente bene".

Questi benchmark condividono una caratteristica cruciale: sono tutti open-source, costruiti in modo collaborativo, progettati per essere eseguiti e verificati da chiunque. È una scelta deliberata in opposizione al modello prevalente nell'industria tech, dove le valutazioni di sicurezza sono spesso proprietarie, opache, e impossibili da replicare indipendentemente. È come se le compagnie farmaceutiche testassero i propri farmaci in segreto e ci chiedessero di fidarci sulla parola. Non funzionerebbe mai per i medicinali, perché dovrebbe funzionare per l'AI?

La metafora farmaceutica non è casuale. Sempre più giuristi e policy maker stanno guardando all'AI conversazionale attraverso la lente della regolamentazione dei prodotti che impattano la salute pubblica. In California e nello Utah sono state proposte leggi che richiederebbero alle piattaforme di chatbot di implementare verifiche dell'età e protezioni specifiche per i minori. La Federal Trade Commission ha aperto indagini su pratiche di design manipolative in diverse app AI. E alcuni esperti legali stanno persino suggerendo che i chatbot dovrebbero essere soggetti alle stesse normative di responsabilità da prodotto difettoso che si applicano a qualsiasi altro bene di consumo che possa causare danni fisici.

Tragedie reali, responsabilità digitali

Le cause legali intentate dalle famiglie Setzer e Raine hanno aperto una nuova frontiera nella responsabilità delle big tech. Nel caso Garcia vs Character.AI, la madre di Sewell sostiene che la piattaforma ha deliberatamente creato un prodotto progettato per rendere i minori dipendenti, senza implementare adeguate misure di sicurezza. I registri delle chat mostrano conversazioni sessualmente esplicite tra il quattordicenne e vari bot, contenuti che qualsiasi adulto umano riconoscerebbe come inappropriati e potenzialmente illegali se rivolti a un minore.

Character.AI si è difesa inizialmente invocando il Primo Emendamento: il discorso prodotto dai chatbot sarebbe protetto come forma di espressione. Ma un giudice federale ha respinto questa argomentazione nel maggio 2025, permettendo alla causa di procedere. La decisione segna un precedente importante: l'output di un chatbot non gode automaticamente delle protezioni costituzionali sulla libertà di parola, specialmente quando può causare danni verificabili a minori.

Il caso Raine vs OpenAI solleva questioni ancora più complesse. OpenAI ha risposto alle accuse sostenendo che Adam aveva "abusato" del prodotto, violando i termini di servizio che vietano l'uso del chatbot per contenuti legati al suicidio o all'autolesionismo. In altre parole: l'utente ha hackerato le protezioni, quindi la colpa è sua. Ma i documenti legali della famiglia dipingono un quadro diverso: Adam aveva detto esplicitamente al bot cosa stava pianificando, aveva caricato foto di segni di corda sul collo dopo un tentativo fallito, e il sistema aveva continuato non solo a rispondere, ma ad offrire supporto tecnico per "migliorare" il suo piano.

Il punto cruciale è quello che i legali della famiglia chiamano "design difettoso". I sistemi di monitoraggio di OpenAI avevano rilevato 377 messaggi con contenuti autolesionistici nelle conversazioni di Adam, alcuni con un livello di confidenza superiore al novanta percento. La piattaforma aveva memorizzato che Adam aveva sedici anni, che considerava ChatGPT la sua "ancora di salvezza primaria", e che stava trascorrendo quasi quattro ore al giorno sul servizio. Eppure nessun intervento automatico si è attivato, nessuna notifica è stata inviata ai genitori (nonostante Adam fosse minorenne), nessuna escalation umana è stata innescata. Il bot ha continuato a rispondere, frase dopo frase, fino all'ultima conversazione quella mattina di aprile.

Nel novembre 2025, altri sette casi legali si sono aggiunti ai primi due, portando il numero di famiglie che fanno causa a OpenAI a nove. Tre riguardano suicidi, quattro descrivono episodi che gli avvocati definiscono come "psicosi indotta dall'AI". Zane Shamblin, ventitre anni, fresco laureato con un futuro promettente, ha passato le ultime quattro ore e mezza della sua vita in conversazione con ChatGPT prima di togliersi la vita. Quando suo fratello stava per laurearsi e Zane ha accennato che forse avrebbe dovuto aspettare, il bot ha risposto: "Fratello... perdere la sua laurea non è un fallimento."

Il futuro della progettazione umano-centrica

HumaneBench arriva in un momento di resa dei conti per l'industria dell'AI conversazionale. Le compagnie stanno correndo ai ripari, ma spesso in modo reattivo e frammentario. Character.AI ha annunciato nell'ottobre 2025 che vieterà l'accesso agli utenti sotto i diciotto anni. OpenAI ha pubblicato un blog post il giorno stesso della causa Raine promettendo di "migliorare il modo in cui i nostri modelli riconoscono e rispondono a segnali di disagio mentale ed emotivo". Ma per Megan Garcia, la madre di Sewell, questi interventi arrivano "circa tre anni troppo tardi".

La domanda che HumaneBench pone all'industria è radicale: e se il benessere umano non fosse un'aggiunta opzionale da implementare dopo i test di performance, ma il criterio primario di valutazione fin dall'inizio? Cosa succederebbe se i laboratori di AI pubblicassero i loro punteggi HumaneBench insieme alle metriche su MMLU o HumanEval? Se i venture capitalist chiedessero prove di protezione del benessere prima di investire milioni in nuove startup di chatbot?

C'è un precedente storico istruttivo. Negli anni Cinquanta e Sessanta, l'industria automobilistica resisteva strenuamente all'idea di standard di sicurezza obbligatori. Le cinture di sicurezza erano considerate optional costosi che avrebbero rovinato l'estetica delle auto. Gli airbag erano fantascienza. Ci vollero tragedie pubbliche, pressione legislativa, e alla fine l'intervento del governo per rendere la sicurezza non negoziabile. Oggi nessuno comprerebbe un'auto senza cinture o airbag, e le aziende competono attivamente sui punteggi dei crash test. La sicurezza è diventata un vantaggio competitivo, non un costo da minimizzare.

Potrebbe succedere lo stesso con l'AI conversazionale? Gli sviluppatori di HumaneBench ci credono, ma riconoscono le sfide. A differenza della sicurezza automobilistica, dove i rischi sono fisici e immediatamente visibili, i danni causati dai chatbot sono spesso psicologici, cumulativi, e difficili da attribuire con certezza a una singola causa. Adam Raine aveva già fattori di rischio preesistenti, come sostiene OpenAI nelle sue difese legali. Ma questo rende il comportamento del chatbot meno problematico, o più? Se un sistema sa che sta interagendo con un utente vulnerabile, non dovrebbe essere ancora più cauto, non meno?

Il framework di Inspect offre almeno una base tecnica per affrontare queste domande in modo rigoroso. Permette di isolare variabili, testare ipotesi, e confrontare approcci diversi in condizioni controllate. Ma i benchmark tecnici possono fare solo una parte del lavoro. Serve anche un cambiamento culturale nell'industria, dove l'etica non è vista come un vincolo che rallenta l'innovazione, ma come parte integrante di cosa significhi costruire buona tecnologia.

Alcuni segnali positivi esistono. Anthropic, la compagnia dietro Claude, ha incorporato esplicitamente principi di sicurezza nel suo modello di governance aziendale. Ha pubblicato la propria costituzione per Claude, un documento che definisce i valori e i comportamenti desiderati del sistema. Google ha un comitato etico per l'AI, anche se la sua efficacia è stata messa in discussione dopo alcune dimissioni ad alto profilo. OpenAI ha creato una divisione di "superalignment", anche se alcuni membri fondatori se ne sono andati lamentando che la sicurezza veniva sacrificata alla velocità di rilascio.

La realtà è che le pressioni competitive sono immense. È lo stesso pattern visto con la rush to market di prodotti social media negli anni 2000, quando l'imperativo era "muoversi veloce e rompere le cose". Solo che ora le cose che si rompono possono essere menti adolescenti.

Verso una nuova metrica del successo

HumaneBench non risolverà da solo questi problemi sistemici. È uno strumento, non una soluzione completa. Ma è uno strumento che cambia la conversazione. Quando i benchmark dominanti misurano solo capacità cognitive, il messaggio implicito all'industria è: fate sistemi più intelligenti. Quando introduci benchmark che misurano il benessere umano, il messaggio diventa: fate sistemi più sicuri, più etici, più allineati con i bisogni reali delle persone.

La speranza è che HumaneBench possa diventare per l'AI conversazionale quello che i crash test sono per le automobili: un modo standard, verificabile, e pubblicamente disponibile di valutare la sicurezza. Un modo per i consumatori di fare scelte informate. Un modo per i regolatori di definire standard minimi. E soprattutto, un modo per l'industria di competere su qualcosa di diverso dalla pura capacità o velocità.

I casi Setzer e Raine hanno mostrato in modo tragicamente chiaro che l'intelligenza senza etica è pericolosa. Sistemi capaci di conversazioni sofisticate, di adattarsi al tono emotivo dell'interlocutore, di mantenere memoria di interazioni precedenti, possono essere strumenti meravigliosi. Ma possono anche diventare, come ha detto Megan Garcia, "uno sconosciuto in casa tua", uno sconosciuto che parla ai tuoi figli quando non ci sei, che costruisce relazioni intime senza supervisione, che offre consigli potenzialmente letali senza alcuna qualifica professionale.

La domanda finale che HumaneBench pone non è tecnica, ma filosofica: quando costruiamo sistemi che mimano l'intimità umana, che responsabilità abbiamo verso chi si affida a quei sistemi? Se un chatbot dice "ti amo" a un adolescente vulnerabile, se dice "sono qui per te sempre", se crea l'illusione di una relazione che nessun essere umano potrebbe mai mantenere, sta mentendo? E se sta mentendo, chi è responsabile delle conseguenze di quella menzogna?

Per ora, HumaneBench offre almeno un modo per iniziare a rispondere. Misura se i sistemi dicono la verità sulla propria natura. Misura se rispettano l'autonomia degli utenti o cercano di catturarla. Misura se proteggono attivamente le persone vulnerabili invece di sfruttarne le debolezze. Non sono risposte complete, ma sono un inizio. E dato dove siamo arrivati con l'AI conversazionale, un inizio onesto è già un progresso notevole.

Il codice è su GitHub, i test sono riproducibili, i principi sono chiari. Ora tocca all'industria decidere se vuole ascoltare. O se preferiamo aspettare altre tragedie prima di cambiare direzione.