LongCat-Video, il Gigante silenzioso della Generazione video OpenSource

Meituan rilascia un modello da 13,6 miliardi di parametri che genera video fino a cinque minuti. Nel caos dell'AI video, arriva una soluzione tecnica elegante che sfida i colossi proprietari con efficienza e trasparenza. Mentre il mondo tecnologico era impegnato a digerire le controversie sul copyright di Sora 2 e a misurarsi con le limitazioni d'accesso di Veo 3, a fine ottobre 2025 il team LongCat di Meituan ha rilasciato LongCat-Video con la discrezione di chi sa di avere qualcosa di solido tra le mani ma non sente il bisogno di urlarlo.

Niente keynote spettacolari, niente demo preparate in laboratorio con cherry-picking sospetto, solo un repository GitHub, i pesi del modello su Hugging Face, e un paper tecnico dettagliato su arXiv. Come dire: ecco il codice, ecco il modello, fate voi.

E il modello, a guardarlo bene, è tutt'altro che modesto. Con 13,6 miliardi di parametri e la capacità di generare video fino a cinque minuti mantenendo coerenza temporale e qualità visiva, LongCat-Video affronta uno dei problemi più ostinati dell'AI video generativa: come evitare che un video lungo si trasformi in una deriva psichedelica di artefatti, color drift e inconsistenze narrative. È il tipo di problema che sembra banale finché non ci sbatti contro, come realizzare che scrivere un racconto lungo è più difficile che concatenare paragrafi brevi.

Il problema che nessuno aveva davvero risolto

Il panorama della generazione video AI nel 2025 assomiglia a una corsa agli armamenti dove tutti puntano sulla stessa metrica: quanto fotorealistico riesci a fare un clip di cinque secondi? Sora, Veo, Movie Gen hanno alzato l'asticella della qualità visiva a livelli impressionanti, ma restano vincolati a durate brevi o comunque limitate. Quando OpenAI ha annunciato Sora 2 con i suoi venti secondi di generazione massima, sembrava un traguardo. Ma venti secondi, in termini di storytelling visivo, sono poco più di un'inquadratura d'apertura. Non racconti molto in venti secondi, al massimo evochi.

Il mondo opensource, dal canto suo, si dibatte tra progetti ambiziosi ma risorse limitate. HunyuanVideo di Tencent arriva a dieci secondi con risultati solidi, Mochi si concentra sull'animazione di immagini statiche, Open-Sora fatica a replicare l'originale proprietario. Tutti condividono lo stesso limite: oltre una certa durata, la coerenza temporale collassa come un soufflé mal cotto. I frame iniziano a deviare nei colori, gli oggetti si moltiplicano o scompaiono, i movimenti perdono continuità fisica. È il fenomeno che i ricercatori chiamano "temporal drift" e che agli utenti appare semplicemente come video che sembrano generati da un'intelligenza artificiale sotto l'effetto di sostanze psicoattive.

LongCat-Video attacca questo problema da una prospettiva diversa. Invece di puntare tutto sulla perfezione fotorealistica di clip brevissime, il team di Meituan ha progettato un'architettura che privilegia la coerenza temporale estesa. L'idea è semplice quanto potente: se addestri un modello esplicitamente sulla capacità di continuare video esistenti, ovvero di generare frame successivi che mantengano consistenza con quelli precedenti, quel modello impara implicitamente a gestire dipendenze temporali lunghe. È un po' come la differenza tra uno sprinter e un maratoneta: il primo esplode sui cento metri, il secondo distribuisce lo sforzo su distanze che farebbero collassare lo sprinter.

Meituan non è un nome che suona familiare a chi non segue il mercato tech cinese, ma parliamo di una delle più grandi piattaforme di servizi locali della Cina, con competenze profonde in machine learning applicato a problemi di scala industriale. Il team LongCat ha lavorato su questo progetto concentrandosi su un obiettivo ingegneristicamente elegante: creare un modello unificato capace di gestire tre task diversi, text-to-video, image-to-video e video continuation, senza architetture separate o pipeline complicate. Un po' come progettare un motore che funziona bene sia con benzina che con diesel che in elettrico, invece di avere tre motori diversi.

Un'architettura pensata per la durata

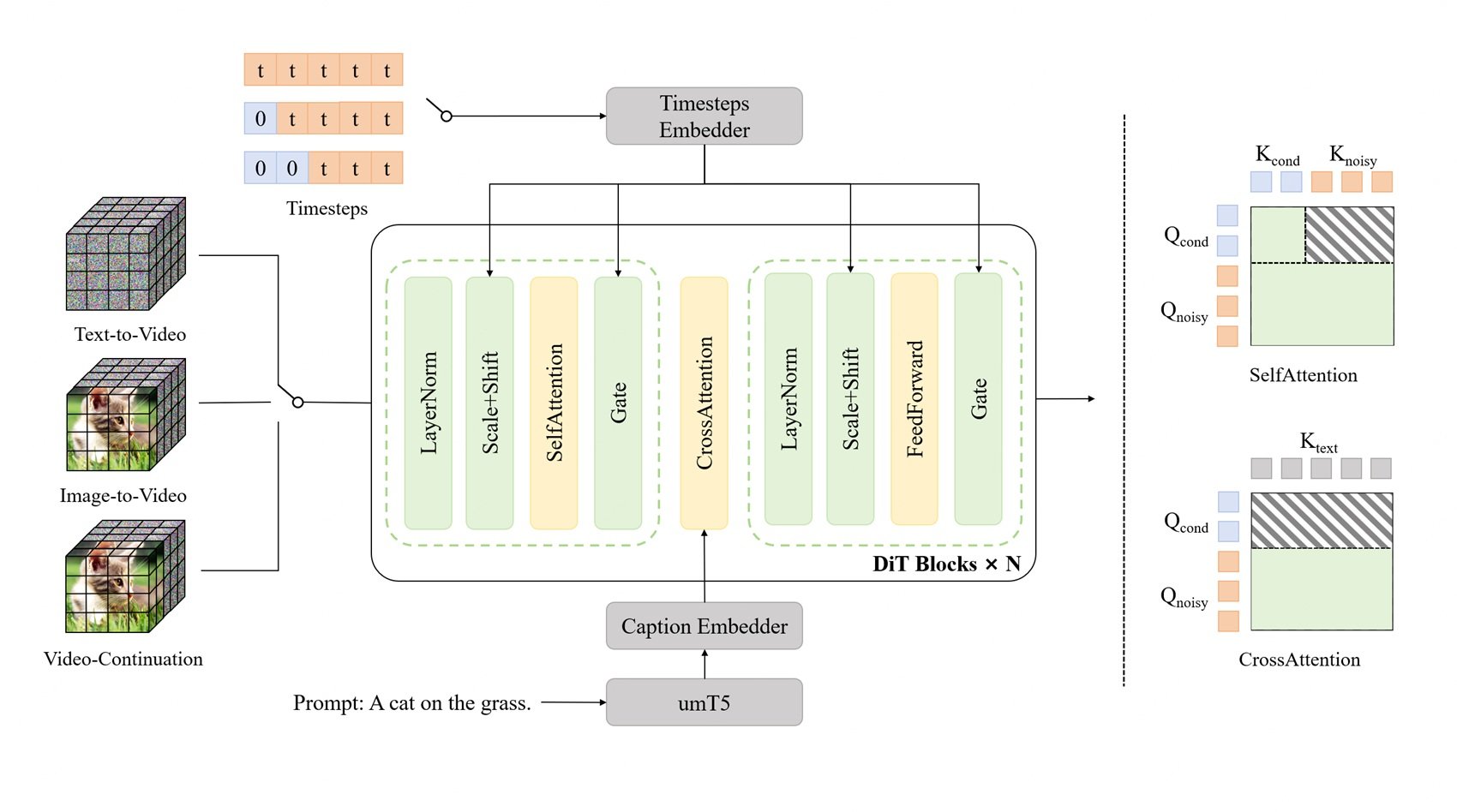

Sotto il cofano, LongCat-Video si basa su un Diffusion Transformer, o DiT, la stessa famiglia architetturale che ha reso Sora un punto di riferimento nel settore. I DiT sono una variante dei transformer originali adattati ai processi di diffusione, quella tecnica di generazione che funziona aggiungendo progressivamente rumore a un'immagine e poi imparando a rimuoverlo in modo controllato. Pensate al restauro di un affresco antico: prima copri tutto con uno strato di sporco virtuale, poi impari a rimuoverlo rivelando l'immagine sottostante. I modelli di diffusione fanno esattamente questo, ma in senso inverso: partono dal rumore puro e lo "puliscono" fino a ottenere l'immagine desiderata.

Il problema con i video lunghi è che ogni frame aggiunto moltiplica esponenzialmente la complessità computazionale. Un video di cinque minuti a 30 fps sono 9.000 frame, e ogni frame deve essere coerente con tutti gli altri. La memoria richiesta esplode, i tempi di generazione diventano proibitivi, e il rischio di errori accumulati aumenta. È come giocare al telefono senza fili con novemila persone: anche un errore microscopico al frame 100 si amplifica drammaticamente al frame 9.000.

LongCat-Video risolve questo con il Block Sparse Attention, un meccanismo che invece di far prestare attenzione a ogni frame a tutti gli altri frame contemporaneamente (operazione computazionalmente devastante), crea blocchi di attenzione locale. Ogni frame presta attenzione principalmente ai frame vicini e a una selezione strategica di frame distanti. È come guardare un panorama: hai la visione nitida di ciò che è vicino, una visione periferica di quello che sta ai lati, e punti di ancoraggio visivo sulla linea dell'orizzonte. Non vedi tutto con la stessa nitidezza, ma il cervello ricostruisce una percezione coerente dello spazio. Il Block Sparse Attention fa la stessa cosa con i video.

L'altra innovazione chiave è la strategia coarse-to-fine, letteralmente "dal grossolano al fine", che opera sia sull'asse temporale che spaziale. Invece di generare immediatamente video ad alta risoluzione con tutti i frame, il modello prima genera una versione a bassa risoluzione con meno frame, catturando la struttura narrativa e i movimenti principali. Poi, in una seconda fase, raffina questa bozza aumentando progressivamente risoluzione spaziale e frame rate temporale. È come lavorare su un'animazione tradizionale: prima disegni i keyframe principali che definiscono le pose e i movimenti chiave, poi aggiungi gli inbetween che rendono tutto fluido, infine colori e rifinisci i dettagli.

Questa strategia non è solo computazionalmente efficiente, è anche più allineata con il modo in cui funziona la narrazione visiva umana. Quando immagini una scena, non la visualizzi immediatamente frame-per-frame in 4K: prima hai un'idea approssimativa della composizione, dei movimenti principali, dell'atmosfera generale. Poi aggiungi dettagli, perfezioni i movimenti, definisci le texture. Il coarse-to-fine replica questo processo cognitivo.

Il pretraining nativo sui task di Video-Continuation è l'ingrediente segreto che tiene insieme tutto. Durante l'addestramento, il modello ha visto centinaia di migliaia di ore di video dove il compito non era generare da zero, ma continuare sequenze esistenti mantenendo coerenza stilistica, narrativa e fisica. Ha imparato cosa significa continuità temporale nel modo più diretto possibile: facendolo, iterativamente, per migliaia di ore. È come imparare a scrivere sequel leggendo romanzi e poi scrivendo i capitoli successivi: impari implicitamente cosa significa mantenere coerenza di tono, personaggi, ambientazione.

Tre task, un solo modello

Una delle scelte architetturali più eleganti di LongCat-Video è l'approccio unificato ai tre task principali: generazione text-to-video da zero, animazione image-to-video di immagini statiche, e video continuation per estendere clip esistenti. La maggior parte dei sistemi affrontano questi task con modelli separati o pipeline elaborate che incollano componenti diversi. LongCat-Video li gestisce tutti distinguendoli semplicemente dal numero di frame condizionali in input.

Nel text-to-video puro, il modello parte da zero frame condizionali e genera tutto basandosi solo sul prompt testuale. È il caso d'uso più difficile perché non hai ancoraggi visivi, devi creare composizione, movimenti, stile e coerenza esclusivamente dall'interpretazione del testo. È come dire a qualcuno "dipingimi una tempesta in mare" senza mostrare riferimenti: deve immaginare tutto.

Nell'image-to-video, fornisci un frame iniziale come condizione e il modello genera i frame successivi che animano quell'immagine. Qui il compito è più vincolato: hai già composizione, stile, illuminazione definiti dal frame iniziale, devi solo aggiungere movimento coerente. È come avere la prima inquadratura di un film già girata e dover decidere come continua la scena.

Nel video continuation, fornisci un intero segmento video e chiedi al modello di estenderlo. Questo è tecnicamente il caso più vincolato ma richiede la massima coerenza temporale: devi rispettare non solo stile e composizione, ma anche la fisica dei movimenti già presenti, la traiettoria degli oggetti, l'evoluzione della scena. È come scrivere il terzo atto di una storia dove i primi due sono già scritti: hai margini creativi, ma devi rispettare personaggi, trama, tono già stabiliti.

L'architettura unificata significa che il modello non ha bisogno di moduli separati per gestire questi casi. Internamente, text-to-video è semplicemente video continuation con zero frame condizionali, image-to-video è video continuation con un frame condizionale, e così via. Questo non solo riduce la complessità ingegneristica, perché mantieni una sola codebase e un solo training pipeline, ma migliora anche la qualità perché il modello condivide rappresentazioni e capacità tra i diversi task. Le competenze apprese per estendere video lunghi aiutano la generazione da zero, e viceversa.

Per sviluppatori e ricercatori, questo approccio è una benedizione. Invece di dover configurare pipeline complesse che chiamano modelli diversi per task diversi, installi un solo modello e cambi semplicemente il numero di frame che fornisci come input. Vuoi generare da testo? Zero frame. Vuoi animare un'immagine? Un frame. Vuoi estendere un video? Tutto il video. La semplicità è sottovalutata nell'ingegneria del software, ma chiunque abbia debuggato pipeline complesse sa quanto valga la pena avere meno componenti in movimento.

I numeri parlano, ma non gridano

Quando si parla di modelli generativi, i benchmark sono terreno minato. Ogni azienda ha i suoi test interni, ottimizzati per far brillare i propri modelli, e i test pubblici come VBench cercano di offrire valutazioni oggettive ma catturano solo alcune dimensioni della qualità percepita. LongCat-Video naviga questi numeri con risultati solidi ma non strabilianti, che è esattamente quello che ti aspetti da un modello opensource sviluppato con una frazione delle risorse dei giganti tech.

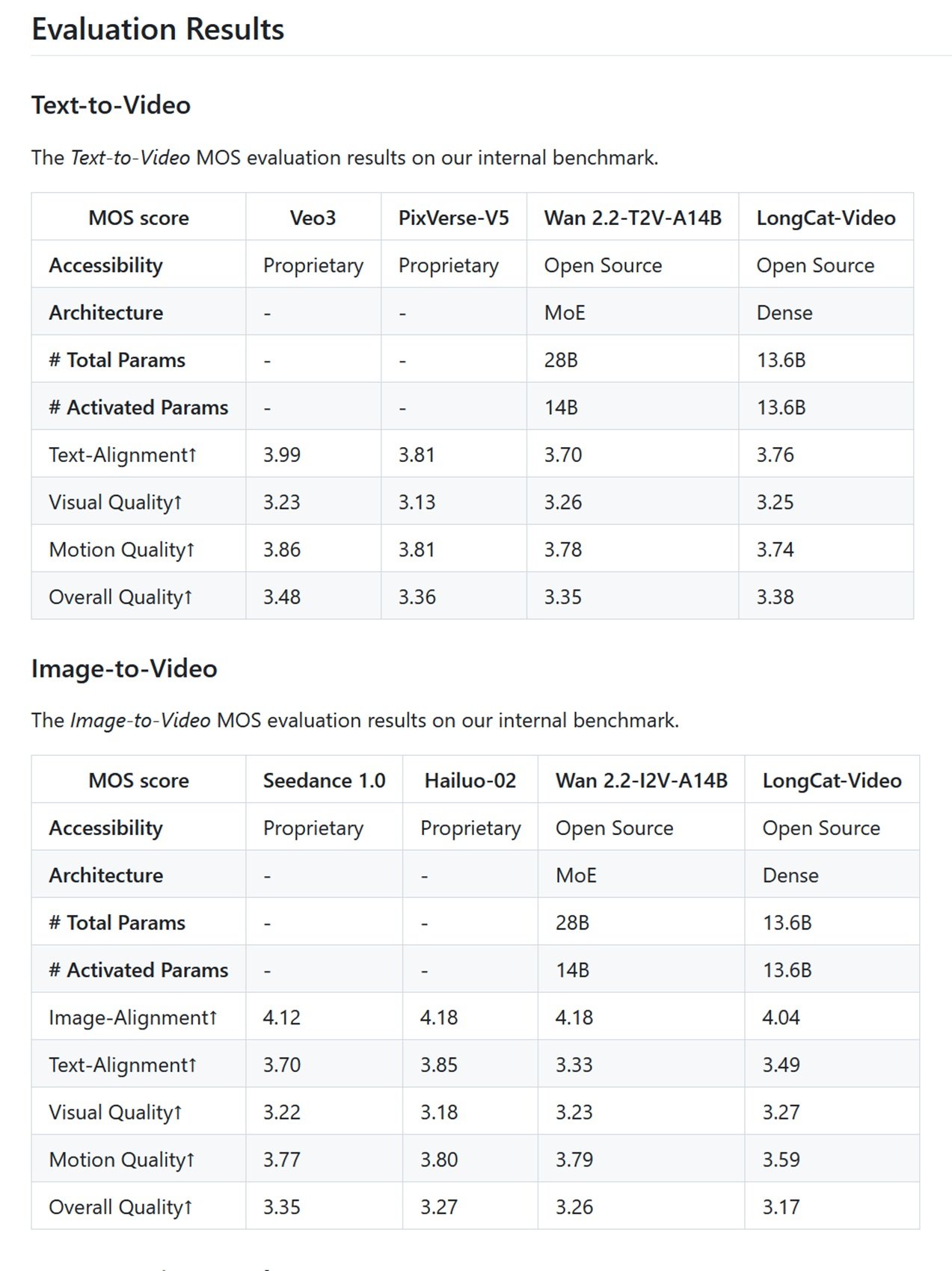

Sui benchmark interni di Meituan basati su Mean Opinion Score, dove valutatori umani giudicano video su una scala da 1 a 5, LongCat-Video ottiene 3.25 per qualità visiva nel text-to-video e 3.27 nell'image-to-video. Per contestualizzare: Veo 3 ottiene 3.51, Sora 2 è a 3.49. Non è un distacco enorme, ma esiste. Nelle metriche di text-alignment, dove si misura quanto il video generato corrisponda al prompt testuale, LongCat-Video ottiene 3.76, mentre i top player proprietari sfiorano il 4.0. Insomma, il modello è competitivo ma non domina.

Su VBench, il benchmark pubblico più rispettato nel settore che valuta 16 dimensioni diverse della qualità video, LongCat-Video si comporta particolarmente bene nella coerenza temporale e nel common sense understanding, dove ottiene il primo posto tra i modelli opensource con un punteggio del 70.94%. Questo è significativo perché il common sense, la capacità di generare video che rispettano fisica, logica spaziale e coerenza narrativa di base, è tradizionalmente il tallone d'Achille dei modelli generativi. Un modello può generare texture fotorealistiche e movimenti fluidi, ma se mette una persona che attraversa un muro o fa levitare oggetti senza motivo, il risultato è straniante.

Il confronto con i competitor opensource rivela uno scenario interessante. HunyuanVideo, che ha una dimensione simile con circa 13 miliardi di parametri, è ottimizzato per video più corti ma con qualità visiva leggermente superiore sui clip da tre secondi. Mochi punta sulla velocità di generazione con 10 miliardi di parametri e un'architettura asimmetrica che privilegia l'efficienza. Open-Sora, il tentativo della community di replicare l'architettura originale di OpenAI, resta indietro su quasi tutte le metriche. CogVideoX-5B, sviluppato dalla Tsinghua University, ha prestazioni comparabili a LongCat sui video corti ma non supporta generazioni oltre i dieci secondi. LTX-Video di Lightricks ha introdotto la promessa della generazione in tempo reale, ma con video limitati a pochi secondi.

Come abbiamo già discusso nell'articolo su Ovi e l'ecosistema opensource della generazione video, il panorama è frammentato tra progetti che ottimizzano per qualità assoluta, velocità di generazione, o durata dei video. LongCat-Video si inserisce in questo panorama con una proposta chiara: non sono il più veloce, non sono il più fotorealistico, ma posso generare video lunghi mantenendo coerenza. È un posizionamento intelligente, perché la durata è ancora un differenziatore forte. Ovi ha dimostrato l'importanza dell'integrazione audio-video nativa, CogVideoX ha spinto sulla coerenza temporale nei dieci secondi, LongCat-Video estende questa capacità a minuti.

Il punto critico è che nessuno di questi modelli opensource batte ancora i sistemi proprietari in qualità assoluta. Sora 2 genera video più fotorealistici, Veo 3 ha uno stile cinematografico più raffinato, Movie Gen integra audio e musica con qualità professionale. Ma tutti questi modelli sono black box inaccessibili, chiusi dietro API a pagamento o waitlist infinite. Non puoi studiarli, non puoi modificarli, non puoi verificare su quali dati sono stati addestrati. Come in un buffet all-you-can-eat dove il cibo sembra migliore ma non sai cosa ci hanno messo dentro, mentre al ristorante opensource vedi la cucina aperta e conosci ogni ingrediente.

Opensource, ma a quale prezzo?

Dire che LongCat-Video è opensource suona democratico e accessibile, ma la realtà hardware racconta una storia più sfumata. Per generare video a 720p e 30 fps in tempi ragionevoli servono almeno 60GB di VRAM, il che significa configurazioni multi-GPU o schede di fascia enterprise come le NVIDIA A100 o H100. Una singola A100 costa quanto una city car usata, e anche con ottimizzazioni come la quantizzazione a 8-bit che riduce i requisiti a circa 18GB su una RTX 4090, parliamo comunque di hardware entusiasta di fascia alta.

Questo solleva la domanda cruciale: democratizzare il codice ma richiedere hardware da quattro-cinquemila euro è vera democratizzazione o solo un'illusione per chi può permettersi le GPU? La risposta dipende da chi sei. Per un singolo hobbista o un creativo indipendente, LongCat-Video resta probabilmente fuori portata a meno di usare servizi cloud, il che reintroduce costi mensili non troppo distanti dagli abbonamenti ai modelli proprietari. Per uno studio creativo di piccole-medie dimensioni, un laboratorio universitario, o una startup tech, spendere qualche migliaio di euro in hardware è un investimento una tantum che dà controllo totale e costi operativi prevedibili. Niente abbonamenti che salgono, niente API che cambiano termini, niente rischio che il servizio venga dismesso.

La licenza MIT sotto cui è rilasciato LongCat-Video è la più permissiva possibile: puoi usarlo commercialmente, modificarlo, integrarlo in prodotti proprietari, senza royalty o vincoli di attribuzione obbligatoria oltre il copyright notice. È la licenza che dice "fai quello che vuoi, questa è la massima libertà che possiamo darti". Per confronto, alcuni modelli opensource usano licenze più restrittive che limitano l'uso commerciale o impongono clausole di condivisione delle modifiche.

Il repository GitHub contiene non solo i pesi del modello ma anche la documentazione completa per training, inference, e fine-tuning. Ci sono esempi di codice per ogni task supportato, script per l'ottimizzazione su diverse configurazioni hardware, e persino guide per il deployment in produzione. Non è plug-and-play come aprire un browser e usare Sora, ma è completo e ben documentato. Un team con competenze di machine learning può essere operativo in giorni, non mesi.

L'accessibilità vera dell'opensource nell'AI video passa però da una progressiva riduzione dei requisiti hardware, che storicamente è sempre successa. I modelli language transformer che cinque anni fa richiedevano server farm oggi girano su laptop. L'ottimizzazione software, le tecniche di quantizzazione, gli acceleratori specializzati stanno comprimendo i requisiti costantemente. Tra un anno, LongCat-Video o suoi discendenti potrebbero girare su configurazioni consumer di fascia media. Tra due anni, forse su smartphone di punta. La traiettoria tecnologica va sempre verso la miniaturizzazione e l'efficienza.

Nel frattempo, LongCat-Video non è il messia che democratizza la generazione video AI per tutti, ma è un passo concreto verso video generativi lunghi, accessibili e modificabili per chi ha le competenze e le risorse per usarlo. È un contributo importante a quell'ecosistema opensource che, come la scena indie dei primi anni Duemila, costruisce alternative concrete ai prodotti mainstream non per superarli in budget o luccichio, ma per offrire libertà, controllo e trasparenza a chi le cerca. E a volte, come insegna la storia della tecnologia, sono proprio queste alternative garage band a inventare le idee che domani diventeranno mainstream.