Robotica: lo stato dell'arte 2025. Separiamo l'Hype dalla Realtà

Nell'ottobre 2024, Tesla presenta "We, Robot" al Warner Bros Studios. Optimus distribuisce bevande, gioca a "sasso-carta-forbice", intrattiene gli ospiti con movenze fluide. I video diventano virali in poche ore. Pochi giorni dopo, Fortune Italia e altri media rivelano che gli umanoidi erano teleoperati da tecnici umani. Adam Jonas di Morgan Stanley conferma l'uso di teleoperazione, come ammesso da alcuni robot stessi che dichiaravano "oggi sono assistito da un umano". La voce sintetica? Un operatore umano in cuffia. Questi "dettagli" nascondono il problema centrale della robotica umanoide nel 2025: il divario abissale tra demo controllate e deployment autonomo.

Non è la prima volta. Nel 2021, il primo Optimus era un ballerino in costume. Nel 2022, il prototipo camminava ma traballava. Nel 2023, le mani acquisivano destrezza manipolativa limitata. Oggi, a novembre 2025, Tesla afferma che venti unità lavorano nelle proprie fabbriche in compiti ripetitivi. Verificare queste affermazioni dall'esterno è impossibile: nessun giornalista indipendente ha filmato Optimus operare autonomamente per turni completi. Questo pattern si ripete nell'industria: video impressionanti, claim audaci, verifiche indipendenti che rivelano teleoperazione o scenari ultra-controllati.

Benvenuti nello stato dell'arte della robotica unita all'intelligenza artificiale: un territorio dove ingegneria straordinaria convive con marketing aggressivo, dove progressi reali vengono gonfiati da aspettative irrealistiche, dove separare ciò che funziona da ciò che è "quasi pronto" richiede occhio clinico. Come in Planetes, l'anime di Makoto Yukimura dove i detriti spaziali vengono raccolti da operatori umani perché l'automazione completa resta troppo costosa e inaffidabile, anche nella robotica terrestre del 2025 l'ultimo metro verso l'autonomia vera si rivela il più lungo.

Atlas: Il Benchmark Tecnico

Se esiste un gold standard tecnico nella robotica umanoide, è Atlas di Boston Dynamics. Non per le applicazioni commerciali, quasi assenti, ma per le capacità dimostrate in modo verificabile. Nell'agosto 2024, l'azienda presenta la versione elettrica del robot, abbandonando l'idraulica che aveva caratterizzato i modelli precedenti. Il nuovo Atlas pesa 89 kg, misura 150 cm, integra 28 gradi di libertà con attuatori elettrici custom che Boston Dynamics non vende separatamente. La peculiarità: articolazioni che ruotano oltre i limiti anatomici umani, permettendo rotazioni complete del torso e movimenti "impossibili" per un corpo biologico.

A ottobre 2024, Boston Dynamics rilascia video di Atlas che manipola componenti automotive in scenario industriale semi-strutturato. Il robot riconosce oggetti variabili, adatta la presa, corregge errori. Niente teleoperazione, ma Large Behavior Models addestrati su migliaia di ore di simulazioni e dati reali. Quando sbaglia, riprova con strategia diversa. Quando l'ambiente cambia, ricalcola il percorso. È autonomia vera? Sì, ma in uno scenario ristretto: componenti noti, spazio mappato, task ripetitivo con variazioni limitate.

Il vero salto avviene nell'ottobre 2024 con la partnership tra Boston Dynamics e Toyota Research Institute. L'obiettivo: combinare la piattaforma hardware di Atlas con i Large Behavior Models sviluppati da TRI, addestrati su miliardi di interazioni simulate. Toyota porta esperienza in manufacturing real-world, Boston Dynamics la robotica di frontiera. Insieme puntano a creare umanoidi capaci di apprendere nuovi task in ore anziché mesi, generalizzando da pochi esempi come fanno i modelli linguistici con il testo.

Ma Atlas resta un progetto di ricerca. Costo stimato per unità, non dichiarato ma stimato, in centinaia di migliaia di dollari. Autonomia operativa: circa 4 ore prima di ricaricare. Manutenzione: tecnici specializzati. Deployment commerciale: zero. Boston Dynamics non vende Atlas, lo usa come piattaforma R&D per affinare tecnologie che poi finiscono in prodotti come Spot, il cane robotico che ha trovato nicchie in ispezioni industriali e cantieri. Atlas dimostra cosa è tecnicamente possibile, non cosa è economicamente scalabile.

Tesla Optimus: Visione o Vaporware?

Elon Musk ha una teoria: la robotica umanoide sarà più grande dell'automotive, più grande dell'energia. Prevede un mercato da 25 trilioni di dollari, con Optimus che costerà 20-30.000 dollari e "rivoluzionerà l'economia". Tesla impiega oltre 200 ingegneri sul progetto, ha costruito infrastrutture di addestramento AI dedicate, investe miliardi. L'ambizione è reale. I risultati verificabili molto meno.

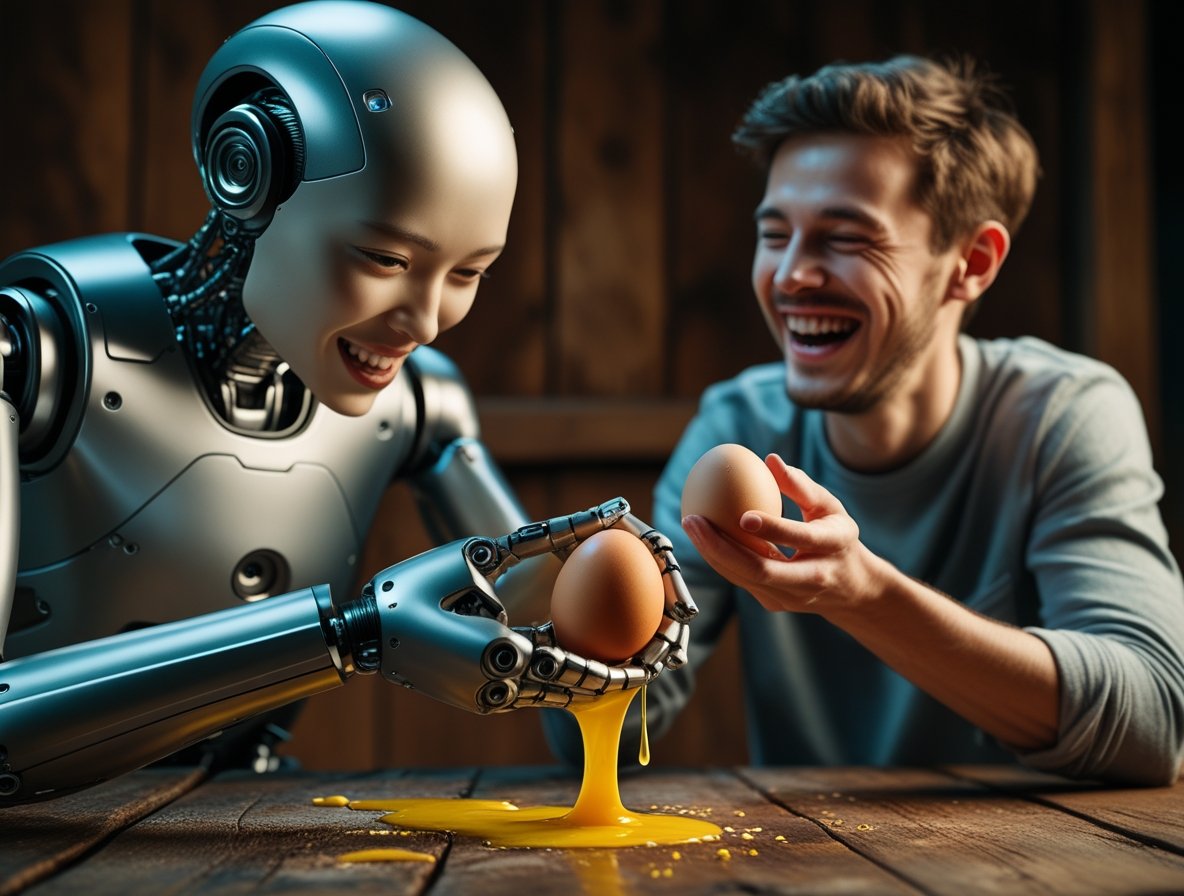

L'ultimo aggiornamento pubblico risale a ottobre 2024: Optimus Gen 2 cammina più velocemente, le mani hanno 11 gradi di libertà, può afferrare un uovo senza romperlo. Nei video ufficiali, piega vestiti, ordina oggetti, trasporta componenti in fabbrica. Ma come abbiamo visto, molte demo erano teleoperazione mascherata. Tesla sostiene che a novembre 2025 venti unità lavorano autonomamente nelle proprie fabbriche texane. Verificare è impossibile: nessun accesso esterno, nessuna conferma da fonti terze.

Il problema centrale è economico. Analisti dell'industria stimano che produrre un umanoide minimamente capace costi oggi 120-150.000 dollari: attuatori ad alta coppia, sensori LIDAR e vision multiple, batterie da 2-3 kWh, computer di bordo potente. Scendere a 20-30.000 dollari richiederebbe economie di scala massicce (centinaia di migliaia di unità) e breakthrough tecnologici su batterie e attuatori. Tesla ha esperienza in scaling manufacturing automotive, ma un'auto ha circa 30.000 componenti; un umanoide capace ne avrebbe altrettanti, con tolleranze meccaniche più strette.

C'è poi il paradosso dell'utilità. Per quale task un umanoide general-purpose da 30.000 dollari batte un robot specializzato da 5.000? In magazzino, i robot mobili autonomi di Amazon costano una frazione e movimentano più merci. In casa, aspirapolvere robotici costano 500 euro e funzionano. Un umanoide domestico dovrebbe cucinare, pulire, stirare, fare riparazioni: task che singolarmente hanno soluzioni automatizzate più economiche, mentre integrarli in un corpo antropomorfo moltiplica complessità e costi.

Musk ha ragione su una cosa: se qualcuno risolverà il problema, avrà un mercato enorme. Ma "se" e "quando" sono domande a cui nessun ingegnere serio risponde con certezze. Tesla ha risorse, talento, visione. Ma dopo tre anni di annunci, mancano ancora deployment verificabili su larga scala.

Figure AI: Un Robot alla BMW (Uno Solo)

Nel gennaio 2024, Figure AI annuncia una partnership con BMW per integrare il robot Figure 02 nello stabilimento di Spartanburg, South Carolina. I comunicati stampa parlano di "rivoluzionare il manufacturing automotive". I video mostrano Figure 02 che inserisce componenti in una scocca con precisione millimetrica. Investitori come OpenAI, Nvidia, Microsoft, Intel pompano 675 milioni di dollari nel round di Serie B. Valutazione: 2,6 miliardi. L'hype è alle stelle.

Dieci mesi dopo, a ottobre 2024, Figure AI pubblica un aggiornamento sostanziale: un robot Figure 02 ha lavorato per cinque mesi consecutivi, dieci ore al giorno, in una sezione controllata dello stabilimento. Il task: installare componenti specifici su un singolo modello di veicolo. Non è più un test pilota di giorni o settimane, ma deployment prolungato con dati operativi reali. L'azienda riporta uptime superiore al 70%, con miglioramenti progressivi grazie ai dati raccolti sul campo. Il robot apprende da errori reali, non simulati, adattando strategie di presa e correggendo deviazioni.

Ma le limitazioni restano evidenti: un singolo robot, un singolo task, un ambiente ultra-controllato. Tempo di addestramento per quella specifica operazione: sei mesi. BMW conferma che l'obiettivo non è sostituire lavoratori ma automatizzare task ergonomicamente gravosi o pericolosi. Entro fine 2025 l'obiettivo è arrivare a dieci unità operative in task diversi. A lungo termine, centinaia.

Il punto critico resta il ROI. Un operatore umano alla BMW costa circa 70.000 dollari annui tra stipendio e benefit. Figure 02 costa stimati 150.000 dollari, più manutenzione (20-30.000 annui), più addestramento specializzato per ogni nuovo task. Break-even in tre-quattro anni, ammesso che il robot lavori stabilmente senza degradazione prestazionale. Per BMW, che produce 1,5 milioni di veicoli annui in 31 stabilimenti, scalare da uno a mille robot richiede non solo capitale ma infrastrutture software (fleet management, monitoring, aggiornamenti OTA) che oggi esistono solo in forma embrionale.

Figure AI sta costruendo quelle infrastrutture, ma il passaggio da singolo deployment a fleet di centinaia di unità è dove tante startup robotiche sono naufragate. Rethink Robotics, pioniera dei cobot, ha chiuso nel 2018 nonostante tecnologia solida e grandi clienti: i costi di supporto e customizzazione hanno eroso i margini. Figure AI ha più capitale e partner migliori, ma la fisica economica non cambia: ogni robot in più costa quasi quanto il primo finché non raggiungi scala massiva. Cinque mesi di operatività continuativa sono un traguardo significativo, ma la distanza tra un robot e mille resta immensa.

Clone Alpha: Biomimetica Affascinante, Prove Assenti

Clone Robotics, startup con sede a Varsavia, persegue un approccio radicalmente diverso: non motori elettrici ma "muscoli" sintetici alimentati da un sistema vascolare idraulico. Clone Alpha, presentato nel 2024, ha avambracci e mani con myofiber che si contraggono come tessuto biologico, dita con 26 gradi di libertà, movimenti fluidi e precisi. Esteticamente impressionante: la pelle sintetica traslucida lascia intravedere tendini e attuatori, come un'illustrazione anatomica di Andreas Vesalius portata in tre dimensioni.

Il problema: non esistono video di Clone Alpha che esegue task complessi autonomamente. I video ufficiali mostrano singoli movimenti di presa, rotazioni del polso, flessioni delle dita. Tutto in ambiente controllato, con il torso assente. Clone Robotics promette che il sistema muscolo-scheletrico consente movimenti più naturali e adattabili di quelli motorizzati, con feedback tattile intrinseco. Ma finché non vediamo il robot completo operare per minuti, non ore, in scenari semi-strutturati, restano claim teorici.

Il vantaggio biomimetico è reale in teoria: muscoli biologici hanno rapporto potenza-peso superiore ai motori elettrici, ammortizzano naturalmente shock meccanici, si adattano a superfici irregolari. Ma l'idraulica introduce complessità: pompe, valvole, sensori di pressione, rischi di perdite, manutenzione intensiva. Nei robot industriali, l'idraulica è stata largamente abbandonata per l'elettrica negli ultimi vent'anni proprio per affidabilità e costi operativi.

Clone Robotics afferma di aver risolto questi problemi con materiali innovativi e design compatto. Hanno raccolto diversi milioni in seed funding, collaborano con università europee, presentano paper peer-reviewed su design degli attuatori. Ma il salto da subsistema funzionante a robot integrato è enorme. Boston Dynamics ci ha messo quindici anni con risorse massicce. Clone è una startup piccola in un mercato dominato da giganti con miliardi di budget.

La sensazione è di guardare un concept car straordinario: design audace, tecnologie affascinanti, ma senza certezza che arrivi mai in produzione. Nella robotica umanoide, l'ingegneria supera regolarmente la fantascienza nei paper, ma si schianta contro economia e fisica quando deve scalare.

Chirurgia Robotica: L'Eccellenza Consolidata

Se volete vedere robotica avanzata che funziona davvero, entrate in una sala operatoria. Intuitive Surgical, con la piattaforma da Vinci, domina la chirurgia robotica da oltre vent'anni. Il sistema da Vinci 5, introdotto nel 2024, integra oltre 150 sensori di forza che trasmettono feedback tattile al chirurgo, permettendo di "sentire" tessuti attraverso gli strumenti. Risoluzione 3D a 10 megapixel, latenza sotto i 50 millisecondi, stabilizzazione tremori, scaling movimenti 1:3 per precisione sub-millimetrica.

I numeri sono impressionanti: oltre 8.500 sistemi installati globalmente, più di 15 milioni di procedure robotiche eseguite cumulativamente, 12.000 procedure solo nei primi sei mesi del 2024. In chirurgia prostatica, toracica, ginecologica, da Vinci è standard in molti centri d'eccellenza. Perché funziona dove gli umanoidi faticano? Tre ragioni: task specifico e ben definito, ambiente ultra-controllato, chirurgo umano nel loop.

Da Vinci non è autonomo: amplifica capacità umane, non le sostituisce. Il chirurgo controlla ogni movimento tramite console; il robot traduce input umani in azioni precise, filtrando tremori e scalando movimenti. È teleoperazione avanzatissima, ma resta teleoperazione. L'AI entra in fasi diagnostiche: analisi pre-operatoria delle immagini, suggerimenti su margini di resezione, identificazione strutture critiche. Ma la decisione resta umana.

I limiti sono economici e logistici: un sistema da Vinci 5 costa 2-3 milioni di dollari, strumenti usa-e-getta 2-3.000 dollari per procedura, contratti di manutenzione 150-200.000 annui. Solo ospedali grandi e specializzati possono permetterselo. Inoltre, curva di apprendimento ripida: un chirurgo impiega 100-150 procedure per raggiungere proficiency. Questo crea disparità: eccellenza robotica concentrata in pochi centri, resto del mondo che opera tradizionalmente.

Sta emergendo competizione: Medtronic con Hugo, Johnson & Johnson con Ottava, CMR Surgical con Versius. Tutti puntano a costi inferiori e modularità maggiore. Ma da Vinci mantiene il vantaggio del first mover: trent'anni di dati operativi, ecosistema di training consolidato, install base enorme. Nella chirurgia robotica, la tecnologia ha superato la fase dimostrativa ed è diventata standard clinico. Negli umanoidi general-purpose, siamo ancora alle demo.

Cobot: La Rivoluzione Silenziosa

Mentre gli umanoidi catturano headline, i robot collaborativi (cobot) trasformano silenziosamente il manufacturing globale. Universal Robots, ABB, FANUC, KUKA vendono decine di migliaia di unità annue. Il mercato vale 1,9 miliardi nel 2024, proiezioni IDTechEx lo vedono a 11,8 miliardi entro il 2030. Perché funzionano? Perché non pretendono di essere umani.

Un cobot come UR10e di Universal Robots: braccio a sei assi, payload 10 kg, precisione ±0,03 mm, costo 35-45.000 dollari. Si programma con interfaccia grafica drag-and-drop: nessun codice, tecnico medio lo addestra in giorni. Sensori di coppia su ogni giunto rilevano collisioni e fermano il movimento entro 0,4 secondi, rendendo sicuro lavorare accanto senza gabbie protettive. Consuma 500 watt, si alimenta a rete standard, occupa mezzo metro quadrato.

I task: pick-and-place, avvitatura, assemblaggio, ispezione qualità, packaging. Task ripetitivi, ergonomicamente gravosi per umani, che i cobot eseguono 24/7 con qualità costante. In linee automotive, elettronica, food processing, pharmaceutical, i cobot affiancano operatori umani in celle collaborative: il robot gestisce il ripetitivo, l'umano supervisiona e gestisce eccezioni. È l'applicazione pratica del Paradosso di Moravec: difficile per umani (ripetizione iperprecisa) è facile per robot, facile per umani (adattamento a variazioni) è difficile per robot.

I limiti sono chiari: payload limitato (10-20 kg), velocità inferiore ai robot industriali tradizionali, impossibilità di gestire variabilità elevata. Ma per task strutturati, il ROI è documentato: studi McKinsey mostrano payback in 12-24 mesi, con produttività aumentata del 20-40% e riduzione difetti del 15-30%. Aziende medio-piccole che non potevano permettersi automazione tradizionale ora integrano cobot.

La direzione futura: cobot con vision AI che riconoscono oggetti variabili, apprendono per dimostrazione invece che per programmazione, si riconfiggurano autonomamente per nuovi task. Progetti come Robotics Hub finanziati dalla UE stanno standardizzando interfacce software per rendere i cobot più intercambiabili e meno dipendenti da vendor singoli. È automazione pragmatica, non visionaria, ma funziona ed è profittevole oggi, non domani.

I Tre Muri Tecnici

Dietro ogni umanoide che cammina traballando o manipola oggetti goffamente ci sono limiti fisici brutali. Tre su tutti definiscono il gap tra prototipo e prodotto.

Batterie: un umanoide che lavora consuma 200-500 watt continuamente. Con batterie Li-ion attuali, densità energetica circa 250 Wh/kg, per 4 ore di autonomia servono 2-3 kWh, ovvero 8-12 kg di batterie. Questo su un robot che già pesa 50-80 kg riduce drasticamente payload e agilità. Tesla Optimus ha batteria da 2,3 kWh per autonomia dichiarata di "diverse ore" (non specificate). Atlas elettrico usa batteria custom non rivelata, autonomia stimata 3-4 ore. Ogni breakthrough in densità energetica aiuterebbe, ma le batterie migliorano del 5-7% annuo, non 50%. Servono anni per raddoppiare autonomia senza aumentare peso.

Attuatori: i motori elettrici affrontano il trilemma forza-velocità-efficienza. Un attuatore ad alta coppia è pesante e lento, uno veloce ha poca forza, uno efficiente ha entrambi limitati. I giunti umani gestiscono carichi enormi con consumi bassissimi: un quadricipite solleva 100 kg consumando pochi watt a riposo. Gli attuatori robotici consumano anche da fermi per mantenere posizioni. Tecnologie emergenti (attuatori a serie elastica, motori a magneti permanenti ad alta densità) migliorano ma costano migliaia di dollari per giunto. Un umanoide con 25-30 attuatori avanzati ha costi hardware proibitivi.

Destrezza: la mano umana ha 27 ossa, 34 muscoli, migliaia di recettori tattili, 26+ gradi di libertà. Le mani robotiche più avanzate ne hanno 10-16, con sensori tattili rudimentali. Afferrare un oggetto rigido è gestibile; manipolare tessuti morbidi, oggetti fragili, superfici scivolose resta difficilissimo. Il feedback tattile ad alta risoluzione richiederebbe migliaia di sensori per cm², elettronica complessa, processing real-time. Oggi i robot "sentono" attraverso sensori di coppia nei motori: indiretti e imprecisi. La ricerca su pelle elettronica e sensori tattili flessibili avanza, ma integrare migliaia di punti di sensing in una mano funzionante è ingegnerizzazione estrema.

Questi limiti non sono bug risolvibili con software: sono vincoli fisici. L'AI può migliorare controllo e pianificazione, ma non può creare energia dal nulla o aumentare la coppia di un motore oltre le sue specifiche. Ogni progressione richiede breakthrough materiali o design radicalmente nuovi. Non è questione di "se", ma "quando" – e il "quando" è molto più lontano di quanto i comunicati stampa suggeriscano.

Geografia degli Investimenti

La robotica umanoide è un campo dominato da pochi player concentrati in USA e Cina. Nel 2024, startup americane (Figure AI, Apptronik, Agility Robotics) e cinesi (UBTech, Fourier Intelligence, Unitree) raccolgono complessivamente oltre 700 milioni di dollari. Gli investitori principali: Nvidia, OpenAI, Microsoft, Amazon, fondi sovrani. La concentrazione è estrema: il 70% del capitale affluisce verso cinque aziende.

Nvidia gioca ruolo di kingmaker con Project GR00T, piattaforma AI per robot umanoidi basata su simulation-to-reality transfer. Fornisce stack software (percezione, pianificazione, controllo) e accesso alle GPU H100/H200 necessarie per addestrare modelli comportamentali. In cambio, le startup integrano hardware Nvidia e condividono dati operativi. È l'equivalente robotico dell'ecosistema CUDA: Nvidia controlla l'infrastruttura computazionale, gli altri competono su hardware e applicazioni.

La Cina persegue strategia diversa: investimenti massicci statali combinati con private equity. UBTech ha robot Walker S operativi in scenario hospitality e manufacturing; Unitree vende quadrupedi consumer da 1.600 dollari; Fourier Intelligence esporta exoscheletri riabilitativi. L'approccio è pragmatico: prodotti più semplici e meno costosi, scaling rapido, sussidio governativo per deployment domestico. Mentre USA punta all'umanoide general-purpose da 20.000 dollari fra dieci anni, Cina vende robot specializzati da 5.000 dollari oggi.

L'Europa è indietro. Progetti come ARISE, finanziati da Horizon Europe con budget totali sotto i 50 milioni, fanno ricerca eccellente ma non scalano verso prodotti. Le startup europee (Clone Robotics, Reachy di Pollen Robotics) restano piccole per mancanza di venture capital disposto a rischiare miliardi. La UE investe più in regolamentazione (AI Act, standard sicurezza) che in deployment. Risultato: ricerca pubblicata su Nature, prodotti venduti da altri.

Questa concentrazione crea rischi: poche aziende controllano dati, algoritmi, supply chain. Se un breakthrough avviene, sarà proprietario e costoso da licenziare. L'alternativa open-source esiste (ROS, robot operating system) ma ha traction limitata in ambito commerciale per mancanza di supporto enterprise. Il rischio non è solo economico ma geopolitico: robotica avanzata diventa leva strategica come semiconduttori e AI, con stesse dinamiche di dipendenza tecnologica.

Le Domande Scomode

Impatto occupazionale: IFR stima 4,2 milioni di robot industriali operativi globalmente a fine 2024, +7% anno su anno. Ogni robot sostituisce in media 1,5-3 lavoratori in task ripetitivi. Ma crea anche domanda per tecnici, programmatori, manutentori. Il World Economic Forum's Future of Jobs 2023 prevede che l'automazione eliminerà 83 milioni di posti entro 2027 ma ne creerà 69 milioni nuovi. La transizione netta negativa di 14 milioni nasconde però disparità enormi: posti persi sono operativi, quelli creati richiedono skills tecniche avanzate. Chi assembla componenti manualmente oggi non diventa programmatore ROS domani senza riqualificazione massiccia che la maggior parte dei paesi non sta finanziando adeguatamente.

Costi nascosti: ogni robot in produzione ha costi operativi spesso ignorati nei business case. Fleet management, monitoring 24/7, aggiornamenti software, parts replacement, downtime imprevisti. McKinsey documenta che TCO (total cost of ownership) robotico è tipicamente 2-3x il prezzo di acquisto su cinque anni. Per deployment massivi serve anche infrastruttura fisica: pavimenti ultrapiatti, illuminazione controllata, aree segregate per ricarica e manutenzione. Questi costi fanno sì che l'automazione convenga solo sopra certe scale produttive, escludendo aziende piccole e medio-piccole.

Etica sanitaria: robot assistenziali in eldercare sollevano questioni irrisolte. Possono monitorare parametri vitali, ricordare terapie, ridurre cadute. Ma un anziano che interagisce prevalentemente con una macchina esperisce isolamento sociale aumentato? Studi in Giappone, dove robot come Pepper sono stati testati in case di riposo, mostrano risultati misti: benefici funzionali (reminder, monitoring) ma riduzione interazione umana significativa. Il rischio è che l'automazione diventi scusa per ridurre personale sanitario, con robot che "riempiono il gap" creato da scelte economiche. Non è la tecnologia il problema, ma come viene applicata e per quali scopi.

Timeline realistiche: chiedete a dieci esperti quando avremo robot domestici general-purpose accessibili e otterrete dieci risposte diverse. Rodney Brooks, fondatore di iRobot e Rethink Robotics, è scettico: "Non prima del 2040, forse mai". Demis Hassabis di Google DeepMind è ottimista: "Metà anni 2030 per applicazioni limitate". Gli analisti Goldman Sachs prevedono mercato mass-market post-2035. Il consenso sommesso è che scenari ristretti (logistica, manufacturing, hospitality) vedranno robot specializzati scalare nei prossimi 5-7 anni, mentre l'umanoide domestico che cucina e pulisce autonomamente resta fantascienza per il prossimo decennio almeno.

2025: Anno Zero o Hype Cycle?

Dove siamo davvero? La risposta dipende da quale robotica osserviamo. Chirurgia: maturo, affidabile, in espansione. Cobot industriali: deployment massiccio in corso, ROI provato. Logistica specializzata: robot mobili autonomi in magazzino Amazon, DHL, scalano rapidamente. Questi funzionano perché task specifico, ambiente controllato, fallback umano disponibile.

Umanoidi general-purpose: hype massimo, deployment minimo. I prototipi impressionano, le demo sono spettacolari, gli investimenti miliardari. Ma manca ancora il salto da "funziona in laboratorio con supervisione" a "funziona autonomamente per turni di otto ore in scenari imprevedibili". Quel salto richiede non un breakthrough ma decine: batterie, attuatori, sensori, materiali, algoritmi, costi.

Il paradosso di Moravec, formulato negli anni '80, affermava che compiti cognitivi complessi (scacchi, calcolo) sono facili per computer, mentre compiti sensomotori semplici (camminare, manipolare) sono difficilissimi. L'AI ha superato la parte cognitiva: GPT-4 supera esseri umani in molti task linguistici. Ma l'incarnazione fisica resta collo di bottiglia. Farsi fare una frittata da un robot è ancora più difficile che farsi scrivere un romanzo.

Come nel film Her di Spike Jonze, dove l'AI Samantha è intimamente presente ma fisicamente assente, potremmo scoprire che l'intelligenza artificiale trasforma radicalmente le nostre vite attraverso interfacce software molto prima che attraverso corpi robotici. Quando l'intelligenza è ovunque ma non ha mani, la domanda diventa: abbiamo davvero bisogno di robot umanoidi, o cerchiamo di replicare noi stessi per narcisismo antropocentrico?

La risposta arriverà non dai lab di Boston o Palo Alto ma dalle fabbriche, dagli ospedali, dai magazzini dove robot specializzati già lavorano in silenzio, risolvendo problemi reali senza sembrare umani. L'hype racconta una storia. L'ingegneria ne scrive un'altra, più lenta e meno glamour, ma reale. E nel 2025, quello che funziona davvero non somiglia quasi mai alla fantascienza che abbiamo immaginato.